Мониторинг VPS: Prometheus, Grafana и Alertmanager на практике в 2026 году

TL;DR

- Комплексный мониторинг VPS с помощью связки Prometheus, Grafana и Alertmanager — это стандарт индустрии в 2026 году, обеспечивающий глубокое понимание состояния сервера и автоматизированное реагирование.

- Prometheus собирает метрики, используя pull-модель и мощный язык запросов PromQL, позволяя агрегировать и анализировать данные с высокой детализацией.

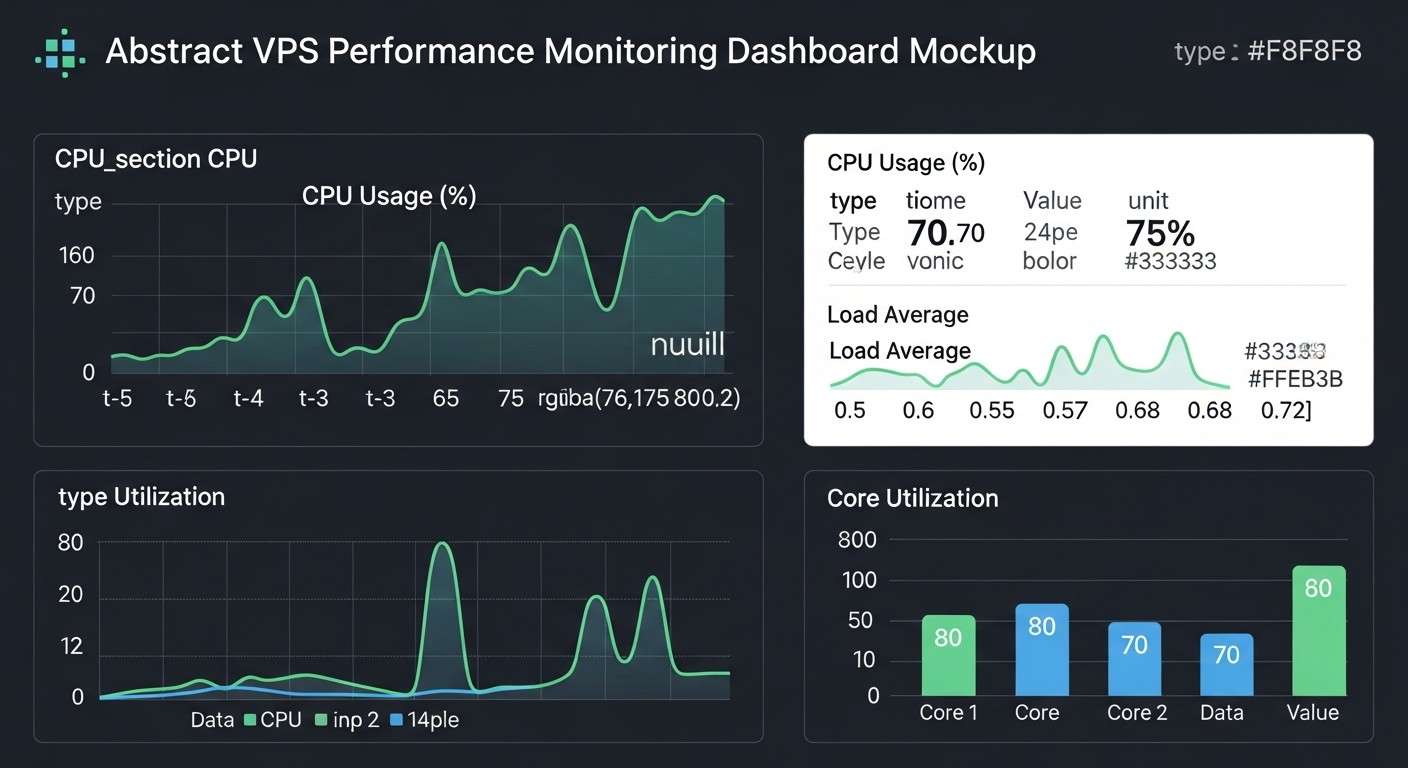

- Grafana трансформирует сырые метрики в наглядные дашборды, делая информацию доступной и понятной для всех членов команды, от инженеров до фаундеров.

- Alertmanager централизованно управляет оповещениями, обеспечивая их группировку, дедупликацию, подавление и маршрутизацию по различным каналам (Slack, Telegram, email, PagerDuty).

- Для эффективного мониторинга VPS критически важно отслеживать CPU, RAM, дисковый ввод/вывод, сетевую активность и специфические метрики приложений, используя Node Exporter и другие экспортеры.

- Оптимизация затрат достигается за счет выбора правильного хостинга, эффективного хранения данных Prometheus и автоматизации развертывания, при этом не стоит экономить на отказоустойчивости системы мониторинга.

- Регулярное тестирование оповещений, актуализация дашбордов и глубокое понимание PromQL — ключевые факторы успеха для стабильной работы продакшн-систем.

1. Введение: Почему мониторинг VPS критичен в 2026 году

В стремительно развивающемся мире информационных технологий, где время простоя сервера измеряется не только в потерянных деньгах, но и в репутационных рисках, качественный мониторинг Virtual Private Server (VPS) становится не просто желательным, а абсолютно необходимым инструментом. К 2026 году, когда микросервисная архитектура и облачные вычисления стали повсеместным стандартом, а ожидания пользователей от доступности сервисов приблизились к 100%, игнорирование мониторинга равносильно управлению самолетом вслепую. Особенно это актуально для стартапов и SaaS-проектов, где каждый час работы сервиса напрямую влияет на бизнес-метрики и лояльность клиентов.

Эта статья адресована широкому кругу технических специалистов: DevOps-инженерам, которые строят и поддерживают инфраструктуру; Backend-разработчикам на Python, Node.js, Go, PHP, стремящимся понимать поведение своих приложений в продакшене; фаундерам SaaS-проектов, для которых стабильность сервиса — залог выживания; системным администраторам, отвечающим за бесперебойную работу серверов; и техническим директорам стартапов, принимающим стратегические решения по стеку технологий. Мы рассмотрим, как связка из трёх мощных и открытых инструментов — Prometheus для сбора метрик, Grafana для их визуализации и Alertmanager для управления оповещениями — позволяет создать надёжную, масштабируемую и экономически эффективную систему мониторинга для любого VPS.

Мы не будем продавать вам «волшебные пилюли» или «революционные методики». Вместо этого, сосредоточимся на практических аспектах: как установить, настроить, поддерживать и оптимизировать эту систему, избегая типичных ошибок и опираясь на реальный опыт. Вы узнаете, какие метрики действительно важны, как правильно их интерпретировать, как настроить умные оповещения, которые не будут спамить, и как использовать данные мониторинга для принятия обоснованных решений, будь то масштабирование инфраструктуры или оптимизация кода. К концу статьи у вас будет полное понимание того, как построить и поддерживать систему мониторинга, которая будет служить вам верой и правдой в условиях постоянно меняющихся требований 2026 года.

2. Основные критерии эффективного мониторинга VPS

Эффективный мониторинг VPS — это не просто сбор любых доступных данных. Это целенаправленный процесс, ориентированный на ключевые метрики, которые напрямую влияют на производительность, стабильность и доступность ваших сервисов. В 2026 году, когда ресурсы VPS стали более гибкими и мощными, но и требования к их утилизации возросли, понимание этих критериев становится ещё более важным.

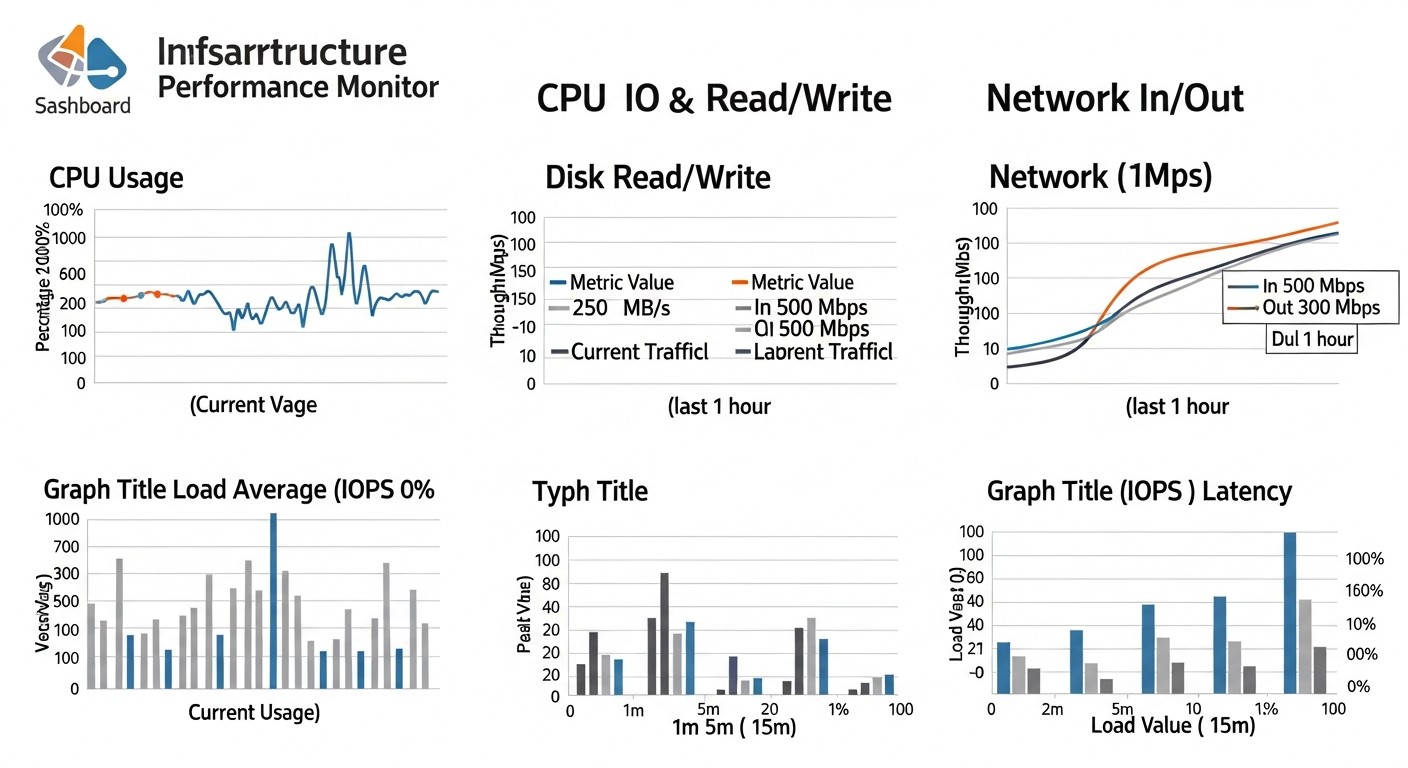

2.1. Загрузка центрального процессора (CPU Utilization)

Метрики CPU — это первое, на что обращают внимание при диагностике проблем. Высокая загрузка CPU может указывать на ресурсоёмкие процессы, бесконечные циклы, неэффективный код или DDoS-атаки. Важно отслеживать не только общую загрузку (node_cpu_seconds_total с различными режимами: idle, user, system, iowait, steal), но и Load Average (node_load1, node_load5, node_load15) — среднее количество процессов, ожидающих выполнения.

idle: Время, когда CPU бездействует. Низкое значение указывает на высокую загрузку.user: Время, когда CPU выполняет пользовательские процессы.system: Время, когда CPU выполняет системные процессы (ядро).iowait: Время, когда CPU ожидает завершения операций ввода/вывода. Высокоеiowaitчасто сигнализирует о проблемах с диском или сетью, а не с самим CPU.steal: (для виртуальных машин) Время, когда виртуальная машина ожидает выделения реального CPU от гипервизора. Высокоеstealможет говорить о перегрузке хост-машины.

Оценивать нужно не только пиковые значения, но и тренды. Например, постоянно растущий load average при стабильном user и system может указывать на проблему с блокировками или нехваткой ресурсов.

2.2. Использование оперативной памяти (RAM Usage)

Нехватка оперативной памяти приводит к использованию свопа (swap), что значительно замедляет работу сервера, поскольку дисковые операции намного медленнее операций с RAM. Мониторинг RAM включает: общее количество памяти, свободную память, используемую память, буферы и кэш (node_memory_MemTotal_bytes, node_memory_MemFree_bytes, node_memory_Buffers_bytes, node_memory_Cached_bytes, node_memory_SwapTotal_bytes, node_memory_SwapFree_bytes). Важно помнить, что Linux активно использует свободную память для кэширования, поэтому низкое значение MemFree не всегда означает проблему, если Buffers и Cached высоки.

Ключевые показатели: процент используемой RAM без учета кэша, процент используемого свопа. Постоянное использование свопа — это явный признак того, что VPS требуется больше RAM или оптимизация потребления памяти приложениями.

2.3. Дисковый ввод/вывод (Disk I/O)

Дисковая подсистема часто становится узким местом, особенно для баз данных, файловых хранилищ или приложений с интенсивной записью/чтением. Метрики для отслеживания: скорость чтения/записи (node_disk_read_bytes_total, node_disk_written_bytes_total), количество операций чтения/записи в секунду (IOPS), время ожидания (latency), утилизация диска (node_disk_io_time_seconds_total). Высокое iowait CPU, как уже упоминалось, часто коррелирует с проблемами дискового I/O.

Важно различать скорость (МБ/с) и количество операций (IOPS), так как для разных задач важны разные показатели. Например, для базы данных критичны IOPS, для файлового сервера — скорость.

2.4. Сетевая активность (Network Activity)

Мониторинг сети включает отслеживание входящего и исходящего трафика (node_network_receive_bytes_total, node_network_transmit_bytes_total), количества пакетов в секунду (PPS), ошибок и отброшенных пакетов (node_network_receive_errs_total, node_network_drop_total). Всплески трафика могут быть нормальными (например, при бэкапах или больших загрузках), но аномально высокий исходящий трафик без видимых причин может указывать на компрометацию сервера или DDoS-атаку с вашего VPS.

Низкая пропускная способность или высокий процент ошибок могут сигнализировать о проблемах на уровне сетевого интерфейса, кабеля, коммутатора или даже на стороне провайдера VPS. В 2026 году, когда большинство VPS поставляются с высокоскоростными сетевыми интерфейсами (10 Гбит/с и выше), важно убедиться, что ваше приложение использует этот ресурс эффективно.

2.5. Запущенные процессы и их состояние (Processes and State)

Количество запущенных процессов (node_procs_running, node_procs_total) и их состояние (sleeping, zombie, uninterruptible) также являются важными индикаторами. Аномально большое количество процессов, особенно зомби-процессов (node_procs_zombie), может свидетельствовать о проблемах с приложением или операционной системой. Мониторинг конкретных процессов, таких как ваш веб-сервер (Nginx, Apache), база данных (PostgreSQL, MySQL) или бэкенд-приложение, на предмет их доступности и потребления ресурсов (CPU, RAM) критически важен.

Для более глубокого анализа процессов можно использовать такие инструменты, как cAdvisor для контейнеров или специализированные экспортеры, которые предоставляют метрики по каждому процессу или группе процессов.

2.6. Доступность и производительность приложений (Application Performance)

Мониторинг инфраструктуры без мониторинга приложений — это полумера. Ваши приложения — это то, что приносит ценность пользователям. Метрики приложений могут включать: количество запросов в секунду (RPS), время ответа (latency), количество ошибок (HTTP 5xx), количество активных пользователей, состояние очередей сообщений, количество открытых соединений к базе данных. Эти метрики часто собираются с помощью специальных экспортеров (например, Nginx exporter, MySQL exporter, Redis exporter) или непосредственно из кода приложения с использованием клиентских библиотек Prometheus.

В 2026 году, когда API-driven подходы и микросервисы доминируют, отслеживание сквозных транзакций и задержек между сервисами становится ключевым для быстрого выявления источника проблемы.

2.7. Свободное место на диске (Disk Space)

Переполнение диска — одна из самых частых причин отказа сервисов. Мониторинг свободного места (node_filesystem_avail_bytes, node_filesystem_size_bytes) на всех критически важных файловых системах (/, /var, /var/log, /home, /opt) должен быть настроен с оповещениями на нескольких уровнях (например, предупреждение при 80% заполнении, критическое при 95%). Это позволяет заранее реагировать, удаляя старые логи, кэши или масштабируя дисковое пространство.

2.8. Статус сетевых сервисов и портов (Network Services Status)

Проверка доступности ключевых сетевых сервисов (HTTP, HTTPS, SSH, PostgreSQL, Redis и т.д.) с помощью Blackbox Exporter позволяет убедиться, что не только VPS работает, но и приложения на нём отвечают. Это внешний взгляд на ваш сервис, имитирующий запрос пользователя или другого сервиса. Важно отслеживать не только доступность (up/down), но и время ответа (latency) этих сервисов.

Каждый из этих критериев важен, и их комплексный анализ позволяет сформировать полную картину здоровья вашего VPS и запущенных на нём приложений. Использование Prometheus и его экспортеров делает сбор этих метрик относительно простым и унифицированным процессом.

3. Сравнительная таблица решений для мониторинга

Выбор системы мониторинга — это стратегическое решение, которое зависит от множества факторов: размера команды, бюджета, сложности инфраструктуры, требований к масштабируемости и гибкости. В 2026 году на рынке представлено множество решений, от полностью управляемых SaaS-платформ до мощных open-source инструментов. Рассмотрим, как Prometheus, Grafana и Alertmanager (PGA-стек) соотносятся с популярными альтернативами, такими как Zabbix и Datadog.

| Критерий | Prometheus + Grafana + Alertmanager (PGA-стек) | Zabbix | Datadog (SaaS) | Netdata (легковесный) |

|---|---|---|---|---|

| Тип решения | Self-hosted, Open Source | Self-hosted, Open Source | SaaS (облачный) | Self-hosted, Open Source |

| Модель сбора метрик | Pull-модель (Prometheus опрашивает экспортеры) | Agent-based (Zabbix-агент отправляет данные) | Agent-based (Datadog-агент отправляет данные) | Agent-based (локальный агент собирает и отдает метрики по HTTP) |

| Гибкость настройки | Высокая. Широкий выбор экспортеров, мощный PromQL, гибкая настройка оповещений в Alertmanager. | Средняя. Множество шаблонов, но кастомные метрики требуют более сложной настройки. | Высокая. Множество интеграций "из коробки", удобный UI для настройки. | Средняя. Много встроенных коллекторов, но кастомные метрики требуют написания плагинов. |

| Масштабируемость | Хорошая. Горизонтальное масштабирование через federated Prometheus, Thanos/Cortex для долгосрочного хранения. | Хорошая. Распределенная архитектура, прокси. | Отличная. Облачная платформа, практически неограниченная масштабируемость. | Ограниченная. Предназначен для мониторинга одного хоста, не кластера. |

| Сложность развертывания | Средняя. Требует понимания компонентов, Docker Compose или Kubernetes упрощает. | Средняя. Требует настройки сервера, базы данных, агентов. | Низкая. Установка агента и настройка в UI. | Очень низкая. Установка одной командой. |

| Стоимость (2026 год, пример) | Низкая (стоимость VPS для хостинга, от $10-30/мес за небольшой сервер + инженерное время). | Низкая (стоимость VPS для хостинга, от $10-30/мес за небольшой сервер + инженерное время). | Высокая (от $15-20/хост/мес + метрики, логи, APM. Для 10 VPS может быть $300-500+/мес). | Низкая (стоимость VPS для хостинга, минимальные требования к ресурсам). |

| Долгосрочное хранение | По умолчанию ограничено (локальное хранилище). Требует интеграции с Thanos/Cortex/VictoriaMetrics для масштабирования и долгосрочного хранения. | Встроенное. Зависит от объема базы данных. | Встроенное, облачное, настраиваемое. | Локальное, очень короткий период (часы/дни) в RAM, опционально на диск. |

| Визуализация | Отличная (Grafana). Мощные дашборды, множество типов графиков, кастомные запросы. | Хорошая. Встроенные графики, карты сети, но менее гибкая, чем Grafana. | Отличная. Богатый UI, множество виджетов, удобные дашборды. | Хорошая. Встроенный веб-интерфейс с множеством графиков в реальном времени. |

| Оповещения | Отличная (Alertmanager). Гибкие правила, группировка, подавление, множество каналов. | Хорошая. Гибкие триггеры, действия, но менее продвинутое управление группами, чем Alertmanager. | Отличная. Интеллектуальные оповещения, машинное обучение, множество каналов. | Базовая. Email, Slack, но без продвинутой логики группировки. |

| Сообщество и поддержка | Активное Open Source сообщество, богатая документация, много готовых решений. | Активное Open Source сообщество, коммерческая поддержка. | Коммерческая поддержка, обширная документация. | Активное Open Source сообщество. |

| Применимость | От малых VPS до крупных кластеров Kubernetes. Идеально для DevOps-ориентированных команд. | От малых VPS до крупных корпоративных инфраструктур. Традиционный выбор для системных администраторов. | От стартапов до крупных предприятий. Отлично для команд, ценящих скорость развертывания и управляемость. | Быстрый локальный мониторинг одного сервера. Отлично для диагностики на месте. |

Как видно из таблицы, PGA-стек предлагает мощное, гибкое и экономически выгодное решение, особенно для команд, готовых инвестировать время в настройку и обслуживание. Его Open Source природа даёт полный контроль над данными и инфраструктурой, что критично для многих фаундеров SaaS и CTO. Datadog выигрывает в скорости развертывания и управляемости, но его стоимость быстро растет с увеличением масштаба. Zabbix — это проверенное временем решение, но его подход к метрикам и визуализации может показаться менее современным по сравнению с Prometheus/Grafana. Netdata же является отличным инструментом для быстрого локального анализа, но не предназначен для централизованного мониторинга кластеров.

В контексте мониторинга VPS, где часто требуется глубокий контроль и оптимизация ресурсов, PGA-стек является идеальным балансом между функциональностью, стоимостью и гибкостью. Он позволяет начать с малого и масштабироваться по мере роста проекта, сохраняя при этом полную прозрачность и контроль над вашей системой мониторинга.

4. Детальный обзор компонентов: Prometheus, Grafana, Alertmanager и экспортеры

Для создания полноценной системы мониторинга VPS нам потребуется не только главная троица, но и ряд вспомогательных компонентов, называемых «экспортерами». Каждый из них выполняет свою уникальную роль, собирая и предоставляя метрики в формате, понятном Prometheus.

4.1. Prometheus: Сердце системы сбора метрик

Prometheus — это мощная система мониторинга и оповещения, разработанная в SoundCloud и ставшая стандартом де-факто для мониторинга контейнеризированных и облачных сред. Его ключевая особенность — это pull-модель: Prometheus сам опрашивает (scrapes) целевые объекты (экспортеры) по HTTP, забирая у них метрики. Это упрощает обнаружение новых целей и управление ими.

Архитектура и принцип работы: Prometheus состоит из нескольких компонентов: основной сервер Prometheus (собирает, хранит и запрашивает метрики), Pushgateway (для ephemeral/batch-jobs), Service Discovery (для автоматического обнаружения целей), и Alertmanager (для обработки оповещений). Метрики хранятся в формате временных рядов (time series) с метками (labels), что делает их невероятно гибкими для запросов и агрегации.

PromQL: Язык запросов Prometheus (PromQL) — это его мощнейшее преимущество. Он позволяет не только выбирать метрики, но и выполнять сложные агрегации, математические операции, фильтрацию по меткам, расчеты скоростей изменения (rate), прогнозирование (predict_linear) и многое другое. Например, запрос sum(rate(node_cpu_seconds_total{mode="idle"}[5m])) by (instance) покажет среднюю загрузку CPU за последние 5 минут по каждой инстанции VPS. Глубокое понимание PromQL критически важно для создания эффективных дашбордов и правил оповещения.

Плюсы: Отличная масштабируемость (через federated, Thanos, Cortex), гибкий язык запросов, активное сообщество, огромное количество готовых экспортеров, низкие накладные расходы на сбор метрик. Идеально подходит для динамических сред.

Минусы: Локальное хранение метрик по умолчанию (требует дополнительных решений для долгосрочного хранения), отсутствие встроенного UI для комплексной визуализации (для этого нужна Grafana), pull-модель может быть неоптимальна для некоторых сценариев (но Pushgateway решает эту проблему).

Для кого подходит: Для DevOps-инженеров и системных администраторов, которым нужен полный контроль над мониторингом, а также для бэкенд-разработчиков, желающих интегрировать метрики своих приложений. Отлично подходит для микросервисов и облачных инфраструктур.

4.2. Grafana: Визуализация данных и создание дашбордов

Grafana — это открытая платформа для аналитики и интерактивной визуализации данных. Она позволяет создавать красивые и информативные дашборды, используя данные из различных источников, включая Prometheus. Grafana не собирает метрики сама, а лишь запрашивает их у настроенных источников данных и отображает в удобном для пользователя виде.

Возможности: Поддержка множества источников данных (Prometheus, InfluxDB, PostgreSQL, Elasticsearch, Zabbix и др.), широкий набор панелей (графики, таблицы, гистограммы, текст, статусные индикаторы), переменные шаблонов (templating) для динамического изменения дашбордов, возможность настройки оповещений (хотя для Prometheus-стека лучше использовать Alertmanager). В 2026 году Grafana продолжает активно развиваться, предлагая новые типы визуализаций, улучшенную производительность и возможности для совместной работы.

Плюсы: Исключительная гибкость визуализации, поддержка PromQL, широкое сообщество, множество готовых дашбордов (Grafana Labs Dashboard Library), возможность совместного использования и разграничения прав доступа.

Минусы: Не является системой сбора метрик, требует отдельной настройки источников данных. Может быть избыточна для очень простых задач, где достаточно командной строки.

Для кого подходит: Для всех, кто хочет наглядно видеть состояние своей инфраструктуры и приложений. От CTO, которым нужны высокоуровневые метрики, до разработчиков, которым важны детали производительности. Фаундеры SaaS могут использовать Grafana для отслеживания ключевых бизнес-метрик.

4.3. Alertmanager: Умное управление оповещениями

Alertmanager — это компонент Prometheus-стека, который обрабатывает оповещения, отправленные сервером Prometheus. Его основная задача — дедупликация, группировка, маршрутизация и подавление оповещений, чтобы ваша команда получала только значимые уведомления, а не шквал однотипных сообщений.

Ключевые функции:

- Группировка: Объединяет похожие оповещения в одно уведомление, чтобы избежать спама. Например, если 10 VPS одновременно превысили порог CPU, Alertmanager отправит одно сообщение о проблеме кластера, а не 10 отдельных.

- Подавление (Inhibition): Позволяет подавлять оповещения, если уже активно более "тяжелое" оповещение. Например, если весь сервер упал, нет смысла получать оповещения о высокой загрузке CPU на этом сервере.

- Отключение (Silences): Временное отключение оповещений для конкретных целей или наборов меток, полезно во время плановых работ или для игнорирования известных временных проблем.

- Маршрутизация: Отправляет оповещения в разные каналы в зависимости от их меток. Например, критические оповещения в PagerDuty, предупреждения в Slack-канал DevOps, а информационные — в email.

Плюсы: Исключительная гибкость в настройке правил оповещения, предотвращение "alert fatigue", поддержка множества интеграций (Slack, Telegram, email, PagerDuty, VictorOps и т.д.), возможность создания сложных цепочек оповещений.

Минусы: Требует тщательной настройки правил для оптимальной работы, может быть сложен для новичков.

Для кого подходит: Для всех, кто не хочет быть завален ненужными оповещениями. Особенно критичен для команд, поддерживающих крупные и сложные системы, где своевременное и релевантное оповещение напрямую влияет на время восстановления сервиса (MTTR).

4.4. Экспортеры: Мосты к метрикам

Экспортеры — это небольшие приложения, которые собирают метрики из различных источников (операционная система, базы данных, веб-серверы, приложения) и предоставляют их в формате Prometheus (по HTTP на порту /metrics). Без экспортеров Prometheus не смог бы собрать данные.

- Node Exporter: Самый важный экспортер для мониторинга VPS. Он собирает метрики операционной системы Linux: CPU, RAM, дисковый I/O, сетевую активность, Load Average, файловые системы, статистику процессов и многое другое. Устанавливается на каждый мониторируемый VPS.

- cAdvisor: Для мониторинга контейнеров Docker. Собирает метрики использования ресурсов (CPU, RAM, сеть, диск) для каждого контейнера, работающего на хосте.

- Blackbox Exporter: Для внешнего мониторинга доступности сервисов. Он может проверять HTTP/HTTPS эндпоинты, TCP-порты, выполнять ICMP-пинги и DNS-запросы. Позволяет мониторить доступность вашего VPS и приложений на нём с точки зрения внешнего мира.

- Pushgateway: Не совсем экспортер, но важный компонент для сбора метрик от короткоживущих (ephemeral) или batch-задач, которые не могут быть опрошены Prometheus. Задачи отправляют свои метрики в Pushgateway, а Prometheus уже опрашивает Pushgateway.

- Специализированные экспортеры: Существует огромное количество экспортеров для конкретных приложений и сервисов:

Nginx exporter,MySQL exporter,PostgreSQL exporter,Redis exporter,MongoDB exporter,RabbitMQ exporterи многие другие. Они позволяют получить глубокие инсайты в работу ваших приложений.

Выбор и правильная настройка экспортеров определяют полноту и детализацию собираемых метрик, что напрямую влияет на эффективность всей системы мониторинга.

5. Практические советы и пошаговые инструкции по развертыванию

Развертывание стека Prometheus, Grafana и Alertmanager на VPS может показаться сложным, но с правильным подходом и использованием Docker Compose этот процесс значительно упрощается. Мы рассмотрим установку всех компонентов на одном VPS, что является типичным сценарием для небольших и средних проектов.

5.1. Подготовка VPS

Перед началом установки убедитесь, что ваш VPS соответствует минимальным требованиям: 2 ядра CPU, 4 ГБ RAM и 50-100 ГБ SSD для Prometheus (в зависимости от объема хранимых метрик). Установите Docker и Docker Compose.

# Обновляем систему

sudo apt update && sudo apt upgrade -y

# Устанавливаем Docker

sudo apt install -y apt-transport-https ca-certificates curl software-properties-common

curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo gpg --dearmor -o /usr/share/keyrings/docker-archive-keyring.gpg

echo "deb [arch=$(dpkg --print-architecture) signed-by=/usr/share/keyrings/docker-archive-keyring.gpg] https://download.docker.com/linux/ubuntu $(lsb_release -cs) stable" | sudo tee /etc/apt/sources.list.d/docker.list > /dev/null

sudo apt update

sudo apt install -y docker-ce docker-ce-cli containerd.io

# Добавляем текущего пользователя в группу docker для работы без sudo

sudo usermod -aG docker $USER

# Выйдите и войдите заново или выполните: newgrp docker

# Устанавливаем Docker Compose (актуальная версия на 2026 год, проверьте на сайте Docker)

# Замените 'v2.x.x' на актуальную версию

sudo mkdir -p ~/.docker/cli-plugins/

curl -SL https://github.com/docker/compose/releases/download/v2.24.5/docker-compose-linux-x86_64 -o ~/.docker/cli-plugins/docker-compose

sudo chmod +x ~/.docker/cli-plugins/docker-compose

# Или для более старых версий (v1.x):

# sudo curl -L "https://github.com/docker/compose/releases/download/1.29.2/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

# sudo chmod +x /usr/local/bin/docker-compose

# Проверяем установки

docker --version

docker compose version

5.2. Структура проекта и конфигурационные файлы

Создадим директорию для проекта и необходимые поддиректории:

mkdir -p monitoring/{prometheus,grafana,alertmanager}

cd monitoring

5.2.1. Конфигурация Prometheus (prometheus/prometheus.yml)

Этот файл определяет, какие цели Prometheus должен опрашивать, как долго хранить данные и какие правила оповещения использовать.

# prometheus/prometheus.yml

global:

scrape_interval: 15s # Как часто Prometheus будет опрашивать цели

evaluation_interval: 15s # Как часто Prometheus будет проверять правила оповещений

# Настройка Alertmanager

alerting:

alertmanagers:

- static_configs:

- targets:

- alertmanager:9093 # Имя сервиса и порт Alertmanager в Docker Compose

# Правила оповещений

rule_files:

- "/etc/prometheus/alert.rules.yml" # Путь к файлу с правилами оповещений

# Цели для сбора метрик

scrape_configs:

# Мониторинг самого Prometheus

- job_name: 'prometheus'

static_configs:

- targets: ['localhost:9090']

# Мониторинг Node Exporter (на этом же VPS)

- job_name: 'node_exporter'

static_configs:

- targets: ['localhost:9100'] # Порт Node Exporter

# Мониторинг других VPS (пример)

# - job_name: 'remote_vps_node_exporter'

# static_configs:

# - targets: ['your_remote_vps_ip:9100'] # Замените на IP удаленного VPS

# labels:

# environment: production

# datacenter: fra1

5.2.2. Правила оповещений Prometheus (prometheus/alert.rules.yml)

Здесь определяются условия, при которых Prometheus должен сгенерировать алерт и отправить его в Alertmanager.

# prometheus/alert.rules.yml

groups:

- name: node_alerts

rules:

- alert: HighCPUUsage

expr: 100 - (avg by (instance) (rate(node_cpu_seconds_total{mode="idle"}[5m])) * 100) > 85

for: 5m

labels:

severity: warning

annotations:

summary: "Высокая загрузка CPU на {{ $labels.instance }}"

description: "Загрузка CPU на {{ $labels.instance }} превышает 85% более 5 минут. Текущее значение: {{ $value | humanize }}%."

- alert: LowDiskSpace

expr: node_filesystem_avail_bytes{fstype="ext4",mountpoint="/"} / node_filesystem_size_bytes{fstype="ext4",mountpoint="/"} * 100 < 10

for: 2m

labels:

severity: critical

annotations:

summary: "Мало места на диске на {{ $labels.instance }}"

description: "Осталось менее 10% свободного места на диске {{ $labels.mountpoint }} на {{ $labels.instance }}. Текущее значение: {{ $value | humanize }}%."

- alert: HighMemoryUsage

expr: (node_memory_MemTotal_bytes - (node_memory_MemFree_bytes + node_memory_Buffers_bytes + node_memory_Cached_bytes)) / node_memory_MemTotal_bytes * 100 > 90

for: 5m

labels:

severity: warning

annotations:

summary: "Высокое потребление памяти на {{ $labels.instance }}"

description: "Использование RAM на {{ $labels.instance }} превышает 90% более 5 минут. Текущее значение: {{ $value | humanize }}%."

- alert: ServerDown

expr: up == 0

for: 1m

labels:

severity: critical

annotations:

summary: "Сервер {{ $labels.instance }} недоступен"

description: "Цель {{ $labels.instance }} недоступна для Prometheus более 1 минуты."

5.2.3. Конфигурация Alertmanager (alertmanager/alertmanager.yml)

Этот файл определяет, куда и как Alertmanager должен отправлять оповещения.

# alertmanager/alertmanager.yml

global:

resolve_timeout: 5m # Время, в течение которого алерт считается "активным" после исчезновения

route:

group_by: ['alertname', 'instance'] # Группируем оповещения по имени алерта и инстанции

group_wait: 30s # Ждем 30 секунд, прежде чем отправить первое оповещение из группы

group_interval: 5m # Интервал между повторными оповещениями для той же группы

repeat_interval: 4h # Интервал повтора оповещений, если проблема не решена

# Дефолтный ресивер для всех алертов

receiver: 'default-receiver'

routes:

# Пример маршрутизации для критических алертов в PagerDuty

- match:

severity: 'critical'

receiver: 'pagerduty-receiver'

continue: true # Продолжаем обработку другими роутами

# Пример маршрутизации для warning алертов в Slack

- match:

severity: 'warning'

receiver: 'slack-receiver'

receivers:

- name: 'default-receiver'

# Fallback, если ни один другой роут не сработал. Можно настроить на почту.

email_configs:

- to: 'your_email@example.com' # Замените на ваш email

from: 'alertmanager@yourdomain.com'

smarthost: 'smtp.yourdomain.com:587' # Пример SMTP-сервера

auth_username: 'your_smtp_username'

auth_password: 'your_smtp_password'

require_tls: true

- name: 'slack-receiver'

slack_configs:

- channel: '#devops-alerts' # Замените на ваш Slack-канал

api_url: 'https://hooks.slack.com/services/T00000000/B00000000/XXXXXXXXXXXXXXXXXXXXXXXX' # Замените на ваш Webhook URL

send_resolved: true

title: '{{ .CommonLabels.alertname }} on {{ .CommonLabels.instance }} ({{ .Status | toUpper }})'

text: '{{ range .Alerts }}*Summary:* {{ .Annotations.summary }}\n*Description:* {{ .Annotations.description }}\n*Severity:* {{ .Labels.severity }}\n*Starts At:* {{ .StartsAt.Format "2006-01-02 15:04:05 MST" }}\n{{ end }}'

- name: 'pagerduty-receiver'

pagerduty_configs:

- service_key: 'YOUR_PAGERDUTY_SERVICE_INTEGRATION_KEY' # Замените на ваш ключ PagerDuty

severity: '{{ .CommonLabels.severity }}'

description: '{{ .CommonLabels.alertname }} on {{ .CommonLabels.instance }} ({{ .Status | toUpper }})'

5.2.4. Конфигурация Grafana

Для Grafana можно использовать стандартный файл grafana/grafana.ini, но чаще всего достаточно настроек по умолчанию или переменных окружения в Docker Compose. Основные настройки, которые могут потребоваться, это административный логин/пароль и источник данных Prometheus.

Для сохранения данных Grafana (дашборды, пользователи) создадим пустую директорию grafana/data.

5.3. Docker Compose файл (docker-compose.yml)

Объединяем все компоненты в один файл docker-compose.yml в корневой директории monitoring:

# docker-compose.yml

version: '3.8'

volumes:

prometheus_data: {}

grafana_data: {}

alertmanager_data: {}

services:

prometheus:

image: prom/prometheus:v2.49.1 # Актуальная версия на 2026 год

container_name: prometheus

ports:

- "9090:9090"

volumes:

- ./prometheus/prometheus.yml:/etc/prometheus/prometheus.yml

- ./prometheus/alert.rules.yml:/etc/prometheus/alert.rules.yml

- prometheus_data:/prometheus

command:

- '--config.file=/etc/prometheus/prometheus.yml'

- '--storage.tsdb.path=/prometheus'

- '--web.console.libraries=/usr/share/prometheus/console_libraries'

- '--web.console.templates=/usr/share/prometheus/consoles'

- '--storage.tsdb.retention.time=30d' # Хранить данные 30 дней

restart: unless-stopped

depends_on:

- alertmanager

grafana:

image: grafana/grafana:10.3.3 # Актуальная версия на 2026 год

container_name: grafana

ports:

- "3000:3000"

volumes:

- grafana_data:/var/lib/grafana

environment:

- GF_SECURITY_ADMIN_USER=admin

- GF_SECURITY_ADMIN_PASSWORD=your_strong_password # ОБЯЗАТЕЛЬНО СМЕНИТЕ!

- GF_SERVER_ROOT_URL=http://localhost:3000 # Или ваш домен/IP

restart: unless-stopped

depends_on:

- prometheus

alertmanager:

image: prom/alertmanager:v0.27.0 # Актуальная версия на 2026 год

container_name: alertmanager

ports:

- "9093:9093"

- "9094:9094" # Для UDP

volumes:

- ./alertmanager/alertmanager.yml:/etc/alertmanager/alertmanager.yml

- alertmanager_data:/alertmanager

command:

- '--config.file=/etc/alertmanager/alertmanager.yml'

- '--storage.path=/alertmanager'

restart: unless-stopped

node_exporter:

image: prom/node-exporter:v1.7.0 # Актуальная версия на 2026 год

container_name: node_exporter

ports:

- "9100:9100"

command:

- '--path.rootfs=/host'

volumes:

- /:/host:ro,rslave # Монтируем корневую ФС хоста

network_mode: host # Используем сетевой стек хоста для доступа к метрикам

restart: unless-stopped

5.4. Запуск системы мониторинга

После создания всех файлов, запустите Docker Compose в директории monitoring:

docker compose up -d

Проверьте статус контейнеров:

docker compose ps

5.5. Настройка Grafana

1. Откройте Grafana в браузере: http://your_vps_ip:3000. Войдите с логином admin и паролем your_strong_password.

2. Добавьте Prometheus как источник данных:

- Перейдите в Configuration (шестерёнка слева) -> Data Sources.

- Нажмите "Add data source" -> "Prometheus".

- В поле "URL" введите

http://prometheus:9090(так как Prometheus и Grafana находятся в одной Docker-сети, они видят друг друга по именам сервисов). - Нажмите "Save & Test". Должно появиться сообщение "Data Source is working".

3. Импортируйте готовый дашборд для Node Exporter:

- Перейдите в Dashboards (квадратик с графиками) -> Import.

- В поле "Import via grafana.com" введите ID:

1860(или другой актуальный ID для Node Exporter Full). - Выберите Prometheus как источник данных и нажмите "Import".

Теперь у вас должен быть полноценный дашборд, отображающий метрики вашего VPS.

5.6. Расширенный мониторинг: Blackbox Exporter

Для мониторинга доступности внешних сервисов или самого VPS извне, добавьте Blackbox Exporter в docker-compose.yml:

blackbox_exporter:

image: prom/blackbox-exporter:v0.25.0 # Актуальная версия на 2026 год

container_name: blackbox_exporter

ports:

- "9115:9115"

volumes:

- ./blackbox/blackbox.yml:/etc/blackbox_exporter/config.yml

command:

- '--config.file=/etc/blackbox_exporter/config.yml'

restart: unless-stopped

Создайте файл blackbox/blackbox.yml:

# blackbox/blackbox.yml

modules:

http_2xx:

prober: http

http:

preferred_ip_protocol: "ipv4"

no_follow_redirects: false

tls_config:

insecure_skip_verify: true # В продакшене лучше использовать валидные сертификаты

icmp:

prober: icmp

icmp:

preferred_ip_protocol: "ipv4"

И добавьте в prometheus/prometheus.yml новую цель для Blackbox Exporter. Например, для проверки доступности вашего сайта:

- job_name: 'blackbox_http'

metrics_path: /probe

params:

module: [http_2xx]

static_configs:

- targets:

- 'https://your_website.com' # Замените на URL вашего сайта

- 'http://your_vps_ip:80' # Или IP вашего VPS

relabel_configs:

- source_labels: [__address__]

target_label: __param_target

- source_labels: [__param_target]

target_label: instance

- target_label: __address__

replacement: blackbox_exporter:9115 # Адрес Blackbox Exporter

После изменения docker-compose.yml и prometheus.yml, перезапустите сервисы:

docker compose up -d --no-deps prometheus blackbox_exporter

docker compose restart prometheus

Теперь Prometheus будет опрашивать Blackbox Exporter, который, в свою очередь, будет проверять доступность вашего сайта или других сервисов. Можно добавить алерт, например, alert: WebsiteDown, если probe_success == 0.

Эти шаги закладывают основу для мощной и гибкой системы мониторинга. Помните, что это лишь отправная точка. Дальнейшая настройка будет включать создание кастомных дашбордов, более сложных правил оповещения и интеграцию с метриками ваших приложений.

6. Типичные ошибки при настройке и эксплуатации мониторинга

Даже при наличии мощных инструментов, таких как Prometheus, Grafana и Alertmanager, ошибки в их настройке и эксплуатации могут свести на нет все преимущества. Зная наиболее распространённые ловушки, можно значительно повысить эффективность вашей системы мониторинга.

6.1. Отсутствие мониторинга самой системы мониторинга (Self-monitoring)

Парадоксально, но одна из самых частых и критичных ошибок — это не мониторить сам стек Prometheus. Если сервер Prometheus упадет, вы не узнаете ни о состоянии ваших VPS, ни о падении самого Prometheus. Важно настроить мониторинг доступности Prometheus, Grafana и Alertmanager. Prometheus по умолчанию собирает метрики о самом себе (job_name: 'prometheus'). Для Alertmanager и Grafana также можно использовать Blackbox Exporter для проверки их HTTP-эндпоинтов, а для Alertmanager — его собственные метрики.

Как избежать: Включите в prometheus.yml таргеты для самого Prometheus, Alertmanager, и Blackbox Exporter. Настройте базовые алерты на up == 0 для этих компонентов. Рассмотрите возможность развертывания минимального "сторожевого" Prometheus на отдельном VPS или использование внешнего сервиса пинг-мониторинга для оповещения, если основной Prometheus недоступен.

6.2. "Alert Fatigue" — перегрузка оповещениями

Если ваша команда получает сотни оповещений в день, большая часть из которых не требует немедленного внимания или является ложноположительной, это приводит к "усталости от алертов". Инженеры начинают игнорировать оповещения, что может привести к пропуску действительно критических проблем. Это одна из главных причин, почему Alertmanager так важен.

Как избежать:

- Тщательно настройте пороги: Начинайте с высоких порогов и постепенно снижайте их, основываясь на реальной производительности ваших систем.

- Используйте

forв Prometheus: Указывайтеfor: 5m(или другое время), чтобы алерт срабатывал только после того, как условие держится в течение указанного периода. Это отфильтровывает кратковременные всплески. - Используйте группировку и подавление в Alertmanager: Объединяйте похожие алерты, подавляйте менее важные, если есть более критичные.

- Разделяйте серьезность (severity): Определите уровни (

info,warning,critical) и маршрутизируйте их в разные каналы. "Info" может идти в Slack-канал, "warning" в Telegram, "critical" в PagerDuty. - Регулярно пересматривайте правила: Удаляйте алерты, которые постоянно срабатывают без реальной проблемы.

6.3. Неправильное использование PromQL и неэффективные запросы

PromQL — мощный, но сложный язык. Неправильные запросы могут приводить к неточным метрикам, высокой нагрузке на Prometheus или даже к его падению. Например, использование sum() без by() может агрегировать слишком много данных, а rate() на слишком коротком интервале может быть слишком "шумным".

Как избежать:

- Изучите PromQL: Потратьте время на понимание функций

rate(),irate(),increase(), агрегационных операторов (sum,avg,max,min) и операторов сопоставления (on,group_left,group_right). - Тестируйте запросы: Используйте UI Prometheus для проверки запросов перед добавлением их в Grafana или правила оповещения.

- Будьте внимательны с метками: Высокая кардинальность (слишком много уникальных комбинаций меток) может привести к проблемам с производительностью и хранением. Избегайте использования меток с уникальными значениями, такими как ID сессий или IP-адреса клиентов.

6.4. Отсутствие долгосрочного хранения метрик

По умолчанию Prometheus хранит метрики локально в течение ограниченного времени (обычно 15-30 дней). Этого может быть недостаточно для анализа долгосрочных трендов, ретроспективного анализа инцидентов или аудита. Попытка хранить данные локально на одном VPS в течение года и более может привести к нехватке дискового пространства и деградации производительности.

Как избежать:

- Используйте удаленное хранилище: Интегрируйте Prometheus с решениями для долгосрочного хранения, такими как Thanos, Cortex или VictoriaMetrics. Эти системы позволяют хранить метрики в S3-совместимых хранилищах (например, MinIO, AWS S3, Yandex Object Storage), масштабировать запросы и обеспечить высокую доступность.

- Управляйте политиками хранения: Определите, какие метрики и как долго должны храниться. Возможно, для некоторых метрик достаточно 30 дней, для других — год.

6.5. Недостаточное документирование и отсутствие Runbooks

Даже самая совершенная система мониторинга бесполезна, если команда не знает, как ею пользоваться, или что делать при срабатывании алертов. Отсутствие документации по дашбордам, алертам и процедурам реагирования (runbooks) приводит к панике и долгому восстановлению.

Как избежать:

- Документируйте дашборды: Добавляйте описания к панелям и дашбордам в Grafana, объясняя, что показывают метрики и что означают различные значения.

- Создавайте Runbooks: Для каждого важного алерта создайте "Runbook" — пошаговую инструкцию о том, что нужно проверить, какие команды выполнить и к кому обратиться при срабатывании оповещения. Это можно интегрировать прямо в описание алерта в Prometheus.

- Проводите обучение: Регулярно обучайте новых членов команды работе с системой мониторинга.

6.6. Игнорирование безопасности

Открытие портов Prometheus, Grafana и Alertmanager в интернет без должной защиты — серьезная уязвимость. Через Grafana можно получить доступ к вашим метрикам, а через Prometheus — к данным о вашей инфраструктуре. Незащищенный Alertmanager может быть использован для спама или подделки оповещений.

Как избежать:

- Используйте фаервол: Ограничьте доступ к портам 9090 (Prometheus), 3000 (Grafana), 9093 (Alertmanager) только для доверенных IP-адресов или вашей внутренней сети.

- Настройте обратный прокси: Используйте Nginx или Caddy с HTTPS и базовой аутентификацией (Basic Auth) или OAuth для доступа к Grafana и Alertmanager.

- Используйте сильные пароли: Для Grafana используйте сложный административный пароль и регулярно его меняйте.

- Включите TLS: Настройте TLS для всех компонентов, если они доступны извне.

Избегая этих распространенных ошибок, вы сможете построить действительно надежную, полезную и управляемую систему мониторинга, которая будет помогать вашей команде поддерживать стабильность и производительность ваших VPS и приложений в 2026 году и далее.

7. Чеклист для практического применения системы мониторинга

Этот чеклист поможет вам убедиться, что ваша система мониторинга на базе Prometheus, Grafana и Alertmanager настроена правильно и эффективно работает. Проходите по нему регулярно, особенно после крупных изменений в инфраструктуре или развертывания новых сервисов.

- Подготовка VPS:

- [ ] Выделен достаточный объем CPU, RAM и SSD для всех компонентов мониторинга.

- [ ] Установлены Docker и Docker Compose (актуальных версий на 2026 год).

- [ ] Открыты необходимые порты в фаерволе (9090 для Prometheus, 3000 для Grafana, 9093 для Alertmanager) или настроен обратный прокси.

- Базовая установка компонентов (Docker Compose):

- [ ] Созданы директории для конфигураций и данных (

prometheus,grafana,alertmanager). - [ ] Файл

docker-compose.ymlнастроен с актуальными образами Prometheus, Grafana, Alertmanager, Node Exporter. - [ ] Тома Docker настроены для постоянного хранения данных (

prometheus_data,grafana_data,alertmanager_data). - [ ] Установлен сильный пароль для администратора Grafana.

- [ ] Созданы директории для конфигураций и данных (

- Конфигурация Prometheus (

prometheus.yml):- [ ]

scrape_intervalиevaluation_intervalнастроены оптимально (15-30 секунд). - [ ] Настроен

alertingи указан адрес Alertmanager. - [ ] Указан путь к

rule_files. - [ ] Добавлен

job_name: 'prometheus'для самомониторинга. - [ ] Добавлен

job_name: 'node_exporter'для мониторинга локального VPS. - [ ] Установлен разумный

--storage.tsdb.retention.time(например, 30-90 дней).

- [ ]

- Правила оповещений Prometheus (

alert.rules.yml):- [ ] Созданы базовые алерты для CPU (

HighCPUUsage), RAM (HighMemoryUsage), диска (LowDiskSpace). - [ ] Настроен алерт на недоступность сервера (

ServerDown). - [ ] Для каждого алерта указан

for(например,5m) для предотвращения ложных срабатываний. - [ ] Добавлены

severity(critical, warning, info) для каждого алерта. - [ ] Созданы информативные

summaryиdescriptionдля каждого алерта.

- [ ] Созданы базовые алерты для CPU (

- Конфигурация Alertmanager (

alertmanager.yml):- [ ] Настроены

routeсgroup_by,group_wait,group_interval,repeat_interval. - [ ] Определены

receiverдля всех необходимых каналов (Slack, Telegram, Email, PagerDuty). - [ ] Настроены специфичные

routesдля разных уровнейseverity. - [ ] Проверены и протестированы все интеграции с мессенджерами/сервисами оповещения.

- [ ] Настроены

- Настройка Grafana:

- [ ] Prometheus добавлен как источник данных с URL

http://prometheus:9090. - [ ] Импортирован готовый дашборд для Node Exporter (например, ID 1860).

- [ ] Созданы или импортированы дашборды для мониторинга приложений и других экспортеров.

- [ ] Настроены права доступа для пользователей Grafana.

- [ ] Prometheus добавлен как источник данных с URL

- Дополнительные экспортеры:

- [ ] Установлен и настроен

Node Exporterна каждом мониторируемом VPS. - [ ] Установлен и настроен

Blackbox Exporterдля внешнего мониторинга доступности сервисов. - [ ] Установлены и настроены специализированные экспортеры для ваших приложений (Nginx, MySQL, Redis и т.д.).

- [ ] Все новые экспортеры добавлены в

prometheus.yml.

- [ ] Установлен и настроен

- Тестирование и валидация:

- [ ] Проверена доступность всех веб-интерфейсов (Prometheus:9090, Grafana:3000, Alertmanager:9093).

- [ ] В Prometheus UI (Status -> Targets) все цели помечены как

UP. - [ ] В Prometheus UI (Alerts) проверены активные алерты.

- [ ] Проверена отправка тестовых оповещений через Alertmanager.

- [ ] Проверена корректность отображения метрик на дашбордах Grafana.

- [ ] Инициированы тестовые ситуации (например, искусственно загружен CPU), чтобы проверить срабатывание алертов.

- Безопасность:

- [ ] Порты мониторинга закрыты от внешнего мира или защищены обратным прокси с аутентификацией.

- [ ] Используются сложные пароли для Grafana и любых других аутентификационных данных.

- [ ] Настроен HTTPS для доступа к Grafana и Alertmanager, если они доступны из интернета.

- Документация и процедуры:

- [ ] Созданы Runbooks для критических алертов.

- [ ] Документированы важные дашборды и их назначение.

- [ ] Команда ознакомлена с работой системы мониторинга и процедурами реагирования.

- Оптимизация и масштабирование:

- [ ] Рассмотрены решения для долгосрочного хранения метрик (Thanos, Cortex, VictoriaMetrics).

- [ ] Проведен анализ кардинальности метрик для предотвращения проблем с производительностью Prometheus.

- [ ] Регулярно пересматриваются и оптимизируются правила оповещений.

Следуя этому чеклисту, вы значительно повысите надежность и эффективность вашей системы мониторинга, что позволит вам быстро реагировать на инциденты и принимать обоснованные решения для развития ваших проектов.

8. Расчет стоимости и экономика владения системой мониторинга

При выборе и развертывании системы мониторинга, особенно для стартапов и SaaS-проектов, экономический аспект играет не меньшую роль, чем технические возможности. Хотя Prometheus, Grafana и Alertmanager являются Open Source, их развертывание и поддержка не бесплатны. Рассмотрим основные статьи расходов и способы их оптимизации к 2026 году.

8.1. Основные статьи расходов

8.1.1. Стоимость VPS для системы мониторинга

Это, пожалуй, самая очевидная статья расходов. Для хостинга Prometheus, Grafana и Alertmanager требуется отдельный VPS. Требования к нему зависят от объема собираемых метрик (количества целей, частоты сбора, длительности хранения).

- Небольшой проект (1-5 VPS, 1000-5000 метрик): 2 CPU, 4 ГБ RAM, 50-100 ГБ SSD. Стоимость у провайдеров типа Hetzner, DigitalOcean, Vultr может составлять от $10 до $30 в месяц в 2026 году.

- Средний проект (10-30 VPS, 10 000-50 000 метрик): 4 CPU, 8-16 ГБ RAM, 200-500 ГБ SSD. Стоимость: $40 до $100 в месяц.

- Крупный проект (50+ VPS, 100 000+ метрик): Требует распределенной архитектуры (Thanos/Cortex/VictoriaMetrics), что увеличивает сложность и стоимость, но позволяет сэкономить на центральном сервере Prometheus. Стоимость может быть $150+ в месяц только за инфраструктуру мониторинга, не считая S3-хранилища.

8.1.2. Стоимость хранения метрик (S3-совместимые хранилища)

Если вы планируете долгосрочное хранение метрик (более 30-90 дней), вам потребуется удаленное хранилище, обычно S3-совместимое. Это может быть AWS S3, Google Cloud Storage, Yandex Object Storage или свой MinIO-кластер.

- AWS S3 (Standard Storage): ~$0.023 за ГБ в месяц.

- Yandex Object Storage: ~$0.019 за ГБ в месяц.

- MinIO (self-hosted): Стоимость дисков и VPS для MinIO.

Для проекта, генерирующего 100 000 метрик в секунду (это много), объем хранения может достигать 100-200 ГБ в день, что за год составит 36-72 ТБ. Это очень дорого. Поэтому важно агрегировать метрики для долгосрочного хранения или хранить только самые важные.

8.1.3. Инженерное время (самая большая скрытая стоимость)

Это самая значительная и часто недооцениваемая статья расходов. Внедрение, настройка, поддержка, обновление и отладка системы мониторинга требуют квалифицированного инженерного времени.

- Начальная настройка: От 1-2 дней для базового стека на одном VPS до нескольких недель для комплексной распределенной системы.

- Поддержка и оптимизация: От нескольких часов в неделю для небольшого проекта до полной ставки DevOps-инженера для крупного.

- Разработка кастомных экспортеров и дашбордов: Зависит от сложности ваших приложений.

Средняя ставка DevOps-инженера в 2026 году составляет $60-100+ в час. Даже 10 часов в месяц на поддержку — это $600-1000. Это значительно больше, чем стоимость VPS.

8.1.4. Стоимость оповещений (SMS, PagerDuty)

Если вы используете платные каналы оповещения, такие как SMS-шлюзы или сервисы типа PagerDuty, VictorOps, это также добавляет к расходам.

- PagerDuty: От $10-20 за пользователя в месяц.

- SMS-шлюзы: От $0.01 до $0.05 за SMS, в зависимости от региона и провайдера.

Для небольших команд обычно достаточно бесплатных каналов, таких как Slack, Telegram, email.

8.2. Сравнительная таблица стоимости (приблизительно на 2026 год)

Примерные расчеты для SaaS-проекта с 10 VPS, 20 000 метрик, 1 год хранения данных, 2 DevOps-инженера.

| Статья расхода | Prometheus + Grafana + Alertmanager (Self-hosted) | Datadog (SaaS) |

|---|---|---|

| VPS для мониторинга (1 шт.) | $50/мес * 12 = $600/год | Включено в стоимость SaaS |

| Хранение метрик (Thanos/S3, 1ТБ/год) | $20/мес * 12 = $240/год | Включено в стоимость SaaS (зависит от объема) |

| Стоимость агентов на 10 VPS | Бесплатно (Node Exporter) | $15/хост/мес * 10 хостов * 12 = $1800/год |

| APM/Логи/Профилирование (аналог) | Бесплатно (OpenTelemetry, Loki, Pyroscope) + доп. VPS | $30/хост/мес * 10 хостов * 12 = $3600/год |

| Инженерное время (настройка/поддержка, 20 ч/мес) | $80/час * 20 ч/мес * 12 = $19200/год | $80/час * 10 ч/мес * 12 = $9600/год (меньше за счет управляемости) |

| Оповещения (PagerDuty) | $20/мес * 2 инженера * 12 = $480/год | $20/мес * 2 инженера * 12 = $480/год |

| ИТОГО (приблизительно) | ~$20720/год | ~$15480/год |

Примечание: Эти цифры очень приблизительны и могут сильно варьироваться. Для Datadog цена может быть значительно выше при использовании всех функций (APM, Security, Synthetics). Для self-hosted решений стоимость инженерного времени является доминирующей.

8.3. Как оптимизировать затраты

Несмотря на то, что инженерное время — это самая большая статья расходов, инвестиции в него окупаются в долгосрочной перспективе за счет глубокого понимания системы и возможности кастомизации.

- Выбирайте оптимальный хостинг: Для VPS под мониторинг не всегда нужен дорогой облачный провайдер. Часто достаточно недорогих VDS у провайдеров с хорошей репутацией.

- Оптимизируйте хранение метрик:

- Уменьшайте

retention.timeв Prometheus, если не нужны старые данные. - Используйте downsampling (агрегацию) для старых метрик при долгосрочном хранении (например, в Thanos/Cortex).

- Избегайте высокой кардинальности меток, которая раздувает размер базы данных Prometheus.

- Уменьшайте

- Автоматизируйте развертывание: Используйте Ansible, Terraform, Puppet или Chef для автоматической установки и настройки Prometheus-стека. Это сократит время на начальную настройку и последующие обновления.

- Используйте готовые решения: Не переизобретайте колесо. Используйте готовые экспортеры, дашборды Grafana и правила оповещений из сообщества.

- Обучайте команду: Чем больше членов команды умеют работать с системой мониторинга, тем меньше нагрузка на одного инженера, и тем быстрее решаются проблемы.

- Оценивайте SaaS vs. Self-hosted: Для очень маленьких проектов с ограниченными инженерными ресурсами SaaS-решения могут быть выгоднее на старте. Но по мере роста и увеличения числа хостов, self-hosted Prometheus-стек становится значительно более экономичным, особенно если у вас есть внутренняя экспертиза.

В 2026 году тенденция к Open Source решениям для мониторинга остается сильной, поскольку они дают полный контроль над данными и позволяют избежать "вендор-лока". Правильное управление затратами на инфраструктуру и инженерное время позволит вам создать мощную и экономически эффективную систему мониторинга.

9. Кейсы и примеры реального применения

Теория важна, но на практике ценность системы мониторинга раскрывается в реальных сценариях. Рассмотрим несколько кейсов, демонстрирующих, как Prometheus, Grafana и Alertmanager помогают решать типовые проблемы DevOps-инженеров и разработчиков.

9.1. Кейс 1: Малый SaaS-проект — предотвращение перегрузки базы данных

Ситуация: Небольшой SaaS-проект, предоставляющий аналитику для e-commerce, работает на одном VPS с PostgreSQL, Nginx и Node.js-бэкендом. Внезапно пользователи начинают жаловаться на медленную работу сервиса, а иногда и на ошибки 500. Проект только начинает расти, и каждый клиент на счету.

Решение с PGA-стеком:

- Установка экспортеров: На VPS были установлены

Node Exporter(для общих метрик ОС),PostgreSQL Exporter(для метрик базы данных) иNginx Exporter. - Настройка Prometheus: Prometheus был настроен на сбор метрик со всех экспортеров.

- Дашборды Grafana: Созданы дашборды:

- "VPS Overview" (CPU, RAM, Disk I/O, Network с Node Exporter).

- "PostgreSQL Health" (активные соединения, блокировки, медленные запросы, кэш-хиты из PostgreSQL Exporter).

- "Nginx Performance" (количество запросов, время ответа, ошибки 5xx из Nginx Exporter).

- Правила Alertmanager: Настроены следующие алерты:

PostgreSQLHighActiveConnections: Если количество активных соединений к PostgreSQL превышает 80% от лимита в течение 5 минут (severity: warning).PostgreSQLSlowQueries: Если среднее время выполнения запросов растет на 20% в течение 10 минут (severity: warning).Nginx5xxErrors: Если количество 5xx ошибок Nginx превышает 5% от общего числа запросов в течение 1 минуты (severity: critical).

Результат: После настройки системы мониторинга, во время пиковой нагрузки, сработал алерт PostgreSQLHighActiveConnections. Инженер, получив оповещение в Slack, сразу же открыл дашборд "PostgreSQL Health" и увидел, что количество соединений действительно приближается к лимиту, а также наблюдается рост медленных запросов. Анализ логов и метрик показал, что один из аналитических отчетов, запускаемый по расписанию, создавал чрезмерную нагрузку на базу данных. Разработчики оперативно оптимизировали запрос и перенесли его выполнение на менее нагруженное время. Проблема была решена до того, как она привела к полному отказу сервиса, сохранив лояльность клиентов и предотвратив репутационные потери.

9.2. Кейс 2: Развивающийся проект с микросервисами — обнаружение "молчаливого" сбоя

Ситуация: Проект вырос до нескольких VPS, на которых развернуты микросервисы (например, на Node.js и Go) в Docker-контейнерах. Один из сервисов, отвечающий за обработку фоновых задач (например, отправку уведомлений), начал работать некорректно: задачи ставятся в очередь, но не обрабатываются, при этом сам контейнер "жив" и не выдает явных ошибок.

Решение с PGA-стеком:

- Интеграция метрик приложения: Разработчики интегрировали клиентскую библиотеку Prometheus в код Node.js и Go сервисов. Добавлены кастомные метрики:

app_queue_size: Количество задач в очереди.app_processed_tasks_total: Общее количество обработанных задач.app_worker_status: Статус воркера (0 - неактивен, 1 - активен).

- cAdvisor для контейнеров: Установлен

cAdvisorдля сбора метрик использования ресурсов каждого контейнера. - Дашборды и алерты:

- Дашборд "Microservice Health" с графиками

app_queue_sizeиrate(app_processed_tasks_total[1m]). - Алерт

BackgroundTaskQueueStalled: Еслиapp_queue_size> 100 иrate(app_processed_tasks_total[5m]) == 0(т.е. очередь растет, а задач не обрабатывается) в течение 5 минут (severity: critical). - Алерт

WorkerInactive: Еслиapp_worker_status == 0в течение 1 минуты (severity: warning).

- Дашборд "Microservice Health" с графиками

Результат: В один из дней, когда произошло обновление сторонней библиотеки, один из воркеров фоновых задач завис, но не упал. Он продолжал потреблять минимальные ресурсы, и Node Exporter не видел проблем. Однако, через 5 минут сработал алерт BackgroundTaskQueueStalled. Разработчики сразу увидели растущую очередь и нулевую скорость обработки задач на дашборде. Быстро проверив логи, они обнаружили, что воркер застрял на обработке некорректного сообщения. Сервис был перезапущен, некорректное сообщение удалено из очереди, и работа возобновилась. Этот кейс демонстрирует, как мониторинг специфичных для приложения метрик позволяет обнаружить проблемы, которые не видны на уровне ОС, и предотвратить потерю данных или задержки в обработке.

9.3. Кейс 3: Оптимизация затрат и ресурсов — выявление неэффективного использования RAM

Ситуация: Фаундер SaaS-проекта обеспокоен растущими счетами за VPS. Инфраструктура состоит из нескольких однотипных VPS, и есть подозрение, что некоторые из них избыточно провизионированы.

Решение с PGA-стеком:

- Сбор метрик: На всех VPS активно собираются метрики

Node Exporter(особенноnode_memory_MemTotal_bytes,node_memory_MemFree_bytes,node_memory_Buffers_bytes,node_memory_Cached_bytes). - Аналитический дашборд Grafana: Создан дашборд "Resource Utilization Overview", который показывает агрегированные и индивидуальные графики использования CPU, RAM, Disk I/O для всех VPS. Использованы PromQL-запросы для вычисления реальной используемой памяти (Total - Free - Buffers - Cache).

- Долгосрочное хранение: Настроено долгосрочное хранение метрик RAM в Thanos для анализа трендов за последние 6 месяцев.

Результат: Анализ дашбордов Grafana и долгосрочных трендов показал, что 3 из 5 VPS постоянно используют менее 30% выделенной RAM, даже в пиковые часы. После консультации с разработчиками выяснилось, что эти VPS были провизионированы с запасом "на всякий случай". На основе этих данных, было принято решение уменьшить объем RAM на этих трех VPS с 8 ГБ до 4 ГБ. Это привело к немедленной экономии $60 в месяц (примерно $720 в год) без какого-либо негативного влияния на производительность сервиса. Мониторинг позволил принять обоснованное решение по оптимизации инфраструктуры, превратив "смутные подозрения" в конкретные цифры и действия.

Эти кейсы демонстрируют, что PGA-стек — это не просто набор инструментов, а полноценная система, которая позволяет не только реагировать на проблемы, но и активно предотвращать их, оптимизировать ресурсы и принимать стратегические решения, основанные на данных.

10. Инструменты и ресурсы для продвинутого мониторинга

Помимо основных компонентов Prometheus, Grafana и Alertmanager, существует обширная экосистема инструментов и ресурсов, которые могут значительно расширить возможности вашей системы мониторинга. В 2026 году эти инструменты продолжают развиваться, предлагая новые способы сбора, анализа и визуализации данных.

10.1. Дополнительные утилиты для работы с Prometheus

- Promtool: Встроенная утилита командной строки для Prometheus, используемая для проверки конфигурационных файлов (

promtool check config) и правил оповещений (promtool check rules). Незаменимый инструмент для отладки. - PromLens / PromQL Editor: Расширенные редакторы PromQL, предлагающие автодополнение, подсветку синтаксиса, визуализацию дерева запросов и другие функции, упрощающие написание сложных запросов. Некоторые из них интегрированы в Grafana.

- Prometheus Operator: Для тех, кто использует Kubernetes, Prometheus Operator автоматизирует развертывание, настройку и управление Prometheus и Alertmanager. Значительно упрощает жизнь в контейнерных средах.

10.2. Инструменты для долгосрочного хранения и масштабирования

Как упоминалось ранее, Prometheus по умолчанию не предназначен для неограниченного долгосрочного хранения. Для этого существуют специализированные решения:

- Thanos: Набор компонентов, который превращает несколько экземпляров Prometheus в глобально масштабируемую систему мониторинга с долгосрочным хранением в объектном хранилище (S3). Позволяет запросить метрики из нескольких Prometheus серверов, агрегировать их и хранить исторические данные.

- Cortex: Другой проект для создания горизонтально масштабируемого, высокодоступного, мультиарендного хранилища метрик Prometheus. Также использует S3 для долгосрочного хранения.

- VictoriaMetrics: Высокопроизводительная, масштабируемая и экономичная база данных временных рядов, совместимая с Prometheus. Может использоваться как удаленное хранилище для Prometheus, так и как самостоятельный Prometheus-совместимый сервер сбора метрик.

Выбор между Thanos, Cortex и VictoriaMetrics зависит от вашей инфраструктуры, требований к масштабируемости и предпочтений команды. В 2026 году все три решения активно развиваются и предлагают зрелые функции.

10.3. Мониторинг логов и трассировки

Мониторинг метрик — это только часть картины. Для полного понимания состояния системы необходимы также логи и трассировка (tracing).

- Loki (Log aggregation): Проект от Grafana Labs, который позиционируется как "Prometheus для логов". Loki индексирует только метки из логов, а не их содержимое, что делает его очень эффективным и экономичным. Интегрируется с Grafana через плагин Loki. Для сбора логов используется агент Promtail.

- ELK Stack (Elasticsearch, Logstash, Kibana): Традиционное решение для сбора, хранения и анализа логов. Мощное, но более ресурсоемкое и сложное в управлении, чем Loki.

- Grafana Tempo (Distributed Tracing): Система для сбора и хранения трассировок, которая также интегрируется с Grafana. Позволяет отслеживать путь запроса через множество микросервисов, выявляя узкие места и задержки.

- OpenTelemetry: Универсальный стандарт для сбора телеметрии (метрики, логи, трассировки) из приложений. Позволяет инструментировать код один раз и отправлять данные в различные бэкенды (Prometheus, Loki, Tempo, Jaeger и т.д.). В 2026 году OpenTelemetry становится де-факто стандартом для инструментирования приложений.

10.4. Полезные ссылки и документация

- Официальная документация Prometheus: Исчерпывающий источник информации по всем аспектам Prometheus.

- Официальная документация Grafana: Подробные руководства по настройке дашбордов, источников данных и другим функциям.

- Официальная документация Alertmanager: Все о группировке, маршрутизации и интеграциях оповещений.

- Grafana Labs Dashboard Library: Огромная коллекция готовых дашбордов, которые можно импортировать и адаптировать под свои нужды.

- Awesome Prometheus: Курируемый список экспортеров, инструментов, статей и ресурсов, связанных с Prometheus.

- PromLabs Blog: Блог от экспертов Prometheus с глубокими статьями о PromQL, архитектуре и лучших практиках.

- Robust Perception Blog: Еще один отличный ресурс с высококачественными статьями по Prometheus.

Активное использование этих ресурсов и инструментов позволит вам построить не просто систему мониторинга, а полноценную платформу observability, которая даст глубокое понимание ваших систем и поможет принимать более обоснованные решения.

11. Troubleshooting: Решение типовых проблем

Даже при самой тщательной настройке в работе системы мониторинга могут возникать проблемы. Знание распространенных сценариев и методов их диагностики поможет вам быстро восстановить работоспособность или найти корень проблемы.

11.1. Prometheus не собирает метрики (Targets DOWN)

Симптомы: В веб-интерфейсе Prometheus (http://your_vps_ip:9090/targets) один или несколько таргетов отображаются как DOWN.

Возможные причины и решения:

- Недоступность экспортера:

- Проверка: Попробуйте получить метрики напрямую из браузера или с помощью

curl:curl http://target_ip:exporter_port/metrics(например,http://localhost:9100/metricsдля Node Exporter). Если ответ не получен или ошибка 404/500, то проблема в самом экспортере. - Решение: Проверьте, запущен ли контейнер/процесс экспортера (

docker psилиsystemctl status node_exporter). Посмотрите логи экспортера (docker logs node_exporter). Убедитесь, что экспортер слушает на правильном порту.

- Проверка: Попробуйте получить метрики напрямую из браузера или с помощью

- Проблемы с сетью/фаерволом:

- Проверка: Убедитесь, что Prometheus может достучаться до экспортера. Если Prometheus и экспортер на разных хостах, проверьте сетевую связность (

ping target_ip) и правила фаервола (sudo ufw statusили правила облачного провайдера). - Решение: Откройте необходимый порт (например, 9100 для Node Exporter) на хосте с экспортером для IP-адреса Prometheus-сервера.

- Проверка: Убедитесь, что Prometheus может достучаться до экспортера. Если Prometheus и экспортер на разных хостах, проверьте сетевую связность (

- Ошибка в конфигурации Prometheus:

- Проверка: Запустите

promtool check config /etc/prometheus/prometheus.yml. Проверьте секциюscrape_configsвprometheus.ymlна опечатки в адресах или портах. - Решение: Исправьте конфигурацию, перезапустите Prometheus (

docker compose restart prometheus).

- Проверка: Запустите

11.2. Grafana не отображает данные или выдает ошибки

Симптомы: Дашборды пустые, графики не строятся, появляются ошибки типа "Cannot connect to Prometheus" или "No data points".

Возможные причины и решения:

- Prometheus недоступен:

- Проверка: Убедитесь, что Prometheus запущен и доступен по адресу, указанному в настройках источника данных Grafana (

http://prometheus:9090, если в Docker Compose). Попробуйте перейти в браузере по этому адресу. - Решение: Если Prometheus недоступен, см. раздел "Prometheus не собирает метрики".

- Проверка: Убедитесь, что Prometheus запущен и доступен по адресу, указанному в настройках источника данных Grafana (

- Неправильный PromQL запрос:

- Проверка: Откройте панель Grafana в режиме редактирования, скопируйте PromQL запрос и вставьте его в веб-интерфейс Prometheus (

http://your_vps_ip:9090/graph). Посмотрите, возвращает ли он данные. - Решение: Исправьте PromQL запрос. Убедитесь, что метрики с такими лейблами вообще существуют (используйте автодополнение в Prometheus UI).

- Проверка: Откройте панель Grafana в режиме редактирования, скопируйте PromQL запрос и вставьте его в веб-интерфейс Prometheus (

- Проблемы с источником данных Grafana:

- Проверка: В Grafana перейдите в Configuration -> Data Sources -> Prometheus. Нажмите "Save & Test". Если есть ошибка, она будет отображена.

- Решение: Исправьте URL, проверьте сетевую связность между Grafana и Prometheus контейнерами.

11.3. Alertmanager не отправляет оповещения

Симптомы: Prometheus показывает активные алерты, но уведомления не приходят в Slack, Telegram или на почту.

Возможные причины и решения:

- Проблема с конфигурацией Alertmanager:

- Проверка: Запустите

promtool check config /etc/alertmanager/alertmanager.yml. Проверьте веб-интерфейс Alertmanager (http://your_vps_ip:9093/#/alerts), чтобы увидеть, какие алерты он получил от Prometheus. Проверьте секциюreceiversиroutes. - Решение: Исправьте синтаксис, проверьте правильность Webhook URL, API-ключей. Перезапустите Alertmanager (

docker compose restart alertmanager).

- Проверка: Запустите

- Проблемы с интеграцией (Slack, Telegram, email):

- Проверка: Для Slack/Telegram Webhook URL: попробуйте отправить тестовый запрос с помощью

curl. Для email: проверьте настройки SMTP-сервера, логи Alertmanager на предмет ошибок подключения к SMTP. - Решение: Убедитесь, что Webhook URL или SMTP-настройки корректны и не истекли. Проверьте спам-папку для email.

- Проверка: Для Slack/Telegram Webhook URL: попробуйте отправить тестовый запрос с помощью

- Алерты подавляются/группируются:

- Проверка: В веб-интерфейсе Alertmanager проверьте вкладки "Silences" и "Inhibitions". Возможно, алерт попадает под правило подавления или отключен вручную.

- Решение: Удалите ненужные silences/inhibitions. Пересмотрите правила

group_by,group_wait,group_interval,repeat_intervalвalertmanager.yml.

11.4. Высокая нагрузка на Prometheus-сервер

Симптомы: Prometheus потребляет много CPU или RAM, диск быстро заполняется, запросы PromQL выполняются медленно.

Возможные причины и решения:

- Высокая кардинальность метрик:

- Проверка: В Prometheus UI перейдите в Status -> TSDb Status. Посмотрите на количество серий (Series) и их рост. Если количество серий очень велико (миллионы) и быстро растет, это указывает на высокую кардинальность.

- Решение: Пересмотрите экспортеры, чтобы избежать меток с уникальными значениями (UUID, ID сессий, полные URL с параметрами). Используйте

relabel_configsвprometheus.ymlдля фильтрации или переписывания меток.

- Частый сбор метрик:

- Проверка: Проверьте

scrape_intervalвprometheus.yml. - Решение: Увеличьте

scrape_intervalдля менее критичных целей (например, до 60 секунд).

- Проверка: Проверьте

- Слишком долгое хранение данных:

- Проверка: Проверьте

--storage.tsdb.retention.timeв команде запуска Prometheus. - Решение: Уменьшите время хранения или рассмотрите внедрение Thanos/Cortex/VictoriaMetrics для долгосрочного хранения.

- Проверка: Проверьте

- Неэффективные запросы в Grafana:

- Проверка: Если нагрузка повышается при открытии определенных дашбордов, значит, проблема в них.

- Решение: Оптимизируйте PromQL запросы в Grafana. Используйте

sum by (...)вместоsum(), если нужно агрегировать по меткам.

11.5. Когда обращаться в поддержку

Если вы исчерпали все возможности самостоятельной диагностики, и проблема не решается, возможно, пришло время обратиться за помощью:

- К провайдеру VPS: Если есть подозрения на проблемы с железом VPS, сетевой связностью на уровне датацентра, или если ваш VPS недоступен на уровне ОС.

- К сообществу Prometheus/Grafana: Для общих вопросов по конфигурации, сложным PromQL запросам или архитектурным решениям. Используйте форумы, Slack-каналы или Stack Overflow.

- К экспертам/консультантам: Для сложных, нестандартных задач, аудита существующей системы, или если у вашей команды нет достаточного опыта в Prometheus-стеке. Это может быть платная услуга, но часто окупается за счет быстрого решения проблемы и получения экспертизы.

Помните, что логи — ваш лучший друг. Всегда начинайте диагностику с просмотра логов соответствующих компонентов (Prometheus, Grafana, Alertmanager, экспортеры) через docker logs или journalctl -u .

12. FAQ: Часто задаваемые вопросы о Prometheus, Grafana и Alertmanager

12.1. В чем основное отличие Prometheus от Zabbix?

Основное отличие заключается в модели сбора метрик и подходе к ним. Prometheus использует pull-модель (сам опрашивает цели) и ориентирован на временные ряды с метками, что обеспечивает высокую гибкость запросов с помощью PromQL. Zabbix использует push-модель (агенты отправляют данные) и более традиционный подход к мониторингу, основанный на элементах данных и триггерах. Prometheus лучше подходит для динамических облачных и контейнерных сред, Zabbix — для более статичных корпоративных инфраструктур.

12.2. Сколько дискового пространства нужно для Prometheus?

Потребление дискового пространства Prometheus сильно зависит от количества собираемых метрик (серий), частоты их сбора и длительности хранения. Ориентировочно, для 10 000 активных серий метрик, собираемых каждые 15 секунд, и хранении данных в течение 30 дней, потребуется около 50-100 ГБ. Для более крупных систем или длительного хранения потребуется значительно больше, поэтому рекомендуется использовать удаленные хранилища типа Thanos/Cortex/VictoriaMetrics с S3.

12.3. Как мониторить логи с помощью Prometheus-стека?

Prometheus не предназначен для сбора логов. Для этого используется отдельный инструмент, такой как Loki от Grafana Labs (часто называют "Prometheus для логов"). Loki собирает логи с помощью агента Promtail, индексирует их по меткам (аналогично Prometheus) и позволяет запрашивать их через Grafana. Альтернативы включают ELK Stack (Elasticsearch, Logstash, Kibana) или другие централизованные системы логирования.

12.4. Можно ли мониторить Docker-контейнеры?

Да, Prometheus отлично подходит для мониторинга Docker-контейнеров. Наиболее распространенный способ — использовать cAdvisor (Container Advisor), который собирает и экспортирует метрики использования ресурсов (CPU, RAM, сеть, диск) для каждого контейнера, работающего на хосте. Эти метрики затем собираются Prometheus, а визуализируются в Grafana.

12.5. Как обеспечить высокую доступность системы мониторинга?

Для высокой доступности Prometheus можно использовать несколько подходов:

- Два экземпляра Prometheus: Запускать два независимых экземпляра Prometheus, собирающих одни и те же метрики.

- Thanos/Cortex/VictoriaMetrics: Эти решения изначально спроектированы для высокой доступности и горизонтального масштабирования, используя объектное хранилище как единую точку правды.

- Alertmanager: Запускать Alertmanager в кластере, чтобы избежать единой точки отказа для оповещений.

- Grafana: Запускать Grafana в кластере и использовать общую базу данных для хранения конфигурации.

12.6. Какие лучшие практики для написания PromQL запросов?

Основные лучшие практики PromQL:

- Используйте

rate()илиirate()для счетчиков (counters). - Избегайте высокой кардинальности меток.

- Используйте

by()для агрегации по конкретным меткам. - Тестируйте запросы в Prometheus UI перед добавлением в Grafana/алерты.

- Документируйте сложные запросы.

- Используйте

sum(rate(...))для агрегации метрик по всем экземплярам.

12.7. Как мониторить внешние сервисы (например, доступность сайта)?

Для мониторинга внешних сервисов используется Blackbox Exporter. Он позволяет проверять HTTP/HTTPS эндпоинты, TCP-порты, выполнять ICMP-пинги и DNS-запросы. Prometheus опрашивает Blackbox Exporter, передавая ему цель для проверки, а Blackbox Exporter возвращает метрики о доступности и времени ответа этой цели.

12.8. Можно ли использовать Prometheus для бизнес-метрик?

Да, Prometheus отлично подходит для сбора и анализа бизнес-метрик. Вы можете инструментировать свои приложения, используя клиентские библиотеки Prometheus, для экспорта таких метрик, как количество регистраций, активных пользователей, выполненных транзакций, средний чек и т.д. Затем эти метрики можно визуализировать в Grafana и настроить на них алерты.

12.9. Как обновлять компоненты Prometheus-стека?

Если вы используете Docker Compose, обновление компонентов довольно просто:

- Измените теги образов в

docker-compose.ymlна новые версии. - Выполните

docker compose pullдля загрузки новых образов. - Выполните

docker compose up -dдля перезапуска контейнеров с новыми образами.

12.10. Какие ресурсы нужны для мониторинга в 2026 году?

В 2026 году требования к ресурсам для мониторинга продолжают расти из-за увеличения объема данных и сложности систем. Для среднего VPS с 10-20 целями и 30-дневным хранением, рекомендуется иметь минимум 4 CPU, 8 ГБ RAM и 200 ГБ SSD. Для более крупных систем или использования долгосрочного хранения с Thanos/Cortex/VictoriaMetrics, требуются дополнительные ресурсы для этих компонентов и объектного хранилища.

13. Заключение: Ваши следующие шаги к надежному мониторингу

В 2026 году, когда стабильность и производительность сервисов являются краеугольным камнем любого успешного проекта, особенно для SaaS-бизнесов и развивающихся стартапов, надёжная система мониторинга — это не просто опция, а абсолютная необходимость. Мы подробно рассмотрели, как связка Prometheus для сбора метрик, Grafana для их визуализации и Alertmanager для умного управления оповещениями формирует мощное, гибкое и экономически эффективное решение для мониторинга VPS и приложений.