Резервное копирование VPS: комплексные стратегии и инструменты для 2026 года

TL;DR

- Стратегия "3-2-1-1-0" остается золотым стандартом: 3 копии, 2 разных носителя, 1 вне площадки, 1 офлайн/иммутабельная, 0 ошибок при восстановлении.

- Автоматизация и оркестрация с использованием инструментов вроде Ansible, Terraform и Kubernetes-операторов критически важны для масштабируемости и надежности в 2026 году.

- Неизменяемое (Immutable) хранилище и версиирование бэкапов – основной барьер против программ-вымогателей и случайного удаления.

- Тестирование восстановления должно быть регулярным, автоматизированным и включать полный цикл проверки целостности данных, а не просто наличие файлов.

- Гибридные стратегии (локальные снапшоты + облачное хранилище) предлагают оптимальный баланс скорости восстановления и долгосрочной надежности.

- Стоимость бэкапа в 2026 году смещается от прямой цены за ТБ к стоимости за операцию, пропускную способность и уровень сервиса (SLA) восстановления.

- Безопасность бэкапов включает шифрование "в покое" и "в пути", строгий контроль доступа (IAM, MFA) и изоляцию сетей хранения.

Введение: Почему резервное копирование VPS критически важно в 2026 году

В стремительно развивающемся цифровом ландшафте 2026 года, где бизнес-процессы все глубже интегрированы с облачными технологиями и виртуальными частными серверами (VPS), вопрос резервного копирования перешел из категории "желательно" в "абсолютно необходимо". VPS стали основой для бесчисленных SaaS-проектов, микросервисных архитектур, высоконагруженных бэкендов и критически важных корпоративных приложений. Однако, с ростом сложности инфраструктуры и объема данных, увеличиваются и риски их потери.

Почему же эта тема приобретает особую актуальность именно сейчас? Во-первых, угрозы кибербезопасности, в частности, программы-вымогатели (ransomware), становятся все более изощренными и целенаправленными. Обычные бэкапы, не защищенные от модификации или удаления, могут быть скомпрометированы вместе с основной системой, делая восстановление невозможным. Во-вторых, человеческий фактор остается главной причиной сбоев: ошибочные команды, неправильные конфигурации, случайное удаление данных. В-третьих, аппаратные сбои, хоть и реже, чем раньше, все еще случаются, а проблемы с хостинг-провайдером (даже у самых надежных) могут привести к недоступности или потере данных. Наконец, регуляторные требования к хранению и защите данных (GDPR, CCPA, HIPAA и их новые итерации) становятся строже, и отсутствие адекватных стратегий бэкапа может обернуться серьезными штрафами и репутационными потерями.

Эта статья адресована широкому кругу технических специалистов: DevOps-инженерам, которые отвечают за надежность и автоматизацию инфраструктуры; Backend-разработчикам (Python, Node.js, Go, PHP), чьи приложения генерируют и обрабатывают критически важные данные; фаундерам SaaS-проектов, для которых потеря данных клиентов равносильна краху бизнеса; системным администраторам, управляющим десятками и сотнями VPS; и техническим директорам стартапов, принимающим стратегические решения о технологическом стеке и безопасности. Мы рассмотрим комплексные подходы, актуальные инструменты и практические рекомендации, которые помогут вам построить отказоустойчивую и безопасную систему резервного копирования для ваших VPS в 2026 году.

Цель этой статьи — не просто перечислить инструменты, а предоставить глубокое понимание принципов, помочь выбрать оптимальную стратегию, исходя из ваших потребностей и бюджета, а также дать конкретные инструкции по внедрению и эксплуатации. Мы избегаем маркетингового буллшита, фокусируясь на реальных кейсах, цифрах и проверенных практиках.

Основные критерии и факторы выбора стратегии резервного копирования

Выбор оптимальной стратегии резервного копирования для VPS — это не просто выбор инструмента, а комплексное решение, которое должно учитывать множество факторов. В 2026 году эти факторы стали еще более критичными из-за возросших требований к доступности, безопасности и эффективности. Рассмотрим ключевые критерии, по которым следует оценивать любую систему бэкапа.

Recovery Point Objective (RPO) и Recovery Time Objective (RTO)

RPO (Целевая точка восстановления) определяет максимально допустимый объем данных, который может быть потерян в случае сбоя. Если ваш RPO составляет 1 час, это означает, что вы готовы потерять данные, созданные в течение последнего часа. Чем ниже RPO (например, 5 минут или почти нулевой), тем чаще должны выполняться резервные копии. Для критически важных систем, где каждая транзакция имеет значение (например, финансовые сервисы), RPO стремится к нулю. Это достигается за счет непрерывного резервного копирования (CDP) или очень частых инкрементальных бэкапов.

RTO (Целевое время восстановления) определяет максимально допустимое время, в течение которого система или приложение должны быть восстановлены после сбоя. Если ваш RTO составляет 4 часа, это означает, что ваш бизнес может позволить себе простой не более четырех часов. Чем ниже RTO (например, несколько минут), тем быстрее должна быть возможность восстановить данные и запустить сервисы. Это требует быстрых механизмов восстановления, таких как моментальные снимки (snapshots) или репликация, а также хорошо отработанных процедур восстановления.

Почему это важно: RPO и RTO — это краеугольные камни любой стратегии аварийного восстановления. Они напрямую влияют на выбор технологий, частоту бэкапов и, как следствие, на стоимость. Определение этих метрик должно начинаться с анализа бизнес-требований и потенциальных потерь от простоя. Например, для блога RPO может быть 24 часа, а RTO — 8 часов, тогда как для онлайн-магазина эти значения могут составлять 15 минут и 1 час соответственно.

Стоимость (Cost)

Стоимость резервного копирования включает не только прямые расходы на хранение данных, но и множество скрытых затрат. В 2026 году, когда объемы данных экспоненциально растут, оптимизация затрат становится приоритетом.

- Хранение данных: Цена за гигабайт в месяц. Облачные провайдеры предлагают разные классы хранилищ (Standard, Infrequent Access, Archive), которые значительно отличаются по стоимости и скорости доступа.

- Трафик: Стоимость исходящего трафика (egress fees) из облачного хранилища может быть существенной, особенно при частом восстановлении или репликации между регионами. Входящий трафик обычно бесплатен.

- Операции: Многие облачные хранилища взимают плату за операции чтения/записи (PUT/GET запросы). При большом количестве мелких файлов или частых инкрементальных бэкапах эти расходы могут накапливаться.

- Лицензии ПО: Стоимость проприетарного ПО для бэкапа (например, Veeam, Acronis) может быть значительной.

- Администрирование и поддержка: Время инженеров, затраченное на настройку, мониторинг, тестирование и устранение проблем, является существенной статьей расходов. Автоматизация позволяет сократить эти затраты.

Как оценивать: Всегда рассчитывайте общую стоимость владения (TCO) на несколько лет, учитывая рост данных и потенциальные операции восстановления. Не забывайте про стоимость простоя в случае сбоя, которая может многократно превысить затраты на бэкап.

Безопасность (Security)

В 2026 году безопасность резервных копий является не менее, а зачастую и более важной, чем безопасность основной системы. Скомпрометированные бэкапы могут быть использованы для вымогательства или утечки конфиденциальных данных.

- Шифрование: Данные должны быть зашифрованы как "в покое" (at rest) на хранилище, так и "в пути" (in transit) во время передачи. Используйте сильные алгоритмы (AES-256) и управляйте ключами шифрования.

- Контроль доступа (IAM): Строгое управление доступом к хранилищу бэкапов. Используйте принцип наименьших привилегий, многофакторную аутентификацию (MFA) и ролевой доступ (RBAC).

- Иммутабельность (Immutable Storage): Возможность сделать бэкап неизменяемым на определенный период. Это предотвращает удаление или изменение копий программами-вымогателями или злоумышленниками.

- Изоляция сети: Разделение сети бэкапов от основной производственной сети.

- Аудит и логирование: Все операции с бэкапами должны логироваться и быть доступны для аудита.

Как оценивать: Проверяйте соответствие стандартам безопасности (ISO 27001, SOC 2 Type 2) и лучшим практикам. Убедитесь, что ваш провайдер или выбранное решение поддерживает необходимые меры защиты.

Масштабируемость (Scalability)

Ваша система резервного копирования должна расти вместе с вашим бизнесом и объемом данных без значительных перестроек архитектуры.

- Объем данных: Система должна легко обрабатывать растущие объемы данных. Облачные хранилища по своей природе масштабируемы, но локальные решения могут требовать апгрейда оборудования.

- Количество VPS: Возможность легко добавлять новые VPS в систему бэкапа, желательно с автоматическим обнаружением и настройкой.

- Производительность: Система должна поддерживать необходимую скорость бэкапа и восстановления даже при пиковых нагрузках.

Как оценивать: Планируйте на 3-5 лет вперед. Какие объемы данных вы ожидаете? Сколько VPS будет у вас через год, три, пять? Убедитесь, что выбранное решение может справиться с этим ростом без существенных затрат на перестройку.

Простота использования и администрирования (Simplicity & Management)

Сложная система бэкапа — это система, которая рано или поздно даст сбой или будет заброшена. Простота снижает вероятность человеческих ошибок.

- Автоматизация: Максимальная автоматизация процессов бэкапа, восстановления и тестирования.

- Интерфейс: Интуитивно понятный интерфейс (GUI) или хорошо документированный API/CLI для управления.

- Мониторинг и оповещения: Интеграция с системами мониторинга (Prometheus, Grafana, Zabbix) и оповещениями (Slack, PagerDuty) о статусе бэкапов.

- Документация: Четкая и актуальная документация по всем процедурам.

Как оценивать: Проведите пилотное внедрение. Насколько легко настроить бэкап для нового VPS? Насколько быстро можно восстановить данные? Сколько времени уходит на ежедневный мониторинг?

Целостность данных (Data Integrity)

Основная цель бэкапа — гарантировать, что восстановленные данные будут идентичны исходным и работоспособны.

- Проверки контрольных сумм: Автоматические проверки контрольных сумм при создании и восстановлении бэкапов.

- Верификация: Регулярное тестирование восстановления (см. ниже) — единственный надежный способ проверить целостность.

- Обнаружение повреждений: Механизмы обнаружения повреждений данных на хранилище.

Как оценивать: Убедитесь, что ваше решение включает механизмы верификации и что вы регулярно их используете.

Географическое распределение (Geographic Distribution)

Хранение копий данных в разных географических локациях защищает от региональных катастроф (пожары, наводнения, землетрясения) и крупных сбоев в дата-центрах.

- Несколько регионов: Хранение хотя бы одной копии бэкапа в другом регионе или даже у другого провайдера. Это ключевой элемент стратегии "3-2-1".

- Скорость передачи: Учитывайте пропускную способность и задержки при передаче данных между регионами.

Как оценивать: Определите критичность данных. Для большинства SaaS-проектов хранение копии в соседнем регионе является хорошим компромиссом. Для высококритичных данных может потребоваться хранение на разных континентах.

Тестирование восстановления (Recovery Testing)

Бэкап, который не был протестирован, считается несуществующим. Регулярное тестирование — это не опция, а обязательный элемент.

- Автоматизация тестирования: Создание изолированных сред для автоматического развертывания бэкапов и проверки их работоспособности (например, запуск приложения, проверка доступности API).

- Частота: Зависит от RPO/RTO и критичности данных, но не реже одного раза в месяц, а для критичных систем — еженедельно.

- Полный цикл: Тестирование не только восстановления файлов, но и полной функциональности системы/приложения.

Как оценивать: Включите тестирование восстановления в ваши CI/CD пайплайны или настройте отдельные автоматизированные задачи. Ведите журнал результатов тестирования.

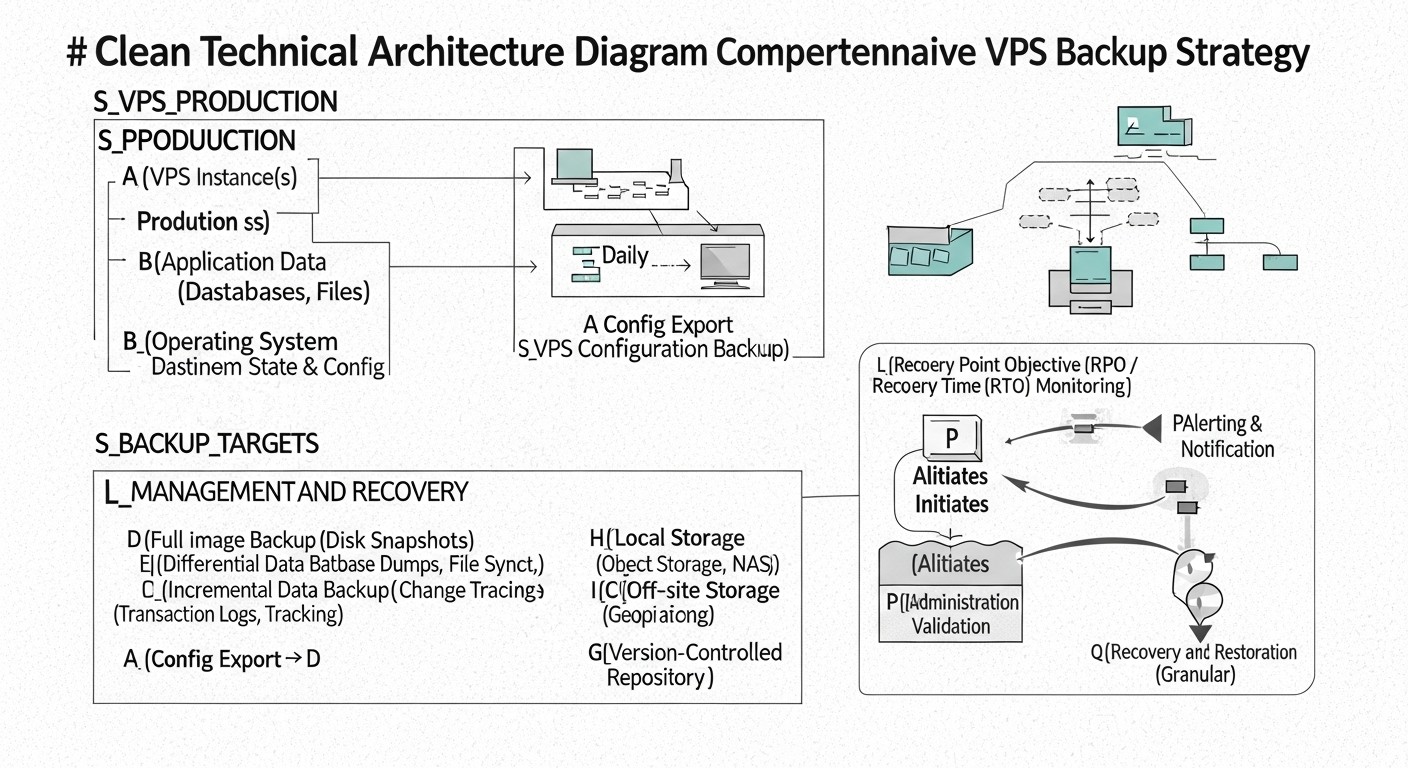

Сравнительная таблица: Основные подходы к резервному копированию VPS

В 2026 году существует множество подходов к резервному копированию VPS, каждый из которых имеет свои преимущества и недостатки. Выбор зависит от ваших RPO/RTO, бюджета, требований к безопасности и сложности инфраструктуры. Ниже представлена сравнительная таблица наиболее популярных и актуальных стратегий.

| Критерий | Снапшоты VPS (Провайдерские) | Агентное резервное копирование (File/Block-level) | Бэкап баз данных (Dump/Replication) | Синхронизация файлов (rsync/S3 CLI) | Облачное резервное копирование как сервис (BaaS) | Репликация дисков/образов (DRBD/ZFS send/receive) |

|---|---|---|---|---|---|---|

| RPO (Целевая точка восстановления) | Низкий (часто 1-4 часа, зависит от провайдера) | Очень низкий (от 5 минут до 1 часа) | Очень низкий (от 0 до 15 минут) | Средний (от 1 до 24 часов) | Низкий (от 15 минут до 4 часов) | Очень низкий (почти нулевой, синхронная репликация) |

| RTO (Целевое время восстановления) | Очень низкий (5-30 минут для восстановления всего VPS) | Средний (1-4 часа для восстановления данных, дольше для VPS) | Низкий (30-60 минут для базы данных) | Высокий (4-12 часов для восстановления данных) | Низкий (1-2 часа для восстановления VPS/данных) | Очень низкий (переключение на реплику за 5-30 минут) |

| Сложность настройки | Низкая (несколько кликов в панели) | Средняя (установка агента, настройка расписания) | Средняя (скрипты, cron, мониторинг) | Низкая (базовые скрипты rsync) | Низкая (установка агента, веб-интерфейс) | Высокая (настройка ядра, сети, синхронизации) |

| Стоимость (ориентировочно 2026 г., за VPS/мес) | $5-$20 (зависит от объема диска и провайдера) | $10-$50 (зависит от объема, провайдера BaaS или собственного хранилища) | $0-$15 (только хранение, если свой скрипт) | $0-$10 (только хранение) | $20-$100 (зависит от объема, функций, SLA) | $0-$20 (только хранение, если свой скрипт) + стоимость второго VPS |

| Гибкость восстановления | Низкая (восстановление всего образа VPS) | Высокая (отдельные файлы, каталоги, полная система) | Высокая (отдельные таблицы, point-in-time recovery) | Высокая (отдельные файлы/каталоги) | Высокая (отдельные файлы, полная система, bare-metal) | Низкая (восстановление всего образа VPS) |

| Защита от ransomware | Средняя (если есть версиирование, но может быть скомпрометировано) | Высокая (если используется иммутабельное хранилище и версиирование) | Высокая (если дампы хранятся отдельно, иммутабельно) | Низкая (rsync может синхронизировать зараженные файлы) | Очень высокая (часто включает иммутабельность, обнаружение угроз) | Низкая (реплицирует все, включая вредоносное ПО) |

| Нагрузка на VPS при бэкапе | Низкая (выполняется на уровне гипервизора) | Средняя (использование CPU/RAM для считывания данных) | Средняя (экспорт данных, может блокировать таблицы) | Средняя (использование CPU/RAM/I/O) | Средняя (использование CPU/RAM для агента) | Высокая (постоянная синхронизация, I/O) |

| Требования к хранилищу | Внутри провайдера (часто S3-совместимое) | S3-совместимое, NFS, блочное хранилище | S3-совместимое, локальный диск, NFS | S3-совместимое, локальный диск, NFS | Внутри провайдера BaaS | Блочное хранилище (локальное или сетевое) |

Детальный обзор каждого пункта/варианта стратегии

Каждая из перечисленных выше стратегий резервного копирования имеет свою нишу и оптимальное применение. Подробное рассмотрение поможет вам понять, какой подход лучше всего соответствует вашим требованиям в 2026 году.

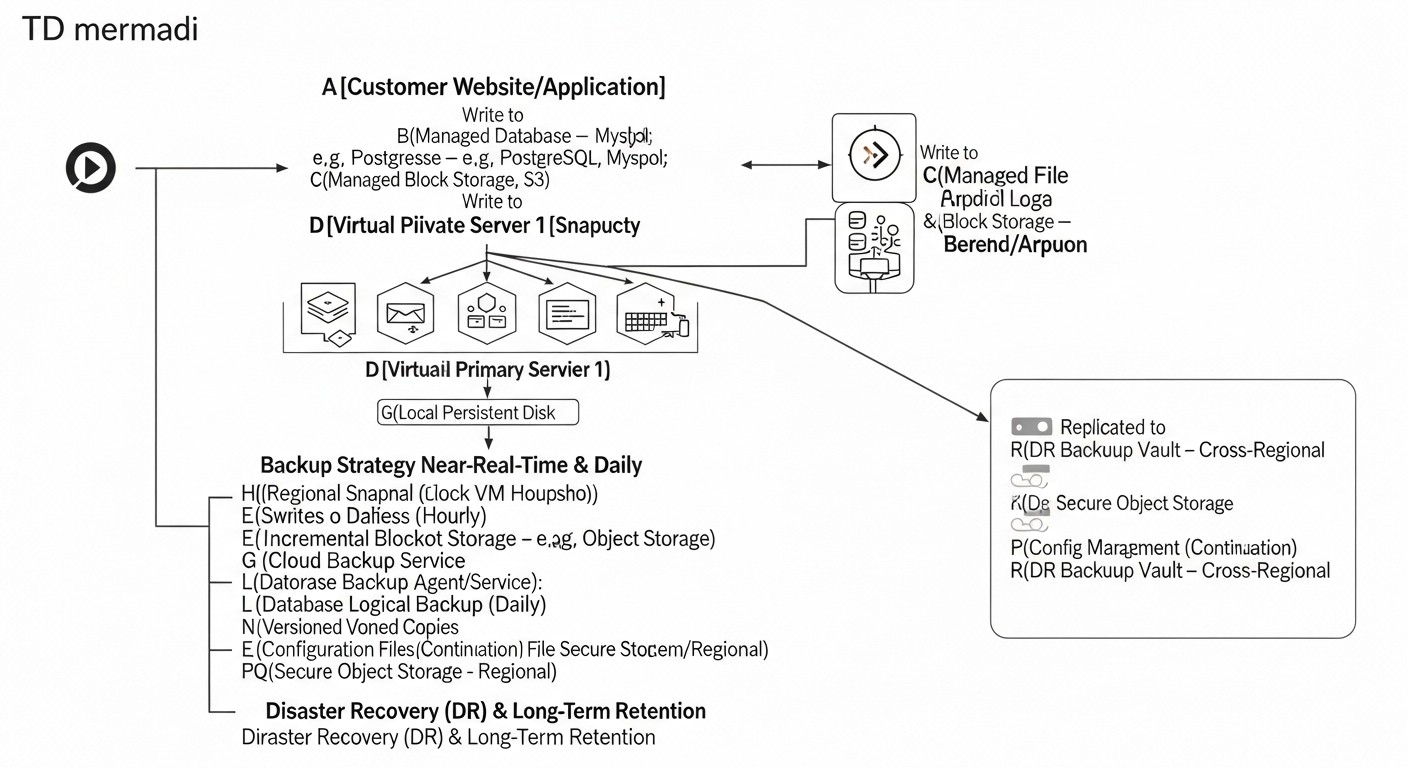

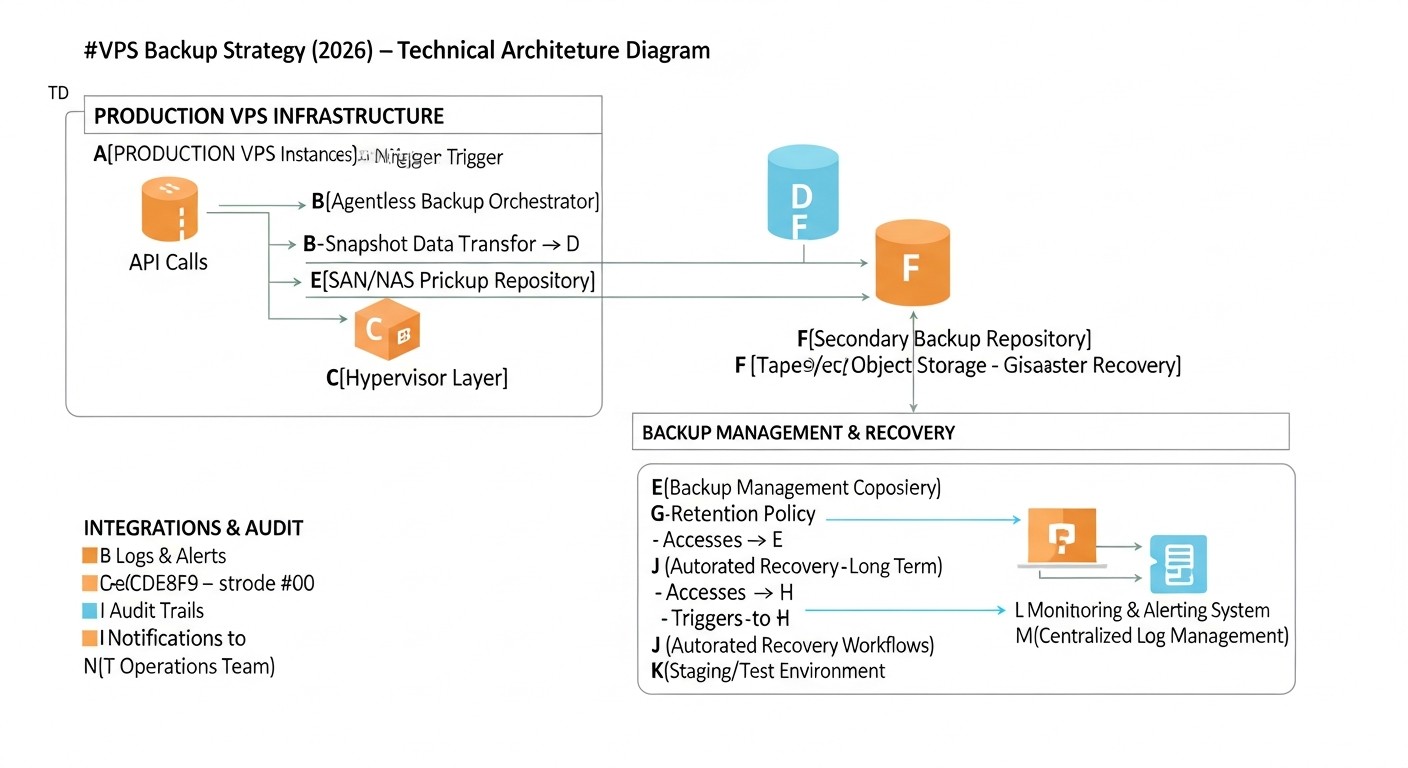

Снапшоты VPS (Провайдерские моментальные снимки)

Описание: Моментальные снимки VPS — это функция, предоставляемая большинством хостинг-провайдеров (DigitalOcean, Vultr, Hetzner Cloud, AWS EC2, Google Cloud Compute Engine). Они создают образ всего диска VPS в определенный момент времени. Снапшоты обычно делаются на уровне гипервизора, что минимизирует нагрузку на гостевую ОС. Восстановление из снапшота означает откат всего VPS к предыдущему состоянию. В 2026 году многие провайдеры предлагают автоматическое расписание для снапшотов и хранение нескольких версий.

Плюсы:

- Простота: Максимально простой в настройке и использовании. Часто достаточно нескольких кликов в панели управления провайдера.

- Быстрое восстановление: Восстановление всего VPS занимает считанные минуты, что обеспечивает низкий RTO для полного восстановления системы.

- Низкая нагрузка: Поскольку операция выполняется на уровне гипервизора, на гостевую ОС практически не оказывается влияния.

- Экономичность: Часто это один из самых дешевых вариантов резервного копирования, особенно для небольших VPS.

Минусы:

- Низкая гибкость восстановления: Вы можете восстановить только весь VPS целиком. Восстановление отдельных файлов или папок обычно невозможно без промежуточных шагов (например, монтирования снапшота к другому VPS).

- Зависимость от провайдера: Вы полностью привязаны к инфраструктуре и политике вашего хостинг-провайдера. Если провайдер столкнется с масштабным сбоем, ваши бэкапы могут быть недоступны.

- Потенциально высокий RPO: Частота снапшотов ограничена (например, раз в 4-24 часа), что может привести к потере значительного объема данных, если сбой произойдет между снимками.

- Ограниченная защита от ransomware: Если злоумышленник получит доступ к панели управления провайдера, он может удалить и снапшоты. Некоторые провайдеры предлагают защиту от удаления, но это не повсеместно.

Для кого подходит: Небольшие проекты, тестовые среды, блоги, а также как первая линия защиты для любых VPS. Хорошо дополняет другие стратегии, но редко является единственным решением для критически важных систем.

Пример использования: Вы запускаете небольшой SaaS-проект на одном VPS. Ежедневные автоматические снапшоты провайдера обеспечивают базовый уровень защиты от случайных ошибок конфигурации или мелких сбоев. Если что-то пойдет не так, вы можете быстро откатить VPS к состоянию предыдущего дня.

Агентное резервное копирование (File/Block-level)

Описание: Этот подход предполагает установку специального агента внутри гостевой ОС VPS. Агент отвечает за сбор данных, их сжатие, шифрование и отправку на удаленное хранилище (S3-совместимое хранилище, NFS, специализированный BaaS). Бэкап может быть файловым (копирование отдельных файлов/каталогов) или блочным (копирование измененных блоков диска). Современные агенты поддерживают инкрементальные и дифференциальные бэкапы, а также дедупликацию данных.

Плюсы:

- Высокая гибкость восстановления: Возможность восстанавливать отдельные файлы, каталоги, базы данных или всю систему целиком. Поддерживается восстановление на "голое железо" (bare-metal recovery).

- Низкий RPO: Благодаря инкрементальным бэкапам и возможности запускать их с высокой частотой (каждые 15-30 минут), можно достичь очень низкого RPO.

- Кросс-платформенность: Агенты обычно поддерживают различные операционные системы (Linux, Windows), что упрощает управление гетерогенной средой.

- Защита от ransomware: При правильной конфигурации (иммутабельное хранилище, версиирование, изоляция доступа) это один из самых надежных методов защиты от программ-вымогателей.

- Эффективность хранения: Дедупликация и сжатие существенно сокращают объем хранимых данных и, как следствие, затраты.

Минусы:

- Сложность настройки: Требует установки и настройки агента на каждом VPS, а также настройки централизованного сервера управления (если это не BaaS).

- Нагрузка на VPS: Процесс бэкапа потребляет ресурсы CPU, RAM и I/O на VPS, что может влиять на производительность приложения во время выполнения.

- Стоимость: Лицензии на проприетарные агенты и стоимость хранения могут быть выше, чем у простых снапшотов.

- Управление агентами: Необходимо следить за актуальностью агентов, их работоспособностью, обновлениями.

Для кого подходит: Критически важные производственные системы, SaaS-проекты с высокими требованиями к RPO/RTO, среды с большим объемом данных, где нужна гибкость восстановления и надежная защита от киберугроз. Примеры инструментов: Veeam Agent for Linux/Windows, Bacula, Bareos, Restic, BorgBackup.

Пример использования: У вас есть production-сервер с базой данных PostgreSQL и несколькими микросервисами. Вы используете Veeam Agent for Linux, который каждые 30 минут делает инкрементальный бэкап всех критически важных директорий и баз данных, отправляя их в S3-совместимое хранилище с включенной иммутабельностью. В случае сбоя вы можете восстановить как отдельные файлы конфигурации, так и всю систему на новый VPS.

Бэкап баз данных (Dump/Replication)

Описание: Этот метод фокусируется исключительно на данных баз данных, которые часто являются самой ценной частью любого приложения. Он включает создание логических дампов (например, с помощью pg_dump для PostgreSQL, mysqldump для MySQL) или использование встроенных механизмов репликации и физического бэкапа (WAL archiving для PostgreSQL, Percona XtraBackup для MySQL). В 2026 году активно используются облачные управляемые базы данных (AWS RDS, Google Cloud SQL), которые предоставляют собственные механизмы бэкапа и point-in-time recovery, значительно упрощая задачу.

Плюсы:

- Очень низкий RPO для данных: Благодаря непрерывной архивации WAL-логов или потоковой репликации можно добиться почти нулевой потери данных (RPO ~0).

- Высокая гибкость восстановления: Возможность восстановления на определенный момент времени (point-in-time recovery), восстановление отдельных таблиц или схем.

- Независимость от ОС: Дампы и логи баз данных не зависят от состояния файловой системы ОС, что делает их более надежными для восстановления только данных.

- Специализированные инструменты: Инструменты вроде Barman для PostgreSQL или Percona XtraBackup для MySQL/MariaDB обеспечивают высокую эффективность и надежность.

Минусы:

- Сложность: Настройка и управление репликацией или архивацией WAL-логов требует глубоких знаний конкретной СУБД.

- Нагрузка на БД: Создание дампов или выполнение физических бэкапов может создавать значительную нагрузку на базу данных.

- Только данные: Этот метод не обеспечивает бэкап операционной системы или файлов приложения, его необходимо комбинировать с другими стратегиями.

- Потенциальные блокировки: Логические дампы могут блокировать таблицы во время выполнения, что неприемлемо для высоконагруженных систем.

Для кого подходит: Любые проекты, использующие реляционные или NoSQL базы данных, где целостность и минимальная потеря данных являются критическими. Особенно важен для SaaS-проектов с высокой транзакционной нагрузкой.

Пример использования: Вы управляете высоконагруженным интернет-магазином, использующим PostgreSQL. Вы настроили Barman для непрерывной архивации WAL-логов на удаленное S3-совместимое хранилище и ежедневные полные физические бэкапы. Если произойдет сбой, вы можете восстановить базу данных на любой момент времени с точностью до секунды.

Синхронизация файлов (rsync/S3 CLI)

Описание: Этот простой, но эффективный метод заключается в использовании утилит командной строки, таких как rsync или клиенты для облачных хранилищ (например, AWS S3 CLI, Google Cloud Storage CLI), для синхронизации файлов и каталогов с удаленным хранилищем. rsync очень эффективен, так как передает только измененные части файлов. В 2026 году эти инструменты остаются актуальными благодаря своей простоте и надежности.

Плюсы:

- Простота: Легко настроить с помощью bash-скриптов и cron-заданий.

- Гибкость: Возможность бэкапить только нужные файлы и каталоги, исключая ненужные.

- Эффективность:

rsyncпередает только дельту изменений, что экономит трафик и время. - Низкая стоимость: Использует стандартные утилиты ОС, плата только за хранилище.

Минусы:

- Отсутствие версионирования по умолчанию: Если не настроить это вручную,

rsyncпросто перезаписывает файлы, что делает его уязвимым для программ-вымогателей и случайного удаления. - Нагрузка на VPS: При первом полном бэкапе или при большом количестве изменений может создавать значительную нагрузку.

- Нет бэкапа открытых файлов:

rsyncможет столкнуться с проблемами при копировании файлов, которые активно используются другими процессами (например, базы данных, лог-файлы). - Высокий RTO для полного восстановления: Восстановление всего VPS требует ручной установки ОС, настройки и затем копирования данных.

Для кого подходит: Бэкап конфигурационных файлов, пользовательских данных, статического контента, логов. Отлично подходит для некритичных данных или как дополнение к другим стратегиям для сохранения отдельных частей системы.

Пример использования: Вы хотите регулярно бэкапить конфигурационные файлы вашего веб-сервера (/etc/nginx) и статические файлы сайта (/var/www/html). Вы используете rsync для отправки этих данных на удаленный S3-совместимый бакет, настроив версионирование на бакете для защиты от перезаписи.

Облачное резервное копирование как сервис (BaaS)

Описание: BaaS (Backup as a Service) — это комплексное решение, предоставляемое сторонним провайдером (например, Acronis Cyber Protect Cloud, Veeam Backup & Replication (для облачных сред), Commvault, Rubrik). Вы платите за сервис, который берет на себя все аспекты резервного копирования: агенты, хранилище, управление, мониторинг, тестирование и восстановление. В 2026 году BaaS решения активно интегрируют AI/ML для обнаружения аномалий и угроз, а также предлагают расширенные возможности по восстановлению, включая миграцию между облаками.

Плюсы:

- Комплексность и "под ключ": Провайдер берет на себя все сложности, от инфраструктуры до поддержки.

- Высокая надежность: BaaS-провайдеры обычно предлагают строгие SLA по RPO/RTO и гарантируют целостность данных.

- Расширенные функции безопасности: Включают иммутабельное хранилище, шифрование, обнаружение ransomware, контроль доступа.

- Простота управления: Централизованная панель управления, автоматизация, отчетность.

- Глобальное распределение: Возможность хранить бэкапы в различных регионах и даже странах.

Минусы:

- Высокая стоимость: Это, как правило, самое дорогое решение, особенно для больших объемов данных или высоких требований к SLA.

- Зависимость от провайдера: Полная привязка к экосистеме BaaS-провайдера.

- Меньший контроль: Вы имеете меньше контроля над низкоуровневыми аспектами хранения и управления данными.

- Потенциальные egress fees: При восстановлении больших объемов данных могут возникнуть значительные расходы на исходящий трафик.

Для кого подходит: Предприятия, которым требуется соответствие строгим регуляторным требованиям, компании без выделенной команды DevOps/системных администраторов, крупные SaaS-проекты, где время инженеров дороже, чем стоимость сервиса. Отлично подходит для сред с высокими требованиями к безопасности и автоматизации.

Пример использования: Средний SaaS-проект с несколькими десятками VPS и строгими требованиями к GDPR и ISO 27001. Использование Acronis Cyber Protect Cloud позволяет централизованно управлять бэкапами всех VPS, обеспечивает высокую степень защиты от ransomware и автоматизированное тестирование восстановления, соответствующее регуляторным нормам.

Репликация дисков/образов (DRBD/ZFS send/receive)

Описание: Этот подход включает репликацию блочных устройств (дисков) или файловых систем между двумя или более VPS. DRBD (Distributed Replicated Block Device) обеспечивает синхронную или асинхронную репликацию блочного устройства в Linux. ZFS send/receive позволяет эффективно реплицировать снимки файловой системы ZFS. Этот метод часто используется для создания высокодоступных кластеров или для быстрого аварийного переключения (failover) на резервный сервер. В 2026 году контейнерные решения и Kubernetes операторы также предлагают свои механизмы репликации Persistent Volumes.

Плюсы:

- Очень низкий RPO: При синхронной репликации RPO может быть практически нулевым.

- Очень низкий RTO: В случае сбоя основного сервера можно быстро переключиться на реплику, что обеспечивает минимальное время простоя.

- Высокая доступность: Основа для построения высокодоступных кластеров.

- Полная копия: Реплицируется вся блочная структура или файловая система, включая ОС и приложения.

Минусы:

- Высокая сложность: Требует глубоких знаний операционных систем, файловых систем, сетевых протоколов и кластерных технологий. Настройка и поддержка могут быть очень трудоемкими.

- Высокие требования к ресурсам: Постоянная репликация создает нагрузку на сеть, I/O и CPU обоих серверов. Для синхронной репликации требуется низкая задержка между серверами.

- Стоимость: Требуется как минимум два полноценных VPS, что удваивает затраты на инфраструктуру.

- Отсутствие защиты от логических ошибок: Если вы случайно удалите данные или заразите систему ransomware, эти изменения будут реплицированы на резервный сервер.

Для кого подходит: Критически важные приложения, требующие максимально возможной доступности и минимального RPO/RTO, где простой недопустим (например, финансовые транзакции, телекоммуникационные сервисы). Часто используется в связке с другими методами бэкапа для обеспечения защиты от логических ошибок.

Пример использования: Вы управляете платежным шлюзом, где каждая секунда простоя стоит десятки тысяч долларов. Вы используете DRBD для синхронной репликации данных между двумя VPS в одном дата-центре, обеспечивая мгновенное переключение при сбое оборудования. Дополнительно, вы делаете ежедневные снапшоты ZFS (если используете ZFS) и отправляете их на удаленное хранилище для защиты от логических ошибок.

Практические советы и рекомендации по внедрению

Внедрение эффективной стратегии резервного копирования требует не только выбора правильных инструментов, но и строгого следования лучшим практикам. В 2026 году акцент смещается на автоматизацию, безопасность и регулярное тестирование.

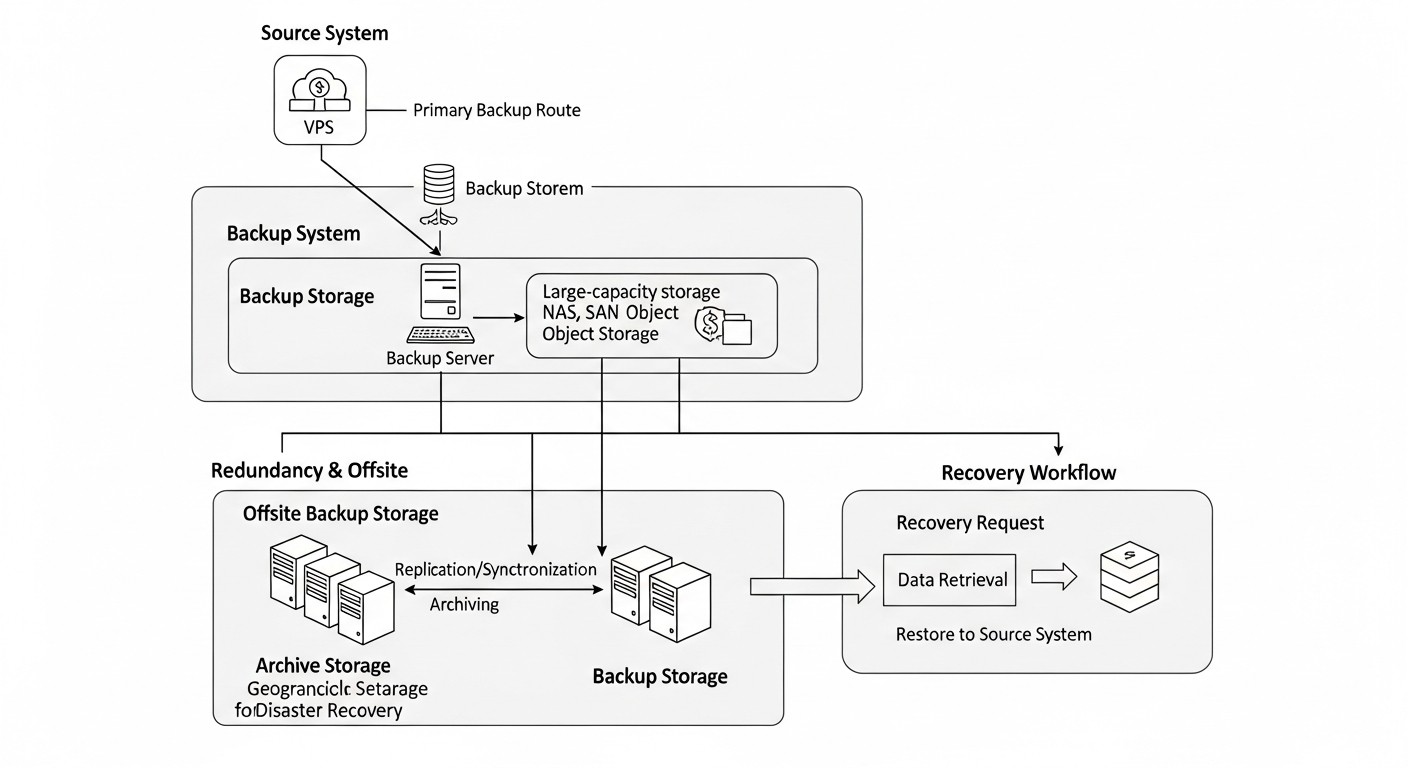

1. Следуйте правилу "3-2-1-1-0"

Это золотой стандарт резервного копирования, адаптированный под современные реалии:

- 3 копии данных: Оригинал и две резервные копии.

- 2 разных носителя: Например, локальный диск и облачное хранилище.

- 1 копия вне площадки: Хранится в другом географическом регионе или у другого провайдера.

- 1 офлайн/иммутабельная копия: Копия, которая не может быть изменена или удалена (например, на ленте, в S3 Glacier Deep Archive с блокировкой объекта, или на диске без сетевого доступа). Это критически важно для защиты от ransomware.

- 0 ошибок при восстановлении: Гарантия того, что ваши бэкапы работоспособны и восстанавливаются без проблем. Достигается регулярным тестированием.

Практика: Объедините провайдерские снапшоты (одна копия на одном носителе), агентное резервное копирование в S3-совместимое хранилище (вторая копия на другом носителе, с версионированием и иммутабельностью) и архивацию наиболее критичных данных в S3 Glacier Deep Archive с блокировкой объекта (третья копия, офлайн/иммутабельная, возможно, в другом регионе).

2. Автоматизируйте все, что можно

Ручные операции — источник ошибок и неэффективности. Используйте инструменты автоматизации для всех этапов:

- Создание бэкапов: Планировщики (cron), оркестраторы (Ansible, Terraform, SaltStack).

- Передача данных: Скрипты с

rsync,s3cmd,rclone. - Мониторинг: Интеграция с Prometheus, Grafana, Zabbix для отслеживания статуса бэкапов.

- Тестирование восстановления: Создание изолированных сред (Docker, Kubernetes, временные VPS) для автоматического восстановления и проверки работоспособности.

Пример скрипта для автоматического бэкапа PostgreSQL и отправки в S3:

#!/bin/bash

# Переменные окружения

DB_NAME="your_database_name"

DB_USER="your_db_user"

S3_BUCKET="s3://your-backup-bucket/postgresql/"

TIMESTAMP=$(date +"%Y%m%d%H%M%S")

BACKUP_FILE="/tmp/${DB_NAME}_${TIMESTAMP}.sql.gz"

RETENTION_DAYS=7 # Сколько дней хранить локальные бэкапы

echo "Starting PostgreSQL backup for ${DB_NAME} at ${TIMESTAMP}..."

# 1. Создание дампа базы данных

pg_dump -U "${DB_USER}" "${DB_NAME}" | gzip > "${BACKUP_FILE}"

if [ $? -ne 0 ]; then

echo "Error creating PostgreSQL dump."

exit 1

fi

echo "PostgreSQL dump created: ${BACKUP_FILE}"

# 2. Отправка дампа в S3

aws s3 cp "${BACKUP_FILE}" "${S3_BUCKET}${DB_NAME}_${TIMESTAMP}.sql.gz" --sse AES256

if [ $? -ne 0 ]; then

echo "Error uploading backup to S3."

exit 1

fi

echo "Backup uploaded to S3: ${S3_BUCKET}${DB_NAME}_${TIMESTAMP}.sql.gz"

# 3. Удаление локальных бэкапов старше RETENTION_DAYS

find /tmp/ -name "${DB_NAME}_.sql.gz" -mtime +"${RETENTION_DAYS}" -delete

echo "Old local backups cleaned up."

echo "PostgreSQL backup finished successfully."

Этот скрипт можно запускать через cron. Убедитесь, что awscli настроен с соответствующими правами доступа и переменные окружения для базы данных корректны.

3. Шифруйте данные

Всегда шифруйте резервные копии. Используйте шифрование "в покое" (на хранилище) и "в пути" (во время передачи). Облачные провайдеры предлагают серверное шифрование (SSE-S3, SSE-KMS), но для максимальной безопасности рассмотрите клиентское шифрование перед отправкой данных на хранилище (например, с помощью GPG, Restic или BorgBackup).

Пример шифрования файла перед отправкой:

# Шифрование файла с помощью GPG

gpg --batch --passphrase "YOUR_SUPER_SECRET_PASSPHRASE" --symmetric --cipher-algo AES256 -o my_data.tar.gz.gpg my_data.tar.gz

# Расшифровка

gpg --batch --passphrase "YOUR_SUPER_SECRET_PASSPHRASE" -o my_data.tar.gz my_data.tar.gz.gpg

Храните ключи шифрования или парольные фразы в безопасном месте, отдельно от бэкапов (например, в HashiCorp Vault, AWS Secrets Manager или другом KMS).

4. Внедряйте иммутабельное хранилище

Для защиты от ransomware и случайного удаления используйте хранилища с возможностью "блокировки объекта" (Object Lock) или "неизменяемого хранения" (Immutable Storage). Многие S3-совместимые хранилища (AWS S3, MinIO, Wasabi) предлагают эту функцию. Это позволяет установить период, в течение которого объект не может быть удален или изменен.

Пример настройки Object Lock в AWS S3:

При создании бакета:

aws s3api create-bucket --bucket your-immutable-bucket --region us-east-1 --object-lock-enabled-for-new-objects

При загрузке объекта с retain-until-date:

aws s3api put-object --bucket your-immutable-bucket --key my_backup.gz --body my_backup.gz --object-lock-mode COMPLIANCE --object-lock-retain-until-date "2026-12-31T23:59:59Z"

Режим COMPLIANCE делает объект неизменяемым даже для рута AWS аккаунта до указанной даты.

5. Регулярно тестируйте восстановление

Непроверенный бэкап — это отсутствие бэкапа. В 2026 году ручное тестирование является анахронизмом. Инвестируйте в автоматизированное тестирование.

- Создайте изолированную среду: Используйте временные VPS, контейнеры или виртуальные машины для восстановления бэкапов.

- Автоматизируйте проверку: После восстановления запустите скрипты, которые проверяют целостность данных, запускают приложения, проверяют доступность API, выполнение запросов к БД.

- Частота: Для критичных систем — еженедельно, для остальных — ежемесячно.

- Документируйте: Ведите журнал всех тестов, включая время восстановления и обнаруженные проблемы.

Пример концепции автоматизированного тестирования (псевдокод):

# Скрипт test_recovery.sh

# 1. Запустить новый временный VPS/контейнер

# (например, через Terraform или Docker)

# 2. Скачать последний бэкап из S3

# 3. Восстановить данные на временный VPS

# 4. Установить зависимости, запустить приложение/БД

# 5. Выполнить серию тестов:

# - Проверить наличие ключевых файлов

# - Запустить SQL-запросы к восстановленной БД

# - Сделать HTTP-запрос к API приложения

# - Проверить логи на ошибки

# 6. Отправить отчет о результате (успех/провал)

# 7. Удалить временный VPS/контейнер

6. Мониторинг и оповещения

Настройте мониторинг статуса выполнения бэкапов и оповещения о любых сбоях. Интегрируйте с вашей системой мониторинга (Prometheus, Grafana, Zabbix, Datadog) и системой оповещений (Slack, PagerDuty, Telegram).

- Что мониторить: Успешность/неуспешность выполнения бэкапа, размер бэкапа (резкие изменения могут указывать на проблемы), время выполнения, доступность хранилища.

- Оповещения: Настройте уведомления о пропущенных бэкапах, ошибках, или если бэкап не выполнялся дольше заданного RPO.

7. Управление доступом и принцип наименьших привилегий (Least Privilege)

Ограничьте доступ к хранилищам бэкапов. Используйте отдельные учетные записи IAM с минимально необходимыми правами:

- Учетная запись для бэкапа должна иметь только права на запись в бакет, но не на удаление или изменение существующих объектов (если не используется иммутабельность).

- Учетная запись для восстановления должна иметь права на чтение.

- Используйте MFA для всех административных доступов.

- Регулярно проводите аудит прав доступа.

8. Документируйте процедуры

Подробно документируйте всю процедуру резервного копирования и восстановления. Это критически важно для передачи знаний и обеспечения быстрого восстановления в стрессовой ситуации. Включите:

- Описание используемых инструментов и их конфигурации.

- Расписание бэкапов и RPO/RTO для каждого компонента.

- Пошаговые инструкции по восстановлению различных сценариев (отдельный файл, база данных, весь VPS).

- Контакты ответственных лиц.

- Журналы тестирования восстановления.

Типичные ошибки при организации резервного копирования и как их избежать

Даже самые опытные инженеры могут допускать ошибки при организации резервного копирования. В 2026 году, когда системы становятся все более сложными, эти ошибки могут иметь катастрофические последствия. Рассмотрим наиболее распространенные из них и способы их предотвращения.

1. Отсутствие или нерегулярное тестирование восстановления

Ошибка: "Бэкапы есть, значит, все в порядке." Многие компании создают резервные копии, но никогда не проверяют, можно ли из них восстановиться. В момент реального сбоя выясняется, что бэкапы повреждены, неполны или процесс восстановления не работает.

Последствия: Длительный простой, полная потеря данных, репутационные и финансовые потери.

Как избежать: Внедрите регулярное, автоматизированное тестирование восстановления. Для критически важных систем — еженедельно, для остальных — ежемесячно. Создавайте изолированные тестовые среды, восстанавливайте данные и проверяйте работоспособность приложений. Документируйте каждый тест.

2. Хранение всех копий в одном месте или у одного провайдера

Ошибка: Все бэкапы хранятся на том же VPS, в том же дата-центре или даже в том же облачном регионе, что и основной сервер. Некоторые провайдеры предлагают "автоматические бэкапы", но они часто хранятся в том же дата-центре.

Последствия: Региональные катастрофы (пожар, наводнение, масштабный сбой провайдера) или компрометация аккаунта могут привести к одновременной потере как основной системы, так и всех резервных копий.

Как избежать: Следуйте правилу "3-2-1-1-0". Храните как минимум одну копию бэкапа вне площадки, желательно у другого провайдера или в другом географическом регионе. Это снижает риск единой точки отказа.

3. Отсутствие защиты от программ-вымогателей (Ransomware)

Ошибка: Бэкапы доступны для записи из производственной среды или не имеют версионирования/иммутабельности. Программы-вымогатели, проникнув в систему, могут зашифровать или удалить не только рабочие данные, но и все доступные резервные копии.

Последствия: Невозможность восстановления данных, необходимость платить выкуп (без гарантии восстановления), утечка данных.

Как избежать: Используйте иммутабельное хранилище (Object Lock в S3, WORM-хранилища). Внедрите строгий контроль доступа (IAM) с минимальными привилегиями для учетных записей бэкапа. Рассмотрите "воздушный зазор" (air gap) для самых критичных данных — офлайн-копию, которая физически отключена от сети.

4. Недостаточный мониторинг и оповещения

Ошибка: Бэкапы настроены, но никто не следит за их статусом. Ошибки в скриптах, переполнение диска, проблемы с доступом к хранилищу остаются незамеченными в течение длительного времени.

Последствия: Обнаружение проблем с бэкапами только в момент сбоя, когда уже слишком поздно. Потеря данных за период, когда бэкапы не работали.

Как избежать: Интегрируйте бэкап-систему с вашей системой мониторинга (Prometheus, Zabbix). Настройте оповещения о любых сбоях, пропущенных бэкапах, а также о необычных изменениях в размере бэкапов (например, резкое уменьшение может указывать на проблему). Проверяйте логи бэкапов ежедневно.

5. Несоответствие RPO/RTO бизнес-требованиям

Ошибка: Выбрана стратегия бэкапа, которая не соответствует реальным бизнес-потребностям по допустимой потере данных (RPO) и времени восстановления (RTO). Например, для критического онлайн-сервиса выбран ежедневный бэкап и восстановление за 8 часов.

Последствия: Неприемлемые потери данных или слишком длительный простой, что приводит к значительным финансовым потерям и недовольству клиентов.

Как избежать: Четко определите RPO и RTO для каждого компонента вашей системы, исходя из бизнес-ценности данных и допустимого простоя. Выбирайте стратегию и инструменты, которые могут обеспечить эти метрики. Регулярно пересматривайте эти требования вместе с заинтересованными сторонами.

6. Отсутствие шифрования резервных копий

Ошибка: Бэкапы хранятся в открытом виде на удаленном хранилище. Это может быть связано с упрощением процесса или недооценкой рисков.

Последствия: Утечка конфиденциальных данных в случае компрометации хранилища или несанкционированного доступа. Нарушение регуляторных требований (GDPR, HIPAA).

Как избежать: Всегда шифруйте резервные копии. Используйте серверное шифрование (например, SSE-S3 для AWS S3) или, для максимальной безопасности, клиентское шифрование перед отправкой данных на хранилище. Управляйте ключами шифрования в безопасном месте (KMS, Vault).

7. Игнорирование баз данных или их некорректное копирование

Ошибка: Фокусировка на бэкапе файловой системы VPS, но игнорирование особенностей резервного копирования баз данных. Копирование файлов базы данных "напрямую" без остановки БД или использования специализированных инструментов может привести к неконсистентным или поврежденным копиям.

Последствия: Восстановленная база данных не запускается, содержит поврежденные данные или не отражает актуальное состояние на момент бэкапа.

Как избежать: Всегда используйте специализированные инструменты для бэкапа баз данных (pg_dump, mysqldump, Percona XtraBackup, Barman, встроенные механизмы облачных БД). Убедитесь, что бэкапы консистентны и позволяют восстановить базу данных в рабочее состояние.

8. Отсутствие документации и "знание у одного человека"

Ошибка: Вся информация о системе бэкапа, включая процедуры восстановления, хранится в голове одного инженера или в неструктурированных заметках.

Последствия: Критический простой или полная невозможность восстановления в случае отсутствия ключевого специалиста (отпуск, увольнение, болезнь). Хаос и паника в стрессовой ситуации.

Как избежать: Подробно документируйте все аспекты системы резервного копирования и восстановления. Храните документацию в централизованной, доступной для команды системе (Confluence, Wiki, GitLab/GitHub Wiki). Регулярно обновляйте документацию и проводите тренировки по восстановлению с участием разных членов команды.

Чеклист для практического применения стратегии резервного копирования

Этот чеклист поможет вам систематизировать процесс организации и проверки вашей системы резервного копирования VPS, убедившись, что вы учли все критически важные аспекты.

- Определение RPO и RTO:

- ✓ Четко определены RPO и RTO для каждого критически важного сервиса/VPS.

- ✓ Эти метрики согласованы с бизнес-требованиями и заинтересованными сторонами.

- Выбор стратегии и инструментов:

- ✓ Выбрана одна или несколько стратегий резервного копирования (снапшоты, агент, БД-дампы, BaaS), соответствующие RPO/RTO и бюджету.

- ✓ Выбраны конкретные инструменты и провайдеры для реализации каждой стратегии.

- Реализация правила "3-2-1-1-0":

- ✓ Создаются как минимум 3 копии данных (оригинал + 2 бэкапа).

- ✓ Копии хранятся на 2 разных типах носителей (например, локальный диск + облачное хранилище).

- ✓ Как минимум 1 копия хранится вне площадки (в другом регионе/у другого провайдера).

- ✓ Как минимум 1 копия является иммутабельной или офлайн (защита от ransomware).

- Автоматизация:

- ✓ Процесс создания резервных копий полностью автоматизирован (cron, Ansible, BaaS).

- ✓ Процесс передачи данных на удаленное хранилище автоматизирован.

- ✓ Процесс очистки старых резервных копий (управление жизненным циклом) автоматизирован.

- Безопасность данных:

- ✓ Все резервные копии шифруются "в покое" и "в пути".

- ✓ Ключи шифрования хранятся в безопасном, изолированном месте (KMS, Vault).

- ✓ Настроены строгие политики IAM/RBAC для доступа к хранилищам бэкапов (принцип наименьших привилегий).

- ✓ Используется многофакторная аутентификация (MFA) для административного доступа.

- Целостность данных и консистентность:

- ✓ Для баз данных используются специализированные методы бэкапа (дампы, WAL-архивация, снапшоты с quiescing).

- ✓ Проверяется консистентность создаваемых бэкапов (например, контрольные суммы).

- Мониторинг и оповещения:

- ✓ Настроен мониторинг успешности/неуспешности каждого задания бэкапа.

- ✓ Настроены оповещения о сбоях, пропущенных бэкапах или аномалиях (например, резкое изменение размера бэкапа).

- ✓ Мониторинг интегрирован с централизованной системой (Prometheus, Zabbix) и системой оповещений (Slack, PagerDuty).

- Тестирование восстановления:

- ✓ Разработан план и процедуры тестирования восстановления.

- ✓ Тестирование восстановления проводится регулярно (еженедельно/ежемесячно).

- ✓ Тестирование включает полный цикл: восстановление, запуск сервисов, проверка функциональности.

- ✓ Результаты тестирования документируются и анализируются.

- ✓ Процесс тестирования максимально автоматизирован.

- Документация:

- ✓ Вся архитектура резервного копирования и восстановления документирована.

- ✓ Подробные пошаговые инструкции по восстановлению различных сценариев доступны и актуальны.

- ✓ Контактная информация ответственных лиц указана.

- Управление жизненным циклом и ретенция:

- ✓ Определена политика хранения резервных копий (сколько копий, как долго, для каких данных).

- ✓ Настроено автоматическое удаление старых бэкапов в соответствии с политикой ретенции.

- ✓ Учтены регуляторные требования к хранению данных.

- Масштабируемость и производительность:

- ✓ Система бэкапа способна масштабироваться вместе с ростом данных и количества VPS.

- ✓ Производительность бэкапа и восстановления соответствует RPO/RTO без значительной нагрузки на производственные системы.

- Бюджетирование:

- ✓ Рассчитана общая стоимость владения (TCO), включая хранение, трафик, операции, лицензии и администрирование.

- ✓ Учтены потенциальные скрытые расходы (например, egress fees при восстановлении).

Расчет стоимости / Экономика резервного копирования

Стоимость резервного копирования — это не только прямые затраты на хранение, но и целый комплекс факторов, включая трафик, операции, лицензии и трудозатраты. В 2026 году, на фоне продолжающегося снижения цен на хранение, все большую роль играют затраты на операции и исходящий трафик, а также стоимость простоя, которая может многократно превысить все расходы на бэкап. Правильный экономический расчет позволяет оптимизировать затраты без ущерба для надежности.

Основные статьи расходов

- Стоимость хранения данных (Storage Cost):

- Цена за ГБ/ТБ в месяц. Разные классы хранилищ (горячее, холодное, архивное) имеют разную стоимость и скорость доступа. Например, S3 Standard, S3 Infrequent Access, S3 Glacier, S3 Glacier Deep Archive.

- Важно учитывать не только объем активных данных, но и количество версий/реплик, а также длительность хранения (политика ретенции).

- Стоимость трафика (Data Transfer Cost):

- Входящий трафик (Ingress): Обычно бесплатен у большинства облачных провайдеров.

- Исходящий трафик (Egress): Может быть очень дорогим. Взимается при чтении данных из хранилища (например, при восстановлении) или при передаче между регионами/провайдерами. Это одна из "скрытых" статей расходов.

- Стоимость операций (API Requests/Operations Cost):

- Многие облачные хранилища взимают плату за количество операций чтения (GET) и записи (PUT) данных.

- Для BaaS-решений это может быть абстрагировано в виде "за VPS" или "за объем данных", но для самостоятельной настройки (например, с S3) это важный фактор. Большое количество мелких файлов или частые инкрементальные бэкапы могут генерировать много операций.

- Стоимость лицензий ПО:

- Для проприетарных решений (Veeam, Acronis BaaS) стоимость лицензии может быть значительной, часто взимается за VPS или за объем защищаемых данных.

- Open-source решения (Restic, BorgBackup) не имеют прямых лицензионных затрат, но требуют больше трудозатрат на настройку и поддержку.

- Трудозатраты (Operational Overhead):

- Время инженеров на проектирование, настройку, мониторинг, тестирование и устранение проблем.

- Автоматизация снижает эти затраты, но первоначальные инвестиции в разработку скриптов и пайплайнов могут быть значительными.

- Стоимость простоя (Downtime Cost):

- Это непрямая, но потенциально самая большая статья расходов. Включает упущенную выгоду, штрафы по SLA, потерю репутации, снижение производительности сотрудников.

- Прямо пропорциональна RTO и критичности сервиса.

Примеры расчетов для разных сценариев (2026 год, ориентировочные цены)

Для упрощения примем следующие гипотетические цены за 2026 год:

- S3 Standard Storage: $0.020/ГБ/мес

- S3 Infrequent Access (IA): $0.0125/ГБ/мес

- S3 Glacier: $0.004/ГБ/мес

- S3 Egress (исходящий трафик): $0.08/ГБ

- S3 PUT requests: $0.005/1000 запросов

- S3 GET requests: $0.0004/1000 запросов

- Лицензия BaaS: $15/VPS/мес (для 100ГБ)

- Стоимость инженера: $50/час

Сценарий 1: Небольшой SaaS-проект (1 VPS, 200 ГБ данных)

Стратегия: Ежедневные снапшоты провайдера + еженедельное агентное резервное копирование на S3 IA с версионированием и иммутабельностью.

- Снапшоты провайдера: $10/мес (за 200 ГБ).

- Агентное резервное копирование (Restic на S3 IA):

- Объем данных: 200 ГБ. Сжатие и дедупликация Restic сокращают до 100 ГБ хранимых данных (за 4 недели, 4 полных бэкапа).

- Хранение S3 IA: 100 ГБ $0.0125/ГБ/мес = $1.25/мес.

- Операции S3: ~5000 PUT (еженедельно) + ~1000 GET (мониторинг) = $0.025 + $0.0004 = ~$0.03/мес.

- Трафик: Еженедельный бэкап 200 ГБ (если полный, но Restic инкрементальный, пусть будет 5 ГБ изменений) 4 недели = 20 ГБ. 20 ГБ $0.00 (ingress free) = $0.00.

- Восстановление (гипотетическое): 1 раз в год, 100 ГБ egress $0.08/ГБ = $8.00/год = $0.67/мес.

- Трудозатраты: 4 часа на настройку Restic и скриптов ($200), 1 час в месяц на мониторинг и обслуживание ($50). Итого ~$67/мес (распределено на год).

Общая стоимость: $10 (снапшоты) + $1.25 (хранение) + $0.03 (операции) + $0.67 (egress) + $67 (трудозатраты) = ~$78.95/мес.

Сценарий 2: Средний SaaS-проект (5 VPS, 1 ТБ данных на каждом, критичные БД)

Стратегия: BaaS решение (например, Acronis) для всех VPS + Barman для PostgreSQL с архивацией WAL-логов в S3 Glacier.

- BaaS для 5 VPS (5 ТБ данных):

- Лицензия BaaS: 5 VPS $30/VPS/мес (для 1 ТБ) = $150/мес. (Часто BaaS включает хранение и операции).

- Дополнительный трафик/операции: Пусть будет включено в BaaS или незначительно.

- Barman для PostgreSQL (1 ТБ данных, 50 ГБ WAL/день):

- Хранение полных бэкапов (1 ТБ) на S3 Glacier: 1 ТБ $0.004/ГБ/мес = $4/мес.

- Хранение WAL-логов (50 ГБ/день 30 дней = 1.5 ТБ/мес) на S3 Glacier: 1.5 ТБ $0.004/ГБ/мес = $6/мес.

- Операции S3 Glacier: Незначительные, так как доступ редкий.

- Трафик: WAL-логи 1.5 ТБ/мес $0.00 (ingress free) = $0.00. Восстановление (гипотетическое): 1 раз в год, 1 ТБ egress $0.08/ГБ = $80/год = $6.67/мес.

- Трудозатраты: 20 часов на настройку BaaS и Barman ($1000), 5 часов в месяц на мониторинг и тестирование ($250). Итого ~$333/мес (распределено на год).

Общая стоимость: $150 (BaaS) + $4 (Glacier Full) + $6 (Glacier WAL) + $6.67 (Glacier Egress) + $333 (трудозатраты) = ~$499.67/мес.

Сценарий 3: Высоконагруженный кластер (10 VPS, 5 ТБ данных, RPO/RTO очень низкие)

Стратегия: Репликация дисков (DRBD) для HA + агентное резервное копирование (Veeam Agent) в S3 IA с иммутабельностью и BaaS для архивации.

- DRBD репликация: Требует 10 дополнительных VPS. Стоимость 10 VPS = $200-$500/мес. (зависит от провайдера).

- Veeam Agent (10 VPS, 5 ТБ данных):

- Лицензия Veeam Agent: 10 VPS $10/VPS/мес = $100/мес.

- Хранение S3 IA: 5 ТБ $0.0125/ГБ/мес = $62.5/мес.

- Операции S3: ~20000 PUT + ~5000 GET = $0.1 + $0.002 = ~$0.1/мес.

- Трафик: Ежедневные инкрементальные бэкапы (пусть 100 ГБ/день) 30 дней = 3 ТБ. 3 ТБ $0.00 = $0.00.

- Восстановление: 2 раза в год, 5 ТБ egress $0.08/ГБ = $400/год = $33.33/мес.

- BaaS для архивации (например, Acronis с холодным хранилищем, 5 ТБ): $100/мес (за 5 ТБ).

- Трудозатраты: 40 часов на настройку DRBD, Veeam, BaaS ($2000), 10 часов в месяц на мониторинг, тестирование, поддержку ($500). Итого ~$667/мес (распределено на год).

Общая стоимость: $350 (доп. VPS) + $100 (Veeam) + $62.5 (S3 IA) + $0.1 (S3 Ops) + $33.33 (S3 Egress) + $100 (BaaS Archive) + $667 (трудозатраты) = ~$1312.93/мес.

Как оптимизировать затраты

- Политика ретенции: Не храните бэкапы вечно, если это не требуется регуляторными нормами. Определите, сколько версий и как долго нужно хранить, и настройте автоматическое удаление старых копий.

- Классы хранилищ: Используйте разные классы хранилищ для разных типов бэкапов. "Горячие" (S3 Standard) для быстрого восстановления, "холодные" (S3 IA) для долгосрочных, "архивные" (Glacier) для очень длительного хранения с редким доступом.

- Дедупликация и сжатие: Инструменты вроде Restic, BorgBackup, Veeam Agent эффективно уменьшают объем хранимых данных.

- Мониторинг egress fees: Будьте внимательны к расходам на исходящий трафик. Если вы часто восстанавливаете большие объемы данных, это может стать самой дорогой статьей. Оцените RTO и RPO, чтобы избежать чрезмерных затрат на быстрые, но дорогие восстановления.

- Автоматизация трудозатрат: Инвестируйте в скрипты, Infrastructure as Code (Terraform, Ansible) для автоматизации настройки и управления. Это снижает постоянные операционные расходы.

- Оценка TCO: Всегда рассчитывайте общую стоимость владения (Total Cost of Ownership) на несколько лет, а не только ежемесячные платежи. Учитывайте стоимость простоя.

Таблица с примерами расчетов (упрощенно, для ежемесячного бэкапа 100ГБ)

| Параметр | Snaпшоты VPS | Restic + S3 IA | Acronis BaaS |

|---|---|---|---|

| Объем данных (исходный) | 100 ГБ | 100 ГБ | 100 ГБ |

| Объем данных (хранимый, после сжатия/дедупл.) | 100 ГБ | ~50 ГБ | ~50 ГБ |

| Стоимость хранения/лицензии | $5.00 | $0.63 (S3 IA) | $20.00 |

| Стоимость операций (оценка) | $0.00 | $0.01 | Включено |

| Стоимость egress (оценка, 1 восстановление/год) | $0.00 | $0.33 | $0.50 (зависит от провайдера) |

| Трудозатраты (оценка/мес) | $20.00 | $50.00 | $10.00 |

| Итоговая стоимость/мес (оценка) | $25.00 | $50.97 | $30.50 |

Эта таблица демонстрирует, что BaaS решения могут быть более дорогими в прямых затратах на лицензии, но значительно снижают трудозатраты, что в итоге может сделать их более экономически выгодными для компаний, где время инженеров стоит дорого. Снапшоты VPS самые дешевые, но имеют ограничения. Самостоятельная настройка с Restic + S3 может быть выгодной по прямым затратам на хранение, но требует больше времени на администрирование.

Кейсы и примеры из реальной практики

Теория важна, но реальные кейсы показывают, как различные стратегии резервного копирования применяются на практике и какие результаты они приносят. Рассмотрим несколько сценариев, актуальных для 2026 года.

Кейс 1: Стартап с SaaS-платформой для малого бизнеса

Описание проекта: Молодой стартап "SmartCRM" предлагает SaaS-решение для управления клиентами. Платформа работает на 5 VPS: один для веб-сервера (Nginx, PHP-FPM), один для API (Node.js), один для PostgreSQL, один для Redis и один для фоновых задач (RabbitMQ, Celery). Общий объем данных около 2 ТБ, база данных занимает 500 ГБ. RPO для данных CRM: 1 час, RTO: 4 часа. Бюджет ограничен, но безопасность данных клиентов критична.

Проблема: Необходимость обеспечить надежное резервное копирование и быстрое восстановление при ограниченных ресурсах и растущем объеме данных. Базовая защита от провайдера недостаточна.

Решение: Гибридная стратегия, сочетающая простоту и надежность.

- Ежедневные провайдерские снапшоты (VPS-уровня): Для всех 5 VPS. Это обеспечивает быстрый откат всего сервера в случае серьезной ошибки конфигурации или сбоя ОС. Снапшоты хранятся 7 дней. Стоимость: ~$50/мес.

- Агентное резервное копирование для файловой системы (Restic): На всех VPS установлен Restic. Ежедневные инкрементальные бэкапы ключевых директорий (

/etc,/var/www,/opt/app, логи) отправляются в S3 Infrequent Access. В S3 включено версионирование и Object Lock на 30 дней для защиты от ransomware. Restic обеспечивает дедупликацию и шифрование данных. Стоимость S3: ~$30/мес. - Бэкап PostgreSQL (Barman): Для базы данных настроен Barman, который делает еженедельные полные бэкапы и непрерывно архивирует WAL-логи в другой S3 бакет (S3 Standard, затем переходит в S3 IA). Это обеспечивает point-in-time recovery с RPO до нескольких минут. Стоимость S3 для БД: ~$40/мес.

- Мониторинг: Все скрипты бэкапа интегрированы с Prometheus/Grafana для отслеживания успешности выполнения и размера бэкапов. Оповещения в Slack при сбоях.

- Тестирование: Раз в месяц автоматически запускается скрипт, который поднимает временный VPS, восстанавливает последний полный бэкап (файлы + БД), запускает базовые тесты приложения и удаляет VPS.

Результаты:

- RPO/RTO: RPO для файлов ~24 часа (Restic), для БД ~15 минут. RTO для полного восстановления ~3 часа (за счет автоматизации).

- Безопасность: Высокий уровень защиты от ransomware благодаря иммутабельности S3 и шифрованию Restic.

- Стоимость: Общая стоимость инфраструктуры бэкапа составила около ~$150/мес, плюс трудозатраты на настройку. Это позволило уложиться в бюджет стартапа, обеспечив при этом высокий уровень надежности.

- Опыт: В одном случае произошла ошибка при обновлении Nginx, которая привела к падению веб-сервера. Благодаря провайдерским снапшотам, VPS был восстановлен за 15 минут до рабочего состояния. В другом случае, разработчик случайно удалил критические данные из БД. Благодаря Barman, база данных была восстановлена на момент за 5 минут до инцидента, с минимальной потерей данных.

Кейс 2: Крупная e-commerce платформа с высокой доступностью

Описание проекта: "MegaShop" — крупная e-commerce платформа с миллионами пользователей. Инфраструктура распределена на 20+ VPS, работающих в кластере. Объем данных десятки ТБ, включая огромную базу данных продуктов, заказов и пользовательских данных. RPO: несколько минут, RTO: менее 30 минут. Простой неприемлем, каждая минута простоя — миллионы долларов потерь. Соответствие PCI DSS и другим регуляторным требованиям.

Проблема: Обеспечить непрерывность бизнеса, минимальные RPO/RTO, масштабируемость и соответствие строгим стандартам безопасности при огромных объемах данных.

Решение: Многоуровневая, высокоавтоматизированная стратегия с акцентом на BaaS и репликацию.

- Репликация баз данных (PostgreSQL Streaming Replication): Основная база данных реплицируется на горячий резервный сервер в другом AZ (Availability Zone) в режиме стриминга. Это обеспечивает практически нулевой RPO и RTO за счет быстрого переключения на реплику. Дополнительно используется Barman для долгосрочного хранения WAL-логов и полных бэкапов в S3 Glacier с Object Lock.

- Облачное резервное копирование как сервис (BaaS, например, Veeam Backup & Replication для облачных сред): Для всех VPS (ОС, приложения, конфигурации) используется BaaS-решение. Оно обеспечивает инкрементальные бэкапы каждые 15 минут, хранение в нескольких регионах, дедупликацию, шифрование и защиту от ransomware. Veeam также предоставляет возможности восстановления на уровне отдельных файлов и bare-metal recovery. Стоимость BaaS: ~$2000/мес.

- Снапшоты Managed Disks/Volumes: Для Persistent Volumes, используемых в Kubernetes, настроены автоматические снапшоты на уровне облачного провайдера. Эти снапшоты являются первым уровнем защиты от быстрых сбоев.

- Мониторинг и оркестрация: Все процессы бэкапа и репликации интегрированы с централизованной системой мониторинга (Datadog) и оркестрации (Ansible, Terraform). Пайплайны CI/CD включают автоматическую проверку бэкапов.

- DRP (Disaster Recovery Plan): Разработан и регулярно тестируется план аварийного восстановления, включающий переключение на резервный регион. Тестирование проводится ежеквартально, с имитацией реальных сбоев.

Результаты:

- RPO/RTO: RPO для БД практически 0, для файловой системы ~15 минут. RTO для переключения на резервный кластер ~15-20 минут.

- Безопасность: Соответствие PCI DSS и другим стандартам благодаря многоуровневой защите, шифрованию, иммутабельности и аудиту.

- Стоимость: Общая стоимость бэкапа и DR-инфраструктуры составила несколько тысяч долларов в месяц, но это оправдано миллионными потерями от простоя.

- Опыт: Во время серьезного сбоя в одном из облачных регионов, произошедшего из-за проблемы с сетевым оборудованием провайдера, платформа смогла переключиться на резервный регион менее чем за 20 минут, минимизировав потери и сохранив репутацию.

Кейс 3: DevOps-команда, использующая Kubernetes и инфраструктуру как код

Описание проекта: DevOps-команда управляет сложной микросервисной архитектурой на Kubernetes, развернутой на нескольких VPS. Все конфигурации хранятся в Git. Данные хранятся в Persistent Volumes (PVs), а также в управляемых облачных базах данных. RPO: 1-4 часа, RTO: 2 часа.

Проблема: Как эффективно бэкапить динамическую, контейнеризированную среду, где VPS являются эфемерными, а данные важны?

Решение: Фокус на данных и конфигурациях, а не на самих VPS.

- Бэкап конфигураций (Git): Все манифесты Kubernetes, Helm-чарты, Ansible-плейбуки, Terraform-конфигурации хранятся в Git-репозиториях. Это "бэкап" конфигурации инфраструктуры как кода.

- Бэкап Persistent Volumes (Velero): Для бэкапа Persistent Volumes (данных, используемых подами) используется Velero. Он делает снапшоты PVs и бэкапы ресурсов Kubernetes (deployments, services, configs). Бэкапы отправляются в S3 с Object Lock. Velero позволяет восстанавливать как отдельные ресурсы, так и целые кластеры. Стоимость S3: ~$100/мес.

- Бэкап управляемых баз данных: Для облачных управляемых баз данных (например, AWS RDS, Google Cloud SQL) используются встроенные механизмы бэкапа с point-in-time recovery. Эти бэкапы хранятся провайдером с соответствующими SLA. Стоимость провайдера БД.

- Офлайн-бэкап (S3 Glacier Deep Archive): Ежемесячно создается архивный бэкап всех критически важных PVs и конфигураций, который отправляется в S3 Glacier Deep Archive с длительным Object Lock.

- Автоматизированное тестирование: В CI/CD пайплайн включена задача, которая раз в неделю развертывает новый, пустой Kubernetes-кластер, восстанавливает из бэкапа часть приложений и данных с помощью Velero, запускает интеграционные тесты и затем удаляет кластер.

Результаты:

- RPO/RTO: RPO для PVs ~1 час, RTO для восстановления части кластера ~1 час.

- Гибкость: Возможность восстанавливать отдельные микросервисы или весь кластер.

- Эффективность: VPS не бэкапятся напрямую, так как они эфемерны и могут быть легко пересозданы из кода. Фокус на данных и конфигурациях.

- Опыт: При обновлении Kubernetes, которое привело к неработоспособности некоторых подов, команда смогла быстро откатить кластер к предыдущему рабочему состоянию с помощью Velero, восстановив как PVs, так и ресурсы Kubernetes.

Инструменты и ресурсы для эффективного резервного копирования

В 2026 году арсенал инструментов для резервного копирования VPS стал еще шире и функциональнее. Выбор правильного инструмента зависит от вашей инфраструктуры, бюджета, требований к RPO/RTO и уровня автоматизации. Здесь мы рассмотрим актуальные утилиты, а также средства для мониторинга и тестирования.

Утилиты для работы с резервными копиями

-

Restic

- Описание: Мощный, безопасный и эффективный инструмент для создания зашифрованных, дедуплицированных бэкапов. Поддерживает множество бэкендов для хранения (локальный диск, SFTP, S3, Azure Blob Storage, Google Cloud Storage и др.). Restic фокусируется на консистентности и безопасности.

- Особенности 2026: Активное сообщество, постоянное развитие, отличная поддержка облачных хранилищ, интеграция с Kubernetes (через операторы).

- Для кого: Идеален для самостоятельной настройки агентного бэкапа на Linux VPS, где важна экономия места, шифрование и гибкость.

- Пример использования:

restic backup --repo s3:s3.amazonaws.com/my-bucket --password-file /path/to/password.txt /var/www /etc/nginx

-

BorgBackup (Borg)

- Описание: Похож на Restic, но с акцентом на производительность и функциональность для локальных и SSH-доступных репозиториев. Также обеспечивает дедупликацию, сжатие и шифрование.

- Особенности 2026: Высокая скорость работы, хорошо подходит для больших объемов данных, когда репозиторий находится на выделенном сервере или NAS.

- Для кого: Пользователи, которым нужна максимальная производительность и гибкость в управлении репозиториями, особенно при наличии собственного хранилища.

- Пример использования:

borg create --stats --compression lz4 /path/to/repo::my-backup-{now} /var/www /etc

-

Duplicity / Duply

- Описание: Старый, но проверенный инструмент для зашифрованных, инкрементальных бэкапов. Поддерживает множество бэкендов. Duply — это обертка для Duplicity, упрощающая конфигурацию.

- Особенности 2026: Менее активно развивается по сравнению с Restic/Borg, но остается надежным решением для тех, кто ищет стабильность.

- Для кого: Для тех, кто уже знаком с инструментом, или для менее требовательных сценариев.

-

rsync

- Описание: Универсальная утилита для синхронизации файлов и каталогов. Передает только измененные части файлов, очень эффективна для дельта-копирования.

- Особенности 2026: Остается незаменимым инструментом для простой синхронизации и создания локальных/удаленных копий.

- Для кого: Для бэкапа конфигурационных файлов, статического контента, или как часть более сложного скрипта. Требует ручной реализации версионирования.

- Пример использования:

rsync -avz --delete /var/www/html/ user@backup-server:/mnt/backups/web/

-

AWS CLI / S3cmd / rclone

- Описание: Инструменты командной строки для взаимодействия с облачными хранилищами (S3-совместимыми). AWS CLI — официальный клиент для AWS S3. S3cmd — для общих S3-совместимых хранилищ. rclone — "швейцарский нож" для облачного хранения, поддерживает более 40 различных облачных провайдеров.

- Особенности 2026: rclone становится стандартом благодаря своей универсальности и поддержке продвинутых функций (шифрование, кеширование, монтирование).

- Для кого: Для отправки файлов в облачное хранилище, управления объектами, использования Object Lock.

- Пример использования (rclone):

rclone sync /path/to/local/data my-s3-remote:my-bucket --config /path/to/rclone.conf --s3-object-lock-mode compliance --s3-object-lock-retain-until-date "2026-12-31T23:59:59Z"

-

Barman (Backup and Recovery Manager for PostgreSQL)

- Описание: Профессиональный инструмент для управления резервным копированием и восстановлением PostgreSQL. Поддерживает непрерывную архивацию WAL-логов, полные и инкрементальные бэкапы, point-in-time recovery.

- Особенности 2026: Является стандартом де-факто для высоконагруженных PostgreSQL-баз данных, активно развивается.

- Для кого: Любой, кто использует PostgreSQL в production и требует низких RPO/RTO.

-

Percona XtraBackup (для MySQL/MariaDB)

- Описание: Открытый инструмент для "горячего" физического бэкапа MySQL/MariaDB без блокировки базы данных.

- Особенности 2026: Незаменимый инструмент для физических бэкапов MySQL-совместимых баз данных.

- Для кого: Пользователи MySQL/MariaDB, которым нужны консистентные бэкапы без простоя.

-

Velero (для Kubernetes)

- Описание: Инструмент для бэкапа и восстановления ресурсов Kubernetes и Persistent Volumes. Работает с облачными провайдерами через Volume Snapshots.

- Особенности 2026: Стандартный инструмент для бэкапа в Kubernetes-экосистеме, активно развивается.

- Для кого: Команды, управляющие приложениями в Kubernetes.

Мониторинг и тестирование

-

Prometheus & Grafana

- Описание: Prometheus — система мониторинга с временными рядами. Grafana — инструмент для визуализации данных.

- Применение: Используйте Prometheus для сбора метрик о статусе бэкапов (успешность, размер, время выполнения). Grafana для создания дашбордов, которые показывают состояние всех бэкапов.

- Пример метрик:

backup_status{job="restic_web_server"} 1(1 = успех, 0 = провал),backup_size_bytes{job="restic_web_server"} 123456789.

-

Zabbix / Nagios / Icinga

- Описание: Традиционные системы мониторинга, которые могут проверять выполнение скриптов, размер файлов, доступность удаленных хранилищ.

- Применение: Настройте проверки, которые запускают скрипты бэкапа и проверяют их выходной код, или проверяют наличие файлов бэкапа на хранилище.

-

Healthchecks.io / UptimeRobot

- Описание: Простые сервисы для мониторинга выполнения периодических задач. Ваш скрипт бэкапа отправляет HTTP-запрос на URL сервиса в случае успеха. Если запрос не приходит в течение заданного времени, вы получаете оповещение.

- Применение: Легкий способ убедиться, что ваши cron-задания бэкапа действительно выполняются.

-

Ansible / Terraform / Docker

- Описание: Инструменты для автоматизации и Infrastructure as Code.

- Применение для тестирования: Используйте Terraform для быстрого создания временного VPS, Ansible для установки необходимых зависимостей и запуска скриптов восстановления. Docker может быть использован для запуска изолированных контейнеров с восстановленными данными для быстрой проверки.

Полезные ссылки и документация

- Restic Documentation

- BorgBackup Documentation

- rclone Documentation

- Barman Documentation

- Percona XtraBackup Documentation

- Velero Documentation

- AWS S3 Object Lock

- Veeam Agent for Linux

- Acronis Cyber Protect Cloud

- Ansible for DevOps

- Terraform Documentation

- Prometheus Documentation

- Grafana Documentation

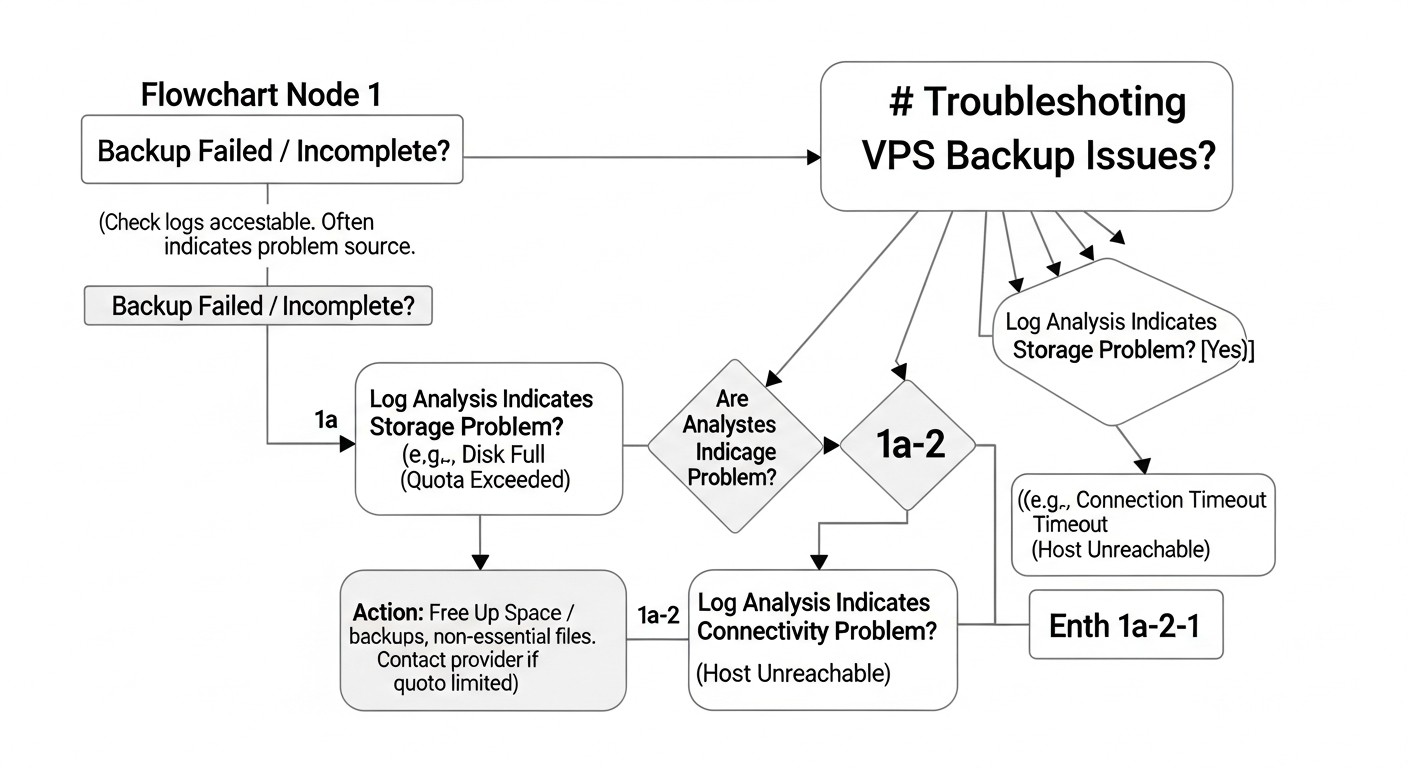

Troubleshooting: Решение типовых проблем с резервным копированием

Даже самая продуманная система резервного копирования может столкнуться с проблемами. Умение быстро диагностировать и устранять их критически важно для поддержания надежности. В 2026 году, с ростом сложности систем, навыки траблшутинга становятся еще ценнее.

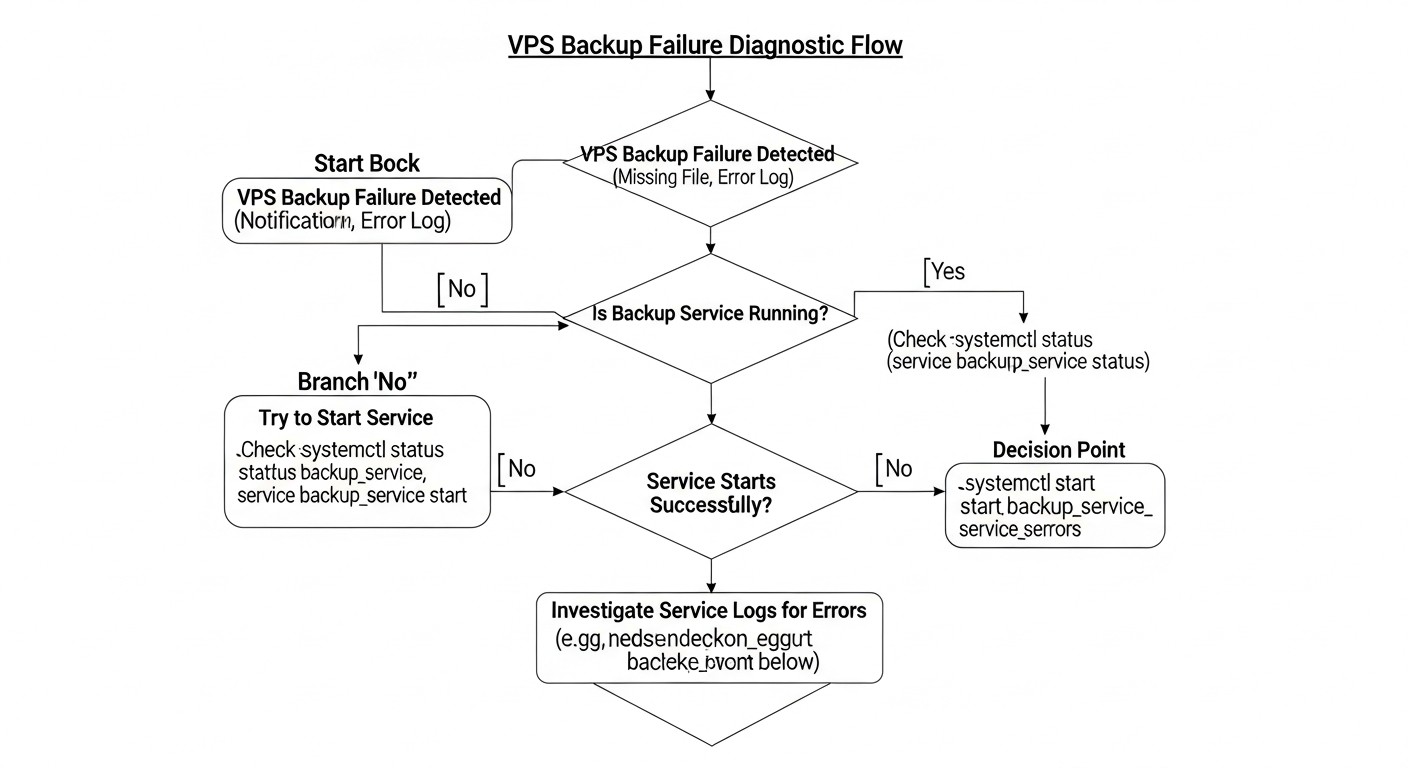

1. Проблема: Бэкап не запускается или завершается с ошибкой

Возможные причины:

- Ошибка в cron-задании: Неверный путь к скрипту, неправильный синтаксис времени.

- Проблемы с правами доступа: Скрипт выполняется от пользователя без необходимых прав на чтение файлов или запись временных данных.

- Нехватка места на диске: На локальном диске VPS, где создаются временные копии или дампы, закончилось место.

- Проблемы с сетью/доступом к хранилищу: Нет связи с S3-бакетом, SFTP-сервером или другим удаленным хранилищем.

- Ошибка в скрипте: Синтаксическая ошибка, неправильная переменная, устаревшая команда.

- Проблемы с аутентификацией: Истек токен, неверные ключи доступа к облачному хранилищу.

Диагностические команды и решения:

- Проверка cron:

Убедитесь, что скрипт имеет права на выполнение (grep CRON /var/log/syslog # Проверить логи cron sudo systemctl status cron # Статус службы cron crontab -l # Проверить список заданий текущего пользователя sudo crontab -l -u root # Проверить список заданий rootchmod +x script.sh). Запустите скрипт вручную, чтобы увидеть ошибки. - Проверка прав доступа: Запустите скрипт от пользователя, от которого он должен выполняться. Проверьте права на директории:

ls -l /path/to/files. - Проверка места на диске:

Очистите временные файлы или увеличьте размер диска.df -h # Проверить свободное место - Проверка сети/доступа к хранилищу:

Проверьте настройки фаервола (iptables, security groups).ping s3.amazonaws.com # Проверить сетевую доступность aws s3 ls s3://your-bucket # Проверить доступ к S3 (для AWS CLI) - Проверка аутентификации: Обновите ключи доступа, проверьте переменные окружения.

2. Проблема: Восстановление из бэкапа не работает или данные повреждены

Возможные причины:

- Повреждение бэкапа: Файл бэкапа был поврежден при создании, передаче или хранении.

- Неконсистентность данных: Бэкап базы данных был сделан без остановки или использования горячего режима, что привело к неконсистентным данным.

- Неверная версия бэкапа: Попытка восстановить из слишком старого или неподходящего бэкапа.

- Ошибка в процедуре восстановления: Неправильные команды, неверный порядок действий.

- Проблемы с шифрованием: Потерян ключ шифрования, неверная парольная фраза.

Диагностические команды и решения:

- Регулярное тестирование восстановления: Это единственная надежная защита. Если тестирование проводится регулярно, вы обнаружите проблему до реального сбоя.

- Проверка контрольных сумм: Если инструмент бэкапа поддерживает, проверьте контрольные суммы бэкапа.

- Проверка логов бэкапа: Изучите логи создания бэкапа на предмет ошибок или предупреждений.

- Документация: Строго следуйте документированной процедуре восстановления. Если ее нет, создайте ее.

- Ключи шифрования: Убедитесь, что используете правильный ключ или пароль. Храните их в надежном месте.

- Консистентность БД: Убедитесь, что для бэкапа БД использовались специализированные инструменты (

pg_dump,mysqldump, XtraBackup) или режим quiescing для снапшотов.

3. Проблема: Бэкап занимает слишком много места или времени

Возможные причины:

- Отсутствие дедупликации/сжатия: Инструмент не использует эти методы, или они отключены.

- Неэффективная политика ретенции: Слишком много старых бэкапов хранится слишком долго.

- Бэкап ненужных файлов: В бэкап попадают временные файлы, кеши, логи, которые не нужны для восстановления.

- Сетевые ограничения: Низкая пропускная способность сети между VPS и хранилищем.

- I/O ограничения: Дисковая подсистема VPS не справляется с нагрузкой при чтении данных для бэкапа.

Диагностические команды и решения:

- Настройка дедупликации/сжатия: Убедитесь, что ваш инструмент (Restic, Borg, Veeam Agent) использует дедупликацию и сжатие.

- Оптимизация политики ретенции: Пересмотрите RPO и определите, сколько версий и как долго нужно хранить. Настройте автоматическое удаление старых бэкапов.

- Исключение ненужных файлов: Используйте списки исключений (

--excludeдля rsync,.resticignoreдля Restic) для исключения временных файлов, кешей, директорий/tmp,/dev,/proc,/sys. - Мониторинг сети и I/O:

Рассмотрите увеличение пропускной способности сети или использование более производительных дисков.iperf3 -c your_backup_server_ip # Проверить пропускную способность сети iostat -x 1 # Мониторинг дисковой активности - Инкрементальные бэкапы: Используйте инкрементальные бэкапы вместо полных, когда это возможно.

4. Проблема: Высокие затраты на хранение или трафик

Возможные причины:

- Неоптимизированное использование классов хранилищ: Все бэкапы хранятся в "горячем" и дорогом хранилище.

- Чрезмерная ретенция: Слишком долгое хранение большого количества версий.

- Большой исходящий трафик (egress): Частые восстановления или репликация между регионами.

Диагностические команды и решения:

- Анализ счетов: Регулярно анализируйте счета от облачного провайдера, чтобы понять, какие статьи расходов являются основными (хранение, трафик, операции).

- Управление жизненным циклом (Lifecycle Policies): Настройте автоматический перевод старых бэкапов в более дешевые классы хранилищ (IA, Glacier) или их удаление.

- Оптимизация ретенции: См. выше.

- Минимизация egress: Планируйте восстановления заранее, если возможно. Рассмотрите кэширование или локальные реплики для часто используемых данных.

Когда обращаться в поддержку

Обращайтесь к своему хостинг-провайдеру или BaaS-провайдеру в следующих случаях:

- Проблемы с инфраструктурой провайдера: Если вы подозреваете, что проблема связана с оборудованием, сетью или сервисами самого провайдера (например, недоступность снапшотов, проблемы с блочным хранилищем).

- Невозможность восстановления из провайдерских бэкапов: Если их автоматические бэкапы не восстанавливаются.

- Проблемы с BaaS-решением: Если вы используете BaaS и сталкиваетесь с ошибками, которые не можете решить самостоятельно.

- Сетевые проблемы, которые не удается диагностировать: Если

pingиtracerouteпоказывают аномалии, но вы не можете определить их источник.

Перед обращением в поддержку всегда собирайте максимум информации: логи, скриншоты ошибок, время возникновения проблемы, шаги для воспроизведения. Это значительно ускорит процесс решения.

FAQ: Часто задаваемые вопросы о резервном копировании VPS

Что такое RPO и RTO и почему они так важны?