Развертывание бессерверных функций (FaaS) на своем VPS/Dedicated сервере с OpenFaaS или Knative: Экспертный гайд 2026

TL;DR

- Самостоятельный FaaS — это тренд 2026: Контроль, экономия и гибкость становятся критически важными, особенно для проектов с чувствительными данными или строгими требованиями к бюджету, в отличие от дорогостоящих проприетарных облачных решений.

- OpenFaaS для простоты и скорости: Идеален для быстрого старта и небольших команд, работает на любом Kubernetes или Docker Swarm, предлагает богатый набор шаблонов и активное сообщество.

- Knative для глубокой интеграции с Kubernetes: Предоставляет мощные возможности масштабирования (вплоть до нуля), управления трафиком и событийной архитектуры на базе нативных Kubernetes-примитивов, подходит для сложных, высоконагруженных систем.

- Ключевые факторы выбора: Производительность, масштабируемость, операционные издержки, экосистема, кривая обучения и стоимость играют решающую роль. В 2026 году особое внимание уделяется энергоэффективности и интеграции с AI/ML-ворклоадами.

- Экономия и контроль: Развертывание FaaS на собственном сервере позволяет значительно сократить операционные расходы в долгосрочной перспективе, избежать привязки к конкретному облачному провайдеру и обеспечить полный контроль над данными и инфраструктурой.

- Обязательная автоматизация: Для успешного управления self-hosted FaaS критически важны CI/CD, IaC (Terraform, Ansible) и продвинутые системы мониторинга (Prometheus, Grafana, Loki), чтобы минимизировать ручные операции.

- Будущее за гибридными решениями: Ожидается рост популярности гибридных FaaS-стратегий, где часть функций работает в публичном облаке, а критические — на собственном железе, что обеспечивает баланс между гибкостью и безопасностью.

Введение

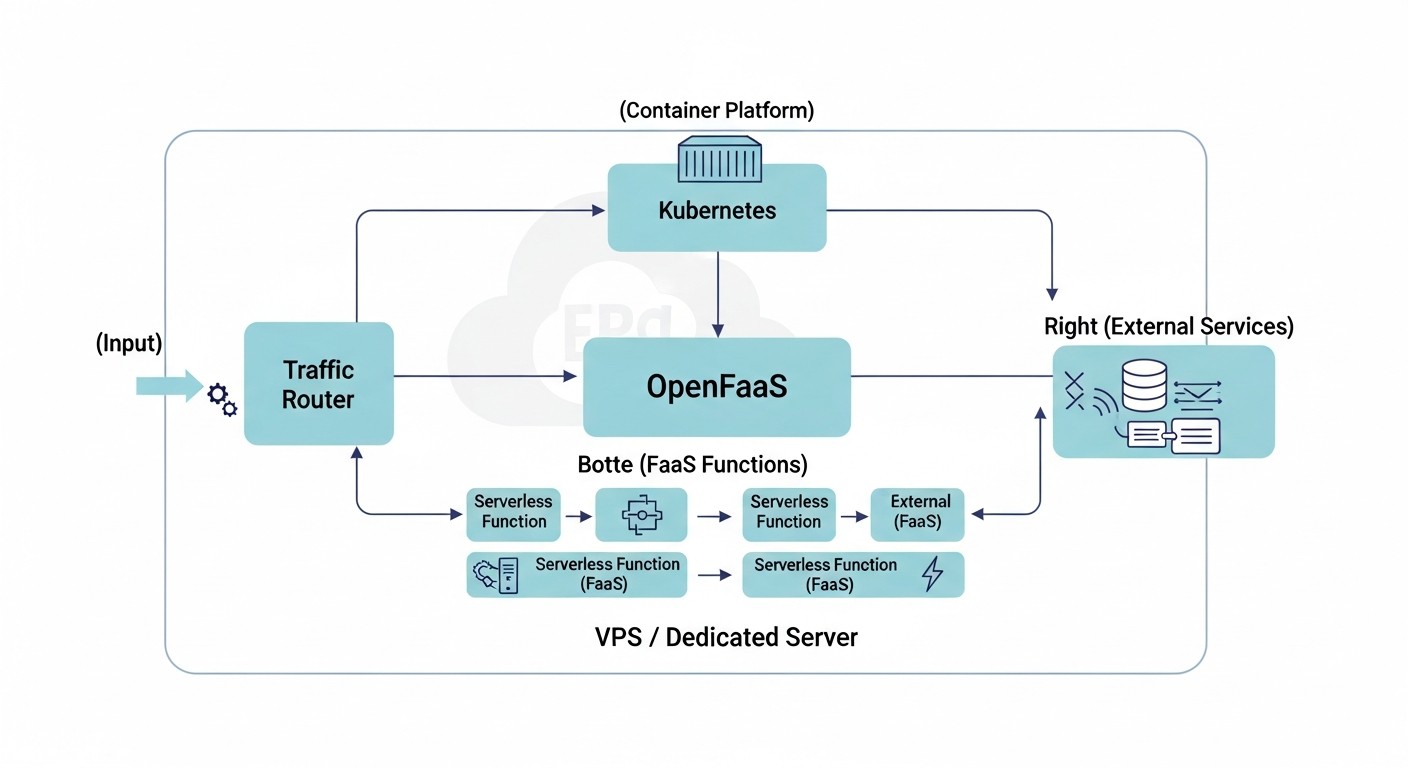

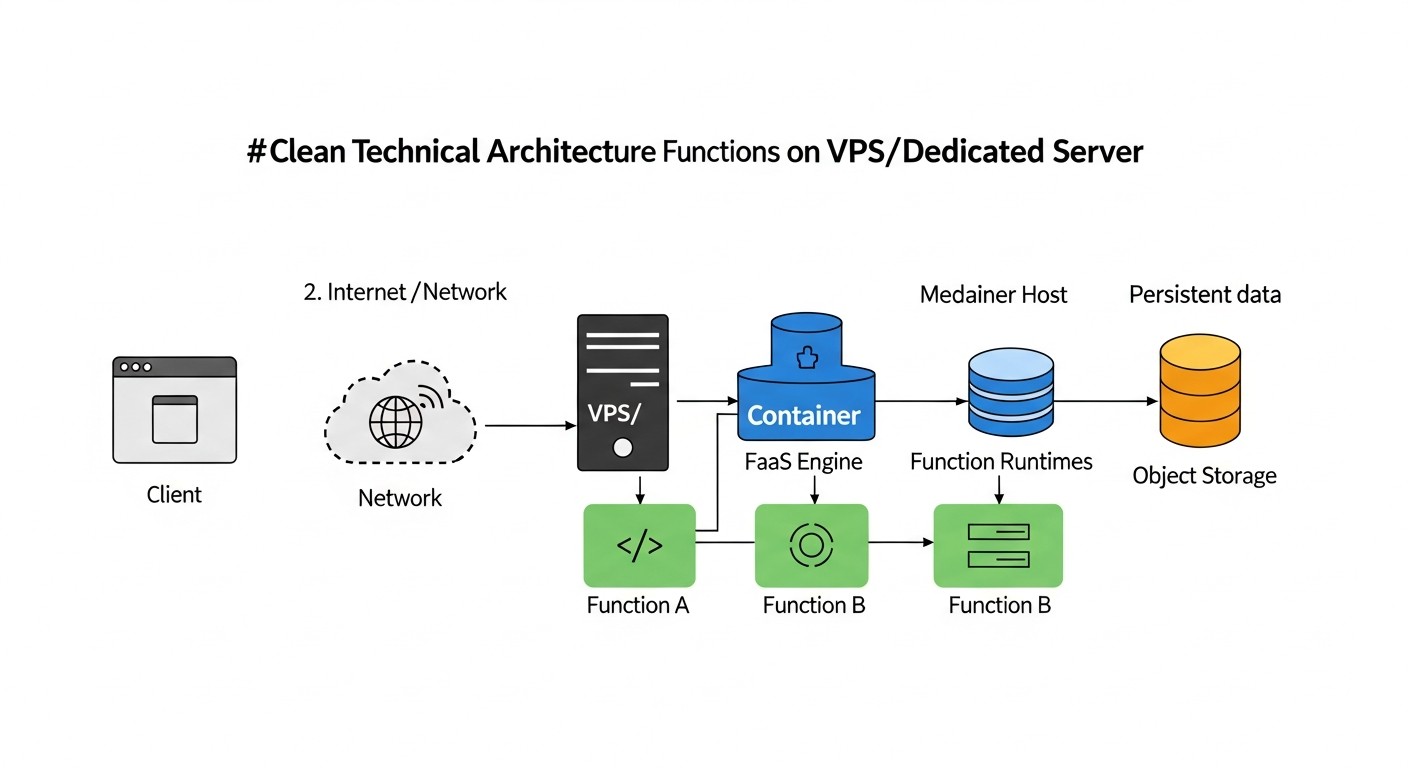

В 2026 году концепция бессерверных вычислений (Serverless, Functions as a Service - FaaS) уже не является футуристической, а стала стандартом де-факто для многих современных архитектур. Однако, если раньше FaaS ассоциировался исключительно с публичными облаками (AWS Lambda, Google Cloud Functions, Azure Functions), то сейчас все больше компаний, особенно стартапов и средних предприятий, переосмысливают эту парадигму. Причины просты: растущие затраты на облачные сервисы, стремление к полному контролю над данными и инфраструктурой, а также желание избежать вендор-лока. Именно здесь на сцену выходят решения для развертывания FaaS на собственном VPS или выделенном сервере, такие как OpenFaaS и Knative.

Эта статья адресована DevOps-инженерам, backend-разработчикам, фаундерам SaaS-проектов, системным администраторам и техническим директорам стартапов, которые ищут альтернативы дорогостоящим облачным FaaS-платформам или хотят построить гибридные облачные решения. Мы глубоко погрузимся в мир OpenFaaS и Knative, рассмотрим их преимущества и недостатки, предоставим практические рекомендации по развертыванию и эксплуатации, а также поможем оценить экономическую целесообразность такого подхода.

Мы живем в эпоху, когда оптимизация ресурсов и независимость от внешних провайдеров становятся не просто желательными, а зачастую критически важными. С ростом сложности приложений и объемов данных, а также ужесточением требований к конфиденциальности, возможность развернуть бессерверные функции на собственном оборудовании, сохраняя при этом гибкость и масштабируемость, становится мощным конкурентным преимуществом. Цель этого гайда — дать вам всю необходимую информацию для принятия обоснованного решения и успешной реализации FaaS-стратегии на своей инфраструктуре.

Основные критерии и факторы выбора

Выбор между OpenFaaS и Knative, а также решение о развертывании FaaS на собственном сервере, должны основываться на тщательном анализе множества факторов. В 2026 году, когда технологии развиваются семимильными шагами, а требования к надежности и производительности постоянно растут, эти критерии становятся еще более значимыми.

1. Производительность и время холодного старта (Cold Start Latency)

Время холодного старта — это задержка между вызовом функции и началом ее выполнения, если экземпляр функции неактивен. Для многих интерактивных приложений (API-шлюзы, вебхуки) это критический параметр. В 2026 году пользователи ожидают мгновенной реакции. OpenFaaS и Knative имеют разные подходы к управлению жизненным циклом функций, что влияет на холодный старт. Knative, благодаря своей интеграции с Kourier/Istio и продвинутым механизмам автомасштабирования, может достигать очень низких значений, вплоть до миллисекунд, за счет "прогрева" контейнеров или использования специализированных примитивов. OpenFaaS также активно работает над оптимизацией, предлагая различные стратегии удержания активных экземпляров. Оценивать следует на реальных нагрузках с учетом типичного размера и языка функции.

2. Масштабируемость и автомасштабирование

Возможность автоматически масштабировать функции в ответ на изменяющуюся нагрузку — краеугольный камень FaaS. В 2026 году это означает не просто горизонтальное масштабирование, но и интеллектуальное управление ресурсами. Knative Serverless построен на базе Kubernetes HPA (Horizontal Pod Autoscaler) и KEDA (Kubernetes Event-Driven Autoscaling), что позволяет масштабироваться от нуля до сотен экземпляров за секунды, используя метрики CPU, памяти, запросов или кастомные события. Это особенно важно для задач с пиковыми нагрузками. OpenFaaS также поддерживает автомасштабирование через HPA и KEDA, но его архитектура может потребовать более тонкой настройки для достижения такого же уровня гранулярности и скорости масштабирования до нуля. Для оценки необходимо проводить нагрузочное тестирование с различными профилями нагрузки.

3. Операционные издержки и сложность управления

Развертывание FaaS на собственном сервере подразумевает ответственность за всю инфраструктуру. Это включает в себя управление Kubernetes-кластером (если он используется), обновление компонентов, мониторинг, логирование и обеспечение безопасности. Knative, будучи более тесно интегрированным с Kubernetes, может потребовать более глубоких знаний Kubernetes-экосистемы. OpenFaaS, особенно в режиме Docker Swarm, предлагает более низкий порог входа. В 2026 году все больше инструментов автоматизации и IaC (Infrastructure as Code) упрощают эти задачи, но базовое понимание остается критическим. Оценка должна включать время, необходимое команде для изучения и поддержки системы, а также доступность квалифицированных специалистов.

4. Экосистема и интеграция

Насколько хорошо FaaS-платформа интегрируется с другими инструментами и сервисами? В 2026 году это означает бесшовную работу с системами CI/CD, базами данных, брокерами сообщений (Kafka, RabbitMQ, NATS), системами мониторинга (Prometheus, Grafana) и инструментами для работы с данными (например, хранилищами объектов). Knative, как часть Kubernetes-экосистемы, естественно выигрывает от богатого набора плагинов и интеграций Kubernetes. OpenFaaS также имеет обширную экосистему и поддерживает интеграцию через шлюзы и плагины, но может потребовать больше усилий для связки с некоторыми специфическими Kubernetes-сервисами. Важно оценить, насколько легко можно подключить существующие или планируемые сервисы.

5. Кривая обучения и входной порог

Насколько быстро ваша команда сможет освоить новую платформу и начать продуктивно работать? OpenFaaS часто считается более простым для начала из-за его фокуса на "функциях как Docker-контейнерах" и CLI. Knative, с его концепциями Service, Revision, Configuration, Route и глубокой интеграцией с Kubernetes, может иметь более крутую кривую обучения, особенно для тех, кто не очень знаком с Kubernetes. Однако, для команд, уже работающих с Kubernetes, Knative может показаться более естественным выбором. В 2026 году доступность обучающих материалов, документации и активного сообщества сильно влияет на этот фактор.

6. Стоимость и экономическая эффективность (TCO - Total Cost of Ownership)

Это один из ключевых факторов для перехода на собственное железо. В 2026 году стоимость владения включает не только аппаратное обеспечение (VPS/Dedicated), но и затраты на электроэнергию (для dedicated), лицензии (если применимо, но OpenFaaS/Knative open-source), зарплату инженеров, время на разработку, тестирование, деплоймент и поддержку. Самостоятельное развертывание FaaS позволяет избежать облачных наценок за каждый вызов функции и за использование ресурсов, но перекладывает операционную нагрузку на вашу команду. Важно провести детальный расчет TCO, сравнивая его с потенциальными расходами на облачные аналоги. Ожидается, что в 2026 году стоимость гигабайт-секунд в облаках продолжит расти, что делает self-hosted FaaS еще более привлекательным для долгосрочных проектов.

7. Безопасность и соответствие требованиям (Compliance)

Развертывание на собственном сервере дает полный контроль над безопасностью. Вы сами отвечаете за сетевую изоляцию, патчинг операционной системы, управление доступом, шифрование данных и соответствие нормативным требованиям (GDPR, PCI DSS и т.д.). OpenFaaS и Knative используют контейнерную изоляцию, что является хорошей базой, но требует дополнительной настройки. В 2026 году с усилением киберугроз и регуляций, возможность полностью контролировать стек безопасности становится критически важной. Необходимо оценить, есть ли у вашей команды экспертиза для обеспечения должного уровня безопасности.

8. Стойкость к отказам и высокая доступность (High Availability)

Как система поведет себя при сбое отдельного компонента или целого сервера? Knative, построенный на Kubernetes, естественно наследует его возможности по самовосстановлению и распределенной работе. Для достижения высокой доступности требуется кластер Kubernetes, а не один VPS. OpenFaaS также может работать в кластере Kubernetes или Docker Swarm, обеспечивая HA. Важно спроектировать инфраструктуру с учетом избыточности, используя несколько VPS или выделенных серверов, балансировщики нагрузки и репликацию данных. Оцените, сколько времени может потребоваться на восстановление после сбоя и какие потери данных допустимы.

9. Поддержка языков и фреймворков

Обе платформы поддерживают широкий спектр языков программирования через концепцию "функций как контейнеров". Вы можете упаковать практически любой код в Docker-образ и запустить его. OpenFaaS предлагает готовые шаблоны для популярных языков (Python, Node.js, Go, .NET Core, Java), что ускоряет разработку. Knative также гибок, позволяя использовать любые контейнеризированные приложения. В 2026 году это означает поддержку не только традиционных языков, но и новых runtime-ов, а также специализированных сред для AI/ML-моделей. Важно убедиться, что выбранная платформа поддерживает или легко расширяется для поддержки языков и фреймворков, используемых вашей командой.

Сравнительная таблица OpenFaaS vs Knative (Актуально на 2026 год)

Ниже представлена сравнительная таблица, которая поможет вам наглядно оценить ключевые различия между OpenFaaS и Knative, с учетом актуальных трендов и характеристик на 2026 год.

| Критерий | OpenFaaS | Knative | Комментарии (2026) |

|---|---|---|---|

| Базовая платформа | Kubernetes, Docker Swarm | Только Kubernetes | OpenFaaS сохраняет гибкость, Knative углубляет интеграцию с Kubernetes, что становится стандартом для сложных систем. |

| Сложность развертывания | Низкая-Средняя (особенно на Docker Swarm) | Средняя-Высокая (требует Kubernetes и его компонентов) | С появлением managed Kubernetes на VPS (например, k3s, MicroK8s), сложность Knative снижается, но OpenFaaS все равно проще для POC. |

| Масштабирование до нуля | Поддерживается, но требует настройки (KEDA) | Нативно встроено и оптимизировано | Knative остается лидером в этом аспекте, что критично для экономии ресурсов при отсутствии нагрузки. |

| Холодный старт | Хороший (50-300 мс) | Отличный (10-100 мс, с оптимизацией) | Knative использует более продвинутые механизмы для минимизации задержек, включая "прогрев" и быструю маршрутизацию. |

| Управление трафиком | Базовое (через шлюз) | Продвинутое (канареечные деплои, A/B-тестирование, процентное распределение) | Knative, благодаря Istio/Kourier, предлагает функции уровня L7, что незаменимо для сложных релизных стратегий. |

| Событийная модель | Через шлюз, внешние брокеры (NATS, Kafka) | Нативная интеграция с Knative Eventing (CloudEvents, брокеры) | Knative Eventing становится мощной платформой для event-driven архитектур, поддерживая множество источников событий. |

| Экосистема и сообщество | Активное, множество шаблонов функций | Очень активное, поддерживается Google, CNCF проект | Оба проекта имеют сильные сообщества, но Knative более тесно связан с общей Kubernetes-экосистемой. |

| Использование ресурсов (Idle) | Среднее (зависит от настроек) | Низкое (благодаря масштабированию до нуля) | Knative значительно эффективнее в режиме простоя, что важно для VPS/Dedicated серверов с фиксированной стоимостью. |

| Интеграция с CI/CD | Хорошая (faas-cli, Docker) | Отличная (kubectl, Tekton, Argo CD) | Оба легко интегрируются, но Knative предлагает более "Kubernetes-нативные" подходы, такие как Tekton. |

| Минимальные требования к CPU/RAM (для FaaS-движка) | 1 vCPU / 1 GB RAM | 2 vCPU / 2 GB RAM (плюс Kubernetes) | Эти значения актуальны для 2026 года для минимального рабочего кластера FaaS без пользовательских функций. |

| Оценочная стоимость 1 vCPU / 2GB RAM VPS в 2026 году | От 8-15 USD/мес | От 8-15 USD/мес (плюс доп. ресурсы для K8s) | Стоимость базового VPS останется относительно стабильной, но для Knative потребуется более мощный базовый K8s. |

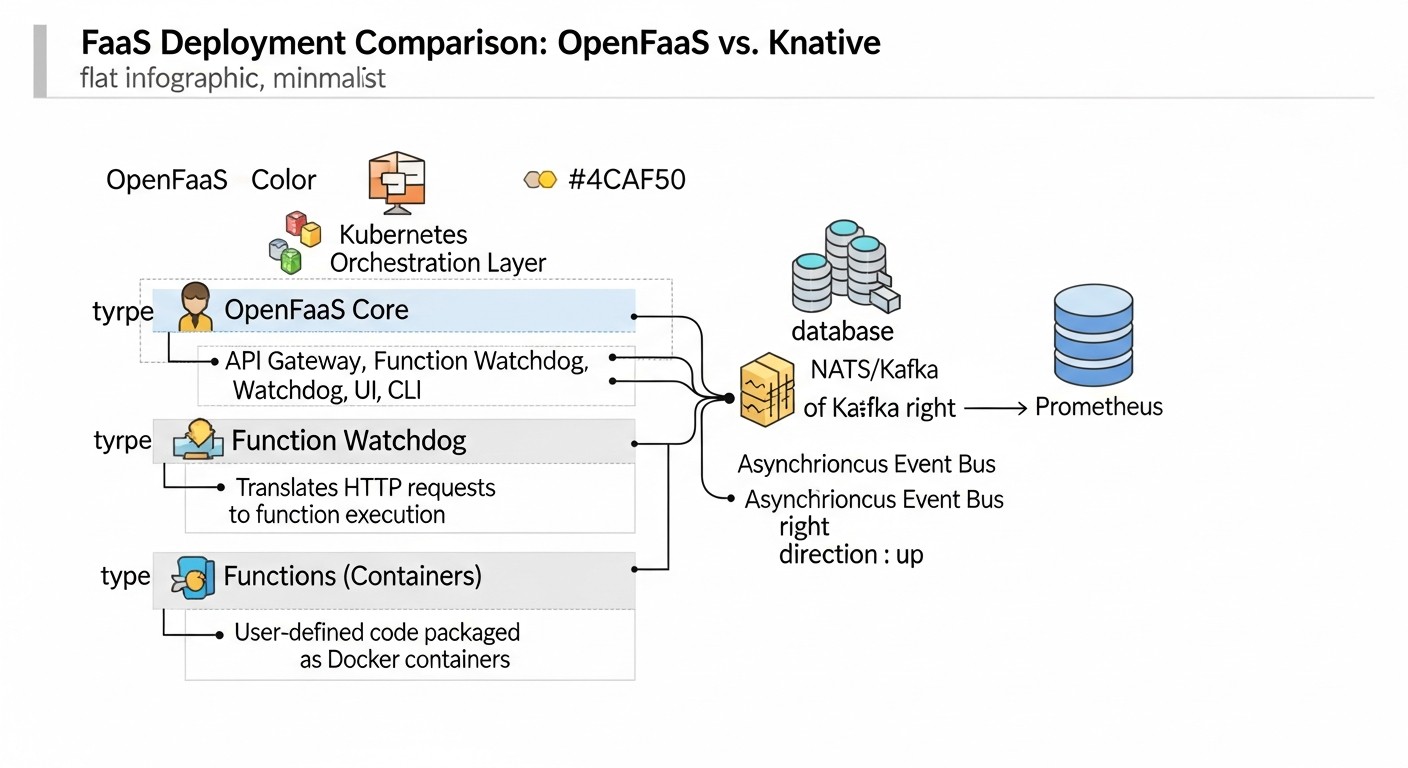

Детальный обзор OpenFaaS

OpenFaaS (Functions as a Service) — это фреймворк для создания бессерверных функций с использованием Docker-контейнеров. Он предоставляет простой способ упаковки любого процесса или сервиса в бессерверную функцию, которая может быть развернута на Kubernetes или Docker Swarm. Проект был запущен Алексом Эллисом в 2017 году и с тех пор активно развивается, предлагая удобный и гибкий подход к FaaS на собственной инфраструктуре.

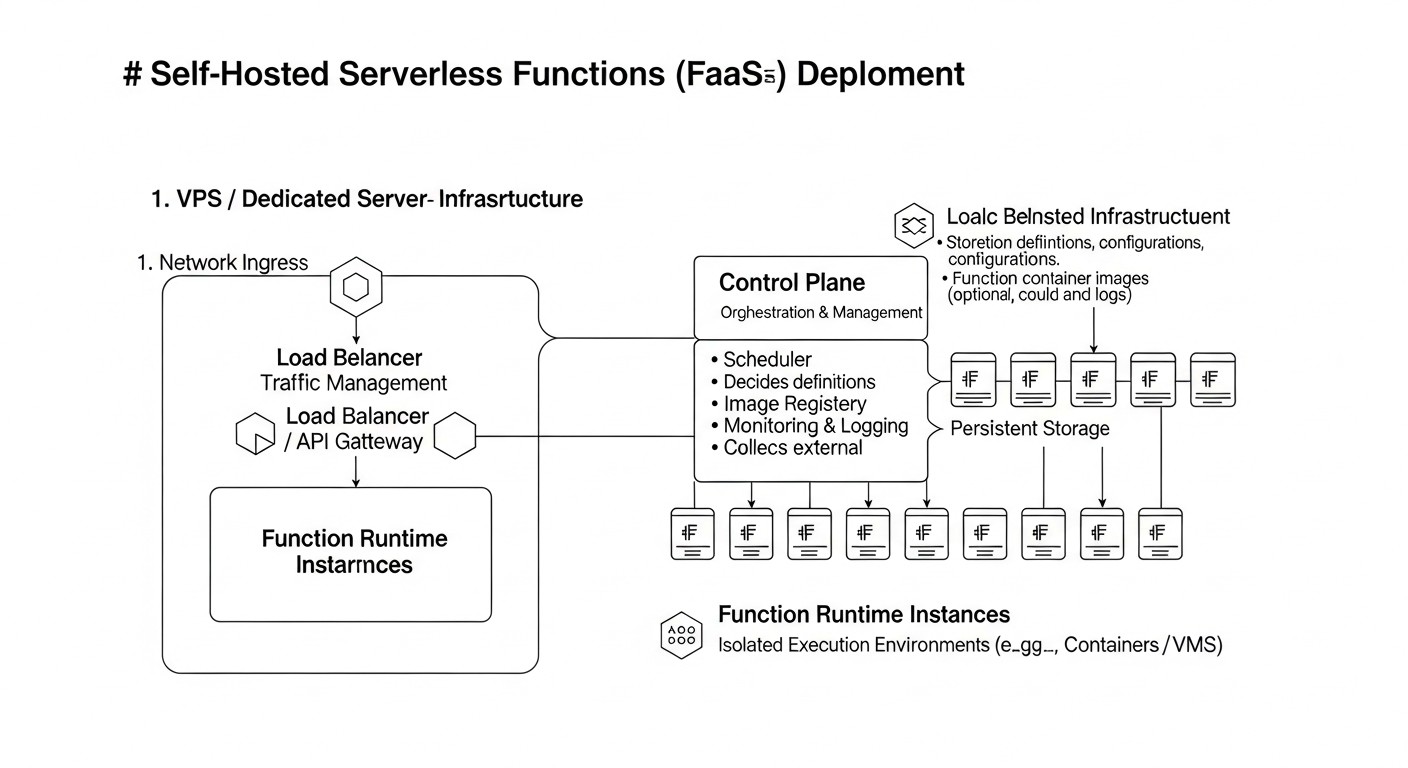

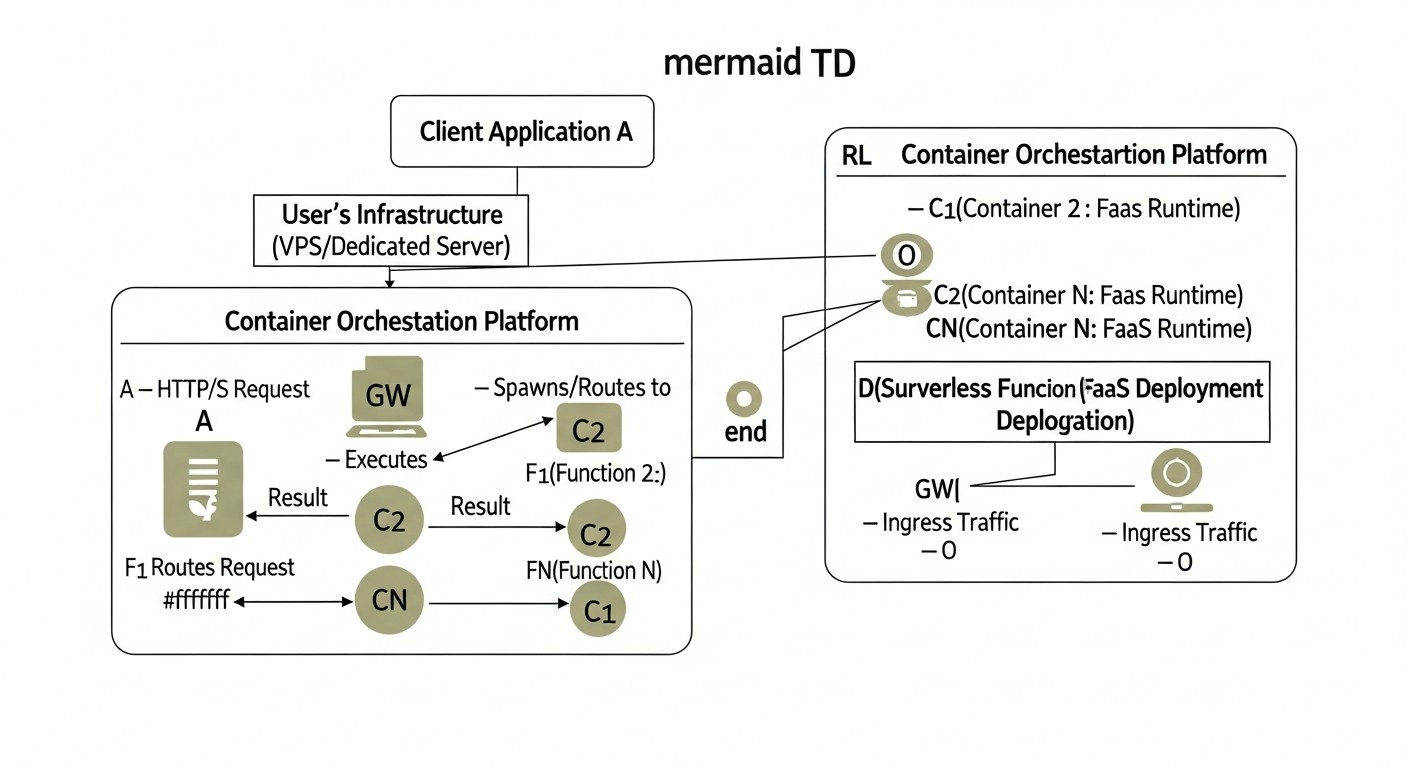

Принцип работы и архитектура

В основе OpenFaaS лежит архитектура, состоящая из нескольких ключевых компонентов:

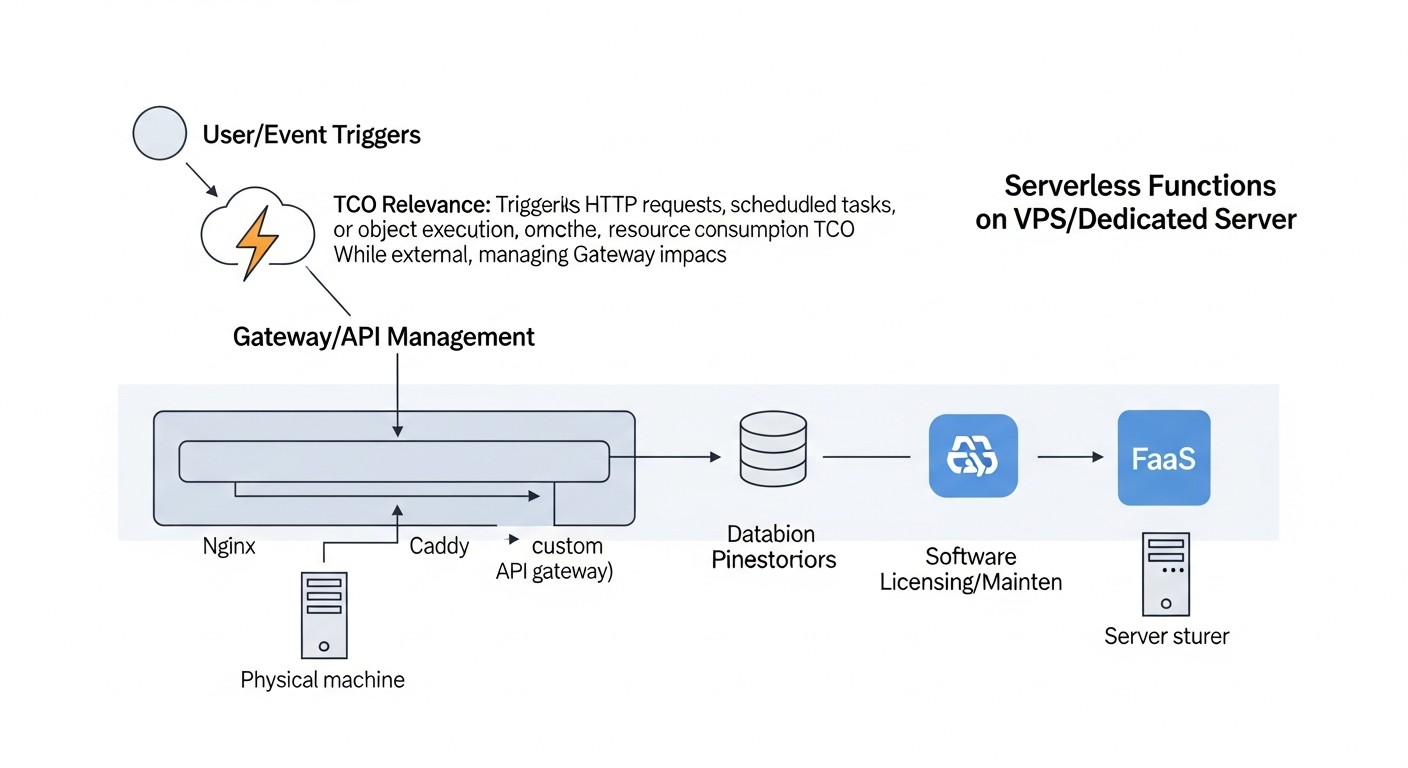

- Gateway (Шлюз): Это основной интерфейс для взаимодействия с OpenFaaS. Он обрабатывает входящие запросы, маршрутизирует их к соответствующим функциям, управляет автомасштабированием и предоставляет API для развертывания и управления функциями. Шлюз также отвечает за сбор метрик и логирование.

- Function Watchdog: Этот компонент запускается внутри каждого контейнера функции и отвечает за обработку входящих HTTP-запросов, передачу их вашей функции и возврат результатов. Он абстрагирует от разработчика детали взаимодействия с платформой, позволяя сосредоточиться на логике функции.

- Prometheus: OpenFaaS использует Prometheus для сбора метрик о вызовах функций, времени выполнения, ошибках и состоянии системы. Эти метрики используются для автомасштабирования и мониторинга.

- NATS Streaming (опционально): Для асинхронных вызовов и обработки событий OpenFaaS может использовать NATS Streaming в качестве брокера сообщений. Это позволяет строить более сложные событийно-ориентированные архитектуры.

Функции в OpenFaaS — это обычные Docker-контейнеры. Вы пишете код на любом языке, используете предоставленные шаблоны (или создаете свои), а OpenFaaS CLI (faas-cli) помогает собрать Docker-образ и развернуть его. Это делает OpenFaaS чрезвычайно гибким, поскольку вы можете использовать любые библиотеки и зависимости, которые могут быть упакованы в контейнер.

Плюсы OpenFaaS

- Простота и скорость старта: OpenFaaS известен своим низким порогом входа. С помощью

faas-cliи нескольких команд можно быстро развернуть первую функцию. Это особенно привлекательно для небольших команд или прототипирования. - Гибкость платформы: Поддержка как Kubernetes, так и Docker Swarm дает возможность выбора в зависимости от текущей инфраструктуры и экспертизы команды. В 2026 году, когда Kubernetes доминирует, поддержка Swarm остается нишевой, но полезной опцией.

- Широкая поддержка языков: Благодаря контейнерной природе, OpenFaaS может запускать функции, написанные на любом языке, для которого можно создать Docker-образ. Есть готовые шаблоны для Python, Node.js, Go, Java, PHP, Ruby, .NET Core и других.

- Активное сообщество и экосистема: Проект имеет большое и активное сообщество, множество примеров, плагинов и интеграций. Документация хорошо структурирована и постоянно обновляется.

- Открытый исходный код: Полностью открытый исходный код означает отсутствие вендор-лока и возможность полной кастомизации под свои нужды.

- Асинхронные вызовы и Event-Driven: Встроенная поддержка асинхронных вызовов через NATS Streaming позволяет легко строить событийно-ориентированные архитектуры, что становится все более важным в 2026 году.

Минусы OpenFaaS

- Менее нативная интеграция с Kubernetes: Хотя OpenFaaS работает на Kubernetes, он не использует его примитивы так глубоко, как Knative. Это может привести к необходимости дополнительной настройки для использования продвинутых функций Kubernetes (например, Service Mesh).

- Масштабирование до нуля требует KEDA: Для эффективного масштабирования функций до нуля (и экономии ресурсов в простое) OpenFaaS требует установки и настройки KEDA, что добавляет дополнительный слой сложности. Без KEDA функции могут оставаться в "горячем" состоянии, потребляя ресурсы.

- Меньше встроенных возможностей по управлению трафиком: По сравнению с Knative, OpenFaaS предлагает более базовые возможности по управлению трафиком (канареечные деплои, A/B-тестирование) "из коробки". Для продвинутых сценариев потребуется интеграция с внешними инструментами, такими как Istio.

- Возможное увеличение операционных издержек: Хотя старт прост, для поддержания высокодоступной и производительной системы на OpenFaaS на Kubernetes требуется понимание обоих стеков, что может увеличить операционную нагрузку.

Для кого подходит OpenFaaS

OpenFaaS идеально подходит для:

- Стартапов и небольших команд: Которым нужна быстрая и простая платформа FaaS для прототипирования и развертывания микросервисов без значительных инвестиций в обучение Kubernetes.

- Разработчиков, предпочитающих Docker: Тем, кто уже знаком с Docker и ценит его простоту для упаковки приложений.

- Проектов с умеренными требованиями к масштабированию: Где не требуется мгновенное масштабирование до сотен тысяч запросов в секунду или сверхнизкие задержки.

- Компаний, стремящихся к максимальной гибкости: И не желающих быть привязанными к конкретной платформе или облачному провайдеру.

- Разработчиков, создающих Event-Driven архитектуры: Благодаря нативной поддержке асинхронных вызовов и интеграции с NATS.

В 2026 году OpenFaaS продолжает быть сильным игроком в нише self-hosted FaaS, особенно для тех, кто ценит простоту и прямой контроль над Docker-контейнерами.

Детальный обзор Knative

Knative — это платформа, построенная на Kubernetes, предназначенная для развертывания и управления бессерверными рабочими нагрузками, контейнерами и функциями. Проект был запущен Google в 2018 году и с тех пор стал одним из ключевых компонентов в экосистеме бессерверных решений на Kubernetes. Knative не является полноценной FaaS-платформой в чистом виде, а скорее набором расширений для Kubernetes, который предоставляет примитивы для построения Serverless-приложений. Он состоит из двух основных компонентов: Knative Serving и Knative Eventing.

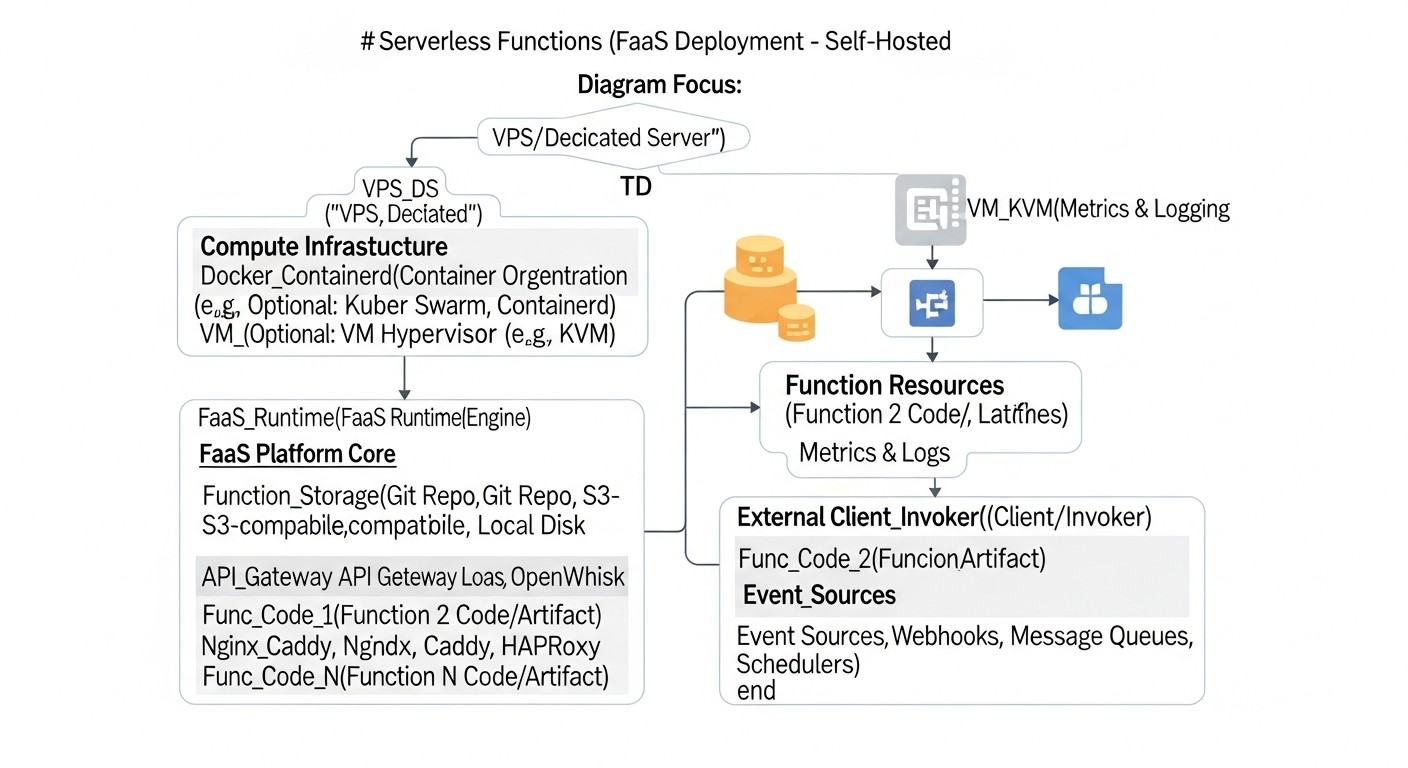

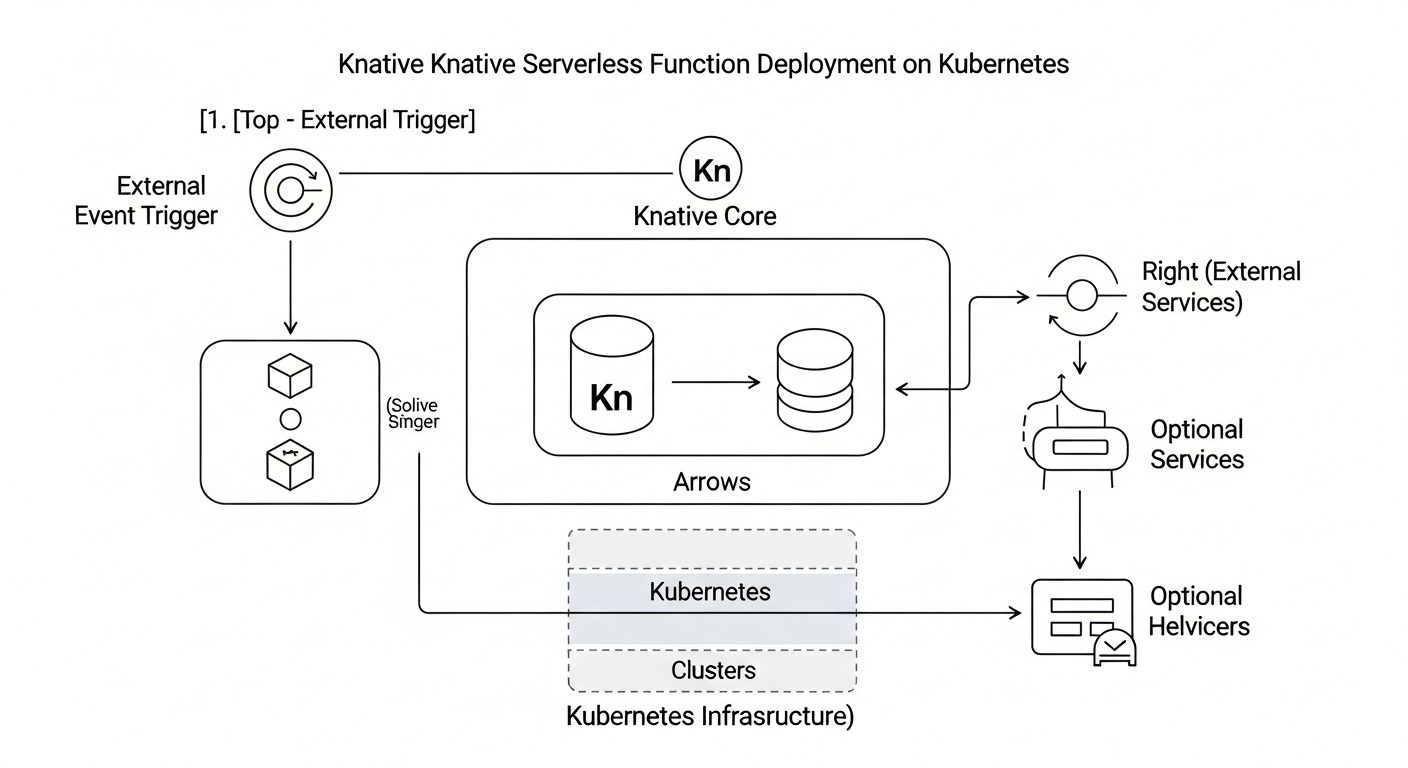

Принцип работы и архитектура

Knative глубоко интегрирован с Kubernetes и использует его возможности для управления жизненным циклом приложений. Его архитектура основана на следующих компонентах:

- Knative Serving: Этот компонент отвечает за развертывание и масштабирование сервисов (контейнеров), а также за управление трафиком. Он предоставляет Kubernetes-объекты (Service, Configuration, Revision, Route), которые позволяют определять, как приложения должны развертываться, масштабироваться (включая до нуля) и маршрутизироваться. Serving использует Service Mesh (такой как Istio или Kourier) для управления входящим трафиком и маршрутизацией.

- Knative Eventing: Этот компонент предназначен для создания событийно-ориентированных архитектур. Он предоставляет примитивы для отправки и получения событий (через CloudEvents), а также для их маршрутизации между различными сервисами. Eventing поддерживает различные источники событий (брокеры сообщений, SaaS-сервисы) и позволяет строить сложные цепочки обработки событий.

- Kubernetes: Knative работает поверх существующего Kubernetes-кластера, используя его возможности по оркестрации контейнеров, управлению ресурсами и обеспечению отказоустойчивости.

- Service Mesh (Istio/Kourier): Knative Serving активно использует Service Mesh для управления входящим трафиком, обеспечения канареечных деплоев, A/B-тестирования и других продвинутых функций маршрутизации. Kourier — это легковесный Ingress-контроллер, разработанный специально для Knative.

Функции в Knative по сути являются контейнеризированными приложениями. Вы можете использовать любой язык или фреймворк, который можно упаковать в Docker-образ. Knative автоматически создает Ingress-маршруты, управляет масштабированием и мониторит состояние сервиса.

Плюсы Knative

- Нативное масштабирование до нуля: Это одно из главных преимуществ Knative. Он автоматически масштабирует сервисы до нуля, когда нет входящего трафика, и быстро запускает их при появлении новых запросов. Это позволяет значительно экономить ресурсы на VPS/Dedicated сервере.

- Продвинутое управление трафиком: Благодаря интеграции с Service Mesh (Istio/Kourier), Knative предлагает мощные возможности по управлению трафиком: канареечные деплои, A/B-тестирование, процентное распределение трафика между различными версиями сервисов. Это критически важно для CI/CD и безопасных релизов.

- Глубокая интеграция с Kubernetes: Knative расширяет Kubernetes, используя его нативные примитивы. Это означает, что Knative "понимает" Kubernetes и хорошо с ним взаимодействует, что упрощает управление для команд, уже работающих с Kubernetes.

- Мощная событийная модель (Eventing): Knative Eventing предоставляет богатый набор инструментов для построения событийно-ориентированных архитектур, поддерживая CloudEvents и различные источники событий. В 2026 году это становится стандартом для распределенных систем.

- Открытый исходный код и поддержка Google: Проект является частью CNCF и активно поддерживается Google, что гарантирует его долгосрочное развитие и стабильность.

- Высокая производительность: Оптимизированное масштабирование и управление трафиком позволяют достигать очень низких задержек холодного старта, что важно для высоконагруженных систем.

Минусы Knative

- Высокий порог входа и сложность развертывания: Knative требует глубоких знаний Kubernetes. Развертывание Knative и его зависимостей (таких как Istio или Kourier) может быть сложным и трудоемким процессом, особенно на "голом" VPS.

- Зависимость от Kubernetes: Knative не может работать без Kubernetes. Если ваша команда не имеет опыта работы с Kubernetes, это может стать серьезным препятствием.

- Более высокие требования к ресурсам: Базовый кластер Kubernetes плюс Knative и его компоненты потребляют больше ресурсов по сравнению с минимальной установкой OpenFaaS. Это может быть проблемой для очень маленьких VPS.

- Ограниченная гибкость платформы: В отличие от OpenFaaS, Knative не поддерживает Docker Swarm, что ограничивает выбор инфраструктуры только Kubernetes.

- Более крутая кривая обучения: Для полного освоения Knative требуется понимание его специфических объектов и концепций (Service, Revision, Configuration, Route), что может занять больше времени.

Для кого подходит Knative

Knative — отличный выбор для:

- Команд с опытом работы с Kubernetes: Если ваша команда уже активно использует Kubernetes, Knative будет естественным расширением вашей инфраструктуры.

- Проектов с высокими требованиями к масштабированию: Особенно для тех, где требуется масштабирование от нуля и обработка пиковых нагрузок с минимальными задержками.

- Разработчиков, строящих сложные микросервисные и событийно-ориентированные архитектуры: Knative Eventing и продвинутое управление трафиком делают его идеальным для таких сценариев.

- Компаний, которым важен полный контроль над трафиком: И кто нуждается в канареечных деплоях, A/B-тестировании и других продвинутых стратегиях выпуска.

- Предприятий, ориентированных на долгосрочное развитие: Knative, как часть экосистемы CNCF и поддерживаемый Google, имеет хорошую перспективу развития.

В 2026 году Knative является выбором по умолчанию для серьезных, высоконагруженных Serverless-проектов на Kubernetes, где инвестиции в обучение и инфраструктуру окупаются мощностью и гибкостью платформы.

Практические советы и рекомендации по развертыванию

Развертывание FaaS на собственном VPS/Dedicated сервере требует внимательного планирования и поэтапного выполнения. Ниже представлены практические рекомендации, которые помогут вам успешно реализовать эту задачу в 2026 году.

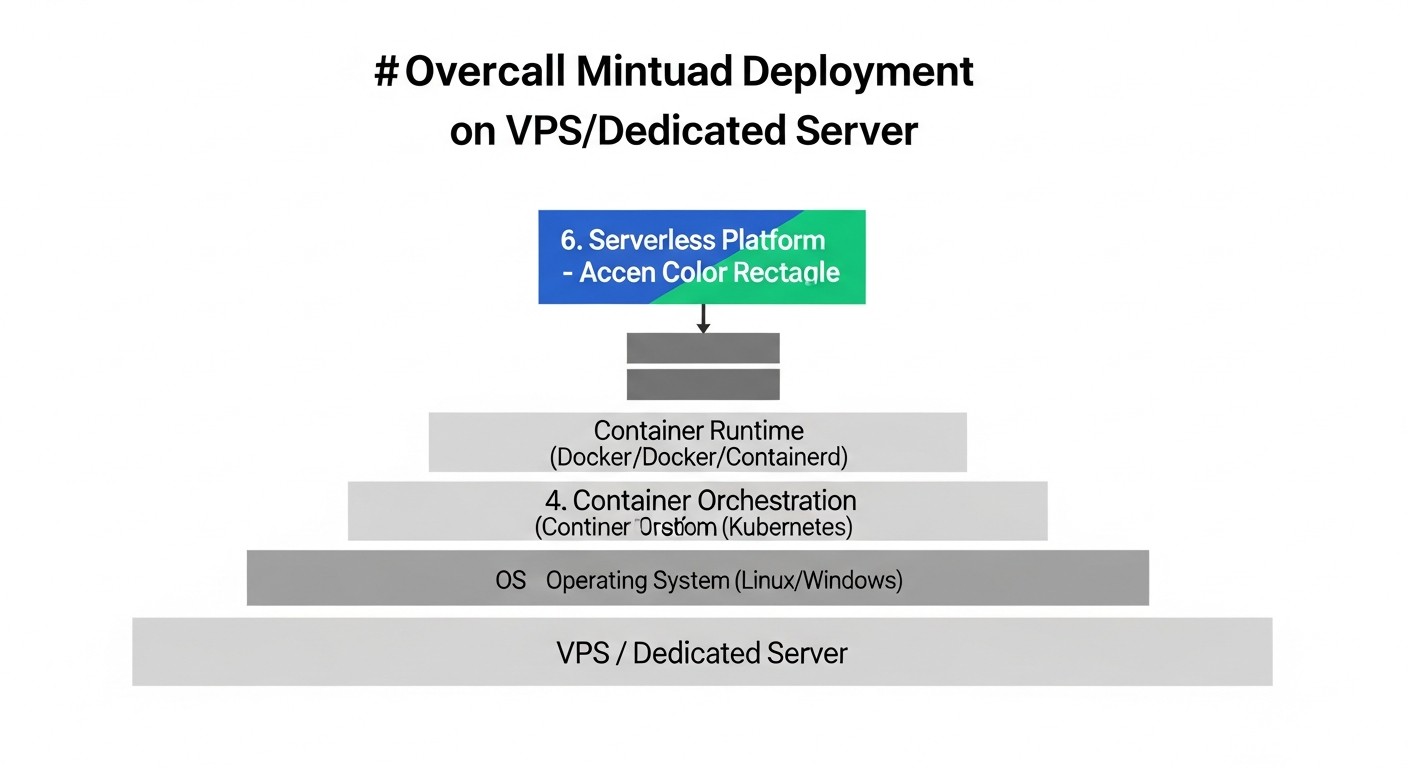

1. Выбор и подготовка сервера

- Характеристики: Для минимального кластера Kubernetes с OpenFaaS или Knative в 2026 году рекомендуется VPS/Dedicated с не менее 4 vCPU, 8 GB RAM и 100 GB SSD. Для рабочей нагрузки эти значения будут значительно выше. Рассмотрите использование NVMe SSD для улучшения производительности ввода-вывода, что критично для контейнерных нагрузок.

- Операционная система: Ubuntu Server (LTS), CentOS Stream или Debian. Убедитесь, что ядро Linux обновлено до последней стабильной версии.

- Безопасность: Настройте файрвол (ufw/firewalld), закройте все ненужные порты, настройте SSH-доступ только по ключам, отключите вход под root. Регулярно обновляйте ОС и все пакеты.

- Виртуализация (для VPS): Убедитесь, что ваш VPS-провайдер предлагает KVM-виртуализацию, так как она обеспечивает лучшую производительность и совместимость с Docker/Kubernetes по сравнению с OpenVZ.

2. Установка Kubernetes (для OpenFaaS и Knative)

В 2026 году для легковесных кластеров на VPS часто используются k3s или MicroK8s. Для более серьезных систем — kubeadm.

Пример установки k3s на Ubuntu Server:

# Обновление системы

sudo apt update && sudo apt upgrade -y

# Установка k3s (однонодовый кластер)

curl -sfL https://get.k3s.io | sh -

# Проверка статуса

sudo systemctl status k3s

# Настройка kubectl

mkdir -p ~/.kube

sudo cp /etc/rancher/k3s/k3s.yaml ~/.kube/config

sudo chown $(id -u):$(id -g) ~/.kube/config

# Проверка кластера

kubectl get nodes

kubectl get pods -A

Для multi-node кластера используйте токены и присоединяйте агентов. Для Knative потребуется более стабильный и мощный кластер Kubernetes.

3. Развертывание OpenFaaS

Предполагается, что Kubernetes уже установлен.

Установка OpenFaaS CLI:

curl -SLs https://cli.openfaas.com | sudo sh

Развертывание OpenFaaS в Kubernetes:

# Создание namespace

kubectl apply -f https://raw.githubusercontent.com/openfaas/faas-netes/master/namespaces.yml

# Развертывание OpenFaaS (стандартная установка)

kubectl apply -f https://raw.githubusercontent.com/openfaas/faas-netes/master/yaml/openfaas.yml

# Развертывание OpenFaaS (с KEDA для масштабирования до нуля)

# Сначала установите KEDA: https://keda.sh/docs/latest/deployments/#install-with-helm

# Затем разверните OpenFaaS с KEDA-enabled конфигурацией:

# kubectl apply -f https://raw.githubusercontent.com/openfaas/faas-netes/master/yaml/openfaas-keda.yml

# Получение пароля админа

echo $(kubectl -n openfaas get secret basic-auth -o jsonpath="{.data.basic_auth_password}" | base64 --decode)

# Экспортирование шлюза (пример для NodePort, для продакшена используйте Ingress)

kubectl -n openfaas port-forward svc/gateway 8080:8080 &

export OPENFAAS_URL=http://127.0.0.1:8080

# Логин

echo -n "admin" | faas-cli login -g $OPENFAAS_URL -u admin --password-stdin

Пример развертывания функции (Python):

# Создание новой функции

faas-cli new --lang python3-http hello-world-py

# Редактирование handler.py и requirements.txt

# (например, добавьте print("Hello, FaaS!"))

# Сборка и деплой

faas-cli build -f hello-world-py.yml

faas-cli deploy -f hello-world-py.yml

# Вызов функции

faas-cli invoke hello-world-py --set-env MESSAGE="OpenFaaS!"

4. Развертывание Knative

Предполагается, что Kubernetes уже установлен и настроен.

Установка Knative Serving:

# Установка Istio (рекомендуется для Knative) или Kourier

# Для Istio: https://istio.io/latest/docs/setup/install/

# Для Kourier (легковесный Ingress):

kubectl apply -f https://github.com/knative/serving/releases/download/knative-v1.12.0/kourier.yaml # Проверьте актуальную версию

# Установка Knative Serving

kubectl apply -f https://github.com/knative/serving/releases/download/knative-v1.12.0/serving-core.yaml # Проверьте актуальную версию

# Установка Knative net-kourier (если используется Kourier)

kubectl apply -f https://github.com/knative/serving/releases/download/knative-v1.12.0/serving-default-domain.yaml # Проверьте актуальную версию

kubectl apply -f https://github.com/knative/serving/releases/download/knative-v1.12.0/net-kourier.yaml # Проверьте актуальную версию

# Проверка статуса

kubectl get pods -n knative-serving

kubectl get pods -n kourier-system # или istio-system

Установка Knative Eventing (опционально):

# Установка Knative Eventing Core

kubectl apply -f https://github.com/knative/eventing/releases/download/knative-v1.12.0/eventing-core.yaml # Проверьте актуальную версию

# Установка Broker (например, InMemoryChannel)

kubectl apply -f https://github.com/knative/eventing/releases/download/knative-v1.12.0/in-memory-channel.yaml # Проверьте актуальную версию

# Установка Broker Default Configuration

kubectl apply -f https://github.com/knative/eventing/releases/download/knative-v1.12.0/mt-broker-config.yaml # Проверьте актуальную версию

# Проверка статуса

kubectl get pods -n knative-eventing

Пример развертывания сервиса Knative (Go):

# service.yaml

apiVersion: serving.knative.dev/v1

kind: Service

metadata:

name: helloworld-go

namespace: default

spec:

template:

spec:

containers:

- image: docker.io/knative/helloworld-go # Пример готового образа

ports:

- containerPort: 8080

env:

- name: TARGET

value: "Go Serverless with Knative!"

# Развертывание

kubectl apply -f service.yaml

# Получение URL сервиса

kubectl get ksvc helloworld-go -o jsonpath='{.status.url}'

5. Мониторинг и логирование

Обязательно настройте стек мониторинга (Prometheus, Grafana) и централизованное логирование (Loki/Fluentd/Elasticsearch). OpenFaaS по умолчанию использует Prometheus, что упрощает интеграцию. Для Knative это также стандартный подход.

# Пример установки Prometheus и Grafana через Helm

helm repo add prometheus-community https://prometheus-community.github.io/helm-charts

helm repo update

helm install prometheus prometheus-community/kube-prometheus-stack --namespace monitoring --create-namespace

# Установка Loki и Promtail

helm repo add grafana https://grafana.github.io/helm-charts

helm repo update

helm install loki grafana/loki --namespace logging --create-namespace

helm install promtail grafana/promtail --namespace logging --create-namespace

6. Автоматизация CI/CD

В 2026 году ручное развертывание FaaS-функций — это анахронизм. Инвестируйте в CI/CD. Используйте GitHub Actions, GitLab CI, Jenkins, Tekton или Argo CD для автоматической сборки, тестирования и развертывания функций при каждом коммите.

- Для OpenFaaS: Интегрируйте

faas-cli buildиfaas-cli deployв ваш CI/CD пайплайн. - Для Knative: Используйте

kubectl apply -fдля Knative Service YAML-файлов. Tekton Pipelines, разработанный для Kubernetes-нативных CI/CD, идеально подходит для Knative.

7. Управление секретами

Никогда не храните конфиденциальные данные (API-ключи, пароли к БД) в коде или Docker-образах. Используйте Kubernetes Secrets, External Secrets, HashiCorp Vault или аналогичные решения для безопасного хранения и доступа к секретам. В 2026 году это не просто рекомендация, а обязательное требование безопасности.

8. Сетевая конфигурация

Настройте Ingress-контроллер (Nginx Ingress, Traefik) для доступа к вашим FaaS-функциям извне, если вы не используете Istio/Kourier. Убедитесь, что DNS-записи правильно указывают на ваш сервер. Используйте Let's Encrypt для бесплатных SSL/TLS-сертификатов.

Типичные ошибки при развертывании FaaS на своем сервере

Развертывание и эксплуатация бессерверных функций на собственной инфраструктуре, при всей своей привлекательности, сопряжено с рядом типичных ошибок. Знание этих подводных камней поможет вам избежать дорогостоящих проблем и обеспечить стабильную работу системы.

1. Недооценка сложности Kubernetes

Ошибка: Предположение, что Kubernetes — это просто "Docker Compose на стероидах", и его можно легко освоить и поддерживать без должного опыта. Особенно актуально для Knative, который глубоко интегрирован с Kubernetes.

Как избежать: Инвестируйте в обучение команды. Выделите время на изучение основных концепций Kubernetes (поды, деплойменты, сервисы, ингрессы, контроллеры, операторы). Начните с простых кластеров (k3s, MicroK8s) и постепенно усложняйте. Если команда не готова к Kubernetes, OpenFaaS на Docker Swarm может быть лучшим стартовым решением.

Последствия: Частые сбои кластера, проблемы с масштабированием, уязвимости безопасности, "останавливающийся" деплоймент, который никто не может понять и починить, что приводит к простою сервисов и потере данных.

2. Игнорирование мониторинга и логирования

Ошибка: Развертывание функций без адекватных систем мониторинга производительности и централизованного логирования. В надежде, что "все будет работать".

Как избежать: Настройте Prometheus (для метрик), Grafana (для дашбордов) и Loki (для централизованного сбора логов) с самого начала. Интегрируйте их с вашими FaaS-платформами. OpenFaaS по умолчанию генерирует Prometheus-метрики. Для Knative это также стандартный подход. Обучите команду использовать эти инструменты для диагностики проблем.

Последствия: "Слепое" управление системой, невозможность быстро определить причину сбоев, долгие часы отладки, потеря ценных данных о производительности, что в 2026 году является недопустимой роскошью.

3. Отсутствие автоматизации CI/CD

Ошибка: Ручное развертывание функций или использование простых скриптов, которые не покрывают весь жизненный цикл (сборка, тестирование, деплой, откат).

Как избежать: Внедрите полный CI/CD пайплайн с использованием инструментов вроде GitHub Actions, GitLab CI, Jenkins, Tekton или Argo CD. Автоматизируйте сборку Docker-образов, тестирование функций, развертывание в тестовых и продакшн-средах, а также возможность быстрого отката. Для Knative особенно полезен Tekton.

Последствия: Медленные и подверженные ошибкам релизы, несогласованность сред, "синдром работает на моей машине", невозможность быстро реагировать на баги и обновления, что снижает скорость разработки и надежность сервиса.

4. Неправильное управление секретами и конфиденциальными данными

Ошибка: Хранение API-ключей, паролей к базам данных и других секретов непосредственно в коде функций, в Docker-образах или в открытом виде в YAML-файлах Kubernetes.

Как избежать: Используйте специализированные решения для управления секретами, такие как Kubernetes Secrets (с шифрованием etcd), External Secrets, HashiCorp Vault. Настройте RBAC в Kubernetes для ограничения доступа к секретам. Внедрите практику использования переменных окружения, которые динамически подставляются из безопасного хранилища.

Последствия: Утечка конфиденциальных данных, компрометация систем, нарушение требований безопасности и регуляций, что может привести к огромным финансовым и репутационным потерям.

5. Недостаточное планирование ресурсов и масштабирования

Ошибка: Развертывание FaaS на VPS с минимальными характеристиками без учета пиковых нагрузок или потенциального роста. Игнорирование настройки автомасштабирования.

Как избежать: Проведите нагрузочное тестирование ваших функций. Оцените ожидаемые пиковые нагрузки и обеспечьте достаточный запас ресурсов (CPU, RAM, дисковое пространство). Настройте Horizontal Pod Autoscaler (HPA) или KEDA для автоматического масштабирования функций. Для Knative убедитесь, что его встроенное автомасштабирование настроено оптимально. Планируйте возможность вертикального масштабирования VPS или перехода на выделенный сервер с запасом.

Последствия: Отказ функций под нагрузкой, долгие времена ответа, перегрузка сервера, недоступность сервиса, что приводит к недовольству пользователей и потере доходов.

6. Игнорирование сетевой безопасности и конфигурации

Ошибка: Оставление открытых портов, неправильная настройка Ingress-контроллеров, отсутствие SSL/TLS шифрования.

Как избежать: Настройте файрвол на VPS (UFW, iptables) и в Kubernetes (Network Policies) для ограничения доступа к компонентам. Используйте Ingress-контроллеры (Nginx, Traefik, Kourier, Istio) для маршрутизации внешнего трафика. Внедрите SSL/TLS для всех внешних конечных точек, используя Let's Encrypt или собственные сертификаты. Рассмотрите использование Web Application Firewall (WAF) для защиты от распространенных атак.

Последствия: Несанкционированный доступ, DDoS-атаки, перехват данных, что ставит под угрозу всю систему и ее пользователей.

7. Отсутствие резервного копирования и стратегии восстановления

Ошибка: Развертывание критически важных FaaS-сервисов без регулярного резервного копирования конфигурации Kubernetes, данных функций и баз данных.

Как избежать: Регулярно создавайте резервные копии etcd-кластера Kubernetes (для восстановления состояния кластера). Для постоянных данных, используемых функциями, настройте резервное копирование соответствующих баз данных или хранилищ. Разработайте и протестируйте план аварийного восстановления (DRP), чтобы знать, как быстро восстановить систему после серьезного сбоя.

Последствия: Полная потеря данных и конфигурации при сбое сервера, невозможность восстановления сервиса, что приводит к катастрофическим последствиям для бизнеса.

Чеклист для практического применения

Этот чеклист поможет вам структурировать процесс развертывания и эксплуатации бессерверных функций на вашем собственном VPS или выделенном сервере, обеспечивая полноту и надежность каждого шага.

Подготовка Инфраструктуры

- Выбор сервера: Определить требуемые характеристики VPS/Dedicated сервера (CPU, RAM, SSD, сеть) исходя из ожидаемой нагрузки и выбрать провайдера. (Рекомендация 2026: не менее 4 vCPU, 8GB RAM, NVMe SSD для K8s).

- Установка ОС: Установить выбранную операционную систему (Ubuntu Server LTS, CentOS Stream, Debian) и обновить до последней стабильной версии.

- Базовая безопасность: Настроить файрвол (UFW/firewalld), SSH-доступ по ключам, отключить root-логин, установить fail2ban.

- Установка Docker: Установить Docker Engine и настроить его для автоматического запуска.

- Установка Kubernetes: Развернуть Kubernetes-кластер (k3s, MicroK8s, kubeadm) и настроить

kubectl. Убедиться в работоспособности кластера.

Выбор и Развертывание FaaS-Платформы

- Выбор FaaS: Принять решение между OpenFaaS и Knative на основе анализа критериев (производительность, сложность, масштабирование, экосистема).

- Развертывание OpenFaaS / Knative:

- Для OpenFaaS: Установить

faas-cli, развернуть OpenFaaS в Kubernetes (или Docker Swarm), настроить KEDA для масштабирования до нуля. - Для Knative: Развернуть Knative Serving (с Kourier/Istio) и Knative Eventing (опционально), настроить Ingress/Gateway.

- Для OpenFaaS: Установить

- Тестовая функция: Развернуть простую "Hello World" функцию на выбранной платформе для проверки работоспособности.

Настройка и Оптимизация

- Мониторинг: Установить Prometheus и Grafana для сбора метрик и визуализации дашбордов. Интегрировать с FaaS-платформой и Kubernetes.

- Логирование: Настроить централизованное логирование (Loki + Promtail/Fluentd) для сбора логов функций и компонентов кластера.

- CI/CD Пайплайн: Разработать и внедрить CI/CD пайплайн (GitHub Actions, GitLab CI, Jenkins, Tekton) для автоматической сборки, тестирования и развертывания функций.

- Управление секретами: Реализовать безопасное управление секретами (Kubernetes Secrets, External Secrets, Vault) для конфиденциальных данных функций.

- Сетевая конфигурация: Настроить Ingress-контроллер, DNS-записи и SSL/TLS-сертификаты (Let's Encrypt) для доступа к функциям.

- Автомасштабирование: Тонко настроить политики автомасштабирования (HPA, KEDA, Knative Serving) для оптимального использования ресурсов и быстрого реагирования на нагрузку.

- Резервное копирование: Настроить регулярное резервное копирование конфигурации Kubernetes (etcd) и любых постоянных данных, используемых функциями. Разработать DRP.

Эксплуатация и Развитие

- Нагрузочное тестирование: Провести нагрузочное тестирование функций для выявления узких мест и проверки настроек масштабирования.

- Оптимизация производительности: Регулярно анализировать метрики производительности и оптимизировать код функций, конфигурации контейнеров и параметры FaaS-платформы.

- Обновления: Разработать стратегию регулярного обновления Kubernetes, FaaS-платформы и операционной системы для поддержания безопасности и получения новых функций.

- Безопасность: Регулярно проводить аудиты безопасности, применять патчи, обновлять политики доступа и следить за уязвимостями.

- Документация: Поддерживать актуальную документацию по архитектуре, развертыванию, эксплуатации и устранению неисправностей.

Расчет стоимости / Экономика владения (TCO)

Переход на self-hosted FaaS часто мотивирован экономическими соображениями. Однако важно понимать, что "бесплатный" open-source не означает "бесплатную" эксплуатацию. В 2026 году, когда стоимость облачных ресурсов продолжает расти, а квалифицированный персонал становится все дороже, расчет Total Cost of Ownership (TCO) становится критически важным.

Основные компоненты TCO

- Аппаратное обеспечение / Аренда VPS/Dedicated:

- VPS: Для небольших проектов или стартапов это основной вариант. Стоимость будет зависеть от количества vCPU, RAM, SSD и пропускной способности сети. В 2026 году стоимость базового VPS (4vCPU/8GB RAM/100GB NVMe SSD) составляет от $15 до $30 в месяц. Для более мощных конфигураций (8vCPU/16GB RAM/200GB NVMe SSD) — от $40 до $80 в месяц.

- Dedicated Server: Для крупных проектов с высокими требованиями к производительности и безопасности. Стоимость аренды выделенного сервера (например, Intel Xeon E-23xx, 6-8 ядер, 64-128GB RAM, 2x1TB NVMe SSD) может составлять от $150 до $400+ в месяц.

- Затраты на персонал (самые значительные скрытые расходы):

- DevOps-инженеры: Необходимы для развертывания, настройки, мониторинга и поддержки Kubernetes, FaaS-платформы, CI/CD, безопасности. Стоимость часа работы квалифицированного DevOps-инженера в 2026 году может варьироваться от $50 до $150+ в зависимости от региона и опыта. Даже если это 0.25-0.5 ставки, это значительные расходы.

- Разработчики: Время, затраченное на изучение платформы, написание функций, отладку.

- Системные администраторы: Для обслуживания базовой ОС и аппаратного обеспечения (если dedicated).

- Лицензии и инструменты (обычно минимальны для Open Source):

- Большинство инструментов (Kubernetes, OpenFaaS, Knative, Prometheus, Grafana) являются Open Source и бесплатны.

- Могут быть платные инструменты для безопасности, продвинутого мониторинга, CI/CD (например, Enterprise-версии Jenkins, GitLab EE).

- Электроэнергия и охлаждение (для Dedicated Server): Если вы владеете оборудованием, а не арендуете, это прямые затраты. Для аренды dedicated сервера это обычно включено в стоимость.

- Сетевой трафик: Большинство VPS/Dedicated провайдеров включают определенный объем трафика. Однако для очень больших объемов может взиматься дополнительная плата.

- Время простоя (Opportunity Cost): Потенциальные потери из-за сбоев, которые могут быть более частыми при отсутствии опыта или недостаточной автоматизации.

Примеры расчетов для разных сценариев (2026 год)

Представим два сценария: небольшой стартап и средний SaaS-проект.

Сценарий 1: Небольшой стартап (OpenFaaS на одном мощном VPS)

- Нагрузка: До 500k вызовов функций в месяц, с пиками до 100 RPS.

- Инфраструктура: 1 VPS (8 vCPU, 16GB RAM, 200GB NVMe SSD) = $60/месяц.

- Персонал: 0.25 ставки DevOps-инженера (частичная занятость или совмещение) = $1500/месяц (исходя из $100/час * 40 часов/мес * 0.25).

- Инструменты/Лицензии: $0 (полностью Open Source).

- Итого TCO в месяц: $60 (VPS) + $1500 (DevOps) = $1560.

- Сравнение с облаком (AWS Lambda, 2026 год, примерные):

- 500k вызовов, 128MB RAM, 50ms avg duration: около $10-20.

- API Gateway, SQS, DB и другие сервисы: могут легко достичь $200-500+.

- Вывод: На первый взгляд, облако дешевле. Но если проект растет, и вам нужно больше контроля или специфические runtime-ы, то самохостинг быстро становится выгоднее. Экономия начинается, когда облачные счета превышают $1000-1500 в месяц.

Сценарий 2: Средний SaaS-проект (Knative на 3-х Dedicated серверах)

- Нагрузка: До 50M вызовов функций в месяц, с пиками до 5000 RPS.

- Инфраструктура: 3 Dedicated Servers (6 ядер, 64GB RAM, 2x1TB NVMe SSD каждый) = 3 * $250 = $750/месяц.

- Персонал: 1.0 ставки DevOps-инженера = $4000/месяц (исходя из $100/час * 40 часов/нед * 4 нед/мес).

- Инструменты/Лицензии: $100/месяц (например, платная версия CI/CD).

- Итого TCO в месяц: $750 (Dedicated) + $4000 (DevOps) + $100 (Инструменты) = $4850.

- Сравнение с облаком (AWS Lambda, 2026 год, примерные):

- 50M вызовов, 256MB RAM, 100ms avg duration: около $1000-2000.

- API Gateway, SQS, RDS, ElastiCache, S3, Load Balancers, Monitoring: могут легко достичь $10000 - $30000+ в месяц.

- Вывод: Для среднего и крупного SaaS-проекта, где облачные счета могут исчисляться десятками тысяч долларов, self-hosted Knative на dedicated серверах предлагает значительную экономию, полный контроль и отсутствие вендор-лока. Однако, это требует серьезных инвестиций в команду.

Скрытые расходы

- Время на обучение: Время, которое команда тратит на изучение новых технологий.

- Непредвиденные сбои: Потери от простоя сервиса из-за ошибок в конфигурации или отсутствия опыта.

- Упущенная выгода: Вместо разработки новых фич команда занимается поддержкой инфраструктуры.

- Масштабирование команды: По мере роста проекта, может потребоваться больше DevOps-инженеров.

- Обновления и патчи: Регулярное поддержание актуальности ПО и ОС требует времени.

Как оптимизировать затраты

- Автоматизация: Максимально автоматизируйте все процессы (CI/CD, IaC, мониторинг) для снижения затрат на персонал.

- Оптимизация ресурсов: Тонко настраивайте автомасштабирование, используйте Knative с его масштабированием до нуля, чтобы минимизировать потребление ресурсов в простое.

- Эффективный код: Пишите производительные функции, потребляющие меньше CPU и RAM, сокращайте время выполнения.

- Гибридные решения: Рассмотрите гибридный подход, когда часть функций, требующих экстремальной масштабируемости, остается в облаке, а основные — на собственном сервере.

- Долгосрочное планирование: Инвестируйте в более мощное железо с запасом, чтобы избежать частых миграций.

Таблица с примерами расчетов (упрощенная)

| Параметр | Облачный FaaS (AWS Lambda + экосистема) | Self-hosted OpenFaaS (VPS) | Self-hosted Knative (Dedicated) |

|---|---|---|---|

| Месячная стоимость железа/аренды | $0 (за FaaS, но $100-3000 за другие сервисы) | $30 - $80 | $200 - $800 |

| Месячная стоимость FaaS-вызовов | $10 - $2000+ | $0 | $0 |

| Месячная стоимость персонала DevOps | $500 - $2000 (для управления облаком) | $1000 - $2500 | $2500 - $5000+ |

| Лицензии/Инструменты (мес.) | $50 - $200 | $0 - $50 | $0 - $100 |

| Итого TCO (примерный диапазон) | $500 - $5000+ | $1000 - $2600 | $2700 - $6000+ |

| Точка безубыточности (Cloud vs Self-hosted) | N/A | При облачных счетах $1000-1500+ | При облачных счетах $3000-5000+ |

Как видно из таблицы, самохостинг начинает окупаться при достижении определенного масштаба. Для небольших проектов облако часто остается дешевле за счет отсутствия прямой оплаты труда DevOps, но для растущих и крупных проектов собственный FaaS может принести значительную экономию и стратегические преимущества.

Кейсы и примеры использования

Чтобы лучше понять, как OpenFaaS и Knative могут быть применены на практике, рассмотрим несколько реалистичных сценариев, актуальных для 2026 года.

Кейс 1: Сервис обработки изображений для онлайн-магазина (OpenFaaS)

Задача: Онлайн-магазин ежедневно загружает тысячи изображений товаров. Необходимо автоматически изменять их размер, накладывать водяные знаки, оптимизировать и сохранять в нескольких форматах для разных устройств (мобильные, десктопы). Требуется быстрое масштабирование при пиковых загрузках (например, во время распродаж) и минимизация затрат в периоды затишья.

Решение с OpenFaaS:

- Инфраструктура: Один мощный выделенный сервер (Intel Xeon E-23xx, 64GB RAM, 2TB NVMe SSD) с Kubernetes и OpenFaaS. Используется NATS Streaming для асинхронной обработки.

- Функции:

image-upload-handler(Python): Принимает входящие запросы на загрузку изображения, сохраняет оригинал в S3-совместимом хранилище (например, MinIO, развернутом на том же сервере), отправляет сообщение в NATS с URL оригинала.image-processor(Go): Слушает сообщения из NATS, скачивает оригинал, использует библиотеку ImageMagick (через Go-обертку) для изменения размера, наложения водяных знаков и оптимизации. Генерирует 3-5 версий изображения и загружает их обратно в MinIO.metadata-extractor(Node.js): Слушает сообщения из NATS после обработки, извлекает EXIF-данные и другие метаданные, сохраняет их в PostgreSQL.

- Масштабирование: OpenFaaS настроен с KEDA для автомасштабирования

image-processorна основе длины очереди NATS. При большой загрузке (много новых изображений) функция быстро масштабируется до десятков экземпляров. В ночное время, когда загрузок нет, функции масштабируются до нуля, экономя ресурсы. - Результаты:

- Экономия: Значительное сокращение затрат по сравнению с облачными FaaS, особенно за счет отсутствия платы за вызовы и минимального потребления ресурсов в простое.

- Производительность: Обработка изображений занимает в среднем 2-5 секунд на одно изображение, что удовлетворяет требованиям магазина.

- Контроль: Полный контроль над процессом обработки, возможность использовать любые библиотеки для работы с изображениями, гибкая настройка безопасности.

- Надежность: Асинхронная обработка через NATS обеспечивает устойчивость к временным сбоям и гарантирует обработку всех изображений.

Кейс 2: Сервис аналитики в реальном времени для IoT-платформы (Knative)

Задача: Платформа собирает данные с тысяч IoT-устройств (сенсоры, счетчики) в реальном времени. Необходимо выполнять быструю предобработку, агрегацию и аномальную детекцию данных, а также отправлять уведомления при критических событиях. Нагрузка сильно колеблется в течение дня и недели.

Решение с Knative:

- Инфраструктура: Кластер Kubernetes из 3-х выделенных серверов (каждый по 8 ядер, 128GB RAM, 1TB NVMe SSD) с Knative Serving и Knative Eventing, а также Kafka-кластер для потоковой обработки данных.

- Функции/Сервисы Knative:

iot-data-ingestor(Java/Spring Boot): Принимает данные с устройств через HTTP-API, выполняет базовую валидацию и отправляет сырые данные в Kafka-топик. Развернут как Knative Service, масштабируется на основе RPS.data-preprocessor(Go): Слушает Kafka-топик с сырыми данными (через KafkaSource в Knative Eventing), нормализует данные, добавляет временные метки и отправляет в другой Kafka-топик (processed-data). Автоматически масштабируется до нуля при отсутствии данных.anomaly-detector(Python/TensorFlow Lite): Слушает топикprocessed-data, использует легкую модель машинного обучения для обнаружения аномалий. При обнаружении аномалии отправляет событие в Knative Broker.notification-sender(Node.js): Подписывается на события из Knative Broker (например, "anomaly-detected"), отправляет уведомления через Slack/Telegram API.

- Масштабирование: Knative Serving автоматически масштабирует все сервисы от нуля до необходимого количества экземпляров на основе метрик запросов (RPS), CPU или длины очереди Kafka (через KEDA, интегрированный с Knative). Istio используется для управления трафиком и обеспечения отказоустойчивости между сервисами.

- Результаты:

- Реактивность: Обработка данных происходит в реальном времени с минимальными задержками (менее 100 мс от устройства до детекции аномалии).

- Экономия ресурсов: Благодаря масштабированию Knative до нуля, в периоды низкой активности потребление ресурсов значительно сокращается, что критически важно для выделенных серверов.

- Гибкость: Легко добавлять новые типы обработки или источники данных благодаря событийно-ориентированной архитектуре Knative Eventing.

- Надежность: Kubernetes-кластер и Service Mesh обеспечивают высокую доступность и отказоустойчивость всей системы.

Кейс 3: CI/CD Webhook Handler для микросервисов (OpenFaaS или Knative)

Задача: Автоматизировать реагирование на события в системах контроля версий (GitHub, GitLab), таких как пуши, мердж-реквесты, успешные сборки. Требуется запускать специфические действия: уведомления, развертывание тестовых сред, запуск дополнительных проверок.

Решение с OpenFaaS:

- Инфраструктура: Небольшой VPS (4 vCPU, 8GB RAM) с k3s и OpenFaaS.

- Функции:

github-webhook-parser(Python): Принимает HTTP POST-запросы от GitHub Webhook, парсит JSON-payload, извлекает тип события (push, pull_request) и репозиторий. Отправляет структурированное событие во внутренний брокер NATS.slack-notifier(Node.js): Слушает NATS на предмет событий, формирует сообщение и отправляет его в Slack-канал.test-env-deployer(Go): При событииpull_request_openedиз NATS, используетkubectlили Helm-команды для развертывания новой тестовой среды для Pull Request'а.

- Масштабирование: OpenFaaS масштабирует функции по HTTP-запросам или длине очереди NATS.

Решение с Knative:

- Инфраструктура: VPS (4 vCPU, 8GB RAM) с k3s и Knative Serving/Eventing.

- Сервисы Knative:

github-webhook-receiver(Python): Knative Service, принимающий webhook-и от GitHub. Преобразует их в CloudEvents и отправляет в Knative Broker.slack-notifier(Node.js): Knative Service, подписанный наgithub.event.pushиgithub.event.pull_requestсобытия из Broker, отправляет уведомления.tekton-pipeline-trigger(Go): Knative Service, подписанный наgithub.event.pull_request_opened, запускает Tekton Pipeline для развертывания тестовой среды.

- Масштабирование: Knative автоматически масштабирует сервисы до нуля, когда нет входящих webhook-ов.

Оба решения эффективно справляются с задачей, демонстрируя гибкость FaaS для автоматизации CI/CD процессов. Выбор зависит от предпочтений команды к OpenFaaS-стилю или глубокой интеграции с Kubernetes, которую предлагает Knative.

Инструменты и ресурсы

Успешное развертывание и эксплуатация самохостинговых FaaS-платформ невозможно без правильного набора инструментов и актуальных ресурсов. В 2026 году экосистема Open Source развивается невероятными темпами, предоставляя мощные и гибкие решения.

1. Утилиты для работы с FaaS-платформами

faas-cli(для OpenFaaS): Официальный CLI для OpenFaaS. Позволяет создавать, развертывать, вызывать и удалять функции. Незаменимый инструмент для разработчика и DevOps.kubectl(для Knative и Kubernetes): Основной инструмент командной строки для взаимодействия с Kubernetes-кластером. Все операции с Knative Service и Eventing выполняются черезkubectl.knCLI (для Knative): Удобная CLI-утилита для Knative, упрощающая работу с Knative Serving и Eventing. Позволяет создавать сервисы, получать их статус, управлять событиями.

2. Мониторинг и тестирование

- Prometheus: Система мониторинга и оповещений с открытым исходным кодом. Стандарт де-факто для Kubernetes-экосистемы. OpenFaaS и Knative предоставляют метрики, которые Prometheus может собирать.

- Grafana: Платформа для аналитики и интерактивных дашбордов. Идеально подходит для визуализации метрик из Prometheus и логов из Loki.

- Loki: Горизонтально масштабируемая, высокодоступная, мультитенентная система агрегации логов, разработанная Grafana Labs. Работает по принципу "только индексирование метаданных", что делает ее очень эффективной.

- K6 / JMeter / Locust: Инструменты для нагрузочного тестирования. Позволяют имитировать реальную нагрузку на FaaS-функции и проверять их масштабируемость и производительность.

3. Системы управления версиями и CI/CD

- Git (GitHub, GitLab, Bitbucket): Основа любого современного процесса разработки.

- GitHub Actions / GitLab CI / Jenkins / Tekton: Инструменты для автоматизации CI/CD пайплайнов. Tekton особенно хорошо интегрируется с Kubernetes и Knative.

- Argo CD: Инструмент для декларативного GitOps-развертывания в Kubernetes. Позволяет синхронизировать состояние кластера с Git-репозиторием.

4. Инструменты для управления конфигурацией и IaC (Infrastructure as Code)

- Terraform: Позволяет декларативно описывать и управлять инфраструктурой (VPS, DNS, балансировщики нагрузки) как кодом.

- Ansible / Chef / Puppet: Инструменты для автоматизации конфигурации серверов, установки ПО, настройки безопасности.

- Helm: Менеджер пакетов для Kubernetes. Упрощает развертывание сложных приложений, таких как Prometheus, Grafana, Istio, Knative.

5. Полезные ссылки и документация

- Официальная документация OpenFaaS

- Официальная документация Knative

- Официальная документация Kubernetes

- KEDA (Kubernetes Event-driven Autoscaling)

- Istio Service Mesh

- MinIO (S3-совместимое объектное хранилище для self-hosted)

- Cloud Native Computing Foundation (CNCF) - организация, поддерживающая многие из этих проектов.

Регулярно следите за обновлениями в этих проектах, так как экосистема развивается очень быстро. Подпишитесь на рассылки, следите за блогами и участвуйте в сообществах, чтобы быть в курсе последних тенденций и лучших практик.

Troubleshooting: Решение проблем

Развертывание и эксплуатация FaaS на собственном сервере — это сложный процесс, и проблемы неизбежны. Умение быстро диагностировать и устранять неисправности является ключевым навыком. Ниже приведены типичные проблемы и подходы к их решению, актуальные для 2026 года.

1. Функции не запускаются / Ошибка при развертывании

- Проблема: Функция зависает в состоянии Pending, CrashLoopBackOff или ImagePullBackOff.

- Диагностика:

kubectl describe pod <function-pod-name> -n <namespace> kubectl logs <function-pod-name> -n <namespace> - Решения:

- ImagePullBackOff: Проверьте имя образа Docker, доступность реестра (Docker Hub, private registry) и правильность учетных данных. Убедитесь, что сервер имеет доступ к Интернету.

- CrashLoopBackOff: Функция запускается и сразу падает. Проверьте логи функции (

kubectl logs) на наличие ошибок в коде, проблем с зависимостями или неправильной конфигурации среды. Убедитесь, что ваша функция правильно обрабатывает HTTP-запросы и возвращает ответ. - Pending: Недостаточно ресурсов в кластере (CPU, RAM). Проверьте

kubectl describe podна наличие сообщений о недостатке ресурсов. Увеличьте ресурсы VPS или кластера, оптимизируйте запросы ресурсов (requestsиlimits) в YAML-файле функции. - Неправильный порт: Убедитесь, что функция слушает порт, который ожидает FaaS-платформа (обычно 8080 или 8000).

2. Высокая задержка / Медленная работа функций

- Проблема: Функции отвечают медленно, наблюдаются высокие задержки холодного старта.

- Диагностика:

- Проверьте метрики Prometheus/Grafana: время выполнения функций, количество холодных стартов, утилизацию CPU/RAM подов.

- Используйте

curl -vили специализированные инструменты для измерения времени ответа.

- Решения:

- Холодный старт:

- OpenFaaS: Убедитесь, что KEDA настроен и работает правильно. Настройте

min_replicasдля критически важных функций, чтобы они всегда имели хотя бы один активный экземпляр. Используйте "прогрев" функций. - Knative: Проверьте конфигурацию Knative Serving и Istio/Kourier. Убедитесь, что автомасштабирование настроено адекватно. Возможно, необходимо увеличить

min-scaleдля критических сервисов.

- OpenFaaS: Убедитесь, что KEDA настроен и работает правильно. Настройте

- Производительность кода: Оптимизируйте код функции, используйте более эффективные алгоритмы, минимизируйте внешние вызовы.

- Ресурсы: Увеличьте выделенные ресурсы (CPU, RAM) для подов функций. Проверьте производительность дисковой подсистемы VPS/Dedicated.

- Сетевые задержки: Проверьте сетевую связность между компонентами (функция-БД, функция-брокер).

- Холодный старт:

3. Проблемы с масштабированием

- Проблема: Функции не масштабируются при росте нагрузки или масштабируются слишком медленно.

- Диагностика:

- Проверьте статус HPA/KEDA (

kubectl get hpa -n <namespace>) или Knative Service (kubectl get ksvc -n <namespace>). - Посмотрите логи контроллеров автомасштабирования.

- Проверьте метрики, на основе которых принимается решение о масштабировании (CPU, RPS, длина очереди).

- Проверьте статус HPA/KEDA (

- Решения:

- Недостаточно ресурсов кластера: Добавьте больше узлов в Kubernetes-кластер или увеличьте ресурсы существующих VPS.

- Неправильные метрики: Убедитесь, что метрики, используемые для автомасштабирования, корректно собираются и отражают реальную нагрузку.

- Политики масштабирования: Настройте параметры

min_replicas,max_replicas,target_average_utilization(для HPA) или Knative-специфичные параметры масштабирования. - Проблемы с KEDA/Knative контроллерами: Проверьте логи подов KEDA/Knative Serving на наличие ошибок.

4. Проблемы с доступом к функциям / Сетевые проблемы

- Проблема: Функции недоступны извне, или наблюдаются ошибки 502/503.

- Диагностика:

- Проверьте статус Ingress-контроллера (Nginx, Traefik, Kourier, Istio Gateway).

- Проверьте логи Ingress-контроллера.

- Используйте

kubectl get svc -n <namespace>иkubectl get ep -n <namespace>для проверки сервисов и их конечных точек. - Проверьте настройки DNS и файрвола на VPS.

- Решения:

- Ingress-контроллер: Убедитесь, что Ingress-контроллер запущен, его поды здоровы и правильно настроены для маршрутизации трафика к FaaS-шлюзу/сервисам.

- DNS: Проверьте, что DNS-записи домена указывают на IP-адрес вашего Ingress-контроллера.

- Файрвол: Убедитесь, что порты 80/443 открыты на файрволе VPS и в Kubernetes Network Policies.

- SSL/TLS: Проверьте, что SSL/TLS-сертификаты действительны и правильно настроены.

5. Проблемы с логированием и мониторингом

- Проблема: Метрики не отображаются в Grafana, логи не попадают в Loki.

- Диагностика:

- Проверьте статус подов Prometheus, Grafana, Loki, Promtail/Fluentd.

- Посмотрите логи этих подов.

- Проверьте конфигурацию Prometheus (

scrape_configs) и Promtail/Fluentd (targets).

- Решения:

- Доступность: Убедитесь, что все компоненты мониторинга и логирования запущены и доступны друг другу.

- Конфигурация: Проверьте правильность конфигурации агентов сбора (Promtail, Fluentd) и серверов (Prometheus, Loki). Убедитесь, что они "видят" метрики и логи ваших FaaS-подов.

- Права доступа: Убедитесь, что у агентов сбора есть необходимые RBAC-права в Kubernetes для чтения логов и метрик.

Когда обращаться в поддержку (или искать помощь в сообществе)

- Когда вы исчерпали все известные вам методы диагностики и решения проблемы.

- Когда проблема связана с глубокими внутренностями Kubernetes, OpenFaaS или Knative, которые вы не понимаете.

- Если вы столкнулись с проблемой, которая кажется багом в самой платформе.

- Когда простой сервиса критичен, и у вас нет времени на глубокое расследование.

Для OpenFaaS и Knative есть активные сообщества в Slack, GitHub Issues и Stack Overflow. Предоставляйте максимально подробную информацию: версии компонентов, логи, конфигурационные файлы, шаги воспроизведения.

Часто задаваемые вопросы (FAQ)

Что такое FaaS и почему его развертывают на своем сервере?

FaaS (Functions as a Service) — это модель облачных вычислений, позволяющая разработчикам запускать код в ответ на события без необходимости управлять базовой инфраструктурой. Развертывание FaaS на своем сервере (self-hosted) позволяет получить полный контроль над данными и инфраструктурой, избежать привязки к конкретному облачному провайдеру (вендор-лок), а также значительно сократить операционные расходы в долгосрочной перспективе, особенно для проектов с большой или предсказуемой нагрузкой, где облачные счета становятся слишком высокими.

Обязательно ли использовать Kubernetes для OpenFaaS или Knative?

Для Knative — да, Kubernetes является обязательной базовой платформой, так как Knative построен как набор расширений для Kubernetes. Для OpenFaaS — нет, хотя Kubernetes является предпочтительным вариантом, OpenFaaS также поддерживает развертывание на Docker Swarm, что может быть проще для небольших проектов или команд без глубокого опыта работы с Kubernetes.

Насколько сложно поддерживать self-hosted FaaS в 2026 году?

Сложность поддержки self-hosted FaaS в 2026 году значительно снизилась благодаря развитию инструментов автоматизации (IaC, CI/CD), улучшению документации и росту сообществ. Однако, это все еще требует наличия квалифицированных DevOps-инженеров или системных администраторов, которые понимают принципы работы Kubernetes (если используется), Docker, сетевых технологий, мониторинга и безопасности. Это не "поставил и забыл", но вполне управляемо при наличии нужной экспертизы.

Можно ли масштабировать FaaS на своем сервере до нуля, как в облаке?

Да, обе платформы — OpenFaaS и Knative — поддерживают масштабирование функций до нуля. Knative имеет эту возможность "из коробки" как часть своей архитектуры Serving, активно используя Service Mesh для управления трафиком и деактивации подов. OpenFaaS может достичь масштабирования до нуля с помощью интеграции с KEDA (Kubernetes Event-Driven Autoscaling), который позволяет масштабировать поды на основе различных метрик, включая отсутствие трафика или длину очереди сообщений.

Какие языки программирования поддерживаются?

Как OpenFaaS, так и Knative поддерживают практически любые языки программирования, которые можно упаковать в Docker-контейнер. Это включает Python, Node.js, Go, Java, PHP, Ruby, .NET Core и другие. OpenFaaS предоставляет готовые шаблоны для многих популярных языков, что ускоряет старт. Knative, будучи более низкоуровневым, просто запускает любой контейнер, который соответствует его контракту.

Как обеспечить высокую доступность (HA) для self-hosted FaaS?

Для обеспечения высокой доступности необходимо развертывать FaaS на кластере из нескольких VPS или выделенных серверов, а не на одном. Kubernetes по своей природе является распределенной системой, обеспечивающей HA. Для OpenFaaS и Knative это означает запуск их компонентов и функций на нескольких узлах Kubernetes, использование балансировщиков нагрузки, репликацию данных и настройку автоматического восстановления после сбоев. Также критически важно иметь стратегию резервного копирования и восстановления данных.

Каковы основные риски при использовании self-hosted FaaS?

Основные риски включают: высокую начальную сложность развертывания и настройки (особенно Knative), необходимость в квалифицированном персонале для поддержки, потенциальные проблемы с безопасностью, если инфраструктура настроена неправильно, и отсутствие готовой экосистемы облачных сервисов (например, управляемых баз данных, которые придется развертывать самим). Также есть риск недооценки операционных издержек и времени на обслуживание.

Могу ли я использовать self-hosted FaaS для критически важных приложений?

Да, многие компании успешно используют self-hosted FaaS для критически важных приложений, но это требует серьезных инвестиций в надежность, безопасность и автоматизацию. Необходимо обеспечить высокую доступность, резервное копирование, продуманные стратегии развертывания (канареечные деплои, A/B-тестирование) и круглосуточный мониторинг. При правильном подходе self-hosted FaaS может быть даже более надежным, чем публичные облака, за счет полного контроля над стеком.

Как управлять зависимостями и библиотеками в функциях?

Зависимости и библиотеки управляются внутри Docker-образа вашей функции. Вы включаете их в Dockerfile или используете файлы requirements.txt (Python), package.json (Node.js) и т.д., которые обрабатываются на этапе сборки образа. OpenFaaS предоставляет шаблоны, которые уже содержат логику для установки зависимостей. Для Knative вы просто собираете свой Docker-образ со всеми необходимыми зависимостями.

Какова роль Ingress-контроллера (Istio, Kourier) в Knative?

Ingress-контроллер (например, Istio Gateway или Kourier) играет ключевую роль в Knative Serving. Он отвечает за маршрутизацию внешнего HTTP-трафика к вашим Knative-сервисам. Knative использует Service Mesh для реализации своих продвинутых функций управления трафиком, таких как канареечные деплои, A/B-тестирование и масштабирование до нуля. Kourier является легковесным Ingress-контроллером, разработанным специально для Knative, тогда как Istio — это более полный Service Mesh.

Заключение и следующие шаги

Развертывание бессерверных функций на своем VPS или выделенном сервере с использованием OpenFaaS или Knative — это не просто технический тренд 2026 года, но и стратегическое решение, которое может принести значительные экономические выгоды, повысить контроль над инфраструктурой и данными, а также обеспечить независимость от облачных провайдеров. Мы рассмотрели основные критерии выбора, детально изучили обе платформы, предоставили практические советы и разобрали типичные ошибки, а также оценили экономику владения.

OpenFaaS предлагает более низкий порог входа и гибкость с поддержкой Docker Swarm, что делает его отличным выбором для стартапов, небольших команд и тех, кто ценит простоту. Knative, с его глубокой интеграцией с Kubernetes и мощными возможностями масштабирования до нуля, управления трафиком и событийно-ориентированной архитектурой, является идеальным решением для более крупных, высоконагруженных и сложных SaaS-проектов, где уже есть экспертиза в Kubernetes.

В конечном итоге, выбор между OpenFaaS и Knative, а также решение о переходе на self-hosted FaaS, должны основываться на тщательном анализе ваших потребностей, ресурсов команды, ожидаемой нагрузки и долгосрочных стратегических целей. Важно помнить, что успех такого перехода напрямую зависит от инвестиций в автоматизацию, мониторинг, безопасность и обучение персонала.

Следующие шаги для читателя:

- Оцените свои потребности: Проанализируйте текущую нагрузку, бюджет, размер команды и уровень экспертизы. Определите, какие функции вы хотите перевести на FaaS и какие требования к ним предъявляются.

- Выберите платформу: На основе критериев, изложенных в статье, сделайте предварительный выбор между OpenFaaS и Knative.

- Начните с POC: Разверните минимальный кластер (например, k3s на одном VPS) и установите выбранную FaaS-платформу. Попробуйте развернуть простую функцию "Hello World" и протестируйте ее.

- Изучите документацию: Глубоко погрузитесь в официальную документацию выбранной платформы, а также Kubernetes, Prometheus, Grafana и других сопутствующих инструментов.

- Постройте CI/CD: Не откладывайте автоматизацию. Создайте простой CI/CD пайплайн для вашей первой функции.

- Мониторинг и логирование: Настройте базовый стек мониторинга и логирования, чтобы иметь представление о работе вашей системы.

- Нагрузочное тестирование: Проведите нагрузочное тестирование, чтобы понять ограничения вашей инфраструктуры и FaaS-платформы.

- Присоединитесь к сообществу: Активное участие в сообществах OpenFaaS, Knative и Kubernetes поможет вам быстрее решать проблемы и быть в курсе последних разработок.

Самохостинг FaaS — это не просто экономия, это путь к большей независимости, гибкости и контролю над вашей технологической экосистемой. Удачи в вашем путешествии в мир бессерверных вычислений на собственных серверах!