Оптимизация Nginx для высоконагруженных веб-приложений на VPS: кэширование, безопасность, производительность

TL;DR

- Используйте Nginx как обратный прокси для кэширования статического контента (Proxy Cache) и динамического (FastCGI/Microcaching), чтобы значительно снизить нагрузку на бэкенд и ускорить отклик.

- Внедрите TLS 1.3 с современными шифрами, HSTS и OCSP Stapling для максимальной безопасности и производительности шифрования.

- Настройте rate limiting и защиту от DDoS на уровне Nginx, используя модули

limit_reqиlimit_connдля предотвращения перегрузки сервера. - Оптимизируйте параметры Nginx (

worker_processes,worker_connections, буферы) и операционной системы (TCP-стек, лимиты файловых дескрипторов) для эффективного использования ресурсов VPS. - Переход на HTTP/2 (и в перспективе HTTP/3) критичен для современных веб-приложений, обеспечивая мультиплексирование и снижение задержек.

- Регулярно мониторьте Nginx (NGINX Amplify, Prometheus/Grafana) и логируйте только необходимое, чтобы оперативно выявлять и устранять узкие места.

- Инвестиции в глубокую оптимизацию Nginx на VPS окупаются снижением затрат на инфраструктуру и улучшением пользовательского опыта.

Введение

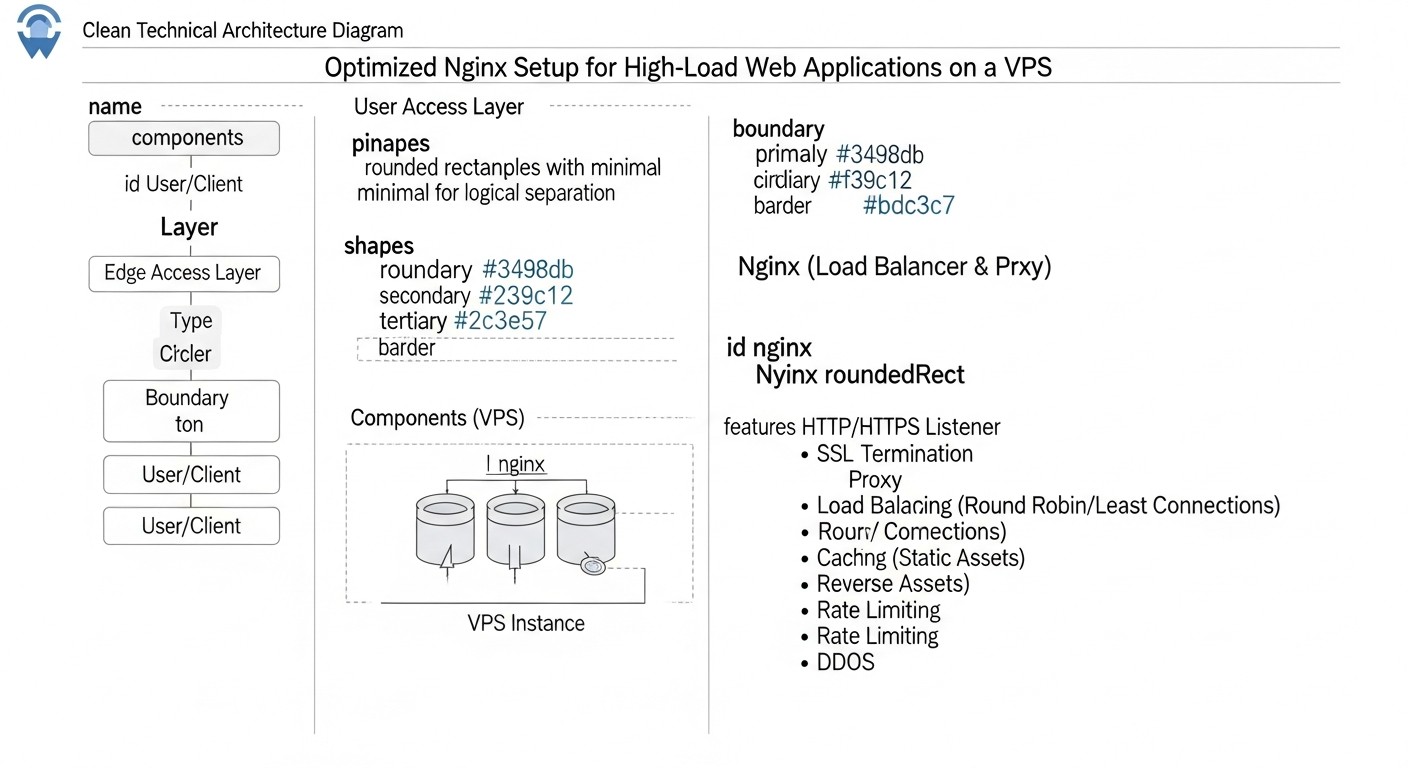

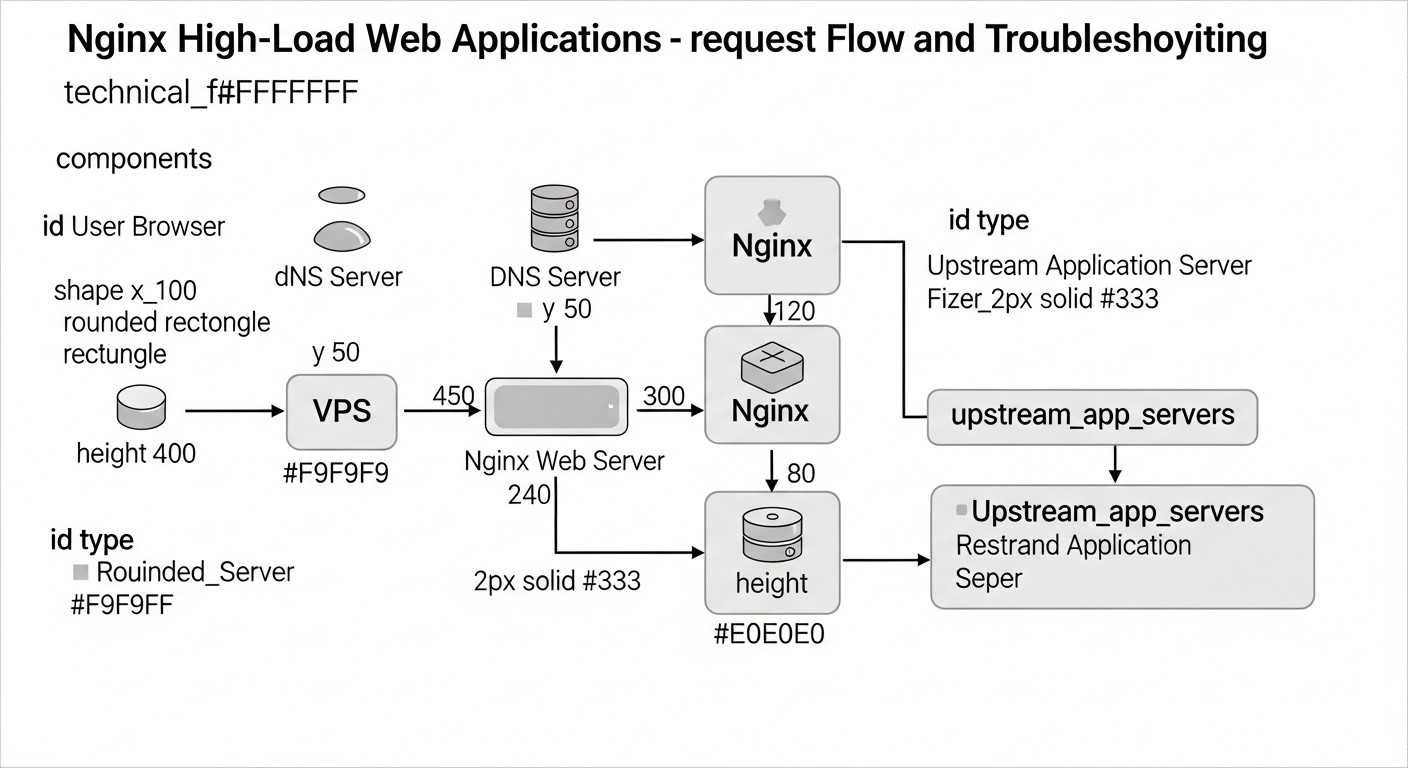

В стремительно развивающемся мире веб-технологий 2026 года, где пользовательские ожидания к скорости и надежности постоянно растут, а конкуренция за внимание пользователя обостряется, производительность веб-приложений становится не просто преимуществом, а критически важным требованием. Особенно это актуально для проектов, развернутых на виртуальных приватных серверах (VPS), где каждый мегабайт ОЗУ и каждый цикл процессора на счету. Nginx, благодаря своей легковесности, высокой производительности и гибкости, давно зарекомендовал себя как де-факто стандарт для обслуживания веб-трафика, будь то статический контент, обратный прокси или балансировщик нагрузки.

Однако просто установить Nginx недостаточно. Для высоконагруженных веб-приложений на VPS необходима глубокая и продуманная оптимизация. Без неё даже мощный VPS может захлебнуться под наплывом трафика, а ресурсы будут расходоваться неэффективно, что напрямую скажется на затратах и пользовательском опыте. В условиях ограниченных ресурсов VPS, каждый процент прироста производительности и каждый байт экономии трафика имеют значение. Неоптимизированный Nginx может стать узким местом, блокирующим масштабирование приложения, даже если бэкенд способен обрабатывать тысячи запросов в секунду.

Эта статья призвана стать исчерпывающим руководством по оптимизации Nginx, охватывая три ключевых аспекта: кэширование, безопасность и производительность. Мы рассмотрим, как правильно настроить Nginx, чтобы он максимально эффективно использовал доступные ресурсы VPS, защищал ваше приложение от угроз и обеспечивал молниеносную скорость отклика. Материал ориентирован на DevOps-инженеров, backend-разработчиков (Python, Node.js, Go, PHP), фаундеров SaaS-проектов, системных администраторов и технических директоров стартапов, которые стремятся выжать максимум из своей инфраструктуры и построить надежные, масштабируемые веб-сервисы. Мы погрузимся в конкретные конфигурации, практические советы и реальные кейсы, актуальные для 2026 года, чтобы вы могли применить полученные знания незамедлительно.

Основные критерии и факторы оптимизации Nginx

Прежде чем погружаться в детали настроек, важно понять, какие метрики и факторы определяют эффективность работы Nginx и веб-приложения в целом. Оптимизация — это не просто набор разрозненных настроек, а системный подход, направленный на улучшение конкретных показателей.

Скорость отклика (Latency)

Скорость отклика, или задержка, — это время, которое проходит с момента отправки запроса пользователем до получения первого байта ответа. Для современных веб-приложений этот показатель критичен. Пользователи ожидают мгновенной загрузки, и даже небольшие задержки могут привести к отказу от использования сервиса. На VPS, где сетевые задержки и ограничения ресурсов могут быть более выражены, минимизация latency становится приоритетом. Nginx влияет на latency через эффективное кэширование, быстрое установление соединений (Keepalive), использование HTTP/2 (и HTTP/3) и оптимизированную обработку запросов. Оценивается с помощью таких инструментов, как WebPageTest, Lighthouse или сторонних сервисов мониторинга.

Пропускная способность (Throughput)

Пропускная способность характеризует объем данных или количество запросов, которые сервер может обработать за единицу времени. Для высоконагруженных систем это один из ключевых показателей. Nginx, будучи высокопроизводительным обратным прокси, способен обрабатывать огромное количество одновременных соединений и запросов. Оптимизация Nginx направлена на увеличение throughput путем эффективного использования CPU и памяти, минимизации блокировок, сжатия данных (gzip/Brotli) и грамотного распределения нагрузки. На VPS с ограниченными сетевыми каналами и процессорными ресурсами, максимизация throughput без перегрузки системы требует тонкой настройки. Мониторинг RPS (Requests Per Second) и Mbps (Megabits per Second) через инструменты вроде Prometheus/Grafana или NGINX Amplify поможет оценить этот критерий.

Использование ресурсов (Resource Utilization)

На VPS, где ресурсы (CPU, RAM, дисковый ввод/вывод) являются ограниченным и часто оплачиваемым по объему благом, их эффективное использование — залог экономической целесообразности и стабильности. Оптимизация Nginx позволяет сократить потребление CPU и RAM, особенно за счет эффективного кэширования, которое снижает нагрузку на бэкенд. Меньшее потребление ресурсов означает возможность обслуживать больше пользователей на том же VPS, отсрочить необходимость апгрейда тарифа или даже перейти на более дешевый. Мониторинг утилизации CPU, RAM, I/O и сетевого трафика через htop, top, iostat, netdata или облачные метрики провайдера VPS является основой для оценки этого фактора.

Устойчивость к нагрузкам и безопасность (Resilience & Security Posture)

Высоконагруженное приложение должно не только быстро работать, но и быть устойчивым к пиковым нагрузкам, сбоям и атакам. Nginx играет ключевую роль в обеспечении безопасности и отказоустойчивости. Механизмы rate limiting, защита от DDoS, строгие настройки SSL/TLS, интеграция с WAF (Web Application Firewall) — всё это позволяет Nginx выступать первым эшелоном обороны. На VPS, где нет возможности развернуть сложные аппаратные решения, Nginx становится критически важным инструментом для защиты. Оценивается путем проведения нагрузочного тестирования (k6, JMeter, Gatling), аудита безопасности (SSL Labs, Nessus) и анализа логов на предмет аномалий и попыток атак.

Сравнительная таблица: Стратегии кэширования в Nginx

Кэширование — это, пожалуй, самый мощный инструмент для оптимизации производительности веб-приложений, особенно на VPS. Правильно настроенное кэширование позволяет Nginx отвечать на запросы, не обращаясь к бэкенду, что значительно снижает нагрузку на приложение и базу данных, а также сокращает время отклика. В 2026 году доступны различные стратегии кэширования, каждая из которых имеет свои особенности.

| Критерий | Кэширование статики (Browser/Nginx) | Nginx Proxy Cache | Nginx FastCGI Cache | Microcaching (Nginx) | Edge Caching (CDN, для сравнения) |

|---|---|---|---|---|---|

| Тип контента | Статика (CSS, JS, изображения, шрифты) | Любой HTTP-контент (HTML, JSON, API ответы) | Динамический контент PHP/Python/Ruby/Go | Динамический контент с коротким сроком жизни | Статика и динамика (глобально) |

| Сложность настройки | Низкая (expires, add_header Cache-Control) |

Средняя (proxy_cache_path, proxy_cache_key) |

Средняя (fastcgi_cache_path, fastcgi_cache_key) |

Средняя (proxy_cache_valid 1s, proxy_cache_bypass) |

Средняя/Высокая (зависит от CDN) |

| Эффективность снижения нагрузки на бэкенд | Высокая (для статики) | Очень высокая (для повторяющихся запросов) | Очень высокая (для повторяющихся запросов) | Высокая (снимает пики) | Экстремально высокая (глобально) |

| Влияние на Latency | Значительное (для повторных визитов) | Значительное (для кэшированных ответов) | Значительное (для кэшированных ответов) | Умеренное (сокращает время генерации) | Максимальное (близость к пользователю) |

| Требования к дисковому пространству на VPS | Минимальные (для Nginx) | Средние/Высокие (зависит от объема кэша) | Средние/Высокие (зависит от объема кэша) | Низкие/Средние (короткий срок жизни) | Не применимо к VPS |

| Актуальность данных | Высокая (версионирование файлов) | Зависит от proxy_cache_valid и proxy_cache_bypass |

Зависит от fastcgi_cache_valid и fastcgi_cache_bypass |

Высокая (обновляется каждую секунду) | Зависит от настроек CDN и Cache-Control |

| Примерная стоимость (2026, на VPS) | Бесплатно (включено в Nginx) | Бесплатно (включено в Nginx), требует диска | Бесплатно (включено в Nginx), требует диска | Бесплатно (включено в Nginx), требует диска | От $5 до $500+/месяц (зависит от трафика и функций) |

| Когда использовать | Всегда для статики | Для API, страниц, часто запрашиваемых данных | Для PHP-приложений (WordPress, Laravel) | Для динамических страниц с частым обновлением | Для глобального охвата и больших объемов трафика |

Как видно из таблицы, выбор стратегии кэширования зависит от типа контента, требований к актуальности данных и доступных ресурсов. В большинстве случаев для VPS оптимально комбинировать несколько подходов: кэшировать статику на уровне Nginx и браузера, использовать Proxy Cache для API и страниц, а FastCGI Cache для PHP-приложений, дополняя это микрокэшированием для снижения пиковых нагрузок.

Детальный обзор каждого пункта/варианта оптимизации

Давайте подробно рассмотрим ключевые аспекты оптимизации Nginx, которые помогут выжать максимум из вашего VPS.

Кэширование: Основа производительности

Кэширование — это наиболее эффективный способ снижения нагрузки на бэкенд и ускорения отклика. Nginx предлагает мощные механизмы для этого.

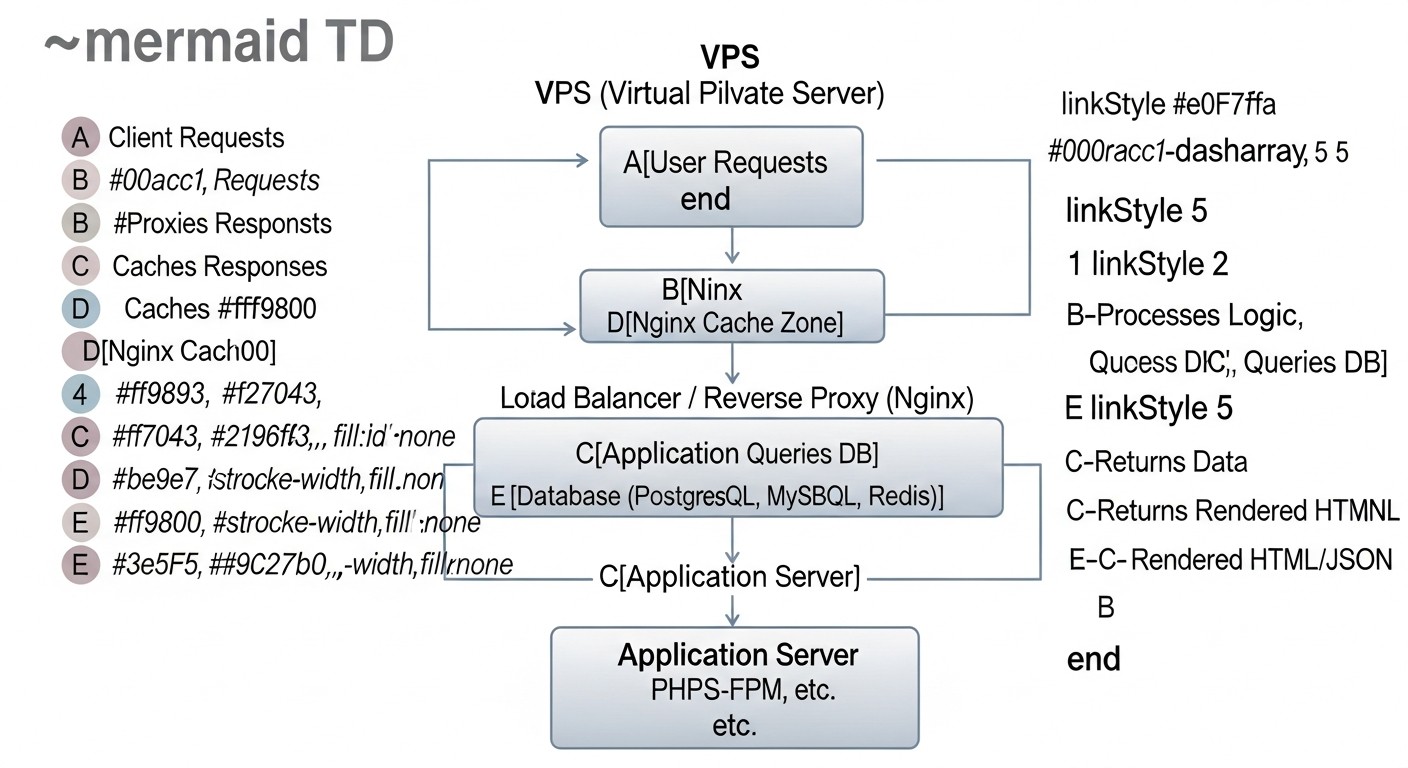

Nginx Proxy Cache

Nginx Proxy Cache позволяет кэшировать ответы от вышестоящих серверов (бэкенда). Это идеальное решение для кэширования HTML-страниц, JSON-ответов API, изображений, CSS и JS, которые генерируются динамически, но меняются нечасто. При первом запросе Nginx передает его бэкенду, сохраняет ответ на диск (или в память) и отдает пользователю. Последующие запросы за тем же ресурсом будут обслуживаться напрямую из кэша, что значительно быстрее. Это существенно снижает нагрузку на CPU и RAM бэкенда, а также на базу данных. На VPS с ограниченными ресурсами это позволяет обрабатывать в разы больше запросов. Ключевые директивы включают proxy_cache_path для определения пути к кэшу и его параметров, proxy_cache для активации кэширования в конкреном location, proxy_cache_key для определения уникального ключа кэша (обычно $scheme$proxy_host$request_uri), и proxy_cache_valid для установки срока жизни кэшированных ответов в зависимости от HTTP-статуса. Важно также настроить proxy_cache_bypass и proxy_no_cache для определенных условий (например, для авторизованных пользователей или POST-запросов), чтобы предотвратить кэширование персонализированного контента. Использование proxy_cache_revalidate позволяет Nginx проверять актуальность кэша с помощью заголовков If-Modified-Since или If-None-Match, минимизируя трафик к бэкенду.

Nginx FastCGI Cache

FastCGI Cache аналогичен Proxy Cache, но предназначен специально для кэширования ответов от FastCGI-серверов, таких как PHP-FPM, Python Gunicorn/uWSGI или Go-приложений. Этот тип кэширования незаменим для высоконагруженных PHP-приложений (WordPress, Laravel, Symfony), где каждая страница может генерироваться с обращением к базе данных. Nginx кэширует полностью сгенерированный HTML или JSON ответ от FastCGI-бэкенда, и при повторных запросах отдает его напрямую, полностью обходя PHP-интерпретатор и базу данных. Это обеспечивает колоссальный прирост производительности и значительно снижает потребление ресурсов. Директивы схожи с Proxy Cache: fastcgi_cache_path, fastcgi_cache, fastcgi_cache_key, fastcgi_cache_valid. Также важны fastcgi_cache_bypass и fastcgi_no_cache для исключения из кэша определенных запросов (например, для админ-панели или страниц корзины). Правильная настройка заголовков Cache-Control на бэкенде также критична для эффективного взаимодействия с FastCGI Cache.

Microcaching

Микрокэширование — это разновидность Proxy/FastCGI кэширования с очень коротким сроком жизни кэша, обычно от 1 до 10 секунд. Оно идеально подходит для динамических страниц, которые часто обновляются, но не настолько часто, чтобы каждый запрос приходилось обрабатывать бэкендом. Например, для новостных сайтов, блогов или ecommerce-платформ, где контент меняется раз в несколько секунд или минут. Микрокэширование позволяет «сгладить» пиковые нагрузки, когда на сервер одновременно приходит множество запросов за одной и той же страницей. Вместо того чтобы перегружать бэкенд, Nginx будет отдавать одну и ту же кэшированную версию на протяжении короткого интервала, значительно сокращая количество обращений к приложению. Это обеспечивает практически мгновенный отклик для большинства пользователей, при этом сохраняя высокую степень актуальности контента. Настраивается с помощью proxy_cache_valid 1s или fastcgi_cache_valid 1s, дополненных правилами proxy_cache_bypass для случаев, когда требуется гарантированно свежий контент.

Кэширование статики и заголовки Expires/Cache-Control

Это базовый, но крайне важный вид кэширования. Статические файлы (изображения, CSS, JavaScript, шрифты, видео) должны быть кэшированы на максимально возможный срок как на уровне Nginx, так и в браузере пользователя. Nginx может отдавать эти файлы напрямую, не обращаясь к бэкенду. Директива expires в Nginx устанавливает заголовок Cache-Control и Expires, указывая браузеру, как долго можно хранить ресурс в локальном кэше. Например, expires 365d для изображений или expires 7d для CSS/JS. Для обеспечения актуальности при изменении файлов рекомендуется использовать версионирование (например, style.css?v=1.2.3 или style.12345.css). Это позволяет браузеру использовать кэшированную версию до тех пор, пока URL не изменится. Правильная настройка кэширования статики снижает трафик, ускоряет загрузку страниц для повторных посетителей и освобождает ресурсы Nginx для обработки более сложных динамических запросов.

Безопасность: Защита вашего приложения

В 2026 году, когда кибератаки становятся всё более изощренными, безопасность веб-приложений на VPS не может быть второстепенным вопросом. Nginx является первой линией обороны.

SSL/TLS Best Practices (TLS 1.3, HSTS, OCSP Stapling)

Использование HTTPS уже давно стало стандартом. Но важно не просто включить HTTPS, а настроить его правильно. В 2026 году обязательным является использование TLS 1.3 — это самая быстрая и безопасная версия протокола, которая сокращает количество рукопожатий и использует современные криптографические алгоритмы. Nginx должен быть скомпилирован с поддержкой OpenSSL 1.1.1 или новее. Важно выбрать сильные шифры, исключив устаревшие и уязвимые (например, RC4, 3DES, CBC-режимы). Директива ssl_protocols TLSv1.2 TLSv1.3; и ssl_ciphers позволяют это сделать. HTTP Strict Transport Security (HSTS) заголовок (add_header Strict-Transport-Security "max-age=31536000; includeSubDomains; preload" always;) принуждает браузеры всегда использовать HTTPS для вашего домена, предотвращая атаки типа SSL stripping. OCSP Stapling (ssl_stapling on; ssl_stapling_verify on;) ускоряет проверку статуса SSL-сертификата и повышает конфиденциальность, поскольку браузеру не нужно обращаться к OCSP-серверу эмитента. Правильная настройка SSL/TLS не только защищает данные пользователей, но и улучшает SEO-показатели, а также повышает доверие к вашему сервису.

Rate Limiting и защита от DDoS

Модули limit_req и limit_conn Nginx — это мощные инструменты для защиты от брутфорс-атак, сканирования уязвимостей и некоторых видов DDoS-атак, а также для предотвращения перегрузки бэкенда. limit_req ограничивает частоту запросов с одного IP-адреса, а limit_conn ограничивает количество одновременных соединений. Например, можно разрешить не более 5 запросов в секунду с burst до 10 для API-эндпоинта и не более 20 одновременных соединений на пользователя. Это предотвращает ситуации, когда один или несколько злоумышленников могут исчерпать ресурсы вашего VPS, отправляя огромное количество запросов. На VPS, где ресурсы ограничены, это критически важно. Настройка должна быть тонкой, чтобы не блокировать легитимных пользователей. Для более продвинутой защиты от DDoS можно интегрировать Nginx с внешними WAF-решениями или использовать облачные сервисы, но базовые меры на уровне Nginx уже дают значительный эффект.

Заголовки безопасности и WAF

Nginx позволяет добавлять различные HTTP-заголовки, которые улучшают безопасность браузера пользователя. Например, X-Frame-Options "DENY" предотвращает кликджекинг, X-Content-Type-Options "nosniff" предотвращает MIME-сниффинг, а Content-Security-Policy (CSP) позволяет контролировать, какие ресурсы может загружать браузер, снижая риск XSS-атак. В 2026 году CSP становится всё более сложным, но его внедрение критично. Для более глубокой защиты можно интегрировать Nginx с Web Application Firewall (WAF), например, ModSecurity. ModSecurity в режиме Nginx-модуля позволяет фильтровать запросы и блокировать известные векторы атак (SQL-инъекции, XSS и т.д.) до того, как они достигнут бэкенда. Это особенно ценно на VPS, где нет возможности развернуть аппаратный WAF. Настройка WAF требует внимательности, чтобы избежать ложных срабатываний, но обеспечивает мощный уровень защиты.

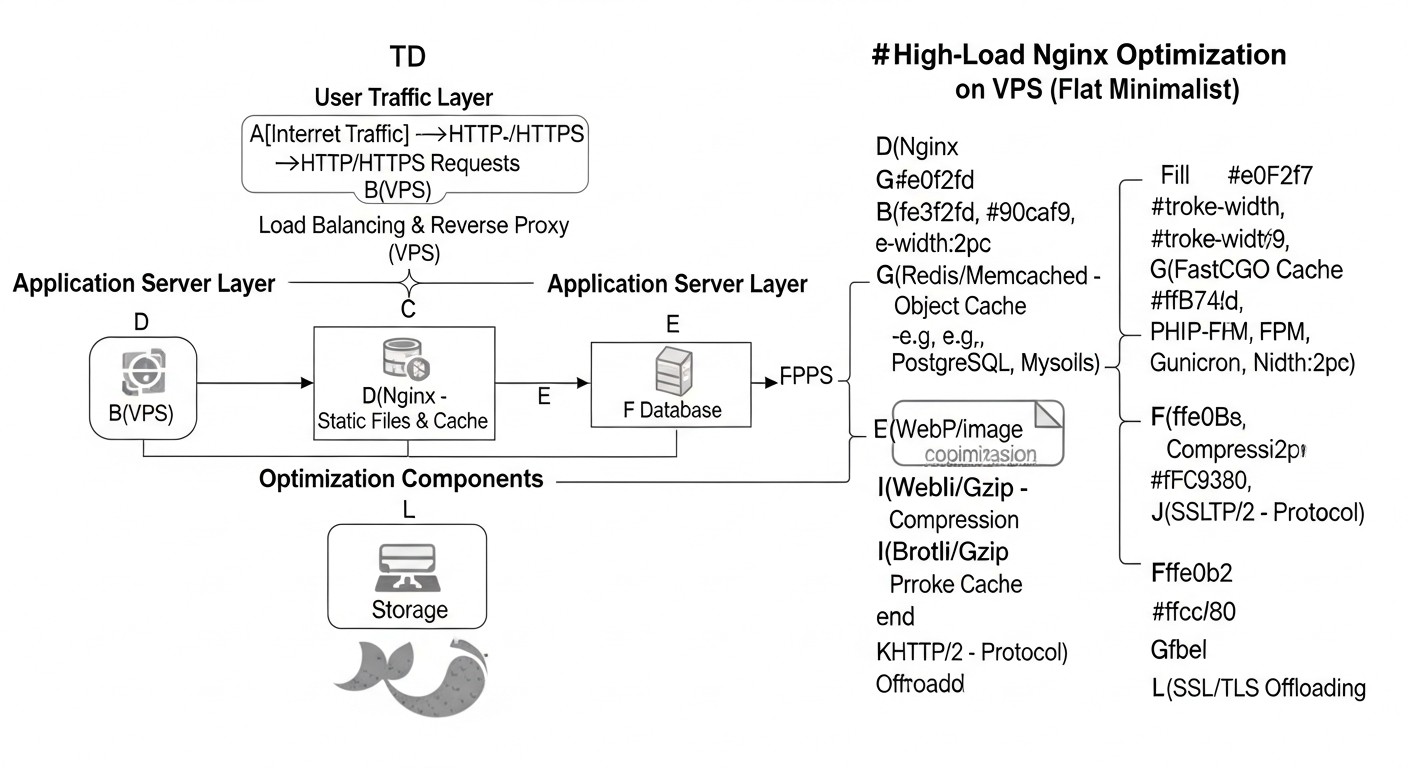

Производительность: Максимальная эффективность

Тонкая настройка внутренних механизмов Nginx и операционной системы позволяет добиться максимальной производительности.

Оптимизация Worker Processes и Connections

Nginx работает по асинхронной, событийной модели, используя небольшое количество рабочих процессов (worker processes) для обработки множества соединений. Количество worker_processes обычно устанавливается равным количеству ядер CPU на вашем VPS (или auto). Каждый worker_process способен обрабатывать тысячи одновременных соединений благодаря неблокирующему вводу/выводу. Директива worker_connections определяет максимальное количество соединений, которое может обрабатывать каждый рабочий процесс. Суммарное количество соединений, которые может обрабатывать Nginx, равно worker_processes * worker_connections. Для VPS с 2-4 ядрами и 2-4 ГБ RAM, разумным значением worker_connections может быть 4096-8192. Важно также увеличить лимиты файловых дескрипторов на уровне операционной системы (ulimit -n) до соответствующего значения, иначе Nginx не сможет открыть столько соединений. Правильная настройка этих параметров позволяет Nginx эффективно использовать доступные ресурсы CPU и RAM, предотвращая их переполнение и обеспечивая стабильную работу под высокой нагрузкой.

Keepalive Connections

Keepalive-соединения позволяют использовать одно TCP-соединение для нескольких HTTP-запросов, вместо того чтобы устанавливать новое соединение для каждого запроса. Это значительно снижает накладные расходы на установление соединения (TCP-рукопожатие, SSL/TLS-рукопожатие) и ускоряет загрузку страниц, содержащих множество ресурсов (изображения, CSS, JS). Директива keepalive_timeout определяет, как долго Nginx будет держать соединение открытым после последнего запроса. Обычно устанавливается в 15-75 секунд. Слишком короткий таймаут приводит к частым переустановкам соединений, слишком длинный — к неэффективному использованию ресурсов. Директива keepalive_requests ограничивает количество запросов, которые могут быть выполнены по одному keepalive-соединению. Оптимальные значения зависят от характера трафика, но для большинства веб-приложений keepalive является обязательным для повышения производительности.

Gzip/Brotli Сжатие

Сжатие HTTP-ответов уменьшает размер передаваемых данных, что сокращает время загрузки страниц для пользователей и экономит пропускную способность. Nginx поддерживает сжатие Gzip "из коробки" и Brotli (через модуль) — более современный и эффективный алгоритм сжатия от Google. Brotli обеспечивает лучшее соотношение сжатия при сравнимой скорости. В 2026 году рекомендуется использовать Brotli для всех поддерживаемых браузеров и Gzip в качестве запасного варианта. Директивы gzip on;, gzip_types, gzip_min_length, gzip_comp_level контролируют параметры сжатия. Важно сжимать только текстовые файлы (HTML, CSS, JS, JSON, XML) и избегать сжатия уже сжатых файлов (изображения JPG/PNG, видео, PDF), так как это только увеличит нагрузку на CPU без выигрыша в размере. Сжатие на лету требует CPU-ресурсов, поэтому для статики лучше использовать предварительно сжатые версии.

HTTP/2 и HTTP/3 (QUIC)

HTTP/2 стал стандартом де-факто, значительно улучшив производительность по сравнению с HTTP/1.1 за счет мультиплексирования (множество запросов по одному соединению), Server Push и сжатия заголовков. Nginx поддерживает HTTP/2 (listen 443 ssl http2;). В 2026 году активно внедряется HTTP/3, основанный на протоколе QUIC, который работает поверх UDP и решает проблему head-of-line blocking на уровне TCP, дополнительно снижая задержки, особенно в условиях нестабильных сетей. Nginx уже имеет экспериментальную поддержку HTTP/3 (через Nginx QUIC). Переход на HTTP/2 и HTTP/3 является одним из самых мощных способов ускорения загрузки страниц, особенно для сайтов с большим количеством ресурсов. Это требует наличия SSL/TLS, так как HTTP/2 и HTTP/3 работают исключительно поверх зашифрованных соединений.

Оптимизация буферов

Nginx использует буферы для временного хранения данных при взаимодействии с клиентами и бэкендом. Правильная настройка размеров буферов предотвращает нежелательные операции записи на диск (что медленно) и обеспечивает плавный поток данных. Ключевые директивы: client_body_buffer_size (для тела запроса клиента), client_header_buffer_size (для заголовков запроса клиента), proxy_buffer_size, proxy_buffers, proxy_busy_buffers_size (для буферизации ответов от бэкенда). Слишком маленькие буферы могут привести к записи данных на диск, что замедляет работу. Слишком большие — к неэффективному использованию RAM. Оптимальные значения зависят от размера типичных запросов и ответов вашего приложения, но часто используются значения в диапазоне 4k-128k для буферов. На VPS, где RAM ограничена, нужно найти баланс между производительностью и потреблением памяти.

Практические советы и рекомендации по настройке Nginx

Давайте перейдем к конкретным конфигурационным файлам и командам, которые помогут вам применить вышеописанные методы на практике. Все примеры актуальны для Nginx 1.20+ и OpenSSL 1.1.1+.

Базовая установка и системная подготовка

Перед тем как начать, убедитесь, что ваша система готова. Используйте актуальную версию дистрибутива (например, Ubuntu Server 22.04 LTS) и Nginx.

# Обновление системы

sudo apt update && sudo apt upgrade -y

# Установка Nginx (если еще не установлен)

sudo apt install nginx -y

# Проверка версии Nginx и OpenSSL

nginx -V

# Убедитесь, что Nginx скомпилирован с OpenSSL 1.1.1 или новее и модулями Brotli, HTTP/2.

# Пример вывода: built with OpenSSL 1.1.1w... --with-http_v2_module --add-module=/path/to/ngx_brotli

# Настройка лимитов файловых дескрипторов (для worker_connections)

# Отредактируйте /etc/security/limits.conf

echo "nginx - nofile 65535" | sudo tee -a /etc/security/limits.conf

echo "nginx - nproc 65535" | sudo tee -a /etc/security/limits.conf

# Отредактируйте /etc/sysctl.conf для увеличения временных портов и других параметров TCP

echo "net.core.somaxconn = 65535" | sudo tee -a /etc/sysctl.conf

echo "net.ipv4.ip_local_port_range = 1024 65535" | sudo tee -a /etc/sysctl.conf

echo "net.ipv4.tcp_tw_reuse = 1" | sudo tee -a /etc/sysctl.conf

echo "net.ipv4.tcp_fin_timeout = 30" | sudo tee -a /etc/sysctl.conf

echo "net.ipv4.tcp_keepalive_time = 600" | sudo tee -a /etc/sysctl.conf

echo "net.ipv4.tcp_max_syn_backlog = 8192" | sudo tee -a /etc/sysctl.conf

sudo sysctl -p # Применить изменения sysctl

Основной конфиг Nginx (/etc/nginx/nginx.conf)

Эти настройки влияют на работу всех виртуальных хостов.

user www-data;

worker_processes auto; # Количество ядер CPU

pid /run/nginx.pid;

include /etc/nginx/modules-enabled/*.conf;

events {

worker_connections 8192; # Максимальное количество соединений на процесс

multi_accept on; # Разрешить worker_process принимать несколько соединений одновременно

use epoll; # Оптимальный метод обработки событий для Linux

}

http {

## Основные настройки производительности

sendfile on;

tcp_nopush on;

tcp_nodelay on;

keepalive_timeout 65; # Таймаут для keepalive соединений

keepalive_requests 1000; # Максимальное количество запросов по одному keepalive соединению

types_hash_max_size 2048;

server_tokens off; # Скрыть версию Nginx для безопасности

## MIME-типы

include /etc/nginx/mime.types;

default_type application/octet-stream;

## SSL/TLS настройки (глобальные, если применимо)

ssl_protocols TLSv1.2 TLSv1.3;

ssl_prefer_server_ciphers on;

ssl_ciphers "TLS_AES_128_GCM_SHA256:TLS_AES_256_GCM_SHA384:TLS_CHACHA20_POLY1305_SHA256:ECDHE-RSA-AES128-GCM-SHA256:ECDHE-RSA-AES256-GCM-SHA384";

ssl_ecdh_curve secp384r1; # Для TLS 1.2

ssl_session_timeout 1d;

ssl_session_cache shared:SSL:10m;

ssl_session_tickets off;

ssl_stapling on;

ssl_stapling_verify on;

resolver 8.8.8.8 8.8.4.4 valid=300s; # DNS-серверы для OCSP

resolver_timeout 5s;

## Gzip / Brotli сжатие

gzip on;

gzip_vary on;

gzip_proxied any;

gzip_comp_level 6;

gzip_buffers 16 8k;

gzip_http_version 1.1;

gzip_types text/plain text/css application/json application/javascript text/xml application/xml application/xml+rss text/javascript;

gzip_min_length 1000; # Минимальный размер ответа для сжатия

# Если установлен модуль Brotli:

# brotli on;

# brotli_comp_level 6;

# brotli_static on; # Отдавать предсжатые .br файлы

# brotli_types text/plain text/css application/json application/javascript text/xml application/xml application/xml+rss text/javascript image/svg+xml;

## Логирование (доступ и ошибки)

access_log /var/log/nginx/access.log;

error_log /var/log/nginx/error.log warn;

## Буферы

client_body_buffer_size 128k;

client_header_buffer_size 128k;

client_max_body_size 100m; # Максимальный размер тела запроса

large_client_header_buffers 4 256k; # Увеличить для больших заголовков

include /etc/nginx/conf.d/*.conf; # Для дополнительных конфигов

include /etc/nginx/sites-enabled/*; # Для виртуальных хостов

}

Настройка Proxy Cache и FastCGI Cache

Создайте директории для кэша и настройте права:

sudo mkdir -p /var/cache/nginx/proxy_cache

sudo mkdir -p /var/cache/nginx/fastcgi_cache

sudo chown -R www-data:www-data /var/cache/nginx

Добавьте в http блок nginx.conf или в отдельный файл (например, /etc/nginx/conf.d/cache.conf):

# Proxy Cache Zone

proxy_cache_path /var/cache/nginx/proxy_cache levels=1:2 keys_zone=my_proxy_cache:100m inactive=60m max_size=10g;

# FastCGI Cache Zone

fastcgi_cache_path /var/cache/nginx/fastcgi_cache levels=1:2 keys_zone=my_fastcgi_cache:100m inactive=60m max_size=10g;

Пример использования в виртуальном хосте (/etc/nginx/sites-available/your_app.conf):

server {

listen 80;

listen [::]:80;

server_name example.com www.example.com;

return 301 https://$host$request_uri; # Перенаправление на HTTPS

}

server {

listen 443 ssl http2; # Включаем HTTP/2

listen [::]:443 ssl http2;

server_name example.com www.example.com;

ssl_certificate /etc/letsencrypt/live/example.com/fullchain.pem;

ssl_certificate_key /etc/letsencrypt/live/example.com/privkey.pem;

ssl_trusted_certificate /etc/letsencrypt/live/example.com/chain.pem;

# HSTS

add_header Strict-Transport-Security "max-age=31536000; includeSubDomains; preload" always;

add_header X-Frame-Options "DENY";

add_header X-Content-Type-Options "nosniff";

add_header X-XSS-Protection "1; mode=block";

add_header Referrer-Policy "no-referrer-when-downgrade";

root /var/www/your_app/public;

index index.php index.html index.htm;

# Кэширование статики на Nginx и в браузере

location ~* \.(jpg|jpeg|gif|png|webp|svg|ico|css|js|woff|woff2|ttf|eot|otf)$ {

expires 365d;

add_header Cache-Control "public, no-transform";

try_files $uri =404;

}

# Proxy Cache для API (если есть)

location /api/v1/data {

proxy_pass http://backend_api_server;

proxy_cache my_proxy_cache;

proxy_cache_valid 200 302 10m; # Кэшировать 200 и 302 ответы на 10 минут

proxy_cache_valid 404 1m; # Кэшировать 404 на 1 минуту

proxy_cache_key "$scheme$proxy_host$request_uri";

proxy_cache_bypass $cookie_nocache $http_pragma $http_authorization; # Не кэшировать для определенных условий

proxy_no_cache $cookie_nocache $http_pragma $http_authorization;

add_header X-Proxy-Cache $upstream_cache_status; # Показать статус кэша

}

# FastCGI Cache для PHP-приложений

location ~ \.php$ {

try_files $uri =404;

fastcgi_split_path_info ^(.+\.php)(/.+)$;

fastcgi_pass unix:/run/php/php8.2-fpm.sock; # Путь к PHP-FPM сокету

fastcgi_index index.php;

fastcgi_param SCRIPT_FILENAME $document_root$fastcgi_script_name;

include fastcgi_params;

fastcgi_cache my_fastcgi_cache;

fastcgi_cache_valid 200 302 1h; # Кэшировать успешные ответы на 1 час

fastcgi_cache_valid 404 1m;

fastcgi_cache_key "$scheme$request_method$host$request_uri";

fastcgi_cache_bypass $cookie_nocache $http_pragma $arg_nocache; # Обход кэша

fastcgi_no_cache $cookie_nocache $http_pragma $arg_nocache;

add_header X-FastCGI-Cache $upstream_cache_status;

}

# Microcaching для всех HTML страниц (пример)

location / {

proxy_pass http://backend_app_server; # Или fastcgi_pass

proxy_cache my_proxy_cache; # Или my_fastcgi_cache

proxy_cache_valid 200 1s; # Кэшировать на 1 секунду

proxy_cache_valid 404 1m;

proxy_cache_key "$scheme$request_method$host$request_uri";

proxy_cache_bypass $cookie_nocache $http_pragma $http_authorization;

proxy_no_cache $cookie_nocache $http_pragma $http_authorization;

add_header X-Micro-Cache $upstream_cache_status;

}

}

Rate Limiting и защита от DDoS

Добавьте в http блок nginx.conf:

# Ограничение запросов: 5 запросов/сек, burst 10 (10 запросов могут быть обработаны в пике, затем задержка)

limit_req_zone $binary_remote_addr zone=mylimit:10m rate=5r/s;

# Ограничение соединений: 20 одновременных соединений с одного IP

limit_conn_zone $binary_remote_addr zone=per_ip:10m;

Используйте в server или location блоке:

server {

# ...

limit_conn per_ip 20; # Применить к серверу в целом

location /login {

limit_req zone=mylimit burst=10 nodelay; # Применить к /login, не задерживать burst

# ...

}

location /api/v1/sensitive {

limit_req zone=mylimit burst=5; # Применить к чувствительному API, задерживать burst

# ...

}

}

Оптимизация буферов для бэкенда

Если Nginx работает как обратный прокси для бэкенда (например, Node.js, Python Gunicorn), эти настройки в location или server блоке критичны:

location / {

proxy_pass http://your_backend;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

proxy_buffers 32 4k; # 32 буфера по 4KB

proxy_buffer_size 8k; # Размер первого буфера

proxy_busy_buffers_size 16k; # Максимальный размер буферов, которые могут быть заняты отправкой

proxy_temp_file_write_size 32k; # Размер данных, записываемых во временный файл

proxy_max_temp_file_size 0; # Отключить запись во временные файлы на диск, если есть достаточно RAM

proxy_connect_timeout 60s;

proxy_send_timeout 60s;

proxy_read_timeout 60s;

}

После любых изменений конфигурации Nginx, всегда проверяйте синтаксис и перезагружайте сервис:

sudo nginx -t

sudo systemctl reload nginx

Типичные ошибки при оптимизации Nginx на VPS

Даже опытные инженеры могут допускать ошибки, особенно при работе с высоконагруженными системами и ограниченными ресурсами VPS. Знание этих подводных камней поможет вам их избежать.

Недостаточные лимиты файловых дескрипторов

Ошибка: Установка worker_connections в Nginx на высокое значение (например, 8192), но игнорирование лимитов файловых дескрипторов (file descriptors, FD) на уровне операционной системы. По умолчанию в Linux лимит FD для процессов может быть низким (например, 1024). Nginx использует FD для каждого соединения, а также для файлов логов, конфигурации, кэша. Если лимит ОС ниже, чем суммарное количество соединений, которое Nginx пытается открыть, вы получите ошибки "too many open files" в логах Nginx, и сервер не сможет принимать новые соединения, несмотря на правильную настройку worker_connections.

Как избежать: Увеличьте лимит FD для пользователя Nginx (обычно www-data или nginx) в /etc/security/limits.conf и/или глобально через /etc/sysctl.conf. Убедитесь, что ulimit -n для пользователя, от имени которого запускается Nginx, соответствует или превышает желаемое worker_connections. После изменения limits.conf может потребоваться перезапуск сессии или сервера.

# В /etc/security/limits.conf

# Добавьте или измените:

# www-data soft nofile 65535

# www-data hard nofile 65535

# Перезапуск Nginx после изменения лимитов (возможно, потребуется перезагрузка VPS)

sudo systemctl restart nginx

Чрезмерное или некорректное кэширование

Ошибка: Кэширование персонализированного контента (например, страниц после авторизации, корзины покупок) или слишком агрессивное кэширование динамически меняющихся данных. Это может привести к тому, что пользователи будут видеть чужой или устаревший контент, что является серьезной проблемой безопасности и пользовательского опыта.

Как избежать: Используйте директивы proxy_cache_bypass и fastcgi_cache_bypass для исключения из кэша запросов с куками авторизации, уникальными токенами или POST-запросов. Тщательно продумайте proxy_cache_key, чтобы он учитывал все параметры, влияющие на уникальность контента. Для очень динамического контента используйте микрокэширование с коротким сроком жизни (1-5 секунд) или вообще откажитесь от кэширования на Nginx для таких страниц, если приложение само эффективно кэширует.

Игнорирование логирования или слишком подробное логирование

Ошибка: Полное отключение логов Nginx (access_log off) в попытке сэкономить ресурсы или, наоборот, слишком подробное логирование каждого запроса, включая статику, что приводит к огромным файлам логов, высокому I/O и быстрому исчерпанию дискового пространства на VPS.

Как избежать: Не отключайте логи полностью, они критически важны для отладки, мониторинга и анализа безопасности. Вместо этого оптимизируйте формат логов (log_format) для включения только нужных данных. Отключите логирование статических файлов (изображений, CSS, JS), которые успешно отдаются из кэша, так как они создают много шума. Используйте access_log off; внутри location блока для статики. Настройте ротацию логов (logrotate) для автоматического сжатия и удаления старых логов.

# В nginx.conf в http блоке

log_format custom_log '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" "$http_user_agent" '

'"$http_x_forwarded_for" "$upstream_response_time" "$request_time"';

access_log /var/log/nginx/access.log custom_log;

# В server блоке для статики

location ~* \.(jpg|jpeg|gif|png|webp|svg|ico|css|js|woff|woff2|ttf|eot|otf)$ {

expires 365d;

add_header Cache-Control "public, no-transform";

access_log off; # Отключить логирование для статики

try_files $uri =404;

}

Неоптимизированные настройки SSL/TLS

Ошибка: Использование устаревших версий TLS (1.0, 1.1), слабых шифров или отсутствие HSTS. Это не только делает ваше приложение уязвимым, но и замедляет TLS-рукопожатие, увеличивая latency.

Как избежать: Всегда используйте TLS 1.2 и TLS 1.3 (если Nginx скомпилирован с OpenSSL 1.1.1+). Выбирайте только сильные, современные шифры. Включите HSTS и OCSP Stapling. Регулярно проверяйте конфигурацию SSL/TLS с помощью сервисов вроде SSL Labs. Обновляйте Nginx и OpenSSL для получения последних улучшений безопасности и производительности.

Игнорирование мониторинга и нагрузочного тестирования

Ошибка: Применение оптимизаций "вслепую" без измерения до и после, а также без регулярного мониторинга работы Nginx под реальной или имитированной нагрузкой. Это приводит к тому, что проблемы остаются незамеченными или новые оптимизации могут вызвать регрессии.

Как избежать: Внедрите систему мониторинга (NGINX Amplify, Prometheus/Grafana, Netdata) для отслеживания ключевых метрик Nginx (RPS, Latency, CPU/RAM usage, кэш-хиты/миссы, ошибки). Регулярно проводите нагрузочное тестирование (k6, JMeter, Gatling) на тестовых или стейджинг-средах, чтобы выявлять узкие места и проверять эффективность оптимизаций до их внедрения в продакшн. Анализируйте логи Nginx на предмет ошибок, предупреждений и аномалий.

Избыточное использование модулей или функций Nginx

Ошибка: Включение множества необязательных модулей или использование сложных конфигураций, которые не приносят ощутимой пользы, но увеличивают потребление памяти и CPU. Например, использование ModSecurity без реальной необходимости или слишком сложные правила перезаписи.

Как избежать: Принцип "чем проще, тем лучше" особенно актуален для VPS. Включайте только те модули и функции, которые вам действительно нужны. Каждая дополнительная директива или модуль добавляет накладные расходы. Проводите бенчмаркинг с различными конфигурациями, чтобы понять, какие изменения действительно дают прирост производительности, а какие лишь усложняют систему.

Чеклист для практического применения оптимизации Nginx

Этот пошаговый алгоритм поможет вам систематически подойти к оптимизации Nginx на вашем VPS.

-

Аудит текущего состояния

Проведите аудит текущей конфигурации Nginx, ресурсов VPS (CPU, RAM, Disk I/O, Network) и производительности вашего веб-приложения (Latency, RPS, Error Rate). Используйте

top,htop,free -h,iostat, а также инструменты вроде Lighthouse, WebPageTest для сбора базовых метрик. -

Обновление Nginx и OpenSSL

Убедитесь, что у вас установлены последние стабильные версии Nginx и OpenSSL (минимум OpenSSL 1.1.1 для TLS 1.3). При необходимости обновите их или перекомпилируйте Nginx с нужными модулями (Brotli, HTTP/3).

-

Настройка системных лимитов

Увеличьте лимиты файловых дескрипторов (

ulimit -n) для пользователя Nginx и настройте параметры TCP-стека в/etc/sysctl.conf(net.core.somaxconn,net.ipv4.ip_local_port_range,net.ipv4.tcp_tw_reuse). -

Оптимизация Worker Processes и Connections

Установите

worker_processes auto;иworker_connectionsна адекватное значение (например, 4096-8192) вnginx.conf, соответствующее системным лимитам. -

Включение и настройка HTTP/2

Добавьте

http2к директивеlisten 443 ssl;в блокеserverдля вашего HTTPS-хоста. Рассмотрите внедрение HTTP/3 (QUIC) при наличии поддержки. -

Настройка SSL/TLS Best Practices

Используйте

ssl_protocols TLSv1.2 TLSv1.3;, современныеssl_ciphers, включитеssl_stapling on;и добавьте заголовок HSTS (Strict-Transport-Security). -

Настройка кэширования статики

Включите

expires 365d;иadd_header Cache-Control "public";для статических файлов. Отключитеaccess_logдля статики в соответствующемlocationблоке. -

Внедрение Nginx Proxy/FastCGI Cache

Определите

proxy_cache_pathиfastcgi_cache_pathвhttpблоке. Используйтеproxy_cache/fastcgi_cacheвlocationблоках для кэширования ответов от бэкенда. Не забудьте про_bypassи_no_cacheдля персонализированного контента. -

Настройка Microcaching

Для динамических, но часто запрашиваемых страниц, настройте

proxy_cache_valid 1s;илиfastcgi_cache_valid 1s;. -

Включение Gzip/Brotli сжатия

Активируйте

gzip on;и настройтеgzip_types. Если доступен модуль Brotli, используйте его для лучшего сжатия (brotli on;). -

Настройка Rate Limiting

Определите

limit_req_zoneиlimit_conn_zoneвhttpблоке и применитеlimit_req/limit_connк соответствующимserverилиlocationблокам для защиты от перегрузок и атак. -

Оптимизация буферов

Настройте

client_body_buffer_size,client_header_buffer_size,proxy_buffersиproxy_buffer_sizeдля оптимальной работы с клиентами и бэкендом, минимизируя запись на диск. -

Настройка заголовков безопасности

Добавьте заголовки

X-Frame-Options,X-Content-Type-Options,X-XSS-Protectionи рассмотрите внедрениеContent-Security-Policy. -

Тестирование и мониторинг

После каждого этапа изменений проверяйте конфигурацию (

sudo nginx -t), перезагружайте Nginx (sudo systemctl reload nginx) и проводите нагрузочное тестирование. Настройте постоянный мониторинг производительности и ошибок. -

Итеративная оптимизация

Оптимизация — это непрерывный процесс. Анализируйте данные мониторинга, выявляйте новые узкие места и продолжайте улучшать конфигурацию Nginx и вашего приложения.

Расчет стоимости и экономика оптимизации Nginx

Инвестиции в оптимизацию Nginx на VPS — это не просто техническое упражнение, а стратегическое решение, которое напрямую влияет на операционные расходы (OpEx) и масштабируемость вашего проекта. В 2026 году стоимость VPS продолжает снижаться, но при этом возрастают требования к производительности. Правильная оптимизация позволяет отсрочить апгрейд VPS до более дорогого тарифа или даже перейти на более дешевый, обслуживая при этом тот же или даже больший объем трафика.

Примеры расчетов для разных сценариев

Сценарий 1: Экономия на апгрейде VPS

Представьте, что ваше веб-приложение на VPS с 2 vCPU, 4GB RAM и 80GB NVMe ($20/месяц в 2026 году) начинает испытывать проблемы с производительностью при пиковой нагрузке в 500 RPS. Без оптимизации, логичным шагом кажется апгрейд до VPS с 4 vCPU, 8GB RAM и 160GB NVMe ($40/месяц). Это увеличит ваши расходы на инфраструктуру вдвое.

Однако, глубокая оптимизация Nginx (кэширование, HTTP/2, Brotli, системные настройки) может снизить нагрузку на бэкенд и Nginx на 30-50%. Если благодаря Nginx Proxy Cache 60% запросов обслуживаются без обращения к бэкенду, а HTTP/2 и Brotli сокращают время загрузки и объем трафика, то ваш текущий VPS может легко справляться с 700-800 RPS. Это означает, что вы отсрочили апгрейд на несколько месяцев или даже год, сэкономив $20/месяц * X месяцев. За год это до $240 экономии.

Сценарий 2: Увеличение пропускной способности без увеличения затрат

Допустим, ваш SaaS-проект на VPS ($30/месяц) обслуживает 1000 активных пользователей и генерирует 1000 RPS. Вы хотите увеличить количество пользователей до 2000, что потенциально удвоит RPS. Без оптимизации это приведет к необходимости удвоить ресурсы VPS (и затраты до $60/месяц).

С оптимизированным Nginx (например, 70% кэш-хитов для статики и 40% для динамики, эффективный rate limiting), ваш текущий VPS может выдержать до 1500-1800 RPS без значительной деградации производительности. Это позволяет вам масштабироваться до 1500-1800 пользователей, не увеличивая ежемесячные затраты на VPS. Вы получаете 50-80% прироста пропускной способности за те же деньги, что напрямую влияет на прибыльность вашего SaaS.

Скрытые расходы и как их оптимизировать

- Время инженера: Самый значительный "скрытый" расход — это время высококвалифицированного DevOps-инженера или разработчика. Однако, это инвестиция. Часы, потраченные на настройку Nginx, окупятся снижением будущих затрат на инфраструктуру и уменьшением количества инцидентов. Автоматизация развертывания Nginx с помощью Ansible, Terraform или Docker/Kubernetes сокращает эти затраты в долгосрочной перспективе.

- Мониторинг: Системы мониторинга (Prometheus, Grafana, NGINX Amplify) требуют установки, настройки и иногда платной подписки. Это не расход, а необходимая инвестиция, которая помогает оперативно выявлять проблемы и оценивать эффективность оптимизаций.

-

Дисковое пространство для кэша: Кэширование на диске требует дополнительного пространства. На VPS с NVMe-дисками это может быть дороже, чем на HDD. Однако, стоимость дискового пространства обычно ниже, чем стоимость дополнительного CPU или RAM. Эффективное управление кэшем (

inactive,max_size) помогает контролировать его размер. - SSL-сертификаты: В 2026 году Let's Encrypt предоставляет бесплатные SSL-сертификаты, что устраняет эту статью расходов. Однако, для Enterprise-уровня могут потребоваться платные EV или Wildcard сертификаты.

Таблица с примерами расчетов

Примерная экономика для среднего SaaS-проекта на VPS в 2026 году:

| Параметр | До оптимизации | После оптимизации Nginx | Разница/Экономия |

|---|---|---|---|

| Тип VPS | 4 vCPU, 8GB RAM, 160GB NVMe | 2 vCPU, 4GB RAM, 80GB NVMe | Переход на более дешевый тариф |

| Стоимость VPS/месяц (2026) | $40 | $20 | -$20/месяц |

| Максимальный RPS (Web App) | 1000 RPS | 1500 RPS (на более дешевом VPS) | +500 RPS |

| Время отклика (Latency) | 200-300 мс | 50-100 мс | -150-200 мс |

| Коэффициент кэш-хитов Nginx | 0% | 60% (для статики), 40% (для динамики) | Значительное снижение нагрузки на бэкенд |

| Потребление CPU бэкендом | 80-90% при пике | 40-50% при пике | -40-50% |

| Потребление RAM бэкендом | 70-80% при пике | 50-60% при пике | -20-30% |

| Годовая экономия на VPS | - | - | До $240/год |

| Прирост вместимости (пользователей) | 1000 | 1500-1800 | +50-80% без доп. затрат |

Как видно, инвестиции в оптимизацию Nginx окупаются многократно. Помимо прямой экономии на железе, вы получаете более быстрый и стабильный сервис, что улучшает пользовательский опыт, снижает отток клиентов и способствует росту вашего бизнеса.

Кейсы и примеры из реальной практики

Теория важна, но реальные примеры демонстрируют истинную силу оптимизации Nginx. Вот несколько кейсов, основанных на типичных сценариях.

Кейс 1: Спасение стартапа от краха из-за "эффекта Хабра"

Проблема

Молодой SaaS-стартап запустил свой продукт — онлайн-инструмент для дизайнеров. VPS-сервер стоил $35/месяц (4 vCPU, 8GB RAM) и работал на Node.js бэкенде с PostgreSQL. В один прекрасный день статья о продукте попала на популярный технологический портал, что вызвало "эффект Хабра" — взрывной рост трафика. RPS взлетел с 50 до 1500. Сервер начал отвечать с 502/504 ошибками, время отклика выросло до 5-10 секунд, а база данных постоянно "захлебывалась". Пользователи не могли зарегистрироваться, сессии обрывались. Стартап терял потенциальных клиентов в самый важный момент.

Решение

Команда экстренно обратилась к DevOps-специалисту. Первым делом Nginx был настроен как обратный прокси с глубоким кэшированием. Были выполнены следующие шаги:

- Настроен Nginx Proxy Cache для всех статических ресурсов (CSS, JS, изображения), а также для некоторых API-эндпоинтов, которые возвращали общие данные (например, список тарифов, публичные шаблоны). Установлен

proxy_cache_valid 200 302 1h;. - Внедрено микрокэширование (

proxy_cache_valid 200 1s;) для главной страницы и страниц описания продукта, которые обновлялись не чаще раза в несколько минут. Это позволило Nginx отдавать свежий контент, но при этом обрабатывать пиковые нагрузки. - Увеличены

worker_connectionsдо 8192 и соответствующие системные лимиты файловых дескрипторов. - Включен HTTP/2 и Brotli-сжатие.

- Настроен

limit_req_zoneдля защиты от сканирования и ботов, которые также набросились на сайт.

Результат

После внедрения этих изменений, Nginx начал обслуживать до 70% запросов из кэша. Нагрузка на Node.js бэкенд и PostgreSQL упала в 3-4 раза. Время отклика стабилизировалось на уровне 150-250 мс. Сервер смог выдерживать пики до 2000 RPS без деградации производительности, используя тот же VPS за $35/месяц. Стартап не только пережил "эффект Хабра", но и эффективно конвертировал значительную часть нового трафика в регистрации, избежав дорогостоящего и экстренного апгрейда инфраструктуры.

Кейс 2: Оптимизация WordPress-блога на VPS для SEO и скорости

Проблема

Популярный блог на WordPress, размещенный на VPS за $25/месяц (2 vCPU, 4GB RAM), испытывал проблемы со скоростью загрузки. Показатели Core Web Vitals были низкими (CLS, LCP, FID), что негативно сказывалось на SEO-рейтинге. При пиковой нагрузке (например, после публикации новой статьи) сервер "замирал", а PHP-FPM процессы потребляли всю доступную RAM.

Решение

Для решения проблемы был применен комплексный подход с акцентом на FastCGI Cache и оптимизацию статики:

- Nginx FastCGI Cache был настроен для кэширования всех страниц блога. Срок жизни кэша установлен на 10 минут (

fastcgi_cache_valid 200 10m;). Для авторизованных пользователей (админов) кэш обходился (fastcgi_cache_bypass $cookie_wordpress_logged_in;). - Настроено агрессивное кэширование статики (изображения, CSS, JS, шрифты) с

expires 365d;и отключением логирования для них. - Включен HTTP/2 и Gzip-сжатие (Brotli не был доступен в текущей сборке Nginx).

- Оптимизированы параметры PHP-FPM (

pm.max_children,pm.start_servers) для лучшего соответствия доступной RAM на VPS. - Настроены заголовки безопасности (HSTS, X-Frame-Options) для улучшения общего рейтинга безопасности.

Результат

После внедрения изменений, Nginx стал отдавать до 95% статики и до 80% динамических страниц из кэша. Время загрузки главной страницы сократилось с 3-4 секунд до менее 1 секунды. Показатели Core Web Vitals значительно улучшились, что привело к росту позиций блога в поисковой выдаче. PHP-FPM процессы теперь потребляли значительно меньше RAM, и сервер стал стабильно работать даже при пиковых нагрузках, используя тот же VPS за $25/месяц. Это позволило владельцу блога сосредоточиться на создании контента, а не на проблемах с сервером.

Инструменты и ресурсы для мониторинга и отладки Nginx

Эффективная оптимизация невозможна без постоянного мониторинга и правильных инструментов для отладки. В 2026 году существует множество зрелых решений, которые помогут вам поддерживать Nginx в оптимальном состоянии.

Утилиты для работы с Nginx и системой

-

nginx -t: Всегда используйте эту команду после любых изменений в конфигурации Nginx, чтобы проверить синтаксис. Это предотвратит ошибки при перезагрузке сервиса. -

nginx -s reloadилиsudo systemctl reload nginx: Для безопасной перезагрузки конфигурации без остановки сервиса. -

nginx -V: Показывает версию Nginx, параметры компиляции и включенные модули. Полезно для проверки поддержки HTTP/2, Brotli или других модулей. -

top/htop: Стандартные утилиты для мониторинга использования CPU, RAM и процессов в реальном времени. Помогают быстро выявить процессы Nginx, потребляющие много ресурсов. -

iostat/iotop: Для мониторинга дискового ввода/вывода (I/O). Критично для кэширующих серверов, чтобы убедиться, что кэш не вызывает узких мест на диске. -

netstat -tulnp/ss -tulnp: Показывает открытые порты и активные сетевые соединения. Полезно для проверки, что Nginx слушает нужные порты. -

tail -f /var/log/nginx/access.log/error.log: Просмотр логов в реальном времени. Незаменим для отладки проблем и мониторинга запросов.

Мониторинг и тестирование

- NGINX Amplify: Официальный инструмент мониторинга от NGINX Inc. Предоставляет подробную информацию о производительности Nginx, включая RPS, Latency, кэш-хиты/миссы, состояние worker-процессов. Есть бесплатный тариф для одного сервера.

-

Prometheus + Grafana: Мощная связка для сбора, хранения и визуализации метрик. Nginx Exporter позволяет собирать данные из

nginx_status. Позволяет создавать кастомные дашборды и алерты, что идеально подходит для глубокого анализа производительности. - Netdata: Легковесный, но очень функциональный мониторинг в реальном времени. Устанавливается одной командой и предоставляет богатые интерактивные дашборды для всей системы, включая Nginx.

- k6: Современный инструмент для нагрузочного тестирования, написанный на Go. Позволяет писать тестовые сценарии на JavaScript, легко интегрируется в CI/CD. Отлично подходит для проверки Nginx под высокой нагрузкой.

- JMeter / Gatling: Более тяжеловесные, но очень мощные инструменты для нагрузочного тестирования, особенно для сложных сценариев с авторизацией, сессиями и множеством шагов.

- SSL Labs Server Test: Онлайн-сервис для глубокого анализа конфигурации SSL/TLS вашего сервера. Поможет убедиться, что вы используете сильные шифры, TLS 1.3 и HSTS.

- WebPageTest / Google Lighthouse: Инструменты для анализа производительности загрузки страниц с точки зрения пользователя. Помогают оценить влияние кэширования, HTTP/2 и сжатия на реальную скорость.

Полезные ссылки и документация

- Официальная документация Nginx: Всегда актуальный и исчерпывающий источник информации по всем директивам.

- Блог Nginx: Публикует статьи о новых функциях, производительности и best practices.

- Mozilla SSL Configuration Generator: Помогает сгенерировать безопасные и актуальные настройки SSL/TLS для Nginx.

- SSL Labs Server Test: Проверьте свою SSL/TLS конфигурацию.

- Google PageSpeed Insights: Анализатор производительности веб-страниц от Google.

Troubleshooting: Решение типичных проблем с Nginx

Даже при самой тщательной настройке могут возникнуть проблемы. Умение быстро диагностировать и устранять их критически важно. Вот несколько типичных проблем и подходов к их решению.

502 Bad Gateway / 504 Gateway Timeout

Описание: Эти ошибки указывают на то, что Nginx не смог получить своевременный или корректный ответ от вышестоящего (бэкенд) сервера. 502 обычно означает, что бэкенд вернул некорректный ответ или упал, 504 — что бэкенд не ответил в течение установленного таймаута.

Диагностика:

- Проверьте логи ошибок Nginx (

/var/log/nginx/error.log). Там будут указаны детали, например "connect() failed (111: Connection refused)" или "upstream timed out". - Проверьте статус бэкенд-приложения (PHP-FPM, Node.js, Gunicorn и т.д.). Используйте

sudo systemctl status php8.2-fpmили аналогичные команды. - Проверьте логи самого бэкенд-приложения.

- Убедитесь, что бэкенд-приложение слушает правильный порт/сокет, и Nginx настроен на подключение к нему (

proxy_passилиfastcgi_pass). - Проверьте сетевую связность между Nginx и бэкендом (

ping,telnetна порт бэкенда).

Решение:

- Увеличьте таймауты Nginx (

proxy_connect_timeout,proxy_send_timeout,proxy_read_timeout) и таймауты бэкенд-приложения, если запросы действительно долгие. - Оптимизируйте бэкенд-приложение, чтобы оно отвечало быстрее.

- Увеличьте количество worker-процессов или потоков бэкенда, чтобы он мог обрабатывать больше параллельных запросов.

- Проверьте, не исчерпываются ли ресурсы VPS (CPU, RAM) бэкендом.

Высокая загрузка CPU Nginx

Описание: Nginx сам по себе обычно очень эффективен и редко является причиной высокой загрузки CPU, если только он не выполняет интенсивные операции (например, SSL-шифрование на старом железе, сжатие большого объема данных на лету).

Диагностика:

- Используйте

htop, чтобы посмотреть, какие процессы Nginx потребляют CPU. - Проверьте

nginx -V, чтобы убедиться, что Nginx скомпилирован с актуальной версией OpenSSL. - Проверьте логи доступа на предмет необычно большого количества запросов (DDoS-атака, боты).

- Оцените, какой объем данных Nginx сжимает на лету (если включен gzip/Brotli).

Решение:

- Убедитесь, что

worker_processesустановлен по количеству ядер CPU. - Используйте TLS 1.3 и современные шифры, они более эффективны.

- Настройте rate limiting, чтобы отсекать избыточные запросы.

- Для статики используйте предварительно сжатые файлы (

gzip_static on;илиbrotli_static on;), чтобы Nginx не тратил CPU на сжатие на лету. - Проверьте, не происходит ли активная запись кэша на медленный диск, что может вызывать задержки и косвенно влиять на CPU.

Нехватка памяти (Out of Memory)

Описание: Nginx или бэкенд-приложение потребляют слишком много RAM, что приводит к замедлениям, использованию свопа или даже краху приложений из-за OOM Killer.

Диагностика:

- Используйте

free -hиhtopдля мониторинга использования RAM. - Проверьте логи Nginx и бэкенда на предмет ошибок, связанных с памятью.

- Оцените размер кэша Nginx (

keys_zone,max_size) и буферов (proxy_buffers), если они слишком велики для вашего VPS. - Проверьте настройки PHP-FPM (

pm.max_children,php_memory_limit) или аналогичные для других бэкендов.

Решение:

- Уменьшите

worker_connections, если каждый worker потребляет слишком много памяти. - Уменьшите

max_sizeдля кэша Nginx илиkeys_zone. - Оптимизируйте буферы Nginx, чтобы они не были чрезмерно большими.

- Оптимизируйте бэкенд-приложение на предмет утечек памяти или неэффективного использования RAM.

- Уменьшите количество worker-процессов бэкенда или лимит памяти для каждого процесса.

- Если ничего не помогает, возможно, ваш VPS просто не справляется с текущей нагрузкой, и требуется апгрейд.

Проблемы с SSL/TLS

Описание: Браузеры сообщают об ошибках SSL-сертификата, сайт недоступен по HTTPS, или медленное SSL-рукопожатие.

Диагностика:

- Проверьте логи ошибок Nginx.

- Используйте онлайн-сервис SSL Labs Server Test для глубокого анализа вашей конфигурации.

- Убедитесь, что пути к

ssl_certificateиssl_certificate_keyв Nginx корректны и файлы существуют. - Проверьте, что сертификат не просрочен.

- Убедитесь, что Nginx слушает порт 443 (

listen 443 ssl;).

Решение:

- Обновите или перевыпустите просроченный сертификат.

- Исправьте пути в конфигурации Nginx.

- Убедитесь, что брандмауэр (ufw, firewalld) разрешает входящие соединения на порт 443.

- Используйте рекомендации SSL Labs для настройки сильных шифров и протоколов.

- Включите OCSP Stapling для ускорения проверки сертификата.

Когда обращаться в поддержку VPS-провайдера

Если вы исчерпали все возможности оптимизации Nginx и бэкенда, а проблемы с производительностью или стабильностью сохраняются, возможно, причина лежит за пределами вашего контроля:

- Проблемы с сетью: Необъяснимые потери пакетов, высокие пинги до вашего VPS, низкая пропускная способность, которая не соответствует заявленной.

- Проблемы с оборудованием: Медленный дисковый I/O, нестабильная работа CPU, внезапные перезагрузки VPS.

- Проблемы с виртуализацией: "Noisy neighbor" эффект, когда соседние VPS на том же физическом хосте потребляют слишком много ресурсов, влияя на ваш VPS.

В этих случаях предоставьте провайдеру максимально подробные логи, метрики и результаты диагностики, чтобы ускорить решение проблемы.

FAQ: Часто задаваемые вопросы по оптимизации Nginx

Какой объем кэша Nginx оптимален для VPS с 4GB RAM?

Для VPS с 4GB RAM, разумно выделить под Nginx Proxy/FastCGI кэш на диске до 5-10GB, при этом размер keys_zone (хранящей метаданные кэша в RAM) не должен превышать 100-200MB. Если у вас много RAM и быстрый SSD/NVMe, можно увеличить keys_zone до 500MB и max_size кэша до 20-30GB. Важно мониторить использование RAM Nginx и дисковое I/O. Если кэш активно сбрасывается на диск, это может указывать на недостаток RAM для keys_zone или слишком интенсивное использование кэша.

Стоит ли использовать Nginx как балансировщик нагрузки на одном VPS?

На одном VPS Nginx можно использовать как балансировщик нагрузки, если у вас несколько инстансов бэкенд-приложения (например, несколько процессов Node.js или Gunicorn), слушающих разные порты, или если вы используете микросервисную архитектуру. Это позволяет Nginx эффективно распределять запросы между ними, повышая отказоустойчивость и равномерно используя CPU. Однако, это не обеспечит отказоустойчивости на уровне сервера. В случае падения VPS, весь сервис станет недоступен.

Как часто нужно обновлять Nginx?

Рекомендуется следить за стабильными релизами Nginx (например, 1.20.x, 1.22.x, 1.24.x) и обновляться, когда выходят новые версии с важными исправлениями безопасности или производительности. Обычно достаточно обновляться раз в несколько месяцев или при выходе LTS-версий дистрибутива. Всегда тестируйте обновления на стейджинг-среде перед развертыванием в продакшн.

Нужно ли использовать отдельный VPS для Nginx и бэкенда?

Для небольших и средних проектов на VPS обычно нет необходимости разделять Nginx и бэкенд на разные VPS. Nginx очень легковесен и может эффективно работать на том же сервере, что и бэкенд. Разделение имеет смысл при очень высоких нагрузках, когда Nginx сам по себе становится узким местом, или для усиления безопасности, но для большинства VPS-проектов это избыточно и ведет к увеличению затрат.

Как Nginx влияет на SEO?

Nginx напрямую влияет на SEO через скорость загрузки страниц и доступность. Быстрая загрузка страниц (благодаря кэшированию, HTTP/2, сжатию) улучшает пользовательский опыт и является важным фактором ранжирования в Google (Core Web Vitals). Правильная настройка SSL/TLS обеспечивает безопасное соединение, что также является SEO-фактором. Устойчивость к нагрузкам гарантирует, что поисковые роботы всегда смогут получить доступ к вашему контенту.

Что такое "Server Tokens off" и почему это важно?

Директива server_tokens off; в nginx.conf отключает отображение версии Nginx в заголовках HTTP-ответов и на страницах ошибок. Это мера безопасности, так как скрытие версии сервера усложняет для злоумышленников идентификацию потенциальных уязвимостей, специфичных для конкретной версии Nginx. Хотя это не панацея, это хорошая практика "безопасности через неясность".

Как бороться с DDoS-атаками, если Nginx rate limiting недостаточно?

Если встроенные возможности Nginx (limit_req, limit_conn) не справляются с DDoS-атакой, это означает, что атака достаточно мощная, чтобы перегрузить даже Nginx. В этом случае необходимо использовать внешние сервисы защиты от DDoS, такие как Cloudflare, Sucuri, Akamai, или решения от вашего VPS-провайдера. Они работают на уровне DNS или проксируют трафик через свои сети, фильтруя вредоносные запросы до того, как они достигнут вашего VPS.

Можно ли использовать Redis или Memcached для кэширования в Nginx?

Nginx сам по себе не поддерживает прямое кэширование в Redis или Memcached. Его встроенные механизмы кэширования работают с файловой системой и RAM (для метаданных). Однако, вы можете использовать Nginx в связке с бэкенд-приложением, которое использует Redis/Memcached для своего собственного кэширования. Например, ваше PHP-приложение может кэшировать данные в Redis, а Nginx уже кэшировать ответы от этого PHP-приложения.

Как Nginx взаимодействует с CDN?

Nginx на вашем VPS может выступать в роли "origin server" для CDN. CDN кэширует ваш контент на своих edge-серверах по всему миру, значительно ускоряя доставку пользователям и снимая нагрузку с вашего VPS. Nginx должен быть настроен для корректной работы с CDN: передавать правильные заголовки Cache-Control, Expires, ETag, а также обрабатывать запросы от CDN. Часто Nginx также используется для обслуживания статики напрямую из кэша, если CDN по какой-то причине не использовалась или не кэшировала определенный ресурс.

Какие параметры Nginx наиболее критичны для VPS с ограниченной RAM?

Для VPS с ограниченной RAM наиболее критичны следующие параметры:

worker_processes: Установитеautoили равно количеству ядер, но не больше, чтобы не создавать избыточное количество процессов.worker_connections: Умеренное значение (2048-4096) для каждого процесса, чтобы не исчерпать RAM на соединения.- Размер

keys_zoneдля кэша: Держите его небольшим (например, 50-100MB), так как это RAM. proxy_buffersиproxy_buffer_size: Установите их на разумные значения (например, 4 8k), избегая чрезмерно больших буферов, которые могут потреблять много RAM на каждое соединение.- Отключение записи временных файлов на диск (

proxy_max_temp_file_size 0;), но только если у вас достаточно RAM для буферизации больших ответов. В противном случае лучше писать на диск.

Заключение

Оптимизация Nginx для высоконагруженных веб-приложений на VPS в 2026 году — это не просто набор технических настроек, а фундаментальный подход к построению эффективной, безопасной и экономически выгодной инфраструктуры. Мы рассмотрели три столпа этой оптимизации: кэширование, безопасность и производительность, а также предоставили конкретные примеры, рекомендации и инструменты.

Кэширование, от статики до микрокэширования динамического контента, является вашим самым мощным союзником в борьбе за скорость и снижение нагрузки на бэкенд. Правильно настроенные SSL/TLS, rate limiting и заголовки безопасности превратят Nginx в надежный щит от угроз. А тонкая настройка worker-процессов, буферов и переход на HTTP/2 (и HTTP/3) позволит выжать максимум производительности из каждого vCPU и мегабайта RAM вашего VPS.

Помните, что оптимизация — это итеративный процесс. Начните с базовых настроек, затем постепенно внедряйте более сложные, постоянно мониторя результаты и анализируя данные. Не бойтесь экспериментировать на тестовых средах и учиться на реальных кейсах. Инвестиции времени и усилий в глубокую оптимизацию Nginx окупятся многократно: ваш сервис станет быстрее, стабильнее, безопаснее, а вы сможете обслуживать больше пользователей на тех же ресурсах, откладывая дорогостоящие апгрейды.

Следующие шаги для читателя:

- Проанализируйте текущую конфигурацию вашего Nginx и метрики производительности вашего VPS.

- Выберите 2-3 наиболее актуальных для вашего проекта пункта из чеклиста и начните их внедрять.

- Настройте систему мониторинга (если у вас её еще нет), чтобы отслеживать влияние ваших изменений.

- Проведите нагрузочное тестирование до и после внедрения оптимизаций.

- Непрерывно обучайтесь и следите за новыми возможностями Nginx и веб-технологий.

Удачи в создании молниеносных и надежных веб-приложений!