Задача доступной донастройки LLM

Донастройка LLM требует значительной мощности GPU и памяти. Модели, такие как Llama 2, GPT-3 и другие, требуют существенных ресурсов, что приводит к высоким затратам при использовании традиционных облачных провайдеров. Это руководство посвящено использованию специализированных облачных провайдеров GPU и интеллектуальным методам оптимизации для значительного снижения этих затрат.

Пошаговое руководство по экономичной донастройке LLM

- Выберите правильный GPU: Выбор подходящего GPU имеет решающее значение. Более новые и мощные GPU часто более экономичны за час обучения, чем старые, даже если их почасовая ставка выше.

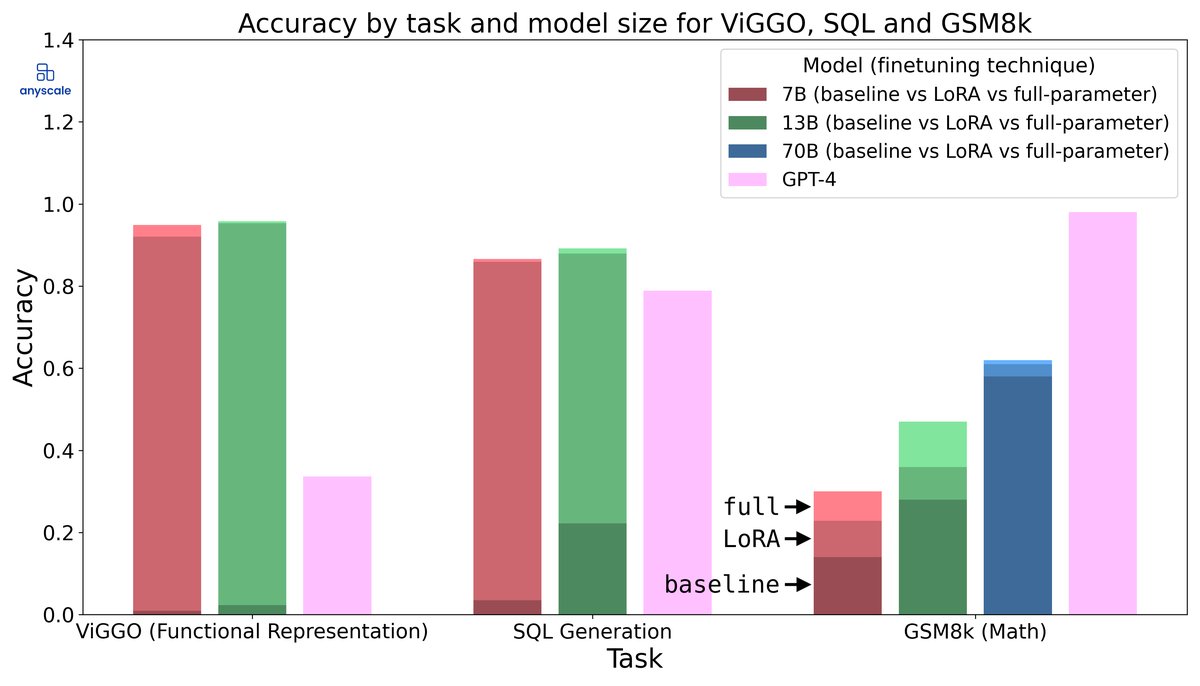

- Оптимизируйте процесс донастройки: Такие методы, как квантование, LoRA (Low-Rank Adaptation) и другие эффективные по параметрам методы донастройки, могут значительно снизить требования к памяти и время обучения.

- Выберите правильного облачного провайдера: Специализированные облачные провайдеры GPU часто предлагают значительно более низкие цены, чем традиционные облачные провайдеры, такие как AWS, Azure и GCP.

- Используйте спотовые/прерываемые экземпляры: Они предлагают существенные скидки, но сопряжены с риском прерывания. Однако для донастройки контрольные точки могут смягчить этот риск.

- Отслеживайте и оптимизируйте использование ресурсов: Постоянно отслеживайте использование GPU, использование памяти и пропускную способность сети для выявления и устранения узких мест.

Рекомендации по GPU для донастройки LLM

GPU высокого класса (для больших моделей и сложных задач)

- NVIDIA A100: Рабочая лошадка для обучения и донастройки LLM. Предлагает отличную производительность и объем памяти (40 ГБ или 80 ГБ).

- NVIDIA H100: Последнее поколение, предлагающее еще более высокую производительность, чем A100, но и более дорогое.

GPU среднего класса (для небольших моделей и умеренных задач)

- NVIDIA RTX 3090: Мощный потребительский GPU с 24 ГБ VRAM, что делает его подходящим для донастройки небольших LLM или использования LoRA на более крупных моделях.

- NVIDIA RTX 4090: Еще более мощный, чем 3090, с аналогичным VRAM и часто лучшим соотношением цены и производительности.

- NVIDIA A40: Предлагает аналогичную производительность RTX 3090, но с более надежной конструкцией серверного класса.

Бюджетные GPU (для экспериментов и мелкомасштабной донастройки)

- NVIDIA RTX 3060: Хороший вариант начального уровня с 12 ГБ VRAM, подходящий для экспериментов с небольшими моделями или использования таких методов, как квантование.

Методы оптимизации затрат

Эффективная по параметрам донастройка (PEFT)

Методы PEFT, такие как LoRA, адаптируют предварительно обученную LLM к конкретной задаче, обучая только небольшое количество параметров. Это значительно снижает требования к памяти и время обучения.

Квантование

Квантование снижает точность весов модели, уменьшая объем памяти и ускоряя вычисления. Такие методы, как 8-битное или 4-битное квантование, можно использовать с минимальным влиянием на производительность.

Обучение со смешанной точностью

Использование обучения со смешанной точностью (например, с использованием bfloat16 или float16) может значительно ускорить обучение и снизить использование памяти по сравнению с полной точностью (float32).

Оптимизация данных

Убедитесь, что ваш набор данных эффективно загружается и обрабатывается. Используйте оптимизированные загрузчики данных и рассмотрите такие методы, как сегментирование данных, чтобы распределить данные по нескольким GPU.

Накопление градиента

Если у вас ограничено памяти GPU, используйте накопление градиента для имитации больших размеров пакетов. Это может улучшить стабильность и производительность обучения.

Рекомендации по облачным провайдерам

RunPod

RunPod предлагает широкий спектр GPU по конкурентоспособным ценам. Они специализируются на предоставлении экземпляров GPU по запросу и позволяют арендовать напрямую у членов сообщества, что часто приводит к снижению цен. Предлагает как экземпляры по запросу, так и спотовые экземпляры.

Цены (пример): RTX 3090 от ~$0,50/час, A100 от ~$3/час

Vast.ai

Vast.ai — еще один отличный вариант для поиска доступных экземпляров GPU. Они агрегируют ресурсы GPU от различных провайдеров и предлагают спотовые экземпляры по очень конкурентоспособным ценам. Известен своим механизмом обнаружения цен, который может привести к чрезвычайно низким ценам.

Цены (пример): RTX 3090 от ~$0,30/час, A100 от ~$2,50/час (спотовые цены колеблются)

Lambda Labs

Lambda Labs предоставляет выделенные GPU-серверы и облачные экземпляры, ориентируясь на рабочие нагрузки глубокого обучения. Они предлагают предварительно настроенные среды и отличную поддержку фреймворков машинного обучения. Дороже, чем RunPod или Vast.ai, но предлагает управляемые решения.

Цены (пример): A100 от ~$4/час (выделенный экземпляр)

Vultr

Vultr предлагает более традиционный облачный опыт, но начал предлагать экземпляры GPU. Их цены могут быть конкурентоспособными, особенно для долгосрочных обязательств. Хороший вариант, если вы предпочитаете более устоявшегося облачного провайдера.

Цены (пример): A100 от ~$3,50/час

Сравнительная таблица

| Провайдер | Цена GPU (A100) (прибл.) | Спотовые экземпляры | Простота использования | Лучше всего подходит для |

|---|---|---|---|---|

| RunPod | $3/час | Да | Умеренная | Пользователи, заботящиеся о стоимости, аренда у сообщества |

| Vast.ai | $2.50/час (спот) | Да (только спот) | Умеренная (требуются некоторые технические знания) | Самые низкие цены, гибкие конфигурации |

| Lambda Labs | $4/час | Нет | Легко (управляемые решения) | Управляемые среды, выделенные серверы |

| Vultr | $3.50/час | Нет | Легко (традиционное облако) | Привычная облачная среда, долгосрочные обязательства |

Распространенные ошибки, которых следует избегать

- Недооценка необходимого объема памяти GPU: Тщательно оцените требования к памяти вашей модели и набора данных перед выбором GPU.

- Игнорирование затрат на передачу данных: Передача больших наборов данных может быть дорогостоящей. Рассмотрите возможность хранения ваших данных рядом с экземпляром GPU.

- Неиспользование спотовых экземпляров: Спотовые экземпляры могут сэкономить вам много денег, но будьте готовы к перебоям. Внедрите контрольные точки, чтобы смягчить этот риск.

- Неспособность отслеживать использование ресурсов: Постоянно отслеживайте использование GPU, использование памяти и пропускную способность сети для выявления и устранения узких мест.

- Игнорирование настройки программного обеспечения: Убедитесь, что ваша среда правильно настроена с необходимыми драйверами, библиотеками и фреймворками. Используйте готовые образы Docker, когда это возможно.

Реальные примеры использования

Донастройка Stable Diffusion

Донастройка Stable Diffusion для определенных стилей или объектов может быть выполнена по доступной цене с использованием GPU RTX 3090 или RTX 4090 на RunPod или Vast.ai. LoRA — популярный метод снижения требований к памяти.

Вывод LLM

Хотя это руководство посвящено донастройке, те же принципы применимы к развертыванию LLM для вывода. Использование квантованных моделей и эффективных механизмов вывода может значительно снизить затраты.

Обучение модели

Обучение LLM с нуля, как правило, дороже, чем донастройка, но применяются те же методы оптимизации затрат. Рассмотрите возможность использования нескольких GPU параллельно для ускорения обучения.