Централизованное логирование для DevOps: ELK Stack на VPS с оптимизацией ресурсов (Актуально на 2026 год)

TL;DR

- В 2026 году централизованное логирование на основе ELK Stack остается критически важным для DevOps, обеспечивая прозрачность и оперативное реагирование в распределенных системах.

- Развертывание ELK на VPS требует тщательной оптимизации ресурсов для достижения стабильной производительности и минимизации затрат, особенно при работе с большими объемами данных.

- Ключевые аспекты оптимизации включают грамотное выделение JVM-памяти для Elasticsearch и Logstash, настройку индексов (ILM, data streams), а также эффективное использование Beats для сбора логов.

- Выбор подходящего VPS-провайдера и конфигурации (CPU, RAM, NVMe SSD) критичен для производительности, при этом стоит учитывать скрытые расходы и возможности масштабирования.

- Внедрение практик безопасности (TLS, аутентификация) и регулярный мониторинг состояния ELK Stack — не опция, а необходимость для поддержания надежности системы.

- Несмотря на появление новых инструментов, ELK сохраняет свою актуальность благодаря гибкости, мощным возможностям анализа и развитому комьюнити, особенно для команд, ищущих баланс между контролем и стоимостью.

- Эта статья предоставляет пошаговый гайд, практические советы, расчеты и рекомендации для успешного внедрения и оптимизации ELK на VPS.

Введение

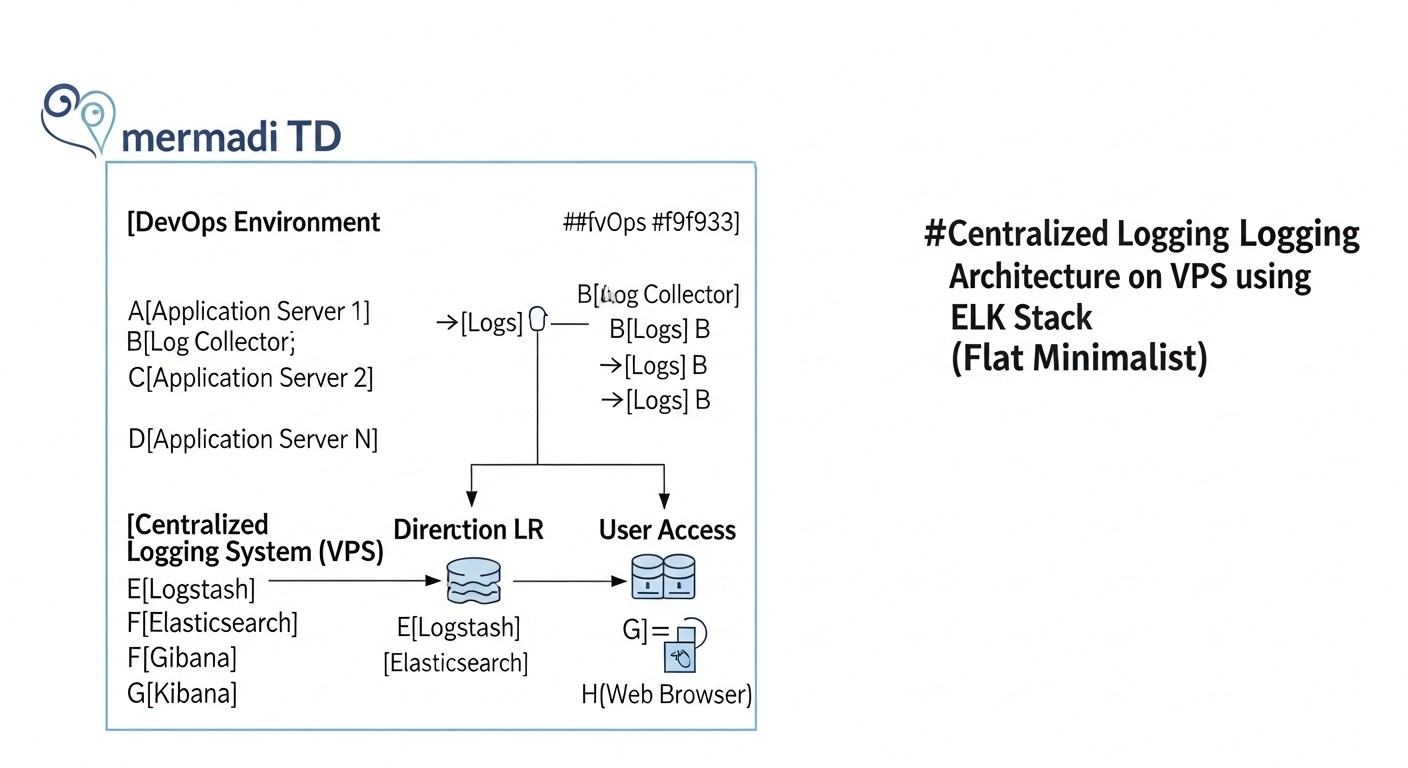

В мире DevOps 2026 года, где микросервисы, контейнеризация и бессерверные архитектуры доминируют, способность быстро понимать, что происходит в вашей распределенной системе, уже не просто преимущество, а абсолютная необходимость. Приложения становятся всё сложнее, а их компоненты разбросаны по множеству серверов, контейнеров и облачных функций. Ручной просмотр логов на каждом узле — это не только неэффективно, но и практически невозможно, особенно когда речь идет о сотнях или тысячах событий в секунду.

Именно здесь на сцену выходит централизованное логирование. Оно позволяет собирать все логи из различных источников в единое хранилище, индексировать их, анализировать и визуализировать в реальном времени. Это дает командам DevOps, разработчикам и системным администраторам беспрецедентную прозрачность, ускоряет процесс отладки, помогает выявлять аномалии и принимать обоснованные решения для оптимизации производительности и безопасности.

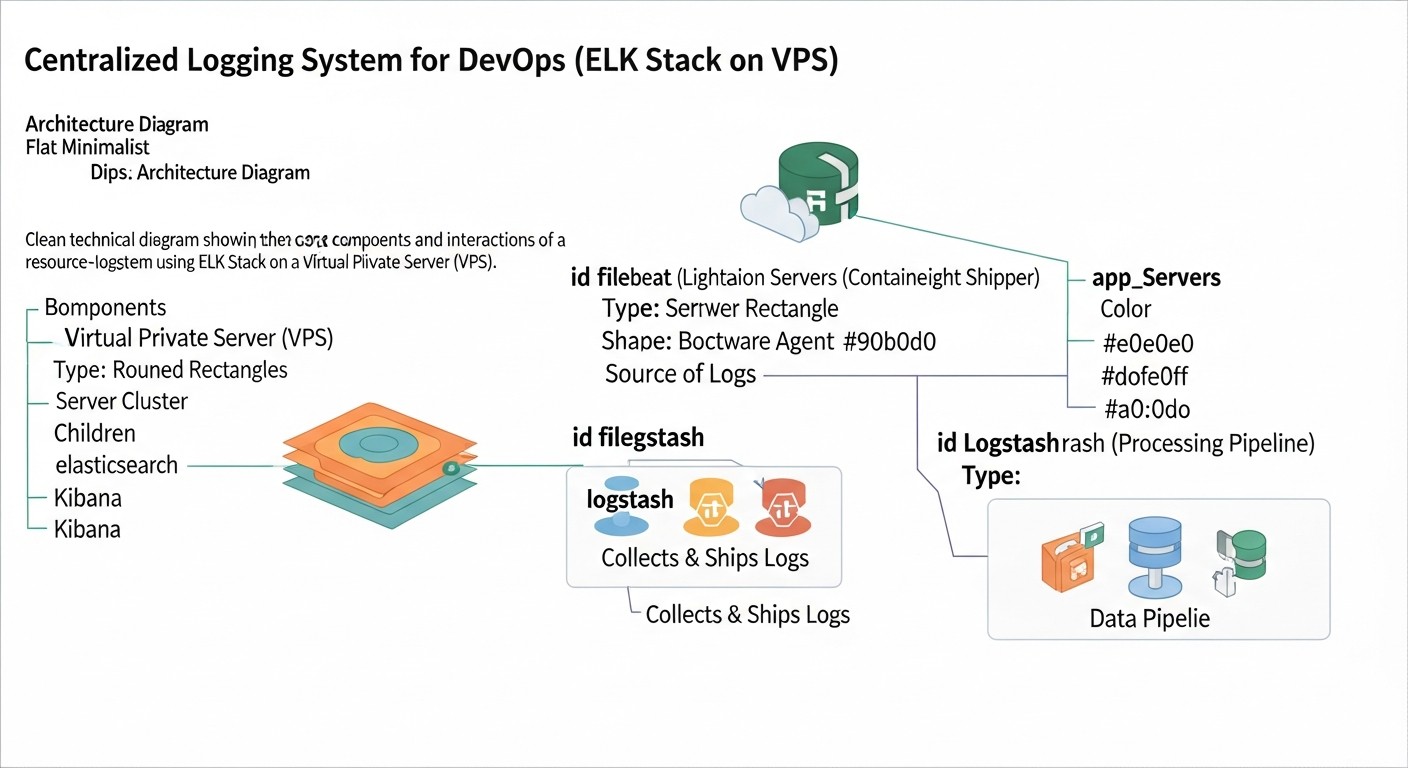

Среди множества доступных решений, ELK Stack (Elasticsearch, Logstash, Kibana) остается одним из наиболее популярных и мощных инструментов для этих целей. Его гибкость, открытость и обширное сообщество сделали его де-факто стандартом для многих компаний, от стартапов до крупных предприятий. Однако, развертывание ELK на виртуальном приватном сервере (VPS) сопряжено с определенными вызовами, главным из которых является оптимизация ресурсов. VPS, по своей природе, предлагает ограниченные ресурсы по сравнению с выделенными серверами или крупными облачными инстансами, и ELK, будучи достаточно ресурсоёмким стеком, требует тонкой настройки для эффективной работы в таких условиях.

Эта статья предназначена для DevOps-инженеров, Backend-разработчиков, фаундеров SaaS-проектов, системных администраторов и технических директоров стартапов, которые стремятся построить надежную и экономичную систему централизованного логирования. Мы не будем заниматься маркетинговым буллшитом. Вместо этого, мы углубимся в практические аспекты развертывания, настройки и, что самое важное, оптимизации ELK Stack на VPS, чтобы вы могли извлечь максимум пользы из своих ограниченных ресурсов. Мы рассмотрим актуальные тенденции 2026 года, дадим конкретные примеры, команды и расчеты, основанные на реальном опыте, чтобы каждый совет можно было немедленно применить на практике.

Основные проблемы, которые решает эта статья:

- Сложность развертывания: Предоставляет пошаговые инструкции для установки и базовой настройки ELK на VPS.

- Высокое потребление ресурсов: Детально описывает методы оптимизации для каждого компонента стека.

- Отсутствие понимания стоимости: Предлагает реалистичные расчеты и стратегии снижения затрат.

- Проблемы масштабирования: Обсуждает подходы к масштабированию ELK в условиях VPS.

- Безопасность: Подчеркивает важность и предлагает базовые шаги по защите данных.

- Нехватка практических советов: Включает реальные кейсы, типичные ошибки и их решения.

К концу статьи вы будете обладать глубоким пониманием того, как эффективно использовать ELK Stack для централизованного логирования на VPS, превращая хаотичный поток логов в ценный источник информации для принятия решений.

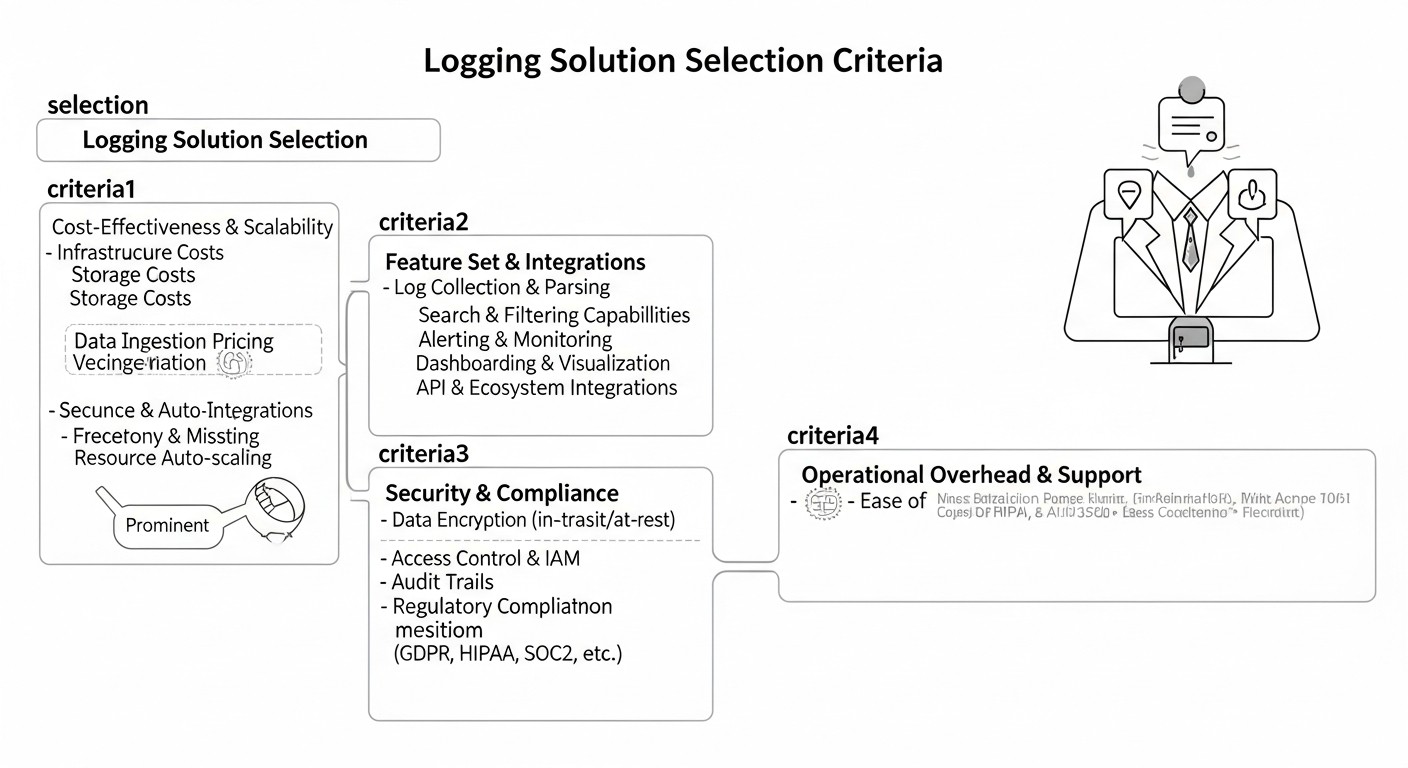

Основные критерии и факторы выбора решения для логирования

Выбор и развертывание системы централизованного логирования — это инвестиция, которая должна окупаться повышением операционной эффективности и сокращением времени на устранение инцидентов. В 2026 году, когда объемы данных продолжают расти, а требования к скорости реакции становятся все строже, особенно важно учитывать ряд ключевых критериев при выборе и настройке вашего решения. Эти факторы напрямую влияют на производительность, стоимость, безопасность и удобство использования системы.

1. Масштабируемость (Scalability)

Почему важен: Ваша система логирования должна расти вместе с вашим приложением. Если сегодня вы обрабатываете 100 логов в секунду, завтра это могут быть 1000 или 10 000. Решение, которое не может масштабироваться горизонтально или вертикально, быстро станет узким местом. На VPS это означает, что вы должны иметь возможность легко расширять ресурсы (CPU, RAM, диск) или, в идеале, распределять нагрузку между несколькими VPS.

Как оценивать:

- Горизонтальное масштабирование: Насколько легко можно добавить новые узлы (Elasticsearch, Logstash, Kibana) для распределения нагрузки? ELK Stack хорошо поддерживает это, но для VPS это означает дополнительные затраты на новые VPS.

- Вертикальное масштабирование: Насколько хорошо решение использует дополнительные ресурсы на одном VPS? (Например, Elasticsearch хорошо масштабируется вертикально, но до определенного предела).

- Производительность при росте данных: Как система ведет себя при увеличении объема входящих логов и количества запросов?

2. Производительность (Performance)

Почему важен: Логи должны собираться, индексироваться и быть доступными для поиска практически в реальном времени. Задержки в несколько минут могут быть критичными для обнаружения и устранения проблем. Медленный поиск или визуализация утомляет пользователей и снижает ценность системы.

Как оценивать:

- Скорость ингестации: Количество логов, которые система может обработать в секунду.

- Скорость поиска: Время, необходимое для выполнения запросов и получения результатов.

- Скорость визуализации: Время загрузки дашбордов и графиков в Kibana.

- Использование ресурсов: Насколько эффективно решение использует CPU, RAM, I/O диска при пиковых нагрузках? Для VPS это особенно важно, так как ресурсы ограничены.

3. Стоимость (Cost)

Почему важен: Для стартапов и SaaS-проектов, работающих на VPS, бюджет — это король. Стоимость включает не только прямые затраты на VPS, но и лицензии (если применимо), время инженеров на настройку и поддержку, а также потенциальные скрытые расходы (трафик, резервное копирование). ELK Stack, будучи open-source, экономичен в плане лицензий, но требует значительных инвестиций в инфраструктуру и время инженеров.

Как оценивать:

- Прямые затраты на инфраструктуру: Ежемесячная стоимость VPS (CPU, RAM, Storage, Network).

- Лицензионные сборы: Для ELK это может быть Elastic Cloud или расширенные коммерческие функции X-Pack. Для VPS обычно используется бесплатная версия.

- Эксплуатационные расходы: Время инженеров на развертывание, настройку, мониторинг, обслуживание, обновление.

- Скрытые расходы: Стоимость трафика, резервного копирования, инструментов мониторинга.

4. Удобство использования и управления (Ease of Use & Management)

Почему важен: Даже самое мощное решение бесполезно, если его трудно настроить, использовать или поддерживать. Интуитивно понятный интерфейс, хорошая документация и простота управления сокращают кривую обучения и повышают продуктивность команды.

Как оценивать:

- Простота установки и настройки: Насколько быстро можно поднять базовую систему?

- Интерфейс: Насколько интуитивно понятен интерфейс для поиска, анализа и визуализации логов (Kibana)?

- Документация и сообщество: Наличие качественной документации и активного сообщества для получения поддержки.

- Возможности автоматизации: Поддержка инфраструктуры как кода (IaC) для развертывания и управления.

5. Безопасность (Security)

Почему важен: Логи часто содержат чувствительную информацию: IP-адреса, пользовательские данные, ошибки с трассировкой стека, которые могут раскрыть детали архитектуры. Недостаточная безопасность системы логирования может привести к утечкам данных и нарушениям комплаенса.

Как оценивать:

- Аутентификация и авторизация: Поддержка ролевого доступа, интеграция с LDAP/AD.

- Шифрование: Поддержка TLS/SSL для передачи данных между компонентами и клиентами.

- Контроль доступа к данным: Возможность гранулярного контроля доступа к индексам и документам.

- Аудит: Ведение журнала действий пользователей и изменений конфигурации.

6. Гибкость и расширяемость (Flexibility & Extensibility)

Почему важен: Каждое приложение уникально. Система логирования должна быть достаточно гибкой, чтобы адаптироваться к вашим специфическим форматам логов, источникам данных и потребностям анализа. Возможность интеграции с другими инструментами (мониторинг, оповещения) также очень важна.

Как оценивать:

- Поддержка различных форматов логов: JSON, Syslog, Apache, Nginx, произвольный текст.

- Плагины и коннекторы: Наличие плагинов для Logstash, Beats для различных источников данных.

- API: Наличие мощного API для программного взаимодействия с данными.

- Интеграция: Возможность интеграции с системами оповещения (Slack, PagerDuty), мониторинга (Prometheus, Grafana).

7. Сохранение данных и управление жизненным циклом (Data Retention & Lifecycle Management)

Почему важен: Хранение логов бесконечно дорого и не всегда нужно. Необходимо определить политику хранения данных (например, 7 дней горячих логов, 30 дней теплых, 90 дней холодных) и иметь механизм для автоматического перемещения или удаления старых данных. Для VPS это критично, так как место на диске ограничено.

Как оценивать:

- Политики индексирования: Поддержка Index Lifecycle Management (ILM) или аналогичных механизмов.

- Управление хранилищем: Возможность использовать различные типы хранилищ (горячее/холодное) или автоматически удалять старые индексы.

- Снапшоты и резервное копирование: Наличие встроенных механизмов для создания резервных копий.

8. Мониторинг и оповещения (Monitoring & Alerting)

Почему важен: Система логирования сама по себе является критически важной частью инфраструктуры. Ее состояние необходимо мониторить, а также настраивать оповещения о критических событиях, обнаруженных в логах. Это могут быть ошибки, аномалии или превышение пороговых значений.

Как оценивать:

- Встроенный мониторинг: Наличие инструментов для мониторинга состояния самого ELK Stack.

- Гибкость оповещений: Возможность создавать сложные правила оповещений на основе данных логов и отправлять их в различные системы уведомлений.

- Интеграция с другими системами мониторинга: Открытые API для экспорта метрик состояния ELK.

Учитывая эти критерии, вы сможете принять обоснованное решение о том, как лучше всего построить вашу систему централизованного логирования, особенно в условиях ограниченных ресурсов VPS.

Сравнительная таблица решений для логирования (Актуально на 2026 год)

В 2026 году рынок решений для централизованного логирования предлагает широкий спектр инструментов, каждый со своими сильными и слабыми сторонами. Для DevOps-инженеров и фаундеров SaaS-проектов, которые часто оперируют на VPS с ограниченным бюджетом, выбор оптимального стека становится критически важным. Ниже представлена сравнительная таблица наиболее популярных решений, с фокусом на их применимость в условиях VPS и актуальные характеристики.

| Критерий | ELK Stack (Open Source) | Loki + Grafana | Splunk Free/Light | CloudWatch Logs (AWS) | Elastic Cloud (Managed ELK) |

|---|---|---|---|---|---|

| Архитектура | Распределенная (Elasticsearch, Logstash, Kibana, Beats). Требует администрирования. | Централизованный Loki (хранит только метаданные) + Grafana. Проще в администрировании. | Монолитная/Распределенная (индексы, форвардеры). Проприетарная. | Полностью управляемая облачная служба AWS. | Полностью управляемая SaaS-платформа Elastic. |

| Тип данных | Структурированные и неструктурированные логи, метрики, APM, Security. | Неструктурированные логи (как текст), метрики. | Структурированные и неструктурированные логи, метрики. | Логи, метрики AWS. | Структурированные и неструктурированные логи, метрики, APM, Security. |

| Модель развертывания на VPS | Да, возможно. Требует значительной оптимизации ресурсов и ручного управления. | Да, гораздо менее ресурсоёмко, чем ELK. Проще в развертывании на одном VPS. | Ограничено (бесплатная версия до 500 МБ/день). Сложно на VPS. | Нет, только в облаке AWS. | Нет, это SaaS. |

| Оптимизация ресурсов на VPS | Высокая потребность в RAM и CPU, особенно для Elasticsearch. Требует глубокой настройки JVM, ILM, shard-ов. | Низкая потребность в RAM и CPU, так как Loki индексирует только метаданные и использует объектное хранилище (S3-совместимое). | Высокая потребность, нецелесообразно для бесплатных версий на VPS. | Не применимо (управляется AWS). | Не применимо (управляется Elastic). |

| Стоимость (ориентировочно 2026, на VPS) | $20-100/мес за VPS (8-16GB RAM, 4-8 vCPU, 200-500GB NVMe). Зависит от объема логов. | $10-50/мес за VPS (4-8GB RAM, 2-4 vCPU, 100-200GB NVMe) + стоимость S3-хранилища (несколько $). | Бесплатно до 500 МБ/день. Enterprise от $1000+/мес. Не для VPS. | Зависит от объема логов и запросов. Например, $30-150/мес за 100GB логов/мес. | От $70/мес за базовый кластер (8GB RAM, 2 vCPU) до тысяч. |

| Скорость ингестации (гипотетически) | Высокая (десятки тысяч событий/сек при правильной настройке). | Очень высокая (десятки-сотни тысяч событий/сек, так как индексируются только метки). | Высокая (при наличии ресурсов). | Высокая. | Очень высокая. |

| Скорость поиска | Очень высокая для структурированных данных. Полнотекстовый поиск. | Быстрый поиск по меткам. Поиск по содержимому логов медленнее. | Очень высокая, мощный язык SPL. | Хорошая для простых запросов, медленнее для сложных. | Очень высокая. |

| Визуализация/Аналитика | Kibana: мощные дашборды, графики, discover, APM, Security. | Grafana: гибкие дашборды, метрики, трейсы, логи. | Splunk UI: очень мощный, но сложный в освоении. | CloudWatch Dashboards: базовые, но достаточные для мониторинга AWS. | Kibana: полная функциональность. |

| Управление жизненным циклом (ILM) | Да, встроенный ILM для автоматического управления индексами (горячие/теплые/холодные/удаление). | Управляется S3-политиками и конфигурацией Loki. | Да. | Настраиваемые политики хранения. | Да, полноценный ILM. |

| Безопасность | Базовая (X-Pack Security) - аутентификация, авторизация, TLS. Расширенные функции платные. | Аутентификация Grafana, TLS, интеграция с IAM для S3. | Встроенная, очень мощная. | Интеграция с AWS IAM, KMS. | Полная безопасность X-Pack. |

| Кривая обучения | Средняя/Высокая (установка, настройка всех компонентов, оптимизация). | Низкая/Средняя (проще в установке, Grafana знакома многим). | Высокая (язык SPL, концепции). | Низкая (для базового использования). | Низкая (для использования, но не для администрирования). |

| Для кого подходит (на VPS) | Команды, которым нужна глубокая аналитика, полнотекстовый поиск, гибкость и полный контроль над данными, готовые инвестировать время в администрирование. | Команды, которым нужен простой, легкий и экономичный способ централизовать логи для отладки и базового мониторинга, уже использующие Grafana. | Крупные предприятия с большим бюджетом, не для VPS-развертывания. | Команды, чья инфраструктура полностью находится в AWS и которым не нужен глубокий анализ логов за пределами AWS-метрик. | Команды, которым нужна вся мощь ELK, но без головной боли администрирования, готовые платить за удобство. |

Выводы из таблицы:

- ELK Stack (Open Source) остается мощным и гибким выбором для тех, кто готов инвестировать в его администрирование и оптимизацию. На VPS это требует особого внимания к ресурсам.

- Loki + Grafana выходит на передний план как более легкая и экономичная альтернатива для VPS, особенно если основная задача — быстрый просмотр логов и их сопоставление с метриками, а не глубокая полнотекстовая аналитика. Его модель хранения (индексирование только метаданных) значительно снижает требования к RAM и CPU на сервере.

- Splunk и CloudWatch Logs — это решения для других масштабов и экосистем, неоптимальные для самостоятельного развертывания на VPS.

- Elastic Cloud — отличный вариант для тех, кто хочет ELK без администрирования, но цена значительно выше, чем самостоятельное развертывание на VPS.

Для целей данной статьи мы сосредоточимся на ELK Stack (Open Source) как на наиболее гибком и контролируемом варианте для развертывания на VPS, с акцентом на то, как сделать его эффективным даже с ограниченными ресурсами.

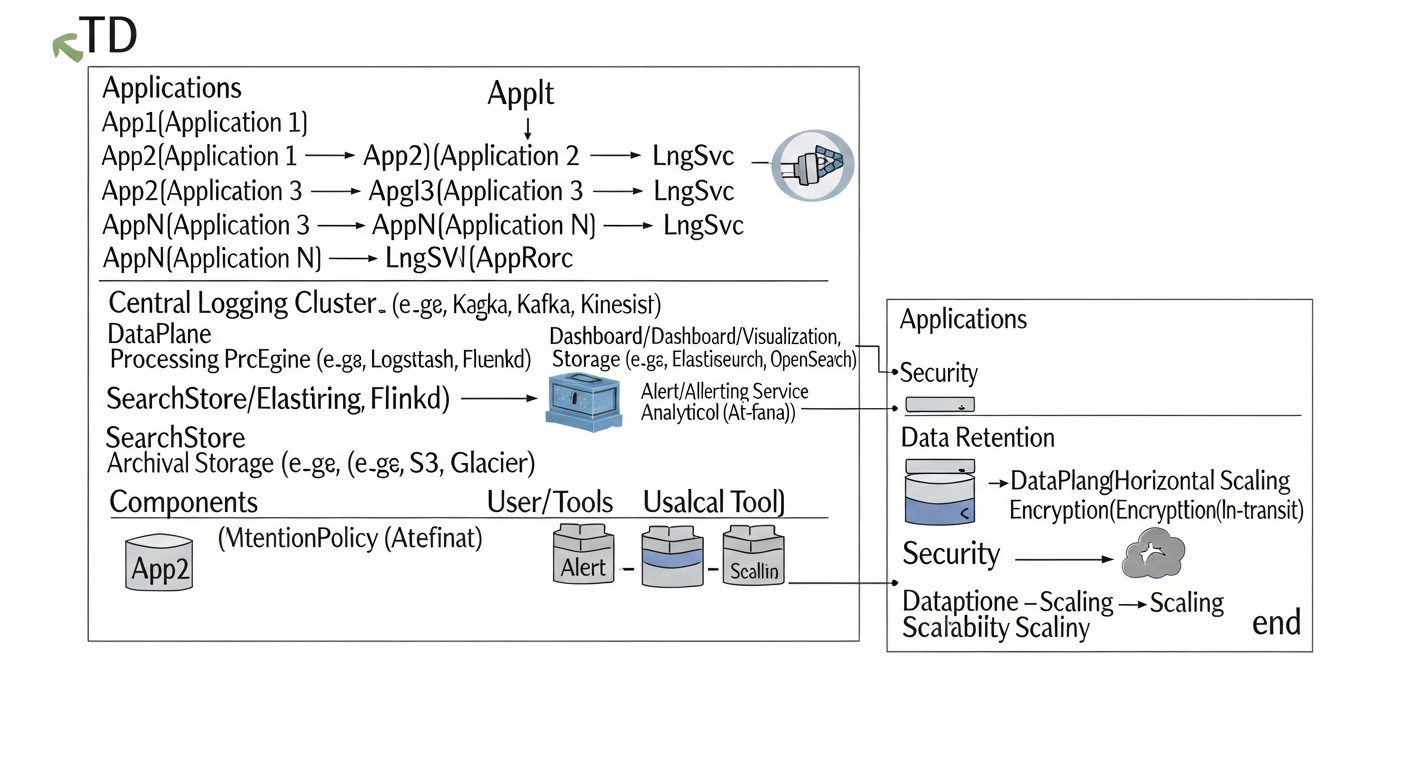

Детальный обзор компонентов ELK Stack и альтернатив

ELK Stack — это аббревиатура, обозначающая три ключевых компонента: Elasticsearch, Logstash и Kibana. В современной интерпретации к ним часто добавляют Beats — семейство легковесных агентов для сбора данных. Давайте рассмотрим каждый из них подробнее, а также коснемся основных альтернатив, которые были упомянуты в сравнительной таблице.

1. Elasticsearch: Сердце хранилища и поиска

Elasticsearch — это распределенная, RESTful поисковая и аналитическая система, построенная на базе Apache Lucene. Это движок, который хранит все ваши логи, индексирует их и обеспечивает молниеносный поиск и агрегацию данных. Для DevOps-инженера это означает возможность быстро находить нужные события среди миллиардов записей.

- Плюсы:

- Скорость: Почти реальное время для индексации и поиска.

- Масштабируемость: Горизонтальное масштабирование путем добавления новых узлов в кластер.

- Гибкость: Поддержка структурированных и неструктурированных данных, мощный язык запросов (DSL).

- Агрегации: Возможность выполнять сложные аналитические запросы, строить графики и дашборды.

- Экосистема: Богатая экосистема плагинов и интеграций.

- Минусы:

- Ресурсоёмкость: Требует много RAM и CPU, особенно для индексации и интенсивных запросов. JVM-процесс может потреблять гигабайты памяти.

- Сложность управления: Управление кластером, шардами, репликами и индексами требует определенных знаний.

- Чувствительность к конфигурации: Неправильные настройки могут привести к нестабильности или потере данных.

- Для кого подходит: Для проектов, которым нужен мощный полнотекстовый поиск, сложная аналитика и высокая скорость обработки данных. Это идеальный выбор, если вы готовы вкладывать время в оптимизацию и администрирование.

- Примеры использования на VPS:

- Хранение и поиск логов веб-серверов (Nginx, Apache), приложений (Python, Node.js, Go), баз данных.

- Анализ безопасности (SIEM-подобные функции для небольших команд).

- Сбор метрик и их хранение для последующего анализа.

Оптимизация для VPS: Ключевой аспект — это управление памятью JVM. Рекомендуется выделять до 50% доступной RAM на VPS, но не более 30.5 GB, чтобы избежать сжатых указателей. Также важна настройка ILM (Index Lifecycle Management) для автоматического удаления старых индексов и использования data streams для эффективного управления данными.

2. Logstash: Конвейер обработки данных

Logstash — это мощный, гибкий и открытый конвейер для сбора, обработки и пересылки данных (ETL). Он может принимать данные из различных источников, трансформировать их (парсинг, обогащение, фильтрация) и отправлять в различные назначения, чаще всего в Elasticsearch.

- Плюсы:

- Гибкость источников/назначений: Поддерживает огромное количество input (file, http, beats, kafka, redis) и output (elasticsearch, s3, email).

- Мощная обработка: Фильтры (grok, mutate, date, geoip) позволяют парсить сложные логи, добавлять контекст, нормализовать данные.

- Устойчивость: Поддержка persistent queues и dead-letter queues для предотвращения потери данных.

- Минусы:

- Ресурсоёмкость: Logstash, особенно с большим количеством сложных фильтров Grok, может потреблять значительные ресурсы CPU и RAM.

- Сложность конфигурации: Написание эффективных и отказоустойчивых конфигураций может быть сложным.

- Производительность: Медленнее, чем Beats, для прямого сбора логов.

- Для кого подходит: Для задач, где требуется сложная обработка данных перед индексацией, агрегация из нескольких источников или обогащение логов.

- Примеры использования на VPS:

- Парсинг неструктурированных текстовых логов в структурированный JSON.

- Обогащение логов IP-адресами (геолокация) или данными из других источников.

- Агрегация логов из Kafka или Redis перед отправкой в Elasticsearch.

Оптимизация для VPS: Используйте Beats для прямого сбора логов, а Logstash только для сложных трансформаций. Оптимизируйте Grok-паттерны (делайте их максимально точными). Настройте количество pipeline workers и batch size. Уменьшите размер JVM heap для Logstash, если он не выполняет очень интенсивные трансформации.

3. Kibana: Интерфейс для визуализации и анализа

Kibana — это мощный инструмент для визуализации и исследования данных, хранящихся в Elasticsearch. Она предоставляет интуитивно понятный веб-интерфейс для создания дашбордов, графиков, таблиц и интерактивных отчетов, позволяя пользователям быстро анализировать логи и метрики.

- Плюсы:

- Визуализация: Широкий набор типов визуализаций (гистограммы, круговые диаграммы, карты, таблиц).

- Дашборды: Возможность создавать интерактивные дашборды из различных визуализаций.

- Discover: Мощный интерфейс для поиска и фильтрации сырых логов.

- Модули: Встроенные модули для APM, Security, Observability.

- Минусы:

- Ресурсоёмкость: Может быть требовательна к RAM и CPU при построении сложных дашбордов с большим количеством данных.

- Зависимость от Elasticsearch: Без работающего Elasticsearch Kibana бесполезна.

- Кривая обучения: Создание сложных визуализаций требует некоторого освоения.

- Для кого подходит: Для всех, кто хочет получить наглядное представление о своих данных, создавать отчеты и мониторить состояние системы.

- Примеры использования на VPS:

- Мониторинг ошибок и предупреждений в реальном времени.

- Анализ трафика веб-сервера.

- Отслеживание производительности приложения.

Оптимизация для VPS: Разместите Kibana на том же VPS, что и Elasticsearch, чтобы минимизировать сетевые задержки. Используйте Nginx или Caddy в качестве обратного прокси для кэширования статических файлов и добавления SSL. Ограничьте количество одновременно открытых дашбордов и сложных визуализаций.

4. Beats: Легковесные агенты сбора данных

Beats — это семейство легковесных, одноцелевых агентов, которые устанавливаются на ваши серверы для сбора различных типов данных (логи, метрики, сетевой трафик, данные безопасности) и их пересылки в Elasticsearch или Logstash. Filebeat для логов и Metricbeat для метрик — наиболее часто используемые.

- Плюсы:

- Легковесность: Низкое потребление ресурсов, что делает их идеальными для установки на производственные серверы.

- Надежность: Гарантированная доставка данных, устойчивость к сетевым сбоям.

- Модульность: Специализированные Beats для разных типов данных и источников (Filebeat, Metricbeat, Packetbeat, Heartbeat, Auditbeat, Winlogbeat).

- Простота настройки: Конфигурация в YAML-файлах, готовые модули для популярных сервисов.

- Минусы:

- Ограниченная обработка: Beats выполняют базовую обработку (например, парсинг JSON), но не подходят для сложных трансформаций, как Logstash.

- Множество агентов: Для разных типов данных требуются разные Beats, что может усложнить управление на большом количестве серверов.

- Для кого подходит: Для всех, кто хочет эффективно и надежно собирать данные с множества серверов и контейнеров с минимальным потреблением ресурсов.

- Примеры использования на VPS:

- Filebeat для сбора логов Nginx, Docker-контейнеров, системных логов.

- Metricbeat для сбора метрик CPU, RAM, диска, сети, а также метрик сервисов (MySQL, Redis, Docker).

Оптимизация для VPS: Используйте Beats вместо Logstash на источниках логов, если не требуется сложная обработка. Настраивайте `scan_frequency` и `harvester_buffer_size` для баланса между актуальностью и потреблением ресурсов. Ограничивайте количество собираемых метрик и логов, чтобы не перегружать систему.

5. Альтернативы: Loki + Grafana

Как уже отмечалось в таблице, Loki от Grafana Labs является серьезным конкурентом ELK, особенно для сценариев с ограниченными ресурсами и фокусом на логи в контексте метрик.

- Плюсы:

- Ресурсоэффективность: Loki индексирует только метки логов, а не их содержимое, что делает его чрезвычайно легким. Логи хранятся в объектном хранилище (S3, GCS) или на локальном диске.

- Интеграция с Grafana: Идеально подходит для команд, которые уже используют Grafana для мониторинга метрик. Логи и метрики легко сопоставляются.

- Простота: Проще в развертывании и управлении, чем ELK.

- Язык запросов LogQL: Похож на PromQL, что облегчает освоение для тех, кто уже знаком с Prometheus.

- Минусы:

- Ограниченный полнотекстовый поиск: Поиск по содержимому логов менее эффективен, чем в Elasticsearch, и требует сканирования больших объемов данных.

- Менее мощная аналитика: Loki не предназначен для выполнения сложных агрегаций и аналитических запросов, как Elasticsearch.

- Меньшая экосистема: Сообщество и набор интеграций меньше, чем у ELK.

- Для кого подходит: Для команд, которым нужен простой и экономичный способ централизовать логи для отладки и базового мониторинга, особенно если они уже используют Grafana для метрик. Отлично подходит для развертывания на небольших VPS.

- Примеры использования на VPS:

- Сбор логов Docker-контейнеров и Kubernetes кластеров (с Promtail).

- Базовый мониторинг ошибок и предупреждений.

- Сопоставление логов с графиками метрик в Grafana для быстрого устранения неполадок.

Выбор между ELK и Loki+Grafana часто сводится к компромиссу между мощностью аналитики и ресурсоэффективностью. Для глубокого анализа и полнотекстового поиска ELK остается лидером, но для быстрого просмотра логов и бюджетных развертываний Loki становится очень привлекательной альтернативой.

Практические советы и рекомендации по развертыванию ELK на VPS с оптимизацией ресурсов

Развертывание ELK Stack на VPS — это искусство балансирования между функциональностью и доступными ресурсами. Цель — получить максимум пользы при минимальных затратах. Ниже представлены пошаговые инструкции и рекомендации, основанные на опыте работы с ELK в ограниченных условиях.

1. Выбор VPS-провайдера и конфигурации (2026 год)

В 2026 году рынок VPS-провайдеров предлагает широкий выбор. Для ELK критичны следующие параметры:

- RAM: Минимум 8 ГБ для минимально жизнеспособного стека. 16 ГБ и более — рекомендуемый старт для продуктивной среды. Elasticsearch особенно любит память.

- CPU: Минимум 2-4 vCPU. Чем больше ядер, тем лучше для параллельной обработки запросов и индексации.

- Диск: Только NVMe SSD. Обычные SSD или HDD не справятся с интенсивными операциями I/O Elasticsearch. Минимум 200-500 ГБ, в зависимости от объема логов и политики хранения.

- Сеть: Стабильный и быстрый сетевой канал (минимум 1 Гбит/с) без скрытых ограничений по трафику, если вы планируете собирать логи с множества внешних источников.

Рекомендуемые провайдеры (2026): Hetzner Cloud, Vultr, DigitalOcean, OVHcloud. Они предлагают хорошее соотношение цена/производительность для NVMe SSD и достаточного количества RAM.

Пример конфигурации для старта (Hetzner Cloud CX41/CX51):

- 8-16 GB RAM

- 4-8 vCPU

- 200-320 GB NVMe SSD

- Цена: $25 - $50/месяц (ориентировочно 2026)

2. Подготовка VPS к установке ELK

Перед установкой компонентов ELK необходимо настроить операционную систему. Рекомендуется использовать Ubuntu Server 22.04 LTS или 24.04 LTS.

# Обновление системы

sudo apt update && sudo apt upgrade -y

# Установка Java (OpenJDK 17 или новее, актуально для ES 8.x/9.x)

sudo apt install openjdk-17-jdk -y

# Увеличение лимитов файловых дескрипторов и памяти для Elasticsearch

# Добавьте в /etc/sysctl.conf

echo "vm.max_map_count=262144" | sudo tee -a /etc/sysctl.conf

sudo sysctl -p

# Добавьте в /etc/security/limits.conf (для пользователя elasticsearch)

# elasticsearch - nofile 65536

# elasticsearch - memlock unlimited

# (Эти настройки будут применены после создания пользователя elasticsearch и перезагрузки)

# Отключение swap (рекомендуется для Elasticsearch, чтобы избежать деградации производительности)

sudo swapoff -a

sudo sed -i '/ swap / s/^\(.*\)$/#\1/g' /etc/fstab

# Установка пакетов для HTTPS-репозиториев

sudo apt install apt-transport-https ca-certificates curl gnupg lsb-release -y

# Добавление репозитория Elastic

curl -fsSL https://artifacts.elastic.co/GPG-KEY-elasticsearch | sudo gpg --dearmor -o /usr/share/keyrings/elastic.gpg

echo "deb [signed-by=/usr/share/keyrings/elastic.gpg] https://artifacts.elastic.co/packages/8.x/apt stable main" | sudo tee /etc/apt/sources.list.d/elastic-8.x.list

sudo apt update

3. Установка и базовая настройка Elasticsearch

Установка:

sudo apt install elasticsearch -y

Настройка (файл /etc/elasticsearch/elasticsearch.yml):

cluster.name: my-elk-cluster(можно оставить по умолчанию, но лучше задать).node.name: node-1path.data: /var/lib/elasticsearch(убедитесь, что это NVMe диск).path.logs: /var/log/elasticsearchnetwork.host: 0.0.0.0(для доступа извне, осторожно с безопасностью!). Для одного VPS достаточноlocalhostили127.0.0.1.http.port: 9200discovery.type: single-node(критично для одного VPS, чтобы избежать попыток формирования кластера).xpack.security.enabled: true(включает базовую безопасность в 8.x по умолчанию).

Оптимизация JVM Heap Size: Это самый важный параметр для Elasticsearch на VPS. Редактируйте /etc/elasticsearch/jvm.options.

Установите -Xms и -Xmx в одно и то же значение, не более 50% от общей RAM VPS, но не более 30.5 GB. Например, для VPS с 16 ГБ RAM:

-Xms8g

-Xmx8g

Запуск и проверка:

sudo systemctl enable elasticsearch

sudo systemctl start elasticsearch

sudo systemctl status elasticsearch

curl -u elastic:your_password https://localhost:9200 # (пароль генерируется при первом запуске)

При первом запуске Elasticsearch 8.x с xpack.security.enabled: true, он автоматически генерирует пароль для пользователя elastic и другие токены. Вам нужно будет их сохранить.

# После первого запуска (если вы забыли или не записали)

sudo /usr/share/elasticsearch/bin/elasticsearch-reset-password -u elastic

4. Установка и базовая настройка Kibana

Установка:

sudo apt install kibana -y

Настройка (файл /etc/kibana/kibana.yml):

server.port: 5601server.host: "0.0.0.0"(или"localhost", если будете использовать Nginx как прокси).elasticsearch.hosts: ["https://localhost:9200"]elasticsearch.username: "kibana_system"(пользователь, созданный ES для Kibana).elasticsearch.password: "YOUR_KIBANA_SYSTEM_PASSWORD"(получается после настройки ES).server.publicBaseUrl: "https://your_domain.com"(если используете домен и SSL).

При первом запуске Kibana, она попросит вас ввести токен для связи с Elasticsearch. Вы можете сгенерировать его на стороне Elasticsearch:

sudo /usr/share/elasticsearch/bin/elasticsearch-create-enrollment-token -s kibana

Затем используйте этот токен в веб-интерфейсе Kibana при первом входе. После этого Kibana предложит вам сгенерировать токен для kibana_system пользователя.

Запуск и проверка:

sudo systemctl enable kibana

sudo systemctl start kibana

sudo systemctl status kibana

Доступ по http://your_vps_ip:5601 (или https, если настроен). Используйте логин elastic и пароль, полученный от Elasticsearch.

5. Установка и базовая настройка Logstash (опционально, используйте Beats по возможности)

Установка:

sudo apt install logstash -y

Настройка (файл /etc/logstash/logstash.yml):

http.host: "0.0.0.0"path.data: /var/lib/logstashpath.logs: /var/log/logstash

Оптимизация JVM Heap Size: Редактируйте /etc/logstash/jvm.options. Для большинства сценариев на VPS 1-2 ГБ будет достаточно.

-Xms1g

-Xmx1g

Пример простейшей конфигурации Logstash (файл /etc/logstash/conf.d/01-beats-input.conf):

input {

beats {

port => 5044

ssl => true

ssl_certificate_authorities => ["/etc/logstash/certs/ca.crt"] # Путь к вашему CA

ssl_certificate => "/etc/logstash/certs/logstash.crt"

ssl_key => "/etc/logstash/certs/logstash.key"

}

}

filter {

# Пример простого парсинга JSON

if [message] =~ /^{.*}$/ {

json {

source => "message"

target => "json_data"

remove_field => ["message"] # Удаляем исходное сообщение, если оно полностью JSON

}

}

}

output {

elasticsearch {

hosts => ["https://localhost:9200"]

user => "logstash_system" # Пользователь для Logstash, создается в ES

password => "YOUR_LOGSTASH_SYSTEM_PASSWORD"

ssl => true

ssl_certificate_verification => false # В продакшене используйте true и CA для ES

# index => "my-app-logs-%{+YYYY.MM.dd}" # Старый способ

manage_template => false # Используем Data Streams

data_stream_acd => true

}

}

Важно: Для работы с Elasticsearch 8.x и выше, а также для обеспечения безопасности, необходимо настроить SSL/TLS и аутентификацию. Это включает создание сертификатов и пользователей. Используйте logstash_system пользователя для Logstash, пароль для которого генерируется в Elasticsearch.

# Генерация пароля для пользователя logstash_system

sudo /usr/share/elasticsearch/bin/elasticsearch-reset-password -u logstash_system

Запуск и проверка:

sudo systemctl enable logstash

sudo systemctl start logstash

sudo systemctl status logstash

6. Установка и базовая настройка Filebeat (на серверах-источниках логов)

Установка Filebeat на серверах, с которых вы собираете логи (не на VPS с ELK):

# Добавление репозитория Elastic (если еще не сделано)

curl -fsSL https://artifacts.elastic.co/GPG-KEY-elasticsearch | sudo gpg --dearmor -o /usr/share/keyrings/elastic.gpg

echo "deb [signed-by=/usr/share/keyrings/elastic.gpg] https://artifacts.elastic.co/packages/8.x/apt stable main" | sudo tee /etc/apt/sources.list.d/elastic-8.x.list

sudo apt update

# Установка Filebeat

sudo apt install filebeat -y

Настройка (файл /etc/filebeat/filebeat.yml):

- В секции

filebeat.inputsнастройте пути к логам:

filebeat.inputs:

- type: filestream

id: my-app-logs

enabled: true

paths:

- /var/log/my-app/*.log

fields:

service_name: my_application

env: production

processors:

- decode_json_fields:

fields: ["message"]

target: "json"

overwrite_keys: true

max_depth: 10

add_error: true

- add_host_metadata: ~

- add_cloud_metadata: ~ # Если это облачная VM

output.logstash:

hosts: ["your_logstash_vps_ip:5044"]

ssl.enabled: true

ssl.verification_mode: none # В продакшене используйте full и CA

# ssl.certificate_authorities: ["/etc/filebeat/certs/ca.crt"] # Путь к CA, если используете full verification

output.elasticsearch:

hosts: ["https://your_elasticsearch_vps_ip:9200"]

username: "filebeat_writer" # Пользователь для Filebeat, создается в ES

password: "YOUR_FILEBEAT_WRITER_PASSWORD"

ssl.enabled: true

ssl.verification_mode: none # В продакшене используйте full и CA

# ssl.certificate_authorities: ["/etc/filebeat/certs/ca.crt"]

index: "my-app-logs-%{+YYYY.MM.dd}" # Или используйте data_stream

data_stream.namespace: default

# data_stream.type: logs # Для версии 8.x+

# data_stream.dataset: myapp.logs

Важно: Для прямого подключения Filebeat к Elasticsearch 8.x, вам потребуется создать пользователя с соответствующими правами. Например, filebeat_writer с ролью, позволяющей писать в data streams.

# Создание пользователя для Filebeat в Elasticsearch

# Сначала сгенерируйте пароль

sudo /usr/share/elasticsearch/bin/elasticsearch-reset-password -u filebeat_writer

# Затем создайте роль (например, через Kibana Dev Tools):

# PUT /_security/role/filebeat_writer_role

# {

# "cluster": ["monitor"],

# "indices": [

# {

# "names": ["logs-*-*"],

# "privileges": ["write", "create_index", "manage_ilm"]

# }

# ],

# "applications": [],

# "run_as": [],

# "metadata": {},

# "transient_metadata": {}

# }

# Назначьте эту роль пользователю filebeat_writer.

Запуск и проверка:

sudo systemctl enable filebeat

sudo systemctl start filebeat

sudo systemctl status filebeat

7. Оптимизация на уровне системы и сети

- Файловая система: Для Elasticsearch рекомендуется XFS или Ext4. Убедитесь, что диск смонтирован с опциями

noatimeиnodiratimeдля снижения I/O. - Firewall: Настройте UFW или другой фаервол для ограничения доступа к портам 9200 (Elasticsearch), 5601 (Kibana) и 5044 (Logstash/Beats). Разрешите доступ только с доверенных IP-адресов или через VPN.

sudo ufw allow 22/tcp # SSH

sudo ufw allow 5601/tcp # Kibana

sudo ufw allow 9200/tcp # Elasticsearch (только для доверенных)

sudo ufw allow 5044/tcp # Beats/Logstash

sudo ufw enable

# Пример конфигурации Nginx для Kibana

server {

listen 80;

server_name your_domain.com;

return 301 https://$host$request_uri;

}

server {

listen 443 ssl http2;

server_name your_domain.com;

ssl_certificate /etc/letsencrypt/live/your_domain.com/fullchain.pem;

ssl_certificate_key /etc/letsencrypt/live/your_domain.com/privkey.pem;

location / {

proxy_pass http://localhost:5601;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

# Базовая аутентификация (опционально)

# auth_basic "Restricted Content";

# auth_basic_user_file /etc/nginx/.htpasswd;

}

}

8. Управление жизненным циклом индексов (ILM)

В 2026 году ILM (Index Lifecycle Management) является стандартной практикой для управления данными в Elasticsearch. Оно позволяет автоматически перемещать индексы между "горячими", "теплыми", "холодными" фазами и удалять их, оптимизируя использование диска.

Используйте Kibana UI (Stack Management -> Index Lifecycle Policies) для создания политик ILM. Например:

- Hot phase: Данные активно записываются и читаются. Переход в Warm через 7 дней.

- Warm phase: Данные только читаются. Переход в Cold через 30 дней.

- Cold phase: Данные редко читаются, возможно, сжатие. Переход в Delete через 90 дней.

- Delete phase: Удаление индекса через 180 дней.

Убедитесь, что ваши Filebeat или Logstash настроены на использование Data Streams, которые автоматически создают индексы с привязкой к ILM-политикам.

Эти практические советы помогут вам не только развернуть ELK Stack на VPS, но и значительно оптимизировать его работу, продлевая жизнь вашим ресурсам и обеспечивая стабильность системы логирования.

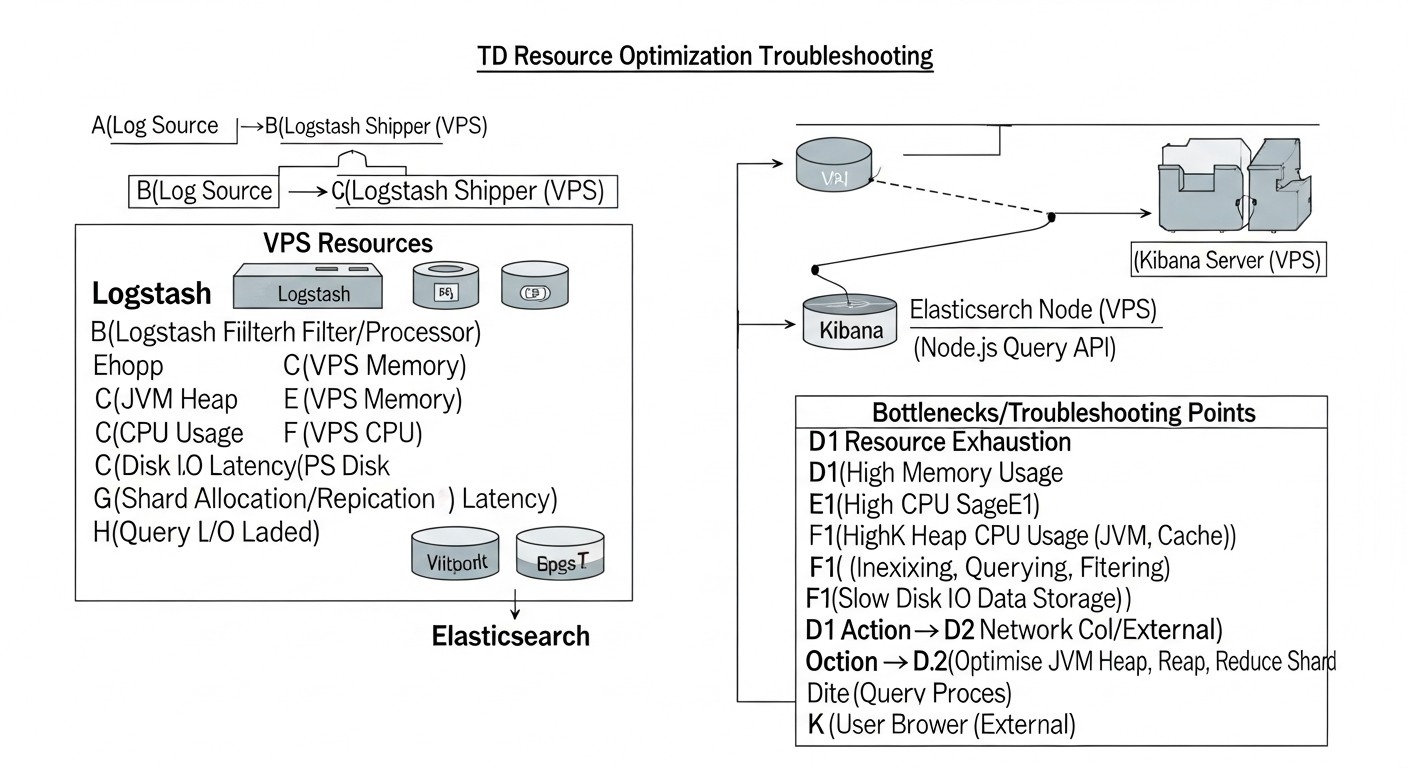

Типичные ошибки при работе с ELK на VPS и как их избежать

Развертывание и эксплуатация ELK Stack, особенно на ограниченных ресурсах VPS, чреваты множеством подводных камней. Ошибки в конфигурации или неверные предположения могут привести к нестабильности, потере данных, деградации производительности или неоправданно высоким затратам. Вот пять наиболее распространенных ошибок и способы их предотвращения:

1. Недостаточное выделение ресурсов (RAM и I/O)

Ошибка: Попытка запустить полноценный ELK Stack на VPS с 2-4 ГБ RAM и обычным HDD/SATA SSD. Elasticsearch, Logstash и Kibana — ресурсоёмкие приложения. Elasticsearch особенно чувствителен к нехватке RAM и медленному I/O диска.

Последствия:

- Постоянные OutOfMemoryError в Elasticsearch и Logstash.

- Медленная индексация и поиск, задержки в поступлении логов.

- "Зависание" Kibana, невозможность построить дашборды.

- Потеря данных из-за переполнения очередей и неспособности системы обработать входящий поток.

- Общая нестабильность системы, частые перезапуски сервисов.

Как избежать:

- Начните с адекватных ресурсов: Минимум 8 ГБ RAM и 4 vCPU, обязательно NVMe SSD. Для продуктивной среды с умеренным потоком логов (несколько тысяч событий/сек) рассмотрите 16 ГБ RAM.

- Оптимизируйте JVM Heap: Установите

-Xmsи-Xmxдля Elasticsearch в 50% от доступной RAM, но не более 30.5 ГБ. Для Logstash 1-2 ГБ обычно достаточно. - Мониторинг: Внимательно отслеживайте использование CPU, RAM, I/O диска и JVM Heap с помощью Metricbeat и Kibana Stack Monitoring.

- Используйте ILM: Автоматически удаляйте старые индексы, чтобы не переполнять диск.

2. Неправильная настройка JVM Heap Size

Ошибка: Установка -Xms и -Xmx для Elasticsearch слишком высоко (более 50% RAM) или слишком низко. Часто новички устанавливают его на максимум или забывают вовсе.

Последствия:

- Если более 50% RAM: Операционная система будет вынуждена использовать swap, что катастрофически замедлит Elasticsearch и приведет к "thrashing" (постоянному обмену данными между RAM и диском).

- Если слишком низко: Elasticsearch не сможет эффективно использовать кэши Lucene, что замедлит поиск и индексацию.

- Разные

-Xmsи-Xmx: Приведет к частым и долгим сборкам мусора (Garbage Collection).

Как избежать:

- Правило 50%: Выделите ровно 50% от доступной физической RAM на JVM Heap, но никогда не превышайте 30.5 ГБ (из-за compressed ordinary object pointers).

- Равные значения: Всегда устанавливайте

-Xmsи-Xmxв одно и то же значение. - Отключите swap: Убедитесь, что swap полностью отключен на VPS, где работает Elasticsearch.

- Мониторинг GC: Используйте Kibana Stack Monitoring для отслеживания времени и частоты сборки мусора.

3. Отсутствие безопасности (открытые порты, слабые пароли)

Ошибка: Оставлять порты Elasticsearch (9200) и Kibana (5601) открытыми для всего мира без аутентификации и SSL/TLS. Использование дефолтных или слабых паролей.

Последствия:

- Утечка данных: Логи могут содержать чувствительную информацию, которая станет доступна злоумышленникам.

- Несанкционированный доступ: Злоумышленники могут изменять или удалять ваши данные.

- DDoS-атаки: Открытые порты могут стать целью для атак.

- Компрометация системы: Через уязвимости в ELK могут получить доступ ко всей системе.

Как избежать:

- Используйте SSL/TLS: Шифруйте весь трафик между компонентами ELK и между клиентами и Kibana/Elasticsearch. Используйте Let's Encrypt для бесплатных сертификатов.

- Включите X-Pack Security: В Elasticsearch 8.x он включен по умолчанию. Используйте сильные, случайно сгенерированные пароли для всех пользователей.

- Фаервол: Ограничьте доступ к портам ELK только с доверенных IP-адресов или используйте VPN/SSH-туннели.

- Nginx/Caddy в качестве прокси: Используйте обратный прокси для Kibana для централизованного управления SSL и, при необходимости, добавления базовой HTTP-аутентификации.

4. Игнорирование Index Lifecycle Management (ILM)

Ошибка: Разрешать Elasticsearch бесконечно хранить все логи, не настраивая политики удаления старых данных.

Последствия:

- Быстрое переполнение диска: Логи генерируются постоянно, и без ILM диск быстро заполнится.

- Деградация производительности: Чем больше данных в индексах, тем медленнее поиск и индексация.

- Непредвиденные расходы: Необходимость постоянно увеличивать объем диска на VPS.

- Ручное управление: Необходимость вручную удалять старые индексы, что отнимает время и чревато ошибками.

Как избежать:

- Настройте ILM с самого начала: Определите политику хранения логов (например, 7 дней "горячих", 30 дней "теплых", 90 дней "холодных", затем удаление) и создайте соответствующие политики в Kibana.

- Используйте Data Streams: Это рекомендуемый способ для логирования в Elasticsearch 7.x/8.x+, который упрощает управление индексами с помощью ILM.

- Мониторинг диска: Регулярно проверяйте свободное место на диске. Настройте оповещения при достижении пороговых значений (например, 80% заполнения).

5. Избыточное использование Logstash для простых задач

Ошибка: Использование Logstash для всех задач по сбору и пересылке логов, даже если требуется минимальная обработка.

Последствия:

- Избыточное потребление ресурсов: Logstash — это JVM-приложение, которое потребляет значительно больше RAM и CPU, чем легковесные Beats.

- Усложнение архитектуры: Добавление лишнего звена в конвейер обработки данных увеличивает потенциальные точки отказа.

- Задержки: Logstash может вносить дополнительные задержки в конвейер, если он перегружен или его фильтры неоптимизированы.

Как избежать:

- Предпочитайте Beats: Используйте Filebeat или Metricbeat для сбора логов и метрик напрямую с источников и отправки их в Elasticsearch. Они гораздо более легковесны и эффективны.

- Используйте Logstash только для сложных трансформаций: Если вам нужен сложный парсинг Grok, обогащение данных из внешних источников или агрегация из множества разных систем, тогда Logstash оправдан.

- Оптимизируйте конфигурацию Logstash: Если Logstash необходим, оптимизируйте его фильтры (например, делайте Grok-паттерны максимально точными), настройте

pipeline.workersиpipeline.batch.size.

Избегая этих распространенных ошибок, вы значительно повысите стабильность, производительность и безопасность вашей системы централизованного логирования на ELK Stack, даже в условиях ограниченных ресурсов VPS.

Чеклист для практического применения ELK на VPS

Этот чеклист поможет вам систематизировать процесс развертывания и оптимизации ELK Stack на VPS, обеспечивая стабильную и эффективную работу вашей системы централизованного логирования.

Фаза 1: Планирование и Подготовка

- Определите требования к ресурсам:

- Оцените примерный объем логов (событий в секунду, объем в ГБ/день).

- Определите требуемое время хранения логов.

- Рассчитайте необходимый объем RAM, CPU и диска для VPS.

- Выберите VPS-провайдера:

- Убедитесь в наличии NVMe SSD и достаточного количества RAM/CPU.

- Проверьте тарифы и возможности масштабирования.

- Выберите версию ELK Stack:

- Рекомендуется последняя стабильная версия (например, 8.x или новее в 2026 году).

- Проверьте совместимость с вашей ОС и Java.

- Подготовьте домен и SSL-сертификаты:

- Зарегистрируйте доменное имя для Kibana (например,

logs.yourdomain.com). - Получите SSL-сертификат (например, с помощью Let's Encrypt).

- Зарегистрируйте доменное имя для Kibana (например,

Фаза 2: Настройка VPS

- Установите операционную систему:

- Рекомендуется Ubuntu Server LTS (22.04 или 24.04).

- Обновите все пакеты (

sudo apt update && sudo apt upgrade -y).

- Настройте системные параметры:

- Установите OpenJDK (версии 17+).

- Увеличьте

vm.max_map_countдо 262144 (/etc/sysctl.conf). - Отключите swap (

sudo swapoff -a, закомментируйте в/etc/fstab). - Настройте лимиты

nofileиmemlockдля пользователяelasticsearch(/etc/security/limits.conf).

- Настройте фаервол (UFW):

- Разрешите SSH (22/tcp).

- Разрешите порты Kibana (5601/tcp), Elasticsearch (9200/tcp), Beats/Logstash (5044/tcp) только с доверенных IP-адресов.

Фаза 3: Установка и Настройка ELK Stack

- Установите Elasticsearch:

- Добавьте репозиторий Elastic.

- Установите пакет

elasticsearch.

- Настройте Elasticsearch:

- Отредактируйте

/etc/elasticsearch/elasticsearch.yml(network.host,discovery.type: single-node). - Оптимизируйте JVM Heap: Установите

-Xmsи-Xmx(50% RAM, не более 30.5 ГБ) в/etc/elasticsearch/jvm.options. - Запустите Elasticsearch, сохраните сгенерированные пароли и токены.

- Сгенерируйте пароли для системных пользователей (

kibana_system,logstash_system,filebeat_writer).

- Отредактируйте

- Установите Kibana:

- Установите пакет

kibana.

- Установите пакет

- Настройте Kibana:

- Отредактируйте

/etc/kibana/kibana.yml(server.host,elasticsearch.hosts,elasticsearch.username/password). - Запустите Kibana, выполните процесс регистрации с Elasticsearch.

- Отредактируйте

- Настройте Nginx/Caddy как обратный прокси для Kibana (рекомендуется):

- Установите Nginx/Caddy.

- Настройте SSL/TLS для вашего домена с помощью Let's Encrypt.

- Сконфигурируйте проксирование запросов с порта 80/443 на порт Kibana 5601.

- Установите Logstash (опционально, если нужна сложная обработка):

- Установите пакет

logstash. - Оптимизируйте JVM Heap: Установите

-Xmsи-Xmx(1-2 ГБ) в/etc/logstash/jvm.options. - Создайте конфигурационный файл (

/etc/logstash/conf.d/*.conf) с inputs, filters, outputs. - Настройте SSL/TLS и аутентификацию для Logstash.

- Запустите Logstash.

- Установите пакет

Фаза 4: Сбор и Управление Логами

- Установите Filebeat (на серверах-источниках):

- Установите пакет

filebeatна каждый сервер, откуда собираются логи.

- Установите пакет

- Настройте Filebeat:

- Отредактируйте

/etc/filebeat/filebeat.yml(filebeat.inputs,output.elasticsearchилиoutput.logstash). - Укажите учетные данные для доступа к Elasticsearch/Logstash.

- Настройте SSL/TLS для Filebeat.

- Запустите Filebeat.

- Отредактируйте

- Настройте Index Lifecycle Management (ILM) в Kibana:

- Создайте политики ILM для автоматического управления индексами (горячая/теплая/холодная/удаление фазы).

- Убедитесь, что Filebeat/Logstash используют Data Streams, привязанные к этим политикам.

- Импортируйте дашборды и визуализации:

- Используйте готовые дашборды от Elastic (через

filebeat setupили Kibana UI). - Создайте собственные дашборды для мониторинга ваших приложений.

- Используйте готовые дашборды от Elastic (через

Фаза 5: Мониторинг и Обслуживание

- Включите Stack Monitoring в Kibana:

- Регулярно отслеживайте состояние Elasticsearch, Kibana, Logstash и Beats.

- Настройте оповещения:

- Создайте оповещения в Kibana (Stack Monitoring Alerts) о критических событиях (заполнение диска, высокая загрузка CPU, ошибки JVM).

- Регулярно обновляйте ELK Stack:

- Следите за новыми версиями и патчами безопасности.

- Планируйте обновления в непиковые часы.

- Создайте стратегию резервного копирования:

- Настройте регулярное создание снапшотов Elasticsearch в облачное хранилище (S3-совместимое).

Следуя этому чеклисту, вы сможете построить надежную и оптимизированную систему централизованного логирования на базе ELK Stack, даже используя ограниченные ресурсы VPS.

Расчет стоимости / Экономика ELK на VPS (Актуально на 2026 год)

Один из ключевых факторов при выборе и развертывании ELK Stack на VPS — это стоимость. В 2026 году цены на VPS продолжают быть конкурентными, но "бесплатный" open-source ELK все равно требует значительных инвестиций в инфраструктуру и время инженеров. Понимание полной картины затрат, включая скрытые расходы, критически важно для фаундеров SaaS-проектов и CTO.

Основные компоненты стоимости

- Стоимость VPS-инфраструктуры:

- RAM: Самый дорогой ресурс для Elasticsearch. Чем больше RAM, тем быстрее работа.

- CPU: Важен для индексации и обработки запросов.

- NVMe SSD: Абсолютно необходим для производительности I/O.

- Трафик: Может быть значительным, если у вас много источников логов или активных пользователей Kibana.

- Время инженеров (самый большой скрытый расход):

- Развертывание и первоначальная настройка.

- Оптимизация производительности и устранение проблем.

- Регулярное обслуживание, обновление и мониторинг.

- Настройка ILM, дашбордов, оповещений.

- Резервное копирование и хранение снапшотов:

- Стоимость облачного хранилища (S3-совместимое) для снапшотов Elasticsearch.

- Дополнительные инструменты и сервисы:

- DNS-сервисы, SSL-сертификаты (хотя Let's Encrypt бесплатны).

- Системы оповещения (например, PagerDuty, если не используются бесплатные аналоги).

Примеры расчетов для разных сценариев (2026 год, ориентировочные цены)

Предположим, средняя зарплата DevOps-инженера в СНГ составляет $3000-5000/месяц (~$20-30/час).

Сценарий 1: Небольшой стартап, 100-500 событий/сек, хранение 30 дней.

- VPS-конфигурация: 1x VPS (16 GB RAM, 4 vCPU, 320 GB NVMe SSD, 1 TB трафика)

- Провайдер: Hetzner Cloud, Vultr, DigitalOcean.

- Ежемесячная стоимость VPS: ~$40-60

- Дополнительные расходы:

- Хранение снапшотов (S3-совместимое): ~$5-10/мес (за 100-200 ГБ).

- DNS: ~$0-5/мес.

- Время инженера:

- Настройка: 10-20 часов (первоначально) = ~$200-600.

- Обслуживание: 2-4 часа/мес = ~$40-120/мес.

Итоговая ежемесячная стоимость: ~$85-195 (после первоначальной настройки).

Сценарий 2: SaaS-проект среднего размера, 1000-3000 событий/сек, хранение 60 дней.

- VPS-конфигурация: 1x VPS (32 GB RAM, 8 vCPU, 640 GB NVMe SSD, 2 TB трафика) ИЛИ 2x VPS (16 GB RAM, 4 vCPU, 320 GB NVMe SSD) для разделения ES/Logstash.

- Провайдер: Hetzner Cloud, Vultr, DigitalOcean.

- Ежемесячная стоимость VPS: ~$80-150 (за 1-2 VPS).

- Дополнительные расходы:

- Хранение снапшотов: ~$10-25/мес (за 300-500 ГБ).

- DNS: ~$0-5/мес.

- Время инженера:

- Настройка: 20-40 часов (первоначально) = ~$400-1200.

- Обслуживание: 4-8 часов/мес = ~$80-240/мес.

Итоговая ежемесячная стоимость: ~$170-420 (после первоначальной настройки).

Таблица с примерами расчетов для разных сценариев (2026)

| Параметр | Малый проект (500 EPS, 30 дн) | Средний проект (3000 EPS, 60 дн) | Крупный проект (10000 EPS, 90 дн) |

|---|---|---|---|

| VPS-конфигурация (RAM/CPU/SSD) | 16GB/4vCPU/320GB NVMe | 32GB/8vCPU/640GB NVMe | 2x (32GB/8vCPU/640GB NVMe) |

| Стоимость VPS (мес.) | $40-60 | $80-150 | $160-300 |

| Стоимость S3-хранилища (мес.) | $5-10 | $10-25 | $20-50 |

| Первоначальная настройка (инж. часы * $30) | 15 ч = $450 | 30 ч = $900 | 60 ч = $1800 |

| Ежемес. обслуживание (инж. часы * $30) | 3 ч = $90 | 6 ч = $180 | 12 ч = $360 |

| ИТОГО (первый месяц) | $495-520 + $450 = $945-970 | $100-175 + $900 = $1000-1075 | $180-350 + $1800 = $1980-2150 |

| ИТОГО (последующие месяцы) | $45-70 + $90 = $135-160 | $90-175 + $180 = $270-355 | $180-350 + $360 = $540-710 |

Скрытые расходы

- Перерасход трафика: Если логи собираются из разных ЦОД или много пользователей Kibana, трафик может стать существенной статьей расходов.

- Простой (Downtime): Нестабильная система логирования означает, что вы теряете ценные данные и время на их восстановление.

- Масштабирование: Переход на более мощный VPS или добавление новых узлов не всегда происходит бесшовно и требует планирования.

- Обучение: Время, необходимое команде для освоения ELK, его особенностей и оптимизации.

Как оптимизировать затраты

- Оптимизация ресурсов ELK:

- JVM Heap: Точная настройка

-Xms/-Xmxдля Elasticsearch и Logstash. - ILM: Установите агрессивные политики ILM для автоматического удаления старых логов, чтобы минимизировать требования к дисковому пространству.

- Beats вместо Logstash: Используйте легковесные Beats для прямого сбора логов и отправки в Elasticsearch, избегая Logstash, если нет сложной обработки.

- Оптимизация запросов: Обучите команду писать эффективные запросы в Kibana, чтобы не перегружать Elasticsearch.

- JVM Heap: Точная настройка

- Эффективное использование VPS:

- Выбирайте VPS с NVMe SSD, так как это значительно повышает производительность и позволяет использовать меньший объем RAM для Elasticsearch (за счет более быстрого I/O).

- Рассмотрите возможность использования одного VPS для всех компонентов ELK для небольших и средних проектов, чтобы избежать дополнительных затрат на отдельные VPS.

- Используйте Nginx/Caddy для кэширования статических файлов Kibana, снижая нагрузку на сам Kibana.

- Мониторинг и автоматизация:

- Активно используйте Stack Monitoring в Kibana для выявления узких мест и предотвращения проблем.

- Автоматизируйте рутинные задачи (обновления, резервное копирование) с помощью скриптов или IaC-инструментов.

- Альтернативы:

- Для очень ограниченных бюджетов или если нужен только базовый просмотр логов, рассмотрите Loki + Grafana. Это решение значительно менее требовательно к ресурсам на VPS.

- Для очень больших объемов логов и если вы уже в облаке, рассмотрите управляемые сервисы (Elastic Cloud, AWS OpenSearch Service), но будьте готовы к более высоким затратам.

Экономика ELK на VPS — это постоянный процесс оптимизации. Регулярный анализ потребления ресурсов и корректировка конфигурации помогут вам контролировать расходы и получать максимальную отдачу от вашей системы логирования.

Кейсы и примеры использования ELK Stack

Чтобы лучше понять практическую ценность ELK Stack на VPS, давайте рассмотрим несколько реалистичных сценариев из мира DevOps и стартапов, демонстрирующих, как централизованное логирование помогает решать конкретные задачи.

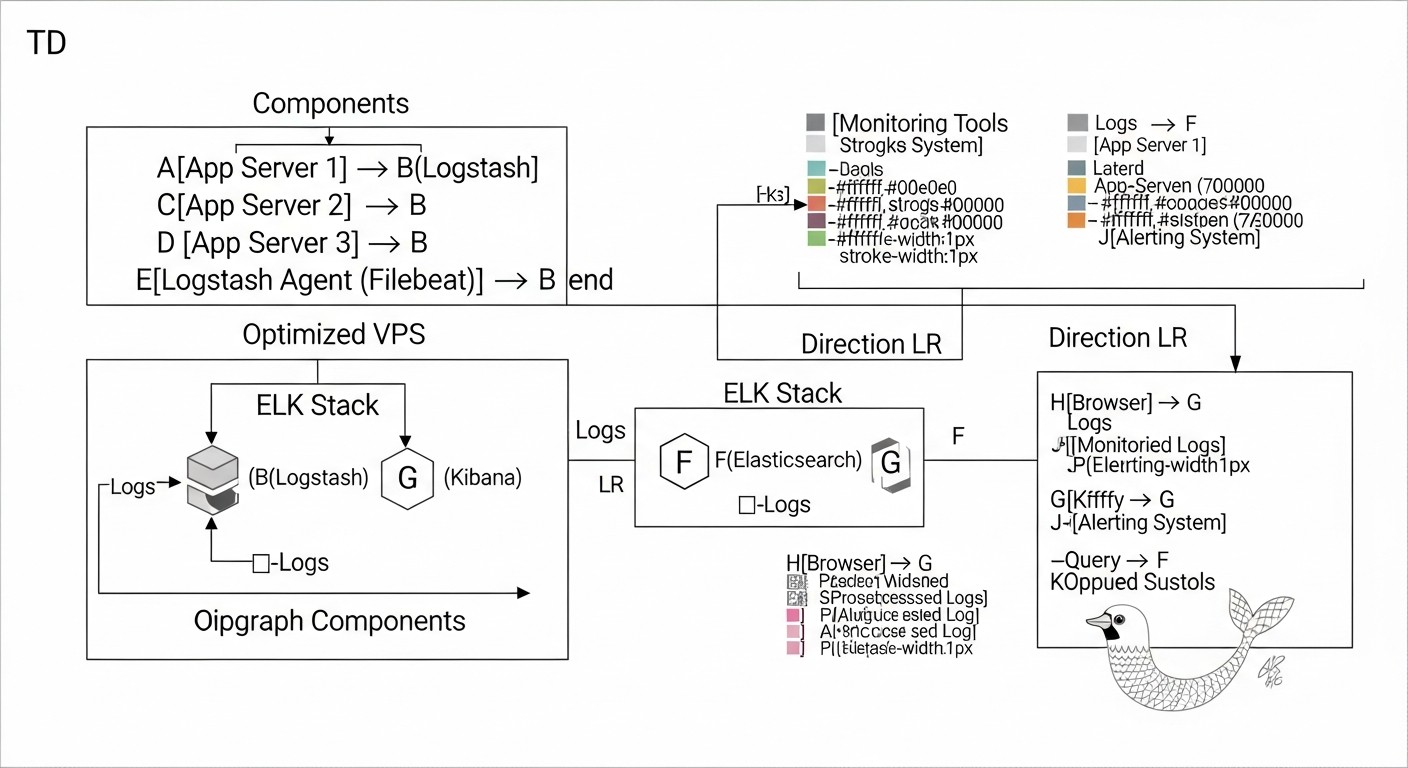

Кейс 1: Мониторинг и отладка микросервисного приложения на Docker Swarm

Описание проблемы: Небольшой SaaS-стартап разработал приложение, состоящее из 5-7 микросервисов, развернутых в Docker Swarm на трех VPS. Каждый микросервис генерирует логи в формате JSON. При возникновении ошибок пользователи жалуются на медленную работу, но определить, какой именно микросервис является причиной, очень сложно. Логи разбросаны по разным контейнерам на разных хостах, и ручной просмотр занимает часы.

Решение с ELK Stack на VPS: Команда развернула один мощный VPS (16GB RAM, 4vCPU, 320GB NVMe) для ELK Stack.

- Filebeat: На каждом из трех VPS с Docker Swarm был установлен Filebeat. Он был настроен для сбора логов всех Docker-контейнеров (используя

filebeat.autodiscover.providersс Docker-просессором) и отправки их напрямую в Elasticsearch на центральном VPS. Filebeat автоматически добавлял метаданные контейнеров (имя сервиса, ID контейнера). - Elasticsearch: На центральном VPS был настроен Elasticsearch с оптимизированным JVM Heap (8GB) и ILM-политикой для хранения логов в течение 30 дней.

- Kibana: Использовалась для создания дашбордов.

Конкретные решения и результаты:

- Обнаружение ошибок: Создан дашборд в Kibana, который агрегировал логи по микросервисам, показывая количество ошибок (

level: error) по каждому из них. При росте числа ошибок в конкретном сервисе, команда мгновенно видела источник проблемы. - Трассировка запросов: Разработчики добавили уникальный

request_idв логи каждого запроса, проходящего через микросервисы. В Kibana стало возможным искать по этомуrequest_idи видеть полный путь запроса через все сервисы, быстро выявляя точку отказа. - Ускорение отладки: Время на обнаружение и изоляцию проблем сократилось с нескольких часов до 5-15 минут.

- Оптимизация производительности: Анализ логов показал, что один из микросервисов генерировал слишком много WARN-сообщений, что указывало на неэффективные запросы к базе данных. Оптимизация этого сервиса значительно улучшила общую производительность приложения.

- Экономия: Общая стоимость одного ELK VPS (~$50/мес) оказалась значительно ниже, чем потерянное время инженеров и недовольство клиентов.

Кейс 2: Анализ безопасности и обнаружение аномалий для Backend-API

Описание проблемы: Backend-команда, разрабатывающая API на Node.js, столкнулась с подозрительными активностями: периодические всплески запросов с необычных IP-адресов, попытки брутфорса аутентификации. Существующая система логирования (простое сохранение в файлы) не позволяла оперативно выявлять и реагировать на эти угрозы.

Решение с ELK Stack на VPS: Команда развернула ELK на VPS (32GB RAM, 8vCPU, 640GB NVMe) для более высокой нагрузки и длительного хранения.

- Filebeat: На сервере с Node.js API был установлен Filebeat для сбора логов Nginx (access.log, error.log) и логов самого Node.js-приложения (в формате JSON).

- Logstash: Использовался для обогащения логов Nginx. Logstash с помощью Grok-фильтров парсил строки логов, извлекал IP-адреса, User-Agent, статус-коды. Затем, используя GeoIP-фильтр, добавлял информацию о географическом местоположении IP-адресов.

- Elasticsearch: Хранил обогащенные логи.

- Kibana: Использовалась для визуализации и настройки оповещений.

Конкретные решения и результаты:

- Обнаружение брутфорса: Создан дашборд, показывающий количество неудачных попыток входа (

status_code: 401) по IP-адресам. Настроен алерт в Kibana (Stack Monitoring -> Alerts), который отправлял уведомление в Slack, если с одного IP-адреса было более 10 неудачных попыток входа за 5 минут. - Географический анализ: С помощью GeoIP-данных построена карта в Kibana, показывающая источники запросов. Это помогло выявить аномальные всплески трафика из определенных стран, которые не являются целевой аудиторией.

- Анализ User-Agent: Дашборд по User-Agent помог выявить ботов и сканеры безопасности.

- Улучшение безопасности: На основе выявленных аномалий, команда смогла оперативно блокировать подозрительные IP-адреса на уровне фаервола или Cloudflare, значительно повысив безопасность API.

- Доказательство комплаенса: Возможность быстро найти и предоставить логи по запросу регуляторов или для внутреннего аудита.

Кейс 3: Мониторинг производительности и ошибок в монолитном PHP-приложении

Описание проблемы: Фаундер SaaS-проекта, работающего на старом монолитном PHP-приложении, сталкивается с "плавающими" проблемами производительности и периодическими ошибками, которые трудно воспроизвести. Приложение работает на одном VPS, логи PHP и Apache пишутся в файлы.

Решение с ELK Stack на VPS: Развернут ELK на том же VPS, где работает PHP-приложение (16GB RAM, 4vCPU, 320GB NVMe), чтобы избежать сетевых задержек и дополнительных затрат.

- Filebeat: Настроен для сбора логов Apache (access_log, error_log) и логов PHP-FPM, а также системных логов.

- Logstash: Использовался для парсинга PHP-логов (которые часто бывают многострочными и неструктурированными) и нормализации их в JSON. Также Logstash обогащал логи информацией о времени выполнения запроса.

- Elasticsearch: Хранил все обработанные логи.

- Kibana: Использовалась для создания дашбордов и оповещений.

Конкретные решения и результаты:

- Обнаружение медленных запросов: В PHP-логах фиксировалось время выполнения запроса. Logstash извлекал это значение. В Kibana создан дашборд, показывающий топ-N самых медленных запросов к приложению. Это помогло выявить узкие места в коде и запросах к базе данных.

- Мониторинг ошибок: Создан дашборд, агрегирующий PHP-ошибки по типу и файлу. Мгновенно видны новые или участившиеся ошибки. Настроено оповещение в Telegram при появлении критических ошибок.

- Анализ трафика: Дашборды по Apache access_log позволяли отслеживать пики трафика, самые популярные страницы и источники запросов, помогая планировать масштабирование или оптимизацию.

- Проактивное устранение проблем: Теперь команда могла реагировать на проблемы до того, как они затрагивали большое количество пользователей, основываясь на данных, а не на жалобах.

- Улучшение качества кода: Разработчики получили четкие метрики и логи для тестирования и оптимизации своего кода.

Эти кейсы демонстрируют, что ELK Stack на VPS, при правильной настройке и оптимизации, является мощным и доступным инструментом для решения широкого круга задач в области мониторинга, отладки и безопасности для различных типов проектов.

Инструменты и ресурсы для работы с ELK

Эффективная работа с ELK Stack требует не только понимания его компонентов, но и использования вспомогательных инструментов и постоянного обращения к актуальным ресурсам. В 2026 году экосистема вокруг Elastic продолжает активно развиваться, предлагая множество утилит и источников знаний.

1. Утилиты для работы и диагностики

curl/wget: Базовые утилиты для взаимодействия с RESTful API Elasticsearch. Незаменимы для проверки статуса кластера, отправки простых запросов или проверки безопасности.curl -u elastic:YOUR_PASSWORD -k "https://localhost:9200/_cat/health?v" curl -u elastic:YOUR_PASSWORD -k -XGET "https://localhost:9200/_cluster/stats?pretty"- Kibana Dev Tools: Встроенный в Kibana интерфейс для отправки запросов к Elasticsearch. Позволяет удобно тестировать поисковые запросы, управлять индексами, создавать ILM-политики и проверять состояние кластера. Это ваш основной инструмент для администрирования через UI.

htop/atop/glances: Инструменты для мониторинга системных ресурсов (CPU, RAM, I/O диска, процессы) на VPS. Помогают выявлять узкие места в работе ELK.sudo apt install htop glances -y htop glancesiostat/vmstat: Утилиты для детального анализа дисковой активности и использования памяти. Критически важны для диагностики проблем с I/O, которые часто возникают с Elasticsearch.iostat -x 1 10 # 10 отчетов с интервалом в 1 секунду vmstat 1 10 # 10 отчетов с интервалом в 1 секундуtcpdump/wireshark: Для анализа сетевого трафика. Полезно для отладки проблем с подключением между компонентами ELK или между Beats и Logstash/Elasticsearch.sudo tcpdump -i eth0 port 5044journalctl/tail: Для просмотра системных логов и логов компонентов ELK.sudo journalctl -u elasticsearch -f sudo tail -f /var/log/elasticsearch/elasticsearch.log- Elasticsearch Head (браузерное расширение/приложение): Позволяет визуально управлять кластером Elasticsearch, просматривать шарды, индексы и выполнять базовые операции. Хотя Kibana Dev Tools более мощный, Head может быть полезен для быстрого обзора.

jq: Утилита для парсинга JSON из командной строки. Очень полезна при работе с JSON-ответами от Elasticsearch API.curl -u elastic:YOUR_PASSWORD -k "https://localhost:9200/_cluster/health?pretty" | jq .status

2. Мониторинг и тестирование

- Kibana Stack Monitoring: Встроенный инструмент для мониторинга состояния всего ELK Stack. Показывает метрики CPU, RAM, I/O, JVM Heap, количество запросов, состояние шардов и многое другое. Настоятельно рекомендуется для постоянного отслеживания производительности и здоровья.

- Metricbeat: Установите его на ELK VPS, чтобы собирать системные метрики и метрики самого ELK Stack и отправлять их в Elasticsearch. Это позволит вам создавать собственные дашборды мониторинга, если встроенного Stack Monitoring недостаточно.

- Prometheus + Grafana: Если у вас уже есть инфраструктура мониторинга на Prometheus, вы можете использовать Exporter'ы для Elasticsearch и Logstash, чтобы собирать их метрики и визуализировать в Grafana.

- Apache JMeter / k6: Для нагрузочного тестирования ELK Stack. Позволяет симулировать большой поток логов или интенсивные поисковые запросы, чтобы проверить производительность и стабильность вашей конфигурации.

3. Полезные ссылки и документация (2026 год)

- Официальная документация Elastic: elastic.co/guide/en/elastic-stack/current/index.html

- Всегда обращайтесь к официальной документации для вашей версии ELK. Она самая полная и актуальная.

- Elastic Blog: elastic.co/blog

- Содержит множество статей о новых функциях, лучших практиках, оптимизации и реальных кейсах использования.

- Elastic Community Forums: discuss.elastic.co/

- Активное сообщество, где можно задать вопросы, найти решения типичных проблем и обменяться опытом.

- YouTube-каналы и обучающие платформы:

- Официальный канал Elastic на YouTube.

- Udemy, Coursera, Pluralsight: Курсы по ELK Stack, часто обновляются под новые версии.

- Awesome Elasticsearch: github.com/dzharii/awesome-elasticsearch

- Курируемый список полезных ресурсов, инструментов, плагинов и статей по Elasticsearch.

- Статьи и гайды от сообщества:

- DigitalOcean Community Tutorials, Logz.io Blog, Medium-статьи от DevOps-инженеров. Ищите свежие материалы с датой публикации 2024-2026 годов.

Использование этих инструментов и ресурсов значительно упростит процесс развертывания, настройки, мониторинга и устранения неполадок с ELK Stack на вашем VPS, позволяя вам оставаться в курсе последних тенденций и лучших практик.

Troubleshooting: решение проблем с ELK

Даже при самой тщательной настройке, проблемы с ELK Stack на VPS неизбежны. Они могут варьироваться от нехватки ресурсов до ошибок конфигурации и сетевых проблем. Умение быстро диагностировать и устранять их — ключевой навык для любого, кто работает с ELK. Вот типичные проблемы и их решения.

1. Elasticsearch не запускается или работает нестабильно

Типичные проблемы:

- OutOfMemoryError (OOM): Недостаточно памяти для JVM.

- Disk Full / Low Disk Space: Диск переполнен или почти заполнен.

vm.max_map_countслишком низко: Elasticsearch не может выделить необходимые системные ресурсы.- Проблемы с файловыми дескрипторами: Слишком низкий лимит

nofile. - Ошибка конфигурации в

elasticsearch.yml: Синтаксические ошибки или неверные параметры. discovery.typeне настроен для single-node: Elasticsearch пытается найти другие узлы кластера и не может запуститься.

Диагностические команды:

sudo systemctl status elasticsearch.service # Проверка статуса сервиса

sudo journalctl -u elasticsearch.service -f # Просмотр логов сервиса в реальном времени

sudo tail -f /var/log/elasticsearch/elasticsearch.log # Основной лог Elasticsearch

df -h # Проверка свободного места на диске

free -h # Проверка использования RAM

sysctl vm.max_map_count # Проверка значения vm.max_map_count

ulimit -n # Проверка лимита файловых дескрипторов для текущего пользователя

Решения:

- OOM: Уменьшите

-Xms/-Xmxвjvm.optionsдо 50% RAM, но не более 30.5 ГБ. Отключите swap. - Disk Full: Удалите старые индексы (вручную или через ILM). Увеличьте объем диска.

vm.max_map_count: Установитеvm.max_map_count=262144в/etc/sysctl.confи применитеsudo sysctl -p.nofile: Увеличьтеnofileдо 65536 для пользователяelasticsearchв/etc/security/limits.conf.- Конфигурация: Внимательно проверьте

elasticsearch.ymlна опечатки. Используйтеdiscovery.type: single-nodeдля одного VPS.

2. Kibana не подключается к Elasticsearch

Типичные проблемы:

- Elasticsearch недоступен: Elasticsearch не запущен, или его порт закрыт фаерволом.

- Неверный

elasticsearch.hosts: Неправильно указан адрес или порт Elasticsearch вkibana.yml. - Проблемы с SSL/TLS: Неверные сертификаты, CA, или несовпадение протоколов (HTTP/HTTPS).

- Ошибка аутентификации: Неверный логин/пароль для пользователя

kibana_system. - Проблемы с токеном регистрации: Если Kibana просит токен, а вы его не предоставили.

Диагностические команды:

sudo systemctl status kibana.service

sudo journalctl -u kibana.service -f

curl -u elastic:YOUR_PASSWORD -k "https://localhost:9200" # Проверка доступности ES

Решения:

- Доступность ES: Убедитесь, что Elasticsearch запущен, и порт 9200 открыт для Kibana (

network.hostвelasticsearch.yml). elasticsearch.hosts: Проверьте, что адрес и порт вkibana.ymlкорректны и соответствуют протоколу (https://localhost:9200).- SSL/TLS: Убедитесь, что сертификаты корректны, и Kibana доверяет CA Elasticsearch. Для быстрого теста можно временно отключить

ssl.verification_mode: none(не рекомендуется для продакшена). - Аутентификация: Проверьте, что

elasticsearch.usernameиelasticsearch.passwordвkibana.ymlверны. Сгенерируйте новый пароль дляkibana_system, если сомневаетесь. - Токен регистрации: Если Kibana требует токен, сгенерируйте его в Elasticsearch (

elasticsearch-create-enrollment-token -s kibana) и введите в UI.

3. Логи не поступают в Elasticsearch / Kibana

Типичные проблемы:

- Filebeat/Logstash не запущен: Сервис не активен.

- Ошибка конфигурации Filebeat/Logstash: Неверные пути к логам, неправильный output, синтаксические ошибки.

- Сетевые проблемы: Фаервол блокирует порт 5044 (для Beats/Logstash) или 9200 (для прямого подключения к ES).

- Проблемы с SSL/TLS: Неверные сертификаты, CA, или несовпадение протоколов между Beats/Logstash и ES.

- Ошибка аутентификации: Неверный логин/пароль для пользователя Filebeat/Logstash.

- Отсутствие шаблонов индексов/data streams: Elasticsearch не знает, как обрабатывать входящие данные.

Диагностические команды:

sudo systemctl status filebeat.service # Или logstash.service

sudo journalctl -u filebeat.service -f # Или logstash.service

sudo tail -f /var/log/filebeat/filebeat.log # Или logstash.log

ping your_elk_vps_ip # Проверка сетевой доступности

telnet your_elk_vps_ip 5044 # Проверка доступности порта

Решения:

- Статус сервиса: Убедитесь, что Filebeat/Logstash запущены и не выдают ошибок в логах.

- Конфигурация: Проверьте

filebeat.ymlилиlogstash.confна опечатки. Убедитесь, что пути к логам верны и output настроен правильно. - Сетевые проблемы: Откройте порты в фаерволе. Проверьте

network.hostв конфигурации Logstash. - SSL/TLS: Проверьте, что сертификаты и CA корректны и доверяются.

- Аутентификация: Убедитесь, что логин/пароль для пользователя Filebeat/Logstash в конфигурации верны.

- Шаблоны: Используйте

filebeat setupдля загрузки дефолтных шаблонов или убедитесь, что ваш output настроен на использование Data Streams.

4. Медленный поиск или визуализация в Kibana

Типичные проблемы:

- Недостаточно ресурсов Elasticsearch: Высокая загрузка CPU или RAM.

- Слишком много шардов: Особенно на одном узле, это приводит к накладным расходам.

- Сложные или неоптимизированные запросы: Запросы, сканирующие большие объемы данных.

- Отсутствие ILM: Слишком много старых, но неактуальных данных в "горячих" индексах.

- Проблемы с I/O диска: Медленный NVMe SSD или его перегрузка.

Диагностические команды:

curl -u elastic:YOUR_PASSWORD -k "https://localhost:9200/_cat/indices?v" # Просмотр индексов и шардов

curl -u elastic:YOUR_PASSWORD -k "https://localhost:9200/_nodes/stats?pretty" # Статистика узлов

Решения:

- Ресурсы: Увеличьте RAM или CPU VPS, если позволяют бюджет и возможности. Оптимизируйте JVM Heap.

- Шарды: Для одного узла старайтесь поддерживать количество шардов в разумных пределах (например, 1-3 шарда на 1GB RAM). Используйте 1 Primary Shard и 0 Replicas для одного узла.

- Запросы: Оптимизируйте запросы в Kibana. Используйте фильтры по времени, исключайте ненужные поля.

- ILM: Внедрите политики ILM для автоматического перемещения и удаления старых данных.

- I/O диска: Убедитесь, что используется NVMe SSD. Мониторьте

iostat, чтобы убедиться, что диск не является узким местом.

Когда обращаться в поддержку?

Обращайтесь в поддержку Elastic (если у вас есть платная подписка) или в сообщество Elastic (форумы, GitHub Issues), если:

- Вы испробовали все стандартные методы диагностики и решения, но проблема сохраняется.

- Вы столкнулись с багом, который, по вашему мнению, является ошибкой в самом ПО Elastic.

- Проблема связана с потерей данных или серьезной деградацией производительности, угрожающей работоспособности вашего приложения.

- Вам нужна экспертная помощь по сложным вопросам масштабирования или архитектуры.

Всегда предоставляйте максимально полную информацию: логи сервисов, конфигурационные файлы, результаты диагностических команд, версию ELK Stack и описание шагов для воспроизведения проблемы.

Часто задаваемые вопросы (FAQ)

Что такое ELK Stack и почему он так популярен в DevOps?

ELK Stack — это набор из трех open-source проектов (Elasticsearch, Logstash, Kibana), используемых для централизованного сбора, обработки, хранения и визуализации логов и метрик. Он популярен в DevOps благодаря своей гибкости, масштабируемости и мощным аналитическим возможностям, которые позволяют командам быстро отлаживать проблемы, мониторить производительность и анализировать поведение приложений в распределенных системах. В 2026 году, несмотря на появление конкурентов, ELK остается стандартом благодаря своей зрелости и обширному сообществу.

Можно ли запустить ELK Stack на одном VPS? Какие минимальные требования?

Да, можно и это распространенная практика для небольших и средних проектов. Минимальные требования для одного VPS в 2026 году: 8 ГБ RAM, 4 vCPU и 200 ГБ NVMe SSD. Для комфортной работы и обработки до 1000-2000 событий в секунду, рекомендуется 16 ГБ RAM, 4-8 vCPU и 320+ ГБ NVMe SSD. Обязательно используйте NVMe SSD из-за интенсивных операций I/O Elasticsearch.

Как оптимизировать потребление памяти Elasticsearch на VPS?

Главный способ — правильная настройка JVM Heap Size. Установите -Xms и -Xmx в /etc/elasticsearch/jvm.options в одно и то же значение, равное примерно 50% от доступной физической RAM на VPS, но не более 30.5 ГБ (из-за сжатых указателей). Также убедитесь, что swap отключен, так как его использование катастрофически замедляет Elasticsearch.

В чем разница между Filebeat и Logstash? Что лучше использовать на VPS?

Filebeat — это легковесный агент для сбора логов, который эффективно пересылает их с источников в Logstash или Elasticsearch. Он потребляет минимум ресурсов. Logstash — это мощный ETL-конвейер для сложной обработки, парсинга и обогащения данных. На VPS рекомендуется использовать Filebeat для сбора логов и отправки их напрямую в Elasticsearch, если не требуется сложная обработка. Logstash используйте только для задач, где необходимы сложные фильтры (Grok, GeoIP и т.д.), так как он значительно более ресурсоёмок.

Как обеспечить безопасность ELK Stack на VPS?