Copia de seguridad de VPS: Estrategias y herramientas integrales para 2026

TL;DR

- La Estrategia "3-2-1-1-0" sigue siendo el estándar de oro: 3 copias, 2 medios diferentes, 1 fuera del sitio, 1 sin conexión/inmutable, 0 errores en la recuperación.

- La automatización y orquestación utilizando herramientas como Ansible, Terraform y operadores de Kubernetes son cruciales para la escalabilidad y fiabilidad en 2026.

- El almacenamiento inmutable y el versionado de las copias de seguridad son la principal barrera contra el ransomware y la eliminación accidental.

- Las pruebas de recuperación deben ser regulares, automatizadas e incluir un ciclo completo de verificación de la integridad de los datos, no solo la presencia de archivos.

- Las estrategias híbridas (instantáneas locales + almacenamiento en la nube) ofrecen un equilibrio óptimo entre la velocidad de recuperación y la fiabilidad a largo plazo.

- El costo de la copia de seguridad en 2026 se desplaza del precio directo por TB al costo por operación, ancho de banda y nivel de servicio (SLA) de recuperación.

- La seguridad de las copias de seguridad incluye cifrado "en reposo" y "en tránsito", control de acceso estricto (IAM, MFA) y aislamiento de las redes de almacenamiento.

Introducción: Por qué la copia de seguridad de VPS es críticamente importante en 2026

En el panorama digital de 2026, en rápida evolución, donde los procesos de negocio están cada vez más integrados con las tecnologías en la nube y los servidores privados virtuales (VPS), la cuestión de la copia de seguridad ha pasado de la categoría de "deseable" a "absolutamente necesaria". Los VPS se han convertido en la base de innumerables proyectos SaaS, arquitecturas de microservicios, backends de alta carga y aplicaciones corporativas de misión crítica. Sin embargo, con el crecimiento de la complejidad de la infraestructura y el volumen de datos, también aumentan los riesgos de su pérdida.

¿Por qué este tema adquiere una relevancia especial precisamente ahora? En primer lugar, las amenazas de ciberseguridad, en particular el ransomware, se están volviendo cada vez más sofisticadas y dirigidas. Las copias de seguridad ordinarias, no protegidas contra modificaciones o eliminaciones, pueden verse comprometidas junto con el sistema principal, haciendo imposible la recuperación. En segundo lugar, el factor humano sigue siendo la principal causa de fallos: comandos erróneos, configuraciones incorrectas, eliminación accidental de datos. En tercer lugar, los fallos de hardware, aunque menos frecuentes que antes, siguen ocurriendo, y los problemas con el proveedor de alojamiento (incluso los más fiables) pueden provocar la inaccesibilidad o la pérdida de datos. Finalmente, los requisitos regulatorios para el almacenamiento y la protección de datos (GDPR, CCPA, HIPAA y sus nuevas iteraciones) se están volviendo más estrictos, y la ausencia de estrategias de copia de seguridad adecuadas puede resultar en multas graves y pérdidas de reputación.

Este artículo está dirigido a una amplia gama de especialistas técnicos: ingenieros de DevOps, responsables de la fiabilidad y automatización de la infraestructura; desarrolladores de Backend (Python, Node.js, Go, PHP), cuyas aplicaciones generan y procesan datos críticos; fundadores de proyectos SaaS, para quienes la pérdida de datos de clientes equivale al colapso del negocio; administradores de sistemas, que gestionan decenas y cientos de VPS; y directores técnicos de startups, que toman decisiones estratégicas sobre la pila tecnológica y la seguridad. Analizaremos enfoques integrales, herramientas actuales y recomendaciones prácticas que le ayudarán a construir un sistema de copia de seguridad tolerante a fallos y seguro para sus VPS en 2026.

El objetivo de este artículo no es simplemente enumerar herramientas, sino proporcionar una comprensión profunda de los principios, ayudar a elegir la estrategia óptima en función de sus necesidades y presupuesto, y brindar instrucciones específicas para la implementación y operación. Evitamos el "bullshit" de marketing, centrándonos en casos reales, cifras y prácticas probadas.

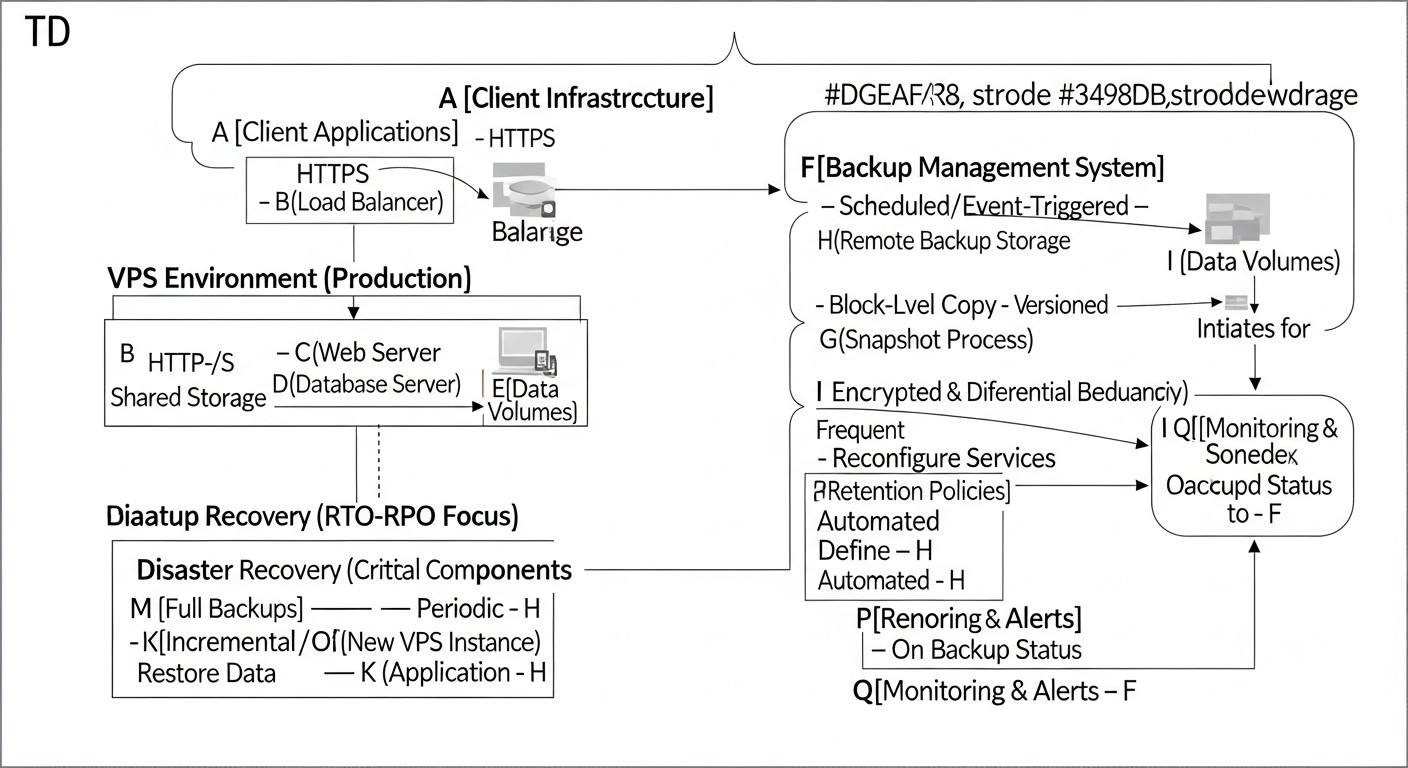

Criterios clave y factores para elegir una estrategia de copia de seguridad

La elección de la estrategia óptima de copia de seguridad para VPS no es solo la selección de una herramienta, sino una solución integral que debe tener en cuenta múltiples factores. En 2026, estos factores se han vuelto aún más críticos debido a las crecientes demandas de disponibilidad, seguridad y eficiencia. Examinemos los criterios clave por los cuales se debe evaluar cualquier sistema de copia de seguridad.

Recovery Point Objective (RPO) y Recovery Time Objective (RTO)

El RPO (Objetivo de Punto de Recuperación) define la cantidad máxima de datos que se pueden perder en caso de un fallo. Si su RPO es de 1 hora, significa que está dispuesto a perder los datos creados durante la última hora. Cuanto menor sea el RPO (por ejemplo, 5 minutos o casi cero), más frecuentes deben ser las copias de seguridad. Para sistemas de misión crítica, donde cada transacción es importante (por ejemplo, servicios financieros), el RPO tiende a cero. Esto se logra mediante la copia de seguridad continua (CDP) o copias de seguridad incrementales muy frecuentes.

El RTO (Objetivo de Tiempo de Recuperación) define el tiempo máximo permitido dentro del cual el sistema o la aplicación deben restaurarse después de un fallo. Si su RTO es de 4 horas, significa que su negocio puede permitirse un tiempo de inactividad de no más de cuatro horas. Cuanto menor sea el RTO (por ejemplo, unos pocos minutos), más rápido debe ser posible restaurar los datos y lanzar los servicios. Esto requiere mecanismos de recuperación rápidos, como instantáneas (snapshots) o replicación, así como procedimientos de recuperación bien practicados.

Por qué es importante: RPO y RTO son los pilares de cualquier estrategia de recuperación ante desastres. Influyen directamente en la elección de tecnologías, la frecuencia de las copias de seguridad y, en consecuencia, en el costo. La definición de estas métricas debe comenzar con un análisis de los requisitos comerciales y las pérdidas potenciales por el tiempo de inactividad. Por ejemplo, para un blog, el RPO puede ser de 24 horas y el RTO de 8 horas, mientras que para una tienda en línea, estos valores pueden ser de 15 minutos y 1 hora, respectivamente.

Costo (Cost)

El costo de la copia de seguridad incluye no solo los gastos directos de almacenamiento de datos, sino también muchos costos ocultos. En 2026, a medida que los volúmenes de datos crecen exponencialmente, la optimización de costos se convierte en una prioridad.

- Almacenamiento de datos: Precio por gigabyte al mes. Los proveedores de la nube ofrecen diferentes clases de almacenamiento (Estándar, Acceso Infrecuente, Archivo), que varían significativamente en costo y velocidad de acceso.

- Tráfico: El costo del tráfico de salida (tarifas de egreso) del almacenamiento en la nube puede ser sustancial, especialmente con recuperaciones frecuentes o replicación entre regiones. El tráfico de entrada suele ser gratuito.

- Operaciones: Muchos almacenamientos en la nube cobran por las operaciones de lectura/escritura (solicitudes PUT/GET). Con un gran número de archivos pequeños o copias de seguridad incrementales frecuentes, estos costos pueden acumularse.

- Licencias de software: El costo del software propietario para copias de seguridad (por ejemplo, Veeam, Acronis) puede ser significativo.

- Administración y soporte: El tiempo de los ingenieros dedicado a la configuración, monitoreo, pruebas y resolución de problemas es una partida de gastos importante. La automatización permite reducir estos costos.

Cómo evaluar: Siempre calcule el costo total de propiedad (TCO) durante varios años, teniendo en cuenta el crecimiento de los datos y las posibles operaciones de recuperación. No olvide el costo del tiempo de inactividad en caso de un fallo, que puede superar con creces los costos de la copia de seguridad.

Seguridad (Security)

En 2026, la seguridad de las copias de seguridad es tan importante, y a menudo más, que la seguridad del sistema principal. Las copias de seguridad comprometidas pueden utilizarse para extorsión o fuga de datos confidenciales.

- Cifrado: Los datos deben cifrarse tanto "en reposo" (at rest) en el almacenamiento como "en tránsito" (in transit) durante la transmisión. Utilice algoritmos fuertes (AES-256) y gestione las claves de cifrado.

- Control de acceso (IAM): Gestión estricta del acceso al almacenamiento de copias de seguridad. Utilice el principio de privilegio mínimo, autenticación multifactor (MFA) y control de acceso basado en roles (RBAC).

- Inmutabilidad (Immutable Storage): La capacidad de hacer que una copia de seguridad sea inmutable durante un período determinado. Esto evita la eliminación o modificación de copias por ransomware o atacantes.

- Aislamiento de red: Separación de la red de copias de seguridad de la red de producción principal.

- Auditoría y registro: Todas las operaciones con copias de seguridad deben registrarse y estar disponibles para auditoría.

Cómo evaluar: Verifique el cumplimiento de los estándares de seguridad (ISO 27001, SOC 2 Tipo 2) y las mejores prácticas. Asegúrese de que su proveedor o la solución elegida admita las medidas de protección necesarias.

Escalabilidad (Scalability)

Su sistema de copia de seguridad debe crecer con su negocio y el volumen de datos sin reestructuraciones significativas de la arquitectura.

- Volumen de datos: El sistema debe manejar fácilmente volúmenes de datos crecientes. Los almacenamientos en la nube son inherentemente escalables, pero las soluciones locales pueden requerir actualizaciones de hardware.

- Número de VPS: La capacidad de agregar fácilmente nuevos VPS al sistema de copia de seguridad, preferiblemente con detección y configuración automáticas.

- Rendimiento: El sistema debe mantener la velocidad de copia de seguridad y recuperación necesaria incluso bajo cargas máximas.

Cómo evaluar: Planifique con 3-5 años de antelación. ¿Qué volúmenes de datos espera? ¿Cuántos VPS tendrá en uno, tres, cinco años? Asegúrese de que la solución elegida pueda manejar este crecimiento sin costos significativos de reestructuración.

Facilidad de uso y administración (Simplicity & Management)

Un sistema de copia de seguridad complejo es un sistema que tarde o temprano fallará o será abandonado. La simplicidad reduce la probabilidad de errores humanos.

- Automatización: Máxima automatización de los procesos de copia de seguridad, recuperación y pruebas.

- Interfaz: Una interfaz intuitiva (GUI) o una API/CLI bien documentada para la gestión.

- Monitoreo y alertas: Integración con sistemas de monitoreo (Prometheus, Grafana, Zabbix) y alertas (Slack, PagerDuty) sobre el estado de las copias de seguridad.

- Documentación: Documentación clara y actualizada de todos los procedimientos.

Cómo evaluar: Realice una implementación piloto. ¿Qué tan fácil es configurar la copia de seguridad para un nuevo VPS? ¿Qué tan rápido se pueden restaurar los datos? ¿Cuánto tiempo lleva el monitoreo diario?

Integridad de los datos (Data Integrity)

El objetivo principal de la copia de seguridad es garantizar que los datos restaurados sean idénticos a los originales y funcionales.

- Verificaciones de suma de comprobación: Verificaciones automáticas de suma de comprobación al crear y restaurar copias de seguridad.

- Verificación: Las pruebas de recuperación regulares (ver más abajo) son la única forma fiable de verificar la integridad.

- Detección de corrupción: Mecanismos para detectar la corrupción de datos en el almacenamiento.

Cómo evaluar: Asegúrese de que su solución incluya mecanismos de verificación y de que los utilice regularmente.

Distribución geográfica (Geographic Distribution)

El almacenamiento de copias de datos en diferentes ubicaciones geográficas protege contra desastres regionales (incendios, inundaciones, terremotos) y fallos importantes en los centros de datos.

- Múltiples regiones: Almacenar al menos una copia de seguridad en otra región o incluso con otro proveedor. Este es un elemento clave de la estrategia "3-2-1".

- Velocidad de transmisión: Tenga en cuenta el ancho de banda y las latencias al transferir datos entre regiones.

Cómo evaluar: Determine la criticidad de los datos. Para la mayoría de los proyectos SaaS, almacenar una copia en una región adyacente es un buen compromiso. Para datos de alta criticidad, puede ser necesario almacenar en diferentes continentes.

Pruebas de recuperación (Recovery Testing)

Una copia de seguridad que no ha sido probada se considera inexistente. Las pruebas regulares no son una opción, sino un elemento obligatorio.

- Automatización de pruebas: Creación de entornos aislados para el despliegue automático de copias de seguridad y la verificación de su funcionalidad (por ejemplo, iniciar la aplicación, verificar la disponibilidad de la API).

- Frecuencia: Depende del RPO/RTO y la criticidad de los datos, pero al menos una vez al mes, y para sistemas críticos, semanalmente.

- Ciclo completo: Pruebas no solo de la restauración de archivos, sino de la funcionalidad completa del sistema/aplicación.

Cómo evaluar: Incluya las pruebas de recuperación en sus pipelines de CI/CD o configure tareas automatizadas separadas. Mantenga un registro de los resultados de las pruebas.

Tabla comparativa: Enfoques principales para la copia de seguridad de VPS

En 2026, existen numerosos enfoques para la copia de seguridad de VPS, cada uno con sus ventajas y desventajas. La elección depende de sus RPO/RTO, presupuesto, requisitos de seguridad y complejidad de la infraestructura. A continuación se presenta una tabla comparativa de las estrategias más populares y actuales.

| Criterio | Instantáneas de VPS (del proveedor) | Copia de seguridad basada en agente (a nivel de archivo/bloque) | Copia de seguridad de bases de datos (Dump/Replicación) | Sincronización de archivos (rsync/S3 CLI) | Copia de seguridad en la nube como servicio (BaaS) | Replicación de discos/imágenes (DRBD/ZFS send/receive) |

|---|---|---|---|---|---|---|

| RPO (Objetivo de Punto de Recuperación) | Bajo (a menudo 1-4 horas, depende del proveedor) | Muy bajo (de 5 minutos a 1 hora) | Muy bajo (de 0 a 15 minutos) | Medio (de 1 a 24 horas) | Bajo (de 15 minutos a 4 horas) | Muy bajo (casi cero, replicación síncrona) |

| RTO (Objetivo de Tiempo de Recuperación) | Muy bajo (5-30 minutos para restaurar todo el VPS) | Medio (1-4 horas para restaurar datos, más para VPS) | Bajo (30-60 minutos para la base de datos) | Alto (4-12 horas para restaurar datos) | Bajo (1-2 horas para restaurar VPS/datos) | Muy bajo (cambio a réplica en 5-30 minutos) |

| Complejidad de configuración | Baja (pocos clics en el panel) | Media (instalación de agente, configuración de programación) | Media (scripts, cron, monitoreo) | Baja (scripts básicos de rsync) | Baja (instalación de agente, interfaz web) | Alta (configuración de kernel, red, sincronización) |

| Costo (estimado 2026, por VPS/mes) | $5-$20 (depende del volumen del disco y del proveedor) | $10-$50 (depende del volumen, proveedor de BaaS o almacenamiento propio) | $0-$15 (solo almacenamiento, si es script propio) | $0-$10 (solo almacenamiento) | $20-$100 (depende del volumen, funciones, SLA) | $0-$20 (solo almacenamiento, si es script propio) + costo del segundo VPS |

| Flexibilidad de recuperación | Baja (recuperación de toda la imagen del VPS) | Alta (archivos individuales, directorios, sistema completo) | Alta (tablas individuales, recuperación a un punto en el tiempo) | Alta (archivos/directorios individuales) | Alta (archivos individuales, sistema completo, bare-metal) | Baja (recuperación de toda la imagen del VPS) |

| Protección contra ransomware | Media (si hay versionado, pero puede ser comprometido) | Alta (si se utiliza almacenamiento inmutable y versionado) | Alta (si los dumps se almacenan por separado, inmutablemente) | Baja (rsync puede sincronizar archivos infectados) | Muy alta (a menudo incluye inmutabilidad, detección de amenazas) | Baja (replica todo, incluido el malware) |

| Carga en el VPS durante la copia de seguridad | Baja (se ejecuta a nivel de hipervisor) | Media (uso de CPU/RAM para leer datos) | Media (exportación de datos, puede bloquear tablas) | Media (uso de CPU/RAM/I/O) | Media (uso de CPU/RAM para el agente) | Alta (sincronización constante, I/O) |

| Requisitos de almacenamiento | Dentro del proveedor (a menudo compatible con S3) | Compatible con S3, NFS, almacenamiento en bloques | Compatible con S3, disco local, NFS | Compatible con S3, disco local, NFS | Dentro del proveedor de BaaS | Almacenamiento en bloques (local o en red) |

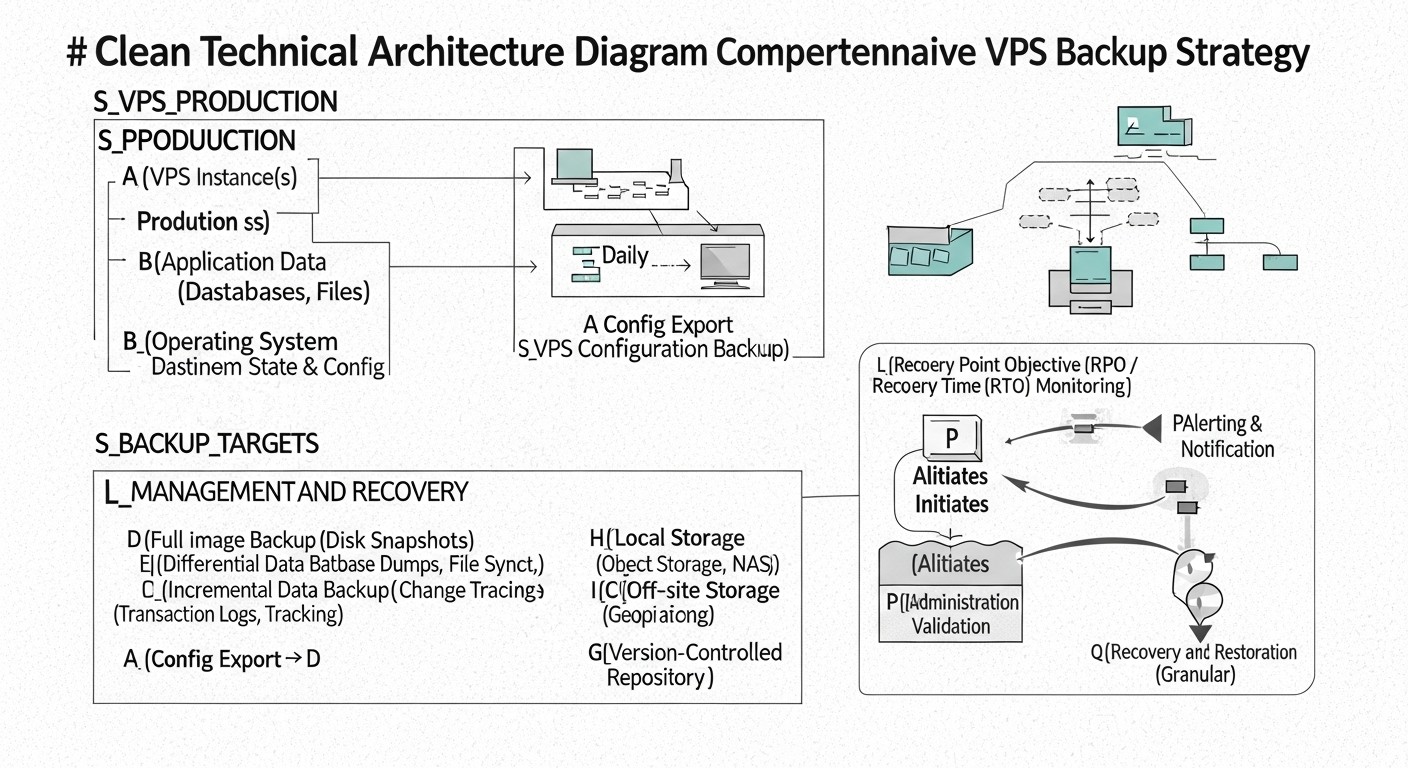

Revisión detallada de cada punto/opción de estrategia

Cada una de las estrategias de copia de seguridad mencionadas anteriormente tiene su nicho y aplicación óptima. Una revisión detallada le ayudará a comprender qué enfoque se adapta mejor a sus requisitos en 2026.

Instantáneas de VPS (Instantáneas del proveedor)

Descripción: Las instantáneas de VPS son una función proporcionada por la mayoría de los proveedores de alojamiento (DigitalOcean, Vultr, Hetzner Cloud, AWS EC2, Google Cloud Compute Engine). Crean una imagen de todo el disco del VPS en un momento determinado. Las instantáneas generalmente se toman a nivel de hipervisor, lo que minimiza la carga en el sistema operativo invitado. La recuperación de una instantánea significa revertir todo el VPS a un estado anterior. En 2026, muchos proveedores ofrecen una programación automática para las instantáneas y el almacenamiento de varias versiones.

Ventajas:

- Simplicidad: Máxima facilidad de configuración y uso. A menudo, unos pocos clics en el panel de control del proveedor son suficientes.

- Recuperación rápida: La restauración de todo el VPS lleva solo unos minutos, lo que proporciona un RTO bajo para la recuperación completa del sistema.

- Baja carga: Dado que la operación se realiza a nivel de hipervisor, el sistema operativo invitado prácticamente no se ve afectado.

- Rentabilidad: A menudo es una de las opciones de copia de seguridad más económicas, especialmente para VPS pequeños.

Desventajas:

- Baja flexibilidad de recuperación: Solo puede restaurar todo el VPS. La recuperación de archivos o carpetas individuales generalmente no es posible sin pasos intermedios (por ejemplo, montar la instantánea en otro VPS).

- Dependencia del proveedor: Está completamente vinculado a la infraestructura y la política de su proveedor de alojamiento. Si el proveedor experimenta un fallo a gran escala, sus copias de seguridad pueden no estar disponibles.

- RPO potencialmente alto: La frecuencia de las instantáneas es limitada (por ejemplo, cada 4-24 horas), lo que puede resultar en la pérdida de una cantidad significativa de datos si ocurre un fallo entre las instantáneas.

- Protección limitada contra ransomware: Si un atacante obtiene acceso al panel de control del proveedor, también puede eliminar las instantáneas. Algunos proveedores ofrecen protección contra la eliminación, pero esto no es universal.

Para quién es adecuado: Proyectos pequeños, entornos de prueba, blogs, y como primera línea de defensa para cualquier VPS. Complementa bien otras estrategias, pero rara vez es la única solución para sistemas de misión crítica.

Ejemplo de uso: Está ejecutando un pequeño proyecto SaaS en un solo VPS. Las instantáneas automáticas diarias del proveedor proporcionan un nivel básico de protección contra errores de configuración accidentales o fallos menores. Si algo sale mal, puede revertir rápidamente el VPS al estado del día anterior.

Copia de seguridad basada en agente (a nivel de archivo/bloque)

Descripción: Este enfoque implica la instalación de un agente especial dentro del sistema operativo invitado del VPS. El agente es responsable de recopilar datos, comprimirlos, cifrarlos y enviarlos a un almacenamiento remoto (almacenamiento compatible con S3, NFS, BaaS especializado). La copia de seguridad puede ser a nivel de archivo (copia de archivos/directorios individuales) o a nivel de bloque (copia de bloques de disco modificados). Los agentes modernos admiten copias de seguridad incrementales y diferenciales, así como la deduplicación de datos.

Ventajas:

- Alta flexibilidad de recuperación: Posibilidad de restaurar archivos individuales, directorios, bases de datos o todo el sistema. Se admite la recuperación "bare-metal".

- RPO bajo: Gracias a las copias de seguridad incrementales y la capacidad de ejecutarlas con alta frecuencia (cada 15-30 minutos), se puede lograr un RPO muy bajo.

- Multiplataforma: Los agentes suelen ser compatibles con varios sistemas operativos (Linux, Windows), lo que simplifica la gestión de un entorno heterogéneo.

- Protección contra ransomware: Con la configuración adecuada (almacenamiento inmutable, versionado, aislamiento de acceso), este es uno de los métodos más fiables de protección contra el ransomware.

- Eficiencia de almacenamiento: La deduplicación y la compresión reducen significativamente el volumen de datos almacenados y, en consecuencia, los costos.

Desventajas:

- Complejidad de configuración: Requiere la instalación y configuración del agente en cada VPS, así como la configuración de un servidor de gestión centralizado (si no es un BaaS).

- Carga en el VPS: El proceso de copia de seguridad consume recursos de CPU, RAM y E/S en el VPS, lo que puede afectar el rendimiento de la aplicación durante la ejecución.

- Costo: Las licencias de agentes propietarios y el costo de almacenamiento pueden ser más altos que los de las instantáneas simples.

- Gestión de agentes: Es necesario monitorear la actualidad de los agentes, su funcionalidad y las actualizaciones.

Para quién es adecuado: Sistemas de producción de misión crítica, proyectos SaaS con altos requisitos de RPO/RTO, entornos con grandes volúmenes de datos donde se necesita flexibilidad de recuperación y protección fiable contra ciberamenazas. Ejemplos de herramientas: Veeam Agent para Linux/Windows, Bacula, Bareos, Restic, BorgBackup.

Ejemplo de uso: Tiene un servidor de producción con una base de datos PostgreSQL y varios microservicios. Utiliza Veeam Agent para Linux, que cada 30 minutos realiza una copia de seguridad incremental de todos los directorios y bases de datos críticos, enviándolos a un almacenamiento compatible con S3 con inmutabilidad habilitada. En caso de fallo, puede restaurar tanto archivos de configuración individuales como todo el sistema en un nuevo VPS.

Copia de seguridad de bases de datos (Dump/Replicación)

Descripción: Este método se centra exclusivamente en los datos de las bases de datos, que a menudo son la parte más valiosa de cualquier aplicación. Incluye la creación de volcados lógicos (por ejemplo, usando pg_dump para PostgreSQL, mysqldump para MySQL) o el uso de mecanismos de replicación y copia de seguridad física incorporados (archivado WAL para PostgreSQL, Percona XtraBackup para MySQL). En 2026, las bases de datos gestionadas en la nube (AWS RDS, Google Cloud SQL) se utilizan activamente y proporcionan sus propios mecanismos de copia de seguridad y recuperación a un punto en el tiempo, simplificando significativamente la tarea.

Ventajas:

- RPO muy bajo para datos: Gracias al archivado continuo de registros WAL o la replicación por streaming, se puede lograr una pérdida de datos casi nula (RPO ~0).

- Alta flexibilidad de recuperación: Posibilidad de recuperación a un punto en el tiempo (point-in-time recovery), restauración de tablas o esquemas individuales.

- Independencia del sistema operativo: Los volcados y registros de la base de datos no dependen del estado del sistema de archivos del sistema operativo, lo que los hace más fiables para restaurar solo los datos.

- Herramientas especializadas: Herramientas como Barman para PostgreSQL o Percona XtraBackup para MySQL/MariaDB proporcionan alta eficiencia y fiabilidad.

Desventajas:

- Complejidad: La configuración y gestión de la replicación o el archivado de registros WAL requiere un conocimiento profundo del SGBD específico.

- Carga en la base de datos: La creación de volcados o la realización de copias de seguridad físicas puede generar una carga significativa en la base de datos.

- Solo datos: Este método no proporciona una copia de seguridad del sistema operativo o los archivos de la aplicación; debe combinarse con otras estrategias.

- Bloqueos potenciales: Los volcados lógicos pueden bloquear tablas durante la ejecución, lo cual es inaceptable para sistemas de alta carga.

Para quién es adecuado: Cualquier proyecto que utilice bases de datos relacionales o NoSQL donde la integridad y la pérdida mínima de datos sean críticas. Especialmente importante para proyectos SaaS con alta carga transaccional.

Ejemplo de uso: Gestiona una tienda en línea de alta carga que utiliza PostgreSQL. Ha configurado Barman para el archivado continuo de registros WAL en un almacenamiento remoto compatible con S3 y copias de seguridad físicas completas diarias. Si ocurre un fallo, puede restaurar la base de datos a cualquier punto en el tiempo con una precisión de segundos.

Sincronización de archivos (rsync/S3 CLI)

Descripción: Este método simple pero efectivo consiste en usar utilidades de línea de comandos, como rsync o clientes para almacenamiento en la nube (por ejemplo, AWS S3 CLI, Google Cloud Storage CLI), para sincronizar archivos y directorios con un almacenamiento remoto. rsync es muy eficiente, ya que solo transfiere las partes modificadas de los archivos. En 2026, estas herramientas siguen siendo relevantes debido a su simplicidad y fiabilidad.

Ventajas:

- Simplicidad: Fácil de configurar con scripts bash y tareas cron.

- Flexibilidad: Posibilidad de hacer copias de seguridad solo de los archivos y directorios necesarios, excluyendo los innecesarios.

- Eficiencia:

rsynctransfiere solo la delta de los cambios, lo que ahorra tráfico y tiempo. - Bajo costo: Utiliza utilidades estándar del sistema operativo, solo se paga por el almacenamiento.

Desventajas:

- Falta de versionado por defecto: Si no se configura manualmente,

rsyncsimplemente sobrescribe los archivos, lo que lo hace vulnerable al ransomware y la eliminación accidental. - Carga en el VPS: Durante la primera copia de seguridad completa o con un gran número de cambios, puede generar una carga significativa.

- No hay copia de seguridad de archivos abiertos:

rsyncpuede tener problemas al copiar archivos que están siendo utilizados activamente por otros procesos (por ejemplo, bases de datos, archivos de registro). - RTO alto para la recuperación completa: La restauración de todo el VPS requiere la instalación manual del sistema operativo, la configuración y luego la copia de los datos.

Para quién es adecuado: Copia de seguridad de archivos de configuración, datos de usuario, contenido estático, registros. Excelente para datos no críticos o como complemento a otras estrategias para preservar partes individuales del sistema.

Ejemplo de uso: Desea hacer una copia de seguridad regular de los archivos de configuración de su servidor web (/etc/nginx) y los archivos estáticos del sitio (/var/www/html). Utiliza rsync para enviar estos datos a un bucket remoto compatible con S3, configurando el versionado en el bucket para protegerse contra la sobrescritura.

Copia de seguridad en la nube como servicio (BaaS)

Descripción: BaaS (Backup as a Service) es una solución integral proporcionada por un tercero (por ejemplo, Acronis Cyber Protect Cloud, Veeam Backup & Replication (para entornos en la nube), Commvault, Rubrik). Usted paga por un servicio que se encarga de todos los aspectos de la copia de seguridad: agentes, almacenamiento, gestión, monitoreo, pruebas y recuperación. En 2026, las soluciones BaaS integran activamente AI/ML para la detección de anomalías y amenazas, y ofrecen capacidades avanzadas de recuperación, incluida la migración entre nubes.

Ventajas:

- Integridad y "llave en mano": El proveedor se encarga de todas las complejidades, desde la infraestructura hasta el soporte.

- Alta fiabilidad: Los proveedores de BaaS suelen ofrecer SLAs estrictos para RPO/RTO y garantizan la integridad de los datos.

- Funciones de seguridad avanzadas: Incluyen almacenamiento inmutable, cifrado, detección de ransomware, control de acceso.

- Facilidad de gestión: Panel de control centralizado, automatización, informes.

- Distribución global: Posibilidad de almacenar copias de seguridad en diferentes regiones e incluso países.

Desventajas:

- Alto costo: Suele ser la solución más cara, especialmente para grandes volúmenes de datos o altos requisitos de SLA.

- Dependencia del proveedor: Vinculación completa al ecosistema del proveedor de BaaS.

- Menor control: Tiene menos control sobre los aspectos de bajo nivel del almacenamiento y la gestión de datos.

- Posibles tarifas de egreso: Al restaurar grandes volúmenes de datos, pueden surgir costos significativos por el tráfico de salida.

Para quién es adecuado: Empresas que requieren el cumplimiento de estrictos requisitos regulatorios, empresas sin un equipo dedicado de DevOps/administradores de sistemas, grandes proyectos SaaS donde el tiempo de los ingenieros es más caro que el costo del servicio. Excelente para entornos con altos requisitos de seguridad y automatización.

Ejemplo de uso: Un proyecto SaaS mediano con varias decenas de VPS y estrictos requisitos de GDPR e ISO 27001. El uso de Acronis Cyber Protect Cloud permite gestionar centralizadamente las copias de seguridad de todos los VPS, proporciona un alto grado de protección contra ransomware y pruebas de recuperación automatizadas que cumplen con las normativas.

Replicación de discos/imágenes (DRBD/ZFS send/receive)

Descripción: Este enfoque implica la replicación de dispositivos de bloques (discos) o sistemas de archivos entre dos o más VPS. DRBD (Distributed Replicated Block Device) proporciona replicación síncrona o asíncrona de un dispositivo de bloques en Linux. ZFS send/receive permite replicar eficientemente instantáneas del sistema de archivos ZFS. Este método se utiliza a menudo para crear clústeres de alta disponibilidad o para una conmutación por error (failover) rápida a un servidor de respaldo. En 2026, las soluciones de contenedores y los operadores de Kubernetes también ofrecen sus propios mecanismos de replicación de volúmenes persistentes.

Ventajas:

- RPO muy bajo: Con la replicación síncrona, el RPO puede ser prácticamente cero.

- RTO muy bajo: En caso de fallo del servidor principal, se puede cambiar rápidamente a la réplica, lo que garantiza un tiempo de inactividad mínimo.

- Alta disponibilidad: Base para la construcción de clústeres de alta disponibilidad.

- Copia completa: Se replica toda la estructura de bloques o el sistema de archivos, incluido el sistema operativo y las aplicaciones.

Desventajas:

- Alta complejidad: Requiere un conocimiento profundo de los sistemas operativos, sistemas de archivos, protocolos de red y tecnologías de clúster. La configuración y el soporte pueden ser muy laboriosos.

- Altos requisitos de recursos: La replicación constante crea una carga en la red, E/S y CPU de ambos servidores. Para la replicación síncrona se requiere una baja latencia entre los servidores.

- Costo: Se requieren al menos dos VPS completos, lo que duplica los costos de infraestructura.

- Falta de protección contra errores lógicos: Si elimina datos accidentalmente o infecta el sistema con ransomware, estos cambios se replicarán en el servidor de respaldo.

Para quién es adecuado: Aplicaciones de misión crítica que requieren la máxima disponibilidad posible y un RPO/RTO mínimo, donde el tiempo de inactividad es inaceptable (por ejemplo, transacciones financieras, servicios de telecomunicaciones). A menudo se utiliza junto con otros métodos de copia de seguridad para proporcionar protección contra errores lógicos.

Ejemplo de uso: Gestiona una pasarela de pago donde cada segundo de inactividad cuesta decenas de miles de dólares. Utiliza DRBD para la replicación síncrona de datos entre dos VPS en el mismo centro de datos, lo que garantiza una conmutación instantánea en caso de fallo del hardware. Además, realiza instantáneas diarias de ZFS (si utiliza ZFS) y las envía a un almacenamiento remoto para protegerse contra errores lógicos.

Consejos prácticos y recomendaciones de implementación

La implementación de una estrategia de copia de seguridad eficaz requiere no solo la elección de las herramientas adecuadas, sino también el estricto cumplimiento de las mejores prácticas. En 2026, el énfasis se desplaza hacia la automatización, la seguridad y las pruebas regulares.

1. Siga la regla "3-2-1-1-0"

Este es el estándar de oro de la copia de seguridad, adaptado a las realidades modernas:

- 3 copias de datos: El original y dos copias de seguridad.

- 2 medios diferentes: Por ejemplo, un disco local y un almacenamiento en la nube.

- 1 copia fuera del sitio: Almacenada en otra región geográfica o con otro proveedor.

- 1 copia sin conexión/inmutable: Una copia que no se puede modificar ni eliminar (por ejemplo, en cinta, en S3 Glacier Deep Archive con bloqueo de objetos, o en un disco sin acceso a la red). Esto es fundamental para la protección contra el ransomware.

- 0 errores en la recuperación: Garantía de que sus copias de seguridad son funcionales y se restauran sin problemas. Se logra mediante pruebas regulares.

Práctica: Combine instantáneas del proveedor (una copia en un medio), copia de seguridad basada en agente en un almacenamiento compatible con S3 (segunda copia en otro medio, con versionado e inmutabilidad) y archivado de los datos más críticos en S3 Glacier Deep Archive con bloqueo de objetos (tercera copia, sin conexión/inmutable, posiblemente en otra región).

2. Automatice todo lo posible

Las operaciones manuales son una fuente de errores e ineficiencia. Utilice herramientas de automatización para todas las etapas:

- Creación de copias de seguridad: Planificadores (cron), orquestadores (Ansible, Terraform, SaltStack).

- Transferencia de datos: Scripts con

rsync,s3cmd,rclone. - Monitoreo: Integración con Prometheus, Grafana, Zabbix para rastrear el estado de las copias de seguridad.

- Pruebas de recuperación: Creación de entornos aislados (Docker, Kubernetes, VPS temporales) para la recuperación automática y la verificación de la funcionalidad.

Ejemplo de script para copia de seguridad automática de PostgreSQL y envío a S3:

#!/bin/bash

# Variables de entorno

DB_NAME="your_database_name"

DB_USER="your_db_user"

S3_BUCKET="s3://your-backup-bucket/postgresql/"

TIMESTAMP=$(date +"%Y%m%d%H%M%S")

BACKUP_FILE="/tmp/${DB_NAME}_${TIMESTAMP}.sql.gz"

RETENTION_DAYS=7 # Cuántos días almacenar las copias de seguridad locales

echo "Iniciando copia de seguridad de PostgreSQL para ${DB_NAME} en ${TIMESTAMP}..."

# 1. Creación del dump de la base de datos

pg_dump -U "${DB_USER}" "${DB_NAME}" | gzip > "${BACKUP_FILE}"

if [ $? -ne 0 ]; then

echo "Error al crear el dump de PostgreSQL."

exit 1

fi

echo "Dump de PostgreSQL creado: ${BACKUP_FILE}"

# 2. Envío del dump a S3

aws s3 cp "${BACKUP_FILE}" "${S3_BUCKET}${DB_NAME}_${TIMESTAMP}.sql.gz" --sse AES256

if [ $? -ne 0 ]; then

echo "Error al subir la copia de seguridad a S3."

exit 1

fi

echo "Copia de seguridad subida a S3: ${S3_BUCKET}${DB_NAME}_${TIMESTAMP}.sql.gz"

# 3. Eliminación de copias de seguridad locales con más de RETENTION_DAYS días

find /tmp/ -name "${DB_NAME}_*.sql.gz" -mtime +"${RETENTION_DAYS}" -delete

echo "Copias de seguridad locales antiguas eliminadas."

echo "Copia de seguridad de PostgreSQL finalizada con éxito."

Este script se puede ejecutar a través de cron. Asegúrese de que awscli esté configurado con los permisos de acceso adecuados y que las variables de entorno para la base de datos sean correctas.

3. Cifre los datos

Siempre cifre las copias de seguridad. Utilice cifrado "en reposo" (en el almacenamiento) y "en tránsito" (durante la transmisión). Los proveedores de la nube ofrecen cifrado del lado del servidor (SSE-S3, SSE-KMS), pero para una seguridad máxima, considere el cifrado del lado del cliente antes de enviar los datos al almacenamiento (por ejemplo, con GPG, Restic o BorgBackup).

Ejemplo de cifrado de un archivo antes de enviarlo:

# Cifrado de un archivo con GPG

gpg --batch --passphrase "YOUR_SUPER_SECRET_PASSPHRASE" --symmetric --cipher-algo AES256 -o my_data.tar.gz.gpg my_data.tar.gz

# Descifrado

gpg --batch --passphrase "YOUR_SUPER_SECRET_PASSPHRASE" -o my_data.tar.gz my_data.tar.gz.gpg

Almacene las claves de cifrado o las frases de contraseña en un lugar seguro, separado de las copias de seguridad (por ejemplo, en HashiCorp Vault, AWS Secrets Manager u otro KMS).

4. Implemente almacenamiento inmutable

Para protegerse contra el ransomware y la eliminación accidental, utilice almacenamientos con capacidad de "bloqueo de objetos" (Object Lock) o "almacenamiento inmutable" (Immutable Storage). Muchos almacenamientos compatibles con S3 (AWS S3, MinIO, Wasabi) ofrecen esta función. Esto permite establecer un período durante el cual un objeto no puede ser eliminado o modificado.

Ejemplo de configuración de Object Lock en AWS S3:

Al crear un bucket:

aws s3api create-bucket --bucket your-immutable-bucket --region us-east-1 --object-lock-enabled-for-new-objects

Al cargar un objeto con retain-until-date:

aws s3api put-object --bucket your-immutable-bucket --key my_backup.gz --body my_backup.gz --object-lock-mode COMPLIANCE --object-lock-retain-until-date "2026-12-31T23:59:59Z"

El modo COMPLIANCE hace que el objeto sea inmutable incluso para la cuenta raíz de AWS hasta la fecha especificada.

5. Pruebe la recuperación regularmente

Una copia de seguridad no probada es una copia de seguridad inexistente. En 2026, las pruebas manuales son un anacronismo. Invierta en pruebas automatizadas.

- Cree un entorno aislado: Utilice VPS temporales, contenedores o máquinas virtuales para restaurar las copias de seguridad.

- Automatice la verificación: Después de la recuperación, ejecute scripts que verifiquen la integridad de los datos, inicien aplicaciones, verifiquen la disponibilidad de la API, la ejecución de consultas a la base de datos.

- Frecuencia: Para sistemas críticos, semanalmente; para otros, mensualmente.

- Documente: Mantenga un registro de todas las pruebas, incluido el tiempo de recuperación y los problemas detectados.

Ejemplo de concepto de prueba automatizada (pseudocódigo):

# Script test_recovery.sh

# 1. Iniciar un nuevo VPS/contenedor temporal

# (por ejemplo, a través de Terraform o Docker)

# 2. Descargar la última copia de seguridad de S3

# 3. Restaurar los datos en el VPS temporal

# 4. Instalar dependencias, iniciar la aplicación/BD

# 5. Ejecutar una serie de pruebas:

# - Verificar la presencia de archivos clave

# - Ejecutar consultas SQL a la BD restaurada

# - Realizar una solicitud HTTP a la API de la aplicación

# - Verificar los logs en busca de errores

# 6. Enviar un informe del resultado (éxito/fallo)

# 7. Eliminar el VPS/contenedor temporal

6. Monitoreo y alertas

Configure el monitoreo del estado de las copias de seguridad y las alertas sobre cualquier fallo. Integre con su sistema de monitoreo (Prometheus, Grafana, Zabbix, Datadog) y sistema de alertas (Slack, PagerDuty, Telegram).

- Qué monitorear: Éxito/fracaso de la copia de seguridad, tamaño de la copia de seguridad (cambios bruscos pueden indicar problemas), tiempo de ejecución, disponibilidad del almacenamiento.

- Alertas: Configure notificaciones sobre copias de seguridad perdidas, errores o si una copia de seguridad no se ha ejecutado durante más tiempo que el RPO establecido.

7. Gestión de acceso y principio de privilegio mínimo (Least Privilege)

Restrinja el acceso a los almacenamientos de copias de seguridad. Utilice cuentas IAM separadas con los derechos mínimos necesarios:

- La cuenta para la copia de seguridad solo debe tener derechos de escritura en el bucket, pero no de eliminación o modificación de objetos existentes (si no se utiliza la inmutabilidad).

- La cuenta para la recuperación debe tener derechos de lectura.

- Utilice MFA para todos los accesos administrativos.

- Realice auditorías de derechos de acceso regularmente.

8. Documente los procedimientos

Documente detalladamente todo el procedimiento de copia de seguridad y recuperación. Esto es fundamental para la transferencia de conocimientos y para garantizar una recuperación rápida en una situación de estrés. Incluya:

- Descripción de las herramientas utilizadas y su configuración.

- Programación de copias de seguridad y RPO/RTO para cada componente.

- Instrucciones paso a paso para la recuperación de diferentes escenarios (archivo individual, base de datos, todo el VPS).

- Contactos de las personas responsables.

- Registros de pruebas de recuperación.

Errores comunes en la organización de la copia de seguridad y cómo evitarlos

Incluso los ingenieros más experimentados pueden cometer errores al organizar la copia de seguridad. En 2026, a medida que los sistemas se vuelven cada vez más complejos, estos errores pueden tener consecuencias catastróficas. Examinemos los más comunes y cómo prevenirlos.

1. Ausencia o pruebas de recuperación irregulares

Error: "Hay copias de seguridad, así que todo está bien." Muchas empresas crean copias de seguridad, pero nunca verifican si se pueden restaurar. En el momento de un fallo real, se descubre que las copias de seguridad están dañadas, incompletas o el proceso de recuperación no funciona.

Consecuencias: Tiempo de inactividad prolongado, pérdida total de datos, pérdidas de reputación y financieras.

Cómo evitarlo: Implemente pruebas de recuperación automatizadas y regulares. Para sistemas de misión crítica, semanalmente; para otros, mensualmente. Cree entornos de prueba aislados, restaure datos y verifique la funcionalidad de las aplicaciones. Documente cada prueba.

2. Almacenamiento de todas las copias en un solo lugar o con un solo proveedor

Error: Todas las copias de seguridad se almacenan en el mismo VPS, en el mismo centro de datos o incluso en la misma región de la nube que el servidor principal. Algunos proveedores ofrecen "copias de seguridad automáticas", pero a menudo se almacenan en el mismo centro de datos.

Consecuencias: Desastres regionales (incendio, inundación, fallo masivo del proveedor) o el compromiso de la cuenta pueden llevar a la pérdida simultánea tanto del sistema principal como de todas las copias de seguridad.

Cómo evitarlo: Siga la regla "3-2-1-1-0". Almacene al menos una copia de seguridad fuera del sitio, preferiblemente con otro proveedor o en otra región geográfica. Esto reduce el riesgo de un único punto de fallo.

3. Falta de protección contra el ransomware

Error: Las copias de seguridad son accesibles para escritura desde el entorno de producción o carecen de versionado/inmutabilidad. El ransomware, una vez que penetra en el sistema, puede cifrar o eliminar no solo los datos de trabajo, sino también todas las copias de seguridad disponibles.

Consecuencias: Imposibilidad de recuperar datos, necesidad de pagar un rescate (sin garantía de recuperación), fuga de datos.

Cómo evitarlo: Utilice almacenamiento inmutable (Object Lock en S3, almacenamientos WORM). Implemente un control de acceso estricto (IAM) con privilegios mínimos para las cuentas de copia de seguridad. Considere una "brecha de aire" (air gap) para los datos más críticos: una copia sin conexión que esté físicamente desconectada de la red.

4. Monitoreo y alertas insuficientes

Error: Las copias de seguridad están configuradas, pero nadie monitorea su estado. Errores en los scripts, desbordamiento de disco, problemas de acceso al almacenamiento pasan desapercibidos durante mucho tiempo.

Consecuencias: Detección de problemas con las copias de seguridad solo en el momento del fallo, cuando ya es demasiado tarde. Pérdida de datos durante el período en que las copias de seguridad no funcionaron.

Cómo evitarlo: Integre el sistema de copia de seguridad con su sistema de monitoreo (Prometheus, Zabbix). Configure alertas para cualquier fallo, copias de seguridad perdidas, así como cambios inusuales en el tamaño de las copias de seguridad (por ejemplo, una disminución brusca puede indicar un problema). Revise los registros de las copias de seguridad diariamente.

5. Incompatibilidad de RPO/RTO con los requisitos comerciales

Error: Se elige una estrategia de copia de seguridad que no cumple con las necesidades comerciales reales en cuanto a la pérdida de datos permitida (RPO) y el tiempo de recuperación (RTO). Por ejemplo, para un servicio en línea crítico, se elige una copia de seguridad diaria y una recuperación en 8 horas.

Consecuencias: Pérdidas de datos inaceptables o tiempo de inactividad demasiado prolongado, lo que resulta en pérdidas financieras significativas e insatisfacción del cliente.

Cómo evitarlo: Defina claramente el RPO y el RTO para cada componente de su sistema, basándose en el valor comercial de los datos y el tiempo de inactividad permitido. Elija una estrategia y herramientas que puedan cumplir con estas métricas. Revise regularmente estos requisitos con las partes interesadas.

6. Falta de cifrado de las copias de seguridad

Error: Las copias de seguridad se almacenan sin cifrar en un almacenamiento remoto. Esto puede deberse a la simplificación del proceso o a la subestimación de los riesgos.

Consecuencias: Fuga de datos confidenciales en caso de compromiso del almacenamiento o acceso no autorizado. Incumplimiento de los requisitos regulatorios (GDPR, HIPAA).

Cómo evitarlo: Siempre cifre las copias de seguridad. Utilice cifrado del lado del servidor (por ejemplo, SSE-S3 para AWS S3) o, para una seguridad máxima, cifrado del lado del cliente antes de enviar los datos al almacenamiento. Gestione las claves de cifrado en un lugar seguro (KMS, Vault).

7. Ignorar las bases de datos o copiarlas incorrectamente

Error: Enfocarse en la copia de seguridad del sistema de archivos del VPS, pero ignorar las particularidades de la copia de seguridad de las bases de datos. Copiar los archivos de la base de datos "directamente" sin detener la base de datos o usar herramientas especializadas puede llevar a copias inconsistentes o dañadas.

Consecuencias: La base de datos restaurada no se inicia, contiene datos dañados o no refleja el estado actual en el momento de la copia de seguridad.

Cómo evitarlo: Siempre utilice herramientas especializadas para la copia de seguridad de bases de datos (pg_dump, mysqldump, Percona XtraBackup, Barman, mecanismos integrados de bases de datos en la nube). Asegúrese de que las copias de seguridad sean consistentes y permitan restaurar la base de datos a un estado operativo.

8. Falta de documentación y "conocimiento en una sola persona"

Error: Toda la información sobre el sistema de copia de seguridad, incluidos los procedimientos de recuperación, se guarda en la cabeza de un solo ingeniero o en notas no estructuradas.

Consecuencias: Tiempo de inactividad crítico o imposibilidad total de recuperación en caso de ausencia del especialista clave (vacaciones, despido, enfermedad). Caos y pánico en una situación de estrés.

Cómo evitarlo: Documente detalladamente todos los aspectos del sistema de copia de seguridad y recuperación. Almacene la documentación en un sistema centralizado y accesible para el equipo (Confluence, Wiki, GitLab/GitHub Wiki). Actualice la documentación regularmente y realice simulacros de recuperación con la participación de diferentes miembros del equipo.

Lista de verificación para la aplicación práctica de la estrategia de copia de seguridad

Esta lista de verificación le ayudará a sistematizar el proceso de organización y verificación de su sistema de copia de seguridad de VPS, asegurándose de que ha tenido en cuenta todos los aspectos críticos.

- Definición de RPO y RTO:

- ✓ RPO y RTO definidos claramente para cada servicio/VPS crítico.

- ✓ Estas métricas están alineadas con los requisitos comerciales y las partes interesadas.

- Elección de la estrategia y las herramientas:

- ✓ Se ha elegido una o varias estrategias de copia de seguridad (instantáneas, agente, volcados de BD, BaaS) que cumplen con el RPO/RTO y el presupuesto.

- ✓ Se han seleccionado herramientas y proveedores específicos para implementar cada estrategia.

- Implementación de la regla "3-2-1-1-0":

- ✓ Se crean al menos 3 copias de datos (original + 2 copias de seguridad).

- ✓ Las copias se almacenan en 2 tipos de medios diferentes (por ejemplo, disco local + almacenamiento en la nube).

- ✓ Al menos 1 copia se almacena fuera del sitio (en otra región/con otro proveedor).

- ✓ Al menos 1 copia es inmutable o sin conexión (protección contra ransomware).

- Automatización:

- ✓ El proceso de creación de copias de seguridad está completamente automatizado (cron, Ansible, BaaS).

- ✓ El proceso de transferencia de datos al almacenamiento remoto está automatizado.

- ✓ El proceso de limpieza de copias de seguridad antiguas (gestión del ciclo de vida) está automatizado.

- Seguridad de los datos:

- ✓ Todas las copias de seguridad se cifran "en reposo" y "en tránsito".

- ✓ Las claves de cifrado se almacenan en un lugar seguro y aislado (KMS, Vault).

- ✓ Se han configurado políticas estrictas de IAM/RBAC para el acceso a los almacenamientos de copias de seguridad (principio de privilegio mínimo).

- ✓ Se utiliza autenticación multifactor (MFA) para el acceso administrativo.

- Integridad y consistencia de los datos:

- ✓ Para las bases de datos se utilizan métodos de copia de seguridad especializados (volcados, archivado WAL, instantáneas con quiescencia).

- ✓ Se verifica la consistencia de las copias de seguridad creadas (por ejemplo, sumas de comprobación).

- Monitoreo y alertas:

- ✓ Se ha configurado el monitoreo del éxito/fracaso de cada tarea de copia de seguridad.

- ✓ Se han configurado alertas sobre fallos, copias de seguridad perdidas o anomalías (por ejemplo, un cambio brusco en el tamaño de la copia de seguridad).

- ✓ El monitoreo está integrado con un sistema centralizado (Prometheus, Zabbix) y un sistema de alertas (Slack, PagerDuty).

- Pruebas de recuperación:

- ✓ Se ha desarrollado un plan y procedimientos para las pruebas de recuperación.

- ✓ Las pruebas de recuperación se realizan regularmente (semanal/mensual).

- ✓ Las pruebas incluyen un ciclo completo: recuperación, inicio de servicios, verificación de la funcionalidad.

- ✓ Los resultados de las pruebas se documentan y analizan.

- ✓ El proceso de prueba está lo más automatizado posible.

- Documentación:

- ✓ Toda la arquitectura de copia de seguridad y recuperación está documentada.

- ✓ Las instrucciones detalladas paso a paso para la recuperación de diferentes escenarios están disponibles y actualizadas.

- ✓ Se ha especificado la información de contacto de las personas responsables.

- Gestión del ciclo de vida y retención:

- ✓ Se ha definido la política de retención de copias de seguridad (cuántas copias, durante cuánto tiempo, para qué datos).

- ✓ Se ha configurado la eliminación automática de copias de seguridad antiguas de acuerdo con la política de retención.

- ✓ Se han tenido en cuenta los requisitos regulatorios para el almacenamiento de datos.

- Escalabilidad y rendimiento:

- ✓ El sistema de copia de seguridad es capaz de escalar con el crecimiento de los datos y el número de VPS.

- ✓ El rendimiento de la copia de seguridad y la recuperación cumple con el RPO/RTO sin una carga significativa en los sistemas de producción.

- Presupuesto:

- ✓ Se ha calculado el costo total de propiedad (TCO), incluyendo almacenamiento, tráfico, operaciones, licencias y administración.

- ✓ Se han tenido en cuenta los posibles costos ocultos (por ejemplo, tarifas de egreso en la recuperación).

Análisis de costos / Economía de la copia de seguridad

El costo de la copia de seguridad no es solo el gasto directo en almacenamiento, sino un conjunto completo de factores, que incluyen el tráfico, las operaciones, las licencias y la mano de obra. En 2026, en el contexto de la continua disminución de los precios de almacenamiento, los costos de las operaciones y el tráfico de salida, así como el costo del tiempo de inactividad, que puede superar con creces todos los gastos de la copia de seguridad, desempeñan un papel cada vez más importante. Un cálculo económico correcto permite optimizar los costos sin comprometer la fiabilidad.

Principales partidas de gastos

- Costo de almacenamiento de datos (Storage Cost):

- Precio por GB/TB al mes. Diferentes clases de almacenamiento (caliente, frío, archivo) tienen diferentes costos y velocidades de acceso. Por ejemplo, S3 Standard, S3 Infrequent Access, S3 Glacier, S3 Glacier Deep Archive.

- Es importante considerar no solo el volumen de datos activos, sino también el número de versiones/réplicas, así como la duración del almacenamiento (política de retención).

- Costo de transferencia de datos (Data Transfer Cost):

- Tráfico de entrada (Ingress): Generalmente gratuito en la mayoría de los proveedores de la nube.

- Tráfico de salida (Egress): Puede ser muy caro. Se cobra al leer datos del almacenamiento (por ejemplo, durante la recuperación) o al transferir entre regiones/proveedores. Esta es una de las partidas de gastos "ocultas".

- Costo de operaciones (API Requests/Operations Cost):

- Muchos almacenamientos en la nube cobran por el número de operaciones de lectura (GET) y escritura (PUT) de datos.

- Para las soluciones BaaS, esto puede abstraerse como "por VPS" o "por volumen de datos", pero para la configuración independiente (por ejemplo, con S3) es un factor importante. Un gran número de archivos pequeños o copias de seguridad incrementales frecuentes pueden generar muchas operaciones.

- Costo de licencias de software:

- Para soluciones propietarias (Veeam, Acronis BaaS), el costo de la licencia puede ser significativo, a menudo se cobra por VPS o por el volumen de datos protegidos.

- Las soluciones de código abierto (Restic, BorgBackup) no tienen costos de licencia directos, pero requieren más mano de obra para la configuración y el soporte.

- Mano de obra (Operational Overhead):

- Tiempo de los ingenieros dedicado al diseño, configuración, monitoreo, pruebas y resolución de problemas.

- La automatización reduce estos costos, pero las inversiones iniciales en el desarrollo de scripts y pipelines pueden ser significativas.

- Costo del tiempo de inactividad (Downtime Cost):

- Esta es una partida de gastos indirecta, pero potencialmente la más grande. Incluye la pérdida de ingresos, multas por SLA, pérdida de reputación, disminución de la productividad de los empleados.

- Directamente proporcional al RTO y la criticidad del servicio.

Ejemplos de cálculos para diferentes escenarios (2026, precios aproximados)

Para simplificar, asumiremos los siguientes precios hipotéticos para 2026:

- Almacenamiento S3 Standard: $0.020/GB/mes

- S3 Infrequent Access (IA): $0.0125/GB/mes

- S3 Glacier: $0.004/GB/mes

- S3 Egress (tráfico de salida): $0.08/GB

- Solicitudes S3 PUT: $0.005/1000 solicitudes

- Solicitudes S3 GET: $0.0004/1000 solicitudes

- Licencia BaaS: $15/VPS/mes (para 100GB)

- Costo de ingeniero: $50/hora

Escenario 1: Pequeño proyecto SaaS (1 VPS, 200 GB de datos)

Estrategia: Instantáneas diarias del proveedor + copia de seguridad semanal basada en agente en S3 IA con versionado e inmutabilidad.

- Instantáneas del proveedor: $10/mes (por 200 GB).

- Copia de seguridad basada en agente (Restic en S3 IA):

- Volumen de datos: 200 GB. La compresión y deduplicación de Restic reducen a 100 GB de datos almacenados (durante 4 semanas, 4 copias de seguridad completas).

- Almacenamiento S3 IA: 100 GB * $0.0125/GB/mes = $1.25/mes.

- Operaciones S3: ~5000 PUT (semanalmente) + ~1000 GET (monitoreo) = $0.025 + $0.0004 = ~$0.03/mes.

- Tráfico: Copia de seguridad semanal de 200 GB (si es completa, pero Restic es incremental, supongamos 5 GB de cambios) * 4 semanas = 20 GB. 20 GB * $0.00 (entrada gratuita) = $0.00.

- Recuperación (hipotética): 1 vez al año, 100 GB de egreso * $0.08/GB = $8.00/año = $0.67/mes.

- Mano de obra: 4 horas para configurar Restic y scripts ($200), 1 hora al mes para monitoreo y mantenimiento ($50). Total ~$67/mes (distribuido anualmente).

Costo total: $10 (instantáneas) + $1.25 (almacenamiento) + $0.03 (operaciones) + $0.67 (egreso) + $67 (mano de obra) = ~$78.95/mes.

Escenario 2: Proyecto SaaS mediano (5 VPS, 1 TB de datos en cada uno, bases de datos críticas)

Estrategia: Solución BaaS (por ejemplo, Acronis) para todos los VPS + Barman para PostgreSQL con archivado de registros WAL en S3 Glacier.

- BaaS para 5 VPS (5 TB de datos):

- Licencia BaaS: 5 VPS * $30/VPS/mes (para 1 TB) = $150/mes. (A menudo, BaaS incluye almacenamiento y operaciones).

- Tráfico/operaciones adicionales: Supongamos que están incluidos en BaaS o son insignificantes.

- Barman para PostgreSQL (1 TB de datos, 50 GB WAL/día):

- Almacenamiento de copias de seguridad completas (1 TB) en S3 Glacier: 1 TB * $0.004/GB/mes = $4/mes.

- Almacenamiento de registros WAL (50 GB/día * 30 días = 1.5 TB/mes) en S3 Glacier: 1.5 TB * $0.004/GB/mes = $6/mes.

- Operaciones S3 Glacier: Insignificantes, ya que el acceso es raro.

- Tráfico: Registros WAL 1.5 TB/mes * $0.00 (entrada gratuita) = $0.00. Recuperación (hipotética): 1 vez al año, 1 TB de egreso * $0.08/GB = $80/año = $6.67/mes.

- Mano de obra: 20 horas para configurar BaaS y Barman ($1000), 5 horas al mes para monitoreo y pruebas ($250). Total ~$333/mes (distribuido anualmente).

Costo total: $150 (BaaS) + $4 (Glacier Completo) + $6 (Glacier WAL) + $6.67 (Glacier Egreso) + $333 (mano de obra) = ~$499.67/mes.

Escenario 3: Clúster de alta carga (10 VPS, 5 TB de datos, RPO/RTO muy bajos)

Estrategia: Replicación de discos (DRBD) para alta disponibilidad + copia de seguridad basada en agente (Veeam Agent) en S3 IA con inmutabilidad y BaaS para archivado.

- Replicación DRBD: Requiere 10 VPS adicionales. Costo de 10 VPS = $200-$500/mes (depende del proveedor).

- Veeam Agent (10 VPS, 5 TB de datos):

- Licencia Veeam Agent: 10 VPS * $10/VPS/mes = $100/mes.

- Almacenamiento S3 IA: 5 TB * $0.0125/GB/mes = $62.5/mes.

- Operaciones S3: ~20000 PUT + ~5000 GET = $0.1 + $0.002 = ~$0.1/mes.

- Tráfico: Copias de seguridad incrementales diarias (supongamos 100 GB/día) * 30 días = 3 TB. 3 TB * $0.00 = $0.00.

- Recuperación: 2 veces al año, 5 TB de egreso * $0.08/GB = $400/año = $33.33/mes.

- BaaS para archivado (por ejemplo, Acronis con almacenamiento en frío, 5 TB): $100/mes (por 5 TB).

- Mano de obra: 40 horas para configurar DRBD, Veeam, BaaS ($2000), 10 horas al mes para monitoreo, pruebas, soporte ($500). Total ~$667/mes (distribuido anualmente).

Costo total: $350 (VPS adicionales) + $100 (Veeam) + $62.5 (S3 IA) + $0.1 (Operaciones S3) + $33.33 (S3 Egreso) + $100 (Archivo BaaS) + $667 (mano de obra) = ~$1312.93/mes.

Cómo optimizar los costos

- Política de retención: No almacene copias de seguridad para siempre, a menos que lo exijan las regulaciones. Determine cuántas versiones y durante cuánto tiempo necesita almacenar, y configure la eliminación automática de copias antiguas.

- Clases de almacenamiento: Utilice diferentes clases de almacenamiento para diferentes tipos de copias de seguridad. "Calientes" (S3 Standard) para una recuperación rápida, "frías" (S3 IA) para almacenamiento a largo plazo, "de archivo" (Glacier) para almacenamiento muy prolongado con acceso raro.

- Deduplicación y compresión: Herramientas como Restic, BorgBackup, Veeam Agent reducen eficazmente el volumen de datos almacenados.

- Monitoreo de tarifas de egreso: Esté atento a los costos del tráfico de salida. Si recupera grandes volúmenes de datos con frecuencia, esto puede convertirse en la partida más cara. Evalúe el RTO y el RPO para evitar costos excesivos en recuperaciones rápidas pero caras.

- Automatización de la mano de obra: Invierta en scripts, Infraestructura como Código (Terraform, Ansible) para automatizar la configuración y la gestión. Esto reduce los costos operativos constantes.

- Evaluación del TCO: Siempre calcule el costo total de propiedad (Total Cost of Ownership) durante varios años, no solo los pagos mensuales. Tenga en cuenta el costo del tiempo de inactividad.

Tabla con ejemplos de cálculos (simplificado, para copia de seguridad mensual de 100GB)

| Parámetro | Instantáneas de VPS | Restic + S3 IA | Acronis BaaS |

|---|---|---|---|

| Volumen de datos (original) | 100 GB | 100 GB | 100 GB |

| Volumen de datos (almacenado, después de compresión/deduplicación) | 100 GB | ~50 GB | ~50 GB |

| Costo de almacenamiento/licencia | $5.00 | $0.63 (S3 IA) | $20.00 |

| Costo de operaciones (estimado) | $0.00 | $0.01 | Incluido |

| Costo de egreso (estimado, 1 recuperación/año) | $0.00 | $0.33 | $0.50 (depende del proveedor) |

| Mano de obra (estimado/mes) | $20.00 | $50.00 | $10.00 |

| Costo total/mes (estimado) | $25.00 | $50.97 | $30.50 |

Esta tabla demuestra que las soluciones BaaS pueden ser más caras en costos directos de licencias, pero reducen significativamente la mano de obra, lo que en última instancia puede hacerlas más rentables para empresas donde el tiempo de los ingenieros es valioso. Las instantáneas de VPS son las más baratas, pero tienen limitaciones. La configuración independiente con Restic + S3 puede ser ventajosa en costos directos de almacenamiento, pero requiere más tiempo de administración.

Casos de estudio y ejemplos de la práctica real

La teoría es importante, pero los casos reales muestran cómo se aplican las diferentes estrategias de copia de seguridad en la práctica y qué resultados producen. Consideremos algunos escenarios relevantes para 2026.

Caso 1: Startup con plataforma SaaS para pequeñas empresas

Descripción del proyecto: La joven startup "SmartCRM" ofrece una solución SaaS para la gestión de clientes. La plataforma funciona en 5 VPS: uno para el servidor web (Nginx, PHP-FPM), uno para la API (Node.js), uno para PostgreSQL, uno para Redis y uno para tareas en segundo plano (RabbitMQ, Celery). El volumen total de datos es de aproximadamente 2 TB, la base de datos ocupa 500 GB. RPO para los datos de CRM: 1 hora, RTO: 4 horas. El presupuesto es limitado, pero la seguridad de los datos de los clientes es crítica.

Problema: Necesidad de garantizar una copia de seguridad fiable y una recuperación rápida con recursos limitados y un volumen de datos creciente. La protección básica del proveedor es insuficiente.

Solución: Estrategia híbrida que combina simplicidad y fiabilidad.

- Instantáneas diarias del proveedor (a nivel de VPS): Para los 5 VPS. Esto proporciona una reversión rápida de todo el servidor en caso de un error de configuración grave o un fallo del sistema operativo. Las instantáneas se almacenan durante 7 días. Costo: ~$50/mes.

- Copia de seguridad basada en agente para el sistema de archivos (Restic): Restic está instalado en todos los VPS. Las copias de seguridad incrementales diarias de los directorios clave (

/etc,/var/www,/opt/app, registros) se envían a S3 Infrequent Access. En S3 se habilita el versionado y el Bloqueo de Objetos durante 30 días para protegerse contra el ransomware. Restic proporciona deduplicación y cifrado de datos. Costo de S3: ~$30/mes. - Copia de seguridad de PostgreSQL (Barman): Para la base de datos se configura Barman, que realiza copias de seguridad completas semanales y archiva continuamente los registros WAL en otro bucket de S3 (S3 Standard, luego pasa a S3 IA). Esto permite la recuperación a un punto en el tiempo con un RPO de unos pocos minutos. Costo de S3 para la base de datos: ~$40/mes.

- Monitoreo: Todos los scripts de copia de seguridad están integrados con Prometheus/Grafana para rastrear el éxito de la ejecución y el tamaño de las copias de seguridad. Alertas en Slack en caso de fallos.

- Pruebas: Una vez al mes se ejecuta automáticamente un script que levanta un VPS temporal, restaura la última copia de seguridad completa (archivos + base de datos), ejecuta pruebas básicas de la aplicación y elimina el VPS.

Resultados:

- RPO/RTO: RPO para archivos ~24 horas (Restic), para base de datos ~15 minutos. RTO para recuperación completa ~3 horas (gracias a la automatización).

- Seguridad: Alto nivel de protección contra ransomware gracias a la inmutabilidad de S3 y el cifrado de Restic.

- Costo: El costo total de la infraestructura de copia de seguridad fue de aproximadamente ~$150/mes, más la mano de obra para la configuración. Esto permitió ajustarse al presupuesto de la startup, al tiempo que se garantizaba un alto nivel de fiabilidad.

- Experiencia: En un caso, hubo un error al actualizar Nginx que provocó la caída del servidor web. Gracias a las instantáneas del proveedor, el VPS se restauró en 15 minutos a un estado operativo. En otro caso, un desarrollador eliminó accidentalmente datos críticos de la base de datos. Gracias a Barman, la base de datos se restauró a un punto 5 minutos antes del incidente, con una pérdida mínima de datos.

Caso 2: Gran plataforma de comercio electrónico con alta disponibilidad

Descripción del proyecto: "MegaShop" es una gran plataforma de comercio electrónico con millones de usuarios. La infraestructura está distribuida en más de 20 VPS que operan en un clúster. El volumen de datos es de decenas de TB, incluyendo una enorme base de datos de productos, pedidos y datos de usuario. RPO: unos pocos minutos, RTO: menos de 30 minutos. El tiempo de inactividad es inaceptable, cada minuto de inactividad representa millones de dólares en pérdidas. Cumplimiento de PCI DSS y otros requisitos regulatorios.

Problema: Garantizar la continuidad del negocio, RPO/RTO mínimos, escalabilidad y cumplimiento de estrictos estándares de seguridad con enormes volúmenes de datos.

Solución: Estrategia multinivel y altamente automatizada con énfasis en BaaS y replicación.

- Replicación de bases de datos (PostgreSQL Streaming Replication): La base de datos principal se replica en un servidor de respaldo en caliente en otra AZ (Zona de Disponibilidad) en modo streaming. Esto proporciona un RPO y RTO prácticamente nulos gracias a la rápida conmutación por error a la réplica. Además, se utiliza Barman para el almacenamiento a largo plazo de los registros WAL y las copias de seguridad completas en S3 Glacier con Bloqueo de Objetos.

- Copia de seguridad en la nube como servicio (BaaS, por ejemplo, Veeam Backup & Replication para entornos en la nube): Para todos los VPS (SO, aplicaciones, configuraciones) se utiliza una solución BaaS. Proporciona copias de seguridad incrementales cada 15 minutos, almacenamiento en varias regiones, deduplicación, cifrado y protección contra ransomware. Veeam también ofrece capacidades de recuperación a nivel de archivo individual y recuperación bare-metal. Costo de BaaS: ~$2000/mes.

- Instantáneas de discos/volúmenes gestionados: Para los volúmenes persistentes (PVs) utilizados en Kubernetes, se configuran instantáneas automáticas a nivel del proveedor de la nube. Estas instantáneas son el primer nivel de protección contra fallos rápidos.

- Monitoreo y orquestación: Todos los procesos de copia de seguridad y replicación están integrados con un sistema de monitoreo centralizado (Datadog) y orquestación (Ansible, Terraform). Los pipelines de CI/CD incluyen la verificación automática de las copias de seguridad.

- DRP (Plan de Recuperación ante Desastres): Se ha desarrollado y se prueba regularmente un plan de recuperación ante desastres, que incluye la conmutación por error a una región de respaldo. Las pruebas se realizan trimestralmente, simulando fallos reales.

Resultados:

- RPO/RTO: RPO para la base de datos prácticamente 0, para el sistema de archivos ~15 minutos. RTO para la conmutación por error a un clúster de respaldo ~15-20 minutos.

- Seguridad: Cumplimiento de PCI DSS y otros estándares gracias a la protección multinivel, el cifrado, la inmutabilidad y la auditoría.

- Costo: El costo total de la infraestructura de copia de seguridad y DR ascendió a varios miles de dólares al mes, pero esto se justifica por las pérdidas millonarias por el tiempo de inactividad.

- Experiencia: Durante un fallo grave en una de las regiones de la nube, ocurrido debido a un problema con el equipo de red del proveedor, la plataforma pudo cambiar a la región de respaldo en menos de 20 minutos, minimizando las pérdidas y preservando la reputación.

Caso 3: Equipo de DevOps que utiliza Kubernetes e infraestructura como código

Descripción del proyecto: Un equipo de DevOps gestiona una compleja arquitectura de microservicios en Kubernetes, desplegada en varios VPS. Todas las configuraciones se almacenan en Git. Los datos se almacenan en volúmenes persistentes (PVs), así como en bases de datos gestionadas en la nube. RPO: 1-4 horas, RTO: 2 horas.

Problema: ¿Cómo realizar copias de seguridad de manera eficiente en un entorno dinámico y contenerizado donde los VPS son efímeros y los datos son importantes?

Solución: Enfoque en datos y configuraciones, no en los propios VPS.

- Copia de seguridad de configuraciones (Git): Todos los manifiestos de Kubernetes, gráficos de Helm, playbooks de Ansible, configuraciones de Terraform se almacenan en repositorios de Git. Esta es la "copia de seguridad" de la configuración de la infraestructura como código.

- Copia de seguridad de volúmenes persistentes (Velero): Para la copia de seguridad de volúmenes persistentes (datos utilizados por los pods) se utiliza Velero. Realiza instantáneas de los PVs y copias de seguridad de los recursos de Kubernetes (deployments, services, configs). Las copias de seguridad se envían a S3 con Bloqueo de Objetos. Velero permite restaurar tanto recursos individuales como clústeres completos. Costo de S3: ~$100/mes.

- Copia de seguridad de bases de datos gestionadas: Para las bases de datos gestionadas en la nube (por ejemplo, AWS RDS, Google Cloud SQL) se utilizan mecanismos de copia de seguridad integrados con recuperación a un punto en el tiempo. Estas copias de seguridad son almacenadas por el proveedor con los SLA correspondientes. Costo del proveedor de la base de datos.

- Copia de seguridad sin conexión (S3 Glacier Deep Archive): Mensualmente se crea una copia de seguridad de archivo de todos los PVs y configuraciones críticos, que se envía a S3 Glacier Deep Archive con un Bloqueo de Objetos de larga duración.

- Pruebas automatizadas: En el pipeline de CI/CD se incluye una tarea que, una vez a la semana, despliega un nuevo clúster de Kubernetes vacío, restaura parte de las aplicaciones y datos desde la copia de seguridad con Velero, ejecuta pruebas de integración y luego elimina el clúster.

Resultados:

- RPO/RTO: RPO para PVs ~1 hora, RTO para la recuperación de parte del clúster ~1 hora.

- Flexibilidad: Posibilidad de restaurar microservicios individuales o todo el clúster.

- Eficiencia: Los VPS no se copian directamente, ya que son efímeros y pueden recrearse fácilmente a partir del código. El enfoque está en los datos y las configuraciones.

- Experiencia: Al actualizar Kubernetes, lo que provocó que algunos pods no funcionaran, el equipo pudo revertir rápidamente el clúster a un estado operativo anterior utilizando Velero, restaurando tanto los PVs como los recursos de Kubernetes.

Herramientas y recursos para una copia de seguridad eficiente

En 2026, el arsenal de herramientas para la copia de seguridad de VPS se ha vuelto aún más amplio y funcional. La elección de la herramienta adecuada depende de su infraestructura, presupuesto, requisitos de RPO/RTO y nivel de automatización. Aquí revisaremos las utilidades actuales, así como las herramientas para monitoreo y pruebas.

Utilidades para trabajar con copias de seguridad

-

Restic

- Descripción: Una herramienta potente, segura y eficiente para crear copias de seguridad cifradas y deduplicadas. Admite múltiples backends de almacenamiento (disco local, SFTP, S3, Azure Blob Storage, Google Cloud Storage y otros). Restic se centra en la consistencia y la seguridad.

- Características 2026: Comunidad activa, desarrollo constante, excelente soporte para almacenamiento en la nube, integración con Kubernetes (a través de operadores).

- Para quién: Ideal para la configuración independiente de copias de seguridad basadas en agente en VPS Linux, donde el ahorro de espacio, el cifrado y la flexibilidad son importantes.

- Ejemplo de uso:

restic backup --repo s3:s3.amazonaws.com/my-bucket --password-file /path/to/password.txt /var/www /etc/nginx

-

BorgBackup (Borg)

- Descripción: Similar a Restic, pero con énfasis en el rendimiento y la funcionalidad para repositorios locales y accesibles por SSH. También proporciona deduplicación, compresión y cifrado.

- Características 2026: Alta velocidad de operación, muy adecuado para grandes volúmenes de datos cuando el repositorio se encuentra en un servidor dedicado o NAS.

- Para quién: Usuarios que necesitan el máximo rendimiento y flexibilidad en la gestión de repositorios, especialmente si tienen su propio almacenamiento.

- Ejemplo de uso:

borg create --stats --compression lz4 /path/to/repo::my-backup-{now} /var/www /etc

-

Duplicity / Duply

- Descripción: Una herramienta antigua pero probada para copias de seguridad cifradas e incrementales. Admite múltiples backends. Duply es un wrapper para Duplicity que simplifica la configuración.

- Características 2026: Se desarrolla menos activamente en comparación con Restic/Borg, pero sigue siendo una solución fiable para quienes buscan estabilidad.

- Para quién: Para aquellos que ya están familiarizados con la herramienta, o para escenarios menos exigentes.

-

rsync

- Descripción: Utilidad universal para la sincronización de archivos y directorios. Transfiere solo las partes modificadas de los archivos, muy eficiente para la copia delta.

- Características 2026: Sigue siendo una herramienta indispensable para la sincronización simple y la creación de copias locales/remotas.

- Para quién: Para la copia de seguridad de archivos de configuración, contenido estático, o como parte de un script más complejo. Requiere la implementación manual del versionado.

- Ejemplo de uso:

rsync -avz --delete /var/www/html/ user@backup-server:/mnt/backups/web/

-

AWS CLI / S3cmd / rclone

- Descripción: Herramientas de línea de comandos para interactuar con almacenamientos en la nube (compatibles con S3). AWS CLI es el cliente oficial para AWS S3. S3cmd es para almacenamientos generales compatibles con S3. rclone es la "navaja suiza" para el almacenamiento en la nube, compatible con más de 40 proveedores de la nube diferentes.

- Características 2026: rclone se está convirtiendo en un estándar debido a su universalidad y soporte para funciones avanzadas (cifrado, caché, montaje).

- Para quién: Para enviar archivos al almacenamiento en la nube, gestionar objetos, usar Bloqueo de Objetos.

- Ejemplo de uso (rclone):

rclone sync /path/to/local/data my-s3-remote:my-bucket --config /path/to/rclone.conf --s3-object-lock-mode compliance --s3-object-lock-retain-until-date "2026-12-31T23:59:59Z"

-

Barman (Backup and Recovery Manager for PostgreSQL)

- Descripción: Herramienta profesional para gestionar la copia de seguridad y recuperación de PostgreSQL. Admite el archivado continuo de registros WAL, copias de seguridad completas e incrementales, recuperación a un punto en el tiempo.

- Características 2026: Es el estándar de facto para bases de datos PostgreSQL de alta carga, en desarrollo activo.

- Para quién: Cualquiera que utilice PostgreSQL en producción y requiera RPO/RTO bajos.

-

Percona XtraBackup (para MySQL/MariaDB)

- Descripción: Herramienta de código abierto para la copia de seguridad física "en caliente" de MySQL/MariaDB sin bloquear la base de datos.

- Características 2026: Herramienta indispensable para copias de seguridad físicas de bases de datos compatibles con MySQL.

- Para quién: Usuarios de MySQL/MariaDB que necesitan copias de seguridad consistentes sin tiempo de inactividad.

-

Velero (para Kubernetes)

- Descripción: Herramienta para la copia de seguridad y recuperación de recursos de Kubernetes y volúmenes persistentes. Funciona con proveedores de la nube a través de instantáneas de volumen.

- Características 2026: Herramienta estándar para copias de seguridad en el ecosistema de Kubernetes, en desarrollo activo.

- Para quién: Equipos que gestionan aplicaciones en Kubernetes.

Monitoreo y pruebas

-

Prometheus & Grafana

- Descripción: Prometheus es un sistema de monitoreo de series temporales. Grafana es una herramienta para la visualización de datos.

- Aplicación: Utilice Prometheus para recopilar métricas sobre el estado de las copias de seguridad (éxito, tamaño, tiempo de ejecución). Grafana para crear paneles que muestren el estado de todas las copias de seguridad.

- Ejemplo de métricas:

backup_status{job="restic_web_server"} 1(1 = éxito, 0 = fallo),backup_size_bytes{job="restic_web_server"} 123456789.

-

Zabbix / Nagios / Icinga