Construcción de un pipeline CI/CD universal para entornos híbridos: de VPS a Kubernetes

TL;DR

- **Entornos híbridos: la nueva realidad:** En 2026, la mayoría de las infraestructuras combinan VPS tradicionales con plataformas contenerizadas (Kubernetes, Docker Swarm), lo que requiere un CI/CD flexible.

- **Abstracción y automatización:** La clave del éxito es crear capas de abstracción que permitan que el CI/CD funcione independientemente de la plataforma de despliegue objetivo, utilizando la contenerización y IaC.

- **La elección de herramientas lo determina todo:** GitLab CI, GitHub Actions y Jenkins siguen siendo líderes, pero su configuración debe tener en cuenta la especificidad de la hibridez, desde el despliegue SSH hasta los Helm charts.

- **Seguridad y observabilidad: no son opcionales:** Los escáneres de seguridad integrados, el registro centralizado y la monitorización son fundamentales para mantener la estabilidad y proteger el pipeline.

- **Costo y escalabilidad:** El equilibrio entre las soluciones autoalojadas (Jenkins en VPS) y los servicios en la nube gestionados (GitHub Actions, GitLab SaaS) debe calcularse teniendo en cuenta el crecimiento del proyecto.

- **GitOps: el estándar de oro:** La adopción del enfoque GitOps con herramientas como ArgoCD o Flux simplifica la gestión de configuraciones y aumenta la transparencia de los despliegues en Kubernetes.

- **Desarrollo continuo:** El pipeline CI/CD es un organismo vivo. Requiere auditorías, optimizaciones y adaptaciones regulares a las nuevas tecnologías y necesidades del negocio.

Introducción

En 2026, el mundo del desarrollo de software continúa evolucionando rápidamente, y el concepto de "entorno híbrido" se ha convertido no solo en un término de moda, sino en una realidad omnipresente. Las empresas, desde startups hasta corporaciones, rara vez utilizan una única plataforma para sus aplicaciones. Con mayor frecuencia, vemos un panorama complejo donde los servicios heredados críticos pueden ejecutarse en los buenos y viejos Virtual Private Servers (VPS) o servidores dedicados, mientras que los nuevos microservicios y componentes escalables se despliegan en orquestadores de contenedores como Kubernetes o Docker Swarm, y parte de la funcionalidad incluso migra a funciones sin servidor (Serverless). Esta diversidad de infraestructura plantea desafíos únicos para los equipos de DevOps y los desarrolladores, especialmente en el contexto de la Integración Continua/Entrega Continua (CI/CD).

¿Por qué este tema es tan importante ahora? Primero, la eficiencia económica. Migrar todas las aplicaciones a Kubernetes suele ser un proceso prohibitivamente costoso y laborioso, especialmente para proyectos con presupuestos limitados o una base de código establecida. Los VPS siguen siendo una solución atractiva para muchos servicios de backend, bases de datos o incluso pequeños proyectos SaaS, donde la simplicidad y la previsibilidad superan la escalabilidad máxima. Segundo, la flexibilidad y la resiliencia. Los entornos híbridos permiten distribuir riesgos, aprovechar las ventajas de cada plataforma y modernizar gradualmente la infraestructura sin una "gran explosión". Tercero, la aceleración del desarrollo. Cuanto más rápido y fiable podamos entregar cambios a cualquiera de nuestros entornos, más rápido responderemos a los cambios del mercado y a las necesidades de los usuarios.

Este artículo pretende ser una guía exhaustiva para construir un pipeline CI/CD universal, capaz de gestionar eficazmente los despliegues en entornos tan heterogéneos. Analizaremos cómo abstraer la lógica de despliegue, qué herramientas son las más adecuadas para esta tarea, cómo garantizar la seguridad y la observabilidad, y cómo evitar errores comunes. ¿Para quién está escrito? Para ingenieros de DevOps que luchan diariamente con la heterogeneidad de la infraestructura; para desarrolladores Backend que desean comprender cómo su código llega a producción; para fundadores de proyectos SaaS que buscan optimizar costos y acelerar el Time-to-Market; para administradores de sistemas que buscan formas de automatizar; y, por supuesto, para directores técnicos de startups que toman decisiones estratégicas sobre la infraestructura.

Nuestro objetivo es proporcionar no solo razonamientos teóricos, sino recomendaciones concretas y aplicables en la práctica, respaldadas por ejemplos del mundo real y datos actualizados a 2026. Nos sumergiremos en los detalles, mostraremos comandos, configuraciones y le ayudaremos a crear un CI/CD fiable y eficiente que sirva de puente entre sus VPS y clústeres de Kubernetes, asegurando una entrega de valor sin interrupciones a sus usuarios.

Criterios clave y factores de elección de CI/CD para entornos híbridos

La elección y el diseño de un pipeline CI/CD para entornos híbridos no es simplemente la selección de una herramienta específica. Es una decisión estratégica que afectará la velocidad de desarrollo, la fiabilidad, la seguridad y, por supuesto, el costo total de propiedad. En 2026, a medida que la infraestructura se vuelve cada vez más compleja, es especialmente importante sopesar cuidadosamente los siguientes criterios:

1. Flexibilidad y adaptabilidad a diferentes entornos objetivo

Este es quizás el criterio más importante para entornos híbridos. El pipeline debe ser capaz de desplegar aplicaciones tanto en VPS clásicos (a través de SSH, Ansible, Docker Compose) como en clústeres de Kubernetes (a través de Helm, Kustomize, ArgoCD), y posiblemente también en funciones sin servidor o plataformas PaaS. Esto significa que el sistema CI/CD debe admitir una variedad de plugins, integraciones y métodos de autenticación. Es importante la capacidad de crear pasos modulares que puedan reutilizarse para diferentes tipos de despliegues, abstrayendo las especificidades de cada plataforma. Por ejemplo, el mismo artefacto (imagen Docker) debe estar listo para ser desplegado tanto con `docker run` en un VPS como a través de un Kubernetes Deployment.

2. Escalabilidad y rendimiento

A medida que el proyecto crece y aumenta el número de desarrolladores, microservicios y la frecuencia de los commits, el sistema CI/CD debe escalar sin problemas. Esto incluye la capacidad de ejecutar múltiples compilaciones paralelas, la asignación dinámica de agentes (runners) y el uso eficiente de los recursos. Para entornos híbridos, esto es especialmente relevante, ya que los agentes pueden distribuirse: parte en VPS para compilaciones locales, parte en Kubernetes para tareas más pesadas y parte en la nube. El rendimiento afecta directamente el Time-to-Market y la satisfacción de los desarrolladores. Es importante evaluar cómo el sistema maneja las cargas máximas y la rapidez con la que se inician nuevas compilaciones.

3. Seguridad y cumplimiento

En 2026, la ciberseguridad no es solo una característica, sino un pilar fundamental. El pipeline CI/CD es un punto de entrada potencial para ataques, por lo que debe estar lo más protegido posible. Esto incluye:

- **Gestión de secretos:** Almacenamiento y acceso seguros a claves API, contraseñas, tokens (por ejemplo, a través de HashiCorp Vault, Kubernetes Secrets o almacenes CI/CD integrados).

- **Aislamiento de compilaciones:** Ejecución de cada tarea en un entorno aislado (contenedores, VM temporales).

- **Escaneo de vulnerabilidades:** Integración de analizadores de código estáticos (SAST) y dinámicos (DAST), escáneres de imágenes de contenedores (Trivy, Snyk), así como verificación de dependencias.

- **Auditoría y registro:** Registro completo de todas las acciones en el pipeline para fines de auditoría y retrospectiva.

- **Control de acceso (RBAC):** Gestión detallada de los derechos de usuarios y equipos para acceder a los pipelines y su configuración.

4. Observabilidad y monitorización

"Lo que no se puede medir, no se puede gestionar." Un pipeline CI/CD eficaz debe proporcionar una imagen completa de lo que está sucediendo:

- **Estado de las compilaciones:** Interfaz clara para el seguimiento de tareas actuales y completadas.

- **Métricas:** Tiempo de ejecución de las etapas, frecuencia de compilaciones exitosas/fallidas, uso de recursos.

- **Registro:** Acceso centralizado a los registros de todas las etapas del pipeline.

- **Alertas:** Notificaciones sobre fallos, compilaciones lentas o eventos críticos.

5. Costo total de propiedad (TCO)

Esto no solo incluye los costos directos de licencias o servicios en la nube, sino también los gastos ocultos:

- **Tiempo de los ingenieros:** Configuración, soporte, depuración, capacitación. Un sistema complejo requiere más tiempo.

- **Infraestructura:** Costo de servidores, VM, recursos de red para soluciones autoalojadas.

- **Consumo de energía:** Relevante para grandes clústeres autoalojados.

- **Pérdidas por inactividad:** Un CI/CD ineficiente ralentiza el desarrollo, lo que lleva a la pérdida de ingresos.

6. Facilidad de uso para desarrolladores

El CI/CD debe ser una herramienta que facilite la vida a los desarrolladores, no que la complique. Una sintaxis de configuración sencilla e intuitiva, una retroalimentación rápida, la capacidad de ejecutar pruebas CI/CD localmente, una buena documentación y una comunidad activa, todo ello contribuye a la adopción y el uso eficaz del sistema. Cuanto menos tiempo dediquen los desarrolladores a depurar el CI/CD, más se centrarán en el código del producto.

7. Integraciones y ecosistema

El CI/CD moderno no existe en el vacío. Debe integrarse fácilmente con:

- **Sistemas de control de versiones:** Git (GitHub, GitLab, Bitbucket).

- **Sistemas de gestión de proyectos:** Jira, Asana.

- **Registros de artefactos:** Docker Hub, GitLab Registry, Nexus, Artifactory.

- **Proveedores de la nube:** AWS, GCP, Azure.

- **Herramientas de Infraestructura como Código (IaC):** Terraform, Ansible, Pulumi.

- **Herramientas de prueba:** JUnit, Selenium, Cypress.

- **Sistemas de alerta:** Slack, Telegram, PagerDuty.

Tabla comparativa de soluciones CI/CD populares para entornos híbridos (2026)

Esta tabla presenta las características clave y los datos orientativos para 2026 de las principales plataformas CI/CD utilizadas en entornos híbridos. Los datos de precios son aproximados y pueden variar significativamente según el volumen de uso y el plan tarifario.

| Criterio | GitLab CI/CD | GitHub Actions | Jenkins | CircleCI | ArgoCD (GitOps) | Tekton (Kubernetes-native) |

|---|---|---|---|---|---|---|

| **Tipo de solución** | Integrado (GitLab) | Integrado (GitHub) | Autoalojado / SaaS | SaaS | Kubernetes-native | Kubernetes-native |

| **Orientación a la hibridez** | Alta. Runners flexibles (compartidos/autoalojados/Kubernetes). | Alta. Runners flexibles (alojados por GitHub/autoalojados). | Máxima. Control total sobre los agentes. | Media. Runners autoalojados disponibles, pero el enfoque principal es SaaS. | Alta. Ideal para K8s, pero puede desplegar en VPS a través de un controlador GitOps. | Alta. Ideal para K8s, pero puede ejecutar comandos SSH. |

| **Gestión de secretos** | Integrado (Variables), HashiCorp Vault, K8s Secrets. | Integrado (Secrets), HashiCorp Vault, integración OIDC. | Integrado (Credenciales), HashiCorp Vault. | Integrado (Contextos), HashiCorp Vault. | Kubernetes Secrets, External Secrets Operator. | Kubernetes Secrets, Tekton Secrets. |

| **Escalabilidad de runners** | Autoescalado de runners de Kubernetes, Docker Machine. | Autoescalado de runners autoalojados, Scale Sets. | Asignación dinámica de agentes (EC2, K8s, Swarm). | Autoescalado de recursos en la nube. | Escala con el clúster K8s. | Escala con el clúster K8s. |

| **Soporte IaC (Terraform, Ansible)** | Excelente, plantillas integradas. | Excelente, muchas Actions. | Excelente, a través de plugins. | Buena, a través de órbitas. | Configuraciones IaC en Git (GitOps). | Configuraciones IaC como Tasks/Pipelines. |

| **Monitorización/Observabilidad** | Dashboards integrados, Prometheus, Grafana. | Registros integrados, OpenTelemetry. | Plugins (Prometheus, Grafana, ELK). | Dashboards integrados, API. | Dashboards integrados, Prometheus. | OpenTelemetry, monitorización K8s. |

| **Costo aproximado (2026)** | Gratis/Premium desde $19/mes/usuario. Autoalojado: solo infraestructura. | Gratis/Pago por uso (desde $0.008/min Linux). Autoalojado: solo infraestructura. | Gratis (Código Abierto). Infraestructura + administración. | Gratis/desde $15/mes (hasta 1000 compilaciones). | Gratis (Código Abierto). Infraestructura K8s. | Gratis (Código Abierto). Infraestructura K8s. |

| **Curva de aprendizaje** | Media. Sintaxis YAML. | Baja-media. Sintaxis YAML, Actions listas para usar. | Media-alta. Groovy, UI, plugins. | Baja-media. Sintaxis YAML. | Media. Conceptos específicos de Kubernetes. | Media-alta. Conceptos específicos de Kubernetes, CRD. |

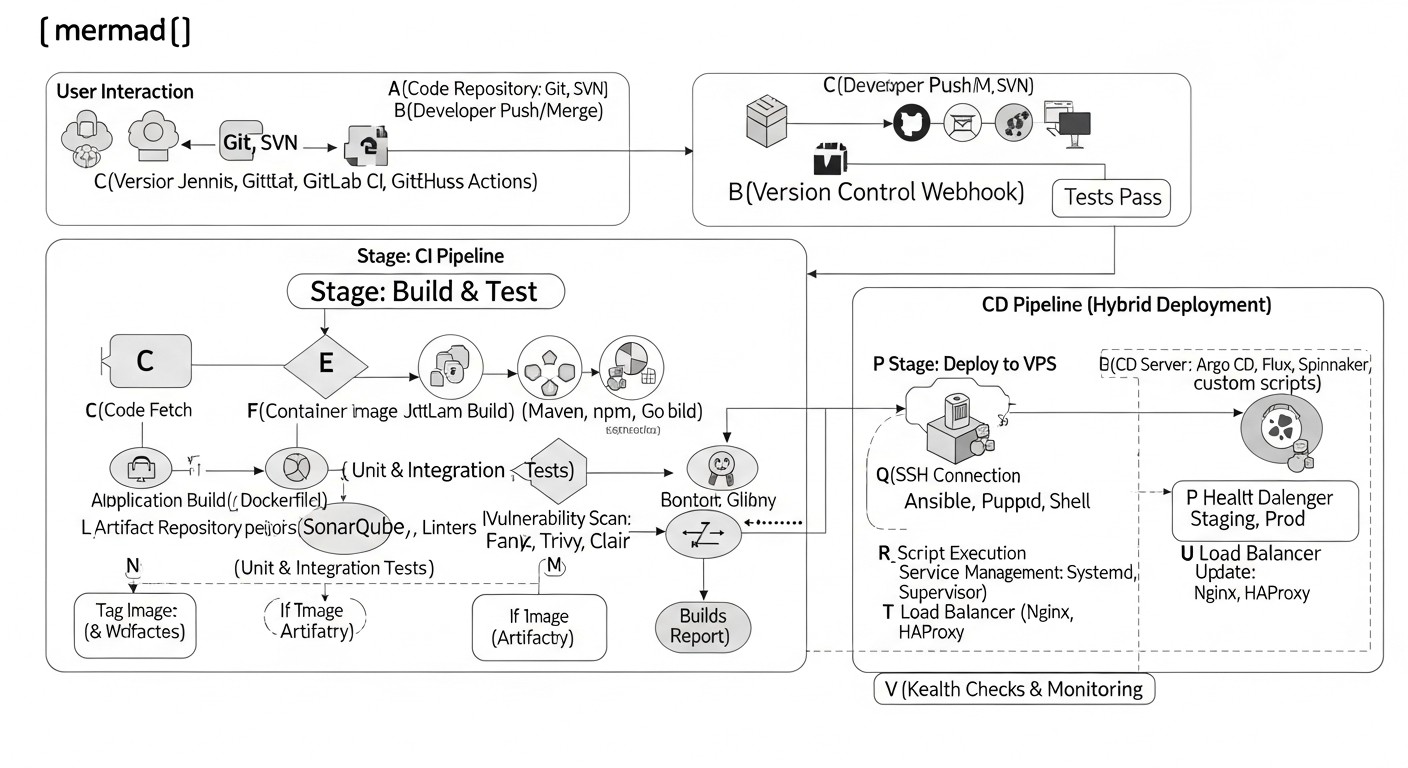

Revisión detallada de enfoques y opciones clave de CI/CD

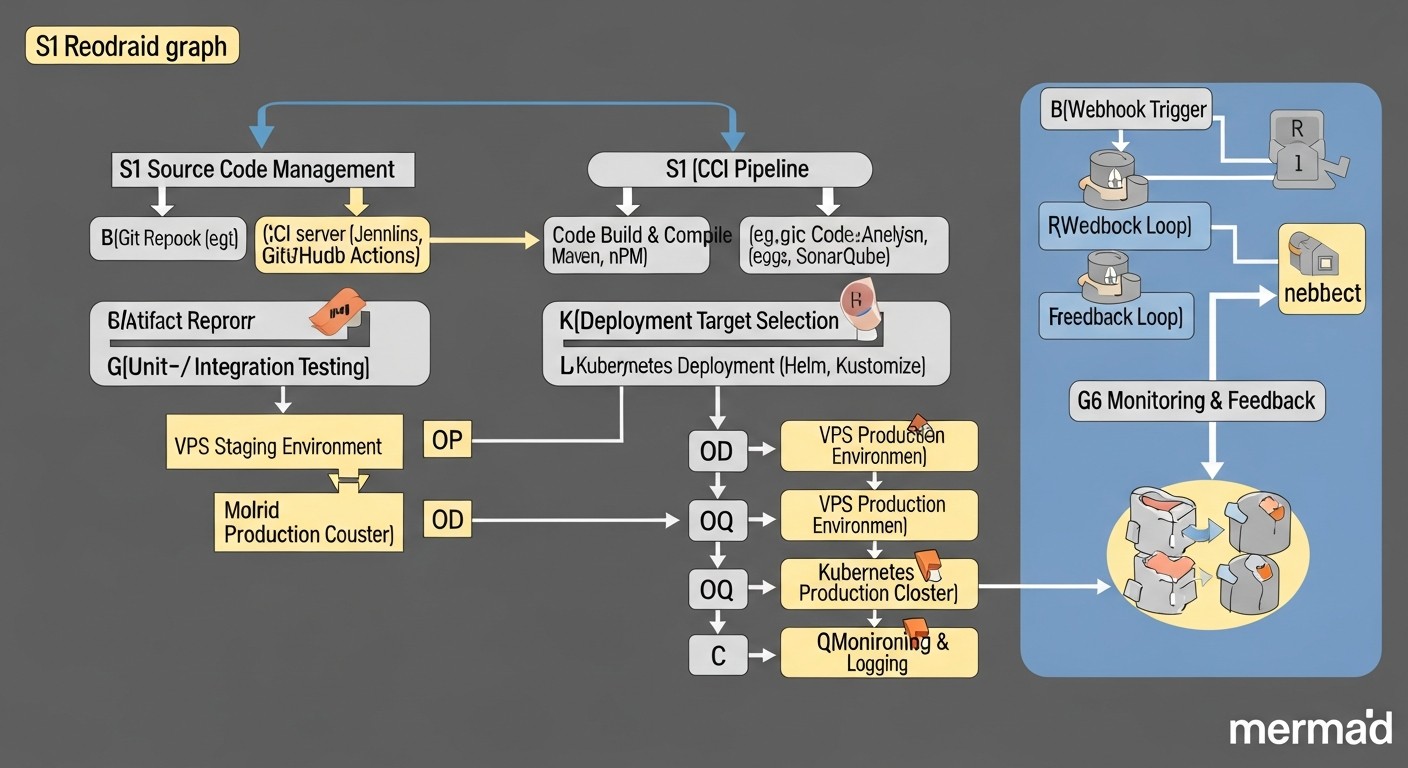

Para crear un pipeline CI/CD universal en entornos híbridos, es necesario comprender las fortalezas y debilidades de los diferentes enfoques y herramientas. Nos centraremos en tres categorías principales de soluciones CI/CD que se encuentran con mayor frecuencia en estas condiciones, así como en GitOps como paradigma.

1. Soluciones integradas basadas en alojamiento Git (GitLab CI/CD, GitHub Actions)

Estas plataformas se han convertido en el estándar de facto para muchos equipos gracias a su profunda integración con los repositorios de código y su facilidad de uso. En 2026, su funcionalidad se ha expandido significativamente, ofreciendo aún mayor flexibilidad para escenarios híbridos.

GitLab CI/CD

GitLab CI/CD es parte de la plataforma integral de GitLab, que abarca todo el ciclo de vida del desarrollo. Esta es su principal ventaja: desde la gestión de repositorios y proyectos hasta CI/CD, seguridad y monitorización, todo en un solo lugar. Para entornos híbridos, GitLab ofrece un potente sistema de runners. Puede utilizar los runners compartidos de GitLab (para inicios rápidos y proyectos pequeños), pero para entornos híbridos y de alta carga, los runners autoalojados son indispensables. Estos pueden desplegarse en VPS comunes (utilizando Docker-executor), en Docker Swarm o, lo que es especialmente eficiente, en un clúster de Kubernetes con el Kubernetes-executor, que crea dinámicamente pods para cada tarea. Esto permite ejecutar compilaciones y despliegues lo más cerca posible de la infraestructura objetivo, minimizando latencias y aumentando la seguridad. La sintaxis de .gitlab-ci.yml es intuitiva y permite crear pipelines complejos con etapas, caché, artefactos y ejecuciones condicionales. GitLab desarrolla activamente funciones de seguridad (SAST, DAST, Container Scanning) y proporciona registros integrados de imágenes y paquetes Docker, lo que simplifica la gestión de artefactos. La integración con HashiCorp Vault y Kubernetes Secrets garantiza una gestión segura de las credenciales.

- **Pros:** Profunda integración con Git, plataforma unificada, potentes runners para cualquier entorno (incluido Kubernetes), herramientas de seguridad y registros integrados, comunidad activa, excelente documentación. Ideal para equipos que desean tener todo bajo un mismo techo, especialmente si ya tienen una instalación de GitLab.

- **Contras:** Para instalaciones muy grandes, GitLab autoalojado puede consumir muchos recursos. El costo de la versión SaaS puede ser alto para equipos grandes.

- **Para quién es adecuado:** Para equipos de cualquier tamaño, especialmente aquellos que buscan una solución integral "lista para usar" y están dispuestos a invertir en el ecosistema de GitLab. Maneja excelentemente los despliegues híbridos gracias a la flexibilidad de los runners.

GitHub Actions

GitHub Actions ha ganado una enorme popularidad gracias a su simplicidad, su extenso marketplace de "acciones" (Actions) listas para usar y su profunda integración con GitHub. Al igual que GitLab CI, GitHub Actions admite runners autoalojados, lo cual es fundamental para entornos híbridos. Estos runners pueden instalarse en cualquier VM, contenedor o clúster de Kubernetes, permitiendo ejecutar tareas de CI/CD en su propia infraestructura, con acceso a recursos internos. El marketplace de Actions contiene miles de módulos listos para compilar, probar, escanear y desplegar, lo que acelera significativamente la creación de pipelines. Por ejemplo, existen Actions para despliegues SSH en VPS, para trabajar con Helm y Kubernetes, y para despliegues en proveedores de la nube. GitHub también desarrolla activamente funciones de seguridad, como CodeQL y Dependabot, que se integran fácilmente en Actions. La integración OIDC permite obtener credenciales temporales de forma segura para los proveedores de la nube, minimizando la necesidad de almacenar secretos a largo plazo.

- **Pros:** Enorme marketplace de Actions, facilidad de uso, profunda integración con GitHub, excelente documentación, runners autoalojados para escenarios híbridos, potentes funciones de seguridad y gestión de secretos a través de OIDC.

- **Contras:** Algunas funciones avanzadas pueden requerir Actions adicionales o la escritura de scripts propios. Los precios de los runners en la nube pueden ser considerables para grandes volúmenes.

- **Para quién es adecuado:** Para equipos que utilizan GitHub como su sistema principal de control de versiones. Ideal para proyectos que necesitan una configuración rápida de CI/CD con un mínimo esfuerzo y acceso a una amplia biblioteca de soluciones listas para usar.

2. Soluciones Open Source universales (Jenkins)

Jenkins sigue siendo un veterano y uno de los servidores CI/CD más flexibles. En 2026, a pesar de la aparición de soluciones en la nube más modernas, Jenkins sigue siendo la elección para empresas que necesitan un control total sobre su pipeline CI/CD y la máxima personalización. Su arquitectura "master-agent" es ideal para entornos híbridos, ya que los agentes (runners) pueden desplegarse en cualquier lugar: en VPS individuales, en Docker Swarm, en Kubernetes, en servidores físicos e incluso en diferentes sistemas operativos. Esto permite ejecutar tareas de despliegue específicas directamente en la plataforma objetivo. Jenkins cuenta con un vasto ecosistema de plugins (decenas de miles) que permiten la integración con prácticamente cualquier herramienta, desde sistemas de control de versiones hasta herramientas de despliegue y monitorización. Los pipelines se pueden describir tanto en la interfaz gráfica como mediante Jenkinsfile (scripts Groovy), lo que proporciona "Pipeline as Code". Para entornos híbridos, Jenkins se puede configurar para despliegues SSH en VPS mediante el plugin SSH Agent, y para Kubernetes, mediante los plugins de Kubernetes, Helm, o incluso ejecutando comandos kubectl directamente desde el agente.

- **Pros:** Máxima flexibilidad y personalización, enorme ecosistema de plugins, control total sobre la infraestructura, capacidad de desplegar agentes en cualquier entorno, "Pipeline as Code" a través de Jenkinsfile.

- **Contras:** Requiere más esfuerzo en configuración y soporte, posible complejidad en la gestión de plugins (dependency hell), la interfaz puede ser menos moderna en comparación con las alternativas en la nube. Requiere recursos dedicados para el servidor Master.

- **Para quién es adecuado:** Para grandes organizaciones con requisitos únicos de CI/CD, para equipos que necesitan control total y la capacidad de personalización profunda, y para aquellos que están dispuestos a invertir en administración y soporte. Es excelente para entornos híbridos complejos donde se requiere una interacción específica con la infraestructura.

3. Soluciones GitOps (ArgoCD, FluxCD) para Kubernetes

GitOps es un paradigma operativo que utiliza Git como única fuente de verdad para la descripción declarativa del estado deseado de la infraestructura y las aplicaciones. En 2026, GitOps se ha convertido en el estándar de oro para la gestión de despliegues en Kubernetes. ArgoCD y FluxCD son las herramientas líderes en este campo. Funcionan según el principio "pull-based": en lugar de que el pipeline CI/CD "empuje" los cambios al clúster, un operador GitOps que se ejecuta dentro de Kubernetes "extrae" (pull) constantemente las configuraciones del repositorio Git y sincroniza el clúster con ese estado. Esto aumenta significativamente la estabilidad, la seguridad y la transparencia de los despliegues.

Aunque ArgoCD y FluxCD están principalmente orientados a Kubernetes, también se pueden utilizar en escenarios híbridos. Por ejemplo, la parte CI del pipeline (compilación, pruebas, creación de la imagen Docker) puede ejecutarse en GitLab CI o GitHub Actions, y luego estas herramientas actualizan los manifiestos de Kubernetes en un repositorio Git. ArgoCD/FluxCD detectan estos cambios y los despliegan en el clúster. Para el despliegue en VPS, se puede utilizar un controlador GitOps especializado que monitorizará el repositorio Git y, al detectar cambios, ejecutará playbooks de Ansible o comandos SSH en los VPS objetivo. De esta manera, Git se convierte en un punto de control unificado para toda la infraestructura híbrida.

- **Pros:** Mayor estabilidad y fiabilidad de los despliegues, transparencia (historial de Git de todos los cambios), reversión simplificada, seguridad mejorada (no es necesario otorgar permisos directos al sistema CI/CD sobre el clúster), declaratividad.

- **Contras:** Enfoque principal en Kubernetes, para VPS se requiere lógica o controladores adicionales. Puede ser más complejo de aprender inicialmente.

- **Para quién es adecuado:** Para equipos que utilizan activamente Kubernetes, que buscan la máxima automatización y estabilidad en los despliegues. Ideal para gestionar arquitecturas de microservicios complejas en K8s.

Consejos prácticos y recomendaciones para construir el pipeline

La construcción de un pipeline CI/CD universal para entornos híbridos requiere no solo la elección de las herramientas adecuadas, sino también un enfoque estratégico en el diseño. A continuación, se presentan recomendaciones y ejemplos concretos que le ayudarán en este proceso.

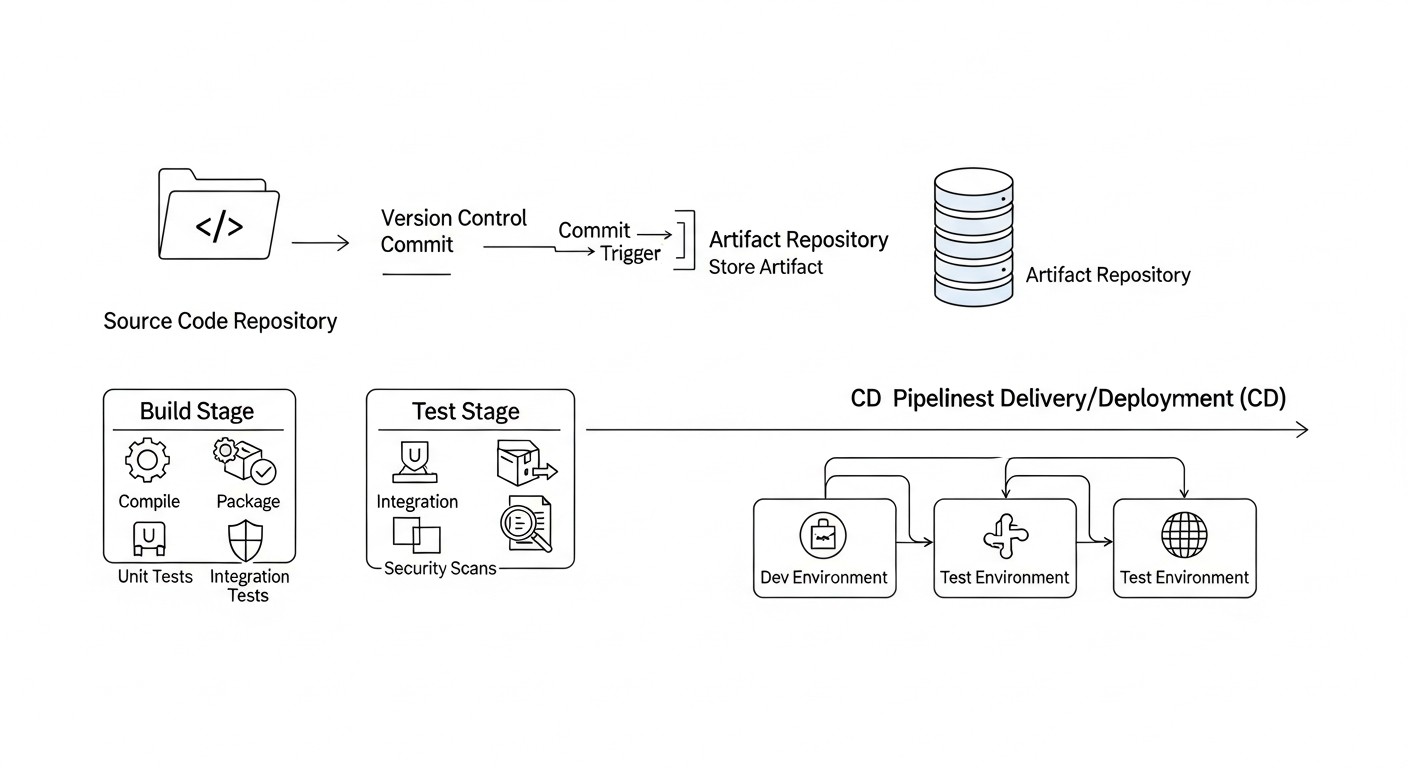

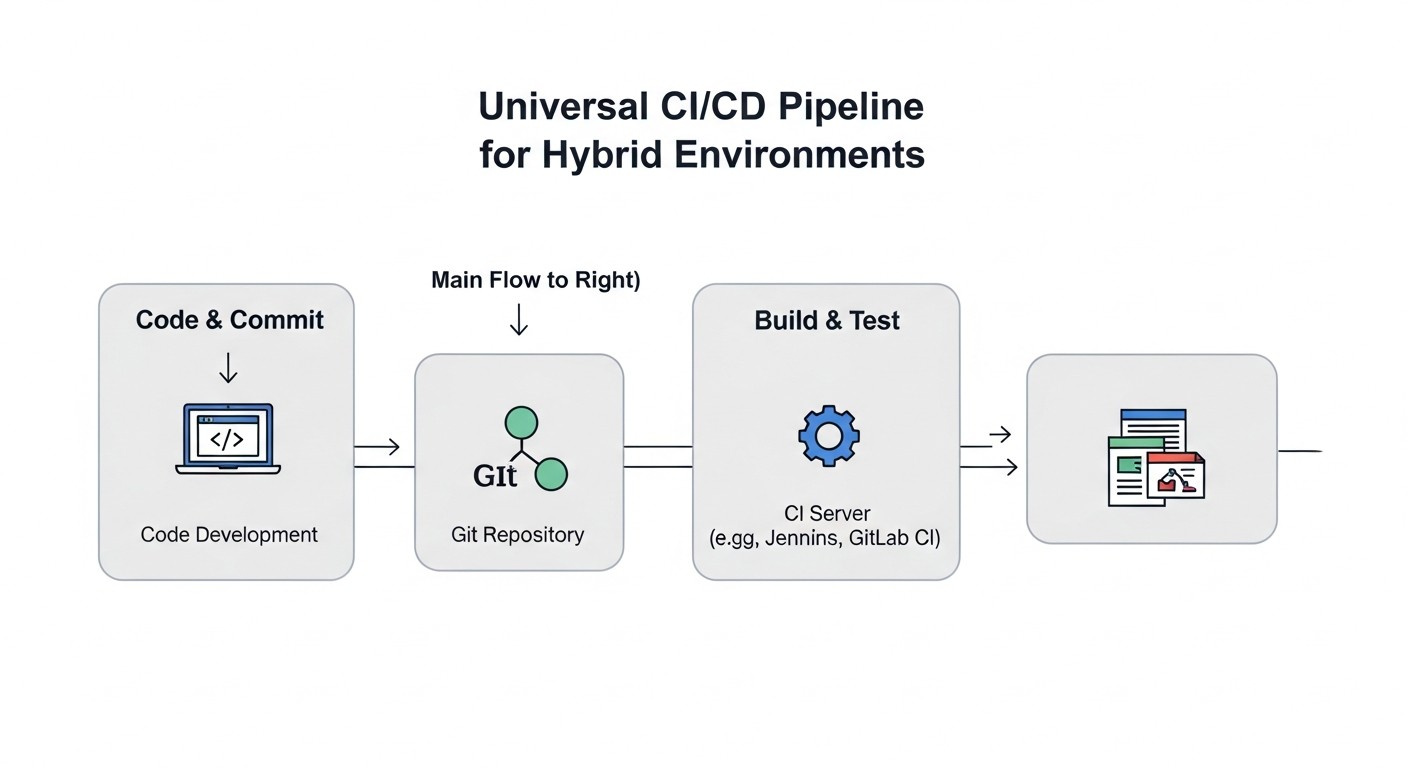

1. Abstracción de la lógica de despliegue mediante contenedores

Utilice al máximo Docker y otras tecnologías de contenedores. Esto permite crear artefactos (imágenes Docker) que pueden desplegarse en prácticamente cualquier entorno: en un VPS, en Docker Swarm o en Kubernetes. El pipeline de CI debe encargarse de compilar el código, probarlo y construir la imagen Docker, que luego se publica en un registro (Docker Hub, GitLab Registry, Artifactory).

Ejemplo de GitLab CI para la construcción de una imagen Docker:

stages:

- build

- test

- publish

variables:

DOCKER_IMAGE_NAME: $CI_REGISTRY_IMAGE/$CI_COMMIT_REF_SLUG

DOCKER_TAG: $CI_COMMIT_SHORT_SHA

build_and_test_app:

stage: build

image: node:20-alpine # Или любое другое для сборки

script:

- npm install

- npm test

- npm run build

artifacts:

paths:

- build/ # Сохраняем артефакты сборки

publish_docker_image:

stage: publish

image: docker:24.0.5-dind # Docker-in-Docker для сборки образа

services:

- docker:24.0.5-dind

script:

- docker login -u $CI_REGISTRY_USER -p $CI_REGISTRY_PASSWORD $CI_REGISTRY

- docker build -t $DOCKER_IMAGE_NAME:$DOCKER_TAG -t $DOCKER_IMAGE_NAME:latest .

- docker push $DOCKER_IMAGE_NAME:$DOCKER_TAG

- docker push $DOCKER_IMAGE_NAME:latest

only:

- main # Публиковать только для основной ветки

2. Enfoque unificado para la gestión de configuraciones (Infrastructure as Code)

Utilice herramientas IaC, como Terraform, Ansible, Pulumi, para gestionar tanto la infraestructura como las configuraciones de las aplicaciones. Esto permite describir de forma declarativa el estado deseado del entorno, ya sea un VPS o un clúster de Kubernetes.

- **Para VPS:** Utilice Ansible para instalar dependencias, desplegar archivos Docker Compose y gestionar servicios.

- **Para Kubernetes:** Utilice Helm para empaquetar aplicaciones y sus dependencias, Kustomize para personalizar manifiestos.

Ejemplo de Ansible Playbook para el despliegue de Docker Compose en un VPS:

- name: Deploy Docker Compose application

hosts: web_servers

become: yes

vars:

app_dir: /opt/my-app

docker_image: "my-registry/my-app:{{ lookup('env', 'CI_COMMIT_SHORT_SHA') }}" # Из переменной CI/CD

tasks:

- name: Ensure app directory exists

ansible.builtin.file:

path: "{{ app_dir }}"

state: directory

mode: '0755'

- name: Copy docker-compose.yml

ansible.builtin.template:

src: templates/docker-compose.yml.j2

dest: "{{ app_dir }}/docker-compose.yml"

mode: '0644'

- name: Pull latest Docker images

community.docker.docker_compose:

project_src: "{{ app_dir }}"

pull: yes

state: present

- name: Start/restart Docker Compose services

community.docker.docker_compose:

project_src: "{{ app_dir }}"

state: started

restarted: yes

En templates/docker-compose.yml.j2 puede utilizar la variable {{ docker_image }}.

3. Uso de secretos

Nunca almacene secretos en el código o en el repositorio Git. Utilice los mecanismos integrados de CI/CD (por ejemplo, GitLab CI/CD Variables, GitHub Actions Secrets) o almacenes externos (HashiCorp Vault, Kubernetes Secrets, AWS Secrets Manager, GCP Secret Manager). Para acceder a los recursos de la nube, utilice credenciales temporales a través de OIDC, si es posible.

Ejemplo de uso de secretos en GitHub Actions:

name: Deploy to VPS

on:

push:

branches:

- main

jobs:

deploy:

runs-on: self-hosted # Используем self-hosted runner на VPS

steps:

- uses: actions/checkout@v4

- name: Deploy with SSH

uses: appleboy/ssh-action@master

with:

host: ${{ secrets.VPS_HOST }}

username: ${{ secrets.VPS_USER }}

key: ${{ secrets.VPS_SSH_KEY }}

script: |

cd /opt/my-app

docker login -u ${{ secrets.DOCKER_USERNAME }} -p ${{ secrets.DOCKER_PASSWORD }}

docker-compose pull

docker-compose up -d --remove-orphans

docker system prune -f

4. Despliegue por etapas (Progressive Delivery)

Para minimizar los riesgos, utilice estrategias de despliegue por etapas:

- **Despliegues Canary:** Despliegue una nueva versión para una pequeña parte de los usuarios y luego aumente gradualmente el tráfico.

- **Despliegues Blue/Green:** Despliegue la nueva versión junto a la antigua y luego cambie el tráfico.

5. Retroalimentación y monitorización

Integre el CI/CD con sistemas de monitorización y alerta. Después de cada despliegue, verifique la funcionalidad de la aplicación, las métricas de rendimiento y los registros. Si algo sale mal, el pipeline debe poder revertir automáticamente o enviar una alerta.

Ejemplo de verificación POST-despliegue en GitLab CI:

post_deploy_check:

stage: deploy_validation

image: curlimages/curl:latest

script:

- curl -f -s http://my-app.example.com/health || (echo "Health check failed!" && exit 1)

- echo "Application is healthy after deployment."

dependencies:

- deploy_to_kubernetes # Или deploy_to_vps

allow_failure: false # Не позволяем конвейеру завершиться успешно, если проверка не прошла

6. Automatización de pruebas

Incluya todo tipo de pruebas en el pipeline:

- **Pruebas unitarias:** Pruebas rápidas para componentes individuales.

- **Pruebas de integración:** Verificación de la interacción entre componentes.

- **Pruebas End-to-End (E2E):** Simulación del comportamiento del usuario (Selenium, Cypress).

- **Pruebas de carga:** Verificación del rendimiento bajo carga (JMeter, k6).

- **Pruebas de seguridad:** SAST, DAST, escaneo de dependencias y contenedores.

7. Uso de GitOps para Kubernetes

Para las partes de Kubernetes de su entorno híbrido, se recomienda encarecidamente utilizar herramientas GitOps, como ArgoCD o FluxCD. Estas simplifican significativamente la gestión de configuraciones, garantizan la coherencia y permiten revertir fácilmente a estados anteriores.

Ejemplo de flujo de trabajo con GitOps:

- El desarrollador sube el código a

feature-branch. - CI (GitLab CI/GitHub Actions) ejecuta la compilación, las pruebas y crea la imagen Docker.

- Si las pruebas pasan con éxito, CI actualiza la etiqueta de la imagen Docker en los manifiestos de Kubernetes (o valores de Helm) en un

gitops-reposeparado. - ArgoCD/FluxCD, al observar el

gitops-repo, detecta automáticamente el cambio y lo aplica al clúster de Kubernetes. - Si es necesario, se puede añadir una aprobación manual en la herramienta GitOps o mediante una Pull Request en el

gitops-repo.

Errores comunes al implementar CI/CD híbrido y cómo evitarlos

La implementación de CI/CD en entornos híbridos conlleva complejidades únicas, y muchos equipos cometen los mismos errores. Conocer estas trampas le ayudará a construir un pipeline más fiable y eficiente.

1. Falta de una estrategia unificada de gestión de secretos

**Error:** Almacenar secretos (contraseñas, tokens, claves SSH) directamente en archivos de configuración en el repositorio Git, pasarlos a través de variables de entorno que se registran, o usar diferentes mecanismos para VPS y Kubernetes sin un enfoque centralizado. Esto lleva a fugas, dificultades con la rotación y la auditoría.

**Cómo evitarlo:** Implemente un sistema centralizado de gestión de secretos. Para CI/CD, pueden ser almacenes integrados (GitLab CI/CD Variables, GitHub Actions Secrets) con un control de acceso estricto. Para el despliegue, utilice HashiCorp Vault, servicios en la nube (AWS Secrets Manager, GCP Secret Manager) o Kubernetes Secrets (con cifrado etcd y, posiblemente, External Secrets Operator para la sincronización con almacenes externos). Siempre utilice OIDC para obtener credenciales temporales si el proveedor de la nube lo admite.

2. Demasiada dependencia de una plataforma de despliegue específica

**Error:** Codificación rígida de la lógica de despliegue específica para VPS (por ejemplo, comandos SSH directos escritos "sobre la marcha") o Kubernetes (por ejemplo, Helm charts muy específicos que no pueden adaptarse). Esto hace que el pipeline sea inflexible y dificulta la migración o el cambio de infraestructura.

**Cómo evitarlo:** Cree capas de abstracción. Su parte de CI debe producir un artefacto universal (por ejemplo, una imagen Docker). La parte de CD debe utilizar herramientas IaC (Ansible para VPS, Helm/Kustomize para Kubernetes) que puedan parametrizarse. Separe la lógica de compilación de la lógica de despliegue. Aspire a que el mismo artefacto pueda desplegarse en diferentes plataformas con cambios mínimos en los scripts de CD.

3. Ignorar la observabilidad y monitorización del pipeline

**Error:** Falta de monitorización de las métricas de CI/CD (tiempo de compilación, éxito, uso de recursos), ausencia de registro centralizado para todas las etapas y alertas sobre fallos. Como resultado, los equipos se enteran de los problemas solo cuando la aplicación no se ha desplegado o los usuarios informan de errores.

**Cómo evitarlo:** Implemente la monitorización de CI/CD como parte de su pipeline. Utilice Prometheus y Grafana para recopilar y visualizar métricas (por ejemplo, con exportadores para Jenkins, GitLab). Centralice los registros de compilación en ELK Stack, Loki o Splunk. Configure alertas (a través de Slack, PagerDuty, Telegram) sobre cualquier fallo, anomalía en el tiempo de compilación o problemas de despliegue. Esto permitirá una respuesta rápida y la identificación de cuellos de botella.

4. Pruebas insuficientes en CI/CD

**Error:** Limitar las pruebas solo a las unitarias o la ausencia total de ellas. Desplegar código no probado en entornos híbridos, donde la infraestructura puede ser compleja, aumenta el riesgo de errores críticos en producción.

**Cómo evitarlo:** Incluya un espectro completo de pruebas automatizadas: Unitarias, de Integración, E2E, de carga y de seguridad (SAST, DAST, escaneo de contenedores). Ejecútelas en las etapas correspondientes del pipeline. Utilice entornos de prueba lo más parecidos posible a producción. Considere implementar pruebas de contrato para microservicios para garantizar la compatibilidad entre componentes desplegados en diferentes plataformas.

5. Operaciones manuales en el pipeline

**Error:** Introducción de pasos manuales en el proceso de despliegue, como la copia manual de archivos, la ejecución de comandos SSH, la configuración manual de parámetros después del despliegue. Esto ralentiza el proceso, aumenta la probabilidad de errores humanos y hace que el pipeline no sea reproducible.

**Cómo evitarlo:** Automatice absolutamente todos los pasos. Utilice IaC para gestionar la infraestructura y la configuración. Para el despliegue en VPS, utilice Ansible o Fabric. Para Kubernetes, Helm, Kustomize, ArgoCD. Si se requiere confirmación, impleméntela como un paso explícito en CI/CD (por ejemplo, una ejecución manual de una etapa en GitLab/GitHub Actions) o a través de un proceso de Pull Request en el repositorio GitOps. El objetivo es hacer que el despliegue sea completamente determinista y repetible.

6. Falta de una estrategia de reversión (Rollback)

**Error:** Ausencia de un mecanismo de reversión claro y automatizado a la versión estable anterior en caso de problemas después del despliegue. Esto puede llevar a largos tiempos de inactividad y pánico en situaciones críticas.

**Cómo evitarlo:** Diseñe el pipeline teniendo en cuenta la posibilidad de reversión. Para Docker Compose en VPS, esto puede ser revertir a la imagen Docker anterior y reiniciar el servicio. Para Kubernetes, es una función integrada (kubectl rollout undo, o revertir un lanzamiento de Helm, o revertir un commit en el repositorio GitOps). Automatice la reversión basándose en métricas de monitorización o resultados de pruebas post-despliegue. Asegúrese de que su CI/CD pueda desplegar de forma rápida y fiable la versión anterior de la aplicación.

Lista de verificación para la aplicación práctica de CI/CD híbrido

Esta lista de verificación le ayudará a sistematizar el proceso de construcción y optimización de un pipeline CI/CD para entornos híbridos, garantizando que no omita aspectos importantes.

Fase de planificación y diseño

- **Defina las plataformas objetivo:** Establezca claramente qué entornos se utilizarán (VPS, Docker Swarm, Kubernetes, Serverless, PaaS) y para qué tipos de aplicaciones. Esto ayudará a elegir las herramientas adecuadas.

- **Desarrolle una estrategia de gestión de artefactos:** Elija un registro unificado de imágenes Docker (por ejemplo, GitLab Registry, Docker Hub, Artifactory) y una estrategia de nomenclatura/etiquetado de imágenes.

- **Elija la herramienta CI/CD principal:** Decida entre GitLab CI, GitHub Actions, Jenkins u otra solución, basándose en los requisitos, el presupuesto y las competencias del equipo.

- **Diseñe la arquitectura de runners/agentes:** Decida dónde se ejecutarán las compilaciones y los despliegues: runners en la nube, autoalojados en VPS, o runners dinámicos en un clúster de Kubernetes.

- **Defina la estrategia de gestión de secretos:** Elija un almacén de secretos centralizado y un mecanismo de acceso a ellos para todos los entornos (CI/CD, VPS, Kubernetes).

- **Planifique la integración con IaC:** Decida qué herramientas IaC (Terraform, Ansible, Helm, Kustomize) se utilizarán para gestionar la infraestructura y las configuraciones.

- **Defina las estrategias de despliegue:** Elija las estrategias adecuadas (Rolling Update, Blue/Green, Canary) para cada entorno objetivo.

- **Establezca las bases de la observabilidad:** Planifique cómo se recopilarán los registros y las métricas de CI/CD y de las aplicaciones, y cómo se configurarán las alertas.

- **Desarrolle una estrategia de reversión:** Determine cómo se realizará una reversión rápida a la versión anterior en caso de problemas.

- **Realice una evaluación del TCO:** Calcule el costo total de propiedad aproximado de la pila CI/CD seleccionada, incluyendo la infraestructura y los costos laborales.

Fase de implementación y configuración

- **Configure los repositorios de código:** Asegúrese de que sus repositorios estén estructurados para CI/CD (por ejemplo, monorepo o polyrepo).

- **Escriba Dockerfile:** Cree Dockerfiles optimizados para cada aplicación que se utilizarán para construir imágenes.

- **Configure el pipeline de CI:** Implemente las etapas de compilación, pruebas (Unitarias, de Integración, E2E) y publicación de imágenes Docker en el registro seleccionado.

- **Configure el pipeline de CD para VPS:** Utilice playbooks de Ansible o scripts SSH para obtener imágenes Docker, actualizar archivos Docker Compose y reiniciar servicios en los VPS.

- **Configure el pipeline de CD para Kubernetes:** Utilice Helm charts o manifiestos Kustomize para describir los despliegues. Integre con ArgoCD/FluxCD para un enfoque GitOps.

- **Implemente la gestión de secretos:** Cargue todos los secretos necesarios en el sistema de gestión de secretos elegido y configure el acceso desde CI/CD.

- **Integre herramientas de seguridad:** Incluya SAST, DAST, escaneo de dependencias y contenedores en el pipeline de CI.

- **Configure la monitorización:** Integre CI/CD con Prometheus/Grafana para la monitorización de métricas y con un sistema de registro centralizado.

- **Configure las alertas:** Cree reglas de alerta para eventos críticos en CI/CD y en las aplicaciones desplegadas.

- **Documente el pipeline:** Cree documentación detallada sobre el funcionamiento del pipeline, su estructura, las herramientas utilizadas y el proceso de depuración.

Fase de optimización y soporte

- **Optimice los tiempos de compilación:** Busque cuellos de botella, utilice el almacenamiento en caché, compilaciones paralelas, runners más potentes.

- **Audite la seguridad regularmente:** Realice auditorías periódicas de seguridad del sistema CI/CD y de los secretos utilizados.

- **Actualice las herramientas:** Manténgase al tanto de las actualizaciones de las plataformas CI/CD, plugins y herramientas IaC para obtener nuevas funciones y correcciones de seguridad.

- **Recopile comentarios:** Comuníquese regularmente con desarrolladores y operadores para mejorar la usabilidad y eficiencia del pipeline.

- **Capacite al equipo:** Ofrezca capacitación a los nuevos miembros del equipo sobre el uso de CI/CD.

Cálculo de costos y economía de propiedad de CI/CD híbrido

La evaluación del costo total de propiedad (Total Cost of Ownership, TCO) de un pipeline CI/CD en entornos híbridos es una tarea compleja que requiere tener en cuenta tanto los costos directos como los ocultos. En 2026, a medida que los servicios en la nube continúan encareciéndose y la necesidad de flexibilidad crece, un cálculo correcto del TCO puede influir significativamente en el presupuesto y la eficiencia del proyecto. Analizaremos ejemplos de cálculos para diferentes escenarios.

Costos ocultos que a menudo se olvidan:

- **Costos laborales de los ingenieros:** Esta es la partida de gastos oculta más grande. Incluye el tiempo de diseño, configuración, depuración, actualización, soporte y capacitación. Un sistema complejo o mal diseñado puede consumir cientos de horas al mes.

- **Inactividad y retrasos:** Un CI/CD lento o inestable ralentiza el desarrollo, aumenta el Time-to-Market, lo que lleva a la pérdida de ingresos.

- **Recursos para el almacenamiento de artefactos:** Costo de almacenar imágenes Docker, registros, informes de pruebas en registros y sistemas de almacenamiento.

- **Tráfico:** Tráfico saliente de CI/CD en la nube o entre sus centros de datos/VPS y servicios en la nube.

- **Licencias y suscripciones:** Además de las plataformas principales, pueden ser necesarias licencias para herramientas de seguridad, monitorización o plugins propietarios de terceros.

- **Capacitación y certificación:** Inversión en la mejora de las cualificaciones del equipo.

- **Seguridad:** Implementación y soporte de herramientas de seguridad, auditoría, respuesta a incidentes.

Ejemplos de cálculos para diferentes escenarios (precios orientativos de 2026)

Escenario 1: Pequeño proyecto SaaS (5 desarrolladores) en VPS y Docker Compose

- **Entorno objetivo:** 3-5 VPS, Docker Compose.

- **Solución CI/CD:** GitLab CI (autoalojado en un VPS) o GitHub Actions (con runner autoalojado en otro VPS).

- **Tareas CI/CD:** Construcción de imágenes Docker, pruebas unitarias/de integración, despliegue en VPS a través de SSH/Ansible.

Cálculo del TCO mensual:

| Partida de gastos | GitLab CI (Autoalojado) | GitHub Actions (Runner autoalojado) |

|---|---|---|

| VPS para GitLab Master/GitHub Runner (4 vCPU, 8GB RAM) | $35 (DigitalOcean/Hetzner) | $35 (DigitalOcean/Hetzner) |

| VPS para aplicaciones (x3) | $75 ($25x3) | $75 ($25x3) |

| Registro de imágenes Docker (GitLab integrado/Docker Hub Pro) | $0 (integrado) | $10 (Docker Hub Pro) |

| Minutos en la nube de CI/CD (para GitHub Actions, si no hay autoalojado) | N/A | $15 (si ~2000 minutos/mes) |

| Costos laborales del ingeniero (configuración/soporte ~10 horas/mes @$80/hora) | $800 | $800 |

| Monitorización/registro (Prometheus, Grafana, Loki en un VPS separado) | $25 | $25 |

| **TOTAL (mensual)** | **~ $935** | **~ $960** |

**Conclusión:** Para proyectos pequeños, las soluciones autoalojadas pueden ser económicamente ventajosas, pero requieren un esfuerzo considerable en soporte. Los servicios en la nube (GitHub Actions) pueden ser más caros debido a los minutos, pero simplifican la administración.

Escenario 2: Proyecto mediano (20 desarrolladores) con microservicios en Kubernetes y VPS para DB/caché

- **Entorno objetivo:** Kubernetes gestionado (EKS/GKE/AKS), 2-3 VPS para bases de datos/caché.

- **Solución CI/CD:** GitLab SaaS (Premium) o GitHub Actions + ArgoCD.

- **Tareas CI/CD:** Construcción de imágenes Docker, pruebas complejas, despliegue en K8s a través de Helm/GitOps, Ansible para VPS.

Cálculo del TCO mensual:

| Partida de gastos | GitLab SaaS (Premium) | GitHub Actions + ArgoCD |

|---|---|---|

| GitLab SaaS Premium (20 usuarios @$19/mes) | $380 | N/A |

| GitHub Actions (runners en la nube, ~15000 minutos/mes) | N/A | $120 (Linux) + $60 (Windows/macOS) |

| Kubernetes gestionado (3 nodos, 8 vCPU, 32GB RAM) | $450 (GKE/EKS) | $450 (GKE/EKS) |

| VPS para DB/caché (x3) | $120 | $120 |

| Registro de imágenes Docker (GitLab integrado/GCR/ECR) | $0 (integrado) | $30 (GCR/ECR) |

| ArgoCD (infraestructura en K8s) | N/A | $20 (parte K8s recursos) |

| Costos laborales del ingeniero (configuración/soporte ~40 horas/mes @$100/hora) | $4000 | $4000 |

| Monitorización/registro (Prometheus/Grafana gestionado, ELK) | $150 | $150 |

| **TOTAL (mensual)** | **~ $5100** | **~ $4950** |

**Conclusión:** Para proyectos medianos con Kubernetes, las soluciones CI/CD en la nube se vuelven más atractivas, ya que reducen los gastos generales de administración del propio CI/CD. El costo de la infraestructura de Kubernetes y los costos laborales de los ingenieros siguen siendo los principales impulsores del TCO.

Escenario 3: Gran corporación (más de 100 desarrolladores) con infraestructura híbrida compleja

- **Entorno objetivo:** Kubernetes On-prem, varios clústeres K8s en la nube, decenas de VPS, Serverless, PaaS.

- **Solución CI/CD:** Jenkins (versión Enterprise o una potente instalación Open Source) + ArgoCD + Tekton.

- **Tareas CI/CD:** Todo tipo de pruebas, despliegues multietapa, integraciones complejas, cumplimiento.

Cálculo del TCO mensual:

| Partida de gastos | Jenkins (Autoalojado) + ArgoCD/Tekton |

|---|---|

| Servidores para Jenkins Master/Agents (físicos/VM, ~50 vCPU, 100GB RAM) | $1500 (propia infraestructura) |

| Licencias Jenkins Enterprise / Plugins | $1000 (estimación) |

| Kubernetes gestionado/On-prem (múltiples clústeres) | $5000 (promedio) |

| VPS/Serverless/PaaS (infraestructura general) | $2000 |

| Registros de artefactos (Artifactory/Nexus Enterprise) | $500 |

| ArgoCD/Tekton (infraestructura en K8s) | $100 |

| Costos laborales de los ingenieros (equipo DevOps ~4 ingenieros @$120/hora) | $76800 (4 * 160 * 120) |

| Monitorización/registro (ELK/Splunk Enterprise) | $1000 |

| Herramientas de seguridad (SAST/DAST Enterprise) | $800 |

| **TOTAL (mensual)** | **~ $89300** |

**Conclusión:** Para grandes corporaciones, el TCO se determina principalmente por los costos laborales de ingenieros altamente cualificados y el costo de una infraestructura compleja. La elección de soluciones Open Source puede reducir los costos directos de licencias, pero aumentará los costos de soporte y personalización. A esta escala, la hibridez se vuelve aún más compleja y costosa, pero necesaria para la flexibilidad y la resiliencia.

Cómo optimizar los costos:

- **Utilice runners autoalojados:** Para CI/CD en la nube (GitHub Actions, CircleCI), ejecutar runners en sus propios VPS o en Kubernetes puede reducir significativamente el costo por minuto, especialmente para compilaciones de Linux.

- **Optimice los pipelines:** Reduzca los tiempos de compilación, utilice el almacenamiento en caché de dependencias, paralelice las tareas. Cuanto más rápido sea el pipeline, menos minutos consumirá.

- **Automatice la administración:** Utilice IaC para el despliegue y la configuración del propio servidor CI/CD y sus agentes.

- **Gestione los recursos de manera eficiente:** Configure el autoescalado de runners para que se inicien solo cuando sea necesario.

- **Limpie los artefactos:** Elimine regularmente las imágenes Docker y los artefactos antiguos para reducir los costos de almacenamiento.

- **Utilice Open Source:** Para muchas tareas existen alternativas Open Source de alta calidad que pueden reducir significativamente los costos directos, pero requieren una mayor inversión en costos laborales.

- **Auditoría y análisis:** Analice regularmente los informes de gastos y uso de recursos para identificar ineficiencias.

En última instancia, la elección y la economía de CI/CD para entornos híbridos es un equilibrio constante entre funcionalidad, flexibilidad, seguridad y costo, que debe revisarse a medida que el proyecto crece y evoluciona.

Casos de estudio y ejemplos de implementación de CI/CD híbrido

Para comprender mejor cómo se aplican en la práctica los conceptos teóricos de CI/CD para entornos híbridos, consideremos algunos escenarios realistas. Estos casos demuestran cómo diferentes empresas resuelven los desafíos de despliegue en condiciones de infraestructura heterogénea.

Caso 1: Startup "SmartLogistics" - Migración de VPS a Kubernetes manteniendo componentes legacy

Problema:

"SmartLogistics" comenzó como una aplicación monolítica en Python/Django, desplegada en dos VPS con Docker Compose. A medida que el negocio crecía y se añadían nuevos servicios (análisis de rutas, API para conductores móviles), el monolito se convirtió en un cuello de botella. El equipo decidió migrar a una arquitectura de microservicios utilizando Kubernetes para los nuevos servicios, pero no podía trasladar toda la funcionalidad existente de inmediato debido a la complejidad y el costo.

Solución:

Se eligió una estrategia híbrida utilizando GitLab CI/CD como elemento central.

- **Parte CI:** Todos los servicios (tanto antiguos como nuevos) fueron contenerizados. GitLab CI se encargó de construir las imágenes Docker, ejecutar las pruebas unitarias y de integración, y luego subir las imágenes al GitLab Container Registry.

- **CD para VPS (Monolito Legacy):** Se desarrolló un playbook de Ansible para el monolito existente. Después de una compilación exitosa de la imagen, GitLab CI ejecutó este playbook, que se conectó al VPS por SSH, actualizó el archivo

docker-compose.ymlcon la nueva etiqueta de imagen y reinició los servicios. Los secretos se almacenaron en las Variables de GitLab CI/CD. - **CD para Kubernetes (Nuevos microservicios):** Para los nuevos microservicios se utilizó un enfoque GitOps con ArgoCD. GitLab CI, después de construir la imagen, actualizó los Helm charts (valores de

image.tag) en un repositorio Git separado (repositorio GitOps). ArgoCD, instalado en el clúster de Kubernetes gestionado (GKE), sincronizó automáticamente estos cambios y desplegó las nuevas versiones de los microservicios. - **Infraestructura general:** Terraform se utilizó para gestionar la infraestructura base (VPS, clúster GKE, configuraciones de red).

- **Monitorización:** Prometheus y Grafana recopilaron métricas tanto de los VPS (a través de Node Exporter) como del clúster de Kubernetes. Los registros se centralizaron en Loki.

Resultados:

- Se aceleró significativamente el desarrollo de nuevos microservicios (despliegue en 5-7 minutos).

- Se mantuvo la estabilidad del monolito legacy, minimizando los riesgos durante la migración gradual.

- Un único punto de entrada para CI/CD (GitLab) simplificó la gestión para el equipo de DevOps.

- GitOps para Kubernetes garantizó la transparencia y fiabilidad de los despliegues.

- Los costos generales de infraestructura se optimizaron mediante el uso de VPS para partes estables pero que consumen muchos recursos, y Kubernetes para servicios escalables.

Caso 2: Empresa "FinTech Solutions" - Despliegue en K8s On-Prem y en la Nube con seguridad reforzada

Problema:

"FinTech Solutions" desarrolla aplicaciones financieras de misión crítica. Cuentan con una infraestructura heredada basada en Kubernetes On-Premise para datos sensibles y un nuevo servicio escalable para API públicas, desplegado en Kubernetes en la nube (Azure AKS). Los requisitos de seguridad, auditoría y cumplimiento eran extremadamente altos. Existía el riesgo de fuga de datos e incumplimiento de las normativas.

Solución:

Se construyó un complejo sistema CI/CD híbrido basado en Jenkins, utilizando Tekton y medidas de seguridad reforzadas.

- **Parte CI (Jenkins + Tekton):** Jenkins Master gestionaba toda la orquestación. Para la compilación y las pruebas, se utilizaron agentes dinámicos de Jenkins, desplegados como pods de Tekton en el clúster de Kubernetes On-Prem (para compilaciones sensibles) y en Azure AKS (para servicios públicos). Esto garantizó el aislamiento y la ejecución de las compilaciones lo más cerca posible del entorno objetivo. Los pipelines de Jenkinsfile incluían:

- Escaneo SAST (SonarQube) y DAST (OWASP ZAP).

- Escaneo de dependencias (Snyk) e imágenes Docker (Trivy).

- Firma de imágenes Docker con Notary.

- **Gestión de secretos:** HashiCorp Vault se integró con Jenkins y los clústeres de Kubernetes. Jenkins obtenía tokens temporales para acceder a Vault, y los pods de Tekton utilizaban Injector para obtener secretos en tiempo de ejecución. Azure AKS utilizaba Azure Key Vault con integración OIDC para acceder a los recursos de la nube.

- **Parte CD (GitOps con FluxCD):** Se utilizó FluxCD para ambos clústeres de Kubernetes (On-Prem y AKS). Después de una compilación y firma exitosa de la imagen, Jenkins actualizó los Helm charts en el repositorio GitOps. FluxCD, ejecutándose en cada clúster, sincronizó automáticamente los cambios. Esto garantizó una transparencia total y la capacidad de auditar todos los despliegues a través de Git.

- **Reversión automatizada:** En caso de detección de problemas por la monitorización o un health check fallido, FluxCD se configuró para revertir automáticamente a la versión anterior descrita en Git.

- **Monitorización y auditoría:** Splunk recopiló registros de todas las partes del pipeline y de ambos clústeres. Prometheus y Grafana se utilizaron para monitorizar el rendimiento y la disponibilidad. Todas las acciones en Jenkins y en el repositorio GitOps se registraron para auditorías de cumplimiento.

Resultados:

- Se logró un alto nivel de seguridad y cumplimiento normativo gracias a las verificaciones exhaustivas y la estricta gestión de secretos.

- La gestión de despliegues en dos clústeres de Kubernetes heterogéneos se unificó y transparentó gracias a GitOps.

- La escalabilidad de CI/CD se garantizó mediante agentes dinámicos de Tekton.

- Se redujeron los riesgos de errores humanos y se aceleró la entrega de cambios a producción, a pesar de la complejidad de la infraestructura.

Estos casos demuestran que un CI/CD universal para entornos híbridos no es una utopía, sino una tarea totalmente realizable que requiere un enfoque bien pensado, la elección correcta de herramientas y una atención constante a los detalles de seguridad y observabilidad.

Herramientas y recursos para CI/CD híbrido

La construcción y el soporte efectivos de un pipeline CI/CD híbrido son imposibles sin el uso de diversas herramientas y el aprendizaje continuo. En 2026, el ecosistema DevOps continúa expandiéndose, ofreciendo nuevas soluciones y mejorando las existentes. A continuación, se presenta una lista de categorías clave de herramientas y recursos útiles.

1. Plataformas CI/CD

- **GitLab CI/CD:** Plataforma integral "todo en uno". Excelente opción para equipos que buscan una solución integrada. Documentación

- **GitHub Actions:** Ideal para proyectos en GitHub, con un enorme marketplace de acciones listas para usar. Documentación

- **Jenkins:** Solución Open Source altamente configurable para máximo control y flexibilidad. Requiere más esfuerzo de soporte. Documentación

- **CircleCI:** CI/CD en la nube con buen soporte para contenedores. Documentación

- **Tekton:** Framework CI/CD nativo de Kubernetes, que permite construir pipelines dentro del clúster. Documentación

2. Herramientas de Infraestructura como Código (IaC)

- **Terraform:** Para la gestión declarativa de infraestructura en la nube y on-prem (VPS, clústeres de Kubernetes, redes). Documentación

- **Ansible:** Para la automatización de la configuración de servidores (VPS), despliegue de aplicaciones y orquestación. Documentación

- **Pulumi:** Utilice lenguajes de programación familiares (Python, Go, TypeScript) para describir la infraestructura. Documentación

- **Helm:** Estándar de facto para la gestión de aplicaciones en Kubernetes. Documentación

- **Kustomize:** Para la personalización declarativa de manifiestos de Kubernetes sin plantillas. Integrado en

kubectl. Documentación

3. Herramientas GitOps para Kubernetes

- **ArgoCD:** Popular controlador GitOps para Kubernetes con una excelente UI y rica funcionalidad. Documentación

- **FluxCD:** Otra potente herramienta GitOps, enfocada en la simplicidad y extensibilidad. Documentación

4. Gestión de secretos

- **HashiCorp Vault:** Almacén centralizado de secretos con asignación dinámica de credenciales. Documentación

- **Kubernetes Secrets:** Mecanismo integrado para almacenar datos confidenciales en K8s. Se recomienda usar con cifrado etcd. Documentación

- **External Secrets Operator:** Integra Kubernetes Secrets con almacenes externos (Vault, AWS Secrets Manager, Azure Key Vault). Documentación

- **Administradores de Secretos de Proveedores de la Nube:** AWS Secrets Manager, Azure Key Vault, Google Secret Manager.

5. Monitorización y registro

- **Prometheus:** Sistema de monitorización con un potente lenguaje de consulta PromQL. Documentación

- **Grafana:** Herramienta para la visualización de métricas de Prometheus y otras fuentes. Documentación

- **Loki:** Sistema de agregación de registros, similar a Prometheus, pero para registros. Documentación

- **ELK Stack (Elasticsearch, Logstash, Kibana):** Potente pila para la recopilación, análisis y visualización centralizada de registros. Documentación

- **OpenTelemetry:** Estándar unificado para la recopilación de telemetría (métricas, registros, trazas). Documentación

6. Herramientas de seguridad

- **Trivy:** Escáner de vulnerabilidades para imágenes de contenedores, sistemas de archivos, repositorios Git y configuraciones. Documentación

- **Snyk:** Plataforma para el escaneo de vulnerabilidades en código, dependencias, contenedores y configuraciones en la nube. Documentación

- **SonarQube:** Herramienta para el análisis estático de código (SAST), búsqueda de errores y vulnerabilidades. Documentación

- **OWASP ZAP:** Herramienta para el análisis dinámico de seguridad de aplicaciones (DAST). Documentación

- **Open Policy Agent (OPA):** Motor de políticas universal para la aplicación de políticas en CI/CD, Kubernetes y otros sistemas. Documentación

7. Utilidades adicionales

- **Docker Compose:** Para el desarrollo local y el despliegue de aplicaciones multicontenedor en VPS. Documentación

- **kubectl:** Línea de comandos para gestionar clústeres de Kubernetes. Documentación

- **SSH:** Herramienta básica para acceso remoto y ejecución de comandos en VPS.

- **cURL/Wget:** Para solicitudes HTTP y verificaciones post-despliegue.

8. Recursos útiles y documentación

- **CNCF Landscape:** Mapa interactivo de proyectos de Cloud Native Computing Foundation, que abarca una multitud de herramientas para contenedores y Kubernetes. Enlace

- **Awesome CI/CD:** Lista curada de recursos, herramientas y artículos sobre CI/CD. Enlace

- **DevOps Roadmap:** Hoja de ruta visual para aprender herramientas y conceptos de DevOps. Enlace

- **Blogs y comunidades:** Lea regularmente los blogs de empresas como GitLab, GitHub, HashiCorp, y participe en las comunidades de DevOps en Slack, Telegram, Reddit.

Recuerde que las herramientas son solo medios. Lo principal es comprender los principios y aplicarlos teniendo en cuenta las especificidades de su proyecto y equipo. No tema experimentar, pero siempre empiece poco a poco y amplíe gradualmente la funcionalidad de su pipeline CI/CD.

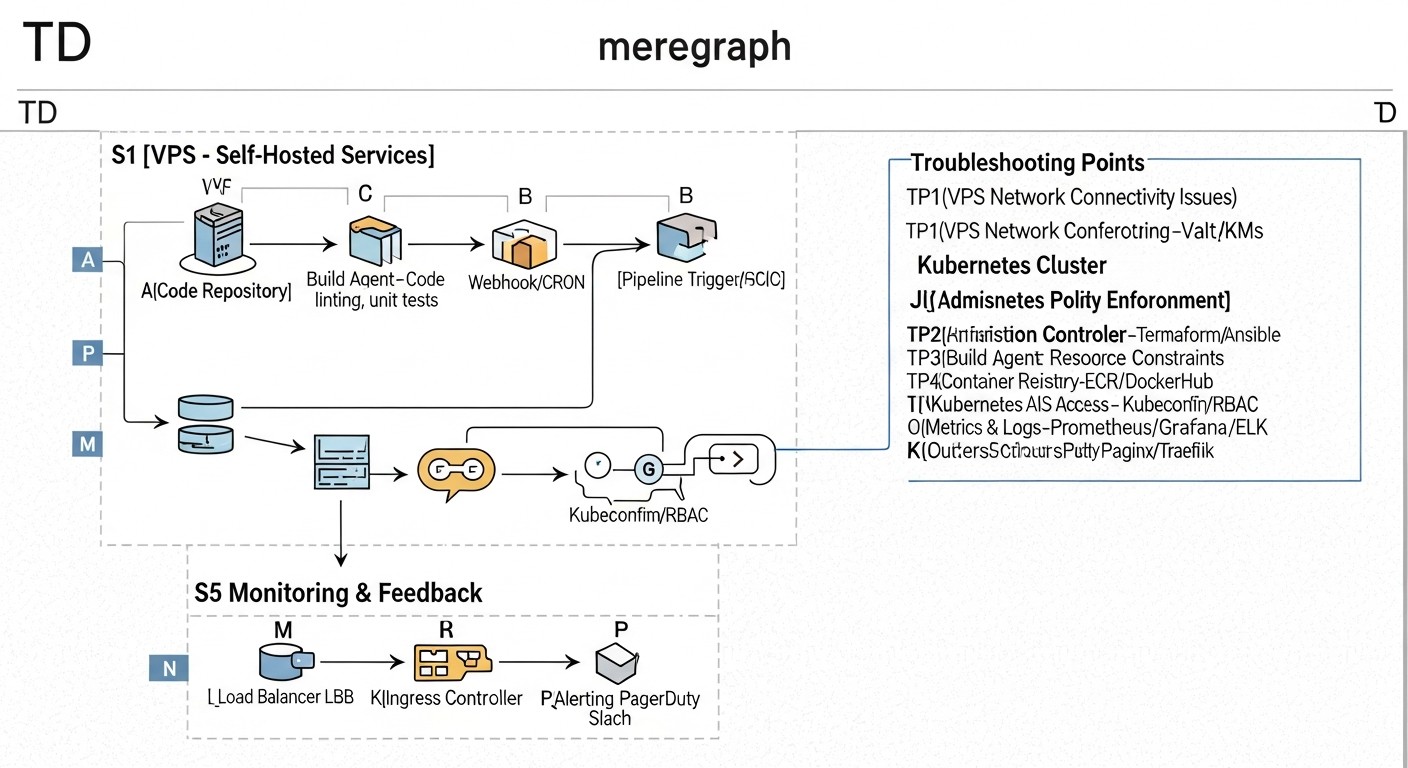

Troubleshooting: Resolución de problemas en pipelines CI/CD híbridos

Incluso el pipeline CI/CD más cuidadosamente diseñado tarde o temprano se enfrentará a problemas. En entornos híbridos, el diagnóstico puede ser especialmente complejo debido a la diversidad de plataformas y herramientas. Una resolución de problemas eficaz requiere un enfoque sistemático y el conocimiento de escenarios típicos.

Problemas típicos y sus soluciones:

1. La construcción de la imagen Docker falla o tarda demasiado

- **Problema:** Errores durante la compilación (dependencias faltantes, errores de sintaxis en el Dockerfile), compilación lenta.

- **Diagnóstico:**

- Verifique los registros de compilación en el sistema CI/CD.

- Ejecute localmente

docker build .en la raíz del proyecto para reproducir el error. - Utilice

docker history <image>para analizar las capas de la imagen.

- **Solución:**

- Optimice el Dockerfile: utilice compilaciones multi-etapa, almacenamiento en caché de capas, imágenes base mínimas (por ejemplo, Alpine).

- Asegúrese de que todas las dependencias estén disponibles y correctamente especificadas.

- Aumente los recursos para el runner de CI/CD si el problema es de rendimiento.

- Utilice el almacenamiento en caché de dependencias (por ejemplo,

npm cache,pip cache) en CI/CD.

2. El despliegue en VPS a través de SSH/Ansible falla

- **Problema:** Acceso SSH denegado, errores de ejecución de comandos, rutas incorrectas, problemas de permisos.

- **Diagnóstico:**

- Verifique los registros de CI/CD, busque mensajes de error específicos de SSH o Ansible.

- Intente conectarse manualmente al VPS desde la máquina donde se ejecuta el runner de CI/CD, utilizando las mismas credenciales (clave SSH).

- Verifique las rutas de los archivos y las variables de entorno en el VPS de destino.

- Ejecute Ansible con el flag

-vvvpara una salida detallada.

- **Solución:**

- Asegúrese de que la clave SSH tenga los permisos correctos (

chmod 400) y se haya añadido a CI/CD como un secreto. - Verifique que el usuario SSH tenga los permisos necesarios (por ejemplo, sudo sin contraseña para Ansible).

- Asegúrese de que el archivo Docker Compose y otras configuraciones se hayan copiado correctamente y estén en los directorios correctos.

- Verifique la accesibilidad de la red entre el runner y el VPS.

- Asegúrese de que la clave SSH tenga los permisos correctos (

3. La aplicación no se inicia o funciona incorrectamente después del despliegue en Kubernetes

- **Problema:** Pods en estado Pending/CrashLoopBackOff, el Service no entrega tráfico, la aplicación devuelve errores.

- **Diagnóstico:**

kubectl get pods -n <namespace>: Verifique el estado de los pods.kubectl describe pod <pod-name> -n <namespace>: Revise los eventos del pod, errores de inicio.kubectl logs <pod-name> -n <namespace>: Verifique los registros de la aplicación.kubectl get events -n <namespace>: Eventos generales del clúster.- Verifique la configuración de Service, Ingress, Deployment/StatefulSet.

- **Solución:**

- Asegúrese de que la imagen Docker esté disponible desde el clúster y se especifique correctamente en los manifiestos.

- Verifique

imagePullSecretssi se utiliza un registro privado. - Verifique

resource requests/limits: es posible que el pod no tenga suficientes recursos. - Asegúrese de que

livenessProbeyreadinessProbeestén configurados correctamente. - Verifique que las variables de entorno y los secretos se monten correctamente en el pod.

- Verifique las políticas de red (Network Policies) si se utilizan.

- Si se usa Helm:

helm status <release-name>,helm get manifest <release-name>. - Si se usa ArgoCD/FluxCD: verifique el estado de sincronización en la UI/CLI, revise los registros del controlador.

4. Problemas con la gestión de secretos

- **Problema:** La aplicación no puede acceder a la base de datos, a una clave API, o el runner de CI/CD no se autentica.

- **Diagnóstico:**

- Verifique que el secreto exista en el almacén (GitLab/GitHub Secrets, Vault, K8s Secrets).

- Verifique los permisos de acceso: si el runner de CI/CD/pod tiene los permisos necesarios para leer el secreto.

- Asegúrese de que el secreto se monte correctamente (para K8s) o se pase como variable de entorno.

- Verifique los registros de la aplicación en busca de errores de autorización.

- **Solución:**

- Vuelva a crear el secreto si hay sospechas de corrupción.

- Verifique la política de acceso (IAM, RBAC) para el runner de CI/CD o la cuenta de servicio en Kubernetes.

- Asegúrese de que los nombres de las variables de entorno o las claves en los archivos de configuración coincidan.

- Utilice tokens temporales y OIDC para minimizar los riesgos.

5. Funcionamiento lento del pipeline CI/CD

- **Problema:** Las compilaciones y los despliegues tardan demasiado, ralentizando el desarrollo.

- **Diagnóstico:**

- Utilice los dashboards integrados de CI/CD (GitLab, Jenkins) para analizar el tiempo de ejecución de cada etapa.

- Verifique la carga de CPU/RAM en los runners de CI/CD.

- Utilice

timepara medir la ejecución de comandos individuales en los scripts.

- **Solución:**

- Optimice el Dockerfile y los scripts de compilación (ver punto 1).

- Utilice el almacenamiento en caché de dependencias y artefactos entre compilaciones.

- Paralice las etapas del pipeline que no tienen dependencias.

- Aumente los recursos de los runners o utilice instancias más potentes.

- Optimice la interacción de red (por ejemplo, coloque los runners más cerca de los registros de artefactos).

Cuándo contactar al soporte:

- **Problemas con la plataforma CI/CD SaaS:** Si utiliza GitHub Actions, GitLab SaaS o CircleCI, y el problema está claramente relacionado con su infraestructura (por ejemplo, indisponibilidad del servicio, errores en sus runners), póngase en contacto con su soporte técnico.

- **Problemas con Kubernetes gestionado:** Si utiliza GKE, EKS, AKS y experimenta problemas a nivel de clúster (por ejemplo, indisponibilidad del servidor API, problemas con el Control Plane), póngase en contacto con el soporte del proveedor de la nube.

- **Vulnerabilidades críticas:** Si ha descubierto una vulnerabilidad crítica en una herramienta Open Source que utiliza, primero verifique si ya existe un parche o una solución conocida en la comunidad. Si no, informe a los desarrolladores del proyecto.

- **Errores no reproducibles:** Si no puede reproducir el problema localmente y los registros no proporcionan una imagen clara, es posible que esté relacionado con las características del entorno CI/CD o la plataforma de destino, y un experto externo o el soporte podrían ayudar.

Recuerde que una buena documentación de su pipeline CI/CD e infraestructura simplifica significativamente la resolución de problemas. Mantenga un registro de cambios para poder entender siempre qué se modificó y cuándo.

FAQ: Preguntas frecuentes sobre CI/CD híbrido

¿Qué es un entorno híbrido en el contexto de CI/CD?

Un entorno híbrido es una infraestructura que combina diferentes plataformas de despliegue. Por ejemplo, parte de las aplicaciones pueden ejecutarse en Virtual Private Servers (VPS) tradicionales o servidores dedicados, mientras que otra parte lo hace en orquestadores de contenedores como Kubernetes o Docker Swarm, posiblemente con elementos de computación sin servidor. El CI/CD para dicho entorno debe ser capaz de desplegar aplicaciones de manera eficiente en cada una de estas plataformas.

¿Por qué no se pueden simplemente migrar todas las aplicaciones a Kubernetes?

Migrar todas las aplicaciones a Kubernetes suele ser un proceso complejo, costoso y laborioso. Para las aplicaciones monolíticas heredadas, esto puede requerir una refactorización significativa. Además, para servicios pequeños y estables o bases de datos, los VPS a menudo ofrecen una mejor previsibilidad, simplicidad de gestión y un costo más bajo en comparación con los gastos generales de Kubernetes.

¿Qué herramienta CI/CD es la más adecuada para entornos híbridos?

No existe una herramienta "mejor" definitiva; la elección depende del tamaño del equipo, el presupuesto y los requisitos específicos. GitLab CI/CD y GitHub Actions ofrecen una excelente integración con Git y runners flexibles (autoalojados), lo que los convierte en buenas opciones. Jenkins proporciona la máxima flexibilidad y control, pero requiere un mayor esfuerzo de soporte. Una combinación de estas herramientas (por ejemplo, GitLab CI para la compilación y ArgoCD para el despliegue en Kubernetes) también es una solución popular.

¿Cómo garantizar la seguridad de CI/CD en un entorno híbrido?

La seguridad se logra mediante varias capas: gestión centralizada de secretos (Vault, Secrets Managers), ejecución de cada compilación en un entorno aislado (contenedores), integración de escáneres de vulnerabilidades (SAST, DAST, Trivy) en el pipeline, control de acceso estricto (RBAC) al sistema CI/CD y a los entornos objetivo, así como auditorías regulares de los registros.

¿Es necesario GitOps si tengo un VPS?

GitOps se centra principalmente en Kubernetes, donde proporciona una gestión declarativa del estado del clúster. Sin embargo, los principios de GitOps (Git como única fuente de verdad, declarativismo, despliegue pull-based) también pueden aplicarse a los VPS. Para ello, se pueden utilizar controladores GitOps especializados o CI/CD que monitoricen el repositorio Git y ejecuten playbooks de Ansible para el despliegue en VPS al detectar cambios.

¿Cómo gestionar las configuraciones para diferentes entornos (dev, stage, prod) en un CI/CD híbrido?

Utilice Infrastructure as Code (IaC) y parametrización. Para Kubernetes, pueden ser Helm charts con diferentes archivos values.yaml para cada entorno o Kustomize con overlays. Para VPS, playbooks de Ansible con variables específicas para cada entorno. Todas las configuraciones deben almacenarse en Git y versionarse.

¿Cómo garantizar una reversión rápida en un entorno híbrido?

La reversión automatizada es fundamental. Para Docker Compose en VPS, esto puede ser revertir a la imagen Docker anterior y reiniciar el servicio. En Kubernetes, es una función integrada (kubectl rollout undo), o revertir un lanzamiento de Helm, o revertir un commit en el repositorio GitOps. Asegúrese de que su CI/CD pueda desplegar de forma rápida y fiable la versión estable anterior.

¿Qué métricas de CI/CD son importantes para la monitorización?

Las métricas clave incluyen: tiempo de ejecución de cada etapa del pipeline, duración total de la compilación/despliegue, frecuencia de compilaciones exitosas/fallidas, uso de recursos por los runners (CPU, RAM), número de tareas pendientes en la cola. Estos datos ayudarán a identificar cuellos de botella y optimizar el rendimiento.

¿Cómo probar aplicaciones desplegadas en entornos híbridos?

Incluya en CI/CD todo tipo de pruebas: Unitarias, de Integración, E2E (End-to-End), de carga y de seguridad. Para entornos híbridos, las pruebas de contrato son especialmente importantes para asegurar que los servicios desplegados en diferentes plataformas interactúen correctamente. Las pruebas E2E deben verificar la funcionalidad a través de todos los componentes, independientemente de su ubicación.

¿Cómo combatir el "vendor lock-in" al elegir CI/CD para entornos híbridos?

Evite la dependencia estricta de funciones propietarias. Utilice tecnologías estandarizadas (Docker, Kubernetes, Git, YAML, Bash). Separe la lógica de compilación de la lógica de despliegue. Si es posible, utilice herramientas Open Source. Esto le permitirá migrar con relativa facilidad a otra plataforma CI/CD en el futuro si las necesidades cambian.

Conclusión

La construcción de un pipeline CI/CD universal para entornos híbridos no es solo una tarea técnica, sino un imperativo estratégico para la mayoría de las empresas modernas en 2026. Un mundo donde los VPS coexisten con Kubernetes, y los monolitos tradicionales interactúan con microservicios, exige flexibilidad, fiabilidad y un alto grado de automatización. Hemos comprobado que dicho pipeline no solo es posible, sino necesario para mantener la competitividad, acelerar la entrega de valor y optimizar los costos operativos.

La clave del éxito reside en varios principios fundamentales: la máxima abstracción de la lógica de despliegue mediante contenedores e Infrastructure as Code, la elección de herramientas capaces de trabajar con plataformas objetivo heterogéneas, y el cumplimiento estricto de las prácticas de seguridad y observabilidad. Independientemente de si elige soluciones integradas como GitLab CI o GitHub Actions, o prefiere un control total con Jenkins en combinación con herramientas GitOps como ArgoCD, es importante recordar la modularidad, la reutilización y la automatización de cada paso.

Recomendaciones finales:

- **Empiece poco a poco:** No intente automatizar todo de inmediato. Identifique las partes más críticas y frecuentemente modificadas de su aplicación y comience por automatizarlas.

- **Invierta en IaC:** Utilice Terraform, Ansible, Helm para describir declarativamente toda su infraestructura y configuraciones. Esto se amortizará muchas veces.

- **Contenerice todo:** Las imágenes Docker son un formato de artefacto universal que simplifica significativamente el despliegue en cualquier entorno.

- **Adopte GitOps para Kubernetes:** Si utiliza Kubernetes, el enfoque GitOps con ArgoCD o FluxCD se convertirá en su mejor aliado para despliegues fiables y transparentes.

- **Priorice la seguridad y la observabilidad:** Integre el escaneo de vulnerabilidades, el registro centralizado y la monitorización en cada etapa de su pipeline.

- **Capacite y desarrolle a su equipo:** CI/CD no es solo herramientas, sino también cultura. Invierta en la capacitación de su equipo para que puedan utilizar y desarrollar el pipeline de manera efectiva.

- **Optimice continuamente:** Su pipeline CI/CD es un organismo vivo. Analice regularmente su rendimiento, busque cuellos de botella y adáptese a las nuevas tecnologías y necesidades del negocio.

Próximos pasos para el lector:

Ahora que está armado con conocimientos y recomendaciones, es hora de actuar. Comience auditando su infraestructura y procesos actuales. Identifique los puntos más problemáticos y elija un pequeño proyecto para la implementación piloto de CI/CD híbrido. Experimente con las herramientas, utilice los ejemplos proporcionados y no tema cometer errores; cada error es una lección valiosa. En última instancia, un pipeline CI/CD universal bien construido se convertirá en la piedra angular de su cultura de ingeniería, proporcionando estabilidad, velocidad y una ventaja competitiva en el mundo en constante cambio del desarrollo de software.