Despliegue de funciones sin servidor (FaaS) en su servidor VPS/Dedicado con OpenFaaS o Knative: Guía Experta 2026

TL;DR

- FaaS autohospedado es la tendencia de 2026: El control, el ahorro y la flexibilidad se vuelven críticos, especialmente para proyectos con datos sensibles o requisitos presupuestarios estrictos, a diferencia de las costosas soluciones de nube propietarias.

- OpenFaaS para simplicidad y velocidad: Ideal para un inicio rápido y equipos pequeños, funciona en cualquier Kubernetes o Docker Swarm, ofrece un rico conjunto de plantillas y una comunidad activa.

- Knative para una integración profunda con Kubernetes: Proporciona potentes capacidades de escalado (hasta cero), gestión de tráfico y arquitectura basada en eventos sobre primitivas nativas de Kubernetes, adecuado para sistemas complejos y de alta carga.

- Factores clave de elección: El rendimiento, la escalabilidad, los costos operativos, el ecosistema, la curva de aprendizaje y el costo juegan un papel decisivo. En 2026, se presta especial atención a la eficiencia energética y la integración con cargas de trabajo de IA/ML.

- Ahorro y control: El despliegue de FaaS en su propio servidor permite reducir significativamente los costos operativos a largo plazo, evitar la dependencia de un proveedor de nube específico y asegurar un control total sobre los datos y la infraestructura.

- Automatización obligatoria: Para una gestión exitosa de FaaS autohospedado, son cruciales CI/CD, IaC (Terraform, Ansible) y sistemas avanzados de monitoreo (Prometheus, Grafana, Loki) para minimizar las operaciones manuales.

- El futuro está en las soluciones híbridas: Se espera un crecimiento en la popularidad de las estrategias FaaS híbridas, donde parte de las funciones operan en la nube pública y las críticas en hardware propio, lo que proporciona un equilibrio entre flexibilidad y seguridad.

Introducción

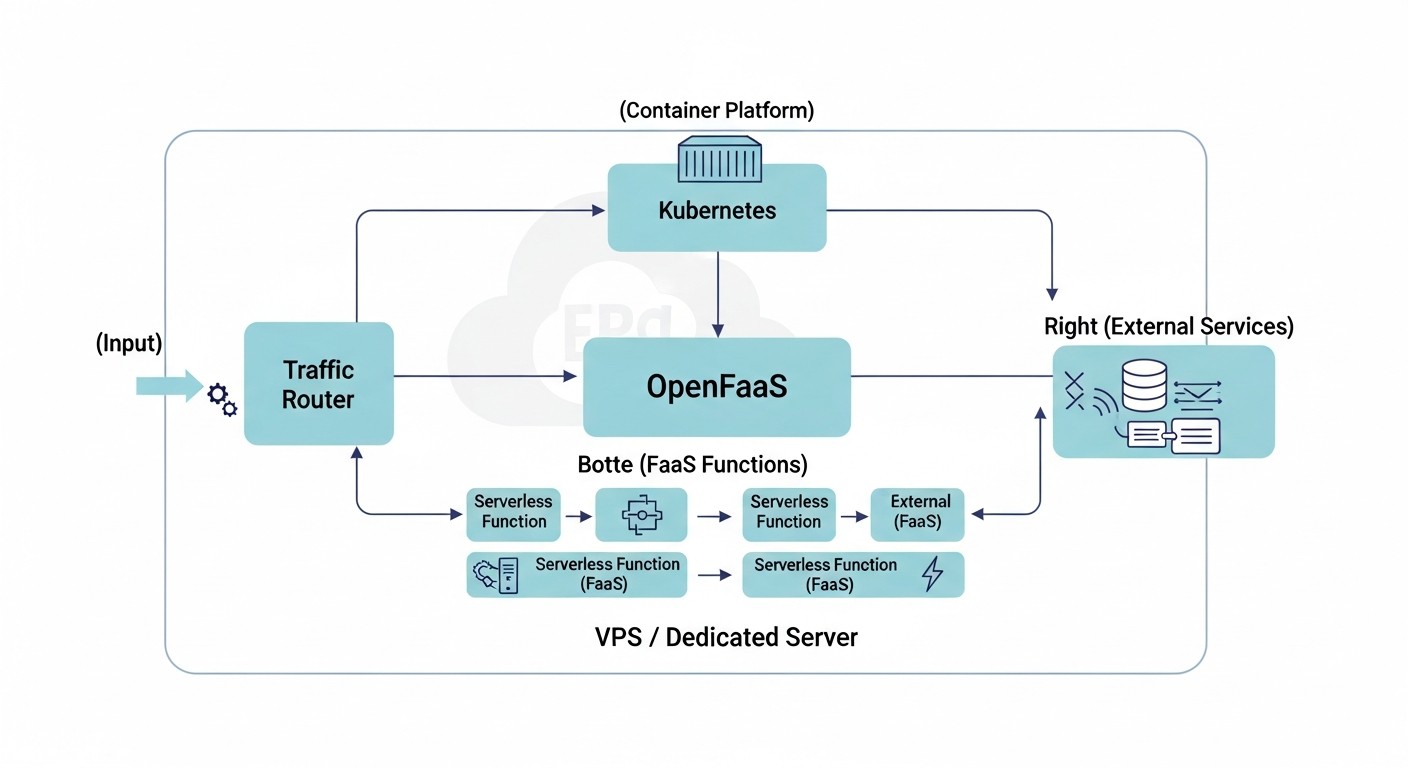

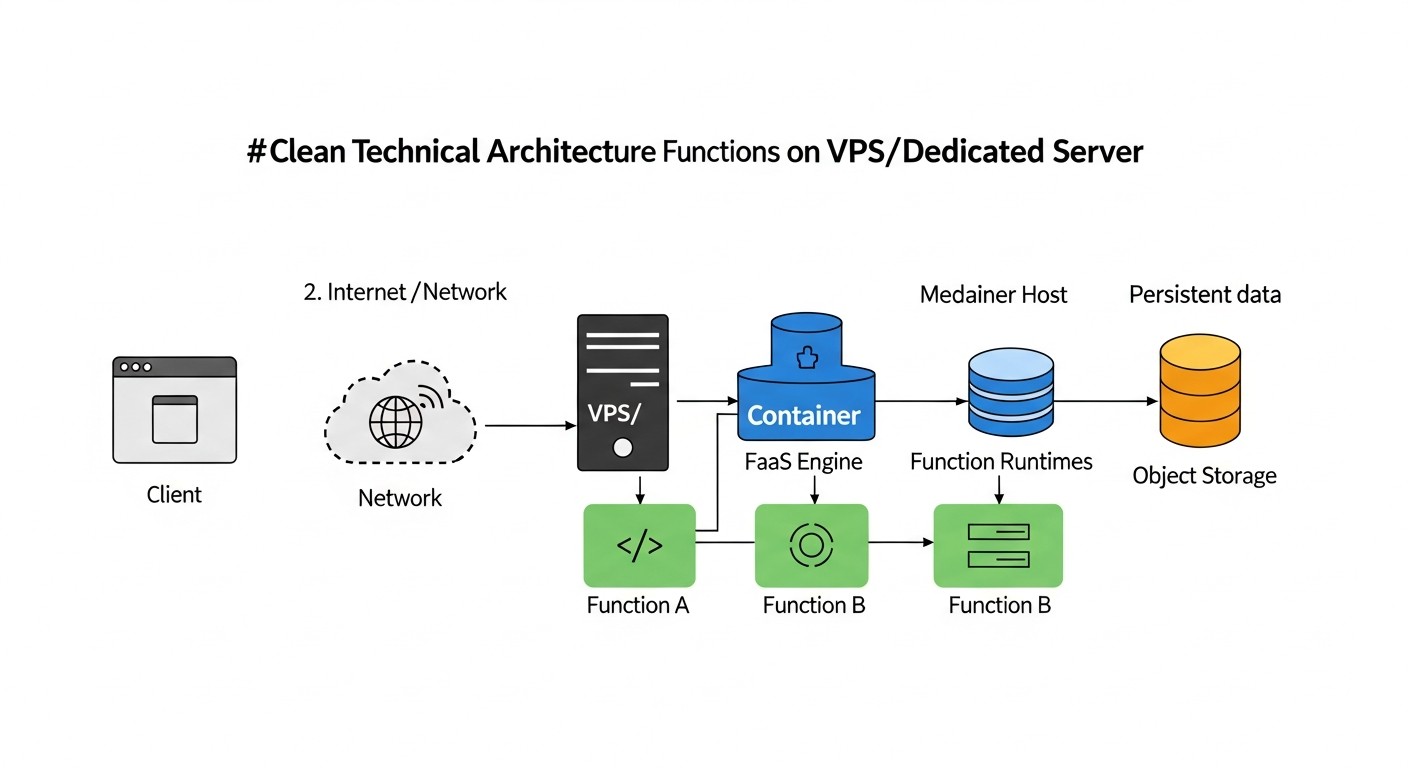

En 2026, el concepto de computación sin servidor (Serverless, Functions as a Service - FaaS) ya no es futurista, sino que se ha convertido en un estándar de facto para muchas arquitecturas modernas. Sin embargo, si antes FaaS se asociaba exclusivamente con nubes públicas (AWS Lambda, Google Cloud Functions, Azure Functions), ahora cada vez más empresas, especialmente startups y medianas empresas, están repensando este paradigma. Las razones son simples: el aumento de los costos de los servicios en la nube, el deseo de un control total sobre los datos y la infraestructura, y la aspiración de evitar la dependencia del proveedor. Es aquí donde entran en juego las soluciones para desplegar FaaS en su propio VPS o servidor dedicado, como OpenFaaS y Knative.

Este artículo está dirigido a ingenieros DevOps, desarrolladores backend, fundadores de proyectos SaaS, administradores de sistemas y directores técnicos de startups que buscan alternativas a las costosas plataformas FaaS en la nube o desean construir soluciones de nube híbridas. Nos sumergiremos profundamente en el mundo de OpenFaaS y Knative, examinaremos sus ventajas y desventajas, proporcionaremos recomendaciones prácticas para el despliegue y la operación, y ayudaremos a evaluar la viabilidad económica de este enfoque.

Vivimos en una era en la que la optimización de recursos y la independencia de proveedores externos no solo son deseables, sino a menudo críticamente importantes. Con el crecimiento de la complejidad de las aplicaciones y los volúmenes de datos, así como el endurecimiento de los requisitos de confidencialidad, la capacidad de desplegar funciones sin servidor en hardware propio, manteniendo la flexibilidad y la escalabilidad, se convierte en una poderosa ventaja competitiva. El objetivo de esta guía es brindarle toda la información necesaria para tomar una decisión informada y una implementación exitosa de la estrategia FaaS en su propia infraestructura.

Criterios clave y factores de elección

La elección entre OpenFaaS y Knative, así como la decisión de desplegar FaaS en su propio servidor, deben basarse en un análisis exhaustivo de múltiples factores. En 2026, cuando las tecnologías avanzan a pasos agigantados y los requisitos de fiabilidad y rendimiento crecen constantemente, estos criterios se vuelven aún más significativos.

1. Rendimiento y tiempo de arranque en frío (Cold Start Latency)

El tiempo de arranque en frío es el retraso entre la invocación de una función y el inicio de su ejecución, si la instancia de la función está inactiva. Para muchas aplicaciones interactivas (pasarelas API, webhooks), este es un parámetro crítico. En 2026, los usuarios esperan una reacción instantánea. OpenFaaS y Knative tienen diferentes enfoques para gestionar el ciclo de vida de las funciones, lo que afecta el arranque en frío. Knative, gracias a su integración con Kourier/Istio y sus avanzados mecanismos de autoescalado, puede lograr valores muy bajos, hasta milisegundos, mediante el "calentamiento" de contenedores o el uso de primitivas especializadas. OpenFaaS también trabaja activamente en la optimización, ofreciendo diversas estrategias para mantener instancias activas. La evaluación debe realizarse con cargas reales, considerando el tamaño y el lenguaje típicos de la función.

2. Escalabilidad y autoescalado

La capacidad de escalar automáticamente las funciones en respuesta a una carga cambiante es la piedra angular de FaaS. En 2026, esto significa no solo escalado horizontal, sino también una gestión inteligente de los recursos. Knative Serverless está construido sobre Kubernetes HPA (Horizontal Pod Autoscaler) y KEDA (Kubernetes Event-Driven Autoscaling), lo que permite escalar de cero a cientos de instancias en segundos, utilizando métricas de CPU, memoria, solicitudes o eventos personalizados. Esto es especialmente importante para tareas con cargas pico. OpenFaaS también soporta autoescalado a través de HPA y KEDA, pero su arquitectura puede requerir una configuración más fina para lograr el mismo nivel de granularidad y velocidad de escalado a cero. Para la evaluación, es necesario realizar pruebas de carga con diferentes perfiles de carga.

3. Costos operativos y complejidad de gestión

El despliegue de FaaS en su propio servidor implica la responsabilidad de toda la infraestructura. Esto incluye la gestión del clúster de Kubernetes (si se utiliza), la actualización de componentes, el monitoreo, el registro y la seguridad. Knative, al estar más estrechamente integrado con Kubernetes, puede requerir un conocimiento más profundo del ecosistema de Kubernetes. OpenFaaS, especialmente en modo Docker Swarm, ofrece un umbral de entrada más bajo. En 2026, cada vez más herramientas de automatización e IaC (Infrastructure as Code) simplifican estas tareas, pero la comprensión básica sigue siendo crítica. La evaluación debe incluir el tiempo que el equipo necesita para aprender y mantener el sistema, así como la disponibilidad de especialistas cualificados.

4. Ecosistema e integración

¿Qué tan bien se integra la plataforma FaaS con otras herramientas y servicios? En 2026, esto significa una operación sin problemas con sistemas CI/CD, bases de datos, brokers de mensajes (Kafka, RabbitMQ, NATS), sistemas de monitoreo (Prometheus, Grafana) y herramientas de datos (por ejemplo, almacenamiento de objetos). Knative, como parte del ecosistema de Kubernetes, se beneficia naturalmente de un rico conjunto de plugins e integraciones de Kubernetes. OpenFaaS también tiene un ecosistema extenso y soporta la integración a través de pasarelas y plugins, pero puede requerir más esfuerzo para vincularse con algunos servicios específicos de Kubernetes. Es importante evaluar la facilidad con la que se pueden conectar los servicios existentes o planificados.

5. Curva de aprendizaje y umbral de entrada

¿Qué tan rápido su equipo podrá dominar la nueva plataforma y comenzar a trabajar productivamente? OpenFaaS a menudo se considera más fácil de empezar debido a su enfoque en "funciones como contenedores Docker" y su CLI. Knative, con sus conceptos de Service, Revision, Configuration, Route y una profunda integración con Kubernetes, puede tener una curva de aprendizaje más pronunciada, especialmente para aquellos que no están muy familiarizados con Kubernetes. Sin embargo, para equipos que ya trabajan con Kubernetes, Knative puede parecer una opción más natural. En 2026, la disponibilidad de materiales de capacitación, documentación y una comunidad activa influye en gran medida en este factor.

6. Costo y eficiencia económica (TCO - Total Cost of Ownership)

Este es uno de los factores clave para la transición a hardware propio. En 2026, el costo de propiedad incluye no solo el hardware (VPS/Dedicado), sino también los costos de electricidad (para dedicado), licencias (si aplica, pero OpenFaaS/Knative son de código abierto), salarios de ingenieros, tiempo de desarrollo, pruebas, despliegue y soporte. El despliegue de FaaS autohospedado permite evitar los recargos de la nube por cada invocación de función y por el uso de recursos, pero transfiere la carga operativa a su equipo. Es importante realizar un cálculo detallado del TCO, comparándolo con los gastos potenciales de las alternativas en la nube. Se espera que en 2026 el costo de gigabyte-segundos en la nube siga aumentando, lo que hace que FaaS autohospedado sea aún más atractivo para proyectos a largo plazo.

7. Seguridad y cumplimiento de requisitos (Compliance)

El despliegue en su propio servidor otorga un control total sobre la seguridad. Usted es responsable del aislamiento de red, el parcheo del sistema operativo, la gestión de acceso, el cifrado de datos y el cumplimiento normativo (GDPR, PCI DSS, etc.). OpenFaaS y Knative utilizan aislamiento de contenedores, lo cual es una buena base, pero requiere configuración adicional. En 2026, con el aumento de las ciberamenazas y las regulaciones, la capacidad de controlar completamente la pila de seguridad se vuelve críticamente importante. Es necesario evaluar si su equipo tiene la experiencia para garantizar el nivel de seguridad adecuado.

8. Resistencia a fallos y alta disponibilidad (High Availability)

¿Cómo se comportará el sistema en caso de fallo de un componente individual o de un servidor completo? Knative, construido sobre Kubernetes, hereda naturalmente sus capacidades de autorrecuperación y operación distribuida. Para lograr alta disponibilidad, se requiere un clúster de Kubernetes, no un solo VPS. OpenFaaS también puede funcionar en un clúster de Kubernetes o Docker Swarm, proporcionando HA. Es importante diseñar la infraestructura con redundancia, utilizando múltiples VPS o servidores dedicados, balanceadores de carga y replicación de datos. Evalúe cuánto tiempo podría llevar la recuperación después de un fallo y qué pérdidas de datos son aceptables.

9. Soporte de lenguajes y frameworks

Ambas plataformas soportan una amplia gama de lenguajes de programación a través del concepto de "funciones como contenedores". Puede empaquetar prácticamente cualquier código en una imagen Docker y ejecutarlo. OpenFaaS ofrece plantillas listas para lenguajes populares (Python, Node.js, Go, .NET Core, Java), lo que acelera el desarrollo. Knative también es flexible, permitiendo el uso de cualquier aplicación contenerizada. En 2026, esto significa soporte no solo para lenguajes tradicionales, sino también para nuevos runtimes, así como entornos especializados para modelos de IA/ML. Es importante asegurarse de que la plataforma elegida soporte o sea fácilmente extensible para soportar los lenguajes y frameworks utilizados por su equipo.

Tabla comparativa OpenFaaS vs Knative (Actualizado a 2026)

A continuación se presenta una tabla comparativa que le ayudará a evaluar visualmente las diferencias clave entre OpenFaaS y Knative, teniendo en cuenta las tendencias y características actuales para 2026.

| Criterio | OpenFaaS | Knative | Comentarios (2026) |

|---|---|---|---|

| Plataforma base | Kubernetes, Docker Swarm | Solo Kubernetes | OpenFaaS mantiene la flexibilidad, Knative profundiza la integración con Kubernetes, lo que se convierte en un estándar para sistemas complejos. |

| Complejidad de despliegue | Baja-Media (especialmente en Docker Swarm) | Media-Alta (requiere Kubernetes y sus componentes) | Con la aparición de Kubernetes gestionado en VPS (por ejemplo, k3s, MicroK8s), la complejidad de Knative disminuye, pero OpenFaaS sigue siendo más sencillo para POC. |

| Escalado a cero | Soportado, pero requiere configuración (KEDA) | Integrado nativamente y optimizado | Knative sigue siendo líder en este aspecto, lo cual es crítico para el ahorro de recursos en ausencia de carga. |

| Arranque en frío | Bueno (50-300 ms) | Excelente (10-100 ms, con optimización) | Knative utiliza mecanismos más avanzados para minimizar los retrasos, incluyendo el "calentamiento" y el enrutamiento rápido. |

| Gestión de tráfico | Básica (a través de la pasarela) | Avanzada (despliegues canary, pruebas A/B, distribución porcentual) | Knative, gracias a Istio/Kourier, ofrece funciones de nivel L7, indispensables para estrategias de lanzamiento complejas. |

| Modelo de eventos | A través de la pasarela, brokers externos (NATS, Kafka) | Integración nativa con Knative Eventing (CloudEvents, brokers) | Knative Eventing se convierte en una potente plataforma para arquitecturas basadas en eventos, soportando múltiples fuentes de eventos. |

| Ecosistema y comunidad | Activa, muchas plantillas de funciones | Muy activa, soportada por Google, proyecto CNCF | Ambos proyectos tienen comunidades fuertes, pero Knative está más estrechamente relacionado con el ecosistema general de Kubernetes. |

| Uso de recursos (Inactivo) | Medio (depende de la configuración) | Bajo (gracias al escalado a cero) | Knative es significativamente más eficiente en modo inactivo, lo cual es importante para servidores VPS/Dedicados con costo fijo. |

| Integración con CI/CD | Buena (faas-cli, Docker) | Excelente (kubectl, Tekton, Argo CD) | Ambos se integran fácilmente, pero Knative ofrece enfoques más "nativos de Kubernetes", como Tekton. |

| Requisitos mínimos de CPU/RAM (para el motor FaaS) | 1 vCPU / 1 GB RAM | 2 vCPU / 2 GB RAM (más Kubernetes) | Estos valores son actuales para 2026 para un clúster FaaS mínimo de trabajo sin funciones de usuario. |

| Costo estimado de 1 vCPU / 2GB RAM VPS en 2026 | Desde 8-15 USD/mes | Desde 8-15 USD/mes (más recursos adicionales para K8s) | El costo de un VPS básico se mantendrá relativamente estable, pero para Knative se requerirá un K8s base más potente. |

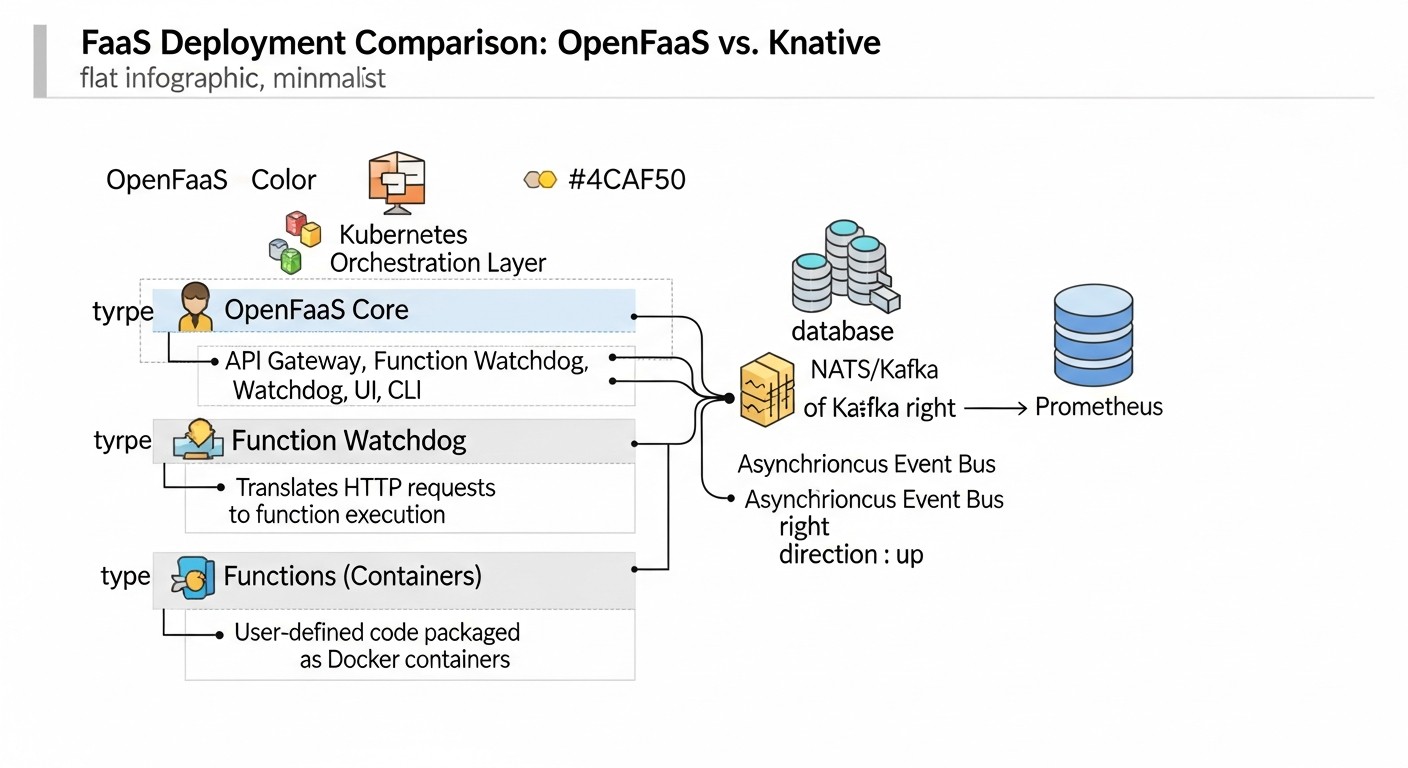

Análisis detallado de OpenFaaS

OpenFaaS (Functions as a Service) es un framework para crear funciones sin servidor utilizando contenedores Docker. Proporciona una forma sencilla de empaquetar cualquier proceso o servicio en una función sin servidor que puede desplegarse en Kubernetes o Docker Swarm. El proyecto fue lanzado por Alex Ellis en 2017 y desde entonces ha evolucionado activamente, ofreciendo un enfoque conveniente y flexible para FaaS en infraestructura propia.

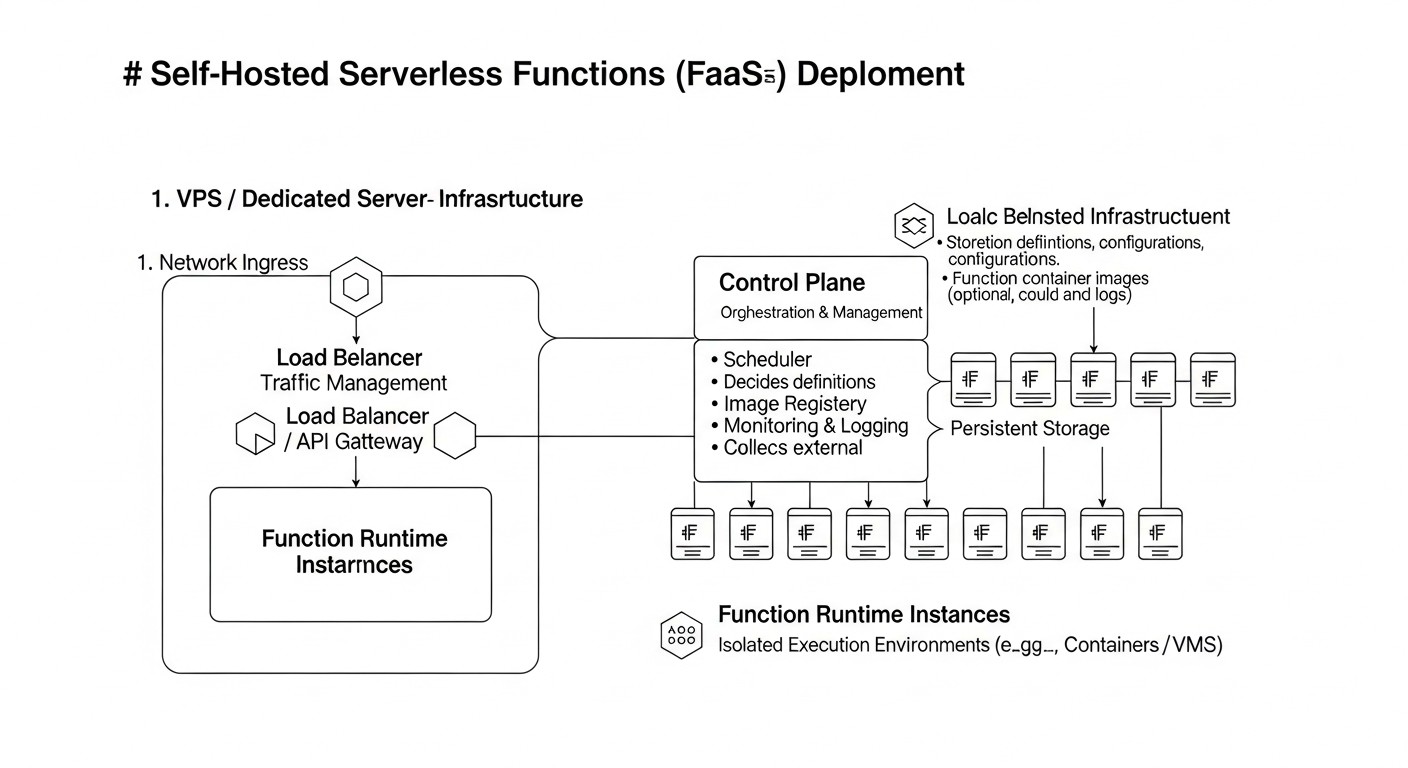

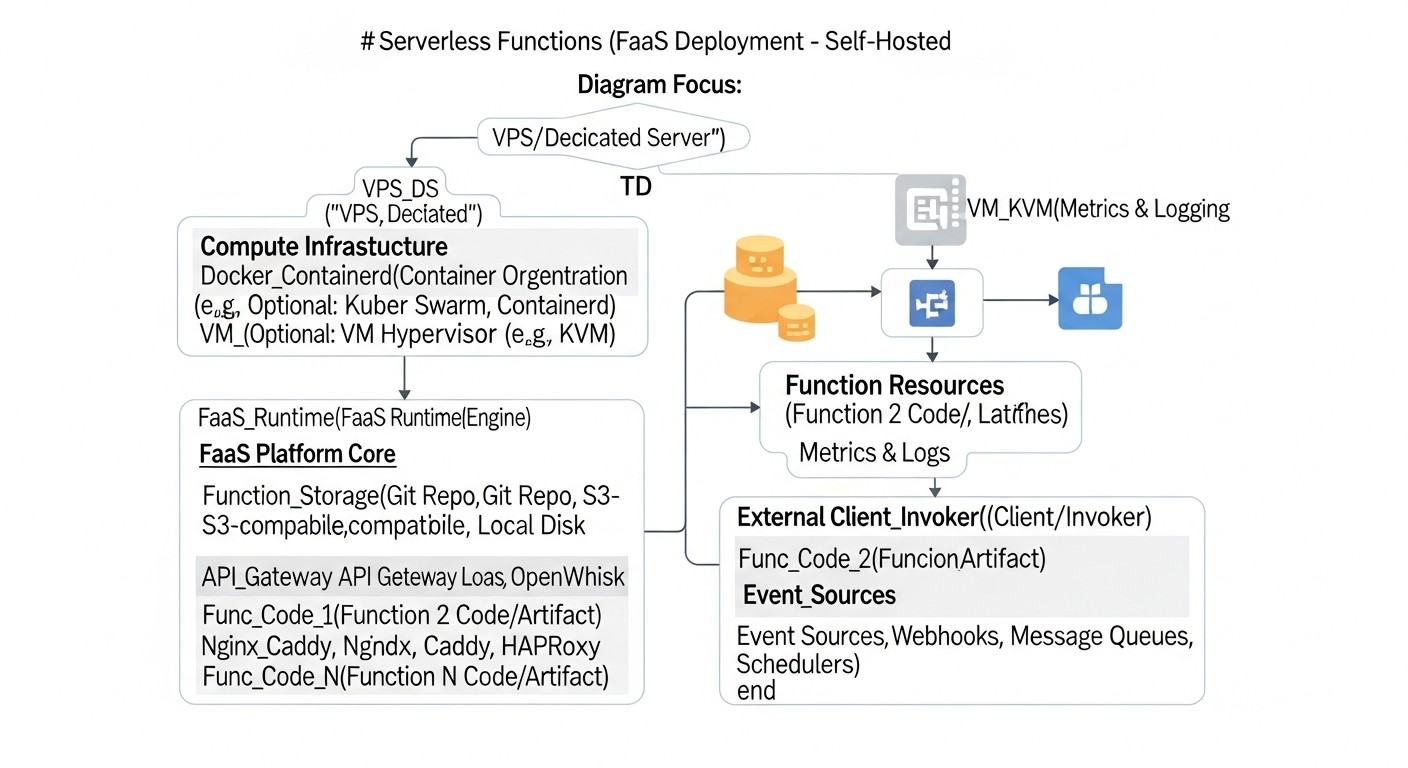

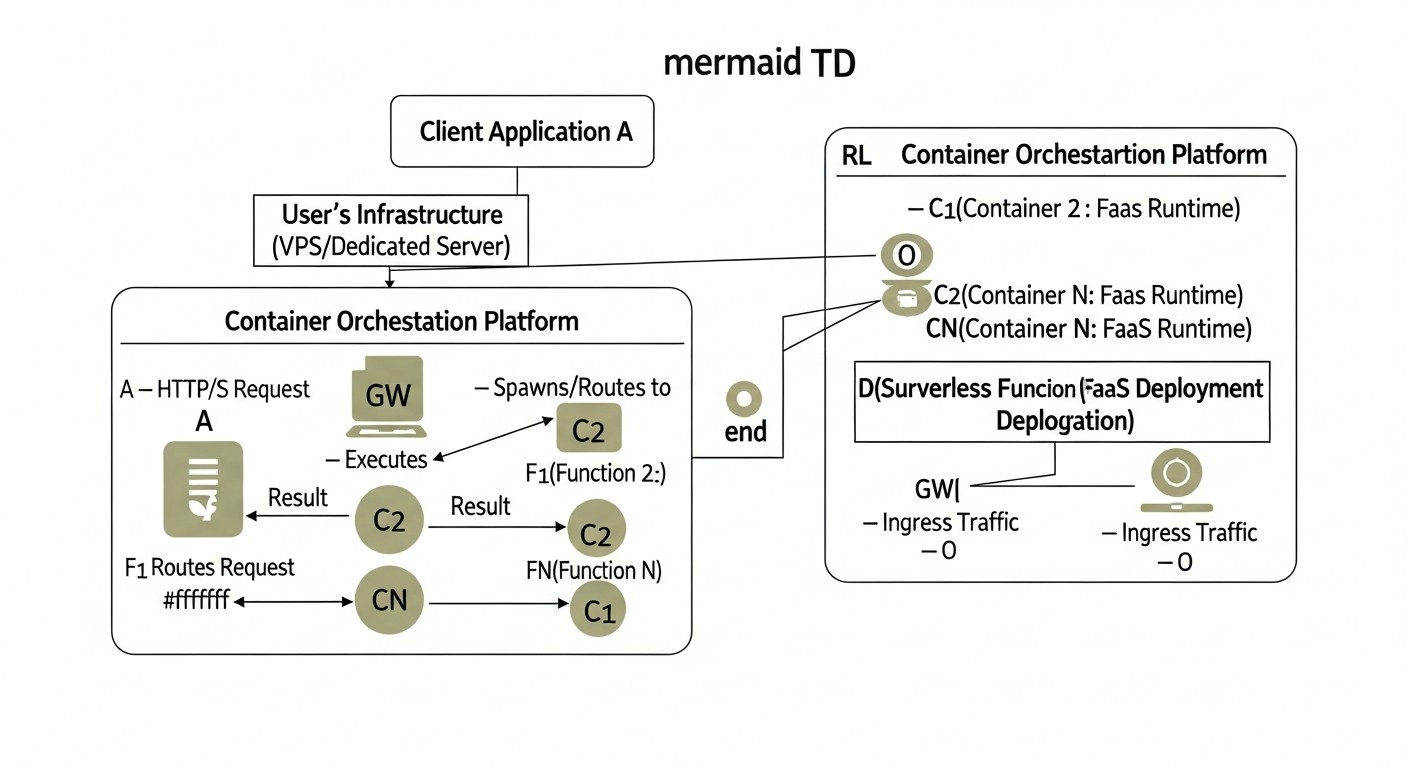

Principio de funcionamiento y arquitectura

La arquitectura de OpenFaaS se basa en varios componentes clave:

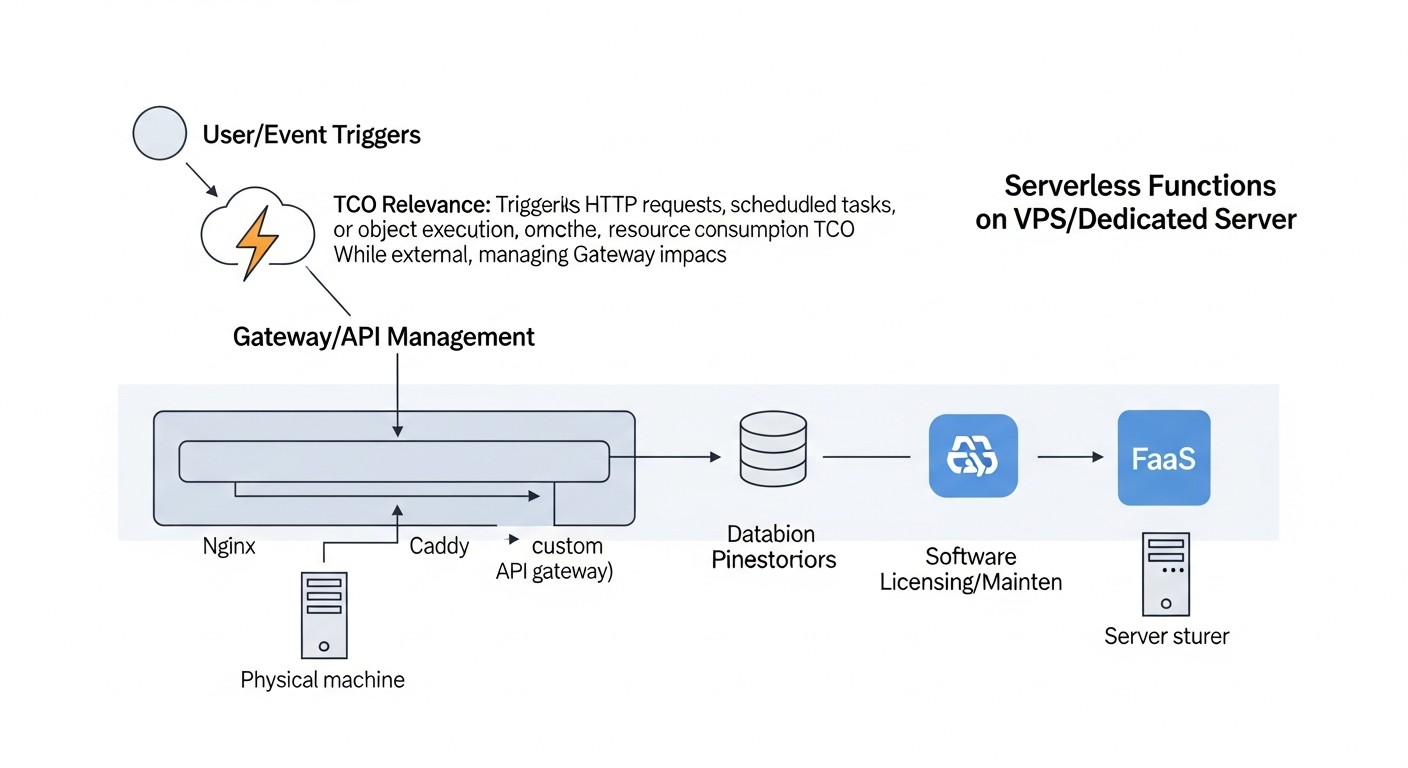

- Gateway (Pasarela): Esta es la interfaz principal para interactuar con OpenFaaS. Procesa las solicitudes entrantes, las enruta a las funciones correspondientes, gestiona el autoescalado y proporciona una API para el despliegue y la gestión de funciones. La pasarela también es responsable de la recopilación de métricas y el registro.

- Function Watchdog: Este componente se ejecuta dentro de cada contenedor de función y es responsable de procesar las solicitudes HTTP entrantes, pasarlas a su función y devolver los resultados. Abstrae al desarrollador de los detalles de interacción con la plataforma, permitiéndole centrarse en la lógica de la función.

- Prometheus: OpenFaaS utiliza Prometheus para recopilar métricas sobre invocaciones de funciones, tiempo de ejecución, errores y estado del sistema. Estas métricas se utilizan para el autoescalado y el monitoreo.

- NATS Streaming (opcional): Para llamadas asíncronas y procesamiento de eventos, OpenFaaS puede utilizar NATS Streaming como broker de mensajes. Esto permite construir arquitecturas basadas en eventos más complejas.

Las funciones en OpenFaaS son contenedores Docker ordinarios. Usted escribe código en cualquier lenguaje, utiliza las plantillas proporcionadas (o crea las suyas propias), y la CLI de OpenFaaS (faas-cli) le ayuda a construir la imagen Docker y desplegarla. Esto hace que OpenFaaS sea extremadamente flexible, ya que puede utilizar cualquier biblioteca y dependencia que pueda empaquetarse en un contenedor.

Ventajas de OpenFaaS

- Simplicidad y rapidez de inicio: OpenFaaS es conocido por su bajo umbral de entrada. Con la ayuda de

faas-cliy unos pocos comandos, se puede desplegar rápidamente la primera función. Esto es especialmente atractivo para equipos pequeños o para la creación de prototipos. - Flexibilidad de la plataforma: El soporte tanto para Kubernetes como para Docker Swarm ofrece la posibilidad de elegir según la infraestructura actual y la experiencia del equipo. En 2026, cuando Kubernetes domina, el soporte para Swarm sigue siendo una opción de nicho, pero útil.

- Amplio soporte de lenguajes: Gracias a su naturaleza de contenedor, OpenFaaS puede ejecutar funciones escritas en cualquier lenguaje para el que se pueda crear una imagen Docker. Existen plantillas listas para Python, Node.js, Go, Java, PHP, Ruby, .NET Core y otros.

- Comunidad y ecosistema activos: El proyecto cuenta con una comunidad grande y activa, muchos ejemplos, plugins e integraciones. La documentación está bien estructurada y se actualiza constantemente.

- Código abierto: El código fuente completamente abierto significa la ausencia de dependencia del proveedor y la posibilidad de una personalización completa según sus necesidades.

- Llamadas asíncronas y Event-Driven: El soporte integrado para llamadas asíncronas a través de NATS Streaming permite construir fácilmente arquitecturas basadas en eventos, lo que se vuelve cada vez más importante en 2026.

Desventajas de OpenFaaS

- Menos integración nativa con Kubernetes: Aunque OpenFaaS funciona en Kubernetes, no utiliza sus primitivas tan profundamente como Knative. Esto puede llevar a la necesidad de configuración adicional para usar funciones avanzadas de Kubernetes (por ejemplo, Service Mesh).

- El escalado a cero requiere KEDA: Para escalar funciones a cero de manera eficiente (y ahorrar recursos en inactividad), OpenFaaS requiere la instalación y configuración de KEDA, lo que añade una capa adicional de complejidad. Sin KEDA, las funciones pueden permanecer en estado "caliente", consumiendo recursos.

- Menos capacidades integradas de gestión de tráfico: En comparación con Knative, OpenFaaS ofrece capacidades más básicas de gestión de tráfico (despliegues canary, pruebas A/B) "de fábrica". Para escenarios avanzados, se requerirá la integración con herramientas externas, como Istio.

- Posible aumento de los costos operativos: Aunque el inicio es sencillo, para mantener un sistema OpenFaaS altamente disponible y de alto rendimiento en Kubernetes se requiere una comprensión de ambas pilas, lo que puede aumentar la carga operativa.

Para quién es adecuado OpenFaaS

OpenFaaS es ideal para:

- Startups y equipos pequeños: Que necesitan una plataforma FaaS rápida y sencilla para prototipos y despliegue de microservicios sin inversiones significativas en el aprendizaje de Kubernetes.

- Desarrolladores que prefieren Docker: Aquellos que ya están familiarizados con Docker y valoran su simplicidad para empaquetar aplicaciones.

- Proyectos con requisitos de escalado moderados: Donde no se requiere un escalado instantáneo a cientos de miles de solicitudes por segundo o latencias ultrabajas.

- Empresas que buscan la máxima flexibilidad: Y no desean estar atadas a una plataforma o proveedor de nube específico.

- Desarrolladores que crean arquitecturas Event-Driven: Gracias al soporte nativo de llamadas asíncronas y la integración con NATS.

En 2026, OpenFaaS sigue siendo un actor fuerte en el nicho de FaaS autohospedado, especialmente para aquellos que valoran la simplicidad y el control directo sobre los contenedores Docker.

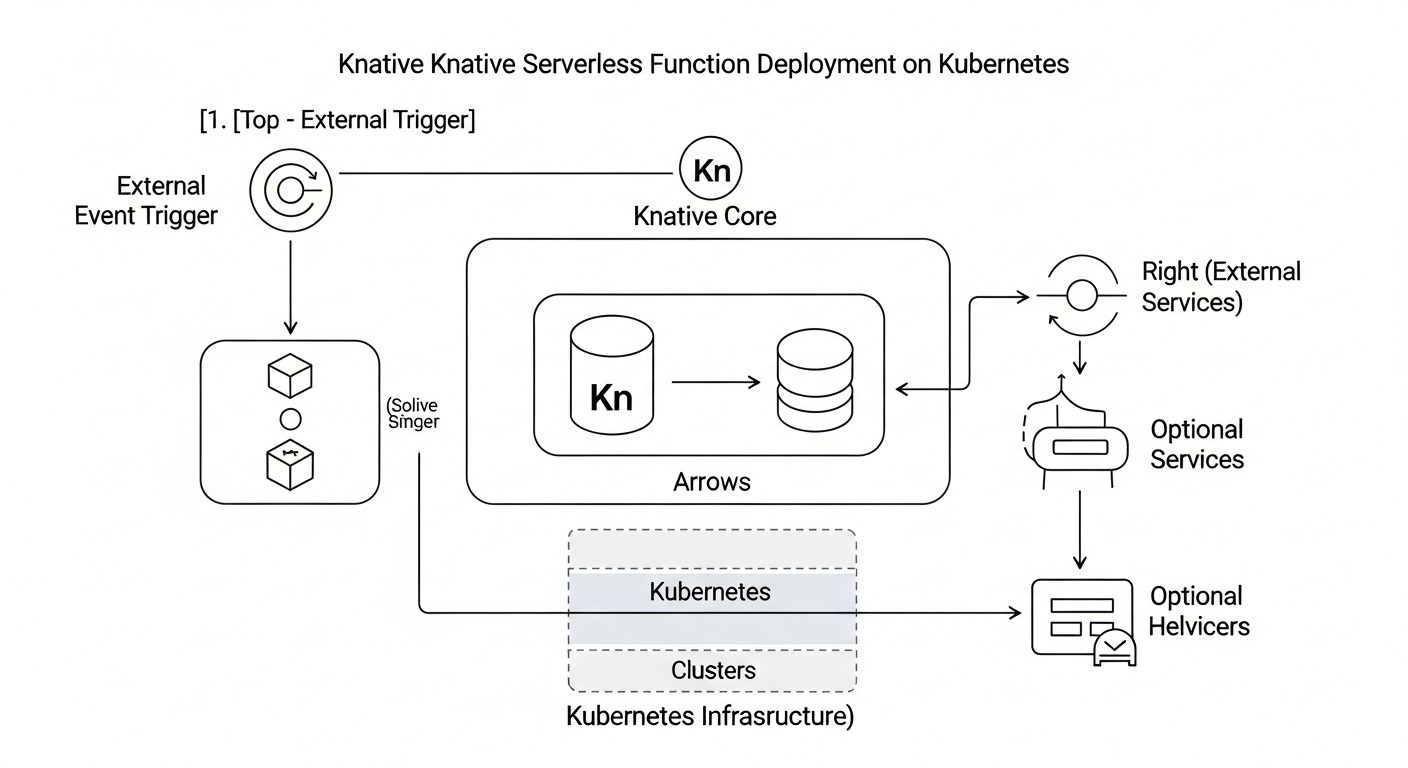

Análisis detallado de Knative

Knative es una plataforma construida sobre Kubernetes, diseñada para desplegar y gestionar cargas de trabajo sin servidor, contenedores y funciones. El proyecto fue lanzado por Google en 2018 y desde entonces se ha convertido en uno de los componentes clave en el ecosistema de soluciones sin servidor en Kubernetes. Knative no es una plataforma FaaS completa en el sentido puro, sino más bien un conjunto de extensiones para Kubernetes que proporciona primitivas para construir aplicaciones Serverless. Consta de dos componentes principales: Knative Serving y Knative Eventing.

Principio de funcionamiento y arquitectura

Knative está profundamente integrado con Kubernetes y utiliza sus capacidades para gestionar el ciclo de vida de las aplicaciones. Su arquitectura se basa en los siguientes componentes:

- Knative Serving: Este componente es responsable del despliegue y escalado de servicios (contenedores), así como de la gestión del tráfico. Proporciona objetos de Kubernetes (Service, Configuration, Revision, Route) que permiten definir cómo deben desplegarse, escalarse (incluyendo a cero) y enrutarse las aplicaciones. Serving utiliza un Service Mesh (como Istio o Kourier) para gestionar el tráfico entrante y el enrutamiento.

- Knative Eventing: Este componente está diseñado para crear arquitecturas basadas en eventos. Proporciona primitivas para enviar y recibir eventos (a través de CloudEvents), así como para enrutarlos entre diferentes servicios. Eventing soporta diversas fuentes de eventos (brokers de mensajes, servicios SaaS) y permite construir cadenas complejas de procesamiento de eventos.

- Kubernetes: Knative funciona sobre un clúster de Kubernetes existente, utilizando sus capacidades para la orquestación de contenedores, la gestión de recursos y la garantía de tolerancia a fallos.

- Service Mesh (Istio/Kourier): Knative Serving utiliza activamente un Service Mesh para gestionar el tráfico entrante, proporcionar despliegues canary, pruebas A/B y otras funciones avanzadas de enrutamiento. Kourier es un controlador Ingress ligero, desarrollado específicamente para Knative.

Las funciones en Knative son esencialmente aplicaciones contenerizadas. Puede utilizar cualquier lenguaje o framework que pueda empaquetarse en una imagen Docker. Knative crea automáticamente rutas Ingress, gestiona el escalado y monitorea el estado del servicio.

Ventajas de Knative

- Escalado nativo a cero: Esta es una de las principales ventajas de Knative. Escala automáticamente los servicios a cero cuando no hay tráfico entrante, y los inicia rápidamente cuando aparecen nuevas solicitudes. Esto permite ahorrar significativamente recursos en un servidor VPS/Dedicado.

- Gestión avanzada de tráfico: Gracias a la integración con Service Mesh (Istio/Kourier), Knative ofrece potentes capacidades de gestión de tráfico: despliegues canary, pruebas A/B, distribución porcentual del tráfico entre diferentes versiones de servicios. Esto es críticamente importante para CI/CD y lanzamientos seguros.

- Integración profunda con Kubernetes: Knative extiende Kubernetes, utilizando sus primitivas nativas. Esto significa que Knative "entiende" Kubernetes e interactúa bien con él, lo que simplifica la gestión para equipos que ya trabajan con Kubernetes.

- Potente modelo de eventos (Eventing): Knative Eventing proporciona un rico conjunto de herramientas para construir arquitecturas basadas en eventos, soportando CloudEvents y diversas fuentes de eventos. En 2026, esto se convierte en un estándar para sistemas distribuidos.

- Código abierto y soporte de Google: El proyecto es parte de CNCF y está activamente soportado por Google, lo que garantiza su desarrollo y estabilidad a largo plazo.

- Alto rendimiento: El escalado optimizado y la gestión del tráfico permiten lograr latencias de arranque en frío muy bajas, lo cual es importante para sistemas de alta carga.

Desventajas de Knative

- Alto umbral de entrada y complejidad de despliegue: Knative requiere un conocimiento profundo de Kubernetes. El despliegue de Knative y sus dependencias (como Istio o Kourier) puede ser un proceso complejo y laborioso, especialmente en un VPS "bare-metal".

- Dependencia de Kubernetes: Knative no puede funcionar sin Kubernetes. Si su equipo no tiene experiencia con Kubernetes, esto puede ser un obstáculo serio.

- Requisitos de recursos más altos: Un clúster básico de Kubernetes más Knative y sus componentes consumen más recursos en comparación con una instalación mínima de OpenFaaS. Esto puede ser un problema para VPS muy pequeños.

- Flexibilidad de plataforma limitada: A diferencia de OpenFaaS, Knative no soporta Docker Swarm, lo que limita la elección de infraestructura solo a Kubernetes.

- Curva de aprendizaje más pronunciada: Para dominar completamente Knative se requiere comprender sus objetos y conceptos específicos (Service, Revision, Configuration, Route), lo que puede llevar más tiempo.

Para quién es adecuado Knative

Knative es una excelente opción para:

- Equipos con experiencia en Kubernetes: Si su equipo ya utiliza activamente Kubernetes, Knative será una extensión natural de su infraestructura.

- Proyectos con altos requisitos de escalado: Especialmente para aquellos donde se requiere escalado desde cero y manejo de cargas pico con latencias mínimas.

- Desarrolladores que construyen arquitecturas complejas de microservicios y basadas en eventos: Knative Eventing y la gestión avanzada de tráfico lo hacen ideal para estos escenarios.

- Empresas a las que les importa el control total del tráfico: Y que necesitan despliegues canary, pruebas A/B y otras estrategias de lanzamiento avanzadas.

- Empresas orientadas al desarrollo a largo plazo: Knative, como parte del ecosistema CNCF y soportado por Google, tiene buenas perspectivas de desarrollo.

En 2026, Knative es la elección predeterminada para proyectos Serverless serios y de alta carga en Kubernetes, donde la inversión en aprendizaje e infraestructura se amortiza con la potencia y flexibilidad de la plataforma.

Consejos prácticos y recomendaciones de despliegue

El despliegue de FaaS en su propio servidor VPS/Dedicado requiere una planificación cuidadosa y una ejecución por etapas. A continuación se presentan recomendaciones prácticas que le ayudarán a implementar esta tarea con éxito en 2026.

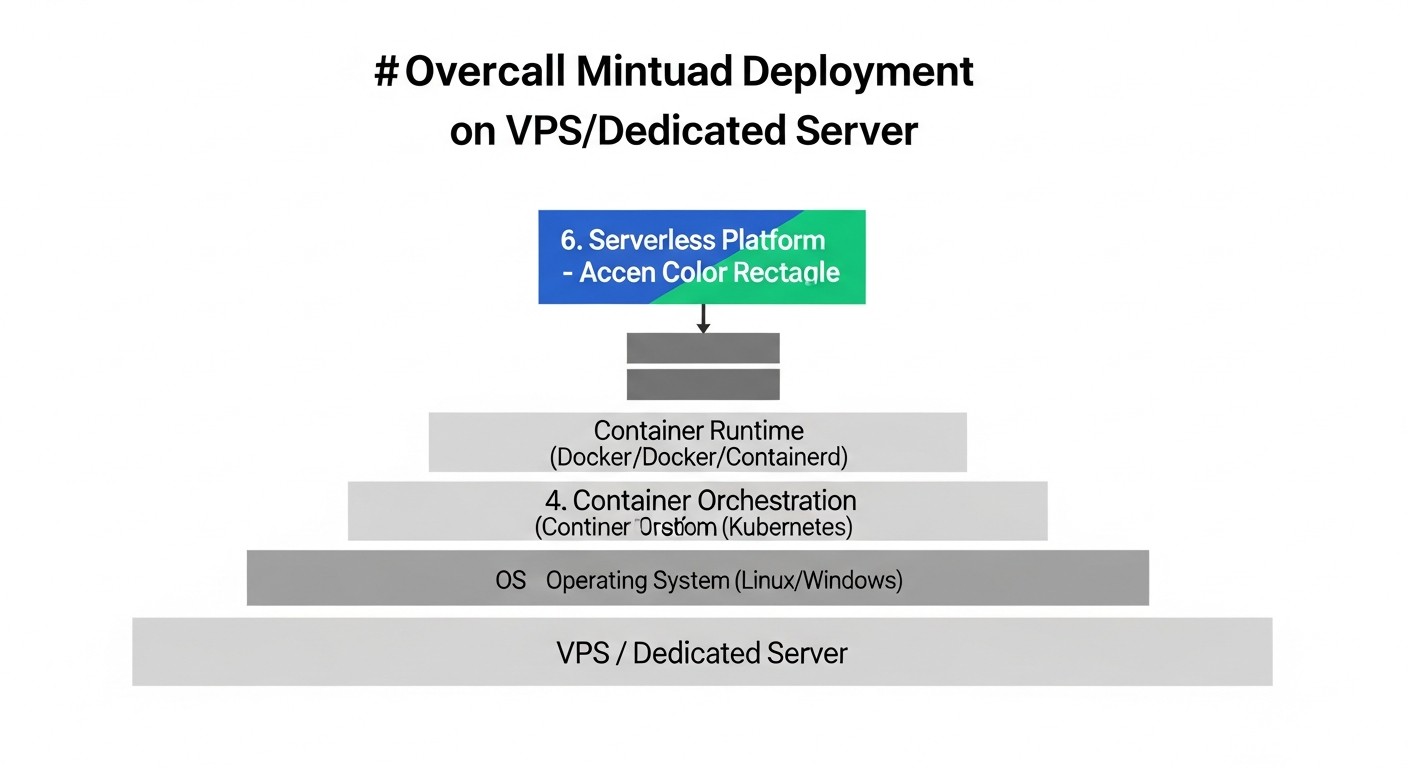

1. Elección y preparación del servidor

- Características: Para un clúster mínimo de Kubernetes con OpenFaaS o Knative en 2026, se recomienda un VPS/Dedicado con al menos 4 vCPU, 8 GB de RAM y 100 GB de SSD. Para una carga de trabajo de producción, estos valores serán significativamente más altos. Considere el uso de NVMe SSD para mejorar el rendimiento de E/S, lo cual es crítico para cargas de contenedores.

- Sistema operativo: Ubuntu Server (LTS), CentOS Stream o Debian. Asegúrese de que el kernel de Linux esté actualizado a la última versión estable.

- Seguridad: Configure el firewall (ufw/firewalld), cierre todos los puertos innecesarios, configure el acceso SSH solo con claves, deshabilite el inicio de sesión como root. Actualice regularmente el sistema operativo y todos los paquetes.

- Virtualización (para VPS): Asegúrese de que su proveedor de VPS ofrezca virtualización KVM, ya que proporciona un mejor rendimiento y compatibilidad con Docker/Kubernetes en comparación con OpenVZ.

2. Instalación de Kubernetes (para OpenFaaS y Knative)

En 2026, para clústeres ligeros en VPS, a menudo se utilizan k3s o MicroK8s. Para sistemas más serios, kubeadm.

Ejemplo de instalación de k3s en Ubuntu Server:

# Actualización del sistema

sudo apt update && sudo apt upgrade -y

# Instalación de k3s (clúster de un solo nodo)

curl -sfL https://get.k3s.io | sh -

# Verificación del estado

sudo systemctl status k3s

# Configuración de kubectl

mkdir -p ~/.kube

sudo cp /etc/rancher/k3s/k3s.yaml ~/.kube/config

sudo chown $(id -u):$(id -g) ~/.kube/config

# Verificación del clúster

kubectl get nodes

kubectl get pods -A

Para un clúster multi-nodo, use tokens y una agentes. Para Knative se requerirá un clúster de Kubernetes más estable y potente.

3. Despliegue de OpenFaaS

Se asume que Kubernetes ya está instalado.

Instalación de OpenFaaS CLI:

curl -SLs https://cli.openfaas.com | sudo sh

Despliegue de OpenFaaS en Kubernetes:

# Creación del namespace

kubectl apply -f https://raw.githubusercontent.com/openfaas/faas-netes/master/namespaces.yml

# Despliegue de OpenFaaS (instalación estándar)

kubectl apply -f https://raw.githubusercontent.com/openfaas/faas-netes/master/yaml/openfaas.yml

# Despliegue de OpenFaaS (con KEDA para escalado a cero)

# Primero instale KEDA: https://keda.sh/docs/latest/deployments/#install-with-helm

# Luego despliegue OpenFaaS con la configuración KEDA-enabled:

# kubectl apply -f https://raw.githubusercontent.com/openfaas/faas-netes/master/yaml/openfaas-keda.yml

# Obtención de la contraseña de administrador

echo $(kubectl -n openfaas get secret basic-auth -o jsonpath="{.data.basic_auth_password}" | base64 --decode)

# Exposición de la pasarela (ejemplo para NodePort, para producción use Ingress)

kubectl -n openfaas port-forward svc/gateway 8080:8080 &

export OPENFAAS_URL=http://127.0.0.1:8080

# Inicio de sesión

echo -n "admin" | faas-cli login -g $OPENFAAS_URL -u admin --password-stdin

Ejemplo de despliegue de una función (Python):

# Creación de una nueva función

faas-cli new --lang python3-http hello-world-py

# Edición de handler.py y requirements.txt

# (por ejemplo, añada print("Hello, FaaS!"))

# Construcción y despliegue

faas-cli build -f hello-world-py.yml

faas-cli deploy -f hello-world-py.yml

# Invocación de la función

faas-cli invoke hello-world-py --set-env MESSAGE="OpenFaaS!"

4. Despliegue de Knative

Se asume que Kubernetes ya está instalado y configurado.

Instalación de Knative Serving:

# Instalación de Istio (recomendado para Knative) o Kourier

# Para Istio: https://istio.io/latest/docs/setup/install/

# Para Kourier (Ingress ligero):

kubectl apply -f https://github.com/knative/serving/releases/download/knative-v1.12.0/kourier.yaml # Verifique la versión actual

# Instalación de Knative Serving

kubectl apply -f https://github.com/knative/serving/releases/download/knative-v1.12.0/serving-core.yaml # Verifique la versión actual

# Instalación de Knative net-kourier (si se usa Kourier)

kubectl apply -f https://github.com/knative/serving/releases/download/knative-v1.12.0/serving-default-domain.yaml # Verifique la versión actual

kubectl apply -f https://github.com/knative/serving/releases/download/knative-v1.12.0/net-kourier.yaml # Verifique la versión actual

# Verificación del estado

kubectl get pods -n knative-serving

kubectl get pods -n kourier-system # o istio-system

Instalación de Knative Eventing (opcional):

# Instalación de Knative Eventing Core

kubectl apply -f https://github.com/knative/eventing/releases/download/knative-v1.12.0/eventing-core.yaml # Verifique la versión actual

# Instalación de Broker (por ejemplo, InMemoryChannel)

kubectl apply -f https://github.com/knative/eventing/releases/download/knative-v1.12.0/in-memory-channel.yaml # Verifique la versión actual

# Instalación de la Configuración Predeterminada del Broker

kubectl apply -f https://github.com/knative/eventing/releases/download/knative-v1.12.0/mt-broker-config.yaml # Verifique la versión actual

# Verificación del estado

kubectl get pods -n knative-eventing

Ejemplo de despliegue de un servicio Knative (Go):

# service.yaml

apiVersion: serving.knative.dev/v1

kind: Service

metadata:

name: helloworld-go

namespace: default

spec:

template:

spec:

containers:

- image: docker.io/knative/helloworld-go # Ejemplo de imagen lista

ports:

- containerPort: 8080

env:

- name: TARGET

value: "Go Serverless with Knative!"

# Despliegue

kubectl apply -f service.yaml

# Obtención de la URL del servicio

kubectl get ksvc helloworld-go -o jsonpath='{.status.url}'

5. Monitoreo y registro

Asegúrese de configurar una pila de monitoreo (Prometheus, Grafana) y registro centralizado (Loki/Fluentd/Elasticsearch). OpenFaaS utiliza Prometheus por defecto, lo que simplifica la integración. Para Knative, este también es el enfoque estándar.

# Ejemplo de instalación de Prometheus y Grafana a través de Helm

helm repo add prometheus-community https://prometheus-community.github.io/helm-charts

helm repo update

helm install prometheus prometheus-community/kube-prometheus-stack --namespace monitoring --create-namespace

# Instalación de Loki y Promtail

helm repo add grafana https://grafana.github.io/helm-charts

helm repo update

helm install loki grafana/loki --namespace logging --create-namespace

helm install promtail grafana/promtail --namespace logging --create-namespace

6. Automatización CI/CD

En 2026, el despliegue manual de funciones FaaS es un anacronismo. Invierta en CI/CD. Utilice GitHub Actions, GitLab CI, Jenkins, Tekton o Argo CD para la construcción, prueba y despliegue automático de funciones en cada commit.

- Para OpenFaaS: Integre

faas-cli buildyfaas-cli deployen su pipeline de CI/CD. - Para Knative: Utilice

kubectl apply -fpara los archivos YAML de Knative Service. Tekton Pipelines, diseñado para CI/CD nativo de Kubernetes, es ideal para Knative.

7. Gestión de secretos

Nunca almacene datos confidenciales (claves API, contraseñas de bases de datos) en el código o en las imágenes Docker. Utilice Kubernetes Secrets, External Secrets, HashiCorp Vault o soluciones similares para un almacenamiento seguro y acceso a los secretos. En 2026, esto no es solo una recomendación, sino un requisito de seguridad obligatorio.

8. Configuración de red

Configure un controlador Ingress (Nginx Ingress, Traefik) para acceder a sus funciones FaaS desde el exterior, si no utiliza Istio/Kourier. Asegúrese de que los registros DNS apunten correctamente a su servidor. Utilice Let's Encrypt para certificados SSL/TLS gratuitos.

Errores comunes al desplegar FaaS en su propio servidor

El despliegue y la operación de funciones sin servidor en infraestructura propia, a pesar de su atractivo, conllevan una serie de errores comunes. Conocer estos escollos le ayudará a evitar problemas costosos y a garantizar un funcionamiento estable del sistema.

1. Subestimación de la complejidad de Kubernetes

Error: Asumir que Kubernetes es simplemente "Docker Compose con esteroides" y que se puede dominar y mantener fácilmente sin la experiencia adecuada. Esto es especialmente relevante para Knative, que está profundamente integrado con Kubernetes.

Cómo evitarlo: Invierta en la capacitación del equipo. Dedique tiempo a aprender los conceptos básicos de Kubernetes (pods, deployments, services, ingresses, controllers, operators). Comience con clústeres simples (k3s, MicroK8s) y aumente gradualmente la complejidad. Si el equipo no está listo para Kubernetes, OpenFaaS en Docker Swarm puede ser una mejor solución inicial.

Consecuencias: Fallos frecuentes del clúster, problemas de escalado, vulnerabilidades de seguridad, despliegues "estancados" que nadie puede entender ni arreglar, lo que lleva a la inactividad del servicio y la pérdida de datos.

2. Ignorar el monitoreo y el registro

Error: Desplegar funciones sin sistemas adecuados de monitoreo de rendimiento y registro centralizado. Con la esperanza de que "todo funcionará".

Cómo evitarlo: Configure Prometheus (para métricas), Grafana (para paneles de control) y Loki (para la recopilación centralizada de registros) desde el principio. Intégrelos con sus plataformas FaaS. OpenFaaS genera métricas de Prometheus por defecto. Para Knative, este también es el enfoque estándar. Capacite al equipo para usar estas herramientas para diagnosticar problemas.

Consecuencias: Gestión "ciega" del sistema, incapacidad para identificar rápidamente la causa de los fallos, largas horas de depuración, pérdida de datos valiosos sobre el rendimiento, lo que en 2026 es un lujo inaceptable.

3. Falta de automatización CI/CD

Error: Despliegue manual de funciones o uso de scripts simples que no cubren todo el ciclo de vida (construcción, prueba, despliegue, reversión).

Cómo evitarlo: Implemente un pipeline completo de CI/CD utilizando herramientas como GitHub Actions, GitLab CI, Jenkins, Tekton o Argo CD. Automatice la construcción de imágenes Docker, las pruebas de funciones, el despliegue en entornos de prueba y producción, así como la capacidad de reversión rápida. Para Knative, Tekton es especialmente útil.

Consecuencias: Lanzamientos lentos y propensos a errores, inconsistencia de entornos, "síndrome de funciona en mi máquina", incapacidad para reaccionar rápidamente a errores y actualizaciones, lo que reduce la velocidad de desarrollo y la fiabilidad del servicio.

4. Gestión incorrecta de secretos y datos confidenciales

Error: Almacenar claves API, contraseñas de bases de datos y otros secretos directamente en el código de las funciones, en imágenes Docker o en texto plano en archivos YAML de Kubernetes.

Cómo evitarlo: Utilice soluciones especializadas para la gestión de secretos, como Kubernetes Secrets (con cifrado etcd), External Secrets, HashiCorp Vault. Configure RBAC en Kubernetes para restringir el acceso a los secretos. Implemente la práctica de usar variables de entorno que se inyectan dinámicamente desde un almacén seguro.

Consecuencias: Fuga de datos confidenciales, compromiso de sistemas, incumplimiento de los requisitos de seguridad y regulaciones, lo que puede llevar a enormes pérdidas financieras y de reputación.

5. Planificación insuficiente de recursos y escalado

Error: Desplegar FaaS en un VPS con características mínimas sin tener en cuenta las cargas pico o el crecimiento potencial. Ignorar la configuración del autoescalado.

Cómo evitarlo: Realice pruebas de carga de sus funciones. Evalúe las cargas pico esperadas y asegure un suministro suficiente de recursos (CPU, RAM, espacio en disco). Configure Horizontal Pod Autoscaler (HPA) o KEDA para el autoescalado automático de funciones. Para Knative, asegúrese de que su autoescalado integrado esté configurado de manera óptima. Planifique la posibilidad de escalado vertical del VPS o la transición a un servidor dedicado con margen.

Consecuencias: Fallo de las funciones bajo carga, tiempos de respuesta prolongados, sobrecarga del servidor, indisponibilidad del servicio, lo que lleva a la insatisfacción del usuario y la pérdida de ingresos.

6. Ignorar la seguridad y configuración de red

Error: Dejar puertos abiertos, configuración incorrecta de los controladores Ingress, falta de cifrado SSL/TLS.

Cómo evitarlo: Configure el firewall en el VPS (UFW, iptables) y en Kubernetes (Network Policies) para restringir el acceso a los componentes. Utilice controladores Ingress (Nginx, Traefik, Kourier, Istio) para enrutar el tráfico externo. Implemente SSL/TLS para todos los puntos finales externos, utilizando Let's Encrypt o certificados propios. Considere el uso de un Web Application Firewall (WAF) para protegerse contra ataques comunes.

Consecuencias: Acceso no autorizado, ataques DDoS, interceptación de datos, lo que pone en peligro todo el sistema y sus usuarios.

7. Falta de copia de seguridad y estrategia de recuperación

Error: Desplegar servicios FaaS críticamente importantes sin una copia de seguridad regular de la configuración de Kubernetes, los datos de las funciones y las bases de datos.

Cómo evitarlo: Cree regularmente copias de seguridad del clúster etcd de Kubernetes (para restaurar el estado del clúster). Para los datos persistentes utilizados por las funciones, configure la copia de seguridad de las bases de datos o almacenes correspondientes. Desarrolle y pruebe un plan de recuperación ante desastres (DRP) para saber cómo restaurar rápidamente el sistema después de un fallo grave.

Consecuencias: Pérdida total de datos y configuración en caso de fallo del servidor, imposibilidad de restaurar el servicio, lo que lleva a consecuencias catastróficas para el negocio.

Lista de verificación para la aplicación práctica

Esta lista de verificación le ayudará a estructurar el proceso de despliegue y operación de funciones sin servidor en su propio VPS o servidor dedicado, garantizando la exhaustividad y fiabilidad de cada paso.

Preparación de la infraestructura

- Elección del servidor: Determinar las características requeridas del servidor VPS/Dedicado (CPU, RAM, SSD, red) en función de la carga esperada y elegir un proveedor. (Recomendación 2026: al menos 4 vCPU, 8GB RAM, NVMe SSD para K8s).

- Instalación del SO: Instalar el sistema operativo elegido (Ubuntu Server LTS, CentOS Stream, Debian) y actualizar a la última versión estable.

- Seguridad básica: Configurar el firewall (UFW/firewalld), acceso SSH por claves, deshabilitar el inicio de sesión como root, instalar fail2ban.

- Instalación de Docker: Instalar Docker Engine y configurarlo para el inicio automático.

- Instalación de Kubernetes: Desplegar un clúster de Kubernetes (k3s, MicroK8s, kubeadm) y configurar

kubectl. Asegurarse de la operatividad del clúster.

Elección y despliegue de la plataforma FaaS

- Elección de FaaS: Tomar una decisión entre OpenFaaS y Knative basándose en el análisis de criterios (rendimiento, complejidad, escalado, ecosistema).

- Despliegue de OpenFaaS / Knative:

- Para OpenFaaS: Instalar

faas-cli, desplegar OpenFaaS en Kubernetes (o Docker Swarm), configurar KEDA para escalado a cero. - Para Knative: Desplegar Knative Serving (con Kourier/Istio) y Knative Eventing (opcional), configurar Ingress/Gateway.

- Para OpenFaaS: Instalar

- Función de prueba: Desplegar una función simple "Hello World" en la plataforma elegida para verificar su operatividad.

Configuración y optimización

- Monitoreo: Instalar Prometheus y Grafana para la recopilación de métricas y la visualización de paneles de control. Integrar con la plataforma FaaS y Kubernetes.

- Registro: Configurar el registro centralizado (Loki + Promtail/Fluentd) para la recopilación de registros de funciones y componentes del clúster.

- Pipeline CI/CD: Desarrollar e implementar un pipeline CI/CD (GitHub Actions, GitLab CI, Jenkins, Tekton) para la construcción, prueba y despliegue automático de funciones.

- Gestión de secretos: Implementar una gestión segura de secretos (Kubernetes Secrets, External Secrets, Vault) para los datos confidenciales de las funciones.

- Configuración de red: Configurar el controlador Ingress, los registros DNS y los certificados SSL/TLS (Let's Encrypt) para el acceso a las funciones.

- Autoescalado: Ajustar finamente las políticas de autoescalado (HPA, KEDA, Knative Serving) para un uso óptimo de los recursos y una respuesta rápida a la carga.

- Copia de seguridad: Configurar copias de seguridad regulares de la configuración de Kubernetes (etcd) y de cualquier dato persistente utilizado por las funciones. Desarrollar un DRP.

Operación y desarrollo

- Pruebas de carga: Realizar pruebas de carga de las funciones para identificar cuellos de botella y verificar la configuración de escalado.

- Optimización del rendimiento: Analizar regularmente las métricas de rendimiento y optimizar el código de las funciones, las configuraciones de los contenedores y los parámetros de la plataforma FaaS.

- Actualizaciones: Desarrollar una estrategia de actualización regular de Kubernetes, la plataforma FaaS y el sistema operativo para mantener la seguridad y obtener nuevas funciones.

- Seguridad: Realizar auditorías de seguridad regularmente, aplicar parches, actualizar las políticas de acceso y monitorear las vulnerabilidades.

- Documentación: Mantener actualizada la documentación sobre la arquitectura, el despliegue, la operación y la resolución de problemas.

Cálculo de costos / Economía de propiedad (TCO)

La transición a FaaS autohospedado a menudo está motivada por consideraciones económicas. Sin embargo, es importante entender que el código abierto "gratuito" no significa operación "gratuita". En 2026, cuando el costo de los recursos en la nube sigue aumentando y el personal cualificado es cada vez más caro, el cálculo del Costo Total de Propiedad (TCO) se vuelve críticamente importante.

Componentes principales del TCO

- Hardware / Alquiler de VPS/Dedicado:

- VPS: Para proyectos pequeños o startups, esta es la opción principal. El costo dependerá del número de vCPU, RAM, SSD y ancho de banda de red. En 2026, el costo de un VPS básico (4vCPU/8GB RAM/100GB NVMe SSD) oscila entre $15 y $30 al mes. Para configuraciones más potentes (8vCPU/16GB RAM/200GB NVMe SSD), entre $40 y $80 al mes.

- Servidor Dedicado: Para proyectos grandes con altos requisitos de rendimiento y seguridad. El costo de alquilar un servidor dedicado (por ejemplo, Intel Xeon E-23xx, 6-8 núcleos, 64-128GB RAM, 2x1TB NVMe SSD) puede oscilar entre $150 y $400+ al mes.

- Costos de personal (los gastos ocultos más significativos):

- Ingenieros DevOps: Necesarios para el despliegue, configuración, monitoreo y soporte de Kubernetes, la plataforma FaaS, CI/CD, seguridad. El costo por hora de un ingeniero DevOps cualificado en 2026 puede variar de $50 a $150+ dependiendo de la región y la experiencia. Incluso si es 0.25-0.5 de un puesto, son gastos significativos.

- Desarrolladores: Tiempo dedicado a aprender la plataforma, escribir funciones, depurar.

- Administradores de sistemas: Para el mantenimiento del sistema operativo base y el hardware (si es dedicado).

- Licencias y herramientas (generalmente mínimas para Open Source):

- La mayoría de las herramientas (Kubernetes, OpenFaaS, Knative, Prometheus, Grafana) son de código abierto y gratuitas.

- Puede haber herramientas de pago para seguridad, monitoreo avanzado, CI/CD (por ejemplo, versiones Enterprise de Jenkins, GitLab EE).

- Electricidad y refrigeración (para Servidor Dedicado): Si usted posee el equipo y no lo alquila, estos son costos directos. Para el alquiler de un servidor dedicado, esto suele estar incluido en el costo.

- Tráfico de red: La mayoría de los proveedores de VPS/Dedicado incluyen un cierto volumen de tráfico. Sin embargo, para volúmenes muy grandes, se puede aplicar un cargo adicional.

- Tiempo de inactividad (Costo de Oportunidad): Pérdidas potenciales debido a fallos que pueden ser más frecuentes por falta de experiencia o automatización insuficiente.

Ejemplos de cálculos para diferentes escenarios (año 2026)

Imaginemos dos escenarios: una pequeña startup y un proyecto SaaS mediano.

Escenario 1: Pequeña startup (OpenFaaS en un VPS potente)

- Carga: Hasta 500k invocaciones de funciones al mes, con picos de hasta 100 RPS.

- Infraestructura: 1 VPS (8 vCPU, 16GB RAM, 200GB NVMe SSD) = $60/mes.

- Personal: 0.25 de un ingeniero DevOps (tiempo parcial o combinación de roles) = $1500/mes (basado en $100/hora * 40 horas/mes * 0.25).

- Herramientas/Licencias: $0 (completamente Open Source).

- TCO total al mes: $60 (VPS) + $1500 (DevOps) = $1560.

- Comparación con la nube (AWS Lambda, año 2026, aproximado):

- 500k invocaciones, 128MB RAM, 50ms duración promedio: alrededor de $10-20.

- API Gateway, SQS, DB y otros servicios: pueden alcanzar fácilmente $200-500+.

- Conclusión: A primera vista, la nube es más barata. Pero si el proyecto crece y necesita más control o runtimes específicos, el autohospedaje rápidamente se vuelve más rentable. El ahorro comienza cuando las facturas de la nube superan los $1000-1500 al mes.

Escenario 2: Proyecto SaaS mediano (Knative en 3 servidores dedicados)

- Carga: Hasta 50M invocaciones de funciones al mes, con picos de hasta 5000 RPS.

- Infraestructura: 3 Servidores Dedicados (6 núcleos, 64GB RAM, 2x1TB NVMe SSD cada uno) = 3 * $250 = $750/mes.

- Personal: 1.0 de un ingeniero DevOps = $4000/mes (basado en $100/hora * 40 horas/semana * 4 semanas/mes).

- Herramientas/Licencias: $100/mes (por ejemplo, versión de pago de CI/CD).

- TCO total al mes: $750 (Dedicado) + $4000 (DevOps) + $100 (Herramientas) = $4850.

- Comparación con la nube (AWS Lambda, año 2026, aproximado):

- 50M invocaciones, 256MB RAM, 100ms duración promedio: alrededor de $1000-2000.

- API Gateway, SQS, RDS, ElastiCache, S3, Load Balancers, Monitoring: pueden alcanzar fácilmente $10000 - $30000+ al mes.

- Conclusión: Para un proyecto SaaS mediano y grande, donde las facturas de la nube pueden ascender a decenas de miles de dólares, Knative autohospedado en servidores dedicados ofrece un ahorro significativo, control total y ausencia de dependencia del proveedor. Sin embargo, esto requiere una inversión seria en el equipo.

Costos ocultos

- Tiempo de aprendizaje: Tiempo que el equipo dedica a aprender nuevas tecnologías.

- Fallos imprevistos: Pérdidas por la inactividad del servicio debido a errores de configuración o falta de experiencia.

- Pérdida de ingresos: En lugar de desarrollar nuevas características, el equipo se dedica al soporte de la infraestructura.

- Escalado del equipo: A medida que el proyecto crece, puede ser necesario más ingenieros DevOps.

- Actualizaciones y parches: El mantenimiento regular del software y el sistema operativo requiere tiempo.

Cómo optimizar los costos

- Automatización: Automatice al máximo todos los procesos (CI/CD, IaC, monitoreo) para reducir los costos de personal.

- Optimización de recursos: Ajuste finamente el autoescalado, utilice Knative con su escalado a cero para minimizar el consumo de recursos en inactividad.

- Código eficiente: Escriba funciones de alto rendimiento que consuman menos CPU y RAM, reduzca el tiempo de ejecución.

- Soluciones híbridas: Considere un enfoque híbrido, donde parte de las funciones que requieren escalabilidad extrema permanecen en la nube, y las principales en su propio servidor.

- Planificación a largo plazo: Invierta en hardware más potente con margen para evitar migraciones frecuentes.

Tabla con ejemplos de cálculos (simplificada)

| Parámetro | FaaS en la nube (AWS Lambda + ecosistema) | OpenFaaS autohospedado (VPS) | Knative autohospedado (Dedicado) |

|---|---|---|---|

| Costo mensual de hardware/alquiler | $0 (para FaaS, pero $100-3000 para otros servicios) | $30 - $80 | $200 - $800 |

| Costo mensual de invocaciones FaaS | $10 - $2000+ | $0 | $0 |

| Costo mensual de personal DevOps | $500 - $2000 (para gestión de la nube) | $1000 - $2500 | $2500 - $5000+ |

| Licencias/Herramientas (mes) | $50 - $200 | $0 - $50 | $0 - $100 |

| TCO total (rango aproximado) | $500 - $5000+ | $1000 - $2600 | $2700 - $6000+ |

| Punto de equilibrio (Nube vs Autohospedado) | N/A | Con facturas de nube de $1000-1500+ | Con facturas de nube de $3000-5000+ |

Como se desprende de la tabla, el autohospedaje comienza a ser rentable al alcanzar una cierta escala. Para proyectos pequeños, la nube a menudo sigue siendo más barata debido a la ausencia de pago directo por el trabajo de DevOps, pero para proyectos en crecimiento y grandes, el FaaS propio puede generar un ahorro significativo y ventajas estratégicas.

Casos de estudio y ejemplos de uso

Para comprender mejor cómo OpenFaaS y Knative pueden aplicarse en la práctica, consideremos algunos escenarios realistas, relevantes para 2026.

Caso 1: Servicio de procesamiento de imágenes para una tienda online (OpenFaaS)

Tarea: Una tienda online carga miles de imágenes de productos diariamente. Es necesario redimensionarlas automáticamente, aplicar marcas de agua, optimizarlas y guardarlas en varios formatos para diferentes dispositivos (móviles, de escritorio). Se requiere un escalado rápido durante las cargas pico (por ejemplo, durante las rebajas) y la minimización de costos en períodos de baja actividad.

Solución con OpenFaaS:

- Infraestructura: Un potente servidor dedicado (Intel Xeon E-23xx, 64GB RAM, 2TB NVMe SSD) con Kubernetes y OpenFaaS. Se utiliza NATS Streaming para el procesamiento asíncrono.

- Funciones:

image-upload-handler(Python): Acepta solicitudes entrantes para cargar imágenes, guarda el original en un almacenamiento compatible con S3 (por ejemplo, MinIO, desplegado en el mismo servidor), envía un mensaje a NATS con la URL del original.image-processor(Go): Escucha mensajes de NATS, descarga el original, utiliza la biblioteca ImageMagick (a través de un wrapper de Go) para redimensionar, aplicar marcas de agua y optimizar. Genera 3-5 versiones de la imagen y las carga de nuevo en MinIO.metadata-extractor(Node.js): Escucha mensajes de NATS después del procesamiento, extrae datos EXIF y otros metadatos, los guarda en PostgreSQL.

- Escalado: OpenFaaS está configurado con KEDA para el autoescalado de

image-processorbasándose en la longitud de la cola de NATS. Con una carga alta (muchas imágenes nuevas), la función se escala rápidamente a decenas de instancias. Por la noche, cuando no hay cargas, las funciones se escalan a cero, ahorrando recursos. - Resultados:

- Ahorro: Reducción significativa de costos en comparación con FaaS en la nube, especialmente debido a la ausencia de tarifas por invocación y el consumo mínimo de recursos en inactividad.

- Rendimiento: El procesamiento de imágenes tarda en promedio 2-5 segundos por imagen, lo que satisface los requisitos de la tienda.

- Control: Control total sobre el proceso de procesamiento, capacidad de usar cualquier biblioteca para trabajar con imágenes, configuración de seguridad flexible.

- Fiabilidad: El procesamiento asíncrono a través de NATS garantiza la resistencia a fallos temporales y asegura el procesamiento de todas las imágenes.

Caso 2: Servicio de análisis en tiempo real para una plataforma IoT (Knative)

Tarea: La plataforma recopila datos de miles de dispositivos IoT (sensores, contadores) en tiempo real. Es necesario realizar un preprocesamiento rápido, agregación y detección de anomalías de los datos, así como enviar notificaciones en caso de eventos críticos. La carga fluctúa significativamente durante el día y la semana.

Solución con Knative:

- Infraestructura: Clúster de Kubernetes de 3 servidores dedicados (cada uno con 8 núcleos, 128GB RAM, 1TB NVMe SSD) con Knative Serving y Knative Eventing, así como un clúster Kafka para el procesamiento de datos en streaming.

- Funciones/Servicios Knative:

iot-data-ingestor(Java/Spring Boot): Recibe datos de los dispositivos a través de una API HTTP, realiza una validación básica y envía los datos brutos a un tema de Kafka. Desplegado como un servicio Knative, se escala en función de las RPS.data-preprocessor(Go): Escucha el tema de Kafka con datos brutos (a través de KafkaSource en Knative Eventing), normaliza los datos, añade marcas de tiempo y los envía a otro tema de Kafka (processed-data). Se escala automáticamente a cero si no hay datos.anomaly-detector(Python/TensorFlow Lite): Escucha el temaprocessed-data, utiliza un modelo ligero de aprendizaje automático para detectar anomalías. Al detectar una anomalía, envía un evento al Knative Broker.notification-sender(Node.js): Se suscribe a eventos del Knative Broker (por ejemplo, "anomaly-detected"), envía notificaciones a través de la API de Slack/Telegram.

- Escalado: Knative Serving escala automáticamente todos los servicios de cero al número necesario de instancias basándose en métricas de solicitudes (RPS), CPU o longitud de la cola de Kafka (a través de KEDA, integrado con Knative). Istio se utiliza para gestionar el tráfico y garantizar la tolerancia a fallos entre servicios.

- Resultados:

- Reactividad: El procesamiento de datos se realiza en tiempo real con latencias mínimas (menos de 100 ms desde el dispositivo hasta la detección de anomalías).

- Ahorro de recursos: Gracias al escalado de Knative a cero, en períodos de baja actividad el consumo de recursos se reduce significativamente, lo cual es críticamente importante para servidores dedicados.

- Flexibilidad: Es fácil añadir nuevos tipos de procesamiento o fuentes de datos gracias a la arquitectura basada en eventos de Knative Eventing.

- Fiabilidad: El clúster de Kubernetes y el Service Mesh garantizan una alta disponibilidad y tolerancia a fallos de todo el sistema.

Caso 3: Manejador de Webhooks CI/CD para microservicios (OpenFaaS o Knative)

Tarea: Automatizar la respuesta a eventos en sistemas de control de versiones (GitHub, GitLab), como pushes, solicitudes de fusión, compilaciones exitosas. Se requiere ejecutar acciones específicas: notificaciones, despliegue de entornos de prueba, ejecución de verificaciones adicionales.

Solución con OpenFaaS:

- Infraestructura: Un pequeño VPS (4 vCPU, 8GB RAM) con k3s y OpenFaaS.

- Funciones:

github-webhook-parser(Python): Acepta solicitudes HTTP POST de GitHub Webhook, analiza el payload JSON, extrae el tipo de evento (push, pull_request) y el repositorio. Envía el evento estructurado a un broker NATS interno.slack-notifier(Node.js): Escucha NATS para eventos, forma un mensaje y lo envía a un canal de Slack.test-env-deployer(Go): Ante un eventopull_request_openedde NATS, utiliza comandoskubectlo Helm para desplegar un nuevo entorno de prueba para la Pull Request.

- Escalado: OpenFaaS escala las funciones por solicitudes HTTP o longitud de la cola de NATS.

Solución con Knative:

- Infraestructura: VPS (4 vCPU, 8GB RAM) con k3s y Knative Serving/Eventing.

- Servicios Knative:

github-webhook-receiver(Python): Servicio Knative que recibe webhooks de GitHub. Los convierte en CloudEvents y los envía al Knative Broker.slack-notifier(Node.js): Servicio Knative, suscrito a eventosgithub.event.pushygithub.event.pull_requestdel Broker, envía notificaciones.tekton-pipeline-trigger(Go): Servicio Knative, suscrito agithub.event.pull_request_opened, inicia un Tekton Pipeline para desplegar el entorno de prueba.

- Escalado: Knative escala automáticamente los servicios a cero cuando no hay webhooks entrantes.

Ambas soluciones abordan eficazmente la tarea, demostrando la flexibilidad de FaaS para automatizar los procesos de CI/CD. La elección depende de las preferencias del equipo por el estilo OpenFaaS o la profunda integración con Kubernetes que ofrece Knative.

Herramientas y recursos

El despliegue y la operación exitosos de plataformas FaaS autohospedadas son imposibles sin el conjunto adecuado de herramientas y recursos actualizados. En 2026, el ecosistema de código abierto se desarrolla a un ritmo increíble, proporcionando soluciones potentes y flexibles.

1. Utilidades para trabajar con plataformas FaaS

faas-cli(para OpenFaaS): CLI oficial para OpenFaaS. Permite crear, desplegar, invocar y eliminar funciones. Una herramienta indispensable para el desarrollador y DevOps.kubectl(para Knative y Kubernetes): La herramienta principal de línea de comandos para interactuar con un clúster de Kubernetes. Todas las operaciones con Knative Service y Eventing se realizan a través dekubectl.knCLI (para Knative): Una útil utilidad CLI para Knative, que simplifica el trabajo con Knative Serving y Eventing. Permite crear servicios, obtener su estado, gestionar eventos.

2. Monitoreo y pruebas

- Prometheus: Sistema de monitoreo y alertas de código abierto. Estándar de facto para el ecosistema de Kubernetes. OpenFaaS y Knative proporcionan métricas que Prometheus puede recopilar.

- Grafana: Plataforma para análisis y paneles de control interactivos. Ideal para visualizar métricas de Prometheus y registros de Loki.

- Loki: Sistema de agregación de registros escalable horizontalmente, de alta disponibilidad y multi-inquilino, desarrollado por Grafana Labs. Funciona bajo el principio de "solo indexación de metadatos", lo que lo hace muy eficiente.

- K6 / JMeter / Locust: Herramientas para pruebas de carga. Permiten simular una carga real en funciones FaaS y verificar su escalabilidad y rendimiento.

3. Sistemas de control de versiones y CI/CD

- Git (GitHub, GitLab, Bitbucket): La base de cualquier proceso de desarrollo moderno.

- GitHub Actions / GitLab CI / Jenkins / Tekton: Herramientas para automatizar pipelines de CI/CD. Tekton se integra especialmente bien con Kubernetes y Knative.

- Argo CD: Herramienta para el despliegue declarativo de GitOps en Kubernetes. Permite sincronizar el estado del clúster con un repositorio Git.

4. Herramientas para la gestión de configuración e IaC (Infrastructure as Code)

- Terraform: Permite describir y gestionar de forma declarativa la infraestructura (VPS, DNS, balanceadores de carga) como código.

- Ansible / Chef / Puppet: Herramientas para la automatización de la configuración de servidores, instalación de software, configuración de seguridad.

- Helm: Gestor de paquetes para Kubernetes. Simplifica el despliegue de aplicaciones complejas, como Prometheus, Grafana, Istio, Knative.

5. Enlaces útiles y documentación

- Documentación oficial de OpenFaaS

- Documentación oficial de Knative

- Documentación oficial de Kubernetes

- KEDA (Kubernetes Event-driven Autoscaling)

- Istio Service Mesh

- MinIO (almacenamiento de objetos compatible con S3 para autohospedaje)

- Cloud Native Computing Foundation (CNCF) - organización que apoya muchos de estos proyectos.

Siga regularmente las actualizaciones de estos proyectos, ya que el ecosistema evoluciona muy rápidamente. Suscríbase a boletines, siga blogs y participe en comunidades para estar al tanto de las últimas tendencias y mejores prácticas.

Troubleshooting: Resolución de problemas

El despliegue y la operación de FaaS en su propio servidor es un proceso complejo, y los problemas son inevitables. La capacidad de diagnosticar y resolver rápidamente los fallos es una habilidad clave. A continuación se presentan problemas típicos y enfoques para su solución, relevantes para 2026.

1. Las funciones no se inician / Error al desplegar

- Problema: La función se queda atascada en estado Pending, CrashLoopBackOff o ImagePullBackOff.

- Diagnóstico:

kubectl describe pod <nombre-del-pod-de-la-funcion> -n <namespace> kubectl logs <nombre-del-pod-de-la-funcion> -n <namespace> - Soluciones:

- ImagePullBackOff: Verifique el nombre de la imagen Docker, la disponibilidad del registro (Docker Hub, registro privado) y la corrección de las credenciales. Asegúrese de que el servidor tenga acceso a Internet.

- CrashLoopBackOff: La función se inicia y cae inmediatamente. Verifique los logs de la función (

kubectl logs) en busca de errores en el código, problemas con las dependencias o una configuración de entorno incorrecta. Asegúrese de que su función maneje correctamente las solicitudes HTTP y devuelva una respuesta. - Pending: Recursos insuficientes en el clúster (CPU, RAM). Verifique

kubectl describe poden busca de mensajes sobre la falta de recursos. Aumente los recursos del VPS o del clúster, optimice las solicitudes de recursos (requestsylimits) en el archivo YAML de la función. - Puerto incorrecto: Asegúrese de que la función esté escuchando el puerto que espera la plataforma FaaS (generalmente 8080 o 8000).

2. Alta latencia / Funcionamiento lento de las funciones

- Problema: Las funciones responden lentamente, se observan altas latencias de arranque en frío.

- Diagnóstico:

- Verifique las métricas de Prometheus/Grafana: tiempo de ejecución de las funciones, número de arranques en frío, utilización de CPU/RAM de los pods.

- Utilice

curl -vo herramientas especializadas para medir el tiempo de respuesta.

- Soluciones:

- Arranque en frío:

- OpenFaaS: Asegúrese de que KEDA esté configurado y funcionando correctamente. Configure

min_replicaspara funciones críticamente importantes para que siempre tengan al menos una instancia activa. Utilice el "calentamiento" de funciones. - Knative: Verifique la configuración de Knative Serving e Istio/Kourier. Asegúrese de que el autoescalado esté configurado adecuadamente. Posiblemente sea necesario aumentar

min-scalepara servicios críticos.

- OpenFaaS: Asegúrese de que KEDA esté configurado y funcionando correctamente. Configure

- Rendimiento del código: Optimice el código de la función, utilice algoritmos más eficientes, minimice las llamadas externas.

- Recursos: Aumente los recursos asignados (CPU, RAM) para los pods de las funciones. Verifique el rendimiento del subsistema de disco del VPS/Dedicado.

- Retrasos de red: Verifique la conectividad de red entre los componentes (función-BD, función-broker).

- Arranque en frío:

3. Problemas de escalado

- Problema: Las funciones no se escalan con el aumento de la carga o se escalan demasiado lento.

- Diagnóstico:

- Verifique el estado de HPA/KEDA (

kubectl get hpa -n <namespace>) o Knative Service (kubectl get ksvc -n <namespace>). - Revise los logs de los controladores de autoescalado.

- Verifique las métricas en las que se basa la decisión de escalado (CPU, RPS, longitud de la cola).

- Verifique el estado de HPA/KEDA (

- Soluciones:

- Recursos insuficientes del clúster: Añada más nodos al clúster de Kubernetes o aumente los recursos de los VPS existentes.

- Métricas incorrectas: Asegúrese de que las métricas utilizadas para el autoescalado se recopilen correctamente y reflejen la carga real.

- Políticas de escalado: Configure los parámetros

min_replicas,max_replicas,target_average_utilization(para HPA) o los parámetros de escalado específicos de Knative. - Problemas con los controladores KEDA/Knative: Verifique los logs de los pods de KEDA/Knative Serving en busca de errores.

4. Problemas de acceso a funciones / Problemas de red

- Problema: Las funciones no son accesibles desde el exterior, o se observan errores 502/503.

- Diagnóstico:

- Verifique el estado del controlador Ingress (Nginx, Traefik, Kourier, Istio Gateway).

- Verifique los logs del controlador Ingress.

- Utilice

kubectl get svc -n <namespace>ykubectl get ep -n <namespace>para verificar los servicios y sus puntos finales. - Verifique la configuración de DNS y el firewall en el VPS.

- Soluciones:

- Controlador Ingress: Asegúrese de que el controlador Ingress esté en ejecución, sus pods estén saludables y configurados correctamente para enrutar el tráfico a la pasarela/servicios FaaS.

- DNS: Verifique que los registros DNS del dominio apunten a la dirección IP de su controlador Ingress.

- Firewall: Asegúrese de que los puertos 80/443 estén abiertos en el firewall del VPS y en las Network Policies de Kubernetes.

- SSL/TLS: Verifique que los certificados SSL/TLS sean válidos y estén configurados correctamente.

5. Problemas de registro y monitoreo

- Problema: Las métricas no se muestran en Grafana, los logs no llegan a Loki.

- Diagnóstico:

- Verifique el estado de los pods de Prometheus, Grafana, Loki, Promtail/Fluentd.

- Revise los logs de estos pods.

- Verifique la configuración de Prometheus (

scrape_configs) y Promtail/Fluentd (targets).

- Soluciones:

- Disponibilidad: Asegúrese de que todos los componentes de monitoreo y registro estén en ejecución y sean accesibles entre sí.

- Configuración: Verifique la corrección de la configuración de los agentes de recopilación (Promtail, Fluentd) y los servidores (Prometheus, Loki). Asegúrese de que "vean" las métricas y los logs de sus pods FaaS.

- Permisos de acceso: Asegúrese de que los agentes de recopilación tengan los permisos RBAC necesarios en Kubernetes para leer logs y métricas.

Cuándo contactar al soporte (o buscar ayuda en la comunidad)

- Cuando haya agotado todos los métodos conocidos de diagnóstico y resolución de problemas.

- Cuando el problema esté relacionado con las profundidades internas de Kubernetes, OpenFaaS o Knative, que usted no comprende.

- Si se encuentra con un problema que parece ser un error en la propia plataforma.

- Cuando la inactividad del servicio es crítica y no tiene tiempo para una investigación profunda.

Para OpenFaaS y Knative existen comunidades activas en Slack, GitHub Issues y Stack Overflow. Proporcione la información más detallada posible: versiones de componentes, logs, archivos de configuración, pasos para reproducir el problema.

Preguntas frecuentes (FAQ)

¿Qué es FaaS y por qué se despliega en su propio servidor?

FaaS (Functions as a Service) es un modelo de computación en la nube que permite a los desarrolladores ejecutar código en respuesta a eventos sin necesidad de gestionar la infraestructura subyacente. El despliegue de FaaS en su propio servidor (autohospedado) permite obtener un control total sobre los datos y la infraestructura, evitar la dependencia de un proveedor de nube específico (vendor lock-in), y reducir significativamente los costos operativos a largo plazo, especialmente para proyectos con una carga grande o predecible, donde las facturas de la nube se vuelven demasiado altas.

¿Es obligatorio usar Kubernetes para OpenFaaS o Knative?

Para Knative, sí, Kubernetes es la plataforma base obligatoria, ya que Knative está construido como un conjunto de extensiones para Kubernetes. Para OpenFaaS, no, aunque Kubernetes es la opción preferida, OpenFaaS también soporta el despliegue en Docker Swarm, lo que puede ser más sencillo para proyectos pequeños o equipos sin experiencia profunda en Kubernetes.

¿Qué tan difícil es mantener FaaS autohospedado en 2026?

La complejidad de mantener FaaS autohospedado en 2026 ha disminuido significativamente gracias al desarrollo de herramientas de automatización (IaC, CI/CD), la mejora de la documentación y el crecimiento de las comunidades. Sin embargo, todavía requiere la presencia de ingenieros DevOps o administradores de sistemas cualificados que comprendan los principios de funcionamiento de Kubernetes (si se utiliza), Docker, tecnologías de red, monitoreo y seguridad. No es un sistema de "instalar y olvidar", pero es totalmente manejable con la experiencia adecuada.

¿Se puede escalar FaaS en su propio servidor a cero, como en la nube?

Sí, ambas plataformas, OpenFaaS y Knative, soportan el escalado de funciones a cero. Knative tiene esta capacidad "de fábrica" como parte de su arquitectura Serving, utilizando activamente Service Mesh para gestionar el tráfico y la desactivación de pods. OpenFaaS puede lograr el escalado a cero mediante la integración con KEDA (Kubernetes Event-Driven Autoscaling), que permite escalar pods basándose en diversas métricas, incluida la ausencia de tráfico o la longitud de la cola de mensajes.

¿Qué lenguajes de programación son compatibles?

Tanto OpenFaaS como Knative soportan prácticamente cualquier lenguaje de programación que pueda empaquetarse en un contenedor Docker. Esto incluye Python, Node.js, Go, Java, PHP, Ruby, .NET Core y otros. OpenFaaS proporciona plantillas listas para muchos lenguajes populares, lo que acelera el inicio. Knative, al ser de nivel más bajo, simplemente ejecuta cualquier contenedor que cumpla con su contrato.

¿Cómo garantizar la alta disponibilidad (HA) para FaaS autohospedado?

Para garantizar la alta disponibilidad, es necesario desplegar FaaS en un clúster de varios VPS o servidores dedicados, no en uno solo. Kubernetes, por su naturaleza, es un sistema distribuido que proporciona HA. Para OpenFaaS y Knative, esto significa ejecutar sus componentes y funciones en múltiples nodos de Kubernetes, utilizar balanceadores de carga, replicación de datos y configurar la recuperación automática después de fallos. También es críticamente importante tener una estrategia de copia de seguridad y recuperación de datos.

¿Cuáles son los principales riesgos al usar FaaS autohospedado?

Los principales riesgos incluyen: alta complejidad inicial de despliegue y configuración (especialmente Knative), necesidad de personal cualificado para el soporte, posibles problemas de seguridad si la infraestructura se configura incorrectamente, y la ausencia de un ecosistema de servicios en la nube listos para usar (por ejemplo, bases de datos gestionadas, que deberán desplegarse por cuenta propia). También existe el riesgo de subestimar los costos operativos y el tiempo de mantenimiento.

¿Puedo usar FaaS autohospedado para aplicaciones de misión crítica?

Sí, muchas empresas utilizan con éxito FaaS autohospedado para aplicaciones de misión crítica, pero esto requiere inversiones significativas en fiabilidad, seguridad y automatización. Es necesario garantizar alta disponibilidad, copias de seguridad, estrategias de despliegue bien pensadas (despliegues canary, pruebas A/B) y monitoreo 24/7. Con el enfoque correcto, FaaS autohospedado puede ser incluso más fiable que las nubes públicas, debido al control total sobre la pila.

¿Cómo gestionar las dependencias y bibliotecas en las funciones?

Las dependencias y bibliotecas se gestionan dentro de la imagen Docker de su función. Las incluye en el Dockerfile o utiliza archivos requirements.txt (Python), package.json (Node.js), etc., que se procesan durante la fase de construcción de la imagen. OpenFaaS proporciona plantillas que ya contienen la lógica para instalar dependencias. Para Knative, simplemente construye su imagen Docker con todas las dependencias necesarias.

¿Cuál es el papel del controlador Ingress (Istio, Kourier) en Knative?

El controlador Ingress (por ejemplo, Istio Gateway o Kourier) juega un papel clave en Knative Serving. Es responsable de enrutar el tráfico HTTP externo a sus servicios Knative. Knative utiliza Service Mesh para implementar sus funciones avanzadas de gestión de tráfico, como despliegues canary, pruebas A/B y escalado a cero. Kourier es un controlador Ingress ligero, desarrollado específicamente para Knative, mientras que Istio es un Service Mesh más completo.

Conclusión y próximos pasos

El despliegue de funciones sin servidor en su propio VPS o servidor dedicado utilizando OpenFaaS o Knative no es solo una tendencia técnica de 2026, sino también una decisión estratégica que puede aportar importantes beneficios económicos, aumentar el control sobre la infraestructura y los datos, y garantizar la independencia de los proveedores de la nube. Hemos examinado los criterios clave de elección, estudiado en detalle ambas plataformas, proporcionado consejos prácticos y analizado errores comunes, así como evaluado la economía de propiedad.

OpenFaaS ofrece un umbral de entrada más bajo y flexibilidad con soporte para Docker Swarm, lo que lo convierte en una excelente opción para startups, equipos pequeños y aquellos que valoran la simplicidad. Knative, con su profunda integración con Kubernetes y potentes capacidades de escalado a cero, gestión de tráfico y arquitectura basada en eventos, es la solución ideal para proyectos SaaS más grandes, de alta carga y complejos, donde ya existe experiencia en Kubernetes.

En última instancia, la elección entre OpenFaaS y Knative, así como la decisión de pasar a FaaS autohospedado, debe basarse en un análisis cuidadoso de sus necesidades, recursos del equipo, carga esperada y objetivos estratégicos a largo plazo. Es importante recordar que el éxito de dicha transición depende directamente de las inversiones en automatización, monitoreo, seguridad y capacitación del personal.

Próximos pasos para el lector:

- Evalúe sus necesidades: Analice la carga actual, el presupuesto, el tamaño del equipo y el nivel de experiencia. Determine qué funciones desea migrar a FaaS y qué requisitos tienen.

- Elija la plataforma: Basándose en los criterios expuestos en el artículo, realice una elección preliminar entre OpenFaaS y Knative.

- Comience con un POC: Despliegue un clúster mínimo (por ejemplo, k3s en un VPS) e instale la plataforma FaaS elegida. Intente desplegar una función simple "Hello World" y pruébela.

- Estudie la documentación: Sumérjase profundamente en la documentación oficial de la plataforma elegida, así como de Kubernetes, Prometheus, Grafana y otras herramientas relacionadas.

- Construya un CI/CD: No posponga la automatización. Cree un pipeline CI/CD simple para su primera función.

- Monitoreo y registro: Configure una pila básica de monitoreo y registro para tener una idea del funcionamiento de su sistema.

- Pruebas de carga: Realice pruebas de carga para comprender las limitaciones de su infraestructura y plataforma FaaS.

- Únase a la comunidad: La participación activa en las comunidades de OpenFaaS, Knative y Kubernetes le ayudará a resolver problemas más rápidamente y a estar al tanto de los últimos desarrollos.

El autohospedaje de FaaS no es solo un ahorro, es un camino hacia una mayor independencia, flexibilidad y control sobre su ecosistema tecnológico. ¡Mucha suerte en su viaje al mundo de la computación sin servidor en sus propios servidores!

¿Te fue útil esta guía?