Registro centralizado para DevOps: ELK Stack en VPS con optimización de recursos (Actualizado a 2026)

TL;DR

- En 2026, el registro centralizado basado en ELK Stack sigue siendo fundamental para DevOps, garantizando transparencia y una respuesta operativa rápida en sistemas distribuidos.

- El despliegue de ELK en un VPS requiere una optimización cuidadosa de los recursos para lograr un rendimiento estable y minimizar los costos, especialmente cuando se trabaja con grandes volúmenes de datos.

- Los aspectos clave de la optimización incluyen una asignación adecuada de memoria JVM para Elasticsearch y Logstash, la configuración de índices (ILM, data streams), así como el uso eficiente de Beats para la recopilación de registros.

- La elección de un proveedor y configuración de VPS adecuados (CPU, RAM, NVMe SSD) es crítica para el rendimiento, y se deben considerar los costos ocultos y las capacidades de escalado.

- La implementación de prácticas de seguridad (TLS, autenticación) y el monitoreo regular del estado de ELK Stack no es una opción, sino una necesidad para mantener la fiabilidad del sistema.

- A pesar de la aparición de nuevas herramientas, ELK mantiene su relevancia gracias a su flexibilidad, potentes capacidades de análisis y una comunidad desarrollada, especialmente para equipos que buscan un equilibrio entre control y costo.

- Este artículo proporciona una guía paso a paso, consejos prácticos, cálculos y recomendaciones para una implementación y optimización exitosas de ELK en un VPS.

Introducción

En el mundo DevOps de 2026, donde los microservicios, la contenerización y las arquitecturas sin servidor dominan, la capacidad de comprender rápidamente lo que sucede en su sistema distribuido ya no es solo una ventaja, sino una necesidad absoluta. Las aplicaciones se vuelven cada vez más complejas, y sus componentes se dispersan en multitud de servidores, contenedores y funciones en la nube. La revisión manual de registros en cada nodo no solo es ineficiente, sino prácticamente imposible, especialmente cuando se trata de cientos o miles de eventos por segundo.

Es aquí donde entra en juego el registro centralizado. Permite recopilar todos los registros de diversas fuentes en un único almacenamiento, indexarlos, analizarlos y visualizarlos en tiempo real. Esto proporciona a los equipos de DevOps, desarrolladores y administradores de sistemas una transparencia sin precedentes, acelera el proceso de depuración, ayuda a identificar anomalías y a tomar decisiones informadas para optimizar el rendimiento y la seguridad.

Entre las muchas soluciones disponibles, ELK Stack (Elasticsearch, Logstash, Kibana) sigue siendo una de las herramientas más populares y potentes para estos fines. Su flexibilidad, apertura y una extensa comunidad lo han convertido en un estándar de facto para muchas empresas, desde startups hasta grandes corporaciones. Sin embargo, el despliegue de ELK en un servidor privado virtual (VPS) conlleva ciertos desafíos, el principal de los cuales es la optimización de recursos. Un VPS, por su naturaleza, ofrece recursos limitados en comparación con servidores dedicados o grandes instancias en la nube, y ELK, al ser una pila que consume bastantes recursos, requiere una configuración fina para funcionar de manera eficiente en tales condiciones.

Este artículo está dirigido a ingenieros DevOps, desarrolladores Backend, fundadores de proyectos SaaS, administradores de sistemas y directores técnicos de startups que buscan construir un sistema de registro centralizado fiable y económico. No nos dedicaremos a la palabrería de marketing. En su lugar, profundizaremos en los aspectos prácticos del despliegue, la configuración y, lo más importante, la optimización de ELK Stack en un VPS, para que pueda sacar el máximo provecho de sus recursos limitados. Revisaremos las tendencias actuales de 2026, proporcionaremos ejemplos concretos, comandos y cálculos basados en la experiencia real, para que cada consejo pueda aplicarse de inmediato en la práctica.

Los principales problemas que resuelve este artículo:

- Complejidad del despliegue: Proporciona instrucciones paso a paso para la instalación y configuración básica de ELK en un VPS.

- Alto consumo de recursos: Describe detalladamente los métodos de optimización para cada componente de la pila.

- Falta de comprensión de los costos: Ofrece cálculos realistas y estrategias para reducir gastos.

- Problemas de escalado: Discute enfoques para escalar ELK en entornos VPS.

- Seguridad: Subraya la importancia y propone pasos básicos para la protección de datos.

- Escasez de consejos prácticos: Incluye casos reales, errores comunes y sus soluciones.

Al final del artículo, usted tendrá un profundo conocimiento de cómo utilizar eficazmente ELK Stack para el registro centralizado en un VPS, transformando un flujo caótico de registros en una valiosa fuente de información para la toma de decisiones.

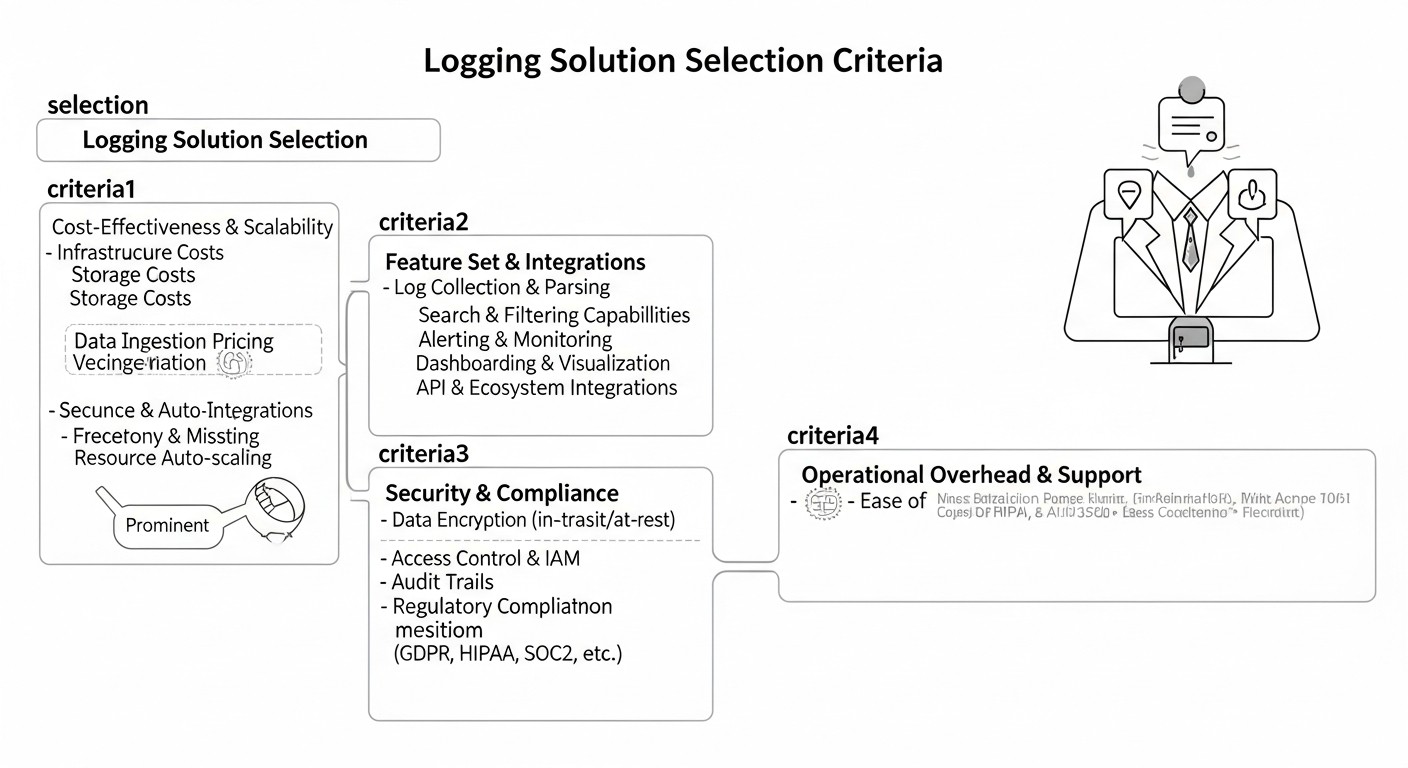

Criterios y factores clave para la elección de una solución de registro

La elección y el despliegue de un sistema de registro centralizado es una inversión que debe amortizarse mediante una mayor eficiencia operativa y una reducción del tiempo de resolución de incidentes. En 2026, a medida que los volúmenes de datos continúan creciendo y los requisitos de velocidad de respuesta se vuelven más estrictos, es especialmente importante considerar una serie de criterios clave al seleccionar y configurar su solución. Estos factores influyen directamente en el rendimiento, el costo, la seguridad y la facilidad de uso del sistema.

1. Escalabilidad (Scalability)

Por qué es importante: Su sistema de registro debe crecer junto con su aplicación. Si hoy procesa 100 registros por segundo, mañana podrían ser 1000 o 10 000. Una solución que no puede escalar horizontal o verticalmente se convertirá rápidamente en un cuello de botella. En un VPS, esto significa que debe poder expandir fácilmente los recursos (CPU, RAM, disco) o, idealmente, distribuir la carga entre varios VPS.

Cómo evaluar:

- Escalado horizontal: ¿Qué tan fácil es añadir nuevos nodos (Elasticsearch, Logstash, Kibana) para distribuir la carga? ELK Stack lo soporta bien, pero para un VPS esto significa costos adicionales en nuevos VPS.

- Escalado vertical: ¿Qué tan bien utiliza la solución los recursos adicionales en un solo VPS? (Por ejemplo, Elasticsearch escala bien verticalmente, pero hasta cierto límite).

- Rendimiento con el crecimiento de datos: ¿Cómo se comporta el sistema al aumentar el volumen de registros entrantes y el número de solicitudes?

2. Rendimiento (Performance)

Por qué es importante: Los registros deben recopilarse, indexarse y estar disponibles para la búsqueda prácticamente en tiempo real. Retrasos de varios minutos pueden ser críticos para la detección y resolución de problemas. Una búsqueda o visualización lenta cansa a los usuarios y reduce el valor del sistema.

Cómo evaluar:

- Velocidad de ingesta: Cantidad de registros que el sistema puede procesar por segundo.

- Velocidad de búsqueda: Tiempo necesario para ejecutar consultas y obtener resultados.

- Velocidad de visualización: Tiempo de carga de los paneles y gráficos en Kibana.

- Uso de recursos: ¿Qué tan eficientemente utiliza la solución la CPU, RAM, E/S de disco en picos de carga? Para un VPS esto es especialmente importante, ya que los recursos son limitados.

3. Costo (Cost)

Por qué es importante: Para startups y proyectos SaaS que operan en un VPS, el presupuesto es el rey. El costo incluye no solo los gastos directos del VPS, sino también las licencias (si aplica), el tiempo de los ingenieros para la configuración y el soporte, así como posibles costos ocultos (tráfico, copias de seguridad). ELK Stack, al ser de código abierto, es económico en términos de licencias, pero requiere una inversión significativa en infraestructura y tiempo de los ingenieros.

Cómo evaluar:

- Costos directos de infraestructura: Costo mensual del VPS (CPU, RAM, Almacenamiento, Red).

- Tarifas de licencia: Para ELK, esto podría ser Elastic Cloud o las funciones comerciales extendidas de X-Pack. Para un VPS, generalmente se utiliza la versión gratuita.

- Costos operativos: Tiempo de los ingenieros para el despliegue, configuración, monitoreo, mantenimiento, actualización.

- Costos ocultos: Costo del tráfico, copias de seguridad, herramientas de monitoreo.

4. Facilidad de uso y gestión (Ease of Use & Management)

Por qué es importante: Incluso la solución más potente es inútil si es difícil de configurar, usar o mantener. Una interfaz intuitiva, buena documentación y facilidad de gestión reducen la curva de aprendizaje y aumentan la productividad del equipo.

Cómo evaluar:

- Facilidad de instalación y configuración: ¿Qué tan rápido se puede levantar un sistema básico?

- Interfaz: ¿Qué tan intuitiva es la interfaz para buscar, analizar y visualizar registros (Kibana)?

- Documentación y comunidad: Disponibilidad de documentación de calidad y una comunidad activa para obtener soporte.

- Capacidades de automatización: Soporte para infraestructura como código (IaC) para el despliegue y la gestión.

5. Seguridad (Security)

Por qué es importante: Los registros a menudo contienen información sensible: direcciones IP, datos de usuario, errores con trazas de pila que pueden revelar detalles de la arquitectura. Una seguridad insuficiente del sistema de registro puede llevar a fugas de datos y violaciones de cumplimiento.

Cómo evaluar:

- Autenticación y autorización: Soporte para acceso basado en roles, integración con LDAP/AD.

- Cifrado: Soporte para TLS/SSL para la transmisión de datos entre componentes y clientes.

- Control de acceso a datos: Capacidad de control de acceso granular a índices y documentos.

- Auditoría: Mantenimiento de un registro de las acciones de los usuarios y los cambios de configuración.

6. Flexibilidad y extensibilidad (Flexibility & Extensibility)

Por qué es importante: Cada aplicación es única. El sistema de registro debe ser lo suficientemente flexible como para adaptarse a sus formatos de registro específicos, fuentes de datos y necesidades de análisis. La capacidad de integración con otras herramientas (monitoreo, alertas) también es muy importante.

Cómo evaluar:

- Soporte para varios formatos de registro: JSON, Syslog, Apache, Nginx, texto arbitrario.

- Plugins y conectores: Disponibilidad de plugins para Logstash, Beats para diversas fuentes de datos.

- API: Disponibilidad de una API potente para la interacción programática con los datos.

- Integración: Posibilidad de integración con sistemas de alerta (Slack, PagerDuty), monitoreo (Prometheus, Grafana).

7. Retención de datos y gestión del ciclo de vida (Data Retention & Lifecycle Management)

Por qué es importante: Almacenar registros indefinidamente es costoso y no siempre necesario. Es fundamental definir una política de retención de datos (por ejemplo, 7 días de registros "calientes", 30 días "tibios", 90 días "fríos") y tener un mecanismo para mover o eliminar automáticamente los datos antiguos. Para un VPS, esto es crítico, ya que el espacio en disco es limitado.

Cómo evaluar:

- Políticas de indexación: Soporte para Index Lifecycle Management (ILM) o mecanismos similares.

- Gestión de almacenamiento: Capacidad de usar diferentes tipos de almacenamiento (caliente/frío) o eliminar automáticamente índices antiguos.

- Instantáneas y copias de seguridad: Disponibilidad de mecanismos integrados para crear copias de seguridad.

8. Monitoreo y alertas (Monitoring & Alerting)

Por qué es importante: El sistema de registro en sí mismo es una parte crítica de la infraestructura. Su estado debe ser monitoreado, y también se deben configurar alertas sobre eventos críticos detectados en los registros. Estos pueden ser errores, anomalías o superación de umbrales.

Cómo evaluar:

- Monitoreo integrado: Disponibilidad de herramientas para monitorear el estado del propio ELK Stack.

- Flexibilidad de alertas: Capacidad de crear reglas de alerta complejas basadas en datos de registro y enviarlas a diferentes sistemas de notificación.

- Integración con otros sistemas de monitoreo: APIs abiertas para la exportación de métricas de estado de ELK.

Teniendo en cuenta estos criterios, podrá tomar una decisión informada sobre la mejor manera de construir su sistema de registro centralizado, especialmente en condiciones de recursos limitados de un VPS.

Tabla comparativa de soluciones de registro (Actualizado a 2026)

En 2026, el mercado de soluciones de registro centralizado ofrece una amplia gama de herramientas, cada una con sus fortalezas y debilidades. Para los ingenieros de DevOps y los fundadores de proyectos SaaS, que a menudo operan en un VPS con un presupuesto limitado, la elección de la pila óptima se vuelve críticamente importante. A continuación se presenta una tabla comparativa de las soluciones más populares, con un enfoque en su aplicabilidad en entornos VPS y características actuales.

| Criterio | ELK Stack (Código Abierto) | Loki + Grafana | Splunk Free/Light | CloudWatch Logs (AWS) | Elastic Cloud (ELK Gestionado) |

|---|---|---|---|---|---|

| Arquitectura | Distribuida (Elasticsearch, Logstash, Kibana, Beats). Requiere administración. | Loki centralizado (solo almacena metadatos) + Grafana. Más sencillo de administrar. | Monolítica/Distribuida (índices, forwarders). Propietaria. | Servicio en la nube de AWS totalmente gestionado. | Plataforma SaaS de Elastic totalmente gestionada. |

| Tipo de datos | Registros estructurados y no estructurados, métricas, APM, Seguridad. | Registros no estructurados (como texto), métricas. | Registros estructurados y no estructurados, métricas. | Registros, métricas de AWS. | Registros estructurados y no estructurados, métricas, APM, Seguridad. |

| Modelo de despliegue en VPS | Sí, posible. Requiere una optimización significativa de recursos y gestión manual. | Sí, mucho menos intensivo en recursos que ELK. Más fácil de desplegar en un solo VPS. | Limitado (versión gratuita hasta 500 MB/día). Difícil en VPS. | No, solo en la nube de AWS. | No, es SaaS. |

| Optimización de recursos en VPS | Alta necesidad de RAM y CPU, especialmente para Elasticsearch. Requiere configuración profunda de JVM, ILM, shards. | Baja necesidad de RAM y CPU, ya que Loki solo indexa metadatos y utiliza almacenamiento de objetos (compatible con S3). | Alta necesidad, no es práctico para versiones gratuitas en VPS. | No aplicable (gestionado por AWS). | No aplicable (gestionado por Elastic). |

| Costo (aproximado 2026, en VPS) | $20-100/mes por VPS (8-16GB RAM, 4-8 vCPU, 200-500GB NVMe). Depende del volumen de registros. | $10-50/mes por VPS (4-8GB RAM, 2-4 vCPU, 100-200GB NVMe) + costo de almacenamiento S3 (unos pocos $). | Gratis hasta 500 MB/día. Enterprise desde $1000+/mes. No para despliegue en VPS. | Depende del volumen de registros y consultas. Por ejemplo, $30-150/mes por 100GB de registros/mes. | Desde $70/mes por un clúster básico (8GB RAM, 2 vCPU) hasta miles. |

| Velocidad de ingesta (hipotéticamente) | Alta (decenas de miles de eventos/segundo con la configuración adecuada). | Muy alta (decenas-cientos de miles de eventos/segundo, ya que solo se indexan las etiquetas). | Alta (con recursos disponibles). | Alta. | Muy alta. |

| Velocidad de búsqueda | Muy alta para datos estructurados. Búsqueda de texto completo. | Búsqueda rápida por etiquetas. La búsqueda por contenido de registros es más lenta. | Muy alta, potente lenguaje SPL. | Buena para consultas simples, más lenta para complejas. | Muy alta. |

| Visualización/Análisis | Kibana: potentes paneles, gráficos, discover, APM, Seguridad. | Grafana: paneles flexibles, métricas, trazas, registros. | Splunk UI: muy potente, pero complejo de aprender. | CloudWatch Dashboards: básicos, pero suficientes para monitorear AWS. | Kibana: funcionalidad completa. |

| Gestión del ciclo de vida (ILM) | Sí, ILM integrado para la gestión automática de índices (calientes/tibios/fríos/eliminación). | Gestionado por políticas S3 y configuración de Loki. | Sí. | Políticas de retención configurables. | Sí, ILM completo. |

| Seguridad | Básica (X-Pack Security) - autenticación, autorización, TLS. Funciones avanzadas de pago. | Autenticación de Grafana, TLS, integración con IAM para S3. | Integrada, muy potente. | Integración con AWS IAM, KMS. | Seguridad completa de X-Pack. |

| Curva de aprendizaje | Media/Alta (instalación, configuración de todos los componentes, optimización). | Baja/Media (más fácil de instalar, Grafana es familiar para muchos). | Alta (lenguaje SPL, conceptos). | Baja (para uso básico). | Baja (para uso, pero no para administración). |

| Para quién es adecuado (en VPS) | Equipos que necesitan análisis profundo, búsqueda de texto completo, flexibilidad y control total sobre los datos, dispuestos a invertir tiempo en la administración. | Equipos que necesitan una forma sencilla, ligera y económica de centralizar registros para depuración y monitoreo básico, que ya utilizan Grafana. | Grandes empresas con gran presupuesto, no para despliegue en VPS. | Equipos cuya infraestructura está completamente en AWS y que no necesitan un análisis profundo de registros más allá de las métricas de AWS. | Equipos que necesitan toda la potencia de ELK, pero sin la molestia de la administración, dispuestos a pagar por la comodidad. |

Conclusiones de la tabla:

- ELK Stack (Código Abierto) sigue siendo una opción potente y flexible para aquellos que están dispuestos a invertir en su administración y optimización. En un VPS, esto requiere una atención especial a los recursos.

- Loki + Grafana se presenta como una alternativa más ligera y económica para VPS, especialmente si la tarea principal es la visualización rápida de registros y su correlación con métricas, en lugar de un análisis profundo de texto completo. Su modelo de almacenamiento (indexación solo de metadatos) reduce significativamente los requisitos de RAM y CPU en el servidor.

- Splunk y CloudWatch Logs son soluciones para otras escalas y ecosistemas, no óptimas para un despliegue autónomo en un VPS.

- Elastic Cloud es una excelente opción para quienes desean ELK sin administración, pero el precio es significativamente más alto que un despliegue autónomo en un VPS.

Para los propósitos de este artículo, nos centraremos en ELK Stack (Código Abierto) como la opción más flexible y controlable para el despliegue en un VPS, con énfasis en cómo hacerlo eficiente incluso con recursos limitados.

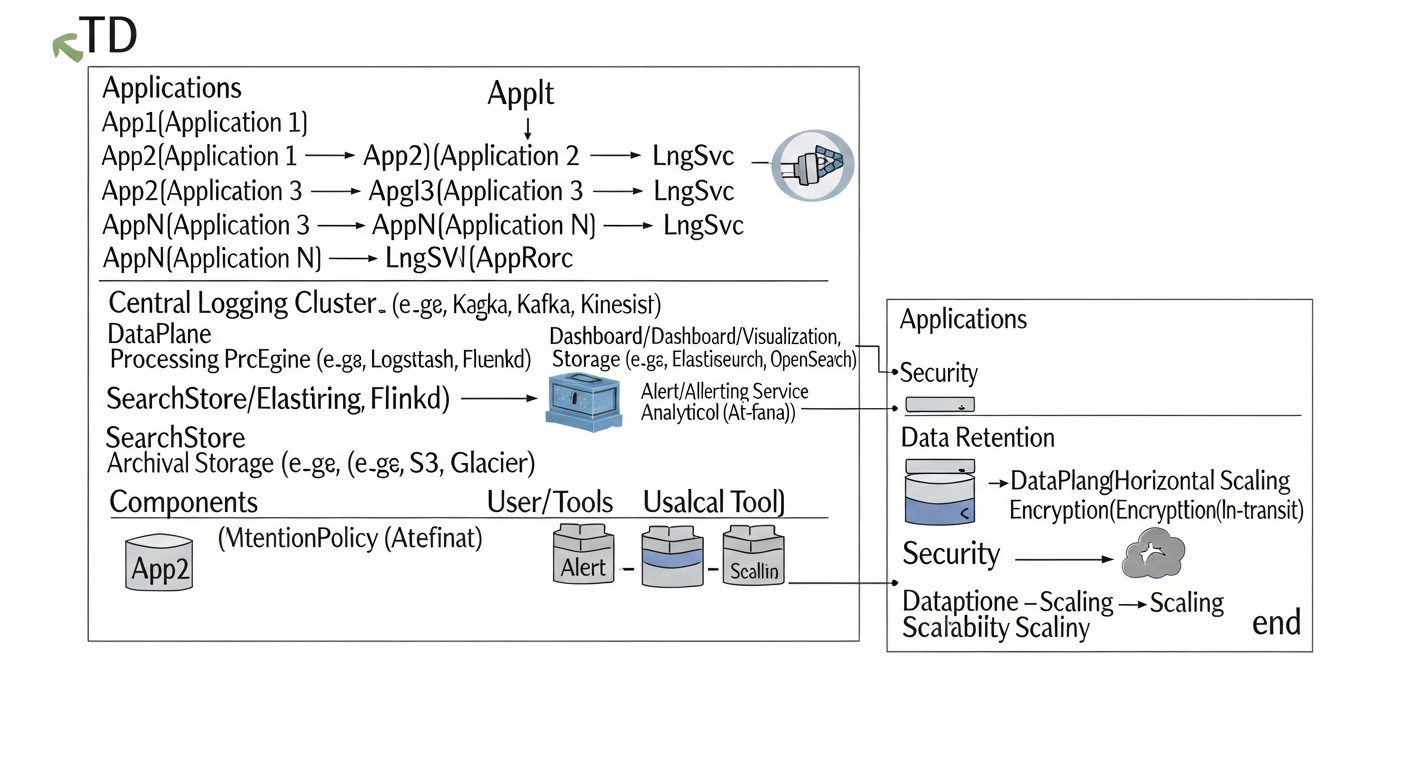

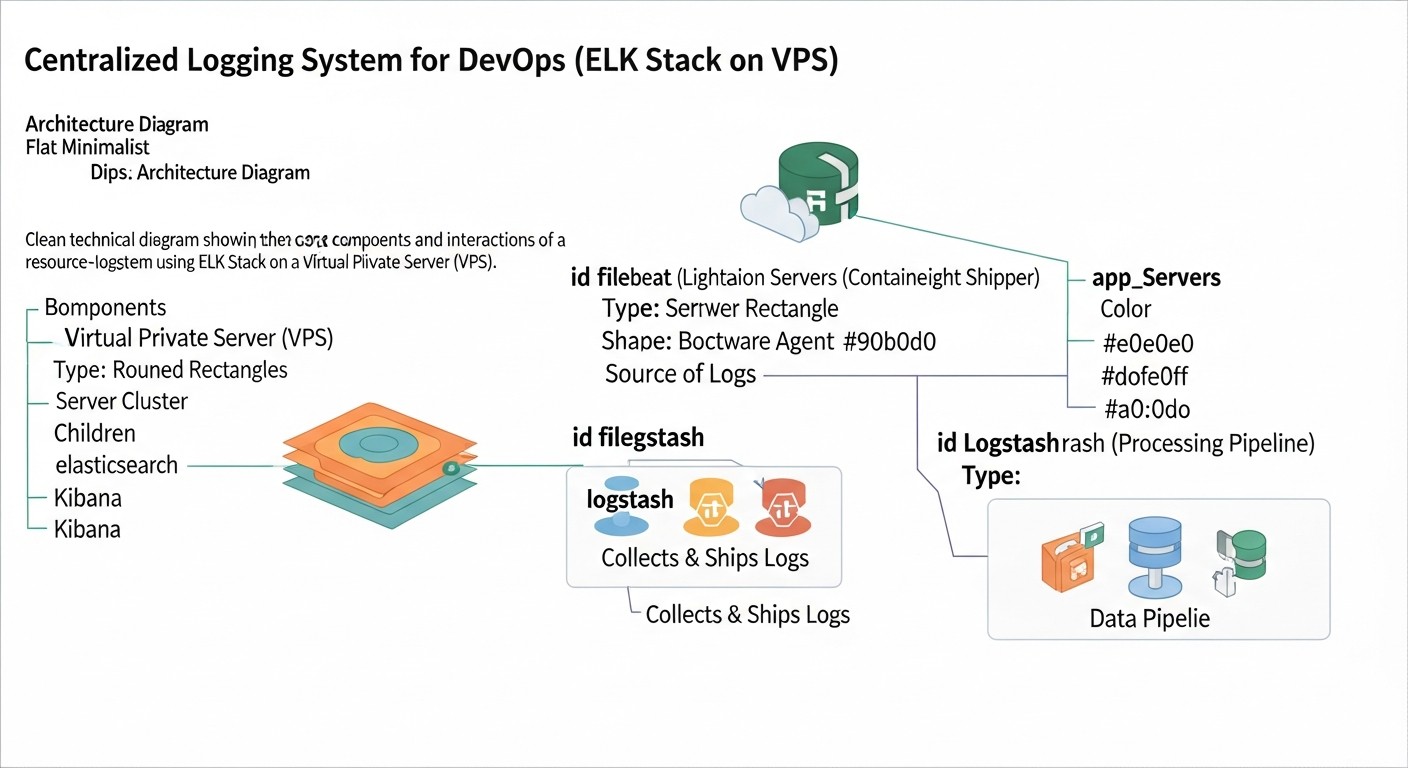

Descripción detallada de los componentes de ELK Stack y alternativas

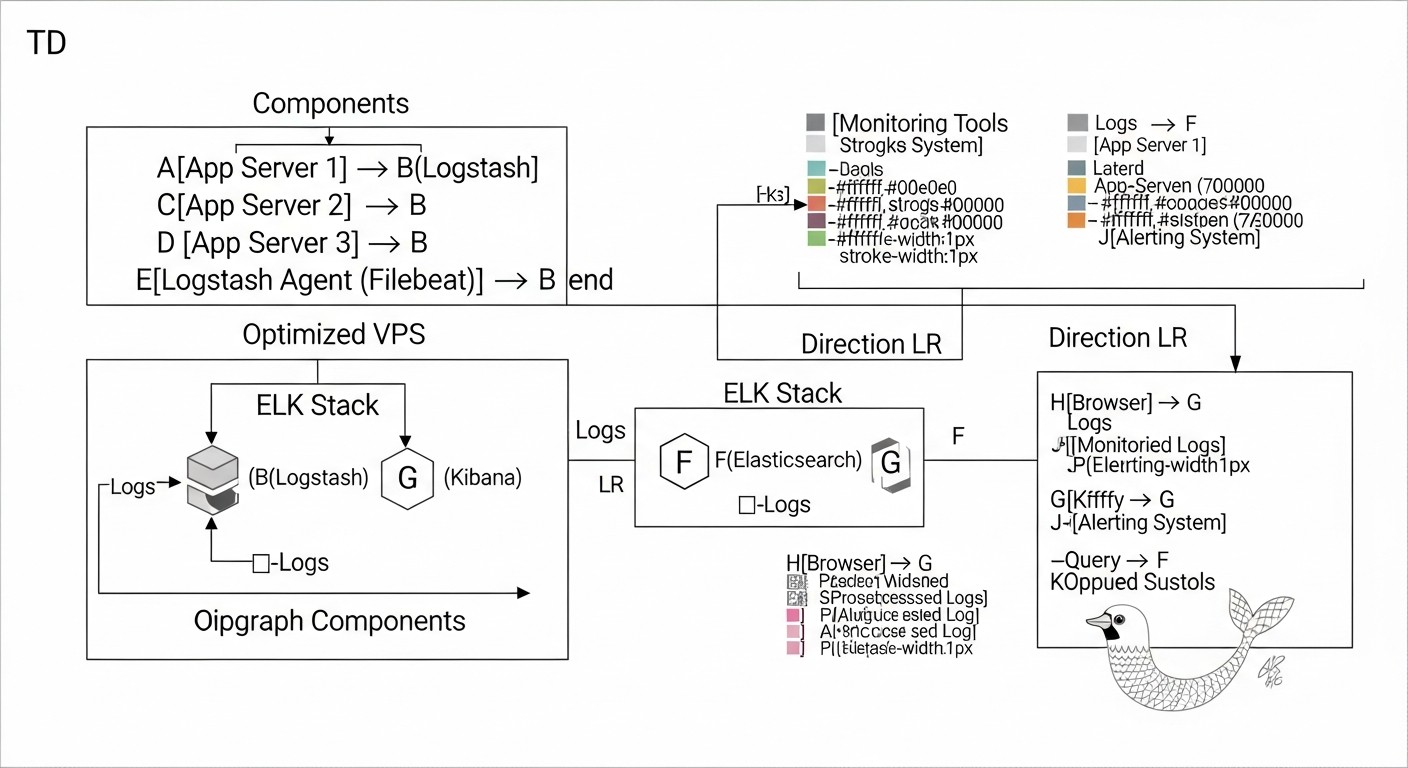

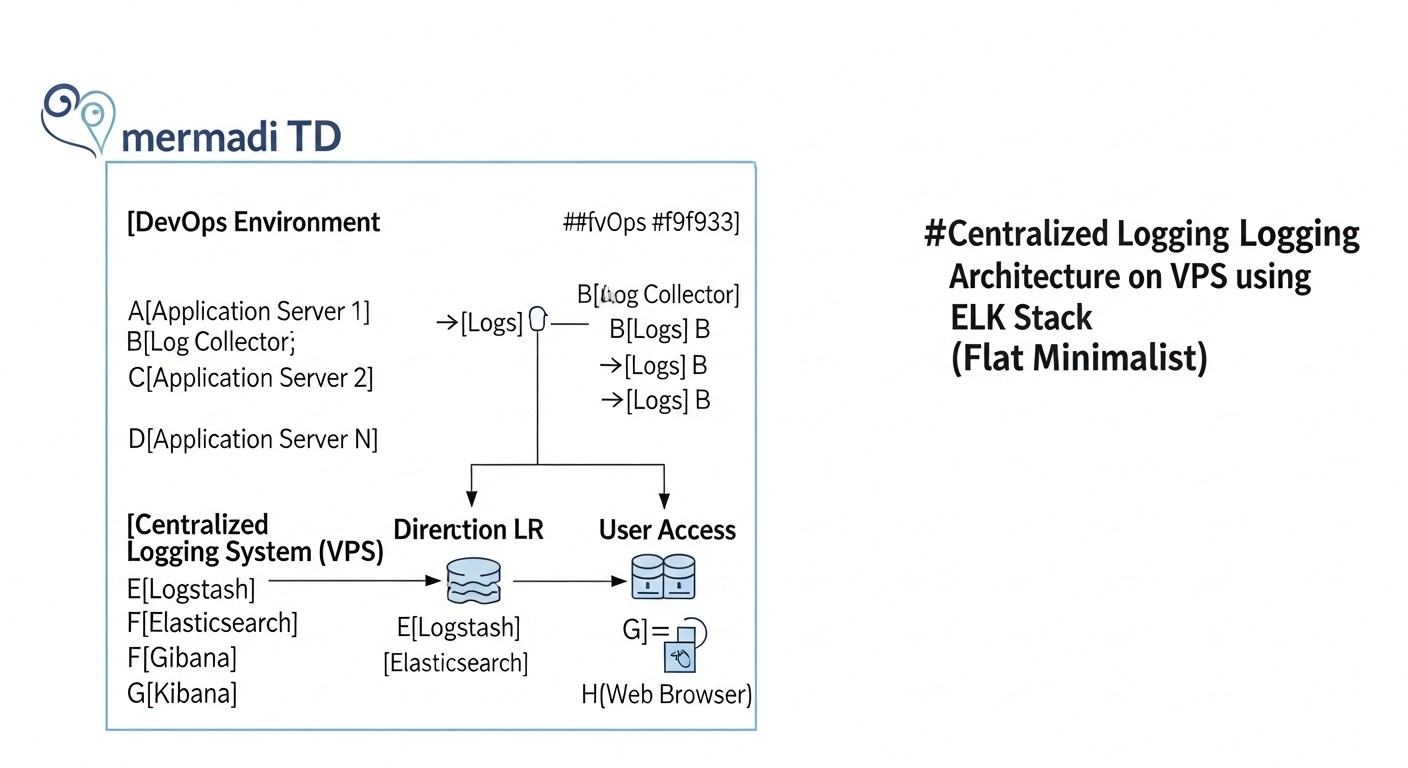

ELK Stack es una abreviatura que designa tres componentes clave: Elasticsearch, Logstash y Kibana. En la interpretación moderna, a menudo se les añade Beats, una familia de agentes ligeros para la recopilación de datos. Examinemos cada uno de ellos en detalle, y también abordemos las principales alternativas que se mencionaron en la tabla comparativa.

1. Elasticsearch: El corazón del almacenamiento y la búsqueda

Elasticsearch es un sistema de búsqueda y análisis distribuido, RESTful, construido sobre Apache Lucene. Es el motor que almacena todos sus registros, los indexa y proporciona una búsqueda y agregación de datos ultrarrápida. Para un ingeniero de DevOps, esto significa la capacidad de encontrar rápidamente los eventos necesarios entre miles de millones de registros.

- Pros:

- Velocidad: Casi en tiempo real para indexación y búsqueda.

- Escalabilidad: Escalado horizontal añadiendo nuevos nodos al clúster.

- Flexibilidad: Soporte para datos estructurados y no estructurados, potente lenguaje de consulta (DSL).

- Agregaciones: Capacidad de ejecutar consultas analíticas complejas, construir gráficos y paneles.

- Ecosistema: Rico ecosistema de plugins e integraciones.

- Contras:

- Intensivo en recursos: Requiere mucha RAM y CPU, especialmente para indexación y consultas intensivas. El proceso JVM puede consumir gigabytes de memoria.

- Complejidad de gestión: La gestión de clústeres, shards, réplicas e índices requiere ciertos conocimientos.

- Sensibilidad a la configuración: Configuraciones incorrectas pueden llevar a inestabilidad o pérdida de datos.

- Para quién es adecuado: Para proyectos que necesitan una potente búsqueda de texto completo, análisis complejo y alta velocidad de procesamiento de datos. Es una opción ideal si está dispuesto a invertir tiempo en optimización y administración.

- Ejemplos de uso en VPS:

- Almacenamiento y búsqueda de registros de servidores web (Nginx, Apache), aplicaciones (Python, Node.js, Go), bases de datos.

- Análisis de seguridad (funciones tipo SIEM para equipos pequeños).

- Recopilación de métricas y su almacenamiento para análisis posterior.

Optimización para VPS: El aspecto clave es la gestión de la memoria JVM. Se recomienda asignar hasta el 50% de la RAM disponible en el VPS, pero no más de 30.5 GB, para evitar punteros comprimidos. También es importante configurar ILM (Index Lifecycle Management) para la eliminación automática de índices antiguos y el uso de data streams para una gestión eficiente de los datos.

2. Logstash: El pipeline de procesamiento de datos

Logstash es un pipeline potente, flexible y de código abierto para la recopilación, procesamiento y reenvío de datos (ETL). Puede recibir datos de diversas fuentes, transformarlos (parseo, enriquecimiento, filtrado) y enviarlos a diferentes destinos, la mayoría de las veces a Elasticsearch.

- Pros:

- Flexibilidad de fuentes/destinos: Soporta una enorme cantidad de inputs (file, http, beats, kafka, redis) y outputs (elasticsearch, s3, email).

- Procesamiento potente: Los filtros (grok, mutate, date, geoip) permiten parsear registros complejos, añadir contexto, normalizar datos.

- Resistencia: Soporte para colas persistentes (persistent queues) y colas de mensajes no entregados (dead-letter queues) para evitar la pérdida de datos.

- Contras:

- Intensivo en recursos: Logstash, especialmente con un gran número de filtros Grok complejos, puede consumir importantes recursos de CPU y RAM.

- Complejidad de configuración: Escribir configuraciones eficientes y tolerantes a fallos puede ser complicado.

- Rendimiento: Más lento que Beats para la recopilación directa de registros.

- Para quién es adecuado: Para tareas que requieren un procesamiento complejo de datos antes de la indexación, agregación de múltiples fuentes o enriquecimiento de registros.

- Ejemplos de uso en VPS:

- Parseo de registros de texto no estructurados a JSON estructurado.

- Enriquecimiento de registros con direcciones IP (geolocalización) o datos de otras fuentes.

- Agregación de registros de Kafka o Redis antes de enviarlos a Elasticsearch.

Optimización para VPS: Utilice Beats para la recopilación directa de registros y Logstash solo para transformaciones complejas. Optimice los patrones Grok (hágalos lo más precisos posible). Configure el número de workers del pipeline y el tamaño del lote (batch size). Reduzca el tamaño del heap de JVM para Logstash si no realiza transformaciones muy intensivas.

3. Kibana: Interfaz para visualización y análisis

Kibana es una potente herramienta para la visualización y exploración de datos almacenados en Elasticsearch. Proporciona una interfaz web intuitiva para crear paneles, gráficos, tablas e informes interactivos, permitiendo a los usuarios analizar rápidamente registros y métricas.

- Pros:

- Visualización: Amplia gama de tipos de visualizaciones (histogramas, gráficos circulares, mapas, tablas).

- Paneles: Capacidad de crear paneles interactivos a partir de diversas visualizaciones.

- Discover: Potente interfaz para buscar y filtrar registros brutos.

- Módulos: Módulos integrados para APM, Seguridad, Observabilidad.

- Contras:

- Intensivo en recursos: Puede ser exigente en RAM y CPU al construir paneles complejos con grandes volúmenes de datos.

- Dependencia de Elasticsearch: Sin un Elasticsearch en funcionamiento, Kibana es inútil.

- Curva de aprendizaje: La creación de visualizaciones complejas requiere cierto dominio.

- Para quién es adecuado: Para cualquiera que quiera obtener una representación visual clara de sus datos, crear informes y monitorear el estado del sistema.

- Ejemplos de uso en VPS:

- Monitoreo de errores y advertencias en tiempo real.

- Análisis del tráfico del servidor web.

- Seguimiento del rendimiento de la aplicación.

Optimización para VPS: Coloque Kibana en el mismo VPS que Elasticsearch para minimizar los retrasos de red. Utilice Nginx o Caddy como proxy inverso para el almacenamiento en caché de archivos estáticos y la adición de SSL. Limite el número de paneles y visualizaciones complejas abiertas simultáneamente.

4. Beats: Agentes ligeros de recopilación de datos

Beats es una familia de agentes ligeros y de propósito único que se instalan en sus servidores para recopilar varios tipos de datos (registros, métricas, tráfico de red, datos de seguridad) y reenviarlos a Elasticsearch o Logstash. Filebeat para registros y Metricbeat para métricas son los más utilizados.

- Pros:

- Ligereza: Bajo consumo de recursos, lo que los hace ideales para instalar en servidores de producción.

- Fiabilidad: Entrega garantizada de datos, resistencia a fallos de red.

- Modularidad: Beats especializados para diferentes tipos de datos y fuentes (Filebeat, Metricbeat, Packetbeat, Heartbeat, Auditbeat, Winlogbeat).

- Facilidad de configuración: Configuración en archivos YAML, módulos listos para servicios populares.

- Contras:

- Procesamiento limitado: Beats realiza un procesamiento básico (por ejemplo, parseo de JSON), pero no es adecuado para transformaciones complejas como Logstash.

- Múltiples agentes: Para diferentes tipos de datos se requieren diferentes Beats, lo que puede complicar la gestión en un gran número de servidores.

- Para quién es adecuado: Para cualquiera que quiera recopilar datos de manera eficiente y fiable de múltiples servidores y contenedores con un consumo mínimo de recursos.

- Ejemplos de uso en VPS:

- Filebeat para la recopilación de registros de Nginx, contenedores Docker, registros del sistema.

- Metricbeat para la recopilación de métricas de CPU, RAM, disco, red, así como métricas de servicios (MySQL, Redis, Docker).

Optimización para VPS: Utilice Beats en lugar de Logstash en las fuentes de registros si no se requiere un procesamiento complejo. Configure `scan_frequency` y `harvester_buffer_size` para equilibrar la actualidad y el consumo de recursos. Limite la cantidad de métricas y registros recopilados para no sobrecargar el sistema.

5. Alternativas: Loki + Grafana

Como ya se señaló en la tabla, Loki de Grafana Labs es un serio competidor de ELK, especialmente para escenarios con recursos limitados y un enfoque en los registros en el contexto de las métricas.

- Pros:

- Eficiencia de recursos: Loki indexa solo las etiquetas de los registros, no su contenido, lo que lo hace extremadamente ligero. Los registros se almacenan en almacenamiento de objetos (S3, GCS) o en disco local.

- Integración con Grafana: Ideal para equipos que ya utilizan Grafana para el monitoreo de métricas. Los registros y las métricas se correlacionan fácilmente.

- Simplicidad: Más fácil de desplegar y gestionar que ELK.

- Lenguaje de consulta LogQL: Similar a PromQL, lo que facilita el aprendizaje para quienes ya están familiarizados con Prometheus.

- Contras:

- Búsqueda de texto completo limitada: La búsqueda por contenido de registros es menos eficiente que en Elasticsearch y requiere escanear grandes volúmenes de datos.

- Análisis menos potente: Loki no está diseñado para realizar agregaciones complejas y consultas analíticas como Elasticsearch.

- Ecosistema más pequeño: La comunidad y el conjunto de integraciones son menores que los de ELK.

- Para quién es adecuado: Para equipos que necesitan una forma sencilla y económica de centralizar registros para depuración y monitoreo básico, especialmente si ya utilizan Grafana para métricas. Ideal para despliegues en VPS pequeños.

- Ejemplos de uso en VPS:

- Recopilación de registros de contenedores Docker y clústeres de Kubernetes (con Promtail).

- Monitoreo básico de errores y advertencias.

- Correlación de registros con gráficos de métricas en Grafana para una rápida resolución de problemas.

La elección entre ELK y Loki+Grafana a menudo se reduce a un compromiso entre la potencia analítica y la eficiencia de los recursos. Para un análisis profundo y una búsqueda de texto completo, ELK sigue siendo el líder, pero para una visualización rápida de registros y despliegues económicos, Loki se convierte en una alternativa muy atractiva.

Consejos prácticos y recomendaciones para el despliegue de ELK en un VPS con optimización de recursos

El despliegue de ELK Stack en un VPS es un arte de equilibrar la funcionalidad y los recursos disponibles. El objetivo es obtener el máximo beneficio con el mínimo costo. A continuación se presentan instrucciones paso a paso y recomendaciones basadas en la experiencia de trabajar con ELK en condiciones limitadas.

1. Elección del proveedor y configuración del VPS (año 2026)

En 2026, el mercado de proveedores de VPS ofrece una amplia variedad. Para ELK, los siguientes parámetros son críticos:

- RAM: Mínimo 8 GB para una pila mínimamente viable. 16 GB o más es el inicio recomendado para un entorno de producción. Elasticsearch es especialmente aficionado a la memoria.

- CPU: Mínimo 2-4 vCPU. Cuantos más núcleos, mejor para el procesamiento paralelo de solicitudes e indexación.

- Disco: Solo NVMe SSD. Los SSD o HDD normales no podrán manejar las operaciones intensivas de E/S de Elasticsearch. Mínimo 200-500 GB, dependiendo del volumen de registros y la política de retención.

- Red: Un canal de red estable y rápido (mínimo 1 Gbit/s) sin restricciones ocultas de tráfico, si planea recopilar registros de muchas fuentes externas.

Proveedores recomendados (2026): Hetzner Cloud, Vultr, DigitalOcean, OVHcloud. Ofrecen una buena relación precio/rendimiento para NVMe SSD y suficiente RAM.

Ejemplo de configuración para empezar (Hetzner Cloud CX41/CX51):

- 8-16 GB RAM

- 4-8 vCPU

- 200-320 GB NVMe SSD

- Precio: $25 - $50/mes (aproximado 2026)

2. Preparación del VPS para la instalación de ELK

Antes de instalar los componentes de ELK, es necesario configurar el sistema operativo. Se recomienda utilizar Ubuntu Server 22.04 LTS o 24.04 LTS.

# Actualización del sistema

sudo apt update && sudo apt upgrade -y

# Instalación de Java (OpenJDK 17 o posterior, relevante para ES 8.x/9.x)

sudo apt install openjdk-17-jdk -y

# Aumento de los límites de descriptores de archivo y memoria para Elasticsearch

# Añadir a /etc/sysctl.conf

echo "vm.max_map_count=262144" | sudo tee -a /etc/sysctl.conf

sudo sysctl -p

# Añadir a /etc/security/limits.conf (para el usuario elasticsearch)

# elasticsearch - nofile 65536

# elasticsearch - memlock unlimited

# (Estas configuraciones se aplicarán después de crear el usuario elasticsearch y reiniciar)

# Desactivar swap (recomendado para Elasticsearch para evitar la degradación del rendimiento)

sudo swapoff -a

sudo sed -i '/ swap / s/^\(.*\)$/#\1/g' /etc/fstab

# Instalación de paquetes para repositorios HTTPS

sudo apt install apt-transport-https ca-certificates curl gnupg lsb-release -y

# Añadir el repositorio de Elastic

curl -fsSL https://artifacts.elastic.co/GPG-KEY-elasticsearch | sudo gpg --dearmor -o /usr/share/keyrings/elastic.gpg

echo "deb [signed-by=/usr/share/keyrings/elastic.gpg] https://artifacts.elastic.co/packages/8.x/apt stable main" | sudo tee /etc/apt/sources.list.d/elastic-8.x.list

sudo apt update

3. Instalación y configuración básica de Elasticsearch

Instalación:

sudo apt install elasticsearch -y

Configuración (archivo /etc/elasticsearch/elasticsearch.yml):

cluster.name: my-elk-cluster(se puede dejar por defecto, pero es mejor definirlo).node.name: node-1path.data: /var/lib/elasticsearch(asegúrese de que sea un disco NVMe).path.logs: /var/log/elasticsearchnetwork.host: 0.0.0.0(para acceso externo, ¡cuidado con la seguridad!). Para un solo VPS,localhosto127.0.0.1es suficiente.http.port: 9200discovery.type: single-node(crítico para un solo VPS, para evitar intentos de formación de clúster).xpack.security.enabled: true(habilita la seguridad básica en 8.x por defecto).

Optimización del tamaño del Heap de JVM: Este es el parámetro más importante para Elasticsearch en un VPS. Edite /etc/elasticsearch/jvm.options.

Establezca -Xms y -Xmx en el mismo valor, no más del 50% de la RAM total del VPS, pero no más de 30.5 GB, para evitar punteros comprimidos.

Por ejemplo, para un VPS con 16 GB de RAM:

-Xms8g

-Xmx8g

Inicio y verificación:

sudo systemctl enable elasticsearch

sudo systemctl start elasticsearch

sudo systemctl status elasticsearch

curl -u elastic:your_password https://localhost:9200 # (la contraseña se genera en el primer inicio)

En el primer inicio de Elasticsearch 8.x con xpack.security.enabled: true, se generará automáticamente una contraseña para el usuario elastic y otros tokens. Deberá guardarlos.

# Después del primer inicio (si lo olvidó o no lo anotó)

sudo /usr/share/elasticsearch/bin/elasticsearch-reset-password -u elastic

4. Instalación y configuración básica de Kibana

Instalación:

sudo apt install kibana -y

Configuración (archivo /etc/kibana/kibana.yml):

server.port: 5601server.host: "0.0.0.0"(o"localhost", si usará Nginx como proxy).elasticsearch.hosts: ["https://localhost:9200"]elasticsearch.username: "kibana_system"(usuario creado por ES para Kibana).elasticsearch.password: "YOUR_KIBANA_SYSTEM_PASSWORD"(obtenido después de configurar ES).server.publicBaseUrl: "https://your_domain.com"(si usa dominio y SSL).

En el primer inicio de Kibana, le pedirá un token para conectarse a Elasticsearch. Puede generarlo en Elasticsearch:

sudo /usr/share/elasticsearch/bin/elasticsearch-create-enrollment-token -s kibana

Luego, use este token en la interfaz web de Kibana en el primer inicio de sesión. Después de esto, Kibana le sugerirá generar un token para el usuario kibana_system.

Inicio y verificación:

sudo systemctl enable kibana

sudo systemctl start kibana

sudo systemctl status kibana

Acceso a través de http://your_vps_ip:5601 (o https, si está configurado). Use el login elastic y la contraseña obtenida de Elasticsearch.

5. Instalación y configuración básica de Logstash (opcional, use Beats si es posible)

Instalación:

sudo apt install logstash -y

Configuración (archivo /etc/logstash/logstash.yml):

http.host: "0.0.0.0"path.data: /var/lib/logstashpath.logs: /var/log/logstash

Optimización del tamaño del Heap de JVM: Edite /etc/logstash/jvm.options. Para la mayoría de los escenarios en un VPS, 1-2 GB serán suficientes.

-Xms1g

-Xmx1g

Ejemplo de la configuración más simple de Logstash (archivo /etc/logstash/conf.d/01-beats-input.conf):

input {

beats {

port => 5044

ssl => true

ssl_certificate_authorities => ["/etc/logstash/certs/ca.crt"] # Ruta a su CA

ssl_certificate => "/etc/logstash/certs/logstash.crt"

ssl_key => "/etc/logstash/certs/logstash.key"

}

}

filter {

# Ejemplo de parseo JSON simple

if [message] =~ /^{.*}$/ {

json {

source => "message"

target => "json_data"

remove_field => ["message"] # Elimina el mensaje original si es completamente JSON

}

}

}

output {

elasticsearch {

hosts => ["https://localhost:9200"]

user => "logstash_system" # Usuario para Logstash, creado en ES

password => "YOUR_LOGSTASH_SYSTEM_PASSWORD"

ssl => true

ssl_certificate_verification => false # En producción use true y CA para ES

# index => "my-app-logs-%{+YYYY.MM.dd}" # Forma antigua

manage_template => false # Usamos Data Streams

data_stream_acd => true

}

}

Importante: Para trabajar con Elasticsearch 8.x y superior, y para garantizar la seguridad, es necesario configurar SSL/TLS y autenticación. Esto incluye la creación de certificados y usuarios. Utilice el usuario logstash_system para Logstash, cuya contraseña se genera en Elasticsearch.

# Generación de contraseña para el usuario logstash_system

sudo /usr/share/elasticsearch/bin/elasticsearch-reset-password -u logstash_system

Inicio y verificación:

sudo systemctl enable logstash

sudo systemctl start logstash

sudo systemctl status logstash

6. Instalación y configuración básica de Filebeat (en los servidores de origen de los registros)

Instalación de Filebeat en los servidores desde los que recopila registros (no en el VPS con ELK):

# Añadir el repositorio de Elastic (si aún no se ha hecho)

curl -fsSL https://artifacts.elastic.co/GPG-KEY-elasticsearch | sudo gpg --dearmor -o /usr/share/keyrings/elastic.gpg

echo "deb [signed-by=/usr/share/keyrings/elastic.gpg] https://artifacts.elastic.co/packages/8.x/apt stable main" | sudo tee /etc/apt/sources.list.d/elastic-8.x.list

sudo apt update

# Instalación de Filebeat

sudo apt install filebeat -y

Configuración (archivo /etc/filebeat/filebeat.yml):

- En la sección

filebeat.inputsconfigure las rutas a los registros:

filebeat.inputs:

- type: filestream

id: my-app-logs

enabled: true

paths:

- /var/log/my-app/*.log

fields:

service_name: my_application

env: production

processors:

- decode_json_fields:

fields: ["message"]

target: "json"

overwrite_keys: true

max_depth: 10

add_error: true

- add_host_metadata: ~

- add_cloud_metadata: ~ # Si es una VM en la nube

output.logstash:

hosts: ["your_logstash_vps_ip:5044"]

ssl.enabled: true

ssl.verification_mode: none # En producción use full y CA

# ssl.certificate_authorities: ["/etc/filebeat/certs/ca.crt"] # Ruta a CA, si usa full verification

output.elasticsearch:

hosts: ["https://your_elasticsearch_vps_ip:9200"]

username: "filebeat_writer" # Usuario para Filebeat, creado en ES

password: "YOUR_FILEBEAT_WRITER_PASSWORD"

ssl.enabled: true

ssl.verification_mode: none # En producción use full y CA

# ssl.certificate_authorities: ["/etc/filebeat/certs/ca.crt"]

index: "my-app-logs-%{+YYYY.MM.dd}" # O use data_stream

data_stream.namespace: default

# data_stream.type: logs # Para versión 8.x+

# data_stream.dataset: myapp.logs

Importante: Para una conexión directa de Filebeat a Elasticsearch 8.x, necesitará crear un usuario con los permisos adecuados. Por ejemplo, filebeat_writer con un rol que permita escribir en data streams.

# Creación de usuario para Filebeat en Elasticsearch

# Primero genere la contraseña

sudo /usr/share/elasticsearch/bin/elasticsearch-reset-password -u filebeat_writer

# Luego cree el rol (por ejemplo, a través de Kibana Dev Tools):

# PUT /_security/role/filebeat_writer_role

# {

# "cluster": ["monitor"],

# "indices": [

# {

# "names": ["logs-*-*"],

# "privileges": ["write", "create_index", "manage_ilm"]

# }

# ],

# "applications": [],

# "run_as": [],

# "metadata": {},

# "transient_metadata": {}

# }

# Asigne este rol al usuario filebeat_writer.

Inicio y verificación:

sudo systemctl enable filebeat

sudo systemctl start filebeat

sudo systemctl status filebeat

7. Optimización a nivel de sistema y red

- Sistema de archivos: Para Elasticsearch se recomienda XFS o Ext4. Asegúrese de que el disco esté montado con las opciones

noatimeynodiratimepara reducir la E/S. - Firewall: Configure UFW u otro firewall para restringir el acceso a los puertos 9200 (Elasticsearch), 5601 (Kibana) y 5044 (Logstash/Beats). Permita el acceso solo desde direcciones IP de confianza o a través de VPN.

sudo ufw allow 22/tcp # SSH

sudo ufw allow 5601/tcp # Kibana

sudo ufw allow 9200/tcp # Elasticsearch (solo para confianza)

sudo ufw allow 5044/tcp # Beats/Logstash

sudo ufw enable

# Ejemplo de configuración de Nginx para Kibana

server {

listen 80;

server_name your_domain.com;

return 301 https://$host$request_uri;

}

server {

listen 443 ssl http2;

server_name your_domain.com;

ssl_certificate /etc/letsencrypt/live/your_domain.com/fullchain.pem;

ssl_certificate_key /etc/letsencrypt/live/your_domain.com/privkey.pem;

location / {

proxy_pass http://localhost:5601;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

# Autenticación básica (opcional)

# auth_basic "Restricted Content";

# auth_basic_user_file /etc/nginx/.htpasswd;

}

}

8. Gestión del ciclo de vida de los índices (ILM)

En 2026, ILM (Index Lifecycle Management) es una práctica estándar para la gestión de datos en Elasticsearch. Permite mover automáticamente los índices entre fases "calientes", "tibias", "frías" y eliminarlos, optimizando el uso del disco.

Utilice la interfaz de usuario de Kibana (Stack Management -> Index Lifecycle Policies) para crear políticas de ILM. Por ejemplo:

- Fase caliente (Hot phase): Los datos se escriben y leen activamente. Transición a Tibia después de 7 días.

- Fase tibia (Warm phase): Los datos solo se leen. Transición a Fría después de 30 días.

- Fase fría (Cold phase): Los datos se leen raramente, posible compresión. Transición a Eliminación después de 90 días.

- Fase de eliminación (Delete phase): Eliminación del índice después de 180 días.

Asegúrese de que sus Filebeat o Logstash estén configurados para usar Data Streams, que crean automáticamente índices vinculados a las políticas de ILM.

Estos consejos prácticos le ayudarán no solo a desplegar ELK Stack en un VPS, sino también a optimizar significativamente su funcionamiento, prolongando la vida útil de sus recursos y garantizando la estabilidad del sistema de registro.

Errores comunes al trabajar con ELK en un VPS y cómo evitarlos

El despliegue y la operación de ELK Stack, especialmente en recursos limitados de un VPS, están plagados de numerosas trampas. Errores de configuración o suposiciones incorrectas pueden llevar a inestabilidad, pérdida de datos, degradación del rendimiento o costos injustificadamente altos. Aquí están los cinco errores más comunes y cómo prevenirlos:

1. Asignación insuficiente de recursos (RAM y E/S)

Error: Intentar ejecutar una pila ELK completa en un VPS con 2-4 GB de RAM y un HDD/SATA SSD normal. Elasticsearch, Logstash y Kibana son aplicaciones que consumen muchos recursos. Elasticsearch es especialmente sensible a la falta de RAM y a una E/S de disco lenta.

Consecuencias:

- Errores OutOfMemoryError constantes en Elasticsearch y Logstash.

- Indexación y búsqueda lentas, retrasos en la llegada de registros.

- Kibana "colgado", incapacidad para construir paneles.

- Pérdida de datos debido al desbordamiento de colas y la incapacidad del sistema para procesar el flujo entrante.

- Inestabilidad general del sistema, reinicios frecuentes de los servicios.

Cómo evitarlo:

- Comience con recursos adecuados: Mínimo 8 GB de RAM y 4 vCPU, obligatoriamente NVMe SSD. Para un entorno de producción con un flujo moderado de registros (varios miles de eventos/segundo), considere 16 GB de RAM.

- Optimice el Heap de JVM: Establezca

-Xmsy-Xmxpara Elasticsearch en el 50% de la RAM disponible, pero no más de 30.5 GB. Para Logstash, 1-2 GB suelen ser suficientes. - Monitoreo: Monitoree cuidadosamente el uso de CPU, RAM, E/S de disco y Heap de JVM con Metricbeat y Kibana Stack Monitoring.

- Use ILM: Elimine automáticamente los índices antiguos para evitar el desbordamiento del disco.

2. Configuración incorrecta del tamaño del Heap de JVM

Error: Establecer -Xms y -Xmx para Elasticsearch demasiado alto (más del 50% de la RAM) o demasiado bajo. A menudo, los principiantes lo configuran al máximo o lo olvidan por completo.

Consecuencias:

- Si es más del 50% de la RAM: El sistema operativo se verá obligado a usar swap, lo que ralentizará catastróficamente Elasticsearch y provocará "thrashing" (intercambio constante de datos entre la RAM y el disco).

- Si es demasiado bajo: Elasticsearch no podrá usar eficazmente las cachés de Lucene, lo que ralentizará la búsqueda y la indexación.

- Diferentes

-Xmsy-Xmx: Conducirá a recolecciones de basura (Garbage Collection) frecuentes y prolongadas.

Cómo evitarlo:

- Regla del 50%: Asigne exactamente el 50% de la RAM física disponible al Heap de JVM, pero nunca exceda los 30.5 GB (debido a los punteros de objetos ordinarios comprimidos).

- Valores iguales: Siempre establezca

-Xmsy-Xmxen el mismo valor. - Desactive swap: Asegúrese de que swap esté completamente desactivado en el VPS donde se ejecuta Elasticsearch.

- Monitoreo de GC: Use Kibana Stack Monitoring para rastrear el tiempo y la frecuencia de la recolección de basura.

3. Falta de seguridad (puertos abiertos, contraseñas débiles)

Error: Dejar los puertos de Elasticsearch (9200) y Kibana (5601) abiertos al mundo sin autenticación y SSL/TLS. Uso de contraseñas predeterminadas o débiles.

Consecuencias:

- Fuga de datos: Los registros pueden contener información sensible que estará disponible para los atacantes.

- Acceso no autorizado: Los atacantes pueden modificar o eliminar sus datos.

- Ataques DDoS: Los puertos abiertos pueden ser un objetivo para ataques.

- Compromiso del sistema: A través de vulnerabilidades en ELK, pueden obtener acceso a todo el sistema.

Cómo evitarlo:

- Use SSL/TLS: Cifre todo el tráfico entre los componentes de ELK y entre los clientes y Kibana/Elasticsearch. Use Let's Encrypt para certificados gratuitos.

- Habilite X-Pack Security: En Elasticsearch 8.x está habilitado por defecto. Use contraseñas fuertes y generadas aleatoriamente para todos los usuarios.

- Firewall: Restrinja el acceso a los puertos de ELK solo desde direcciones IP de confianza o use VPN/túneles SSH.

- Nginx/Caddy como proxy: Use un proxy inverso para Kibana para la gestión centralizada de SSL y, si es necesario, para agregar autenticación HTTP básica.

4. Ignorar la gestión del ciclo de vida de los índices (ILM)

Error: Permitir que Elasticsearch almacene todos los registros indefinidamente, sin configurar políticas para eliminar datos antiguos.

Consecuencias:

- Desbordamiento rápido del disco: Los registros se generan constantemente, y sin ILM, el disco se llenará rápidamente.

- Degradación del rendimiento: Cuantos más datos haya en los índices, más lenta será la búsqueda y la indexación.

- Costos imprevistos: Necesidad de aumentar constantemente el volumen del disco en el VPS.

- Gestión manual: Necesidad de eliminar manualmente los índices antiguos, lo que consume tiempo y es propenso a errores.

Cómo evitarlo:

- Configure ILM desde el principio: Defina una política de retención de registros (por ejemplo, 7 días "calientes", 30 días "tibios", 90 días "fríos", luego eliminación) y cree las políticas correspondientes en Kibana.

- Use Data Streams: Es la forma recomendada para el registro en Elasticsearch 7.x/8.x+, que simplifica la gestión de índices con ILM.

- Monitoreo del disco: Verifique regularmente el espacio libre en disco. Configure alertas al alcanzar umbrales (por ejemplo, 80% de ocupación).

5. Uso excesivo de Logstash para tareas simples

Error: Usar Logstash para todas las tareas de recopilación y reenvío de registros, incluso si se requiere un procesamiento mínimo.

Consecuencias:

- Consumo excesivo de recursos: Logstash es una aplicación JVM que consume significativamente más RAM y CPU que los Beats ligeros.

- Complicación de la arquitectura: Añadir un eslabón adicional en el pipeline de procesamiento de datos aumenta los posibles puntos de fallo.

- Retrasos: Logstash puede introducir retrasos adicionales en el pipeline si está sobrecargado o sus filtros no están optimizados.

Cómo evitarlo:

- Prefiera Beats: Use Filebeat o Metricbeat para recopilar registros y métricas directamente de las fuentes y enviarlos a Elasticsearch. Son mucho más ligeros y eficientes.

- Use Logstash solo para transformaciones complejas: Si necesita un parseo Grok complejo, enriquecimiento de datos de fuentes externas o agregación de muchos sistemas diferentes, entonces Logstash está justificado.

- Optimice la configuración de Logstash: Si Logstash es necesario, optimice sus filtros (por ejemplo, haga que los patrones Grok sean lo más precisos posible), configure

pipeline.workersypipeline.batch.size.

Al evitar estos errores comunes, aumentará significativamente la estabilidad, el rendimiento y la seguridad de su sistema de registro centralizado en ELK Stack, incluso en condiciones de recursos limitados de un VPS.

Lista de verificación para la aplicación práctica de ELK en un VPS

Esta lista de verificación le ayudará a sistematizar el proceso de despliegue y optimización de ELK Stack en un VPS, garantizando un funcionamiento estable y eficiente de su sistema de registro centralizado.

Fase 1: Planificación y Preparación

- Defina los requisitos de recursos:

- Estime el volumen aproximado de registros (eventos por segundo, volumen en GB/día).

- Determine el tiempo de retención de registros requerido.

- Calcule la RAM, CPU y disco necesarios para el VPS.

- Elija un proveedor de VPS:

- Asegúrese de la disponibilidad de NVMe SSD y suficiente RAM/CPU.

- Verifique las tarifas y las capacidades de escalado.

- Elija la versión de ELK Stack:

- Se recomienda la última versión estable (por ejemplo, 8.x o posterior en 2026).

- Verifique la compatibilidad con su sistema operativo y Java.

- Prepare el dominio y los certificados SSL:

- Registre un nombre de dominio para Kibana (por ejemplo,

logs.yourdomain.com). - Obtenga un certificado SSL (por ejemplo, usando Let's Encrypt).

- Registre un nombre de dominio para Kibana (por ejemplo,

Fase 2: Configuración del VPS

- Instale el sistema operativo:

- Se recomienda Ubuntu Server LTS (22.04 o 24.04).

- Actualice todos los paquetes (

sudo apt update && sudo apt upgrade -y).

- Configure los parámetros del sistema:

- Instale OpenJDK (versión 17+).

- Aumente

vm.max_map_counta 262144 (/etc/sysctl.conf). - Desactive swap (

sudo swapoff -a, comente en/etc/fstab). - Configure los límites

nofileymemlockpara el usuarioelasticsearch(/etc/security/limits.conf).

- Configure el firewall (UFW):

- Permita SSH (22/tcp).

- Permita los puertos de Kibana (5601/tcp), Elasticsearch (9200/tcp), Beats/Logstash (5044/tcp) solo desde direcciones IP de confianza.

Fase 3: Instalación y Configuración de ELK Stack

- Instale Elasticsearch:

- Añada el repositorio de Elastic.

- Instale el paquete

elasticsearch.

- Configure Elasticsearch:

- Edite

/etc/elasticsearch/elasticsearch.yml(network.host,discovery.type: single-node). - Optimice el Heap de JVM: Establezca

-Xmsy-Xmx(50% RAM, no más de 30.5 GB) en/etc/elasticsearch/jvm.options. - Inicie Elasticsearch, guarde las contraseñas y tokens generados.

- Genere contraseñas para los usuarios del sistema (

kibana_system,logstash_system,filebeat_writer).

- Edite

- Instale Kibana:

- Instale el paquete

kibana.

- Instale el paquete

- Configure Kibana:

- Edite

/etc/kibana/kibana.yml(server.host,elasticsearch.hosts,elasticsearch.username/password). - Inicie Kibana, complete el proceso de registro con Elasticsearch.

- Edite

- Configure Nginx/Caddy como proxy inverso para Kibana (recomendado):

- Instale Nginx/Caddy.

- Configure SSL/TLS para su dominio usando Let's Encrypt.

- Configure el proxy de las solicitudes del puerto 80/443 al puerto 5601 de Kibana.

- Instale Logstash (opcional, si se necesita procesamiento complejo):

- Instale el paquete

logstash. - Optimice el Heap de JVM: Establezca

-Xmsy-Xmx(1-2 GB) en/etc/logstash/jvm.options. - Cree un archivo de configuración (

/etc/logstash/conf.d/*.conf) con inputs, filters, outputs. - Configure SSL/TLS y autenticación para Logstash.

- Inicie Logstash.

- Instale el paquete

Fase 4: Recopilación y Gestión de Registros

- Instale Filebeat (en los servidores de origen):

- Instale el paquete

filebeaten cada servidor desde donde se recopilan los registros.

- Instale el paquete

- Configure Filebeat:

- Edite

/etc/filebeat/filebeat.yml(filebeat.inputs,output.elasticsearchooutput.logstash). - Especifique las credenciales para acceder a Elasticsearch/Logstash.

- Configure SSL/TLS para Filebeat.

- Inicie Filebeat.

- Edite

- Configure Index Lifecycle Management (ILM) en Kibana:

- Cree políticas de ILM para la gestión automática de índices (fases caliente/tibia/fría/eliminación).

- Asegúrese de que Filebeat/Logstash utilicen Data Streams vinculados a estas políticas.

- Importe paneles y visualizaciones:

- Utilice los paneles predefinidos de Elastic (a través de

filebeat setupo la interfaz de usuario de Kibana). - Cree sus propios paneles para monitorear sus aplicaciones.

- Utilice los paneles predefinidos de Elastic (a través de

Fase 5: Monitoreo y Mantenimiento

- Habilite Stack Monitoring en Kibana:

- Monitoree regularmente el estado de Elasticsearch, Kibana, Logstash y Beats.

- Configure alertas:

- Cree alertas en Kibana (Stack Monitoring Alerts) sobre eventos críticos (disco lleno, alta carga de CPU, errores de JVM).

- Actualice regularmente ELK Stack:

- Esté atento a las nuevas versiones y parches de seguridad.

- Programe las actualizaciones en horas de menor actividad.

- Cree una estrategia de copia de seguridad:

- Configure la creación regular de instantáneas de Elasticsearch en almacenamiento en la nube (compatible con S3).

Siguiendo esta lista de verificación, podrá construir un sistema de registro centralizado fiable y optimizado basado en ELK Stack, incluso utilizando recursos limitados de un VPS.

Cálculo de costos / Economía de ELK en VPS (Actualizado a 2026)

Uno de los factores clave al elegir y desplegar ELK Stack en un VPS es el costo. En 2026, los precios de los VPS siguen siendo competitivos, pero el ELK de código abierto "gratuito" aún requiere una inversión significativa en infraestructura y tiempo de los ingenieros. Comprender el panorama completo de los costos, incluidos los gastos ocultos, es fundamental para los fundadores de proyectos SaaS y los CTO.

Componentes principales del costo

- Costo de la infraestructura VPS:

- RAM: El recurso más caro para Elasticsearch. Cuanta más RAM, más rápido funciona.

- CPU: Importante para la indexación y el procesamiento de consultas.

- NVMe SSD: Absolutamente necesario para el rendimiento de E/S.

- Tráfico: Puede ser significativo si tiene muchas fuentes de registros o usuarios activos de Kibana.

- Tiempo de los ingenieros (el mayor costo oculto):

- Despliegue y configuración inicial.

- Optimización del rendimiento y resolución de problemas.

- Mantenimiento, actualización y monitoreo regulares.

- Configuración de ILM, paneles, alertas.

- Copia de seguridad y almacenamiento de instantáneas:

- Costo del almacenamiento en la nube (compatible con S3) para las instantáneas de Elasticsearch.

- Herramientas y servicios adicionales:

- Servicios DNS, certificados SSL (aunque Let's Encrypt es gratuito).

- Sistemas de alerta (por ejemplo, PagerDuty, si no se utilizan alternativas gratuitas).

Ejemplos de cálculos para diferentes escenarios (año 2026, precios aproximados)

Supongamos que el salario promedio de un ingeniero DevOps en la CEI es de $3000-5000/mes (~$20-30/hora).

Escenario 1: Pequeña startup, 100-500 eventos/seg, almacenamiento de 30 días.

- Configuración del VPS: 1x VPS (16 GB RAM, 4 vCPU, 320 GB NVMe SSD, 1 TB de tráfico)

- Proveedor: Hetzner Cloud, Vultr, DigitalOcean.

- Costo mensual del VPS: ~$40-60

- Gastos adicionales:

- Almacenamiento de instantáneas (compatible con S3): ~$5-10/mes (por 100-200 GB).

- DNS: ~$0-5/mes.

- Tiempo del ingeniero:

- Configuración: 10-20 horas (inicialmente) = ~$200-600.

- Mantenimiento: 2-4 horas/mes = ~$40-120/mes.

Costo mensual total: ~$85-195 (después de la configuración inicial).

Escenario 2: Proyecto SaaS de tamaño medio, 1000-3000 eventos/seg, almacenamiento de 60 días.

- Configuración del VPS: 1x VPS (32 GB RAM, 8 vCPU, 640 GB NVMe SSD, 2 TB de tráfico) O 2x VPS (16 GB RAM, 4 vCPU, 320 GB NVMe SSD) para separar ES/Logstash.

- Proveedor: Hetzner Cloud, Vultr, DigitalOcean.

- Costo mensual del VPS: ~$80-150 (por 1-2 VPS).

- Gastos adicionales:

- Almacenamiento de instantáneas: ~$10-25/mes (por 300-500 GB).

- DNS: ~$0-5/mes.

- Tiempo del ingeniero:

- Configuración: 20-40 horas (inicialmente) = ~$400-1200.

- Mantenimiento: 4-8 horas/mes = ~$80-240/mes.

Costo mensual total: ~$170-420 (después de la configuración inicial).

Tabla con ejemplos de cálculos para diferentes escenarios (2026)

| Parámetro | Proyecto pequeño (500 EPS, 30 días) | Proyecto mediano (3000 EPS, 60 días) | Proyecto grande (10000 EPS, 90 días) |

|---|---|---|---|

| Configuración VPS (RAM/CPU/SSD) | 16GB/4vCPU/320GB NVMe | 32GB/8vCPU/640GB NVMe | 2x (32GB/8vCPU/640GB NVMe) |

| Costo VPS (mes) | $40-60 | $80-150 | $160-300 |

| Costo almacenamiento S3 (mes) | $5-10 | $10-25 | $20-50 |

| Configuración inicial (horas ing. * $30) | 15 h = $450 | 30 h = $900 | 60 h = $1800 |

| Mantenimiento mensual (horas ing. * $30) | 3 h = $90 | 6 h = $180 | 12 h = $360 |

| TOTAL (primer mes) | $495-520 + $450 = $945-970 | $100-175 + $900 = $1000-1075 | $180-350 + $1800 = $1980-2150 |

| TOTAL (meses siguientes) | $45-70 + $90 = $135-160 | $90-175 + $180 = $270-355 | $180-350 + $360 = $540-710 |

Costos ocultos

- Exceso de tráfico: Si los registros se recopilan de diferentes centros de datos o hay muchos usuarios de Kibana, el tráfico puede convertirse en un gasto significativo.

- Tiempo de inactividad (Downtime): Un sistema de registro inestable significa que se pierden datos valiosos y tiempo en su recuperación.

- Escalado: La transición a un VPS más potente o la adición de nuevos nodos no siempre es fluida y requiere planificación.

- Capacitación: El tiempo necesario para que el equipo domine ELK, sus características y optimización.

Cómo optimizar los costos

- Optimización de recursos de ELK:

- JVM Heap: Configuración precisa de

-Xms/-Xmxpara Elasticsearch y Logstash. - ILM: Establezca políticas ILM agresivas para la eliminación automática de registros antiguos, minimizando los requisitos de espacio en disco.

- Beats en lugar de Logstash: Utilice Beats ligeros para la recopilación directa de registros y el envío a Elasticsearch, evitando Logstash si no hay un procesamiento complejo.

- Optimización de consultas: Capacite al equipo para escribir consultas eficientes en Kibana, para no sobrecargar Elasticsearch.

- JVM Heap: Configuración precisa de

- Uso eficiente del VPS:

- Elija un VPS con NVMe SSD, ya que esto mejora significativamente el rendimiento y permite usar menos RAM para Elasticsearch (gracias a una E/S más rápida).

- Considere usar un solo VPS para todos los componentes de ELK para proyectos pequeños y medianos, para evitar costos adicionales de VPS separados.

- Use Nginx/Caddy para el almacenamiento en caché de archivos estáticos de Kibana, reduciendo la carga sobre el propio Kibana.

- Monitoreo y automatización:

- Utilice activamente Stack Monitoring en Kibana para identificar cuellos de botella y prevenir problemas.

- Automatice tareas rutinarias (actualizaciones, copias de seguridad) con scripts o herramientas IaC.

- Alternativas:

- Para presupuestos muy limitados o si solo se necesita una visualización básica de registros, considere Loki + Grafana. Esta solución es significativamente menos exigente en recursos en un VPS.

- Para volúmenes muy grandes de registros y si ya está en la nube, considere servicios gestionados (Elastic Cloud, AWS OpenSearch Service), pero prepárese para costos más altos.

La economía de ELK en un VPS es un proceso de optimización constante. El análisis regular del consumo de recursos y el ajuste de la configuración le ayudarán a controlar los gastos y a obtener el máximo rendimiento de su sistema de registro.

Casos y ejemplos de uso de ELK Stack

Para comprender mejor el valor práctico de ELK Stack en un VPS, examinemos algunos escenarios realistas del mundo de DevOps y las startups, que demuestran cómo el registro centralizado ayuda a resolver tareas específicas.

Caso 1: Monitoreo y depuración de una aplicación de microservicios en Docker Swarm

Descripción del problema: Una pequeña startup SaaS desarrolló una aplicación que consta de 5-7 microservicios, desplegados en Docker Swarm en tres VPS. Cada microservicio genera registros en formato JSON. Cuando ocurren errores, los usuarios se quejan de un rendimiento lento, pero es muy difícil determinar qué microservicio es la causa. Los registros están dispersos en diferentes contenedores en diferentes hosts, y la revisión manual lleva horas.

Solución con ELK Stack en VPS: El equipo desplegó un VPS potente (16GB RAM, 4vCPU, 320GB NVMe) para ELK Stack.

- Filebeat: En cada uno de los tres VPS con Docker Swarm se instaló Filebeat. Se configuró para recopilar registros de todos los contenedores Docker (utilizando

filebeat.autodiscover.providerscon el procesador Docker) y enviarlos directamente a Elasticsearch en el VPS central. Filebeat añadió automáticamente metadatos de los contenedores (nombre del servicio, ID del contenedor). - Elasticsearch: En el VPS central se configuró Elasticsearch con un Heap de JVM optimizado (8GB) y una política ILM para almacenar registros durante 30 días.

- Kibana: Se utilizó para crear paneles.

Soluciones y resultados concretos:

- Detección de errores: Se creó un panel en Kibana que agregaba los registros por microservicio, mostrando el número de errores (

level: error) para cada uno de ellos. Al aumentar el número de errores en un servicio específico, el equipo veía instantáneamente la fuente del problema. - Trazado de solicitudes: Los desarrolladores añadieron un

request_idúnico a los registros de cada solicitud que pasaba por los microservicios. En Kibana, fue posible buscar por esterequest_idy ver la ruta completa de la solicitud a través de todos los servicios, identificando rápidamente el punto de fallo. - Aceleración de la depuración: El tiempo para detectar y aislar problemas se redujo de varias horas a 5-15 minutos.

- Optimización del rendimiento: El análisis de los registros mostró que uno de los microservicios generaba demasiados mensajes WARN, lo que indicaba consultas ineficientes a la base de datos. La optimización de este servicio mejoró significativamente el rendimiento general de la aplicación.

- Ahorro: El costo total de un VPS ELK (~$50/mes) resultó ser significativamente menor que el tiempo perdido de los ingenieros y la insatisfacción de los clientes.

Caso 2: Análisis de seguridad y detección de anomalías para una API Backend

Descripción del problema: Un equipo de backend que desarrolla una API en Node.js se enfrentó a actividades sospechosas: picos periódicos de solicitudes desde direcciones IP inusuales, intentos de fuerza bruta de autenticación. El sistema de registro existente (simple guardado en archivos) no permitía identificar y reaccionar rápidamente a estas amenazas.

Solución con ELK Stack en VPS: El equipo desplegó ELK en un VPS (32GB RAM, 8vCPU, 640GB NVMe) para una mayor carga y almacenamiento a largo plazo.

- Filebeat: En el servidor con la API de Node.js se instaló Filebeat para recopilar registros de Nginx (access.log, error.log) y registros de la propia aplicación Node.js (en formato JSON).

- Logstash: Se utilizó para enriquecer los registros de Nginx. Logstash, con la ayuda de filtros Grok, parseó las líneas de los registros, extrajo direcciones IP, User-Agent, códigos de estado. Luego, utilizando el filtro GeoIP, añadió información sobre la ubicación geográfica de las direcciones IP.

- Elasticsearch: Almacenó los registros enriquecidos.

- Kibana: Se utilizó para la visualización y configuración de alertas.

Soluciones y resultados concretos:

- Detección de fuerza bruta: Se creó un panel que mostraba el número de intentos de inicio de sesión fallidos (

status_code: 401) por dirección IP. Se configuró una alerta en Kibana (Stack Monitoring -> Alerts) que enviaba una notificación a Slack si desde una dirección IP había más de 10 intentos de inicio de sesión fallidos en 5 minutos. - Análisis geográfico: Con la ayuda de datos GeoIP, se construyó un mapa en Kibana que mostraba las fuentes de las solicitudes. Esto ayudó a identificar picos anómalos de tráfico de ciertos países que no son el público objetivo.

- Análisis de User-Agent: Un panel de User-Agent ayudó a identificar bots y escáneres de seguridad.

- Mejora de la seguridad: Basándose en las anomalías detectadas, el equipo pudo bloquear rápidamente direcciones IP sospechosas a nivel de firewall o Cloudflare, mejorando significativamente la seguridad de la API.

- Prueba de cumplimiento: Capacidad de encontrar y proporcionar rápidamente registros a solicitud de reguladores o para auditorías internas.

Caso 3: Monitoreo del rendimiento y errores en una aplicación PHP monolítica

Descripción del problema: El fundador de un proyecto SaaS, que opera con una antigua aplicación PHP monolítica, se enfrenta a problemas de rendimiento "flotantes" y errores periódicos que son difíciles de reproducir. La aplicación se ejecuta en un solo VPS, y los registros de PHP y Apache se escriben en archivos.

Solución con ELK Stack en VPS: Se desplegó ELK en el mismo VPS donde se ejecuta la aplicación PHP (16GB RAM, 4vCPU, 320GB NVMe), para evitar retrasos de red y costos adicionales.

- Filebeat: Se configuró para recopilar registros de Apache (access_log, error_log) y registros de PHP-FPM, así como registros del sistema.

- Logstash: Se utilizó para parsear los registros de PHP (que a menudo son multilínea y no estructurados) y normalizarlos a JSON. Logstash también enriqueció los registros con información sobre el tiempo de ejecución de la solicitud.

- Elasticsearch: Almacenó todos los registros procesados.

- Kibana: Se utilizó para crear paneles y alertas.

Soluciones y resultados concretos:

- Detección de solicitudes lentas: En los registros de PHP se registraba el tiempo de ejecución de la solicitud. Logstash extraía este valor. En Kibana se creó un panel que mostraba las N solicitudes más lentas a la aplicación. Esto ayudó a identificar cuellos de botella en el código y en las consultas a la base de datos.

- Monitoreo de errores: Se creó un panel que agregaba los errores de PHP por tipo y archivo. Se visualizaban instantáneamente los errores nuevos o recurrentes. Se configuró una alerta en Telegram al aparecer errores críticos.

- Análisis de tráfico: Los paneles de Apache access_log permitían rastrear picos de tráfico, las páginas más populares y las fuentes de las solicitudes, ayudando a planificar el escalado o la optimización.

- Resolución proactiva de problemas: Ahora el equipo podía reaccionar a los problemas antes de que afectaran a un gran número de usuarios, basándose en datos, no en quejas.

- Mejora de la calidad del código: Los desarrolladores obtuvieron métricas y registros claros para probar y optimizar su código.

Estos casos demuestran que ELK Stack en un VPS, con la configuración y optimización adecuadas, es una herramienta potente y accesible para resolver una amplia gama de tareas en el monitoreo, depuración y seguridad para diferentes tipos de proyectos.

Herramientas y recursos para trabajar con ELK

El trabajo eficiente con ELK Stack requiere no solo la comprensión de sus componentes, sino también el uso de herramientas auxiliares y la consulta constante de recursos actualizados. En 2026, el ecosistema alrededor de Elastic continúa desarrollándose activamente, ofreciendo una multitud de utilidades y fuentes de conocimiento.

1. Utilidades para el trabajo y diagnóstico

curl/wget: Utilidades básicas para interactuar con la API RESTful de Elasticsearch. Indispensables para verificar el estado del clúster, enviar consultas simples o verificar la seguridad.curl -u elastic:YOUR_PASSWORD -k "https://localhost:9200/_cat/health?v" curl -u elastic:YOUR_PASSWORD -k -XGET "https://localhost:9200/_cluster/stats?pretty"- Kibana Dev Tools: Interfaz integrada en Kibana para enviar consultas a Elasticsearch. Permite probar cómodamente consultas de búsqueda, gestionar índices, crear políticas ILM y verificar el estado del clúster. Es su herramienta principal para la administración a través de la interfaz de usuario.

htop/atop/glances: Herramientas para monitorear los recursos del sistema (CPU, RAM, E/S de disco, procesos) en el VPS. Ayudan a identificar cuellos de botella en el funcionamiento de ELK.sudo apt install htop glances -y htop glancesiostat/vmstat: Utilidades para el análisis detallado de la actividad del disco y el uso de la memoria. Críticamente importantes para diagnosticar problemas de E/S, que a menudo surgen con Elasticsearch.iostat -x 1 10 # 10 informes con un intervalo de 1 segundo vmstat 1 10 # 10 informes con un intervalo de 1 segundotcpdump/wireshark: Para el análisis del tráfico de red. Útil para depurar problemas de conexión entre componentes de ELK o entre Beats y Logstash/Elasticsearch.sudo tcpdump -i eth0 port 5044journalctl/tail: Para ver los registros del sistema y los registros de los componentes de ELK.sudo journalctl -u elasticsearch -f sudo tail -f /var/log/elasticsearch/elasticsearch.log- Elasticsearch Head (extensión/aplicación de navegador): Permite gestionar visualmente el clúster de Elasticsearch, ver shards, índices y realizar operaciones básicas. Aunque Kibana Dev Tools es más potente, Head puede ser útil para una visión general rápida.

jq: Utilidad para parsear JSON desde la línea de comandos. Muy útil al trabajar con respuestas JSON de la API de Elasticsearch.curl -u elastic:YOUR_PASSWORD -k "https://localhost:9200/_cluster/health?pretty" | jq .status

2. Monitoreo y pruebas

- Kibana Stack Monitoring: Herramienta integrada para monitorear el estado de toda la pila ELK. Muestra métricas de CPU, RAM, E/S, Heap de JVM, número de solicitudes, estado de los shards y mucho más. Muy recomendable para el seguimiento constante del rendimiento y la salud.

- Metricbeat: Instálelo en el VPS de ELK para recopilar métricas del sistema y métricas del propio ELK Stack y enviarlas a Elasticsearch. Esto le permitirá crear sus propios paneles de monitoreo si el Stack Monitoring integrado no es suficiente.

- Prometheus + Grafana: Si ya tiene una infraestructura de monitoreo con Prometheus, puede usar los Exporter's para Elasticsearch y Logstash para recopilar sus métricas y visualizarlas en Grafana.

- Apache JMeter / k6: Para pruebas de carga de ELK Stack. Permite simular un gran flujo de registros o consultas de búsqueda intensivas para verificar el rendimiento y la estabilidad de su configuración.

3. Enlaces útiles y documentación (año 2026)

- Documentación oficial de Elastic: elastic.co/guide/en/elastic-stack/current/index.html

- Siempre consulte la documentación oficial para su versión de ELK. Es la más completa y actualizada.

- Blog de Elastic: elastic.co/blog

- Contiene muchos artículos sobre nuevas funciones, mejores prácticas, optimización y casos de uso reales.

- Foros de la Comunidad Elastic: discuss.elastic.co/

- Una comunidad activa donde puede hacer preguntas, encontrar soluciones a problemas comunes e intercambiar experiencias.

- Canales de YouTube y plataformas de aprendizaje:

- Canal oficial de Elastic en YouTube.

- Udemy, Coursera, Pluralsight: Cursos sobre ELK Stack, a menudo actualizados para nuevas versiones.

- Awesome Elasticsearch: github.com/dzharii/awesome-elasticsearch

- Una lista curada de recursos útiles, herramientas, plugins y artículos sobre Elasticsearch.

- Artículos y guías de la comunidad:

- DigitalOcean Community Tutorials, Logz.io Blog, artículos de Medium de ingenieros de DevOps. Busque materiales recientes con fecha de publicación 2024-2026.

El uso de estas herramientas y recursos simplificará significativamente el proceso de despliegue, configuración, monitoreo y resolución de problemas con ELK Stack en su VPS, permitiéndole mantenerse al tanto de las últimas tendencias y mejores prácticas.

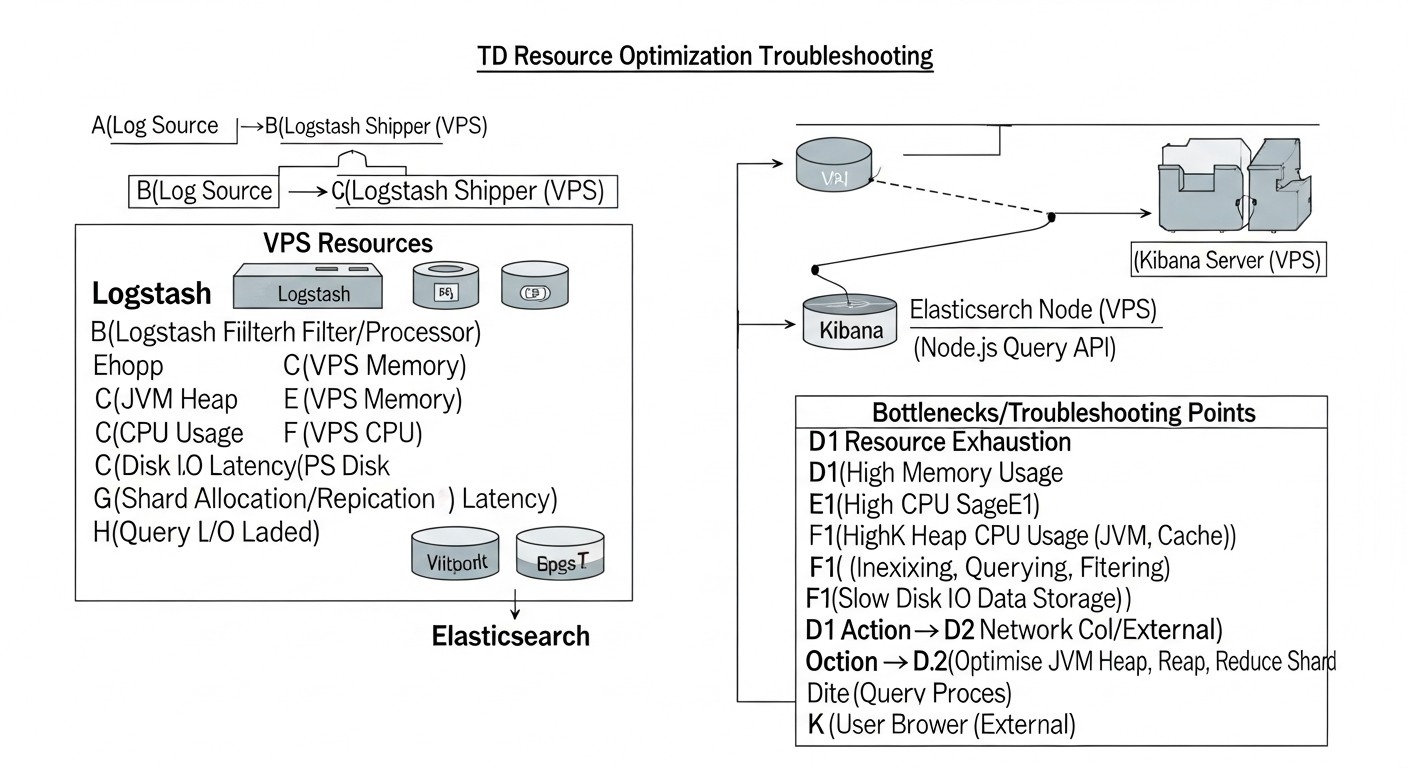

Troubleshooting: resolución de problemas con ELK

Incluso con la configuración más cuidadosa, los problemas con ELK Stack en un VPS son inevitables. Pueden variar desde la falta de recursos hasta errores de configuración y problemas de red. La capacidad de diagnosticarlos y resolverlos rápidamente es una habilidad clave para cualquiera que trabaje con ELK. Aquí se presentan problemas típicos y sus soluciones.

1. Elasticsearch no se inicia o funciona de forma inestable

Problemas típicos:

- OutOfMemoryError (OOM): Memoria insuficiente para la JVM.

- Disk Full / Low Disk Space: Disco lleno o casi lleno.

vm.max_map_countdemasiado bajo: Elasticsearch no puede asignar los recursos del sistema necesarios.- Problemas con los descriptores de archivo: Límite

nofiledemasiado bajo. - Error de configuración en

elasticsearch.yml: Errores de sintaxis o parámetros incorrectos. discovery.typeno configurado para single-node: Elasticsearch intenta encontrar otros nodos del clúster y no puede iniciarse.

Comandos de diagnóstico:

sudo systemctl status elasticsearch.service # Comprobar el estado del servicio

sudo journalctl -u elasticsearch.service -f # Ver los logs del servicio en tiempo real

sudo tail -f /var/log/elasticsearch/elasticsearch.log # Log principal de Elasticsearch

df -h # Comprobar el espacio libre en disco

free -h # Comprobar el uso de RAM

sysctl vm.max_map_count # Comprobar el valor de vm.max_map_count

ulimit -n # Comprobar el límite de descriptores de archivo para el usuario actual

Soluciones:

- OOM: Reduzca

-Xms/-Xmxenjvm.optionsal 50% de la RAM, pero no más de 30.5 GB. Desactive swap. - Disk Full: Elimine índices antiguos (manualmente o mediante ILM). Aumente el volumen del disco.

vm.max_map_count: Establezcavm.max_map_count=262144en/etc/sysctl.confy apliquesudo sysctl -p.nofile: Aumentenofilea 65536 para el usuarioelasticsearchen/etc/security/limits.conf.- Configuración: Revise cuidadosamente

elasticsearch.ymlen busca de errores tipográficos. Usediscovery.type: single-nodepara un solo VPS.

2. Kibana no se conecta a Elasticsearch

Problemas típicos:

- Elasticsearch no disponible: Elasticsearch no está iniciado, o su puerto está cerrado por el firewall.

elasticsearch.hostsincorrecto: Dirección o puerto de Elasticsearch incorrectamente especificado enkibana.yml.- Problemas con SSL/TLS: Certificados incorrectos, CA, o falta de coincidencia de protocolos (HTTP/HTTPS).

- Error de autenticación: Nombre de usuario/contraseña incorrectos para el usuario

kibana_system. - Problemas con el token de registro: Si Kibana solicita un token y usted no lo ha proporcionado.

Comandos de diagnóstico:

sudo systemctl status kibana.service

sudo journalctl -u kibana.service -f

curl -u elastic:YOUR_PASSWORD -k "https://localhost:9200" # Comprobar la disponibilidad de ES

Soluciones:

- Disponibilidad de ES: Asegúrese de que Elasticsearch esté iniciado y el puerto 9200 esté abierto para Kibana (

network.hostenelasticsearch.yml). elasticsearch.hosts: Verifique que la dirección y el puerto enkibana.ymlsean correctos y coincidan con el protocolo (https://localhost:9200).- SSL/TLS: Asegúrese de que los certificados sean correctos y que Kibana confíe en la CA de Elasticsearch. Para una prueba rápida, puede deshabilitar temporalmente

ssl.verification_mode: none(no recomendado para producción). - Autenticación: Verifique que

elasticsearch.usernameyelasticsearch.passwordenkibana.ymlsean correctos. Genere una nueva contraseña parakibana_systemsi tiene dudas. - Token de registro: Si Kibana requiere un token, genérelo en Elasticsearch (

elasticsearch-create-enrollment-token -s kibana) e introdúzcalo en la interfaz de usuario.

3. Los registros no llegan a Elasticsearch / Kibana

Problemas típicos:

- Filebeat/Logstash no iniciado: El servicio no está activo.

- Error de configuración de Filebeat/Logstash: Rutas de registros incorrectas, salida incorrecta, errores de sintaxis.

- Problemas de red: El firewall bloquea el puerto 5044 (para Beats/Logstash) o 9200 (para conexión directa a ES).

- Problemas con SSL/TLS: Certificados incorrectos, CA, o falta de coincidencia de protocolos entre Beats/Logstash y ES.

- Error de autenticación: Nombre de usuario/contraseña incorrectos para el usuario de Filebeat/Logstash.

- Falta de plantillas de índice/data streams: Elasticsearch no sabe cómo procesar los datos entrantes.

Comandos de diagnóstico:

sudo systemctl status filebeat.service # O logstash.service