Optimización de Nginx para aplicaciones web de alta carga en VPS: caché, seguridad, rendimiento

TL;DR

- Utilice Nginx como proxy inverso para el almacenamiento en caché de contenido estático (Proxy Cache) y dinámico (FastCGI/Microcaching) para reducir significativamente la carga en el backend y acelerar la respuesta.

- Implemente TLS 1.3 con cifrados modernos, HSTS y OCSP Stapling para una máxima seguridad y rendimiento de cifrado.

- Configure la limitación de tasa (rate limiting) y la protección DDoS a nivel de Nginx, utilizando los módulos

limit_reqylimit_connpara evitar la sobrecarga del servidor. - Optimice los parámetros de Nginx (

worker_processes,worker_connections, búferes) y del sistema operativo (pila TCP, límites de descriptores de archivo) para un uso eficiente de los recursos del VPS. - La transición a HTTP/2 (y en perspectiva HTTP/3) es crítica para las aplicaciones web modernas, proporcionando multiplexación y reducción de latencia.

- Monitoree Nginx regularmente (NGINX Amplify, Prometheus/Grafana) y registre solo lo necesario para identificar y resolver cuellos de botella rápidamente.

- Las inversiones en la optimización profunda de Nginx en un VPS se amortizan con la reducción de los costos de infraestructura y la mejora de la experiencia del usuario.

Introducción

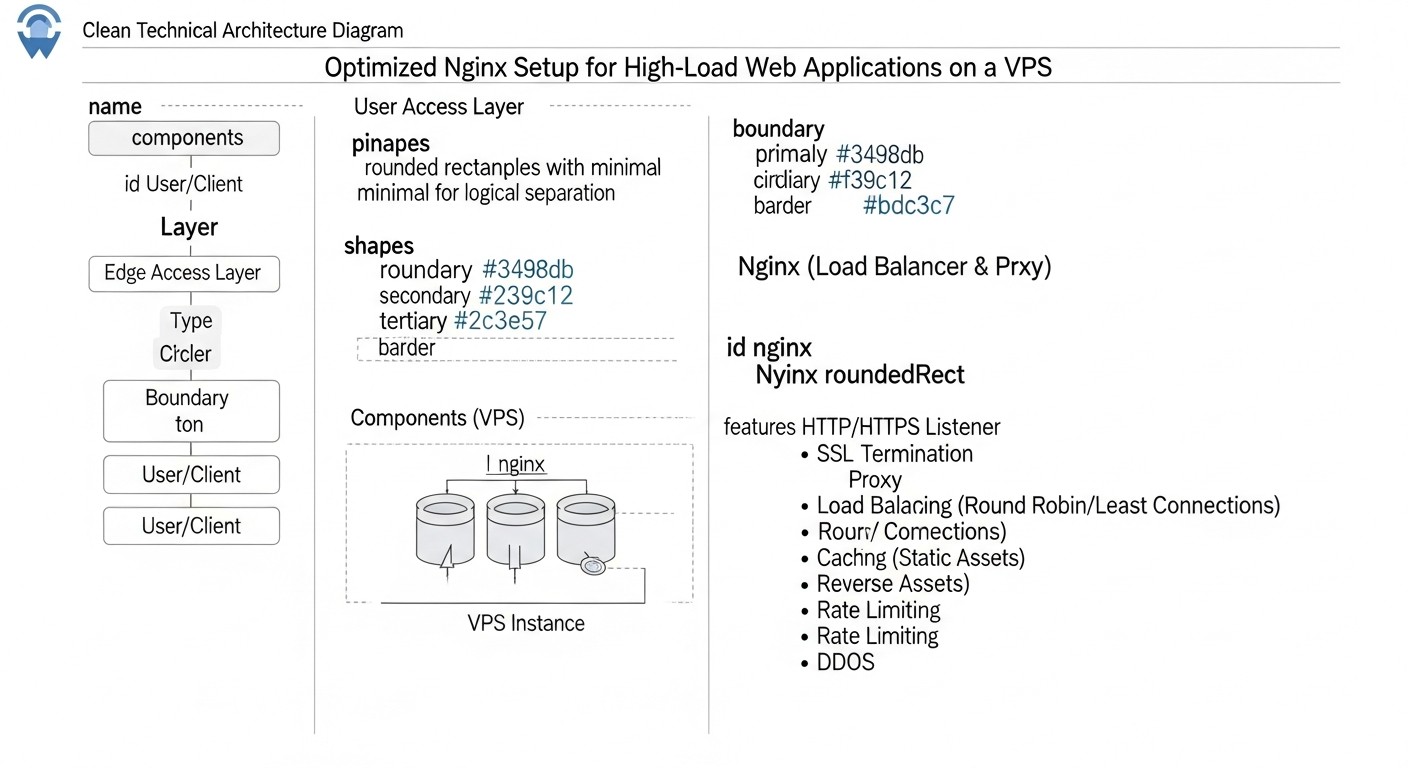

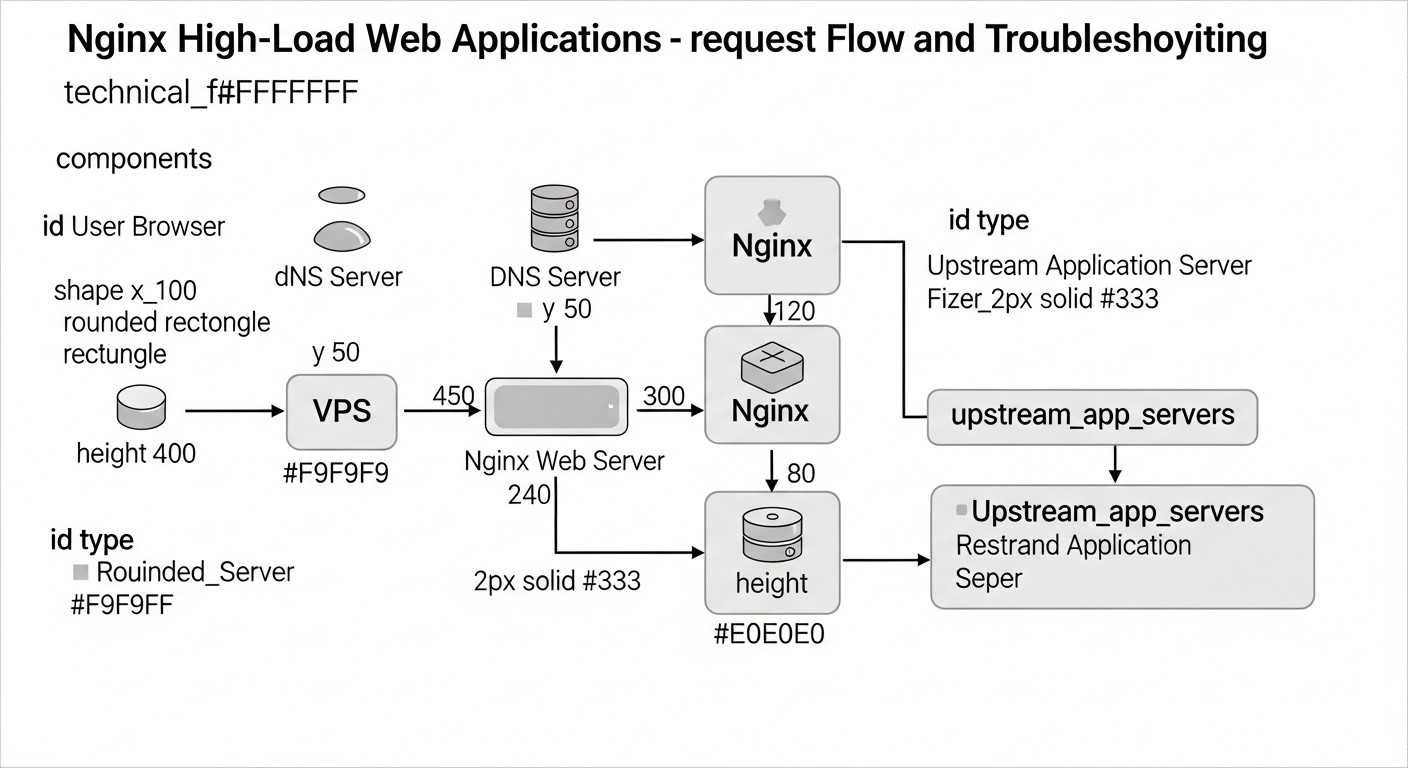

En el mundo de las tecnologías web en rápida evolución de 2026, donde las expectativas de los usuarios sobre la velocidad y la fiabilidad crecen constantemente, y la competencia por la atención del usuario se agudiza, el rendimiento de las aplicaciones web se convierte no solo en una ventaja, sino en un requisito crítico. Esto es especialmente relevante para proyectos desplegados en servidores privados virtuales (VPS), donde cada megabyte de RAM y cada ciclo de procesador cuentan. Nginx, gracias a su ligereza, alto rendimiento y flexibilidad, se ha establecido desde hace tiempo como el estándar de facto para servir tráfico web, ya sea contenido estático, proxy inverso o balanceador de carga.

Sin embargo, simplemente instalar Nginx no es suficiente. Para aplicaciones web de alta carga en un VPS, se requiere una optimización profunda y bien pensada. Sin ella, incluso un VPS potente puede colapsar bajo una avalancha de tráfico, y los recursos se utilizarán de manera ineficiente, lo que afectará directamente los costos y la experiencia del usuario. En condiciones de recursos limitados de un VPS, cada porcentaje de aumento de rendimiento y cada byte de ahorro de tráfico son importantes. Un Nginx no optimizado puede convertirse en un cuello de botella, bloqueando la escalabilidad de la aplicación, incluso si el backend es capaz de procesar miles de solicitudes por segundo.

Este artículo pretende ser una guía exhaustiva para la optimización de Nginx, cubriendo tres aspectos clave: almacenamiento en caché, seguridad y rendimiento. Analizaremos cómo configurar Nginx correctamente para que utilice los recursos disponibles del VPS de la manera más eficiente posible, proteja su aplicación de amenazas y proporcione una velocidad de respuesta ultrarrápida. El material está dirigido a ingenieros DevOps, desarrolladores backend (Python, Node.js, Go, PHP), fundadores de proyectos SaaS, administradores de sistemas y directores técnicos de startups que buscan exprimir al máximo su infraestructura y construir servicios web fiables y escalables. Nos sumergiremos en configuraciones específicas, consejos prácticos y casos reales, relevantes para 2026, para que pueda aplicar los conocimientos adquiridos de inmediato.

Criterios y factores clave de optimización de Nginx

Antes de sumergirnos en los detalles de la configuración, es importante comprender qué métricas y factores determinan la eficiencia de Nginx y de la aplicación web en general. La optimización no es solo un conjunto de configuraciones dispersas, sino un enfoque sistemático destinado a mejorar indicadores específicos.

Velocidad de respuesta (Latencia)

La velocidad de respuesta, o latencia, es el tiempo que transcurre desde que el usuario envía una solicitud hasta que recibe el primer byte de respuesta. Para las aplicaciones web modernas, este indicador es crítico. Los usuarios esperan una carga instantánea, e incluso pequeños retrasos pueden llevar al abandono del servicio. En un VPS, donde las latencias de red y las limitaciones de recursos pueden ser más pronunciadas, minimizar la latencia se convierte en una prioridad. Nginx influye en la latencia a través de un almacenamiento en caché eficiente, un establecimiento rápido de conexiones (Keepalive), el uso de HTTP/2 (y HTTP/3) y un procesamiento optimizado de las solicitudes. Se evalúa con herramientas como WebPageTest, Lighthouse o servicios de monitoreo de terceros.

Rendimiento (Throughput)

El rendimiento (throughput) caracteriza el volumen de datos o el número de solicitudes que un servidor puede procesar por unidad de tiempo. Para sistemas de alta carga, este es uno de los indicadores clave. Nginx, al ser un proxy inverso de alto rendimiento, es capaz de manejar una enorme cantidad de conexiones y solicitudes simultáneas. La optimización de Nginx tiene como objetivo aumentar el rendimiento mediante el uso eficiente de la CPU y la memoria, la minimización de bloqueos, la compresión de datos (gzip/Brotli) y una distribución inteligente de la carga. En un VPS con canales de red y recursos de procesador limitados, maximizar el rendimiento sin sobrecargar el sistema requiere una configuración fina. El monitoreo de RPS (Requests Per Second) y Mbps (Megabits per Second) a través de herramientas como Prometheus/Grafana o NGINX Amplify ayudará a evaluar este criterio.

Uso de recursos (Resource Utilization)

En un VPS, donde los recursos (CPU, RAM, entrada/salida de disco) son un bien limitado y a menudo se pagan por volumen, su uso eficiente es la clave de la viabilidad económica y la estabilidad. La optimización de Nginx permite reducir el consumo de CPU y RAM, especialmente a través de un almacenamiento en caché eficiente, que disminuye la carga en el backend. Un menor consumo de recursos significa la posibilidad de atender a más usuarios en el mismo VPS, posponer la necesidad de actualizar el plan o incluso cambiar a uno más económico. El monitoreo de la utilización de CPU, RAM, I/O y tráfico de red a través de htop, top, iostat, netdata o las métricas en la nube del proveedor de VPS es fundamental para evaluar este factor.

Resistencia a la carga y seguridad (Resilience & Security Posture)

Una aplicación de alta carga no solo debe funcionar rápidamente, sino también ser resistente a picos de carga, fallos y ataques. Nginx juega un papel clave en la garantía de la seguridad y la tolerancia a fallos. Mecanismos de limitación de tasa, protección DDoS, configuraciones estrictas de SSL/TLS, integración con WAF (Web Application Firewall), todo esto permite a Nginx actuar como la primera línea de defensa. En un VPS, donde no es posible desplegar soluciones de hardware complejas, Nginx se convierte en una herramienta críticamente importante para la protección. Se evalúa mediante pruebas de carga (k6, JMeter, Gatling), auditorías de seguridad (SSL Labs, Nessus) y análisis de registros en busca de anomalías e intentos de ataque.

Tabla comparativa: Estrategias de almacenamiento en caché en Nginx

El almacenamiento en caché es, quizás, la herramienta más potente para optimizar el rendimiento de las aplicaciones web, especialmente en un VPS. Un almacenamiento en caché correctamente configurado permite a Nginx responder a las solicitudes sin recurrir al backend, lo que reduce significativamente la carga en la aplicación y la base de datos, y también acorta el tiempo de respuesta. En 2026, existen varias estrategias de almacenamiento en caché, cada una con sus propias características.

| Criterio | Caché de estáticos (Navegador/Nginx) | Nginx Proxy Cache | Nginx FastCGI Cache | Microcaching (Nginx) | Edge Caching (CDN, para comparar) |

|---|---|---|---|---|---|

| Tipo de contenido | Estático (CSS, JS, imágenes, fuentes) | Cualquier contenido HTTP (HTML, JSON, respuestas de API) | Contenido dinámico PHP/Python/Ruby/Go | Contenido dinámico de corta duración | Estático y dinámico (globalmente) |

| Complejidad de configuración | Baja (expires, add_header Cache-Control) |

Media (proxy_cache_path, proxy_cache_key) |

Media (fastcgi_cache_path, fastcgi_cache_key) |

Media (proxy_cache_valid 1s, proxy_cache_bypass) |

Media/Alta (depende del CDN) |

| Eficacia en la reducción de la carga del backend | Alta (para estáticos) | Muy alta (para solicitudes repetidas) | Muy alta (para solicitudes repetidas) | Alta (mitiga picos) | Extremadamente alta (globalmente) |

| Impacto en la latencia | Significativo (para visitas repetidas) | Significativo (para respuestas en caché) | Significativo (para respuestas en caché) | Moderado (reduce el tiempo de generación) | Máximo (proximidad al usuario) |

| Requisitos de espacio en disco en el VPS | Mínimos (para Nginx) | Medios/Altos (depende del volumen de caché) | Medios/Altos (depende del volumen de caché) | Bajos/Medios (corta duración) | No aplicable a VPS |

| Actualidad de los datos | Alta (versionado de archivos) | Depende de proxy_cache_valid y proxy_cache_bypass |

Depende de fastcgi_cache_valid y fastcgi_cache_bypass |

Alta (se actualiza cada segundo) | Depende de la configuración del CDN y Cache-Control |

| Costo aproximado (2026, en VPS) | Gratis (incluido en Nginx) | Gratis (incluido en Nginx), requiere disco | Gratis (incluido en Nginx), requiere disco | Gratis (incluido en Nginx), requiere disco | De $5 a $500+/mes (depende del tráfico y las funciones) |

| Cuándo usar | Siempre para estáticos | Para API, páginas, datos solicitados frecuentemente | Para aplicaciones PHP (WordPress, Laravel) | Para páginas dinámicas con actualización frecuente | Para cobertura global y grandes volúmenes de tráfico |

Como se desprende de la tabla, la elección de la estrategia de almacenamiento en caché depende del tipo de contenido, los requisitos de actualidad de los datos y los recursos disponibles. En la mayoría de los casos, para un VPS es óptimo combinar varios enfoques: almacenar en caché estáticos a nivel de Nginx y del navegador, usar Proxy Cache para API y páginas, y FastCGI Cache para aplicaciones PHP, complementando esto con microcaching para reducir las cargas máximas.

Revisión detallada de cada punto/opción de optimización

Analicemos en detalle los aspectos clave de la optimización de Nginx que le ayudarán a sacar el máximo provecho de su VPS.

Almacenamiento en caché: La base del rendimiento

El almacenamiento en caché es la forma más efectiva de reducir la carga en el backend y acelerar la respuesta. Nginx ofrece potentes mecanismos para ello.

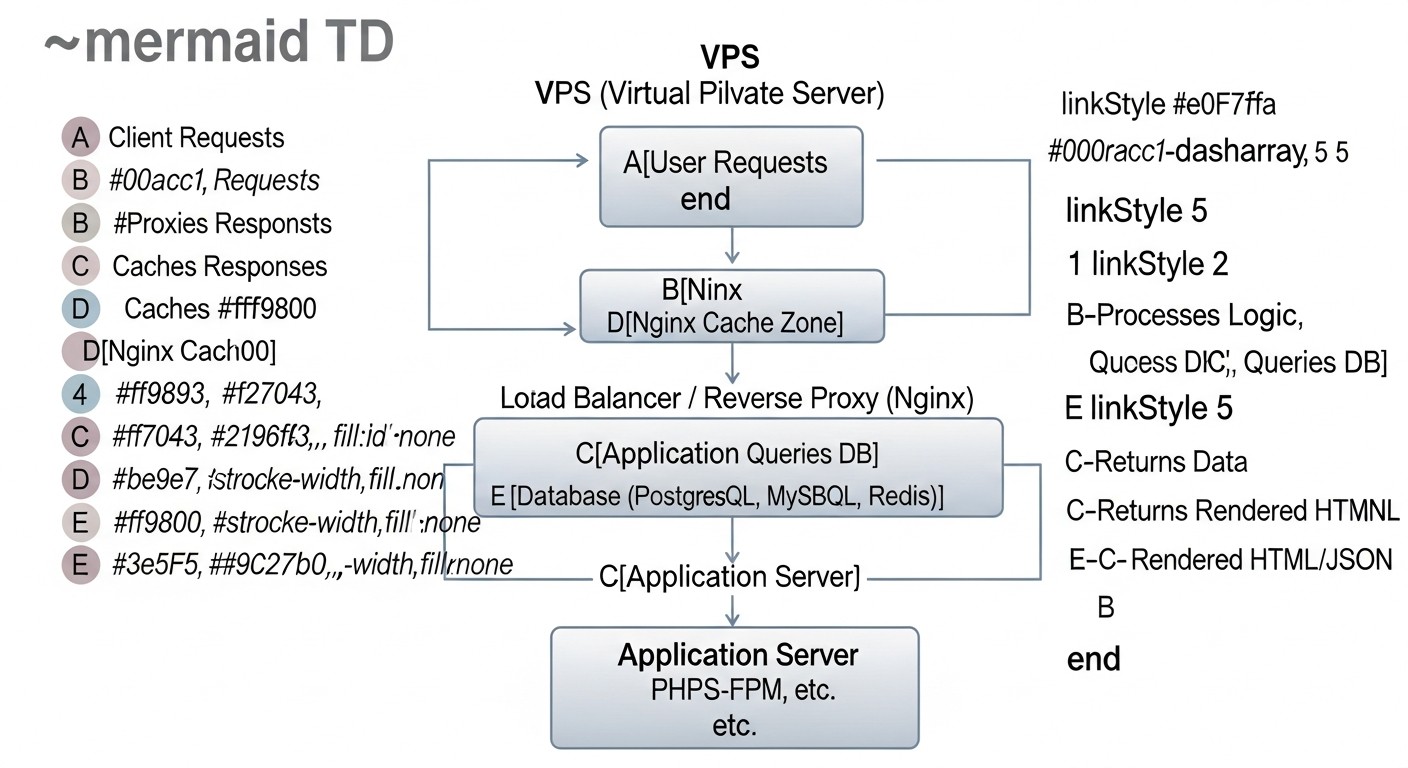

Nginx Proxy Cache

Nginx Proxy Cache permite almacenar en caché las respuestas de los servidores ascendentes (backend). Es una solución ideal para almacenar en caché páginas HTML, respuestas JSON de API, imágenes, CSS y JS que se generan dinámicamente pero no cambian con frecuencia. En la primera solicitud, Nginx la reenvía al backend, guarda la respuesta en disco (o en memoria) y la entrega al usuario. Las solicitudes posteriores para el mismo recurso se servirán directamente desde la caché, lo que es significativamente más rápido. Esto reduce sustancialmente la carga de CPU y RAM del backend, así como de la base de datos. En un VPS con recursos limitados, esto permite procesar muchas más solicitudes. Las directivas clave incluyen proxy_cache_path para definir la ruta a la caché y sus parámetros, proxy_cache para activar el almacenamiento en caché en una location específica, proxy_cache_key para definir una clave de caché única (generalmente $scheme$proxy_host$request_uri), y proxy_cache_valid para establecer la vida útil de las respuestas en caché según el estado HTTP. También es importante configurar proxy_cache_bypass y proxy_no_cache para ciertas condiciones (por ejemplo, para usuarios autenticados o solicitudes POST) para evitar el almacenamiento en caché de contenido personalizado. El uso de proxy_cache_revalidate permite a Nginx verificar la actualidad de la caché utilizando los encabezados If-Modified-Since o If-None-Match, minimizando el tráfico al backend.

Nginx FastCGI Cache

FastCGI Cache es similar a Proxy Cache, pero está diseñado específicamente para almacenar en caché las respuestas de servidores FastCGI, como PHP-FPM, Python Gunicorn/uWSGI o aplicaciones Go. Este tipo de almacenamiento en caché es indispensable para aplicaciones PHP de alta carga (WordPress, Laravel, Symfony), donde cada página puede generarse con una consulta a la base de datos. Nginx almacena en caché la respuesta HTML o JSON completamente generada desde el backend FastCGI, y en solicitudes posteriores la entrega directamente, omitiendo completamente el intérprete PHP y la base de datos. Esto proporciona un aumento masivo del rendimiento y reduce significativamente el consumo de recursos. Las directivas son similares a Proxy Cache: fastcgi_cache_path, fastcgi_cache, fastcgi_cache_key, fastcgi_cache_valid. También son importantes fastcgi_cache_bypass y fastcgi_no_cache para excluir ciertas solicitudes de la caché (por ejemplo, para el panel de administración o las páginas del carrito de compras). La configuración correcta de los encabezados Cache-Control en el backend también es crítica para una interacción eficiente con FastCGI Cache.

Microcaching

El microcaching es una variante del almacenamiento en caché Proxy/FastCGI con una vida útil de caché muy corta, generalmente de 1 a 10 segundos. Es ideal para páginas dinámicas que se actualizan con frecuencia, pero no tan a menudo como para que cada solicitud deba ser procesada por el backend. Por ejemplo, para sitios de noticias, blogs o plataformas de comercio electrónico, donde el contenido cambia cada pocos segundos o minutos. El microcaching permite "suavizar" los picos de carga cuando muchas solicitudes para la misma página llegan al servidor simultáneamente. En lugar de sobrecargar el backend, Nginx entregará la misma versión en caché durante un corto intervalo, reduciendo significativamente el número de accesos a la aplicación. Esto proporciona una respuesta casi instantánea para la mayoría de los usuarios, manteniendo al mismo tiempo un alto grado de actualidad del contenido. Se configura con proxy_cache_valid 1s o fastcgi_cache_valid 1s, complementado con reglas proxy_cache_bypass para los casos en que se requiere contenido garantizado y fresco.

Almacenamiento en caché de estáticos y encabezados Expires/Cache-Control

Este es un tipo de almacenamiento en caché básico pero extremadamente importante. Los archivos estáticos (imágenes, CSS, JavaScript, fuentes, videos) deben almacenarse en caché durante el mayor tiempo posible tanto a nivel de Nginx como en el navegador del usuario. Nginx puede entregar estos archivos directamente, sin recurrir al backend. La directiva expires en Nginx establece los encabezados Cache-Control y Expires, indicando al navegador cuánto tiempo puede almacenar el recurso en la caché local. Por ejemplo, expires 365d para imágenes o expires 7d para CSS/JS. Para garantizar la actualidad cuando los archivos cambian, se recomienda usar el versionado (por ejemplo, style.css?v=1.2.3 o style.12345.css). Esto permite que el navegador use la versión en caché hasta que la URL cambie. La configuración correcta del almacenamiento en caché de estáticos reduce el tráfico, acelera la carga de páginas para visitantes recurrentes y libera recursos de Nginx para procesar solicitudes dinámicas más complejas.

Seguridad: Protegiendo su aplicación

En 2026, cuando los ciberataques son cada vez más sofisticados, la seguridad de las aplicaciones web en un VPS no puede ser una cuestión secundaria. Nginx es la primera línea de defensa.

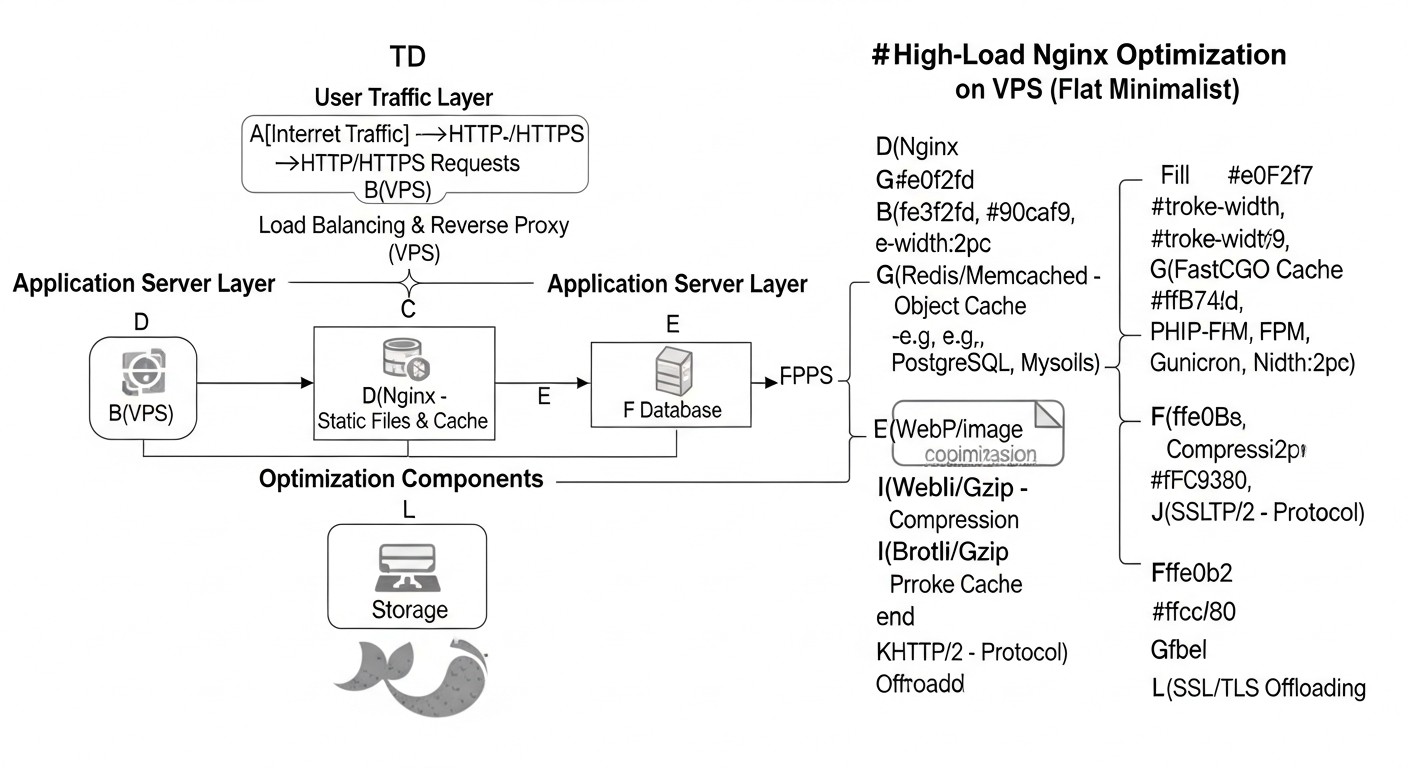

Mejores prácticas de SSL/TLS (TLS 1.3, HSTS, OCSP Stapling)

El uso de HTTPS se ha convertido desde hace tiempo en un estándar. Pero es importante no solo habilitar HTTPS, sino configurarlo correctamente. En 2026, el uso de TLS 1.3 es obligatorio: es la versión más rápida y segura del protocolo, que reduce el número de handshakes y utiliza algoritmos criptográficos modernos. Nginx debe compilarse con soporte para OpenSSL 1.1.1 o posterior. Es importante elegir cifrados fuertes, excluyendo los obsoletos y vulnerables (por ejemplo, RC4, 3DES, modos CBC). Las directivas ssl_protocols TLSv1.2 TLSv1.3; y ssl_ciphers permiten hacerlo. El encabezado HTTP Strict Transport Security (HSTS) (add_header Strict-Transport-Security "max-age=31536000; includeSubDomains; preload" always;) obliga a los navegadores a usar siempre HTTPS para su dominio, previniendo ataques de tipo SSL stripping. OCSP Stapling (ssl_stapling on; ssl_stapling_verify on;) acelera la verificación del estado del certificado SSL y aumenta la confidencialidad, ya que el navegador no necesita contactar al servidor OCSP del emisor. La configuración correcta de SSL/TLS no solo protege los datos de los usuarios, sino que también mejora los indicadores de SEO y aumenta la confianza en su servicio.

Limitación de tasa (Rate Limiting) y protección DDoS

Los módulos limit_req y limit_conn de Nginx son herramientas potentes para proteger contra ataques de fuerza bruta, escaneo de vulnerabilidades y algunos tipos de ataques DDoS, así como para evitar la sobrecarga del backend. limit_req limita la frecuencia de solicitudes desde una dirección IP, y limit_conn limita el número de conexiones simultáneas. Por ejemplo, se pueden permitir no más de 5 solicitudes por segundo con un burst de hasta 10 para un endpoint de API y no más de 20 conexiones simultáneas por usuario. Esto evita situaciones en las que uno o varios atacantes puedan agotar los recursos de su VPS enviando una enorme cantidad de solicitudes. En un VPS, donde los recursos son limitados, esto es críticamente importante. La configuración debe ser fina para no bloquear a usuarios legítimos. Para una protección DDoS más avanzada, se puede integrar Nginx con soluciones WAF externas o utilizar servicios en la nube, pero las medidas básicas a nivel de Nginx ya proporcionan un efecto significativo.

Encabezados de seguridad y WAF

Nginx permite añadir varios encabezados HTTP que mejoran la seguridad del navegador del usuario. Por ejemplo, X-Frame-Options "DENY" previene el clickjacking, X-Content-Type-Options "nosniff" previene el MIME-sniffing, y Content-Security-Policy (CSP) permite controlar qué recursos puede cargar el navegador, reduciendo el riesgo de ataques XSS. En 2026, CSP se vuelve cada vez más complejo, pero su implementación es crítica. Para una protección más profunda, se puede integrar Nginx con un Web Application Firewall (WAF), por ejemplo, ModSecurity. ModSecurity en modo módulo de Nginx permite filtrar solicitudes y bloquear vectores de ataque conocidos (inyecciones SQL, XSS, etc.) antes de que lleguen al backend. Esto es especialmente valioso en un VPS, donde no es posible desplegar un WAF de hardware. La configuración de un WAF requiere atención para evitar falsos positivos, pero proporciona un potente nivel de protección.

Rendimiento: Máxima eficiencia

La configuración fina de los mecanismos internos de Nginx y del sistema operativo permite lograr el máximo rendimiento.

Optimización de Worker Processes y Connections

Nginx funciona con un modelo asíncrono y basado en eventos, utilizando un pequeño número de procesos de trabajo (worker processes) para manejar múltiples conexiones. El número de worker_processes generalmente se establece igual al número de núcleos de CPU en su VPS (o auto). Cada worker_process es capaz de manejar miles de conexiones simultáneas gracias a la entrada/salida no bloqueante. La directiva worker_connections define el número máximo de conexiones que cada proceso de trabajo puede manejar. El número total de conexiones que Nginx puede manejar es igual a worker_processes * worker_connections. Para un VPS con 2-4 núcleos y 2-4 GB de RAM, un valor razonable para worker_connections podría ser 4096-8192. También es importante aumentar los límites de descriptores de archivo a nivel del sistema operativo (ulimit -n) al valor correspondiente, de lo contrario, Nginx no podrá abrir tantas conexiones. La configuración correcta de estos parámetros permite a Nginx utilizar eficientemente los recursos de CPU y RAM disponibles, evitando su desbordamiento y asegurando un funcionamiento estable bajo alta carga.

Keepalive Connections

Las conexiones Keepalive permiten usar una única conexión TCP para varias solicitudes HTTP, en lugar de establecer una nueva conexión para cada solicitud. Esto reduce significativamente la sobrecarga de establecer una conexión (handshake TCP, handshake SSL/TLS) y acelera la carga de páginas que contienen muchos recursos (imágenes, CSS, JS). La directiva keepalive_timeout define cuánto tiempo Nginx mantendrá abierta la conexión después de la última solicitud. Generalmente se establece en 15-75 segundos. Un tiempo de espera demasiado corto conduce a reinstalaciones frecuentes de conexiones, uno demasiado largo, a un uso ineficiente de los recursos. La directiva keepalive_requests limita el número de solicitudes que se pueden realizar a través de una única conexión keepalive. Los valores óptimos dependen de la naturaleza del tráfico, pero para la mayoría de las aplicaciones web, keepalive es obligatorio para mejorar el rendimiento.

Compresión Gzip/Brotli

La compresión de respuestas HTTP reduce el tamaño de los datos transmitidos, lo que acorta el tiempo de carga de las páginas para los usuarios y ahorra ancho de banda. Nginx admite la compresión Gzip "de fábrica" y Brotli (a través de un módulo), un algoritmo de compresión más moderno y eficiente de Google. Brotli proporciona una mejor relación de compresión con una velocidad comparable. En 2026, se recomienda usar Brotli para todos los navegadores compatibles y Gzip como opción de respaldo. Las directivas gzip on;, gzip_types, gzip_min_length, gzip_comp_level controlan los parámetros de compresión. Es importante comprimir solo archivos de texto (HTML, CSS, JS, JSON, XML) y evitar comprimir archivos ya comprimidos (imágenes JPG/PNG, videos, PDF), ya que esto solo aumentará la carga de la CPU sin ganar en tamaño. La compresión sobre la marcha requiere recursos de CPU, por lo que para los estáticos es mejor usar versiones precomprimidas.

HTTP/2 y HTTP/3 (QUIC)

HTTP/2 se ha convertido en el estándar de facto, mejorando significativamente el rendimiento en comparación con HTTP/1.1 gracias a la multiplexación (múltiples solicitudes sobre una única conexión), Server Push y la compresión de encabezados. Nginx admite HTTP/2 (listen 443 ssl http2;). En 2026, se está implementando activamente HTTP/3, basado en el protocolo QUIC, que funciona sobre UDP y resuelve el problema de bloqueo de encabezado de línea a nivel de TCP, reduciendo aún más las latencias, especialmente en redes inestables. Nginx ya tiene soporte experimental para HTTP/3 (a través de Nginx QUIC). La transición a HTTP/2 y HTTP/3 es una de las formas más potentes de acelerar la carga de páginas, especialmente para sitios con muchos recursos. Esto requiere la presencia de SSL/TLS, ya que HTTP/2 y HTTP/3 funcionan exclusivamente sobre conexiones cifradas.

Optimización de búferes

Nginx utiliza búferes para almacenar temporalmente datos al interactuar con clientes y el backend. La configuración correcta de los tamaños de los búferes evita operaciones de escritura en disco no deseadas (que son lentas) y garantiza un flujo de datos fluido. Las directivas clave son: client_body_buffer_size (para el cuerpo de la solicitud del cliente), client_header_buffer_size (para los encabezados de la solicitud del cliente), proxy_buffer_size, proxy_buffers, proxy_busy_buffers_size (para el almacenamiento en búfer de las respuestas del backend). Los búferes demasiado pequeños pueden provocar la escritura de datos en el disco, lo que ralentiza el funcionamiento. Los búferes demasiado grandes pueden llevar a un uso ineficiente de la RAM. Los valores óptimos dependen del tamaño de las solicitudes y respuestas típicas de su aplicación, pero a menudo se utilizan valores en el rango de 4k-128k para los búferes. En un VPS, donde la RAM es limitada, es necesario encontrar un equilibrio entre el rendimiento y el consumo de memoria.

Consejos prácticos y recomendaciones para configurar Nginx

Pasemos a los archivos de configuración y comandos específicos que le ayudarán a aplicar los métodos descritos anteriormente en la práctica. Todos los ejemplos son válidos para Nginx 1.20+ y OpenSSL 1.1.1+.

Instalación básica y preparación del sistema

Antes de comenzar, asegúrese de que su sistema esté listo. Utilice una versión actualizada de la distribución (por ejemplo, Ubuntu Server 22.04 LTS) y Nginx.

# Actualización del sistema

sudo apt update && sudo apt upgrade -y

# Instalación de Nginx (si aún no está instalado)

sudo apt install nginx -y

# Verificación de la versión de Nginx y OpenSSL

nginx -V

# Asegúrese de que Nginx esté compilado con OpenSSL 1.1.1 o posterior y los módulos Brotli, HTTP/2.

# Ejemplo de salida: built with OpenSSL 1.1.1w... --with-http_v2_module --add-module=/path/to/ngx_brotli

# Configuración de límites de descriptores de archivo (para worker_connections)

# Edite /etc/security/limits.conf

echo "nginx - nofile 65535" | sudo tee -a /etc/security/limits.conf

echo "nginx - nproc 65535" | sudo tee -a /etc/security/limits.conf

# Edite /etc/sysctl.conf para aumentar los puertos temporales y otros parámetros TCP

echo "net.core.somaxconn = 65535" | sudo tee -a /etc/sysctl.conf

echo "net.ipv4.ip_local_port_range = 1024 65535" | sudo tee -a /etc/sysctl.conf

echo "net.ipv4.tcp_tw_reuse = 1" | sudo tee -a /etc/sysctl.conf

echo "net.ipv4.tcp_fin_timeout = 30" | sudo tee -a /etc/sysctl.conf

echo "net.ipv4.tcp_keepalive_time = 600" | sudo tee -a /etc/sysctl.conf

echo "net.ipv4.tcp_max_syn_backlog = 8192" | sudo tee -a /etc/sysctl.conf

sudo sysctl -p # Aplicar cambios de sysctl

Configuración principal de Nginx (/etc/nginx/nginx.conf)

Estas configuraciones afectan el funcionamiento de todos los hosts virtuales.

user www-data;

worker_processes auto; # Número de núcleos de CPU

pid /run/nginx.pid;

include /etc/nginx/modules-enabled/*.conf;

events {

worker_connections 8192; # Número máximo de conexiones por proceso

multi_accept on; # Permitir que worker_process acepte múltiples conexiones simultáneamente

use epoll; # Método óptimo de procesamiento de eventos para Linux

}

http {

## Configuraciones básicas de rendimiento

sendfile on;

tcp_nopush on;

tcp_nodelay on;

keepalive_timeout 65; # Tiempo de espera para conexiones keepalive

keepalive_requests 1000; # Número máximo de solicitudes por una conexión keepalive

types_hash_max_size 2048;

server_tokens off; # Ocultar la versión de Nginx por seguridad

## Tipos MIME

include /etc/nginx/mime.types;

default_type application/octet-stream;

## Configuraciones SSL/TLS (globales, si aplica)

ssl_protocols TLSv1.2 TLSv1.3;

ssl_prefer_server_ciphers on;

ssl_ciphers "TLS_AES_128_GCM_SHA256:TLS_AES_256_GCM_SHA384:TLS_CHACHA20_POLY1305_SHA256:ECDHE-RSA-AES128-GCM-SHA256:ECDHE-RSA-AES256-GCM-SHA384";

ssl_ecdh_curve secp384r1; # Para TLS 1.2

ssl_session_timeout 1d;

ssl_session_cache shared:SSL:10m;

ssl_session_tickets off;

ssl_stapling on;

ssl_stapling_verify on;

resolver 8.8.8.8 8.8.4.4 valid=300s; # Servidores DNS para OCSP

resolver_timeout 5s;

## Compresión Gzip / Brotli

gzip on;

gzip_vary on;

gzip_proxied any;

gzip_comp_level 6;

gzip_buffers 16 8k;

gzip_http_version 1.1;

gzip_types text/plain text/css application/json application/javascript text/xml application/xml application/xml+rss text/javascript;

gzip_min_length 1000; # Tamaño mínimo de respuesta para compresión

# Si el módulo Brotli está instalado:

# brotli on;

# brotli_comp_level 6;

# brotli_static on; # Servir archivos .br precomprimidos

# brotli_types text/plain text/css application/json application/javascript text/xml application/xml application/xml+rss text/javascript image/svg+xml;

## Registro (acceso y errores)

access_log /var/log/nginx/access.log;

error_log /var/log/nginx/error.log warn;

## Búferes

client_body_buffer_size 128k;

client_header_buffer_size 128k;

client_max_body_size 100m; # Tamaño máximo del cuerpo de la solicitud

large_client_header_buffers 4 256k; # Aumentar para encabezados grandes

include /etc/nginx/conf.d/*.conf; # Para configuraciones adicionales

include /etc/nginx/sites-enabled/*; # Para hosts virtuales

}

Configuración de Proxy Cache y FastCGI Cache

Cree directorios para la caché y configure los permisos:

sudo mkdir -p /var/cache/nginx/proxy_cache

sudo mkdir -p /var/cache/nginx/fastcgi_cache

sudo chown -R www-data:www-data /var/cache/nginx

Agregue al bloque http de nginx.conf o a un archivo separado (por ejemplo, /etc/nginx/conf.d/cache.conf):

# Zona de Proxy Cache

proxy_cache_path /var/cache/nginx/proxy_cache levels=1:2 keys_zone=my_proxy_cache:100m inactive=60m max_size=10g;

# Zona de FastCGI Cache

fastcgi_cache_path /var/cache/nginx/fastcgi_cache levels=1:2 keys_zone=my_fastcgi_cache:100m inactive=60m max_size=10g;

Ejemplo de uso en un host virtual (/etc/nginx/sites-available/your_app.conf):

server {

listen 80;

listen [::]:80;

server_name example.com www.example.com;

return 301 https://$host$request_uri; # Redirección a HTTPS

}

server {

listen 443 ssl http2; # Habilitamos HTTP/2

listen [::]:443 ssl http2;

server_name example.com www.example.com;

ssl_certificate /etc/letsencrypt/live/example.com/fullchain.pem;

ssl_certificate_key /etc/letsencrypt/live/example.com/privkey.pem;

ssl_trusted_certificate /etc/letsencrypt/live/example.com/chain.pem;

# HSTS

add_header Strict-Transport-Security "max-age=31536000; includeSubDomains; preload" always;

add_header X-Frame-Options "DENY";

add_header X-Content-Type-Options "nosniff";

add_header X-XSS-Protection "1; mode=block";

add_header Referrer-Policy "no-referrer-when-downgrade";

root /var/www/your_app/public;

index index.php index.html index.htm;

# Almacenamiento en caché de estáticos en Nginx y en el navegador

location ~* \.(jpg|jpeg|gif|png|webp|svg|ico|css|js|woff|woff2|ttf|eot|otf)$ {

expires 365d;

add_header Cache-Control "public, no-transform";

try_files $uri =404;

}

# Proxy Cache para API (si existe)

location /api/v1/data {

proxy_pass http://backend_api_server;

proxy_cache my_proxy_cache;

proxy_cache_valid 200 302 10m; # Almacenar en caché respuestas 200 y 302 por 10 minutos

proxy_cache_valid 404 1m; # Almacenar en caché 404 por 1 minuto

proxy_cache_key "$scheme$proxy_host$request_uri";

proxy_cache_bypass $cookie_nocache $http_pragma $http_authorization; # No almacenar en caché bajo ciertas condiciones

proxy_no_cache $cookie_nocache $http_pragma $http_authorization;

add_header X-Proxy-Cache $upstream_cache_status; # Mostrar estado de la caché

}

# FastCGI Cache para aplicaciones PHP

location ~ \.php$ {

try_files $uri =404;

fastcgi_split_path_info ^(.+\.php)(/.+)$;

fastcgi_pass unix:/run/php/php8.2-fpm.sock; # Ruta al socket PHP-FPM

fastcgi_index index.php;

fastcgi_param SCRIPT_FILENAME $document_root$fastcgi_script_name;

include fastcgi_params;

fastcgi_cache my_fastcgi_cache;

fastcgi_cache_valid 200 302 1h; # Almacenar en caché respuestas exitosas por 1 hora

fastcgi_cache_valid 404 1m;

fastcgi_cache_key "$scheme$request_method$host$request_uri";

fastcgi_cache_bypass $cookie_nocache $http_pragma $arg_nocache; # Evitar caché

fastcgi_no_cache $cookie_nocache $http_pragma $arg_nocache;

add_header X-FastCGI-Cache $upstream_cache_status;

}

# Microcaching para todas las páginas HTML (ejemplo)

location / {

proxy_pass http://backend_app_server; # O fastcgi_pass

proxy_cache my_proxy_cache; # O my_fastcgi_cache

proxy_cache_valid 200 1s; # Almacenar en caché por 1 segundo

proxy_cache_valid 404 1m;

proxy_cache_key "$scheme$request_method$host$request_uri";

proxy_cache_bypass $cookie_nocache $http_pragma $http_authorization;

proxy_no_cache $cookie_nocache $http_pragma $http_authorization;

add_header X-Micro-Cache $upstream_cache_status;

}

}

Limitación de tasa (Rate Limiting) y protección DDoS

Agregue al bloque http de nginx.conf:

# Limitación de solicitudes: 5 solicitudes/seg, burst 10 (10 solicitudes pueden ser procesadas en pico, luego retraso)

limit_req_zone $binary_remote_addr zone=mylimit:10m rate=5r/s;

# Limitación de conexiones: 20 conexiones simultáneas desde una IP

limit_conn_zone $binary_remote_addr zone=per_ip:10m;

Utilice en el bloque server o location:

server {

# ...

limit_conn per_ip 20; # Aplicar al servidor en general

location /login {

limit_req zone=mylimit burst=10 nodelay; # Aplicar a /login, no retrasar burst

# ...

}

location /api/v1/sensitive {

limit_req zone=mylimit burst=5; # Aplicar a API sensible, retrasar burst

# ...

}

}

Optimización de búferes para el backend

Si Nginx funciona como proxy inverso para un backend (por ejemplo, Node.js, Python Gunicorn), estas configuraciones en el bloque location o server son críticas:

location / {

proxy_pass http://your_backend;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

proxy_buffers 32 4k; # 32 búferes de 4KB

proxy_buffer_size 8k; # Tamaño del primer búfer

proxy_busy_buffers_size 16k; # Tamaño máximo de búferes que pueden estar ocupados enviando

proxy_temp_file_write_size 32k; # Tamaño de los datos escritos en el archivo temporal

proxy_max_temp_file_size 0; # Desactivar la escritura en archivos temporales en disco, si hay suficiente RAM

proxy_connect_timeout 60s;

proxy_send_timeout 60s;

proxy_read_timeout 60s;

}

Después de cualquier cambio en la configuración de Nginx, siempre verifique la sintaxis y recargue el servicio:

sudo nginx -t

sudo systemctl reload nginx

Errores comunes al optimizar Nginx en un VPS

Incluso los ingenieros experimentados pueden cometer errores, especialmente cuando trabajan con sistemas de alta carga y recursos limitados de VPS. Conocer estos escollos le ayudará a evitarlos.

Límites insuficientes de descriptores de archivo

Error: Establecer worker_connections en Nginx a un valor alto (por ejemplo, 8192), pero ignorar los límites de descriptores de archivo (file descriptors, FD) a nivel del sistema operativo. Por defecto en Linux, el límite de FD para los procesos puede ser bajo (por ejemplo, 1024). Nginx utiliza FD para cada conexión, así como para archivos de registro, configuración, caché. Si el límite del SO es inferior al número total de conexiones que Nginx intenta abrir, recibirá errores "too many open files" en los registros de Nginx, y el servidor no podrá aceptar nuevas conexiones, a pesar de la configuración correcta de worker_connections.

Cómo evitarlo: Aumente el límite de FD para el usuario de Nginx (generalmente www-data o nginx) en /etc/security/limits.conf y/o globalmente a través de /etc/sysctl.conf. Asegúrese de que ulimit -n para el usuario bajo el cual se ejecuta Nginx coincida o exceda el worker_connections deseado. Después de cambiar limits.conf, puede ser necesario reiniciar la sesión o el servidor.

# En /etc/security/limits.conf

# Agregue o modifique:

# www-data soft nofile 65535

# www-data hard nofile 65535

# Reinicie Nginx después de cambiar los límites (puede ser necesario reiniciar el VPS)

sudo systemctl restart nginx

Caché excesivo o incorrecto

Error: Almacenamiento en caché de contenido personalizado (por ejemplo, páginas después de la autenticación, carrito de compras) o almacenamiento en caché demasiado agresivo de datos que cambian dinámicamente. Esto puede llevar a que los usuarios vean contenido ajeno o desactualizado, lo que es un problema grave de seguridad y experiencia de usuario.

Cómo evitarlo: Utilice las directivas proxy_cache_bypass y fastcgi_cache_bypass para excluir de la caché las solicitudes con cookies de autenticación, tokens únicos o solicitudes POST. Piense cuidadosamente en proxy_cache_key para que tenga en cuenta todos los parámetros que afectan la unicidad del contenido. Para contenido muy dinámico, use microcaching con una vida útil corta (1-5 segundos) o desactive completamente el almacenamiento en caché en Nginx para dichas páginas, si la aplicación misma ya lo hace de manera eficiente.

Ignorar el registro o un registro demasiado detallado

Error: Desactivar completamente los registros de Nginx (access_log off) en un intento de ahorrar recursos o, por el contrario, un registro demasiado detallado de cada solicitud, incluidos los estáticos, lo que lleva a archivos de registro enormes, alta E/S y un rápido agotamiento del espacio en disco en el VPS.

Cómo evitarlo: No desactive los registros por completo, son críticamente importantes para la depuración, el monitoreo y el análisis de seguridad. En su lugar, optimice el formato de los registros (log_format) para incluir solo los datos necesarios. Desactive el registro de archivos estáticos (imágenes, CSS, JS) que se sirven correctamente desde la caché, ya que generan mucho ruido. Use access_log off; dentro del bloque location para los estáticos. Configure la rotación de registros (logrotate) para comprimir y eliminar automáticamente los registros antiguos.

# En nginx.conf en el bloque http

log_format custom_log '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" "$http_user_agent" '

'"$http_x_forwarded_for" "$upstream_response_time" "$request_time"';

access_log /var/log/nginx/access.log custom_log;

# En el bloque server para estáticos

location ~* \.(jpg|jpeg|gif|png|webp|svg|ico|css|js|woff|woff2|ttf|eot|otf)$ {

expires 365d;

add_header Cache-Control "public, no-transform";

access_log off; # Desactivar el registro para estáticos

try_files $uri =404;

}

Configuración SSL/TLS no optimizada

Error: Uso de versiones obsoletas de TLS (1.0, 1.1), cifrados débiles o ausencia de HSTS. Esto no solo hace que su aplicación sea vulnerable, sino que también ralentiza el handshake TLS, aumentando la latencia.

Cómo evitarlo: Siempre use TLS 1.2 y TLS 1.3 (si Nginx está compilado con OpenSSL 1.1.1+). Elija solo cifrados fuertes y modernos. Habilite HSTS y OCSP Stapling. Revise regularmente la configuración SSL/TLS con servicios como SSL Labs. Actualice Nginx y OpenSSL para obtener las últimas mejoras de seguridad y rendimiento.

Ignorar el monitoreo y las pruebas de carga

Error: Aplicar optimizaciones "a ciegas" sin medir antes y después, y sin un monitoreo regular del funcionamiento de Nginx bajo carga real o simulada. Esto lleva a que los problemas pasen desapercibidos o que las nuevas optimizaciones puedan causar regresiones.

Cómo evitarlo: Implemente un sistema de monitoreo (NGINX Amplify, Prometheus/Grafana, Netdata) para rastrear métricas clave de Nginx (RPS, Latencia, uso de CPU/RAM, aciertos/fallos de caché, errores). Realice regularmente pruebas de carga (k6, JMeter, Gatling) en entornos de prueba o staging para identificar cuellos de botella y verificar la efectividad de las optimizaciones antes de implementarlas en producción. Analice los registros de Nginx en busca de errores, advertencias y anomalías.

Uso excesivo de módulos o funciones de Nginx

Error: Habilitar muchos módulos opcionales o usar configuraciones complejas que no aportan un beneficio tangible, pero aumentan el consumo de memoria y CPU. Por ejemplo, usar ModSecurity sin una necesidad real o reglas de reescritura demasiado complejas.

Cómo evitarlo: El principio "cuanto más simple, mejor" es especialmente relevante para un VPS. Habilite solo los módulos y funciones que realmente necesita. Cada directiva o módulo adicional agrega una sobrecarga. Realice pruebas de rendimiento con diferentes configuraciones para comprender qué cambios realmente aumentan el rendimiento y cuáles solo complican el sistema.

Lista de verificación para la aplicación práctica de la optimización de Nginx

Este algoritmo paso a paso le ayudará a abordar sistemáticamente la optimización de Nginx en su VPS.

-

Auditoría del estado actual

Realice una auditoría de la configuración actual de Nginx, los recursos del VPS (CPU, RAM, E/S de disco, red) y el rendimiento de su aplicación web (Latencia, RPS, Tasa de errores). Utilice

top,htop,free -h,iostat, así como herramientas como Lighthouse, WebPageTest para recopilar métricas básicas. -

Actualización de Nginx y OpenSSL

Asegúrese de tener instaladas las últimas versiones estables de Nginx y OpenSSL (mínimo OpenSSL 1.1.1 para TLS 1.3). Si es necesario, actualícelos o recompile Nginx con los módulos necesarios (Brotli, HTTP/3).

-

Configuración de límites del sistema

Aumente los límites de descriptores de archivo (

ulimit -n) para el usuario de Nginx y configure los parámetros de la pila TCP en/etc/sysctl.conf(net.core.somaxconn,net.ipv4.ip_local_port_range,net.ipv4.tcp_tw_reuse). -

Optimización de Worker Processes y Connections

Establezca

worker_processes auto;yworker_connectionsen un valor adecuado (por ejemplo, 4096-8192) ennginx.conf, que corresponda a los límites del sistema. -

Habilitación y configuración de HTTP/2

Agregue

http2a la directivalisten 443 ssl;en el bloqueserverpara su host HTTPS. Considere la implementación de HTTP/3 (QUIC) si hay soporte. -

Configuración de las mejores prácticas de SSL/TLS

Utilice

ssl_protocols TLSv1.2 TLSv1.3;,ssl_ciphersmodernos, habilitessl_stapling on;y agregue el encabezado HSTS (Strict-Transport-Security). -

Configuración del almacenamiento en caché de estáticos

Habilite

expires 365d;yadd_header Cache-Control "public";para archivos estáticos. Desactiveaccess_logpara estáticos en el bloquelocationcorrespondiente. -

Implementación de Nginx Proxy/FastCGI Cache

Defina

proxy_cache_pathyfastcgi_cache_pathen el bloquehttp. Utiliceproxy_cache/fastcgi_cacheen los bloqueslocationpara almacenar en caché las respuestas del backend. No olvide_bypassy_no_cachepara contenido personalizado. -

Configuración de Microcaching

Para páginas dinámicas pero solicitadas con frecuencia, configure

proxy_cache_valid 1s;ofastcgi_cache_valid 1s;. -

Habilitación de la compresión Gzip/Brotli

Active

gzip on;y configuregzip_types. Si el módulo Brotli está disponible, úselo para una mejor compresión (brotli on;). -

Configuración de la limitación de tasa

Defina

limit_req_zoneylimit_conn_zoneen el bloquehttpy apliquelimit_req/limit_conna los bloquesserverolocationcorrespondientes para proteger contra sobrecargas y ataques. -

Optimización de búferes

Configure

client_body_buffer_size,client_header_buffer_size,proxy_buffersyproxy_buffer_sizepara un funcionamiento óptimo con clientes y backend, minimizando la escritura en disco. -

Configuración de encabezados de seguridad

Agregue los encabezados

X-Frame-Options,X-Content-Type-Options,X-XSS-Protectiony considere la implementación deContent-Security-Policy. -

Pruebas y monitoreo

Después de cada etapa de cambios, verifique la configuración (

sudo nginx -t), recargue Nginx (sudo systemctl reload nginx) y realice pruebas de carga. Configure un monitoreo constante del rendimiento y los errores. -

Optimización iterativa

La optimización es un proceso continuo. Analice los datos de monitoreo, identifique nuevos cuellos de botella y continúe mejorando la configuración de Nginx y su aplicación.

Cálculo de costos y economía de la optimización de Nginx

Las inversiones en la optimización de Nginx en un VPS no son solo un ejercicio técnico, sino una decisión estratégica que afecta directamente los gastos operativos (OpEx) y la escalabilidad de su proyecto. En 2026, el costo de los VPS sigue disminuyendo, pero al mismo tiempo aumentan los requisitos de rendimiento. Una optimización adecuada permite posponer la actualización del VPS a un plan más caro o incluso cambiar a uno más económico, sirviendo al mismo o incluso mayor volumen de tráfico.

Ejemplos de cálculos para diferentes escenarios

Escenario 1: Ahorro en la actualización del VPS

Imagine que su aplicación web en un VPS con 2 vCPU, 4GB de RAM y 80GB NVMe ($20/mes en 2026) comienza a experimentar problemas de rendimiento con una carga máxima de 500 RPS. Sin optimización, el paso lógico parece ser actualizar a un VPS con 4 vCPU, 8GB de RAM y 160GB NVMe ($40/mes). Esto duplicaría sus costos de infraestructura.

Sin embargo, una optimización profunda de Nginx (almacenamiento en caché, HTTP/2, Brotli, configuraciones del sistema) puede reducir la carga en el backend y Nginx en un 30-50%. Si gracias a Nginx Proxy Cache el 60% de las solicitudes se atienden sin recurrir al backend, y HTTP/2 y Brotli reducen el tiempo de carga y el volumen de tráfico, su VPS actual puede manejar fácilmente 700-800 RPS. Esto significa que ha pospuesto la actualización por varios meses o incluso un año, ahorrando $20/mes * X meses. En un año, esto representa hasta $240 de ahorro.

Escenario 2: Aumento del rendimiento sin aumentar los costos

Supongamos que su proyecto SaaS en un VPS ($30/mes) atiende a 1000 usuarios activos y genera 1000 RPS. Desea aumentar el número de usuarios a 2000, lo que potencialmente duplicaría el RPS. Sin optimización, esto llevaría a la necesidad de duplicar los recursos del VPS (y los costos a $60/mes).

Con un Nginx optimizado (por ejemplo, 70% de aciertos de caché para estáticos y 40% para dinámicos, limitación de tasa efectiva), su VPS actual puede soportar hasta 1500-1800 RPS sin una degradación significativa del rendimiento. Esto le permite escalar a 1500-1800 usuarios sin aumentar los costos mensuales del VPS. Obtiene un 50-80% de aumento de rendimiento por el mismo dinero, lo que afecta directamente la rentabilidad de su SaaS.

Costos ocultos y cómo optimizarlos

- Tiempo del ingeniero: El "costo oculto" más significativo es el tiempo de un ingeniero DevOps o desarrollador altamente calificado. Sin embargo, es una inversión. Las horas dedicadas a configurar Nginx se amortizarán con la reducción de los costos futuros de infraestructura y la disminución del número de incidentes. La automatización del despliegue de Nginx con Ansible, Terraform o Docker/Kubernetes reduce estos costos a largo plazo.

- Monitoreo: Los sistemas de monitoreo (Prometheus, Grafana, NGINX Amplify) requieren instalación, configuración y, a veces, una suscripción de pago. Esto no es un gasto, sino una inversión necesaria que ayuda a identificar problemas rápidamente y a evaluar la efectividad de las optimizaciones.

-

Espacio en disco para la caché: El almacenamiento en caché en disco requiere espacio adicional. En un VPS con discos NVMe, esto puede ser más caro que en un HDD. Sin embargo, el costo del espacio en disco suele ser menor que el costo de CPU o RAM adicionales. Una gestión eficiente de la caché (

inactive,max_size) ayuda a controlar su tamaño. - Certificados SSL: En 2026, Let's Encrypt proporciona certificados SSL gratuitos, lo que elimina este gasto. Sin embargo, para el nivel Enterprise, pueden ser necesarios certificados EV o Wildcard de pago.

Tabla con ejemplos de cálculos

Economía aproximada para un proyecto SaaS promedio en un VPS en 2026:

| Parámetro | Antes de la optimización | Después de la optimización de Nginx | Diferencia/Ahorro |

|---|---|---|---|

| Tipo de VPS | 4 vCPU, 8GB RAM, 160GB NVMe | 2 vCPU, 4GB RAM, 80GB NVMe | Cambio a un plan más económico |

| Costo de VPS/mes (2026) | $40 | $20 | -$20/mes |

| RPS máximo (Aplicación Web) | 1000 RPS | 1500 RPS (en un VPS más económico) | +500 RPS |

| Tiempo de respuesta (Latencia) | 200-300 ms | 50-100 ms | -150-200 ms |

| Tasa de aciertos de caché de Nginx | 0% | 60% (para estáticos), 40% (para dinámicos) | Reducción significativa de la carga del backend |

| Consumo de CPU por el backend | 80-90% en pico | 40-50% en pico | -40-50% |

| Consumo de RAM por el backend | 70-80% en pico | 50-60% en pico | -20-30% |

| Ahorro anual en VPS | - | - | Hasta $240/año |

| Aumento de capacidad (usuarios) | 1000 | 1500-1800 | +50-80% sin costos adicionales |

Como se puede ver, las inversiones en la optimización de Nginx se amortizan varias veces. Además del ahorro directo en hardware, obtiene un servicio más rápido y estable, lo que mejora la experiencia del usuario, reduce la rotación de clientes y contribuye al crecimiento de su negocio.

Casos y ejemplos de la práctica real

La teoría es importante, pero los ejemplos reales demuestran el verdadero poder de la optimización de Nginx. Aquí hay algunos casos basados en escenarios típicos.

Caso 1: Salvando una startup del colapso debido al "efecto Habr"

Problema

Una joven startup SaaS lanzó su producto, una herramienta en línea para diseñadores. El servidor VPS costaba $35/mes (4 vCPU, 8GB RAM) y funcionaba con un backend Node.js con PostgreSQL. Un día, un artículo sobre el producto apareció en un popular portal tecnológico, lo que provocó el "efecto Habr": un aumento explosivo del tráfico. El RPS se disparó de 50 a 1500. El servidor comenzó a responder con errores 502/504, el tiempo de respuesta aumentó a 5-10 segundos, y la base de datos se "ahogaba" constantemente. Los usuarios no podían registrarse, las sesiones se interrumpían. La startup estaba perdiendo clientes potenciales en el momento más importante.

Solución

El equipo contactó urgentemente a un especialista en DevOps. Lo primero que se hizo fue configurar Nginx como proxy inverso con un almacenamiento en caché profundo. Se realizaron los siguientes pasos:

- Se configuró Nginx Proxy Cache para todos los recursos estáticos (CSS, JS, imágenes), así como para algunos endpoints de API que devolvían datos generales (por ejemplo, lista de tarifas, plantillas públicas). Se estableció

proxy_cache_valid 200 302 1h;. - Se implementó microcaching (

proxy_cache_valid 200 1s;) para la página principal y las páginas de descripción del producto, que no se actualizaban más de una vez cada pocos minutos. Esto permitió a Nginx entregar contenido fresco, pero al mismo tiempo manejar picos de carga. - Se aumentaron

worker_connectionsa 8192 y los límites de descriptores de archivo del sistema correspondientes. - Se habilitó HTTP/2 y la compresión Brotli.

- Se configuró

limit_req_zonepara proteger contra escaneos y bots que también atacaron el sitio.

Resultado

Después de implementar estos cambios, Nginx comenzó a servir hasta el 70% de las solicitudes desde la caché. La carga en el backend de Node.js y PostgreSQL se redujo en 3-4 veces. El tiempo de respuesta se estabilizó en 150-250 ms. El servidor pudo soportar picos de hasta 2000 RPS sin degradación del rendimiento, utilizando el mismo VPS de $35/mes. La startup no solo sobrevivió al "efecto Habr", sino que también convirtió eficazmente una parte significativa del nuevo tráfico en registros, evitando una costosa y urgente actualización de la infraestructura.

Caso 2: Optimización de un blog de WordPress en VPS para SEO y velocidad

Problema

Un popular blog de WordPress, alojado en un VPS por $25/mes (2 vCPU, 4GB RAM), experimentaba problemas con la velocidad de carga. Los indicadores de Core Web Vitals eran bajos (CLS, LCP, FID), lo que afectaba negativamente la clasificación SEO. Durante la carga máxima (por ejemplo, después de publicar un nuevo artículo), el servidor se "congelaba" y los procesos de PHP-FPM consumían toda la RAM disponible.

Solución

Para resolver el problema, se aplicó un enfoque integral con énfasis en FastCGI Cache y la optimización de estáticos:

- Nginx FastCGI Cache se configuró para almacenar en caché todas las páginas del blog. La vida útil de la caché se estableció en 10 minutos (

fastcgi_cache_valid 200 10m;). Para usuarios autenticados (administradores), la caché se omitía (fastcgi_cache_bypass $cookie_wordpress_logged_in;). - Se configuró un almacenamiento en caché agresivo de estáticos (imágenes, CSS, JS, fuentes) con

expires 365d;y se deshabilitó el registro para ellos. - Se habilitó HTTP/2 y la compresión Gzip (Brotli no estaba disponible en la compilación actual de Nginx).

- Se optimizaron los parámetros de PHP-FPM (

pm.max_children,php_memory_limit) para que se ajustaran mejor a la RAM disponible en el VPS. - Se configuraron los encabezados de seguridad (HSTS, X-Frame-Options) para mejorar la clasificación general de seguridad.

Resultado

Después de implementar los cambios, Nginx comenzó a servir hasta el 95% de los estáticos y hasta el 80% de las páginas dinámicas desde la caché. El tiempo de carga de la página principal se redujo de 3-4 segundos a menos de 1 segundo. Los indicadores de Core Web Vitals mejoraron significativamente, lo que llevó a un aumento en las posiciones del blog en los resultados de búsqueda. Los procesos de PHP-FPM ahora consumían mucha menos RAM, y el servidor funcionaba de manera estable incluso durante las cargas máximas, utilizando el mismo VPS de $25/mes. Esto permitió al propietario del blog concentrarse en la creación de contenido, en lugar de en los problemas del servidor.

Herramientas y recursos para monitorear y depurar Nginx

Una optimización efectiva es imposible sin un monitoreo constante y las herramientas adecuadas para la depuración. En 2026, existen muchas soluciones maduras que le ayudarán a mantener Nginx en un estado óptimo.

Utilidades para trabajar con Nginx y el sistema

-

nginx -t: Siempre use este comando después de cualquier cambio en la configuración de Nginx para verificar la sintaxis. Esto evitará errores al recargar el servicio. -

nginx -s reloadosudo systemctl reload nginx: Para recargar la configuración de forma segura sin detener el servicio. -

nginx -V: Muestra la versión de Nginx, los parámetros de compilación y los módulos habilitados. Útil para verificar el soporte de HTTP/2, Brotli u otros módulos. -

top/htop: Utilidades estándar para monitorear el uso de CPU, RAM y procesos en tiempo real. Ayudan a identificar rápidamente los procesos de Nginx que consumen muchos recursos. -

iostat/iotop: Para monitorear la entrada/salida de disco (I/O). Crítico para servidores de caché para asegurarse de que la caché no cause cuellos de botella en el disco. -

netstat -tulnp/ss -tulnp: Muestra los puertos abiertos y las conexiones de red activas. Útil para verificar que Nginx esté escuchando los puertos correctos. -

tail -f /var/log/nginx/access.log/error.log: Visualización de registros en tiempo real. Indispensable para la depuración de problemas y el monitoreo de solicitudes.

Monitoreo y pruebas

- NGINX Amplify: Herramienta oficial de monitoreo de NGINX Inc. Proporciona información detallada sobre el rendimiento de Nginx, incluyendo RPS, Latencia, aciertos/fallos de caché, estado de los procesos worker. Tiene un plan gratuito para un servidor.

-

Prometheus + Grafana: Potente combinación para la recopilación, almacenamiento y visualización de métricas. Nginx Exporter permite recopilar datos de

nginx_status. Permite crear paneles personalizados y alertas, lo que es ideal para un análisis profundo del rendimiento. - Netdata: Monitoreo ligero pero muy funcional en tiempo real. Se instala con un solo comando y proporciona ricos paneles interactivos para todo el sistema, incluido Nginx.

- k6: Herramienta moderna para pruebas de carga, escrita en Go. Permite escribir escenarios de prueba en JavaScript, se integra fácilmente en CI/CD. Excelente para probar Nginx bajo alta carga.

- JMeter / Gatling: Herramientas más pesadas pero muy potentes para pruebas de carga, especialmente para escenarios complejos con autenticación, sesiones y múltiples pasos.

- SSL Labs Server Test: Servicio en línea para un análisis profundo de la configuración SSL/TLS de su servidor. Le ayudará a asegurarse de que está utilizando cifrados fuertes, TLS 1.3 y HSTS.

- WebPageTest / Google Lighthouse: Herramientas para analizar el rendimiento de carga de páginas desde la perspectiva del usuario. Ayudan a evaluar el impacto del almacenamiento en caché, HTTP/2 y la compresión en la velocidad real.

Enlaces útiles y documentación

- Documentación oficial de Nginx: Siempre una fuente de información actualizada y exhaustiva sobre todas las directivas.

- Blog de Nginx: Publica artículos sobre nuevas funciones, rendimiento y mejores prácticas.

- Generador de configuración SSL de Mozilla: Ayuda a generar configuraciones SSL/TLS seguras y actualizadas para Nginx.

- SSL Labs Server Test: Verifique su configuración SSL/TLS.

- Google PageSpeed Insights: Analizador de rendimiento de páginas web de Google.

Troubleshooting: Resolución de problemas comunes con Nginx

Incluso con la configuración más cuidadosa, pueden surgir problemas. La capacidad de diagnosticarlos y resolverlos rápidamente es fundamental. Aquí hay algunos problemas típicos y enfoques para su solución.

502 Bad Gateway / 504 Gateway Timeout

Descripción: Estos errores indican que Nginx no pudo obtener una respuesta oportuna o correcta del servidor ascendente (backend). 502 generalmente significa que el backend devolvió una respuesta incorrecta o se cayó, 504 significa que el backend no respondió dentro del tiempo de espera establecido.

Diagnóstico:

- Verifique los registros de errores de Nginx (

/var/log/nginx/error.log). Allí se indicarán los detalles, por ejemplo, "connect() failed (111: Connection refused)" o "upstream timed out". - Verifique el estado de la aplicación backend (PHP-FPM, Node.js, Gunicorn, etc.). Use

sudo systemctl status php8.2-fpmo comandos similares. - Verifique los registros de la propia aplicación backend.

- Asegúrese de que la aplicación backend esté escuchando el puerto/socket correcto y que Nginx esté configurado para conectarse a él (

proxy_passofastcgi_pass). - Verifique la conectividad de red entre Nginx y el backend (

ping,telnetal puerto del backend).

Solución:

- Aumente los tiempos de espera de Nginx (

proxy_connect_timeout,proxy_send_timeout,proxy_read_timeout) y los tiempos de espera de la aplicación backend, si las solicitudes son realmente largas. - Optimice la aplicación backend para que responda más rápido.

- Aumente el número de procesos worker o hilos del backend para que pueda manejar más solicitudes paralelas.

- Verifique si los recursos del VPS (CPU, RAM) están siendo agotados por el backend.

Alta carga de CPU de Nginx

Descripción: Nginx en sí mismo suele ser muy eficiente y rara vez es la causa de una alta carga de CPU, a menos que esté realizando operaciones intensivas (por ejemplo, cifrado SSL en hardware antiguo, compresión de grandes volúmenes de datos sobre la marcha).

Diagnóstico:

- Use

htoppara ver qué procesos de Nginx están consumiendo CPU. - Verifique

nginx -Vpara asegurarse de que Nginx esté compilado con una versión actualizada de OpenSSL. - Verifique los registros de acceso en busca de una cantidad inusualmente grande de solicitudes (ataque DDoS, bots).

- Evalúe la cantidad de datos que Nginx está comprimiendo sobre la marcha (si gzip/Brotli está habilitado).

Solución:

- Asegúrese de que

worker_processesesté configurado según el número de núcleos de CPU. - Use TLS 1.3 y cifrados modernos, son más eficientes.

- Configure la limitación de tasa para descartar solicitudes excesivas.

- Para estáticos, use archivos precomprimidos (

gzip_static on;obrotli_static on;) para que Nginx no gaste CPU en la compresión sobre la marcha. - Verifique si la caché se está escribiendo activamente en un disco lento, lo que puede causar retrasos e influir indirectamente en la CPU.

Falta de memoria (Out of Memory)

Descripción: Nginx o la aplicación backend consumen demasiada RAM, lo que provoca ralentizaciones, uso de swap o incluso el colapso de las aplicaciones debido al OOM Killer.

Diagnóstico:

- Utilice

free -hyhtoppara monitorear el uso de RAM. - Verifique los registros de Nginx y del backend en busca de errores relacionados con la memoria.

- Evalúe el tamaño de la caché de Nginx (

keys_zone,max_size) y los búferes (proxy_buffers), si son demasiado grandes para su VPS. - Verifique la configuración de PHP-FPM (

pm.max_children,php_memory_limit) o similar para otros backends.

Solución:

- Reduzca

worker_connectionssi cada worker consume demasiada memoria. - Reduzca

max_sizepara la caché de Nginx okeys_zone. - Optimice los búferes de Nginx para que no sean excesivamente grandes.

- Optimice la aplicación backend en busca de fugas de memoria o uso ineficiente de la RAM.

- Reduzca el número de procesos worker del backend o el límite de memoria para cada proceso.

- Si nada ayuda, es posible que su VPS simplemente no pueda manejar la carga actual y se requiera una actualización.

Problemas con SSL/TLS

Descripción: Los navegadores informan errores de certificado SSL, el sitio no está disponible a través de HTTPS o el handshake SSL es lento.

Diagnóstico:

- Verifique los registros de errores de Nginx.

- Utilice el servicio en línea SSL Labs Server Test para un análisis profundo de su configuración.

- Asegúrese de que las rutas a

ssl_certificateyssl_certificate_keyen Nginx sean correctas y que los archivos existan. - Verifique que el certificado no haya caducado.

- Asegúrese de que Nginx esté escuchando en el puerto 443 (

listen 443 ssl;).

Solución:

- Actualice o vuelva a emitir el certificado caducado.

- Corrija las rutas en la configuración de Nginx.

- Asegúrese de que el firewall (ufw, firewalld) permita las conexiones entrantes en el puerto 443.

- Utilice las recomendaciones de SSL Labs para configurar cifrados y protocolos fuertes.

- Habilite OCSP Stapling para acelerar la verificación del certificado.

Cuándo contactar al soporte del proveedor de VPS

Si ha agotado todas las opciones de optimización de Nginx y del backend, y los problemas de rendimiento o estabilidad persisten, es posible que la causa esté fuera de su control:

- Problemas de red: Pérdida inexplicable de paquetes, pings altos a su VPS, bajo ancho de banda que no coincide con lo anunciado.

- Problemas de hardware: E/S de disco lenta, funcionamiento inestable de la CPU, reinicios repentinos del VPS.

- Problemas de virtualización: Efecto "vecino ruidoso", cuando los VPS vecinos en el mismo host físico consumen demasiados recursos, afectando a su VPS.

En estos casos, proporcione al proveedor los registros, métricas y resultados de diagnóstico más detallados posibles para acelerar la resolución del problema.

FAQ: Preguntas frecuentes sobre la optimización de Nginx

¿Qué tamaño de caché de Nginx es óptimo para un VPS con 4GB de RAM?

Para un VPS con 4GB de RAM, es razonable asignar hasta 5-10GB de caché de disco para Nginx Proxy/FastCGI, mientras que el tamaño de keys_zone (que almacena metadatos de caché en RAM) no debe exceder los 100-200MB. Si tiene mucha RAM y un SSD/NVMe rápido, puede aumentar keys_zone hasta 500MB y max_size de la caché hasta 20-30GB. Es importante monitorear el uso de RAM de Nginx y la E/S de disco. Si la caché se descarga activamente en el disco, esto puede indicar una falta de RAM para keys_zone o un uso demasiado intensivo de la caché.

¿Debería usar Nginx como balanceador de carga en un solo VPS?

En un solo VPS, Nginx se puede usar como balanceador de carga si tiene varias instancias de la aplicación backend (por ejemplo, varios procesos de Node.js o Gunicorn) escuchando en diferentes puertos, o si usa una arquitectura de microservicios. Esto permite a Nginx distribuir eficientemente las solicitudes entre ellos, aumentando la tolerancia a fallos y utilizando la CPU de manera uniforme. Sin embargo, esto no proporcionará tolerancia a fallos a nivel de servidor. En caso de caída del VPS, todo el servicio dejará de estar disponible.

¿Con qué frecuencia debo actualizar Nginx?

Se recomienda estar atento a las versiones estables de Nginx (por ejemplo, 1.20.x, 1.22.x, 1.24.x) y actualizar cuando se publiquen nuevas versiones con importantes correcciones de seguridad o rendimiento. Generalmente, es suficiente actualizar cada pocos meses o cuando se lanzan versiones LTS de la distribución. Siempre pruebe las actualizaciones en un entorno de staging antes de implementarlas en producción.

¿Es necesario usar un VPS separado para Nginx y el backend?

Para proyectos pequeños y medianos en un VPS, generalmente no es necesario separar Nginx y el backend en diferentes VPS. Nginx es muy ligero y puede funcionar eficientemente en el mismo servidor que el backend. La separación tiene sentido en cargas muy altas, cuando Nginx por sí mismo se convierte en un cuello de botella, o para mejorar la seguridad, pero para la mayoría de los proyectos de VPS, esto es excesivo y conduce a un aumento de los costos.

¿Cómo afecta Nginx al SEO?

Nginx influye directamente en el SEO a través de la velocidad de carga de las páginas y la disponibilidad. Una carga rápida de las páginas (gracias al almacenamiento en caché, HTTP/2, compresión) mejora la experiencia del usuario y es un factor importante de clasificación en Google (Core Web Vitals). Una configuración correcta de SSL/TLS garantiza una conexión segura, lo que también es un factor SEO. La resistencia a la carga garantiza que los rastreadores de los motores de búsqueda siempre puedan acceder a su contenido.

¿Qué es "Server Tokens off" y por qué es importante?

La directiva server_tokens off; en nginx.conf desactiva la visualización de la versión de Nginx en los encabezados de las respuestas HTTP y en las páginas de error. Esta es una medida de seguridad, ya que ocultar la versión del servidor dificulta que los atacantes identifiquen posibles vulnerabilidades específicas de una versión particular de Nginx. Aunque no es una panacea, es una buena práctica de "seguridad por oscuridad".

¿Cómo combatir los ataques DDoS si la limitación de tasa de Nginx es insuficiente?

Si las capacidades integradas de Nginx (limit_req, limit_conn) no son suficientes para un ataque DDoS, significa que el ataque es lo suficientemente potente como para sobrecargar incluso a Nginx. En este caso, es necesario utilizar servicios externos de protección DDoS, como Cloudflare, Sucuri, Akamai, o soluciones de su proveedor de VPS. Estos funcionan a nivel de DNS o proxy el tráfico a través de sus redes, filtrando las solicitudes maliciosas antes de que lleguen a su VPS.

¿Se puede usar Redis o Memcached para el almacenamiento en caché en Nginx?

Nginx por sí mismo no admite el almacenamiento en caché directo en Redis o Memcached. Sus mecanismos de almacenamiento en caché integrados funcionan con el sistema de archivos y la RAM (para metadatos). Sin embargo, puede usar Nginx en conjunto con una aplicación backend que use Redis/Memcached para su propio almacenamiento en caché. Por ejemplo, su aplicación PHP puede almacenar datos en caché en Redis, y Nginx ya almacenar en caché las respuestas de esa aplicación PHP.

¿Cómo interactúa Nginx con un CDN?

Nginx en su VPS puede actuar como "servidor de origen" para un CDN. El CDN almacena en caché su contenido en sus servidores de borde (edge-servers) en todo el mundo, acelerando significativamente la entrega a los usuarios y reduciendo la carga en su VPS. Nginx debe configurarse para funcionar correctamente con el CDN: transmitir los encabezados Cache-Control, Expires, ETag correctos, y también procesar las solicitudes del CDN. A menudo, Nginx también se utiliza para servir estáticos directamente desde la caché, si el CDN por alguna razón no se utilizó o no almacenó en caché un recurso específico.

¿Qué parámetros de Nginx son más críticos para un VPS con RAM limitada?

Para un VPS con RAM limitada, los parámetros más críticos son los siguientes:

worker_processes: Establezcaautoo igual al número de núcleos, pero no más, para no crear un número excesivo de procesos.worker_connections: Un valor moderado (2048-4096) para cada proceso, para no agotar la RAM en las conexiones.- Tamaño de

keys_zonepara la caché: Manténgalo pequeño (por ejemplo, 50-100MB), ya que esto es RAM. proxy_buffersyproxy_buffer_size: Establézcalos en valores razonables (por ejemplo, 4 8k), evitando búferes excesivamente grandes que pueden consumir mucha RAM por cada conexión.- Desactivar la escritura de archivos temporales en disco (

proxy_max_temp_file_size 0;), pero solo si tiene suficiente RAM para almacenar en búfer respuestas grandes. De lo contrario, es mejor escribir en disco.

Conclusión

La optimización de Nginx para aplicaciones web de alta carga en un VPS en 2026 no es solo un conjunto de configuraciones técnicas, sino un enfoque fundamental para construir una infraestructura eficiente, segura y económicamente viable. Hemos cubierto los tres pilares de esta optimización: almacenamiento en caché, seguridad y rendimiento, y hemos proporcionado ejemplos concretos, recomendaciones y herramientas.

El almacenamiento en caché, desde estáticos hasta microcaching de contenido dinámico, es su aliado más poderoso en la lucha por la velocidad y la reducción de la carga en el backend. Un SSL/TLS correctamente configurado, la limitación de tasa y los encabezados de seguridad convertirán a Nginx en un escudo confiable contra las amenazas. Y la configuración fina de los procesos worker, los búferes y la transición a HTTP/2 (y HTTP/3) le permitirán exprimir el máximo rendimiento de cada vCPU y megabyte de RAM de su VPS.

Recuerde que la optimización es un proceso iterativo. Comience con las configuraciones básicas, luego implemente gradualmente las más complejas, monitoreando constantemente los resultados y analizando los datos. No tema experimentar en entornos de prueba y aprender de casos reales. Las inversiones de tiempo y esfuerzo en una optimización profunda de Nginx se amortizarán muchas veces: su servicio será más rápido, más estable, más seguro, y podrá atender a más usuarios con los mismos recursos, posponiendo costosas actualizaciones.

Próximos pasos para el lector:

- Analice la configuración actual de su Nginx y las métricas de rendimiento de su VPS.

- Elija 2-3 puntos más relevantes para su proyecto de la lista de verificación y comience a implementarlos.

- Configure un sistema de monitoreo (si aún no lo tiene) para rastrear el impacto de sus cambios.

- Realice pruebas de carga antes y después de implementar las optimizaciones.

- Continúe aprendiendo y manténgase al tanto de las nuevas características de Nginx y las tecnologías web.

¡Mucha suerte en la creación de aplicaciones web ultrarrápidas y confiables!