El desafío del ajuste fino asequible de LLM

El ajuste fino de LLM requiere una potencia y memoria de GPU significativas. Modelos como Llama 2, GPT-3 y otros demandan recursos sustanciales, lo que genera altos costos al usar proveedores de nube tradicionales. Esta guía se centra en aprovechar los proveedores de nube de GPU especializados y las técnicas de optimización inteligentes para reducir drásticamente estos costos.

Guía paso a paso para el ajuste fino rentable de LLM

- Elija la GPU correcta: Seleccionar la GPU adecuada es crucial. Las GPU más nuevas y potentes suelen ser más rentables por hora de entrenamiento que las más antiguas, incluso si su tarifa por hora es más alta.

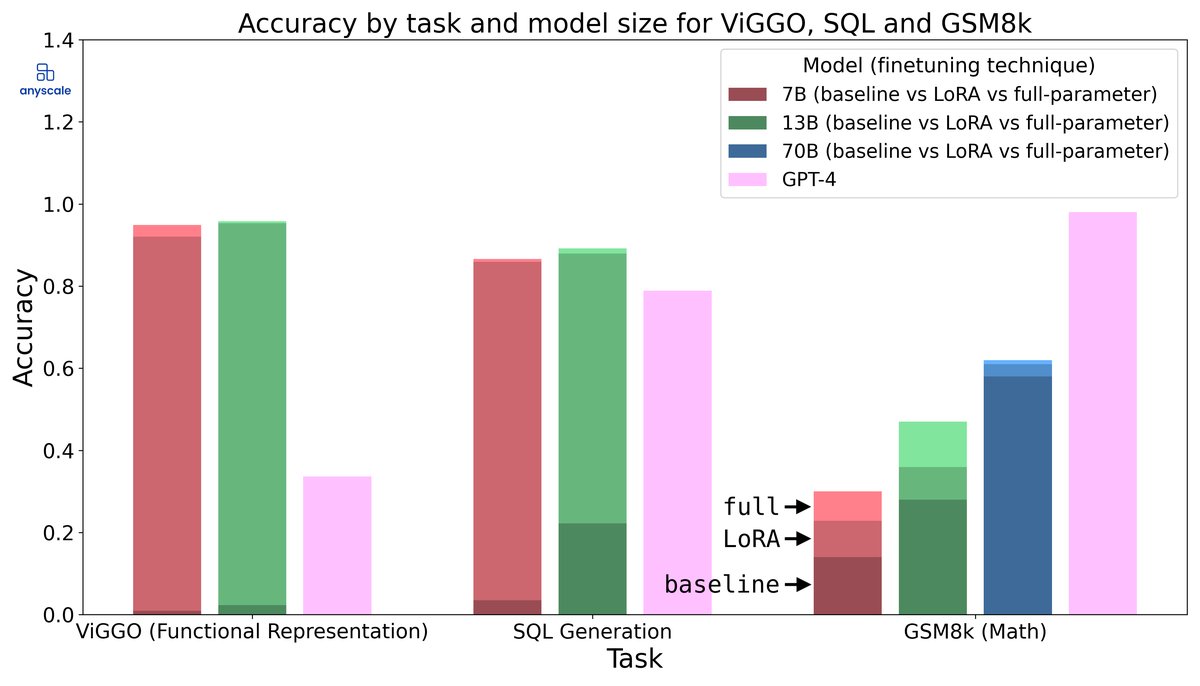

- Optimice su proceso de ajuste fino: Técnicas como la cuantización, LoRA (Adaptación de bajo rango) y otros métodos de ajuste fino eficientes en parámetros pueden reducir significativamente los requisitos de memoria y el tiempo de entrenamiento.

- Seleccione el proveedor de nube adecuado: Los proveedores de nube de GPU especializados a menudo ofrecen precios significativamente más bajos que los proveedores de nube tradicionales como AWS, Azure y GCP.

- Utilice instancias puntuales/instancias interrumpibles: Estas ofrecen descuentos sustanciales, pero conllevan el riesgo de interrupción. Sin embargo, para el ajuste fino, los puntos de control pueden mitigar este riesgo.

- Supervise y optimice el uso de recursos: Supervise continuamente la utilización de la GPU, el uso de la memoria y el ancho de banda de la red para identificar y eliminar los cuellos de botella.

Recomendaciones de GPU para el ajuste fino de LLM

GPU de gama alta (para modelos grandes y tareas complejas)

- NVIDIA A100: Un caballo de batalla para el entrenamiento y ajuste fino de LLM. Ofrece un excelente rendimiento y capacidad de memoria (40 GB u 80 GB).

- NVIDIA H100: La última generación, que ofrece un rendimiento aún mayor que la A100, pero también más cara.

GPU de gama media (para modelos más pequeños y tareas moderadas)

- NVIDIA RTX 3090: Una potente GPU de grado de consumidor con 24 GB de VRAM, lo que la hace adecuada para ajustar LLM más pequeños o usar LoRA en modelos más grandes.

- NVIDIA RTX 4090: Aún más potente que la 3090, con VRAM similar y, a menudo, una mejor relación precio-rendimiento.

- NVIDIA A40: Ofrece un rendimiento similar a la RTX 3090 pero con un diseño de grado de servidor más robusto.

GPU económicas (para experimentación y ajuste fino a pequeña escala)

- NVIDIA RTX 3060: Una buena opción de nivel de entrada con 12 GB de VRAM, adecuada para experimentar con modelos más pequeños o usar técnicas como la cuantización.

Técnicas de optimización de costos

Ajuste fino eficiente en parámetros (PEFT)

Las técnicas PEFT, como LoRA, adaptan un LLM preentrenado a una tarea específica entrenando solo una pequeña cantidad de parámetros. Esto reduce significativamente los requisitos de memoria y el tiempo de entrenamiento.

Cuantización

La cuantización reduce la precisión de los pesos del modelo, reduciendo la huella de memoria y acelerando el cálculo. Se pueden utilizar técnicas como la cuantización de 8 bits o 4 bits con un impacto mínimo en el rendimiento.

Entrenamiento de precisión mixta

El uso de entrenamiento de precisión mixta (por ejemplo, el uso de bfloat16 o float16) puede acelerar significativamente el entrenamiento y reducir el uso de memoria en comparación con la precisión total (float32).

Optimización de datos

Asegúrese de que su conjunto de datos se cargue y procese de manera eficiente. Utilice cargadores de datos optimizados y considere técnicas como el particionamiento de datos para distribuir los datos en varias GPU.

Acumulación de gradiente

Si tiene memoria de GPU limitada, utilice la acumulación de gradiente para simular tamaños de lote más grandes. Esto puede mejorar la estabilidad y el rendimiento del entrenamiento.

Recomendaciones de proveedores de nube

RunPod

RunPod ofrece una amplia gama de GPU a precios competitivos. Se especializan en proporcionar instancias de GPU bajo demanda y le permiten alquilar directamente a miembros de la comunidad, lo que a menudo resulta en precios más bajos. Ofrece instancias tanto bajo demanda como puntuales.

Precios (Ejemplo): RTX 3090 desde ~$0.50/hora, A100 desde ~$3/hora

Vast.ai

Vast.ai es otra excelente opción para encontrar instancias de GPU asequibles. Agregan recursos de GPU de varios proveedores y ofrecen instancias puntuales a precios altamente competitivos. Conocido por su mecanismo de descubrimiento de precios que puede conducir a precios extremadamente bajos.

Precios (Ejemplo): RTX 3090 desde ~$0.30/hora, A100 desde ~$2.50/hora (los precios al contado fluctúan)

Lambda Labs

Lambda Labs proporciona servidores de GPU dedicados e instancias en la nube, centrándose en cargas de trabajo de aprendizaje profundo. Ofrecen entornos preconfigurados y un excelente soporte para marcos de aprendizaje automático. Más caro que RunPod o Vast.ai, pero ofrece soluciones gestionadas.

Precios (Ejemplo): A100 desde ~$4/hora (instancia dedicada)

Vultr

Vultr ofrece una experiencia de nube más tradicional, pero ha comenzado a ofrecer instancias de GPU. Sus precios pueden ser competitivos, especialmente para compromisos a más largo plazo. Una buena opción si prefiere un proveedor de nube más establecido.

Precios (Ejemplo): A100 desde ~$3.50/hora

Tabla comparativa

| Proveedor | Precio de GPU (A100) (Aprox.) | Instancias puntuales | Facilidad de uso | Mejor para |

|---|---|---|---|---|

| RunPod | $3/hora | Sí | Moderado | Usuarios conscientes de los costos, alquileres comunitarios |

| Vast.ai | $2.50/hora (spot) | Sí (solo spot) | Moderado (Requiere algunos conocimientos técnicos) | Precios más bajos, configuraciones flexibles |

| Lambda Labs | $4/hora | No | Fácil (Soluciones gestionadas) | Entornos gestionados, servidores dedicados |

| Vultr | $3.50/hora | No | Fácil (Nube tradicional) | Entorno de nube familiar, compromisos a largo plazo |

Errores comunes que se deben evitar

- Subestimar la memoria de GPU requerida: Estime cuidadosamente los requisitos de memoria de su modelo y conjunto de datos antes de seleccionar una GPU.

- Ignorar los costos de transferencia de datos: Transferir grandes conjuntos de datos puede ser costoso. Considere almacenar sus datos cerca de la instancia de GPU.

- No usar instancias puntuales: Las instancias puntuales pueden ahorrarle mucho dinero, pero prepárese para las interrupciones. Implemente la creación de puntos de control para mitigar este riesgo.

- No supervisar el uso de recursos: Supervise continuamente la utilización de la GPU, el uso de la memoria y el ancho de banda de la red para identificar y eliminar los cuellos de botella.

- Pasar por alto la configuración del software: Asegúrese de que su entorno esté configurado correctamente con los controladores, bibliotecas y marcos necesarios. Utilice imágenes de Docker preconstruidas cuando estén disponibles.

Casos de uso reales

Ajuste fino de Stable Diffusion

El ajuste fino de Stable Diffusion para estilos o temas específicos se puede realizar de manera asequible utilizando GPU RTX 3090 o RTX 4090 en RunPod o Vast.ai. LoRA es una técnica popular para reducir los requisitos de memoria.

Inferencia de LLM

Si bien esta guía se centra en el ajuste fino, los mismos principios se aplican a la implementación de LLM para la inferencia. El uso de modelos cuantificados y motores de inferencia eficientes puede reducir significativamente los costos.

Entrenamiento de modelos

Entrenar LLM desde cero es generalmente más caro que el ajuste fino, pero se aplican las mismas técnicas de optimización de costos. Considere usar varias GPU en paralelo para acelerar el entrenamiento.